LLM 評(píng)估匯總:真的吊打 LLaMA-3,媲美 GPT-4 嗎?

一、背景

在過(guò)去的一年多里,國(guó)內(nèi)在大模型領(lǐng)域的發(fā)展異常迅速,涌現(xiàn)出上百個(gè)大模型,許多模型已經(jīng)迭代了多個(gè)版本,并且各種指標(biāo)不斷刷新。與此同時(shí),我們也經(jīng)常在國(guó)內(nèi)的一些文章中看到聲稱“吊打 LLaMA 3”或“媲美 GPT-4”的說(shuō)法。那么,國(guó)內(nèi)的大模型真的已經(jīng)達(dá)到對(duì)標(biāo) OpenAI 的水平了嗎?

實(shí)際上,由于大模型的評(píng)估指標(biāo)種類繁多,各種文章中所對(duì)比的模型也不盡相同,甚至有時(shí)會(huì)出現(xiàn)一些誤導(dǎo)信息。因此,我們決定系統(tǒng)性梳理一下公認(rèn)性能較強(qiáng)的大模型的相關(guān)指標(biāo),以全面了解各種模型的能力。

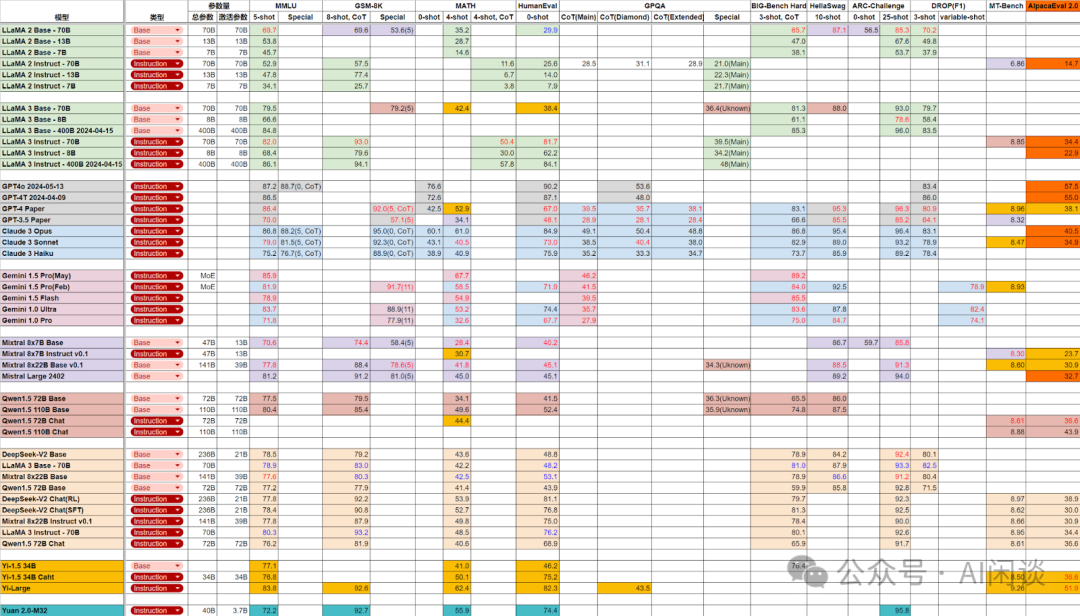

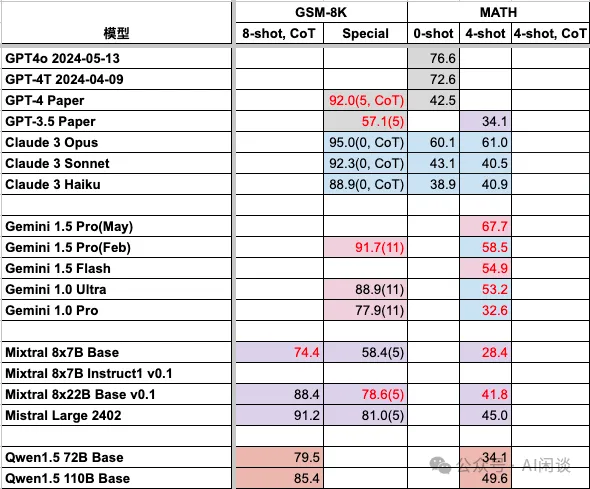

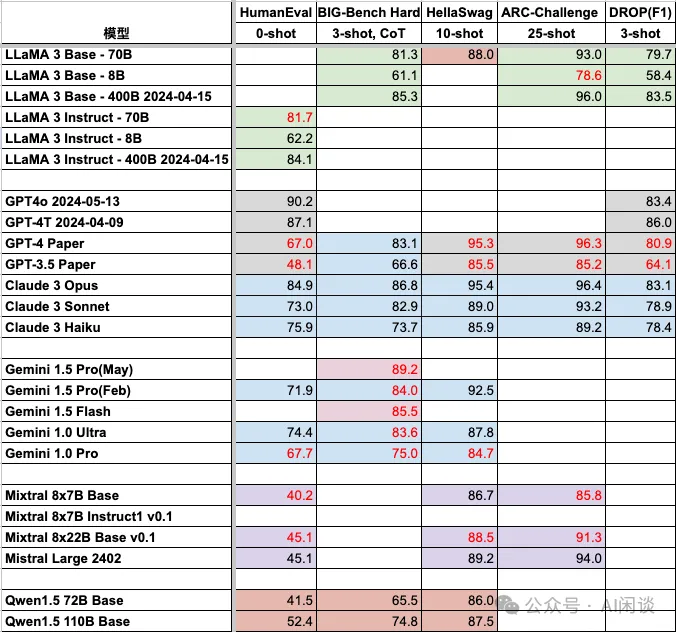

如下圖展示了我們梳理的一部分常見文本類基準(zhǔn)評(píng)估指標(biāo)(圖中的不同底色表示數(shù)據(jù)來(lái)源,比如淡綠色表示數(shù)據(jù)來(lái)自 LLaMA 3 官方,淡藍(lán)色表示數(shù)據(jù)來(lái)自 Claude 3 Paper,灰色表示來(lái)自 OpenAI 官方,淡紫色表示來(lái)自 Mixtral 官方等)。需要說(shuō)明的是,這僅僅是部分常見指標(biāo),也并未涉及多模態(tài)基準(zhǔn)評(píng)估。此外,由于數(shù)據(jù)比較多,且來(lái)源繁雜,難免會(huì)有遺漏或錯(cuò)誤的地方,歡迎指出和糾正。本文中,我們也會(huì)簡(jiǎn)單介紹在收集這些數(shù)據(jù)時(shí)發(fā)現(xiàn)的一些問(wèn)題,遇到的困惑,以及具體數(shù)據(jù)的來(lái)源,以便大家也能更準(zhǔn)確的分辨各種大模型的能力。

二、引言

2.1 評(píng)估指標(biāo)

常見的文本任務(wù)評(píng)估指標(biāo)包括如下幾個(gè):

- MMLU:通用知識(shí)和推理能力。

- MATH:數(shù)學(xué)解決問(wèn)題能力。

- GSM8K:小學(xué)數(shù)學(xué)。

- HumanEval:Python 編碼任務(wù)。

- GPQA:大學(xué)生物、物理和化學(xué)問(wèn)答。

- DROP:閱讀理解和算術(shù)。

- Big-Bench-Hard:綜合評(píng)估。

- ARC-Challenge:常識(shí)推理。

- HellaSwag:常識(shí)推理。

- AGIEval:大學(xué)入學(xué)考試和資格考試。

- MT-Bench:多輪對(duì)話基準(zhǔn)測(cè)試。

- AlpacaEval 2.0:指令跟隨能力。

2.2 評(píng)估框架

Harness 是 EleutherAI 開源的 LLM 評(píng)估框架,對(duì)應(yīng)的代碼庫(kù)為:GitHub - EleutherAI/lm-evaluation-harness: A framework for few-shot evaluation of language models.。也是 Huggingface 官方 Open-LLM-Leaderboard (a Hugging Face Space by open-llm-leaderboard)后端使用的評(píng)估框架,在很多論文中被使用。

Helm 是斯坦福大學(xué)開發(fā)的 LLM 評(píng)估框架,對(duì)應(yīng)的論文為:[2211.09110] Holistic Evaluation of Language Models,對(duì)應(yīng)的代碼庫(kù)為:??https://github.com/stanford-crfm/helm??。其可以評(píng)估模型在 12 個(gè)方面的能力。

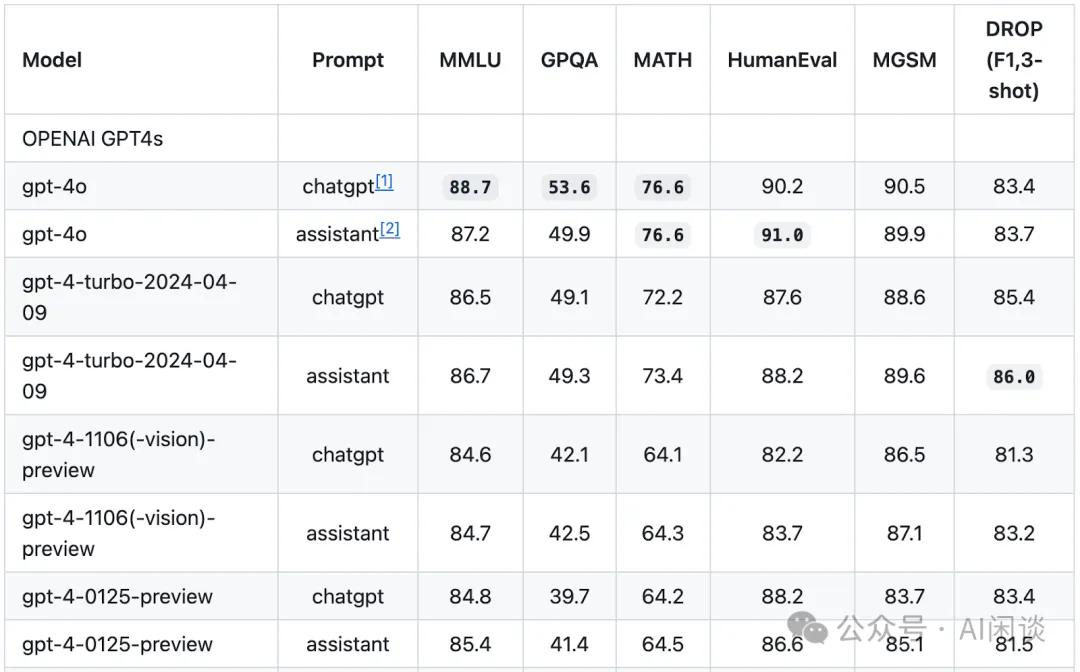

simple-evals 是 OpenAI 最近開源的針對(duì)幾個(gè)常見指標(biāo)的評(píng)估工具 (GitHub - openai/simple-evals),也是其 GPT-4o 使用的評(píng)估工具。如下圖所示為其對(duì)應(yīng)的評(píng)估結(jié)果:

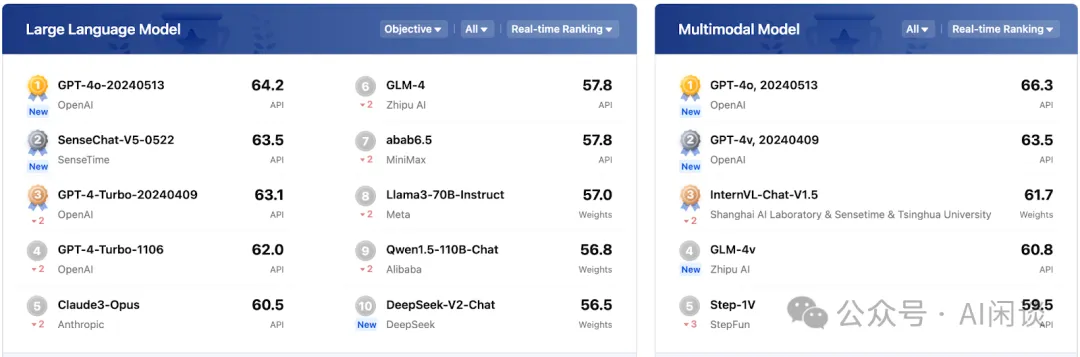

OpenCompass 是一個(gè)國(guó)內(nèi)常用的評(píng)估框架,對(duì)應(yīng)的代碼庫(kù)為:OpenCompass is an LLM evaluation platform, supporting a wide range of models (Llama3, Mistral, InternLM2,GPT-4,LLaMa2, Qwen,GLM, Claude, etc) over 100+ datasets.。其也提供詳細(xì)的 Leaderboard:OpenCompass司南。如下圖所示:

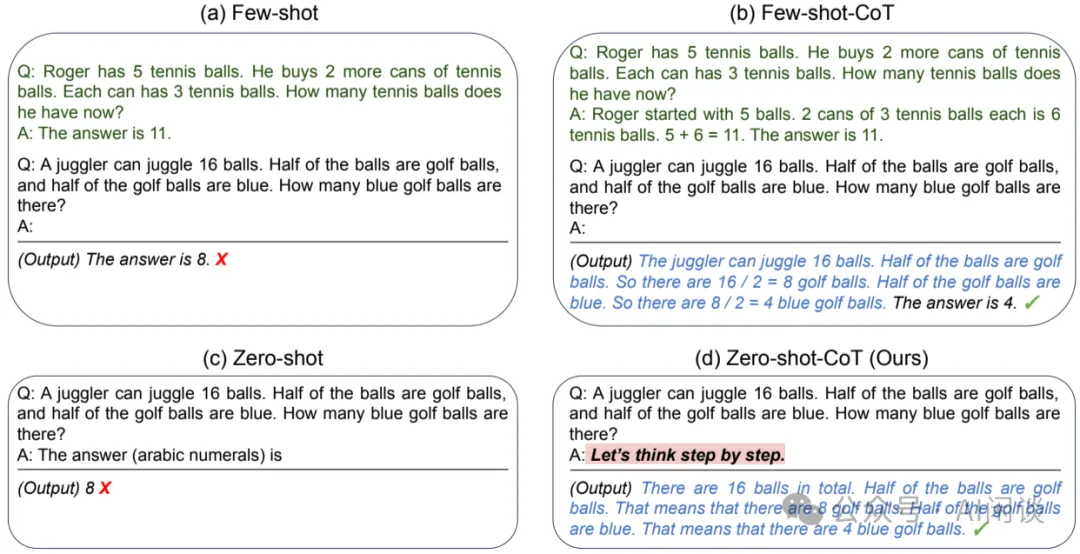

2.3 Few-shot & CoT

在評(píng)估中經(jīng)常會(huì)使用 few-shot 和 CoT 方法,如下圖所示(圖片來(lái)自 [2205.11916] Large Language Models are Zero-Shot Reasoners)為 0-shot,few-shot 以及是否包含 CoT 的區(qū)別,簡(jiǎn)單來(lái)說(shuō):

- few-shot就是表示 Prompt 中會(huì)提供一些示例,沒(méi)有示例表示為 0-shot,5 個(gè)示例為 5-shot。

- CoT就是在 Prompt 中會(huì)提供 CoT(Chain of Thought,[2201.11903] Chain-of-Thought Prompting Elicits Reasoning in Large Language Models),也就是推理過(guò)程。其中最經(jīng)典的 CoT 為 “Let’s think step by step.”。?

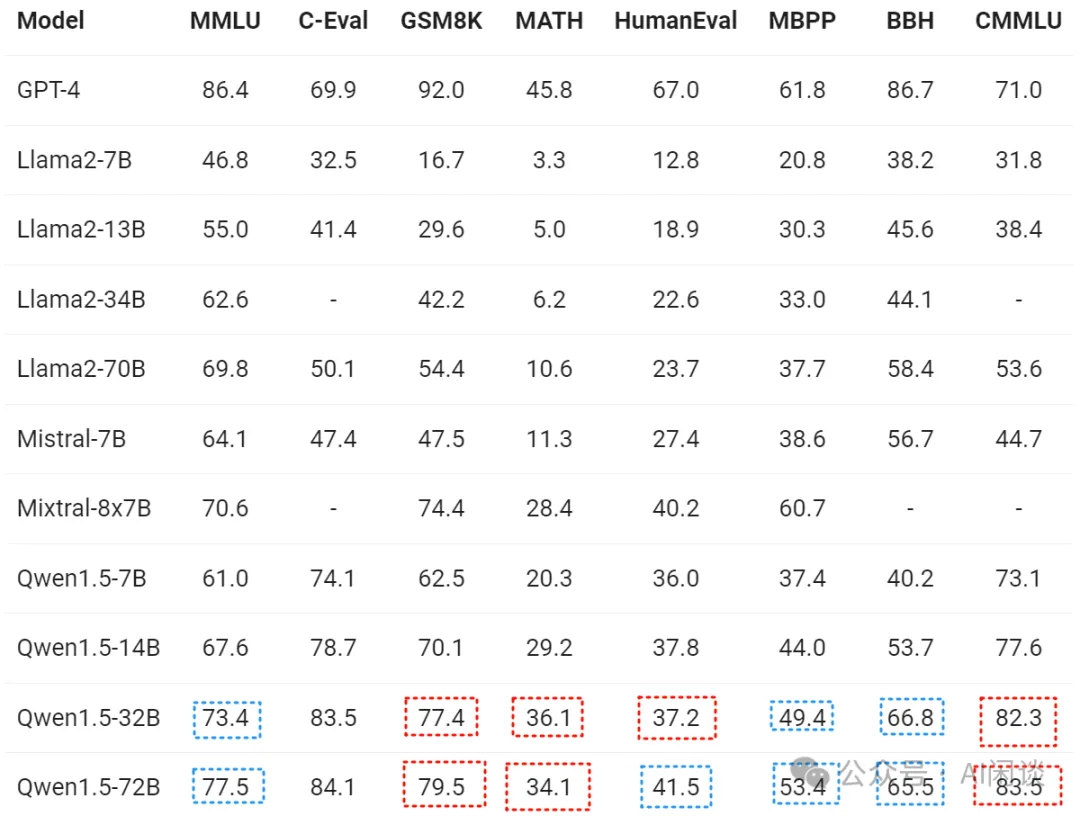

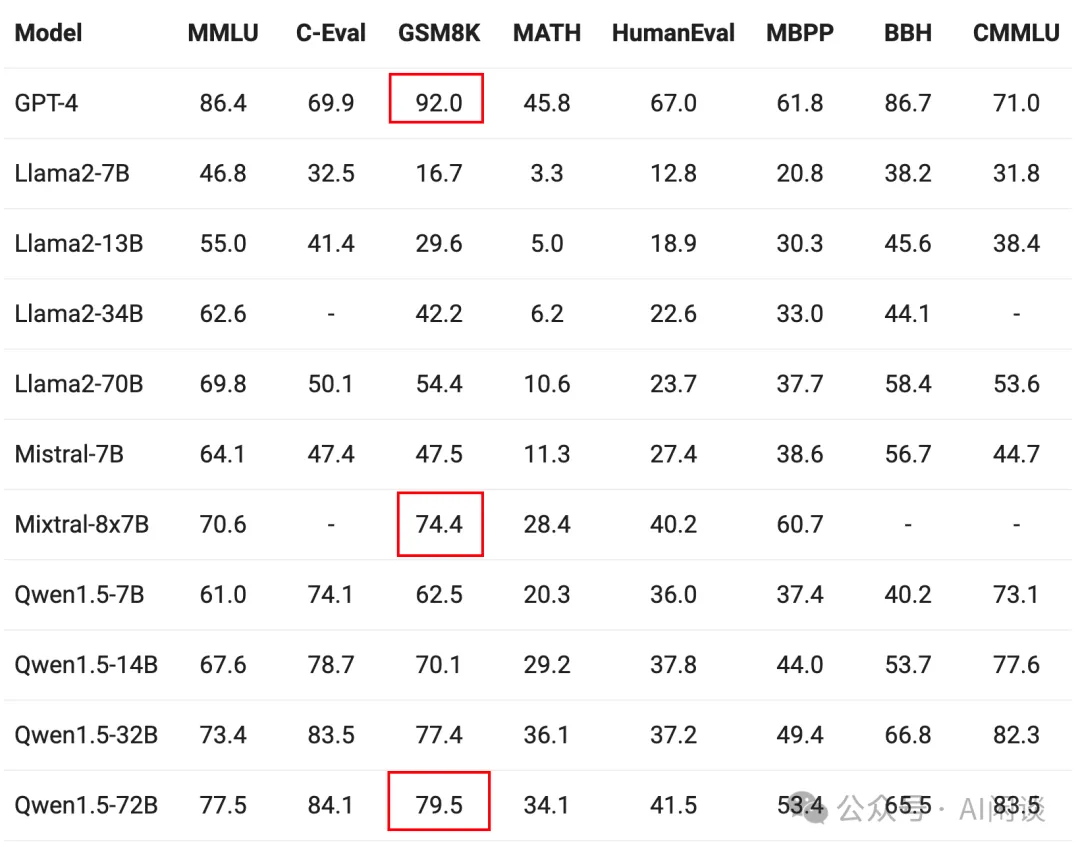

在基準(zhǔn)評(píng)估中,為了公平對(duì)比,使用相同的配置才有參考價(jià)值。然而部分評(píng)估中并未清晰的列出對(duì)應(yīng)的配置,如下圖所示分別為 Introducing Qwen1.5 | Qwen 官網(wǎng)上關(guān)于 Qwen1.5 和 零一萬(wàn)物 上關(guān)于 Yi-1.5 模型的各種指標(biāo),很多都沒(méi)有明確指出對(duì)應(yīng)的配置,導(dǎo)致部分指標(biāo)無(wú)法對(duì)齊:

2.4 Base 模型 & Instruction 模型

現(xiàn)在有很多開源的 LLM 都會(huì)提供 Base 模型和 Instruction 模型,其中:

- Base 模型:是在大量未標(biāo)注的通用文本數(shù)據(jù)上進(jìn)行無(wú)監(jiān)督訓(xùn)練,比如網(wǎng)頁(yè)、書籍、代碼、新聞文章等。Base 模型適用于需要廣泛自然語(yǔ)言理解和生成的場(chǎng)景,但對(duì)具體的任務(wù)可能不如專用模型。

- Instruction 模型:通常是在 Base 模型基礎(chǔ)上,使用經(jīng)過(guò)人工標(biāo)注或篩選的指令數(shù)據(jù)通過(guò)有監(jiān)督微調(diào)訓(xùn)練而來(lái)。這些數(shù)據(jù)的質(zhì)量通常很高,而且有些時(shí)候會(huì)針對(duì)特定場(chǎng)景。這類模型更適合需要特定指令進(jìn)行操作的場(chǎng)景。

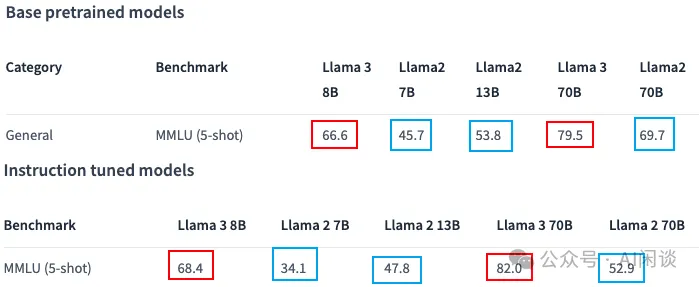

雖然 Instruction 模型也是基于 Base 模型微調(diào),但是他們的評(píng)估指標(biāo)可能會(huì)有比較大的區(qū)別,如下圖所示(meta-llama/Meta-Llama-3-70B · Hugging Face),對(duì)于 MMLU 指標(biāo):

- LLaMA 2模型的 Base 模型都比 Instruction 模型高,甚至差了 10 分以上。

- LLaMA 3模型的 Base 模型都比 Instruction 模型低。?

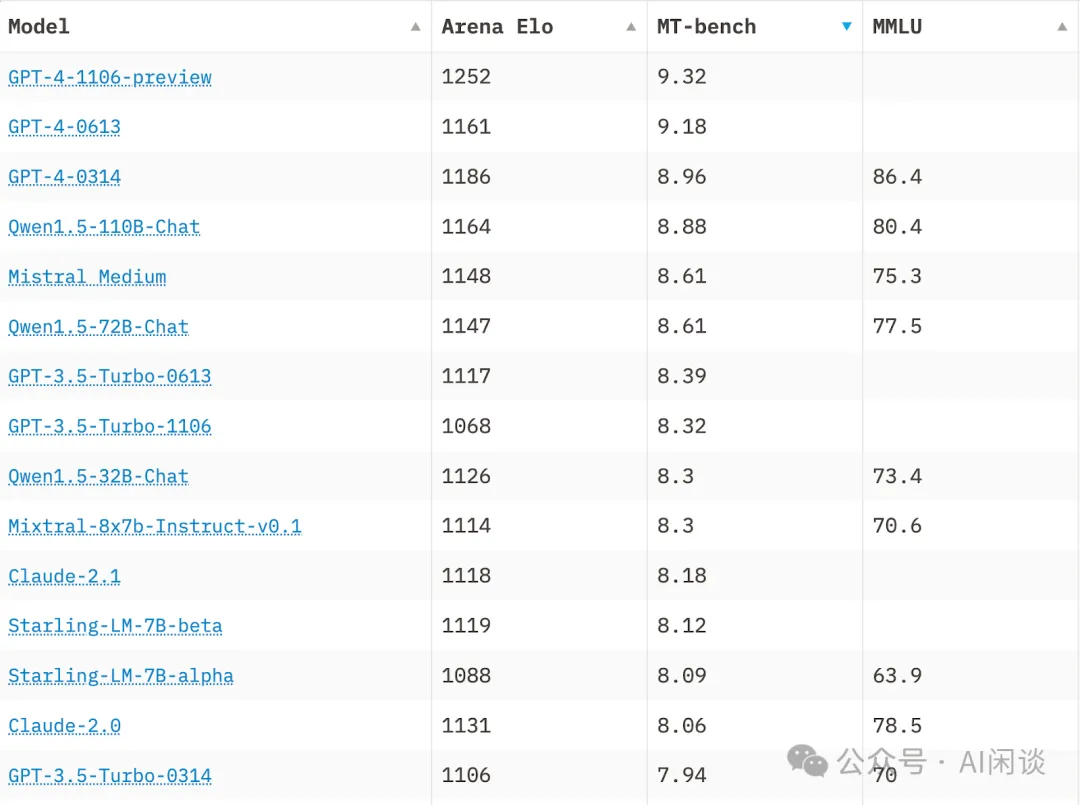

我們?cè)谑占瘮?shù)據(jù)的時(shí)候發(fā)現(xiàn)很多地方會(huì)混淆兩個(gè)模型的指標(biāo),比如經(jīng)常看的 LMSys Chatbot Arena Leaderboard - a Hugging Face Space by lmsys 中就混淆了 Qwen1.5-110B 以及 Qwen1.5-72B 的 Base 模型和 Instruction 模型。參考 Qwen-1.5 的官方博客 Qwen1.5-110B:Qwen1.5系列的首個(gè)千億參數(shù)開源模型| Qwen,下圖中的 MT-bench 指標(biāo)確實(shí)是 Qwen1.5-110B-Chat(Instruction)和 Qwen1.5-72B-Chat(Instruction)模型,但 MMLU 對(duì)應(yīng)的是 Qwen1.5-110B(Base)和 Qwen1.5-72B(Base)模型:

2.5 不同模型版本

早期的 LLM 通常都會(huì)發(fā)布詳細(xì)的技術(shù)報(bào)告,包括具體版本和性能指標(biāo)的說(shuō)明。然而,最近的很多 LLM 僅以簡(jiǎn)單的博客頁(yè)面形式發(fā)布,甚至缺乏對(duì)模型及其評(píng)估指標(biāo)的詳細(xì)介紹,特別是一些閉源模型。這種變化為不同模型之間的橫向?qū)Ρ葞?lái)了很大的挑戰(zhàn)。如下圖所示為 LMSys Chatbot Arena Leaderboard - a Hugging Face Space by lmsys 榜單,可以看出,排名前 12 的模型中,GPT-4 就有 4 個(gè)版本,Gemini-1.5 也有三個(gè)版本:

2.6 評(píng)估工具差異

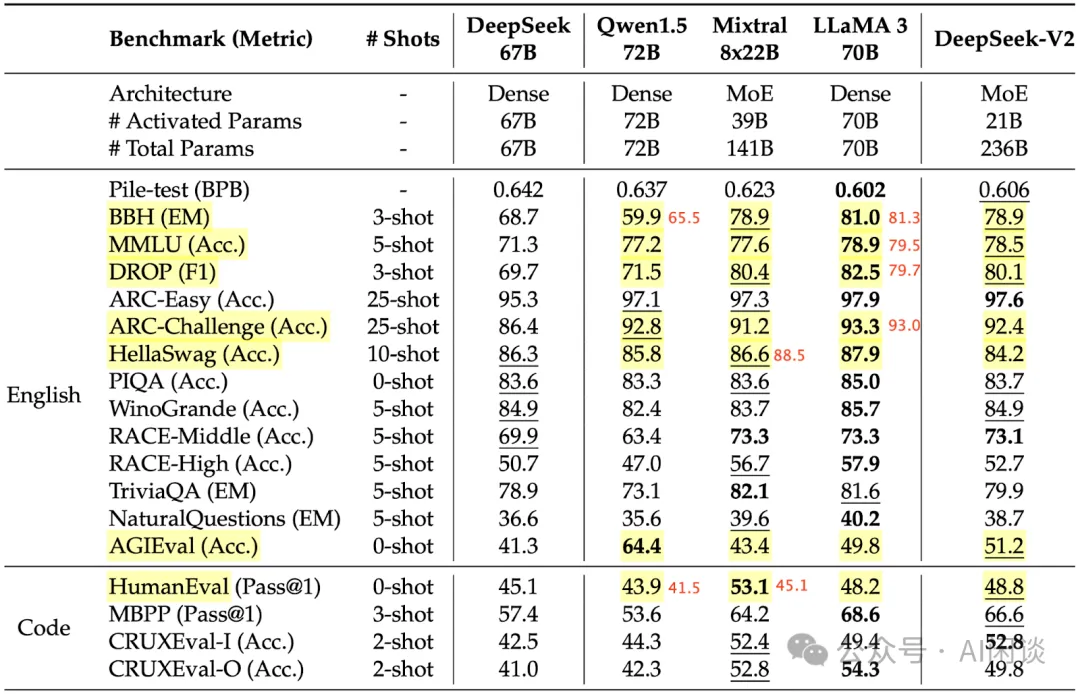

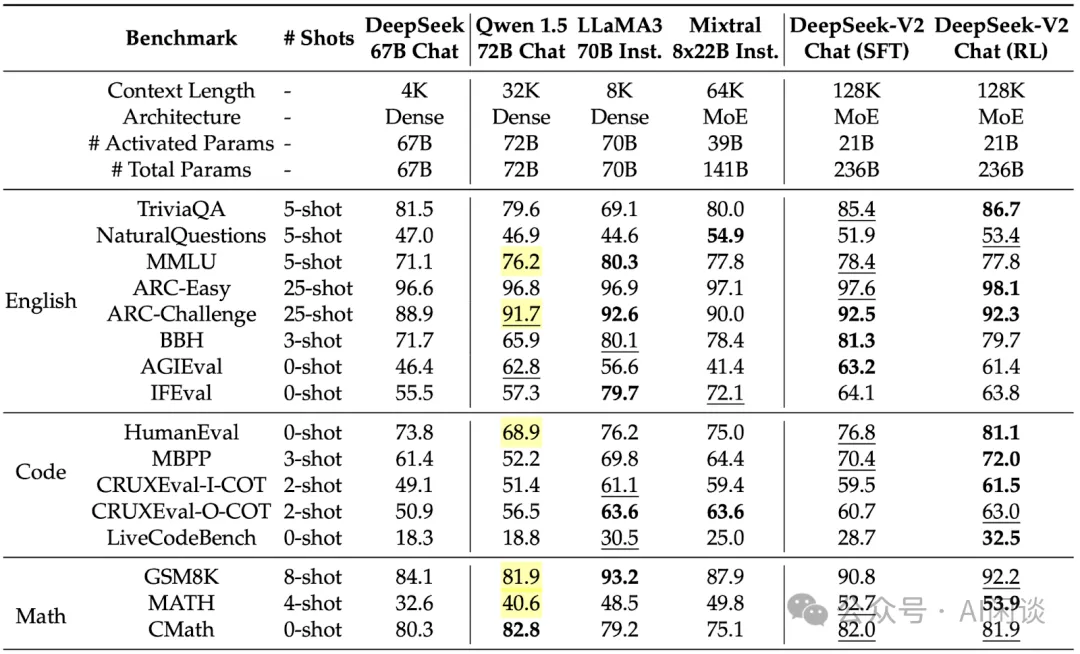

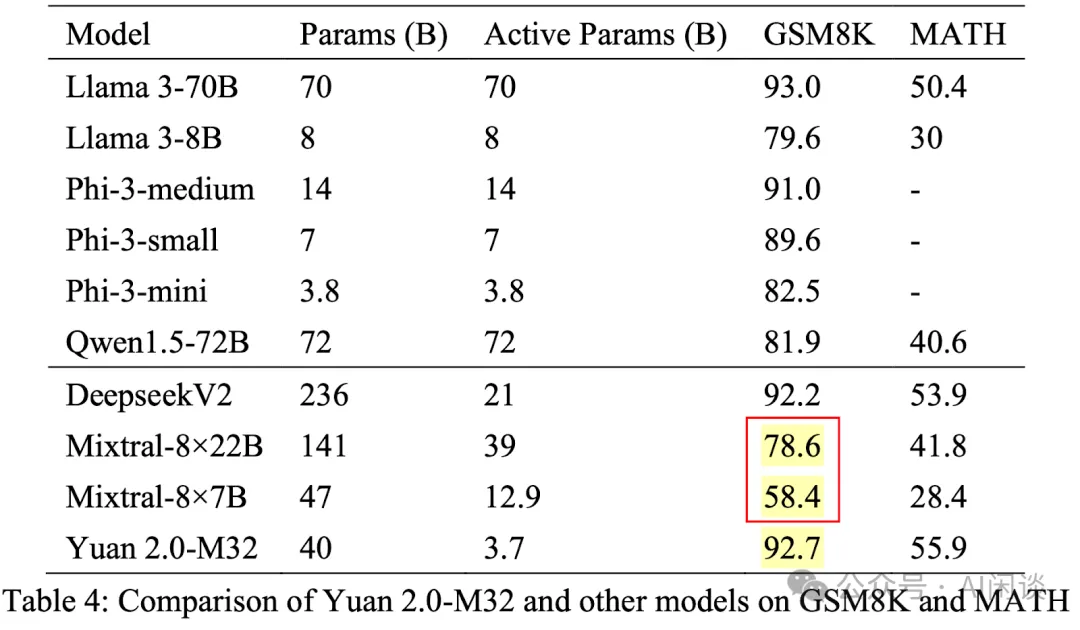

很多公司都有自己的評(píng)估工具,其有些時(shí)候不會(huì)和開源社區(qū)的評(píng)估方式完全對(duì)齊,導(dǎo)致評(píng)估指標(biāo)的差異。比如在 DeepSeek-V2([2405.04434] DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model)中,作者使用了內(nèi)部評(píng)估工具,導(dǎo)致有些結(jié)果和我們從 Qwen1.5 72B、Mixtral 8x22B 和 LLaMA3 70B 官方報(bào)告中看到的結(jié)果不太一致,圖中紅色部分為相應(yīng)的官方數(shù)據(jù):

在浪潮的源 2.0-M32 [2405.17976] Yuan 2.0-M32: Mixture of Experts with Attention Router 中,作者也提供了 Qwen1.5-72B Chat 的結(jié)果,但是看著是直接引用了下圖所示 DeepSeek-V2-Chat 的結(jié)果。但是源 2.0-M32 中并沒(méi)有說(shuō)明自己使用的評(píng)估工具。

2.7 數(shù)據(jù)污染

數(shù)據(jù)污染問(wèn)題在大模型訓(xùn)練中非常常見,沒(méi)有經(jīng)過(guò)仔細(xì)的數(shù)據(jù)清理過(guò)程,很可能會(huì)在訓(xùn)練集中混入部分基準(zhǔn)評(píng)估數(shù)據(jù)。比如,OpenAI 的 GPT-4 Paper 中提到,其發(fā)現(xiàn)訓(xùn)練集中不小心混入了 BIG-Bench 數(shù)據(jù),所以 GPT-4 Paper 中并未提供 BIG-Bench Hard 的評(píng)估結(jié)果。

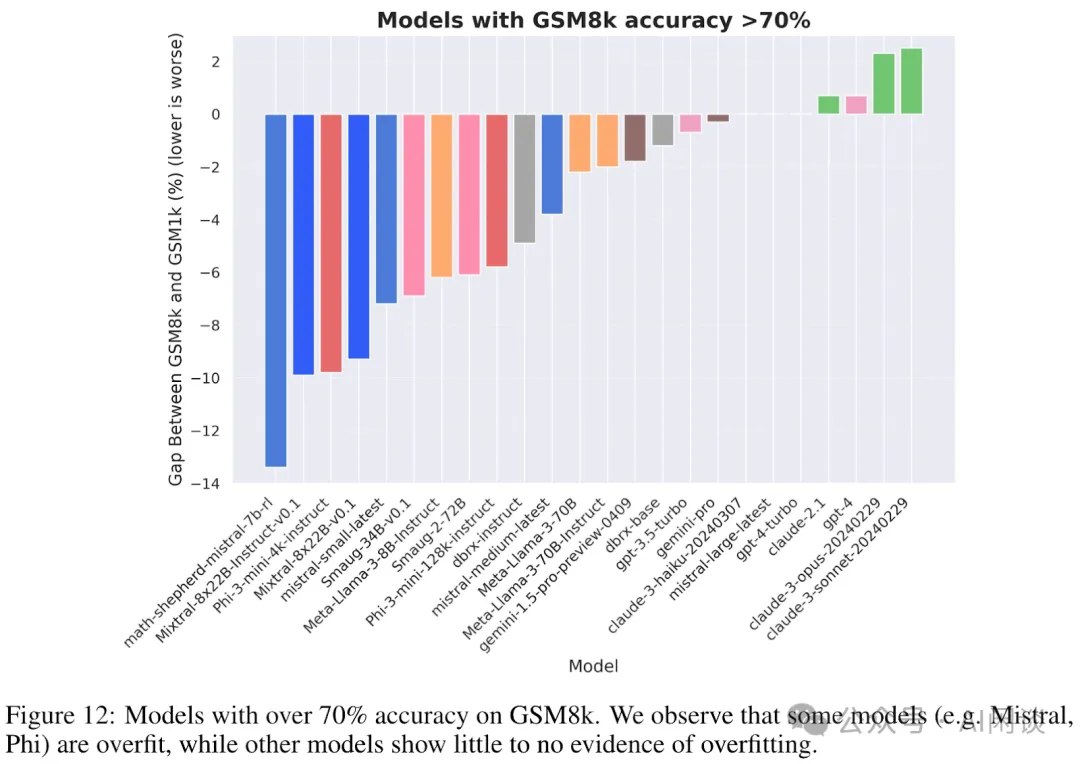

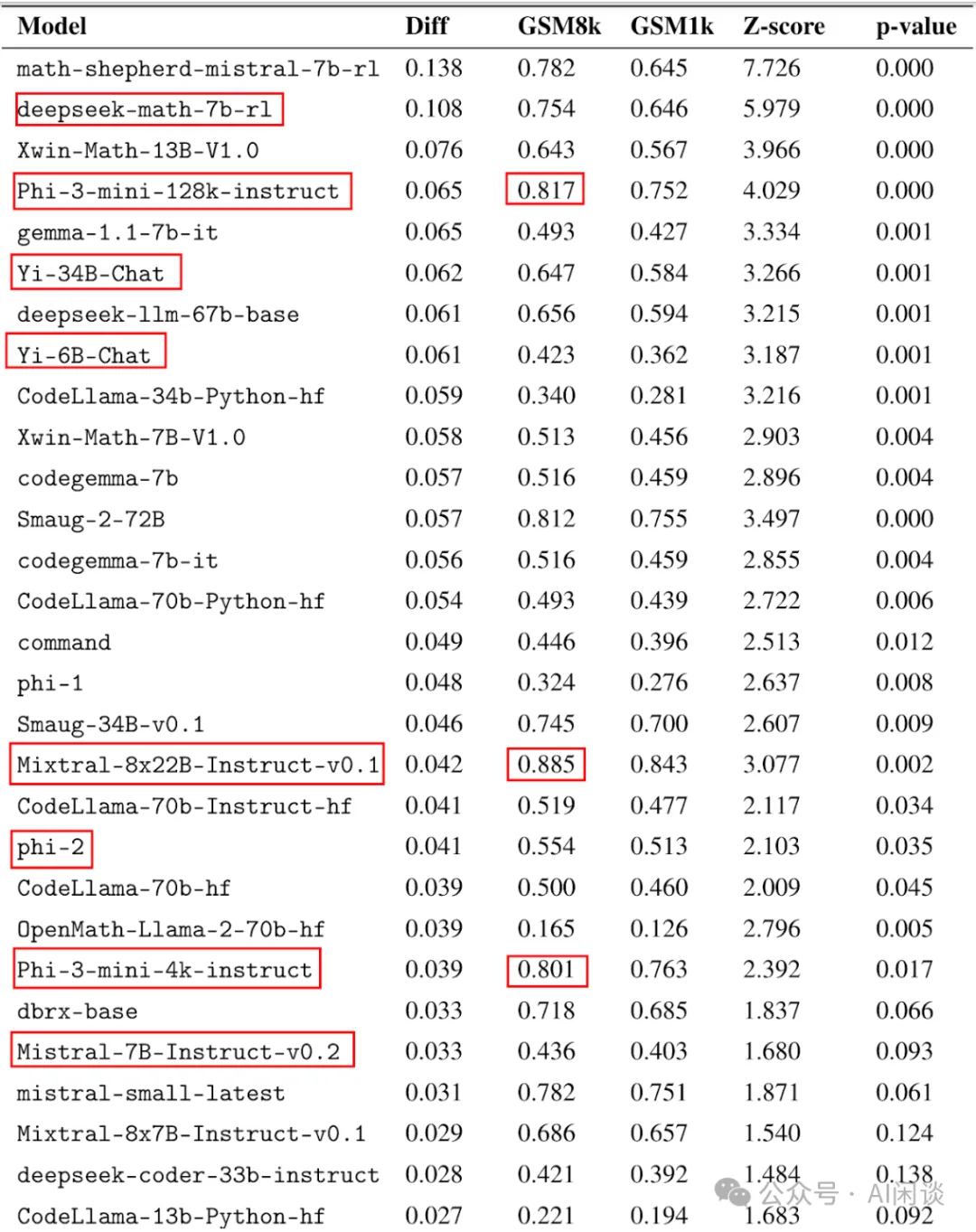

最近 Scale AI 的研究員研究了 GSM-8K 數(shù)據(jù)泄漏問(wèn)題,對(duì)應(yīng)的 Paper 為:[2405.00332] A Careful Examination of Large Language Model Performance on Grade School Arithmetic。作者通過(guò)人工標(biāo)注方式構(gòu)建了 GSM-1K 數(shù)據(jù)集,其難度與 GSM-8K 類似,包含 1250 道小學(xué)數(shù)學(xué)題。作者使用該數(shù)據(jù)集對(duì)一些開源和閉源 LLM 進(jìn)行了基準(zhǔn)測(cè)試,發(fā)現(xiàn)部分模型在 GSM-1K 上的性能甚至比 GSM-8K 低 10% 以上,比如 math-shepherd-mistral-7b-rl 指標(biāo)低了將近 13%;而 Claude 3 和 GPT-4 模型指標(biāo)沒(méi)有下降:

如下圖所示為部分詳細(xì)數(shù)據(jù),可以看出其包含了多個(gè)我們常見的模型,甚至是微軟最近發(fā)布的非常強(qiáng)大的小模型 Phi-3:

三、MMLU

[2009.03300] Measuring Massive Multitask Language Understanding 評(píng)估集是為了衡量文本模型的多任務(wù)準(zhǔn)確性,其涵蓋涵蓋人文科學(xué)(humanitities)、社會(huì)科學(xué)(social science)、自然科學(xué)(hard sciences)等領(lǐng)域的 57 個(gè)子任務(wù),比如小學(xué)數(shù)學(xué)、美國(guó)歷史、計(jì)算機(jī)科學(xué)、法律等。題目都是多項(xiàng)選擇題,通過(guò)測(cè)試語(yǔ)言模型在不同領(lǐng)域的知識(shí)和推理能力來(lái)評(píng)估其綜合性能。

與其他語(yǔ)言理解評(píng)估集(如 GLUE、SuperGLUE 等)相比,MMLU 的任務(wù)種類更多,覆蓋面更廣,能夠更加全面地評(píng)估大規(guī)模語(yǔ)言模型的能力。這使得 MMLU 成為當(dāng)前評(píng)估大規(guī)模預(yù)訓(xùn)練語(yǔ)言模型的一個(gè)重要工具。幾乎每個(gè) LLM 都會(huì)評(píng)估并對(duì)比其在 MMLU 基準(zhǔn)上的能力,而且絕大部分都是評(píng)估 5-shot 能力,少量模型會(huì)評(píng)估 5-shot+CoT 能力,比如 The Claude 3 Model Family: Opus, Sonnet, Haiku。

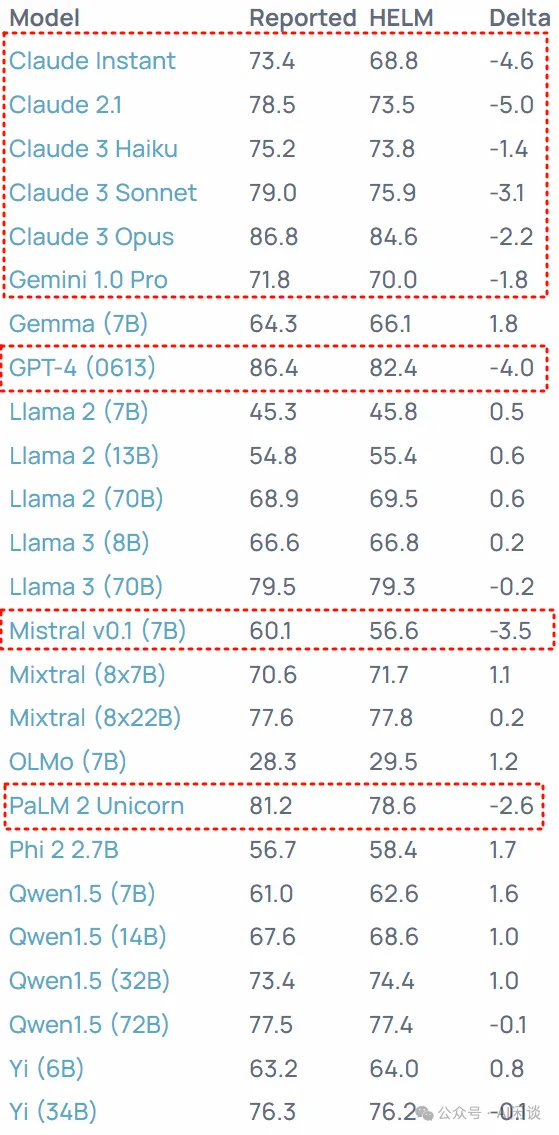

MMLU 指標(biāo)相對(duì)比較統(tǒng)一,基本不會(huì)有太多歧義。然而,在 Massive Multitask Language Understanding (MMLU) on HELM 中,作者發(fā)現(xiàn)很多模型聲稱的 MMLU 指標(biāo)和 Helm 中評(píng)估出來(lái)的有較大差距,如下圖所示:

四、GSM-8K

各種模型基本都會(huì)提供 GSM-8K 評(píng)估結(jié)果,但對(duì)應(yīng)的評(píng)估結(jié)果比較混亂。比如,有些是 0-shot+CoT 結(jié)果,有些是 8-shot+CoT,有些是 5-shot+CoT,甚至有些是 11-shot。Google Gemini([2403.05530] Gemini 1.5: Unlocking multimodal understanding across millions of tokens of context) 之前被吐槽的一個(gè)點(diǎn)就是拿 GSM-8K 11-shot 的結(jié)果和其他模型 8-shot,5-shot 的結(jié)果對(duì)比。

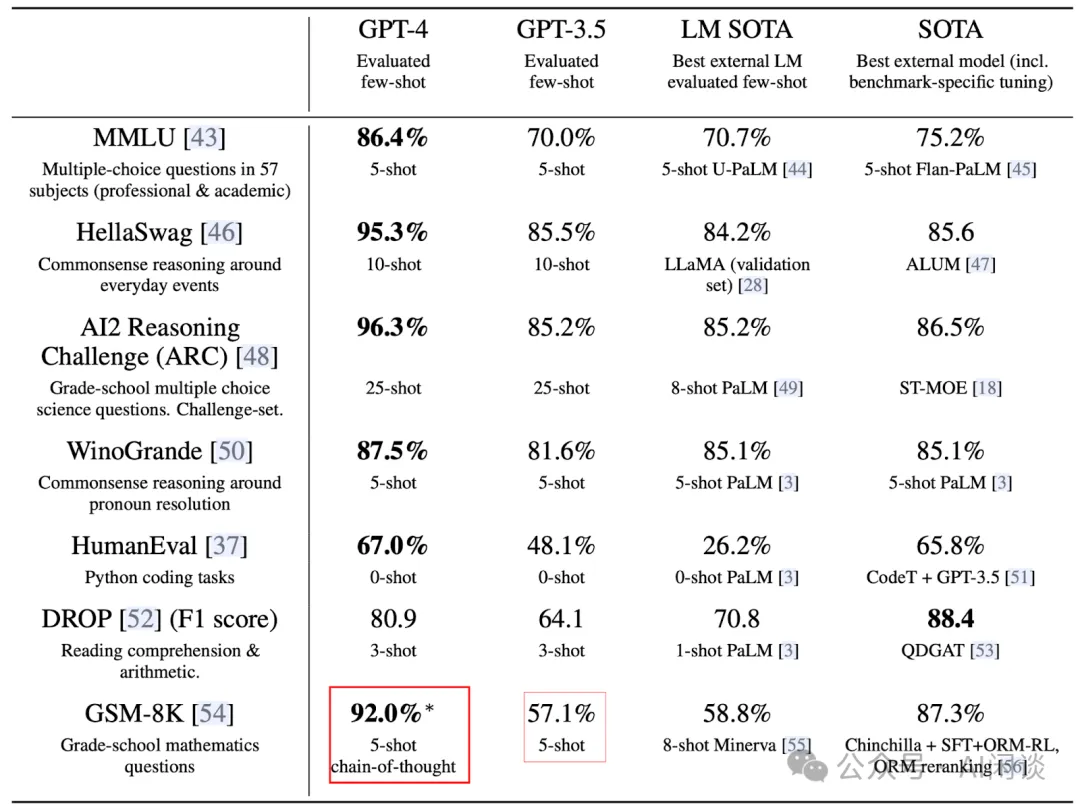

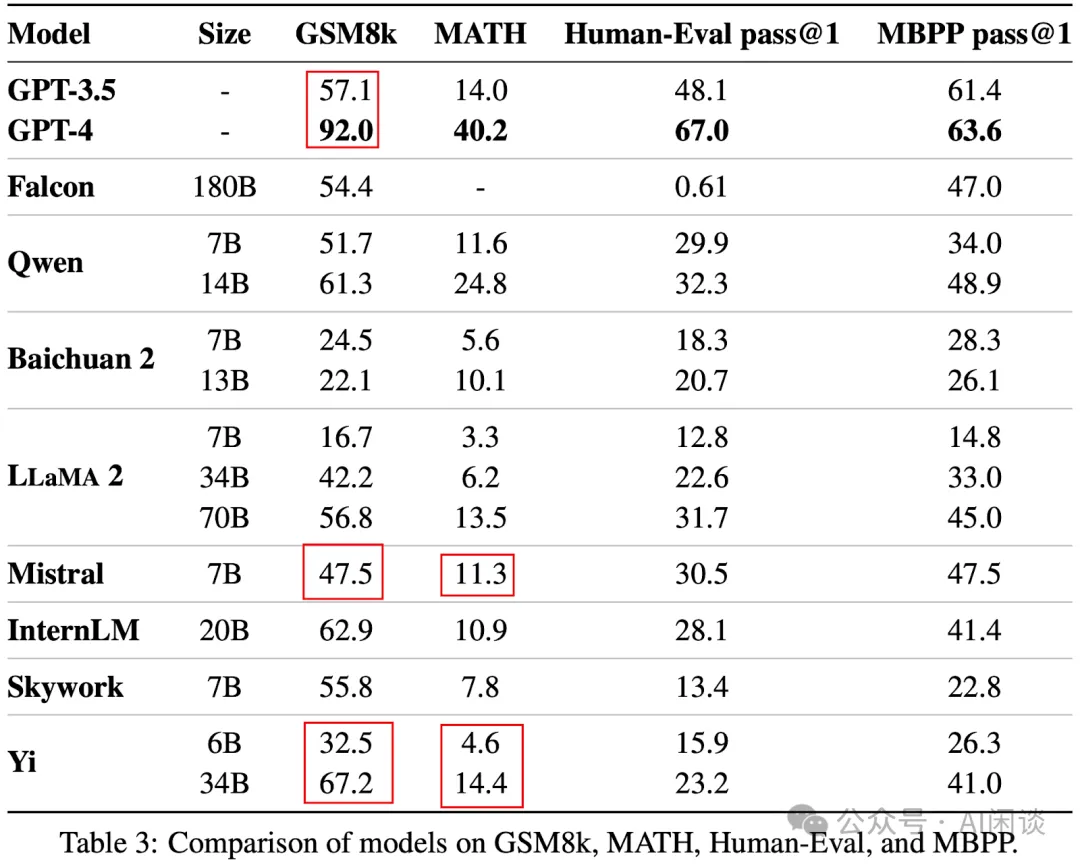

如下圖所示為 GPT-4([2303.08774] GPT-4 Technical Report)中的關(guān)鍵結(jié)果,可以看出其 GSM-8K 的 92.0 為 5-shot+CoT 的結(jié)果,而 GPT-3.5 的 57.1 為 5-shot 的結(jié)果:

如下圖所示為阿里的通義千問(wèn) Qwen1.5 介紹 | Qwen 中的官方評(píng)估結(jié)果,其并沒(méi)有具體介紹 GSM8K 是 5-shot 還是 8-shot(不過(guò)從其開源的評(píng)估工具可以看出是 8-shot+CoT 的結(jié)果,具體可以參考 ??https://github.com/QwenLM/Qwen/blob/main/eval/gsm8k_prompt.txt??),但是對(duì)應(yīng)的結(jié)果中 GPT-4 的 92.0 為 5-shot+CoT 結(jié)果,Mixtral-8x7B 的 74.4 確實(shí)為 8-shot+CoT 結(jié)果。

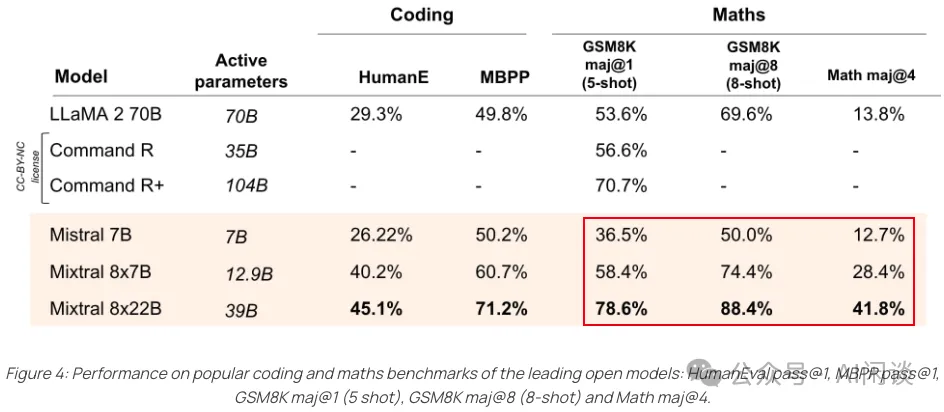

實(shí)際上 Mixtral 官方提供了相應(yīng) 5-shot 和 8-shot 的結(jié)果,如下圖 Figure 4 所示(Cheaper, Better, Faster, Stronger | Mistral AI | Frontier AI in your hands)其 Mixtral 8x7B 的 5-shot 結(jié)果只有 58.4:

如下圖 Table 3 所示,零一萬(wàn)物的 Yi 模型([2403.04652] Yi: Open Foundation Models by 01.AI)也存在同樣的情況,論文中介紹的是 GSM-8K 的 8-shot 結(jié)果,但是 GPT-3.5 和 GPT-4 的是 5-shot 的結(jié)果。此外 Mistral 7B 的 GSM-8K 和 MATH 結(jié)果也比上圖中 Mistral 的官方結(jié)果或者 [2310.06825] Mistral 7B 論文中的結(jié)果要低。

在浪潮的源 2.0-M32 [2405.17976] Yuan 2.0-M32: Mixture of Experts with Attention Router 中作者同樣將 8-shot 的 GSM-8K 結(jié)果與 5-shot 的 Mixtral-8x7B,Mixtral-8x22B 進(jìn)行比較,實(shí)際上兩個(gè)模型對(duì)應(yīng)的 8-shot 應(yīng)該為 74.4 和 88.4:

五、MATH

MATH 的評(píng)估相對(duì)比較統(tǒng)一,基本上都是 4-shot 的結(jié)果,但是 GPT-4o,GPT-4T 相關(guān)結(jié)果都是 0-shot 的,具體也可以參考 OpenAI 的評(píng)估腳本 GitHub - openai/simple-evals,此外 Claude 3 同時(shí)提供了 0-shot 和 4-shot 結(jié)果,如下圖所示:

六、GPQA

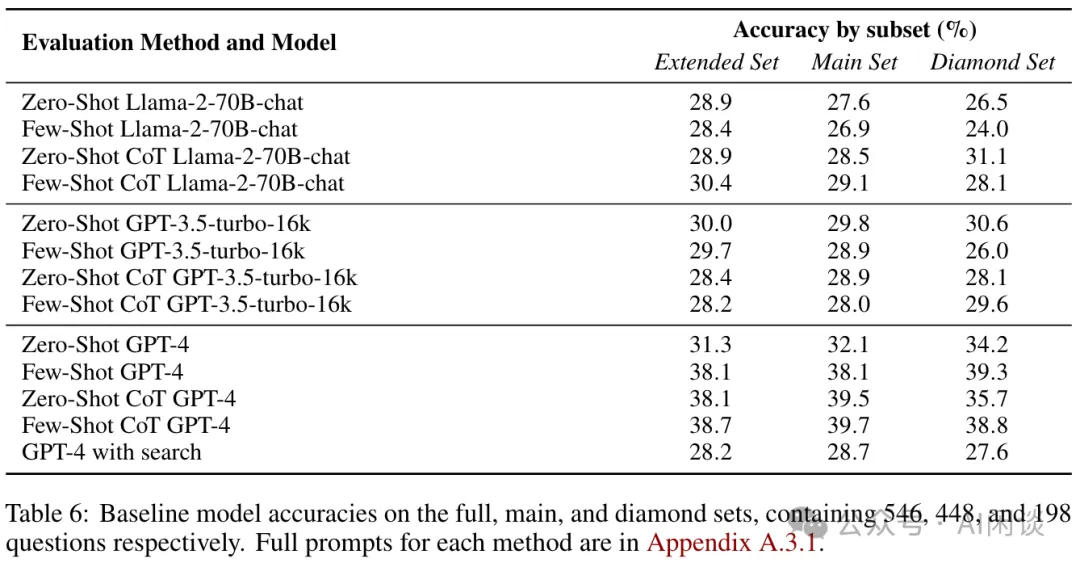

[2311.12022] GPQA: A Graduate-Level Google-Proof Q&A Benchmark 是一個(gè)比較新的評(píng)估集,是由生物、物理和化學(xué)領(lǐng)域的專家編寫的多項(xiàng)選擇題,問(wèn)題的質(zhì)量高且難度大。其全集 full(extended) 包含 546 個(gè)問(wèn)題,main 和 diamond 是對(duì)應(yīng)的兩個(gè)子集,分別包含 448 和 198 個(gè)問(wèn)題。如下圖 Table 6 所示為作者針對(duì) LLaMA-2-70B-Chat、GPT-3.5 和 GPT-4 的評(píng)估結(jié)果,可以看出,其也包含了 0-shot,0-shot+CoT,以及 few-shot+CoT 的配置:

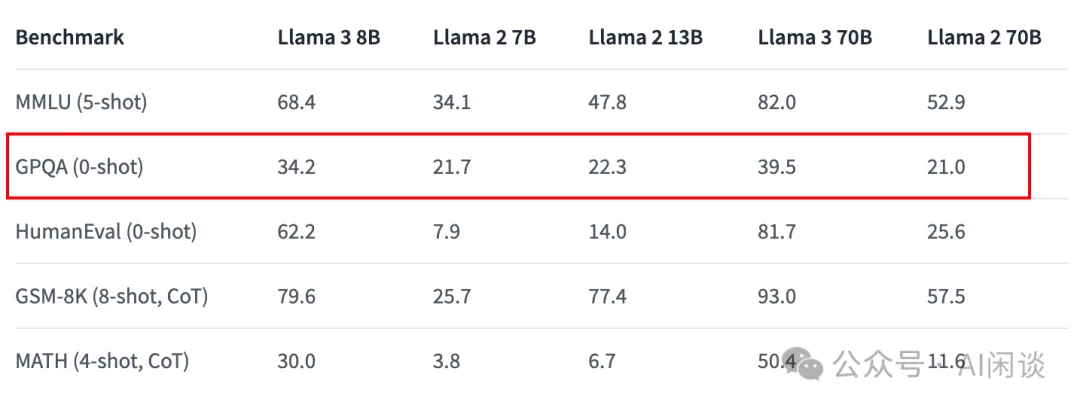

在 Meta 的 LLaMA-3 meta-llama/Meta-Llama-3-70B · Hugging Face 中,作者并未特別說(shuō)明使用的哪個(gè)集合,只介紹其為 GPQA(0-shot),不過(guò)在 llama3/eval_details.md at main 中提到是 Main 集合,并且沒(méi)有說(shuō)明使用 CoT,如下圖所示:

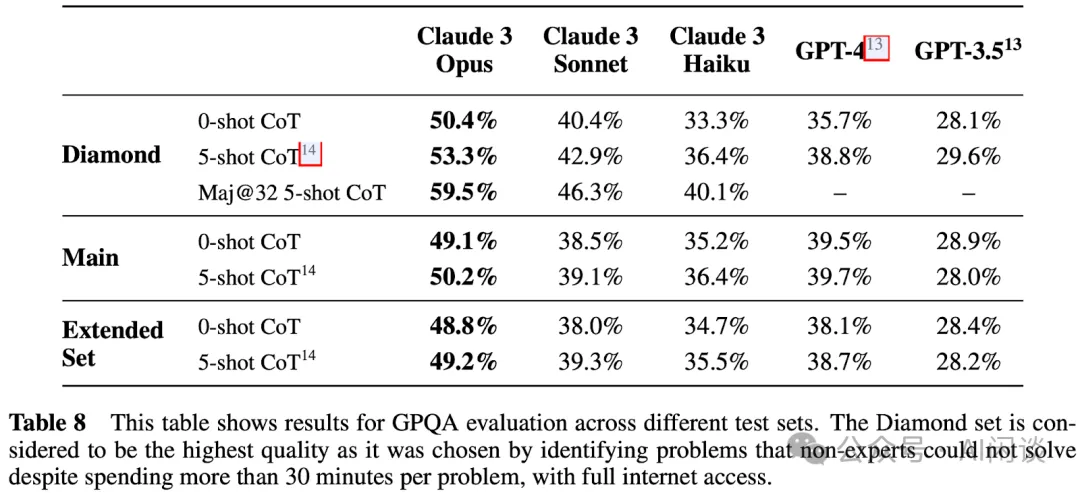

在 The Claude 3 Model Family: Opus, Sonnet, Haiku 中,作者給出了 Claude 3 在 3 個(gè)集合上詳細(xì)的評(píng)估結(jié)果:

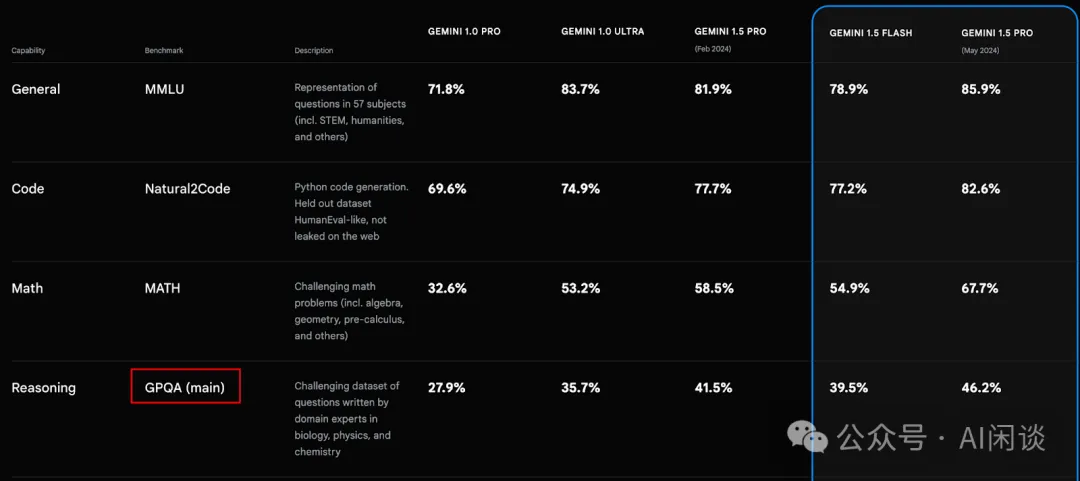

在 Gemini Pro - Google DeepMind 中,Google Gemini 提供了 main 集合下的評(píng)估結(jié)果:

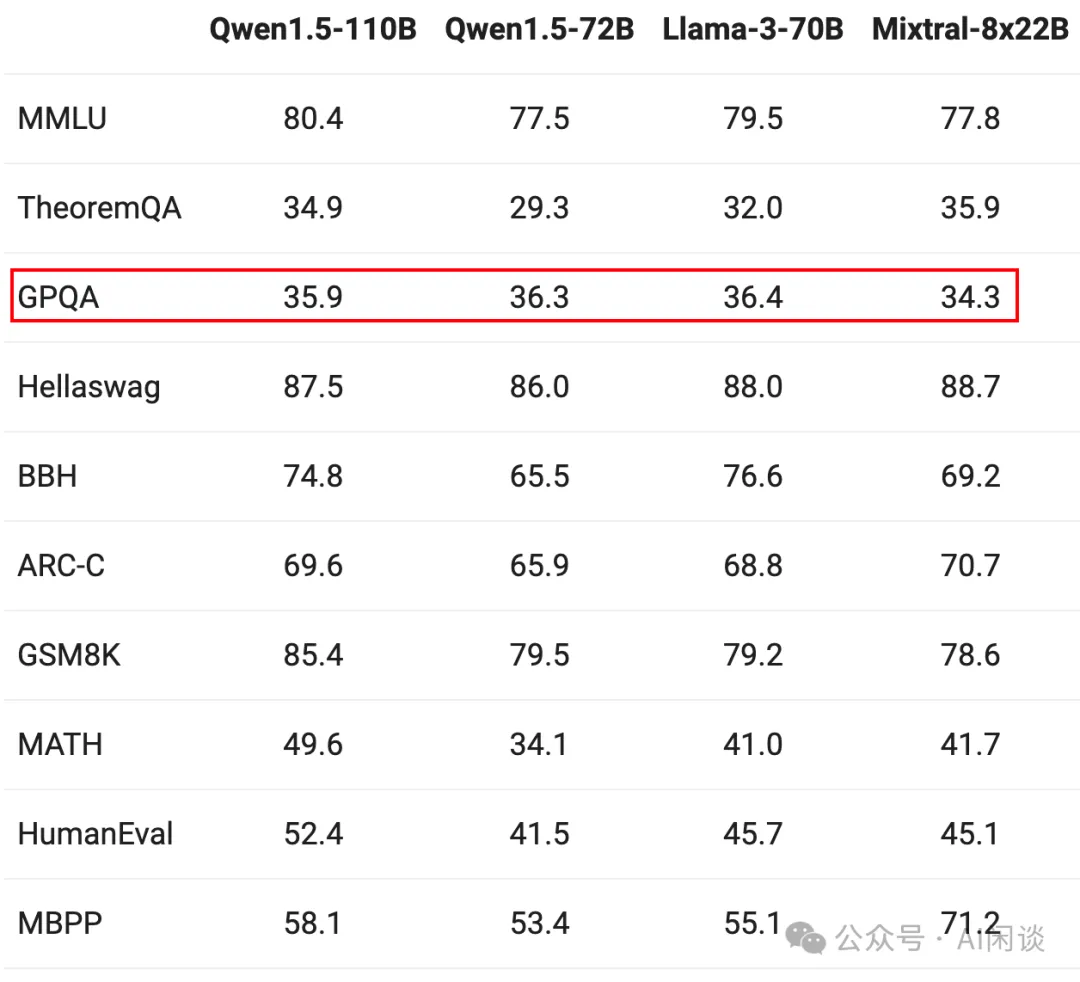

在阿里的通義千問(wèn) Qwen1.5-110B:Qwen1.5系列的首個(gè)千億參數(shù)開源模型| Qwen 中同樣沒(méi)有介紹 GPQA 對(duì)應(yīng)的集合,甚至未介紹是否是 0-shot:

七、HumanEval&BBH&HellaSwag&ARC-C&DROP

如下的幾個(gè)指標(biāo)相對(duì)比較統(tǒng)一,各個(gè)模型基本也都有相應(yīng)的結(jié)果,如下圖所示:

- HumanEval通常都是采用0-shot評(píng)估

- BIG-Bench Hard(BBH)通常采用3-shot+CoT評(píng)估

- HellaSwag通常采用10-shot評(píng)估

- ARC-C通常采用25-shot評(píng)估

- DROP通常采用3-shot評(píng)估?

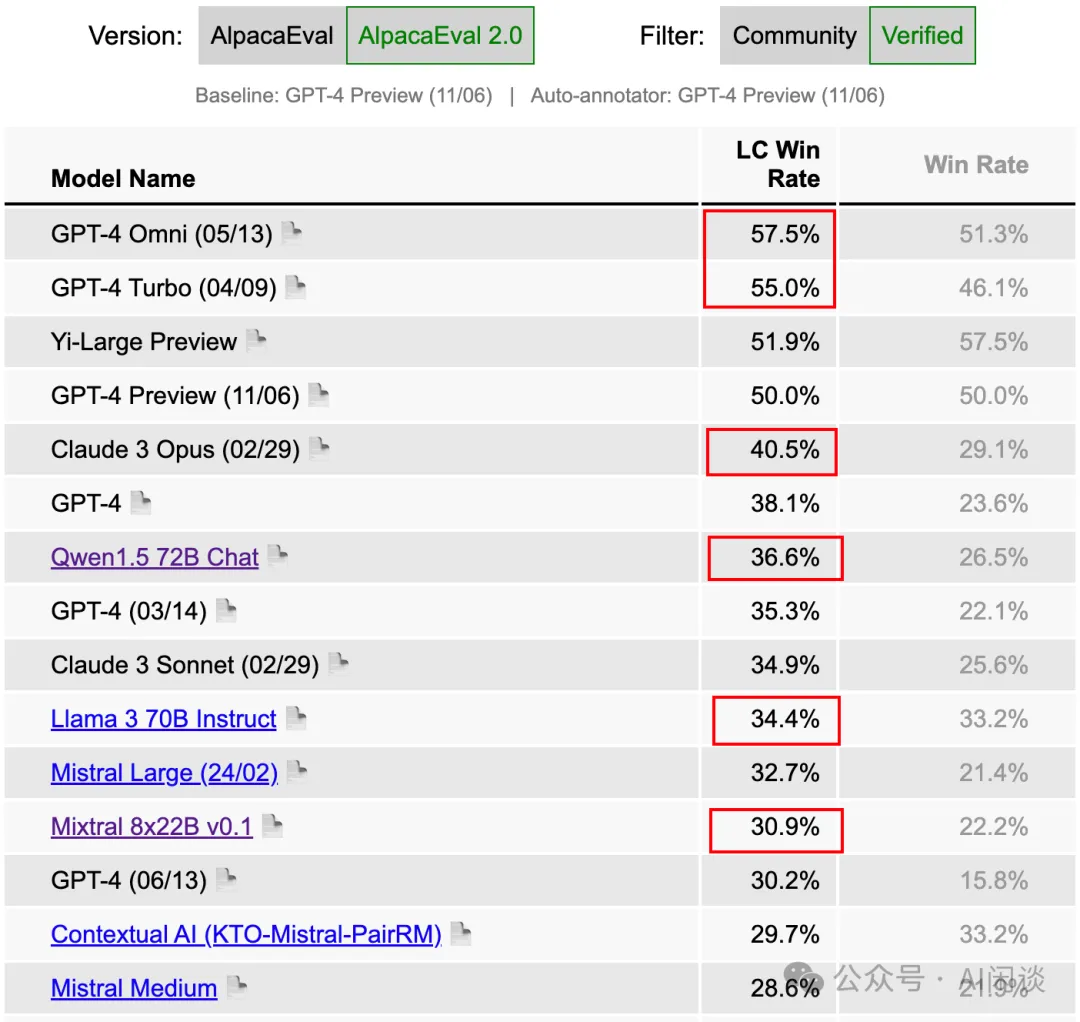

八、AlpacaEval 2.0

AlpacaEval 2.0 是一個(gè)指令遵循評(píng)估,它利用 LLM 來(lái)評(píng)估生成質(zhì)量。在 AlpacaEval 中,會(huì)傾向于生成較長(zhǎng)輸出的模型。因此,在 AlpacaEval 2.0 中,作者引入了長(zhǎng)度控制(Length-Controlled AlpacaEval),來(lái)緩解這種偏好。對(duì)應(yīng)的論文為:[2404.04475] Length-Controlled AlpacaEval: A Simple Way to Debias Automatic Evaluators。對(duì)應(yīng)的 Leaderboard 為:AlpacaEval Leaderboard。

九、LMSYS Chatbot Arena

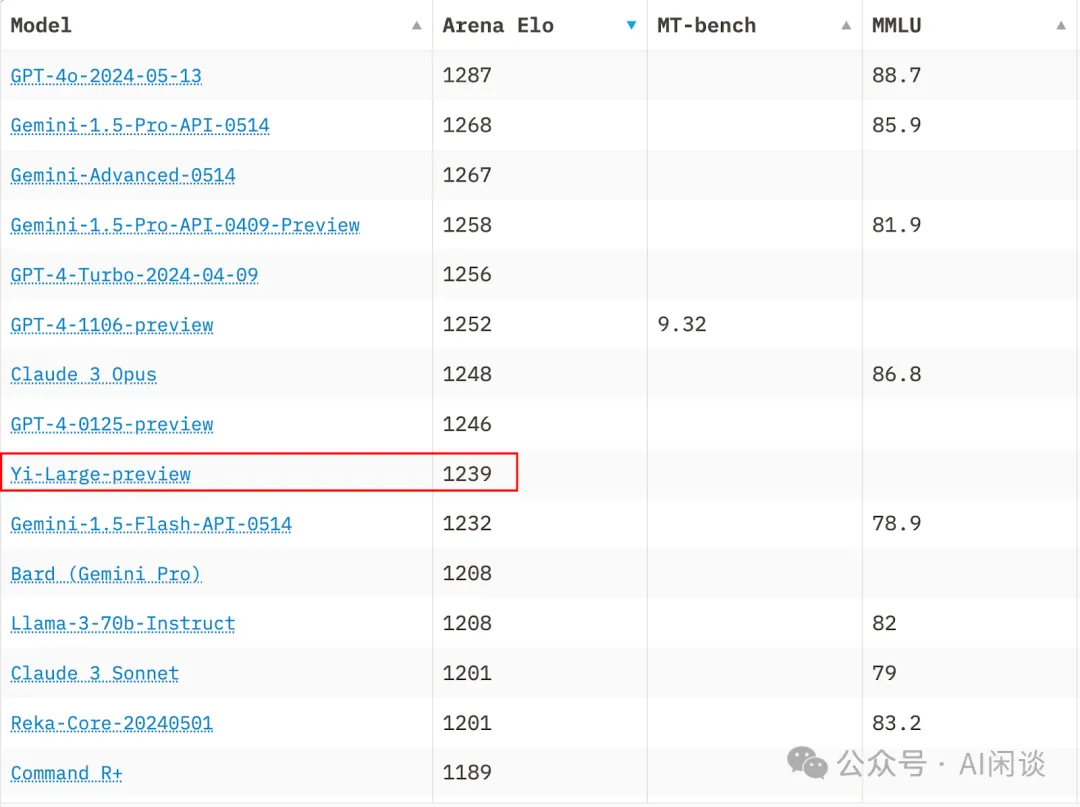

國(guó)外社區(qū)經(jīng)常會(huì)使用 Chatbot Arena(LMSys Chatbot Arena Leaderboard - a Hugging Face Space by lmsys)來(lái)評(píng)估 LLM 的能力。其相當(dāng)于大模型的競(jìng)技場(chǎng),都是通過(guò)真實(shí)用戶打分結(jié)果來(lái)評(píng)估人類對(duì)模型的偏好,其更接近真實(shí)用戶場(chǎng)景,也更加客觀。對(duì)應(yīng)的論文為:[2403.04132] Chatbot Arena: An Open Platform for Evaluating LLMs by Human Preference。這也是“零一萬(wàn)物 Yi-Large 在 LMSYS 中文榜單排名第一”的來(lái)源,如下圖所示為按照 Arena Elo 排序的結(jié)果(截止 2024-06-01):

在 Chatbot Arena 中也提供了 MT-bench 和 MMLU 的相關(guān)指標(biāo),如下圖所示為按照 MT-bench 排序的結(jié)果:

十、參考鏈接

- ??https://github.com/EleutherAI/lm-evaluation-harness??

- ??https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard??

- ??https://arxiv.org/abs/2211.09110??

- ??https://github.com/stanford-crfm/helm??

- ??https://github.com/openai/simple-evals??

- ??https://github.com/open-compass/OpenCompass/??

- ??https://rank.opencompass.org.cn/home??

- ??https://arxiv.org/abs/2205.11916??

- ??https://arxiv.org/abs/2201.11903??

- ??https://huggingface.co/meta-llama/Meta-Llama-3-70B??

- ??https://huggingface.co/spaces/lmsys/chatbot-arena-leaderboard??

- ??https://qwenlm.github.io/zh/blog/qwen1.5-110b/??

- ??https://arxiv.org/abs/2405.04434??

- ??https://arxiv.org/abs/2405.17976??

- ??https://crfm.stanford.edu/2024/05/01/helm-mmlu.html??

- ??https://arxiv.org/abs/2405.00332??

- ??https://arxiv.org/abs/2009.03300??

- ??https://www-cdn.anthropic.com/de8ba9b01c9ab7cbabf5c33b80b7bbc618857627/Model_Card_Claude_3.pdf??

- ??https://arxiv.org/abs/2403.05530??

- ??https://arxiv.org/abs/2303.08774??

- ??https://qwenlm.github.io/zh/blog/qwen1.5/??

- ??https://github.com/QwenLM/Qwen/blob/main/eval/gsm8k_prompt.txt??

- ??https://mistral.ai/news/mixtral-8x22b/??

- ??https://arxiv.org/abs/2403.04652??

- ??https://arxiv.org/abs/2311.12022??

- ??https://arxiv.org/abs/2404.04475??

- ??https://tatsu-lab.github.io/alpaca_eval/??

- ??https://arxiv.org/abs/2403.04132???

本文轉(zhuǎn)載自 ??AI閑談??,作者: AI閑談