上海交大&阿里巴巴推出虛擬試衣新里程碑式工作——AnyFit:任意場景、任意組合! 精華

文章鏈接:https://arxiv.org/pdf/2405.18172

工程鏈接:https://colorful-liyu.github.io/anyfit-page/

今天和大家一起學習的是一種名為AnyFit的新型虛擬試穿系統,旨在解決現有技術在處理不同場景和服飾組合時出現的衣物風格不匹配和質量下降問題。通過引入輕量級、可擴展的Hydra Block操作符和并行注意力機制,AnyFit能夠有效地將多種服飾特征注入主網絡,實現高保真度的試穿效果。此外,通過合成多個模型的殘差和實施mask區域增強策略,AnyFit顯著提高了模型在真實世界場景中的魯棒性和表達能力。實驗結果表明,AnyFit在高清基準測試和實際數據上均超越了現有技術,能夠生成細節豐富且逼真的試穿圖像。

主要貢獻

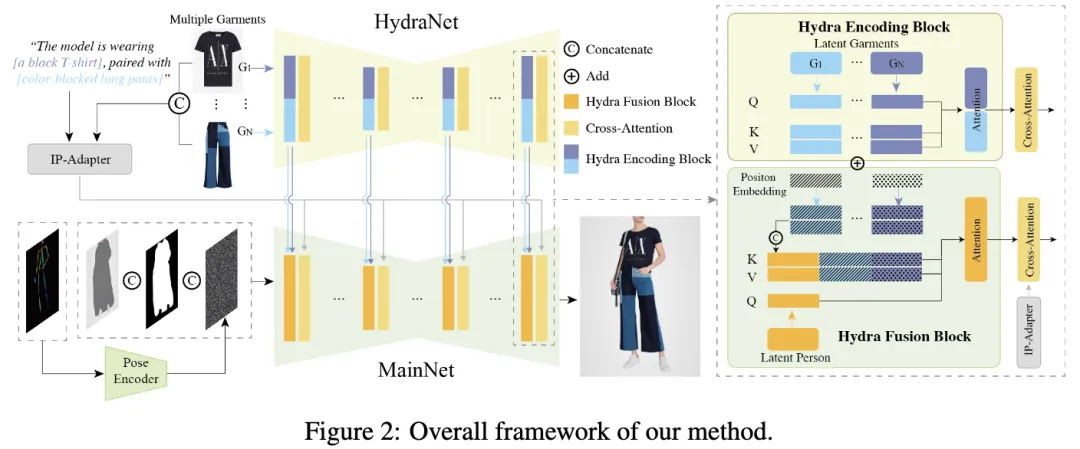

確立AnyFit為一種新穎的虛擬試衣(VTON)范式,能夠熟練應對各種場景下任意服裝組合的挑戰,如下圖1所示。AnyFit主要由兩個同構的U-Net組成,即HydraNet和MainNet。前者負責提取細粒度的服裝特征,而后者負責生成試穿效果。

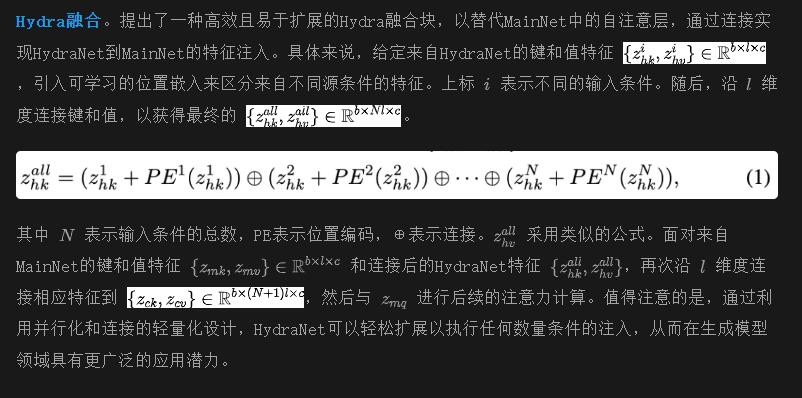

可擴展性:AnyFit的一個顯著特點是創新引入了Hydra編碼塊,僅在共享的HydraNet中并行化注意力矩陣,從而使每增加一個分支參數量僅增加8%,即可輕松擴展到任何數量的條件。這種并行化提案基于以下洞察:只有自注意力層對于隱式變形至關重要,其余組件主要作為通用特征提取器。研究者們進一步發明了Hydra融合塊,以無縫整合Hydra編碼的特征到MainNet中,并通過位置嵌入區分來自不同來源的編碼。需要注意的是,當僅限于單一條件時,ReferenceNet或GarmentNet可以視為HydraNet的特定實例。

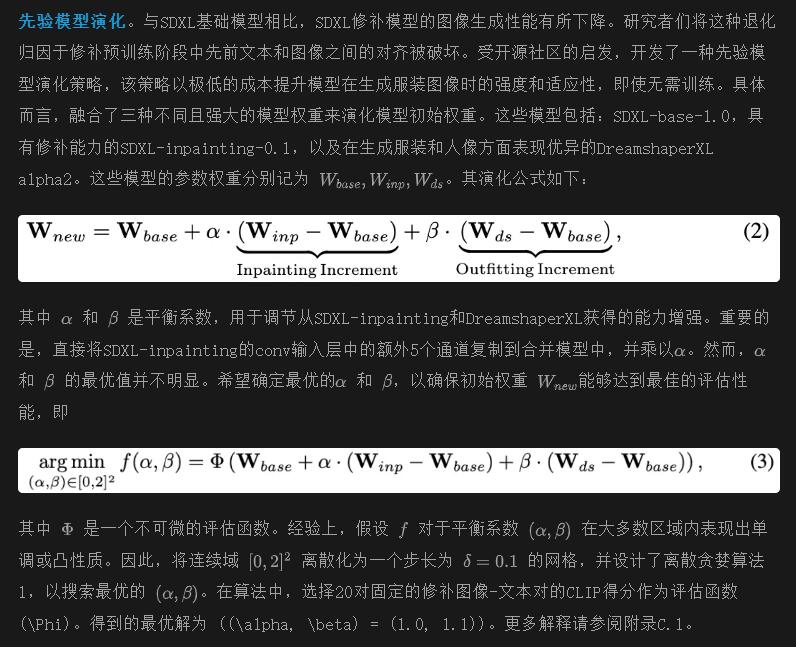

穩健性:觀察表明,現有虛擬試穿(VTON)工作生成的圖像在穩健性和質量上明顯低于原始穩定擴散表現。受社區討論的啟發,提出了先驗模型演化策略。這種創新方法涉及在模型家族(例如,一系列微調版本的SDXL)內合并參數變化,使得基礎模型的多種能力能夠獨立演化。在訓練前放大模型固有潛力,這種策略被證明為直觀且高效的方法,特別是當面對雙U-Net訓練成本顯著增加的問題時,這在之前的研究中被忽略。此外,引入了自適應mask增強,以進一步優化服裝的合身度。它需要在訓練階段延長無解析mask區域的長度,使模型能夠自主理解服裝的整體形狀,從而擺脫之前依賴于服裝mask提示的局限。在推理過程中,根據目標服裝的縱橫比調整mask區域的形狀,從而顯著提升試穿效果,特別是對于長款服裝(如風衣)。

方法

模型概述

可擴展性:為了保留服裝的細節,并支持單件和多件服裝的VTON,采用了一個鏡像MainNet的HydraNet來編碼服裝信息。它與MainNet共享相同的權重初始化,并根據條件數量并行化注意力矩陣,創建不同條件編碼的Hydra編碼塊。

穩健性:在訓練過程中,觀察到mask 信息泄漏和質量下降等問題。為了解決這些問題,分別采用了自適應mask 增強和先驗模型演化,這顯著增強了模型在不同場景下的穩健性,且成本效益高且簡單易行。

HydraNet用于多條件VTON

HydraNet。受在人像編輯領域成功實踐的啟發,本文引入了一個與主要生成網絡(MainNet)同構的服裝編碼網絡,以精確保留服裝的細節。在處理多服裝VTON時,一個直接的方法可能涉及復制多個服裝編碼網絡以管理不同的條件。然而,這種方法會導致參數數量顯著增加,使其計算量過于龐大。實驗表明,對于具有相似內容的條件(如不同類型的服裝),自注意模塊在隱變量變形和將服裝對齊到需要修補的位置方面起著至關重要的作用。相反,其他網絡結構通常負責一般特征提取,可以在不同條件編碼分支之間共享,而不會影響模型的性能。

通過模型演化和mask增強實現穩健的VTON

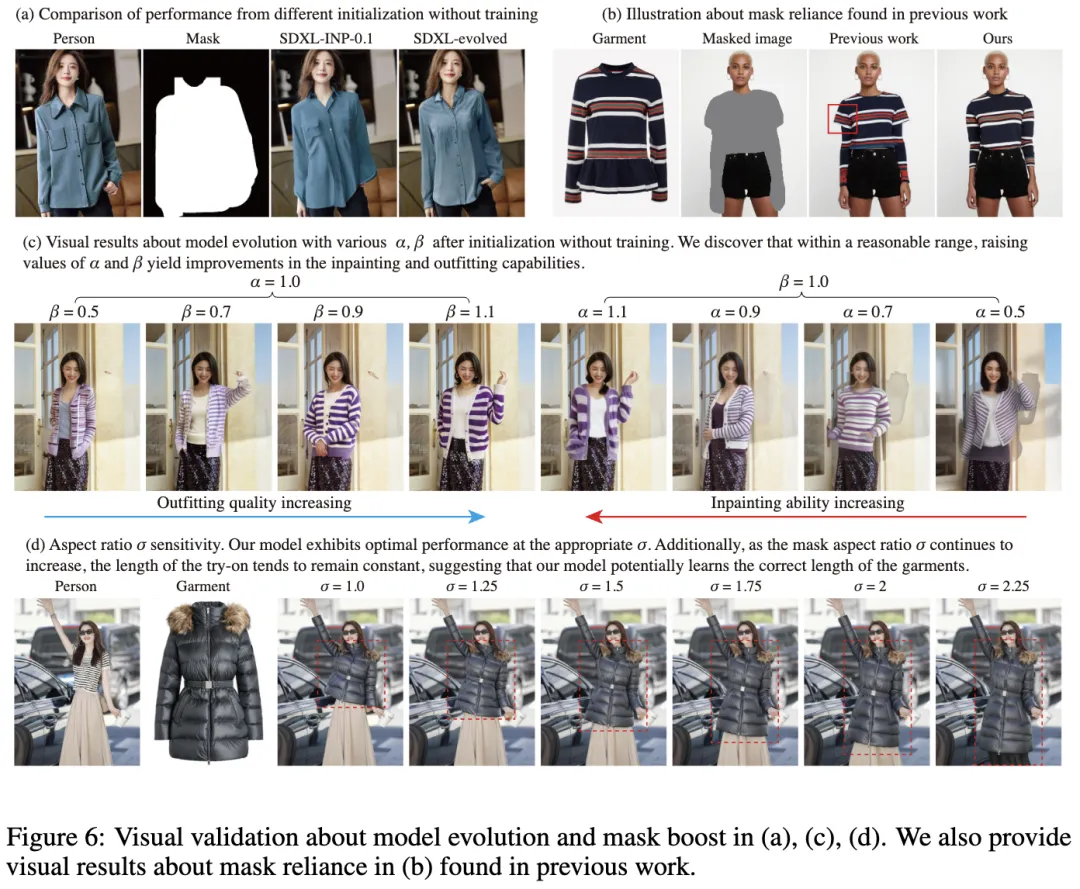

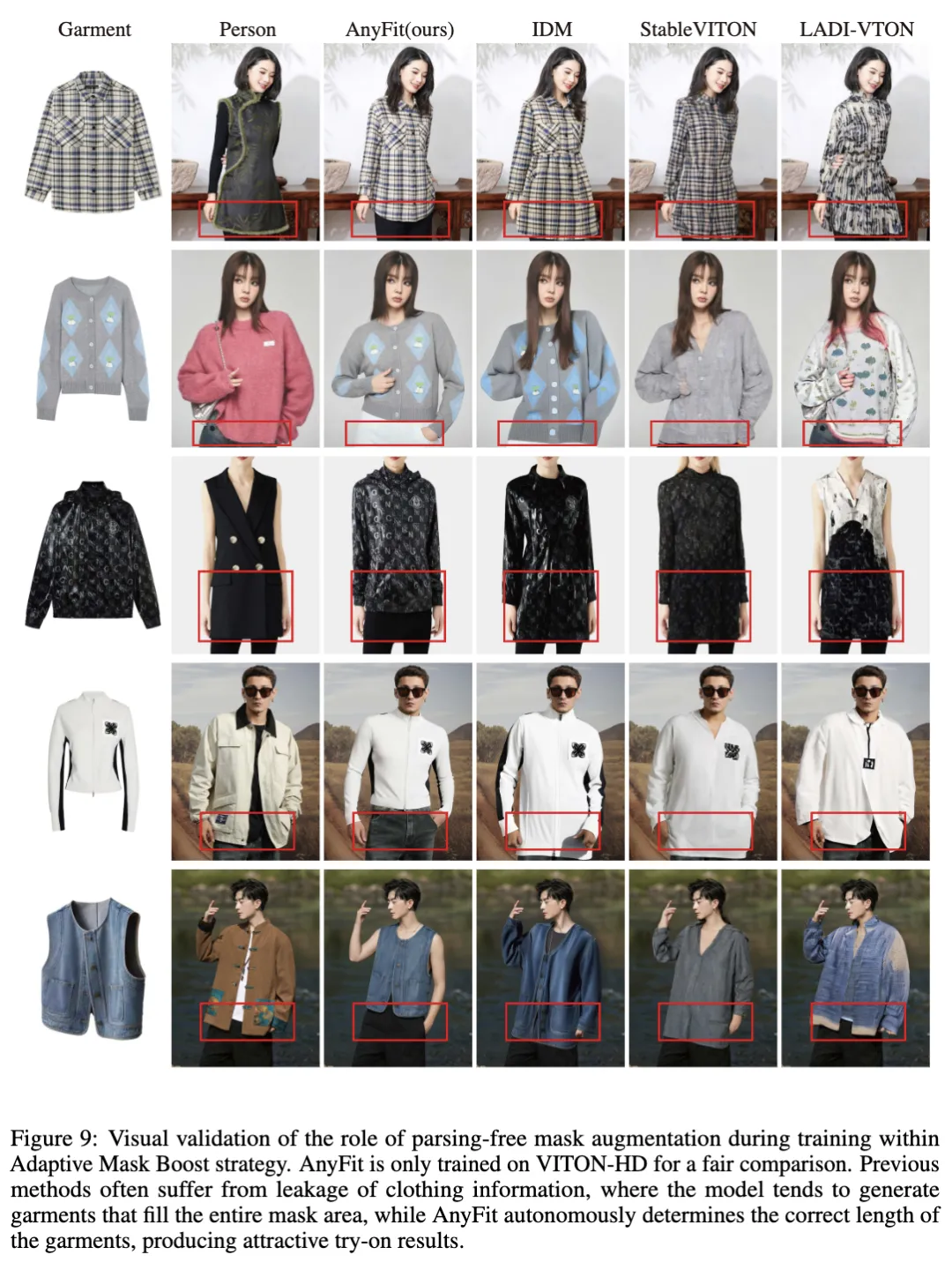

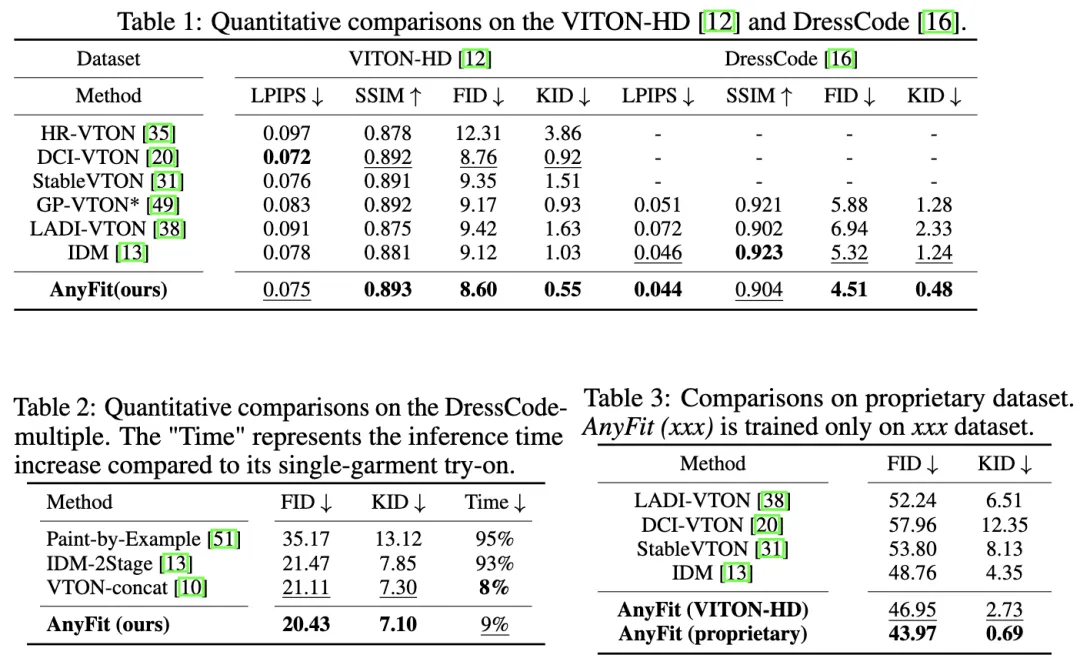

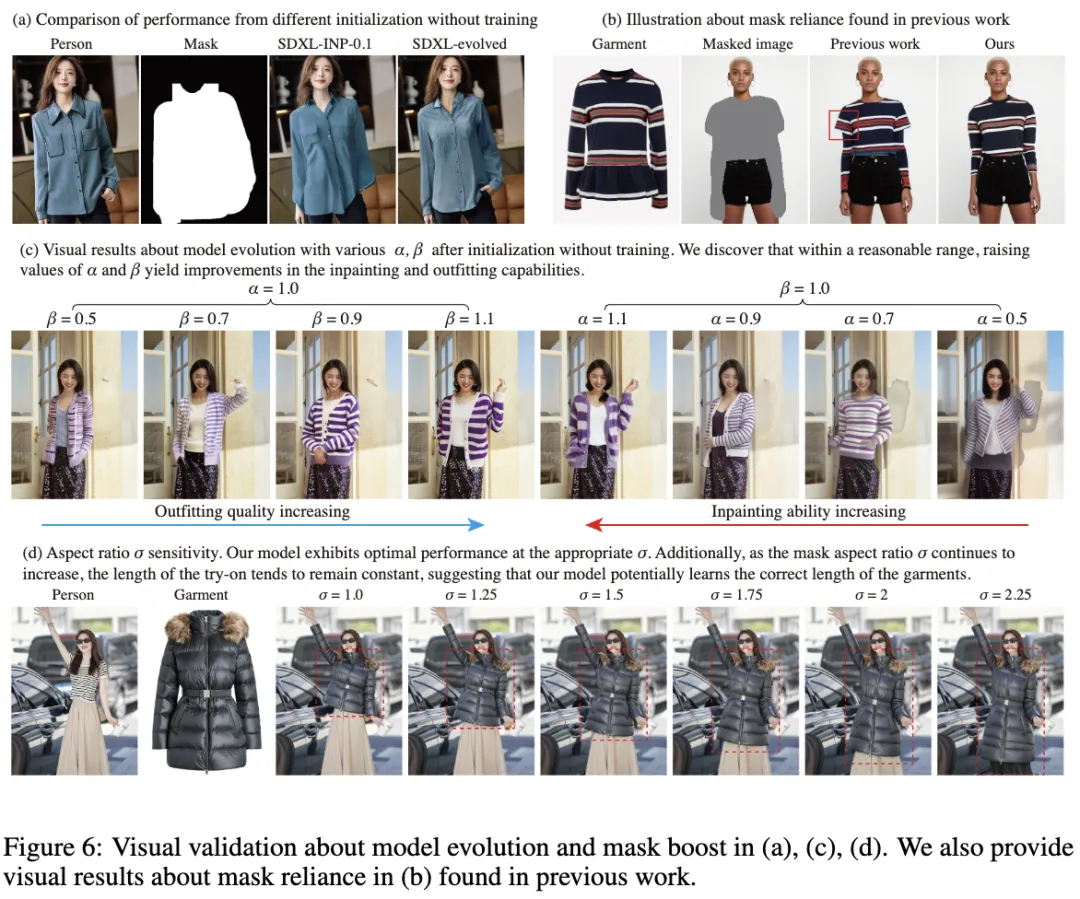

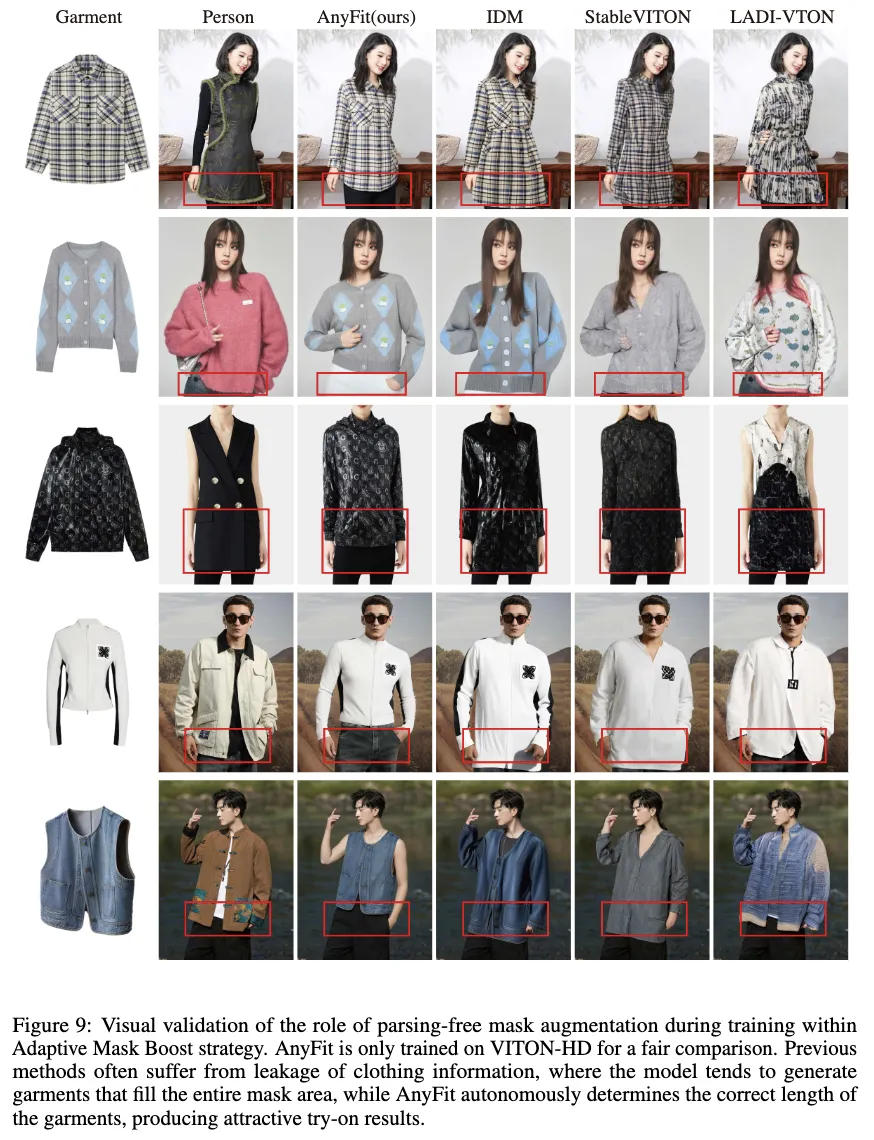

自適應mask增強。以前的工作在跨類別試穿場景中通常表現出有限的穩健性,導致渲染的服裝樣式不準確,如下圖6和圖9所示。這主要是由于依賴于從服裝解析中得出的無關mask ,這在訓練期間往往會泄露服裝形狀的邊緣。這種泄露可能導致生成的服裝幾乎完全覆蓋無關mask區域。針對這些局限性,采用了一種直觀且有效的方法,即自適應mask增強策略,大大增強了模型在跨類別試穿方面的穩健性。該策略主要包括訓練期間的mask增強和推理期間的自適應延長。

實驗

定性結果

單服裝試穿。圖3和圖4在VITON-HD、更具挑戰性的專有數據和野外數據上提供了AnyFit與基線方法的定性比較,涵蓋了開放服裝和分層渲染場景。為了與基線方法進行公平比較,包括了在VITON-HD上訓練的AnyFit的結果。AnyFit在保留復雜圖案細節方面表現出色,這歸功于HydraNet和IP-Adapter之間的有效協作。它還在語義級別上保持了正確的服裝輪廓。這表明,通過mask 增強,AnyFit增強了對服裝原始形狀的回憶,而其他受mask 影響的模型往往會生成不正確的外觀。先前的模型演化進一步增強了服裝的紋理表示。值得注意的是,當在專有數據集上訓練時,AnyFit會根據姿勢自動填充內衣或解開衣物,而在VITON-HD上訓練的版本則因缺乏此類訓練數據而無法做到。

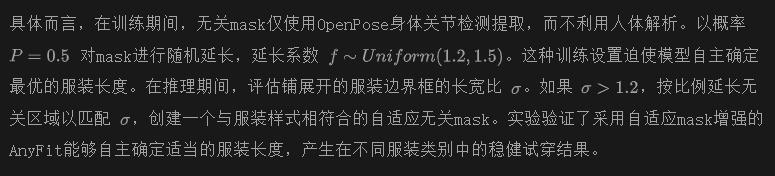

多服裝試穿。下圖5提供了使用編譯的DressCode-multiple數據集進行多服裝試穿的定性比較。首先,AnyFit展示了高保真的布料保留。由于位于不同條件分支中的獨特和個體的Hydra-Blocks,AnyFit準確地描繪了上衣和下衣之間的分界線,并展示了連接處的合理過渡。相比之下,VTON-concat在串聯后處理相對服裝尺寸時處理不當,導致服裝失真和模糊。與此同時,IDM-2Stage在上下衣交接處面臨著偽影,因為在試穿一個服裝時,它會掩蓋另一個服裝的部分。值得注意的是,盡管訓練時一個服裝呈現為平鋪圖像,另一個服裝為從人物圖像裁剪的扭曲布料,但在推理時,AnyFit在面對兩種都作為平鋪圖像呈現的服裝時仍然表現出色。

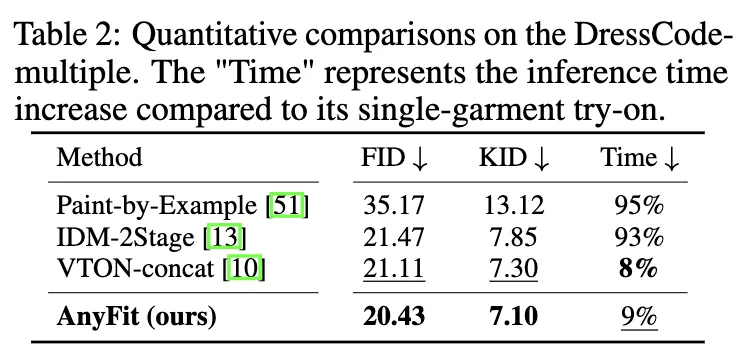

定量結果

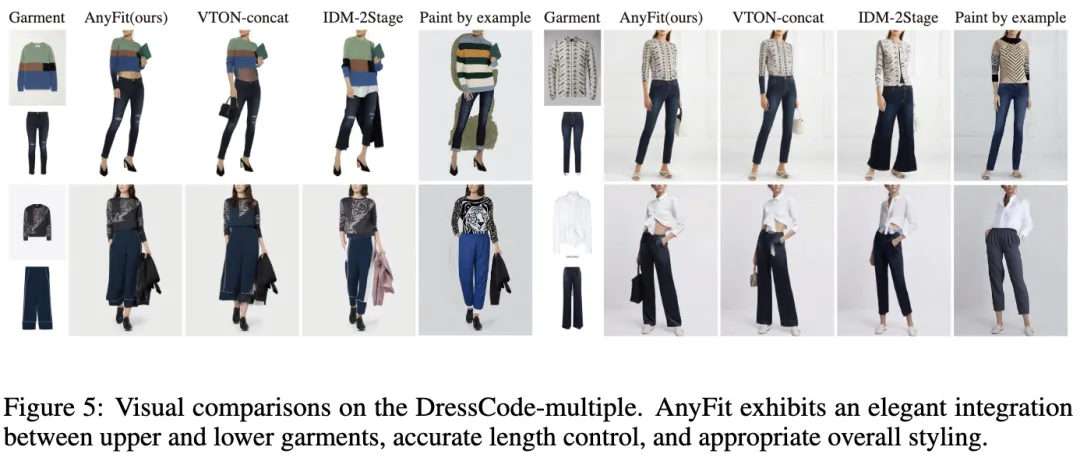

如下表1、2、3所示,在VITON-HD、DressCode、專有數據集和DressCode-multiple上進行了廣泛的實驗,結果一致表明AnyFit顯著優于所有基線方法。這證實了AnyFit在單件服裝和多件服裝任務中在各種場景下提供優越的試穿質量的能力。此外,注意到AnyFit在未配對設置下在FID和KID指標方面顯示出顯著改善,展示了本文模型在跨類別試穿中的魯棒性。

消融研究

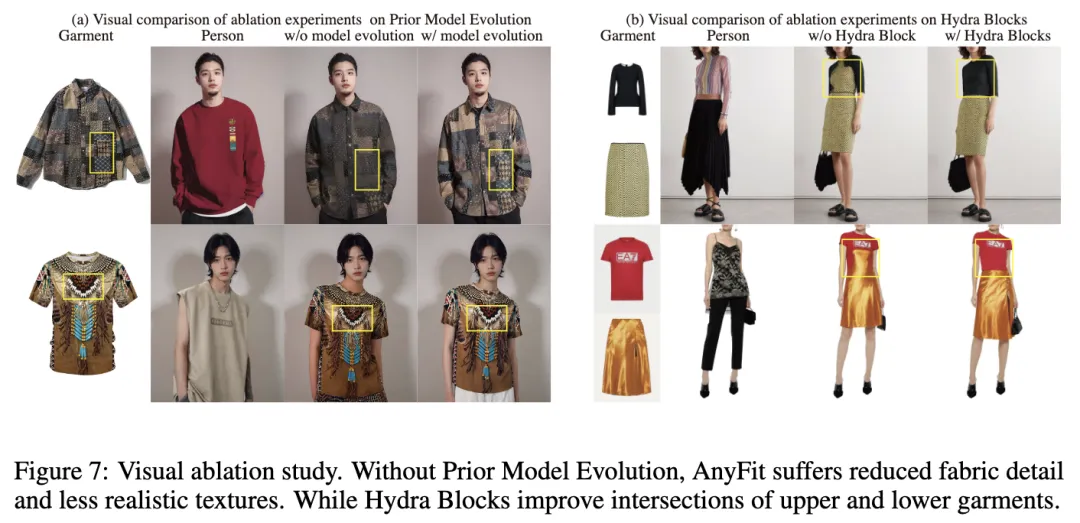

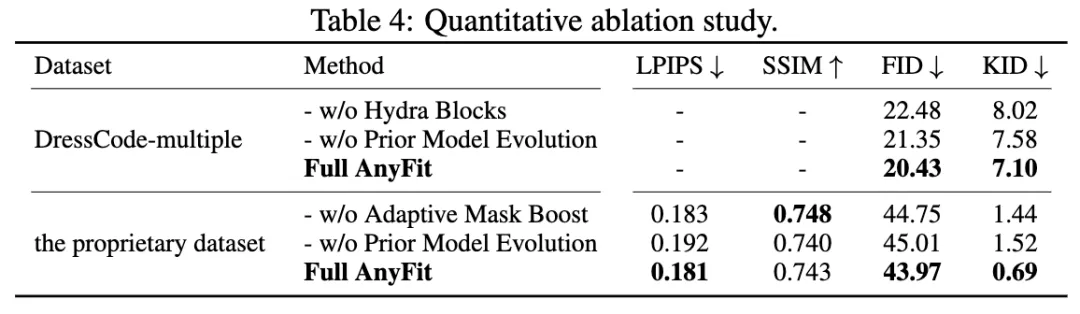

Hydra Blocks。為驗證本文提出的Hydra Blocks的有效性,直接使用一個條件化的單一HydraNet作為基線“w/o Hydra Block”,實際上退化為ReferenceNet,同時編碼頂部和底部服裝條件,然后將它們連接到MainNet中。如下表4、圖7和10所示,缺乏Hydra Block的模型往往在上衣和下衣交接處產生偽影。這些模型還經常允許一個服裝的特征影響另一個,導致不正確的服裝風格。然而,引入Hydra Block后,AnyFit始終展現出更穩定的結果。

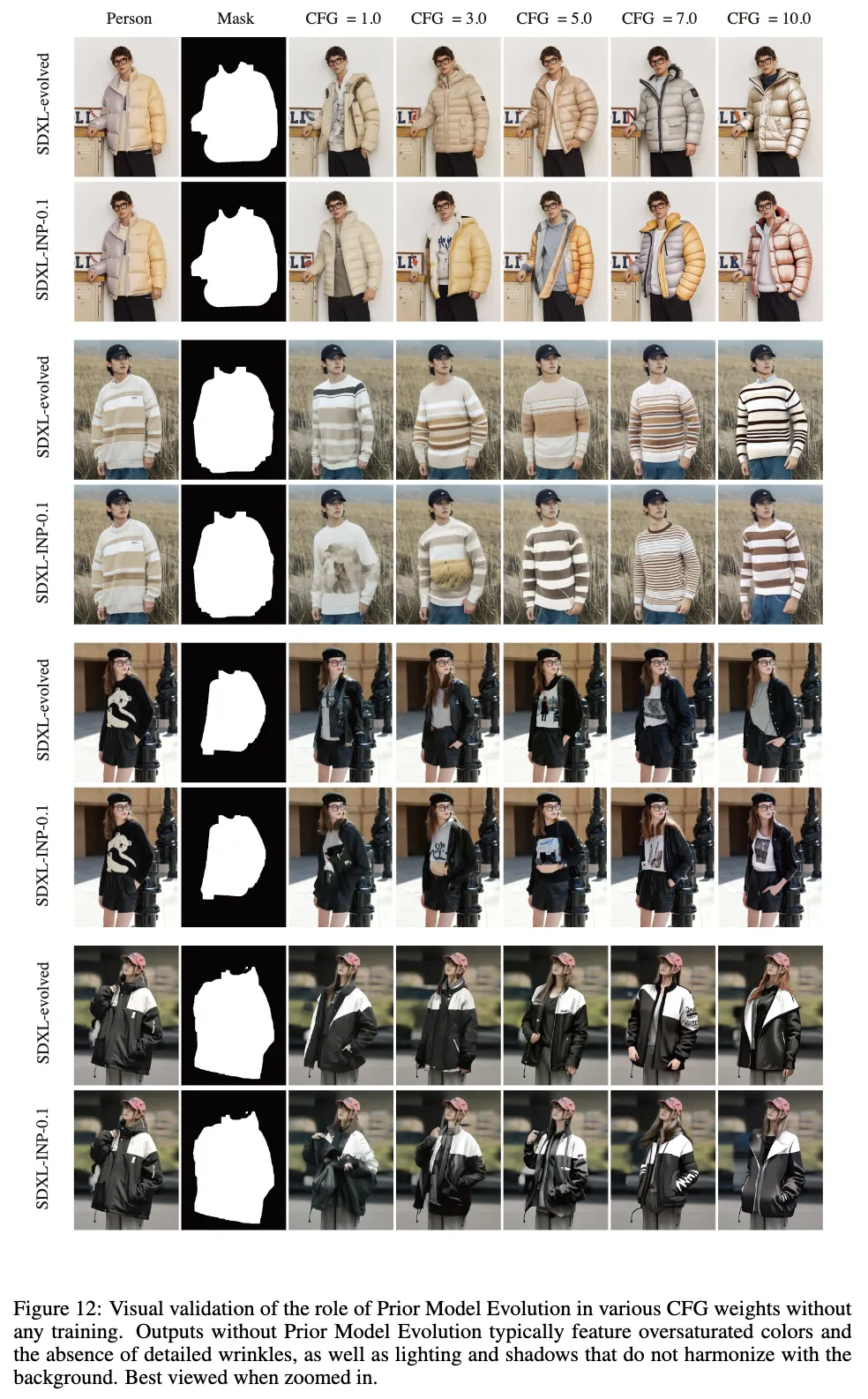

Prior Model Evolution。在下圖12和6(a)中定性展示了Prior Model Evolution的效果。SDXL-evolved模型顯著減少了偽影,并顯著增強了魯棒性,而沒有Prior Model Evolution的輸出通常具有過度飽和的顏色,以及與背景不協調的光照和陰影。模型能力的逐步增強在圖6(c)中可視化。還在圖7和表4中從經驗和定量上驗證了Prior Model Evolution策略的有效性。通過增強模型的初始能力,Prior Model Evolution減少了學習的難度,并顯著提升了服裝裝配能力和標志保真度。

Adaptive Mask Boost。在上圖6(b)和下圖9中圖示展示了先前方法中發現的信息泄露和mask 依賴的問題。在表4和圖9中經驗和定量上驗證了Adaptive Mask Boost策略的有效性。該策略顯著增強了模型對不同服裝類別的魯棒性,使其能夠自主確定適當的服裝長度,而不是依賴于mask 。此外,在推理過程中手動調整了長寬比σ,顯示了自適應延伸的積極影響。

結論

AnyFit,這是一個適用于任何場景下任意服裝組合的新穎而強大的VTON pipeline,為實現逼真的試穿效果邁出了關鍵性的一步。為支持多件服裝試穿,AnyFit構建了具有輕量級和可擴展并行化注意力的HydraNet,促進了多件服裝的特征注入。通過在真實場景中觀察到的偽影,通過合成多模型的殘差以及實施mask區域增強策略來提升其潛力。對高分辨率基準和真實數據的全面實驗表明,AnyFit在各方面顯著超越了所有基線方法。

更廣泛的影響

隨著生成圖像的能力,AnyFit可能被用于違反知識產權或隱私規范的不當目的。因此,基于這些風險,強烈主張謹慎使用這項技術。

本文轉自 AI生成未來 ,作者:Yuhan Li等