能訓(xùn)出SOTA模型的優(yōu)質(zhì)數(shù)據(jù)集發(fā)布!復(fù)旦最新VidGen-1M: 文生視頻還得靠好數(shù)據(jù)

論文鏈接:https://arxiv.org/pdf/2408.02629

項(xiàng)目鏈接:https://sais-fuxi.github.io/projects/vidgen-1m/

git鏈接:https://github.com/SAIS-FUXI/VidGen

亮點(diǎn)直擊

- 引入了一個(gè)專門(mén)用于訓(xùn)練文本到視頻模型的高質(zhì)量視頻數(shù)據(jù)集。

- 提出了一種多階段策展方法,在有限計(jì)算資源下實(shí)現(xiàn)精準(zhǔn)且高質(zhì)量的數(shù)據(jù)策展。

- 發(fā)布了本文的文本到視頻模型,該模型生成的高質(zhì)量視頻在性能上超越了當(dāng)前最先進(jìn)的方法。

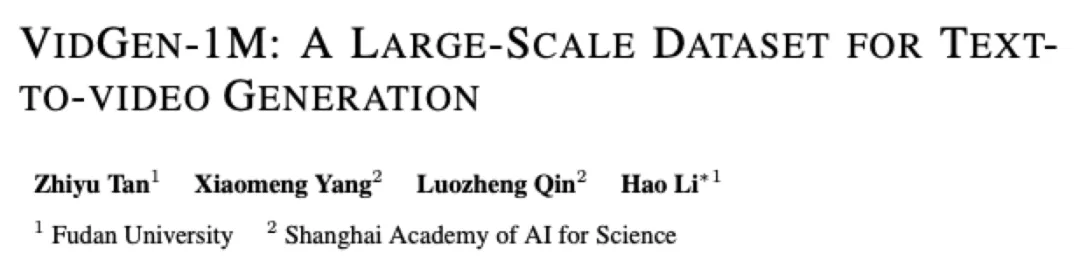

視頻-文本對(duì)的質(zhì)量從根本上決定了文本到視頻模型的上限。目前,用于訓(xùn)練這些模型的數(shù)據(jù)集存在顯著缺陷,包括低時(shí)間一致性、低質(zhì)量的字幕、低質(zhì)量的視頻以及數(shù)據(jù)分布不平衡。現(xiàn)行的視頻策展過(guò)程依賴于圖像模型進(jìn)行標(biāo)記和基于規(guī)則的人工策展,導(dǎo)致計(jì)算負(fù)擔(dān)高且數(shù)據(jù)不干凈。因此,缺乏適合文本到視頻模型的訓(xùn)練數(shù)據(jù)集。為了解決這個(gè)問(wèn)題,本文提出了VidGen-1M,這是一個(gè)優(yōu)質(zhì)的文本到視頻模型訓(xùn)練數(shù)據(jù)集。通過(guò)粗到細(xì)的策展策略生成,該數(shù)據(jù)集保證了高質(zhì)量的視頻和具有優(yōu)良時(shí)間一致性的詳細(xì)字幕。在用于訓(xùn)練視頻生成模型時(shí),該數(shù)據(jù)集的實(shí)驗(yàn)結(jié)果超越了使用其他模型所獲得的結(jié)果。

方法

在構(gòu)建VidGen的過(guò)程中,本文利用了來(lái)自HD-VILA數(shù)據(jù)集的380萬(wàn)高分辨率、長(zhǎng)時(shí)段視頻。隨后,這些視頻被分割成1.08億個(gè)視頻片段。接下來(lái),本文對(duì)這些視頻片段進(jìn)行了標(biāo)注和采樣。然后,使用VILA模型進(jìn)行視頻字幕生成。最后,為了糾正前幾個(gè)步驟中的數(shù)據(jù)整理錯(cuò)誤,本文部署了LLM進(jìn)行進(jìn)一步的字幕整理。

粗略策展

為了在有限的計(jì)算資源下實(shí)現(xiàn)高效的數(shù)據(jù)整理,本文首先采用粗略的整理方法。這包括場(chǎng)景分割、視頻標(biāo)注、過(guò)濾和采樣,以減少后續(xù)字幕生成和精細(xì)整理階段的計(jì)算負(fù)擔(dān)。

場(chǎng)景分割

運(yùn)動(dòng)不一致性,例如場(chǎng)景變化和漸變,常常在原始視頻中出現(xiàn)。然而,由于運(yùn)動(dòng)不一致性直接切斷了視頻語(yǔ)義,文本到視頻模型對(duì)其非常敏感并容易混淆,導(dǎo)致訓(xùn)練效率大幅降低。為了減輕這種影響,本文遵循之前的研究,以級(jí)聯(lián)方式利用 PySceneDetect 檢測(cè)和移除原始視頻中的場(chǎng)景轉(zhuǎn)換。

標(biāo)注

構(gòu)建適合訓(xùn)練文本到視頻模型的數(shù)據(jù)集需要滿足以下標(biāo)準(zhǔn):高質(zhì)量視頻、類別平衡和視頻內(nèi)的強(qiáng)時(shí)間一致性。為了實(shí)現(xiàn)這一目標(biāo),本文首先需要對(duì)每個(gè)分割的視頻片段進(jìn)行標(biāo)注。隨后,這些標(biāo)簽將作為策劃和采樣的基礎(chǔ)。

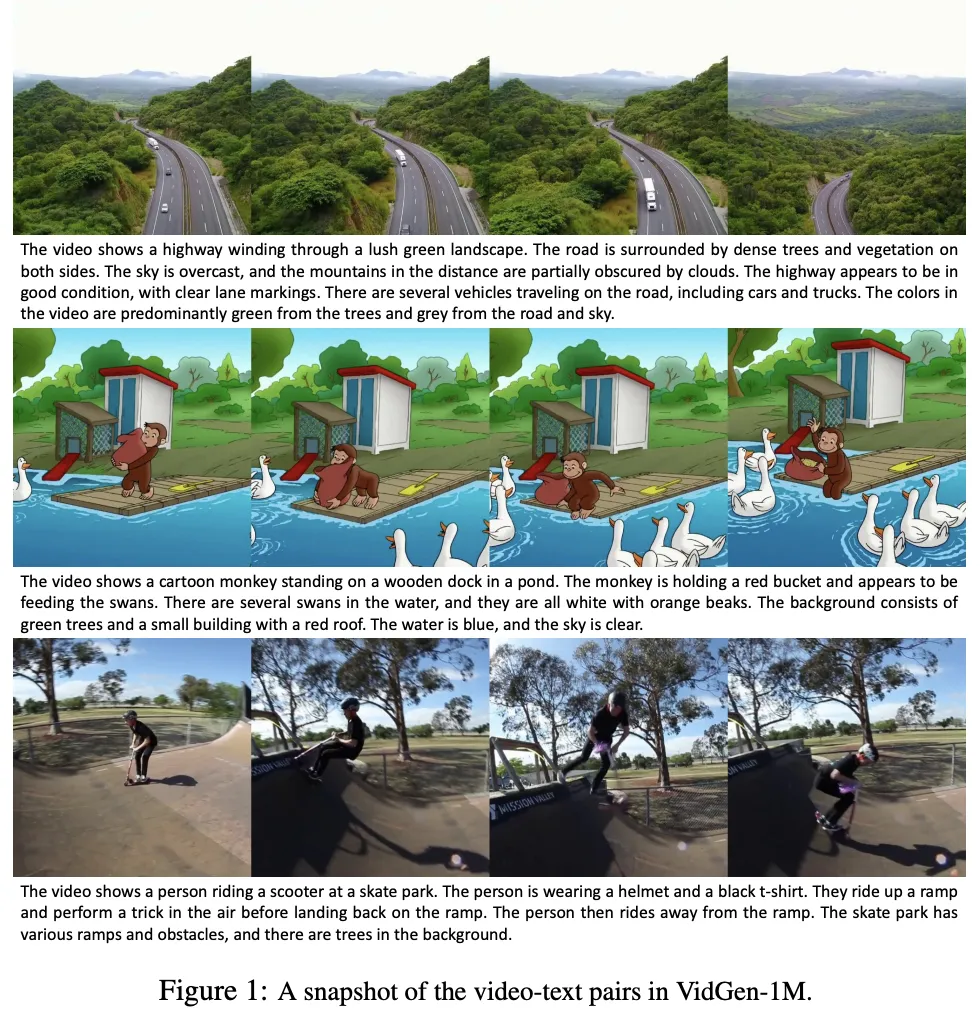

視頻質(zhì)量 視頻的視覺(jué)質(zhì)量對(duì)于高效訓(xùn)練文本到視頻模型至關(guān)重要。為了提高文本到視頻生成中生成視頻的質(zhì)量,本文采用了一種策略,過(guò)濾掉低美學(xué)吸引力和高OCR分?jǐn)?shù)的視頻。在這種情況下,本文采用LAION美學(xué)模型來(lái)預(yù)測(cè)和評(píng)估美學(xué)分?jǐn)?shù),從而確保訓(xùn)練數(shù)據(jù)的高質(zhì)量。特別是,美學(xué)模型還可以過(guò)濾掉視覺(jué)異常的視頻,例如色彩分布不規(guī)則或視覺(jué)元素奇怪的視頻。

時(shí)間一致性 視頻中的錯(cuò)誤場(chǎng)景分割會(huì)顯著影響模型訓(xùn)練的效果。高時(shí)間一致性是訓(xùn)練文本到視頻模型所需的關(guān)鍵特征。為確保這一點(diǎn),本文利用CLIP模型提取視覺(jué)特征并評(píng)估時(shí)間一致性。通過(guò)計(jì)算視頻片段的起始幀和結(jié)束幀之間的余弦相似度來(lái)實(shí)現(xiàn)這一評(píng)估,從而提供連續(xù)性和一致性的定量衡量。

類別 HD-VILA-100M視頻數(shù)據(jù)集在其類別上顯示出顯著的不平衡,導(dǎo)致這些類別的視頻生成模型性能不佳。為了解決這個(gè)問(wèn)題,本文使用預(yù)定義的類別標(biāo)簽來(lái)標(biāo)注每個(gè)視頻,并借助CLIP模型。具體來(lái)說(shuō),本文從每個(gè)視頻的初始、中間和最終幀中提取CLIP圖像特征,計(jì)算它們的平均值,然后確定這些平均圖像特征與每個(gè)標(biāo)簽相關(guān)的文本特征之間的相似性。這種方法使本文能夠?yàn)槊總€(gè)視頻分配最合適的標(biāo)簽。

運(yùn)動(dòng) 本文采用RAFT模型來(lái)預(yù)測(cè)視頻的光流分?jǐn)?shù)。由于靜態(tài)視頻和運(yùn)動(dòng)過(guò)快的視頻都會(huì)對(duì)訓(xùn)練文本到視頻模型產(chǎn)生不利影響,本文根據(jù)光流分?jǐn)?shù)過(guò)濾掉這些視頻。

采樣

通過(guò)使用與視覺(jué)質(zhì)量、時(shí)間一致性、類別和運(yùn)動(dòng)相關(guān)的標(biāo)簽,本文進(jìn)行了過(guò)濾和采樣任務(wù)。下圖2所展示的數(shù)據(jù)集中多個(gè)維度的數(shù)據(jù)分布清晰表明,低質(zhì)量、靜態(tài)場(chǎng)景、運(yùn)動(dòng)速度過(guò)快以及文本與視頻不匹配且時(shí)間一致性差的視頻被系統(tǒng)地移除。同時(shí),本文確保了在不同類別中樣本的相對(duì)均勻分布。

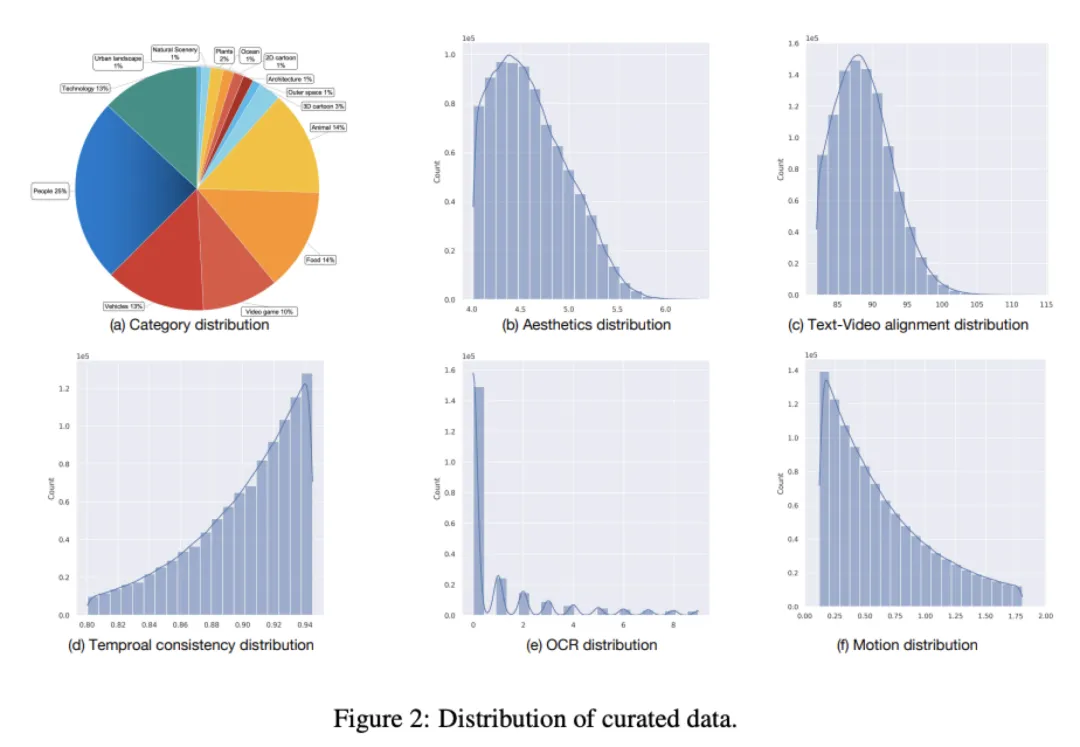

字幕

視頻字幕的質(zhì)量對(duì)文本到視頻模型有著至關(guān)重要的影響,而HD-VILA-100M數(shù)據(jù)集中的字幕存在一些問(wèn)題,包括文本與視頻之間的不匹配、描述不充分以及詞匯使用有限。為了提高字幕的信息密度,本文采用了最先進(jìn)的視覺(jué)語(yǔ)言模型VILA。由于VILA在視頻字幕生成方面的卓越能力,本文顯著提升了字幕的質(zhì)量。在生成字幕后,本文使用CLIP評(píng)分來(lái)過(guò)濾出文本與視頻相似度較低的對(duì)。本文在下表2中展示了詞匯分析,其中有效的不同名詞和有效的不同動(dòng)詞是指在數(shù)據(jù)集中出現(xiàn)超過(guò)10次的詞匯。利用VILA模型對(duì)HD-VILA-100M數(shù)據(jù)集進(jìn)行處理后,本文生成了增強(qiáng)版的HD-VILA-100M數(shù)據(jù)集。在Panda-70M數(shù)據(jù)集中,有270K個(gè)不同的名詞和76K個(gè)不同的動(dòng)詞;然而,只有16.1%和19.2%的名詞和動(dòng)詞分別符合有效性標(biāo)準(zhǔn)。使用VILA生成的字幕顯著提高了有效比例以及每個(gè)視頻中名詞和動(dòng)詞的平均數(shù)量,從而增加了概念密度。

精細(xì)策展

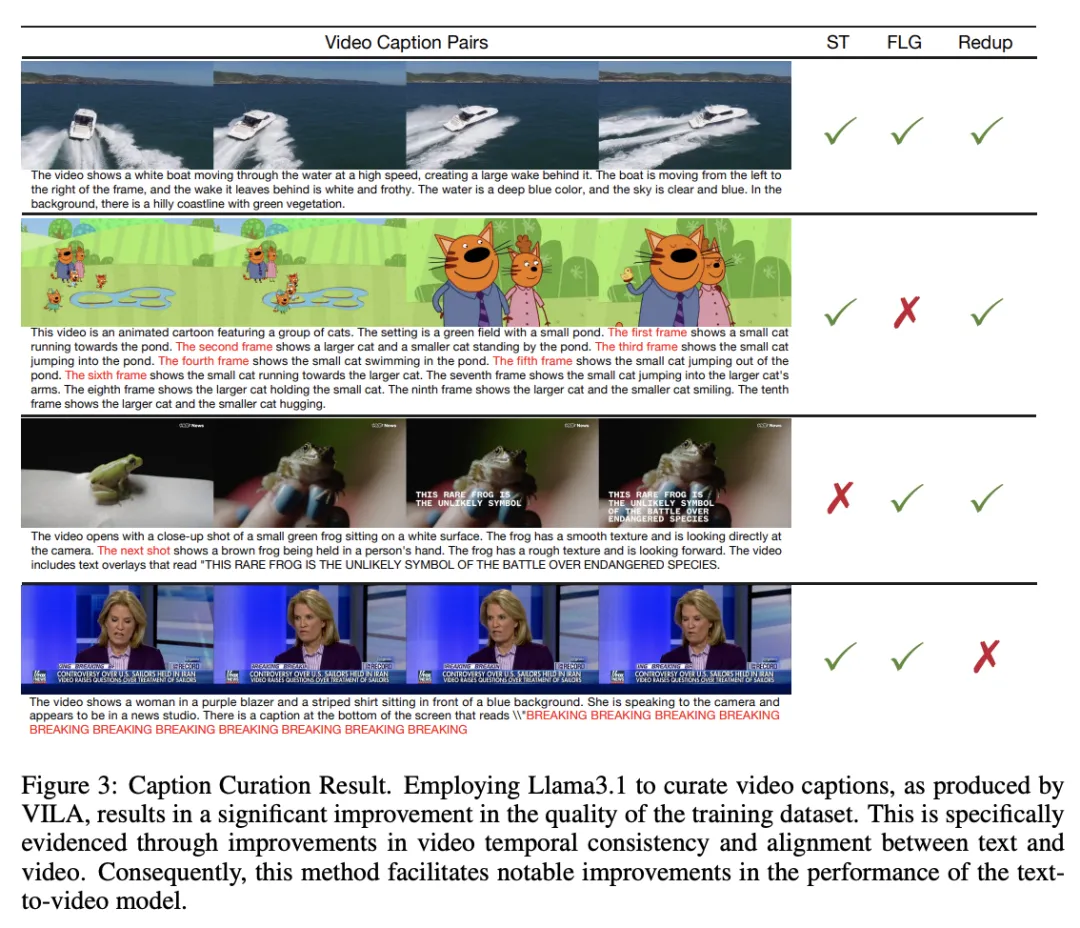

在粗略策展和字幕生成階段,使用CLIP評(píng)分過(guò)濾文本-圖像對(duì)齊和時(shí)間一致性可以去除一些不一致的數(shù)據(jù),但并不完全有效。因此,在視頻字幕中會(huì)出現(xiàn)一些問(wèn)題,如場(chǎng)景轉(zhuǎn)換,以及兩種典型的描述錯(cuò)誤:

- 生成eos標(biāo)記失敗,即模型未能正確終止生成過(guò)程,導(dǎo)致循環(huán)或重復(fù)的標(biāo)記生成

- 幀級(jí)生成,即模型缺乏對(duì)幀之間動(dòng)態(tài)關(guān)系的理解,為每個(gè)幀生成孤立的描述,導(dǎo)致字幕缺乏連貫性,無(wú)法準(zhǔn)確反映視頻的整體故事情節(jié)和動(dòng)作序列。

為了解決上述數(shù)據(jù)策劃問(wèn)題,一種潛在的解決方案是人工注釋,但這種方法成本過(guò)高。隨著大型語(yǔ)言模型的最新進(jìn)展,這個(gè)問(wèn)題可以得到解決。可以使用語(yǔ)言模型(LLM)分析特定模式,如場(chǎng)景轉(zhuǎn)換、重復(fù)內(nèi)容和幀級(jí)描述,來(lái)識(shí)別多模態(tài)語(yǔ)言模型(MLLM)生成的字幕中的錯(cuò)誤。像LLAMA3這樣的模型在這些任務(wù)中表現(xiàn)出色,使其成為人工注釋的可行替代方案。

在本文努力隔離和去除在文本-視頻對(duì)齊和時(shí)間一致性方面存在差異的視頻-文本配對(duì)時(shí),利用了先進(jìn)的語(yǔ)言模型(LLM)LLAMA3.1來(lái)審查各自的字幕。精細(xì)策劃的應(yīng)用顯著提高了文本-視頻對(duì)的質(zhì)量,如下圖3所示。研究主要圍繞三個(gè)關(guān)鍵因素展開(kāi):場(chǎng)景轉(zhuǎn)換(ST)、幀級(jí)生成(FLG)和重復(fù)(Redup)。

實(shí)驗(yàn)

實(shí)施細(xì)節(jié)

為了評(píng)估本文文本到視頻訓(xùn)練數(shù)據(jù)集的有效性,本文使用基礎(chǔ)模型進(jìn)行了全面評(píng)估,該模型由空間和時(shí)間注意力塊組成。為了加速訓(xùn)練過(guò)程,本文最初在大量低分辨率256X256圖像和視頻上進(jìn)行了廣泛的預(yù)訓(xùn)練。隨后,本文使用512X512像素分辨率的圖像和4秒視頻在本文的 VidGen-1M 數(shù)據(jù)集上進(jìn)行了聯(lián)合訓(xùn)練。

實(shí)驗(yàn)結(jié)果

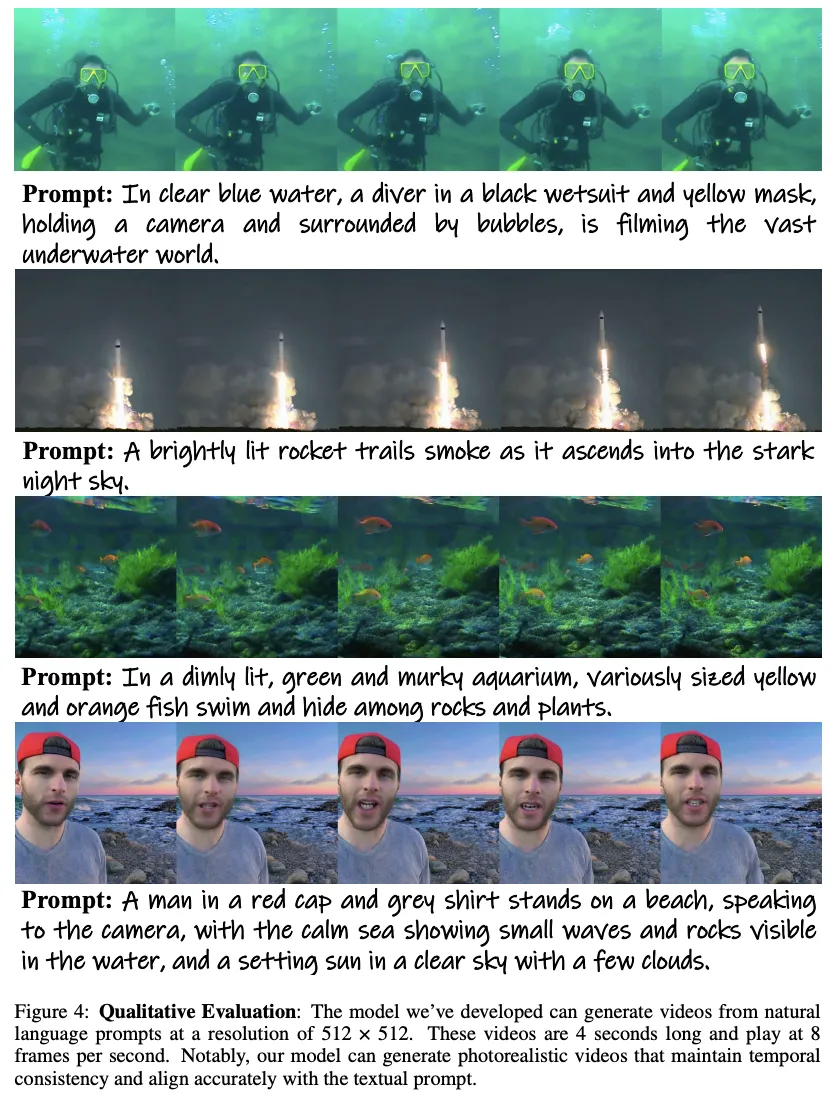

定性評(píng)估

如下圖4所示,本文模型生成高質(zhì)量視頻的能力證明了高分辨率VidGen-1M數(shù)據(jù)集的穩(wěn)健性。該數(shù)據(jù)集的高質(zhì)量體現(xiàn)在生成視頻的真實(shí)感和細(xì)節(jié)上,進(jìn)一步證明了其在訓(xùn)練本文模型方面的有效性。本文生成的視頻一個(gè)顯著特點(diǎn)是其強(qiáng)大的“提示跟隨”能力,這是訓(xùn)練數(shù)據(jù)中視頻-文本對(duì)高度一致性的直接結(jié)果。這種一致性確保了模型能夠準(zhǔn)確解釋文本提示,并生成具有高保真度的相應(yīng)視頻內(nèi)容。第一個(gè)例子進(jìn)一步強(qiáng)調(diào)了VidGen-1M數(shù)據(jù)集的高質(zhì)量。生成的視頻展示了驚人的真實(shí)感——從潛水員在水下漂浮的頭發(fā)到氣泡的運(yùn)動(dòng)。這些細(xì)節(jié)展示了顯著的時(shí)間一致性,并遵循現(xiàn)實(shí)世界的物理規(guī)律,突顯了模型生成可信且視覺(jué)上準(zhǔn)確的視頻內(nèi)容的能力。

VidGen-1M數(shù)據(jù)集的質(zhì)量對(duì)計(jì)算機(jī)視覺(jué)領(lǐng)域,特別是文本到視頻生成,有著深遠(yuǎn)的影響。通過(guò)提供高分辨率和時(shí)間一致性的訓(xùn)練數(shù)據(jù),VidGen-1M使模型能夠生成更真實(shí)和高質(zhì)量的視頻。這可以推動(dòng)視頻生成技術(shù)的發(fā)展,突破當(dāng)前的可能性界限。此外,VidGen-1M提供的高質(zhì)量數(shù)據(jù)可能會(huì)簡(jiǎn)化模型訓(xùn)練過(guò)程。借助更準(zhǔn)確和詳細(xì)的訓(xùn)練數(shù)據(jù),模型可以更有效地學(xué)習(xí),可能減少對(duì)大量計(jì)算資源和耗時(shí)訓(xùn)練周期的需求。通過(guò)這種方式,VidGen-1M不僅改善了文本到視頻生成的結(jié)果,還促進(jìn)了更高效和可持續(xù)的模型訓(xùn)練實(shí)踐。

結(jié)論

在本文中介紹了一個(gè)高質(zhì)量的視頻-文本數(shù)據(jù)集,該數(shù)據(jù)集具有高視頻質(zhì)量、高字幕質(zhì)量、高時(shí)間一致性和高視頻-文本對(duì)齊度,專門(mén)用于訓(xùn)練文本到視頻生成模型。上述各種高質(zhì)量特性源于本文精心設(shè)計(jì)的數(shù)據(jù)策展過(guò)程,該過(guò)程以粗到細(xì)的方式高效地確保了數(shù)據(jù)質(zhì)量。為了驗(yàn)證VidGen-1M的有效性,在其上訓(xùn)練了一個(gè)文本到視頻生成模型。結(jié)果令人鼓舞,訓(xùn)練在VidGen-1M上的模型在零樣本UCF101上取得了顯著更好的FVD分?jǐn)?shù),與最先進(jìn)的文本到視頻模型相比有明顯提升。

本文轉(zhuǎn)自 AI生成未來(lái) ,作者:Zhiyu Tan等