更小、更弱,卻更優(yōu):通過(guò)計(jì)算最優(yōu)抽樣訓(xùn)練大語(yǔ)言模型推理器

一、結(jié)論寫(xiě)在前面

論文標(biāo)題:Smaller, Weaker, Yet Better: Training LLM Reasoners via Compute-Optimal Sampling

論文鏈接:??https://arxiv.org/pdf/2408.16737??

利用來(lái)自強(qiáng)大語(yǔ)言模型(LMs)的高質(zhì)量合成數(shù)據(jù)進(jìn)行訓(xùn)練是提升LMs推理性能的常見(jiàn)策略。論文重新審視了在固定推理預(yù)算(例如,F(xiàn)LOPs)下,這一策略是否為計(jì)算最優(yōu)。為此,論文探究了使用更強(qiáng)但更昂貴(SE)模型與較弱但更廉價(jià)(WC)模型生成合成數(shù)據(jù)之間的權(quán)衡。

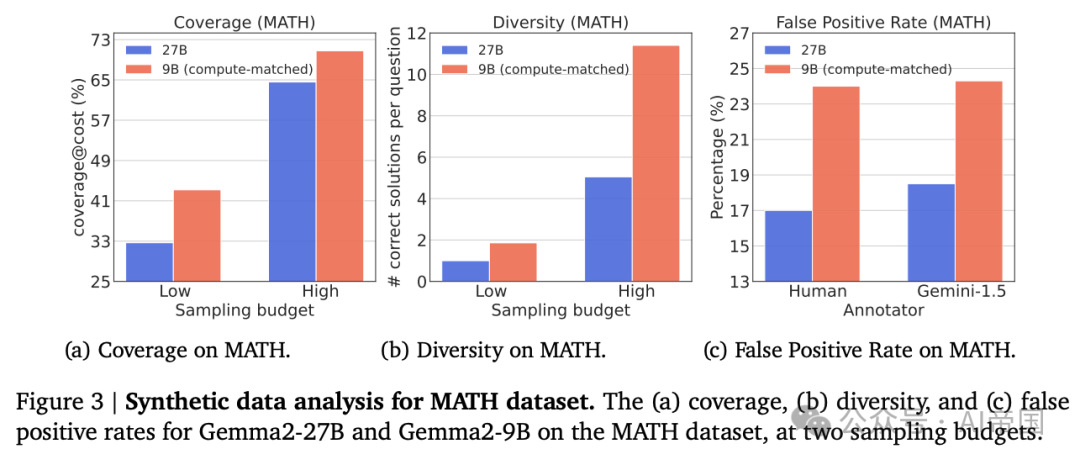

論文評(píng)估了生成數(shù)據(jù)在三個(gè)關(guān)鍵指標(biāo)上的表現(xiàn):覆蓋率、多樣性和誤報(bào)率,并表明WC模型生成的數(shù)據(jù)可能具有更高的覆蓋率和多樣性,但也表現(xiàn)出更高的誤報(bào)率。

隨后,論文在不同設(shè)置下對(duì)LMs進(jìn)行微調(diào):知識(shí)蒸餾、自我改進(jìn)以及一種新穎的弱到強(qiáng)改進(jìn)設(shè)置,其中較弱的LM向較強(qiáng)的LM傳授推理能力。論文的研究發(fā)現(xiàn),在多個(gè)基準(zhǔn)和多種WC與SE模型選擇下,基于WC生成數(shù)據(jù)微調(diào)的模型始終優(yōu)于那些基于SE生成數(shù)據(jù)訓(xùn)練的模型。這些結(jié)果挑戰(zhàn)了當(dāng)前依賴SE模型生成合成數(shù)據(jù)的主流做法,表明WC可能是訓(xùn)練高級(jí)LM推理器的計(jì)算最優(yōu)途徑。

一個(gè)具體例子是:對(duì)于Gemma2系列在MATH數(shù)據(jù)集上,Gemma2-9B實(shí)現(xiàn)了11%更高的覆蓋率和86%更高的多樣性,但也伴隨著7%的更高FPR,相比于Gemma2-27B。

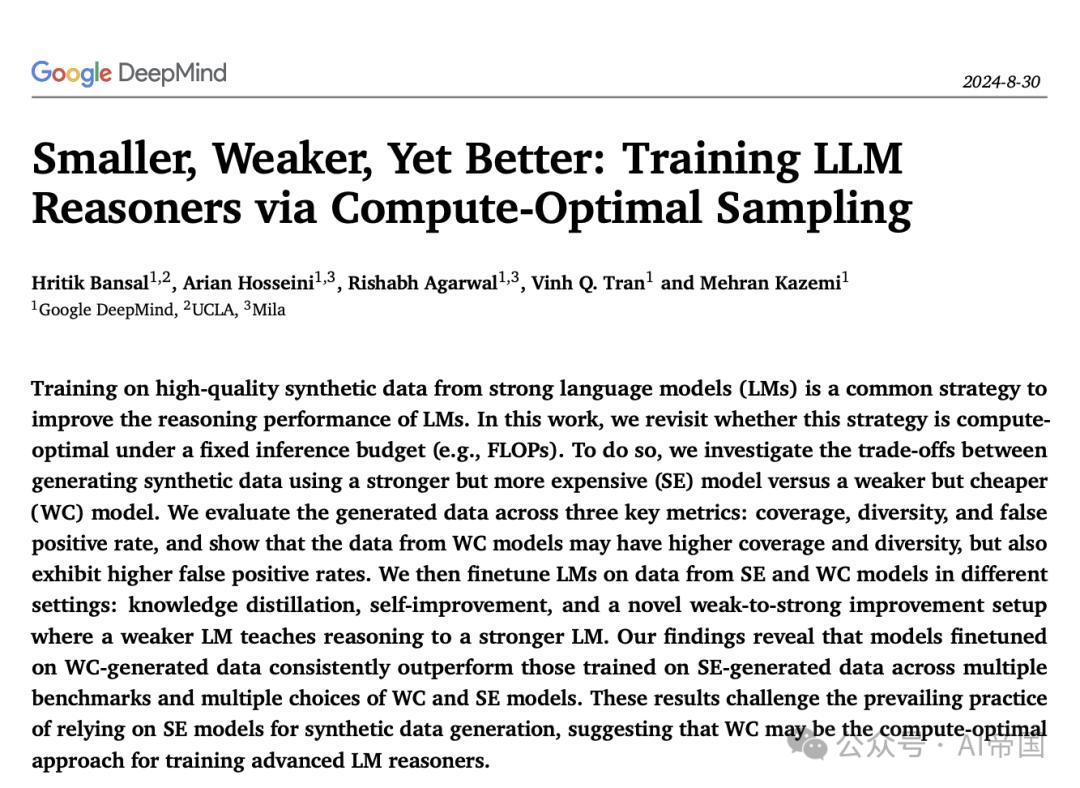

圖 1 | 結(jié)果總結(jié)。(a) 論文在計(jì)算匹配的設(shè)置下,使用從更強(qiáng)大但更昂貴的LM(Gemma2-27B)和較弱但較便宜的LM(Gemma2-9B)收集的合成數(shù)據(jù),對(duì)Gemma-7B、Gemma2-9B和Gemma2-27B進(jìn)行微調(diào),用于MATH數(shù)據(jù)集。論文發(fā)現(xiàn),在多種微調(diào)范式——知識(shí)蒸餾、自我改進(jìn)和弱到強(qiáng)改進(jìn)(即使用較弱的模型來(lái)改進(jìn)較強(qiáng)的模型)中,使用Gemma2-9B數(shù)據(jù)進(jìn)行訓(xùn)練是更計(jì)算優(yōu)化的設(shè)置。(b) 論文在價(jià)格匹配的設(shè)置下,使用由最先進(jìn)的LM Gemini-1.5-Pro和Gemini-1.5-Flash生成的合成數(shù)據(jù),對(duì)Gemma模型(7B/9B/27B)進(jìn)行微調(diào)。論文發(fā)現(xiàn),使用Flash生成的數(shù)據(jù)進(jìn)行微調(diào)始終優(yōu)于使用Pro生成的數(shù)據(jù)。

二、論文的簡(jiǎn)單介紹

2.1 論文的背景

最近的研究表明,通過(guò)語(yǔ)言模型自身合成生成這些數(shù)據(jù)是可行的,這為訓(xùn)練數(shù)據(jù)的獲取提供了一種潛在的更具擴(kuò)展性和效率的方法。一種廣泛采用的方法是從LM中為一個(gè)問(wèn)題采樣多個(gè)候選解決方案,過(guò)濾它們以確保最終答案的正確性,并在正確的解決方案上對(duì)模型進(jìn)行微調(diào)。多項(xiàng)研究表明,使用這種合成解決方案訓(xùn)練的LM優(yōu)于使用人類編寫(xiě)的解決方案訓(xùn)練的LM。從業(yè)者通常從強(qiáng)大的LM中采樣解決方案以確保高質(zhì)量。然而,從強(qiáng)大的LM中采樣是昂貴且資源密集型的,并且限制了在實(shí)際采樣預(yù)算內(nèi)可以生成的解決方案數(shù)量。

論文探索了一種替代采樣方法。在固定的計(jì)算預(yù)算下,論文研究了從較弱但更便宜(WC)模型采樣,而不是通常采用的從較強(qiáng)且昂貴的微調(diào)LM(stronger but more expensive,SE)采樣的方法。通過(guò)比較WC和SE的數(shù)據(jù),論文沿著三個(gè)在合成數(shù)據(jù)效用中起關(guān)鍵作用的方向進(jìn)行分析:1-覆蓋率,解決的獨(dú)特問(wèn)題的數(shù)量;2-多樣性,每個(gè)問(wèn)題獲得的平均獨(dú)特解決方案數(shù)量;以及3-假陽(yáng)性率(FPR),即以錯(cuò)誤理由得出正確最終答案的問(wèn)題百分比。

論文發(fā)現(xiàn),由于可以從WC模型生成更多的樣本,與后者相比,這可能導(dǎo)致解決更廣泛的問(wèn)題,并在固定預(yù)算下提供更多數(shù)據(jù)。論文在各種監(jiān)督微調(diào)設(shè)置中比較了這兩種合成生成的數(shù)據(jù)集對(duì)訓(xùn)練LM推理器的效用,并顯示使用WC數(shù)據(jù)訓(xùn)練始終優(yōu)于使用SE數(shù)據(jù)訓(xùn)練。作為一個(gè)具體例子,對(duì)于Gemma2系列在MATH數(shù)據(jù)集(Hendrycks等人,2021)上,Gemma2-9B實(shí)現(xiàn)了11%更高的覆蓋率和86%更高的多樣性,但也伴隨著7%的更高FPR,相比于Gemma2-27B。

2.2. 預(yù)備知識(shí)

設(shè) D={q_i, a_i} _i=1 ^i=n 為一個(gè)包含 n 個(gè)推理問(wèn)題 q_i 及其最終答案(即標(biāo)簽) a_i 的訓(xùn)練數(shù)據(jù)集。利用此類數(shù)據(jù)提升模型推理能力的成功方法如下:論文采樣k 個(gè)樣本,其中 r_i j 是模型為 q_i 生成的第 j 個(gè)推理鏈(即解決方案),a_i j 是模型在非零溫度下對(duì) q_i 的最終答案,并創(chuàng)建合成數(shù)據(jù) D_G={q_i, {( r_i j, a_i j )}_j=1 ^j=k 。

接著,論文通過(guò)比較 a_i j 與 a_i 來(lái)過(guò)濾錯(cuò)誤的解決方案,移除那些最終答案與標(biāo)準(zhǔn)答案不匹配的方案。最后,論文在剩余數(shù)據(jù) D_G 上監(jiān)督微調(diào)模型,以最大化目標(biāo)函數(shù)??(??),即在給定問(wèn)題 q 下生成推理 r 和最終答案 a 的概率。

關(guān)于 D_G,論文計(jì)算了平均值,如 Chen et al., 2010 所述。從概念上講,coverage@k 衡量了至少有一個(gè)正確解決方案的獨(dú)特問(wèn)題的比例,假設(shè)論文從模型中為每個(gè)問(wèn)題采樣 k 個(gè)解決方案。論文還定義了多樣性 Q k 為每當(dāng)論文為每個(gè)問(wèn)題采樣 k 個(gè)解決方案時(shí),平均每個(gè)問(wèn)題獲得的獨(dú)特正確解決方案的數(shù)量。最后,論文定義假陽(yáng)性率 ( F P R ) 為 tD_G 中推理錯(cuò)誤但最終答案正確的解決方案的百分比。

不同的語(yǔ)言模型(LM)選擇來(lái)采樣解決方案和微調(diào)模型會(huì)導(dǎo)致不同的設(shè)置。知識(shí)蒸餾(Hinton et al., 2015)對(duì)應(yīng)于在從更強(qiáng)和更大的LM中采樣的合成數(shù)據(jù)上訓(xùn)練學(xué)生LM。自我改進(jìn)(Huang et al., 2022)對(duì)應(yīng)于在由其自身生成的樣本上訓(xùn)練LM。

2.3. 計(jì)算匹配的采樣和訓(xùn)練

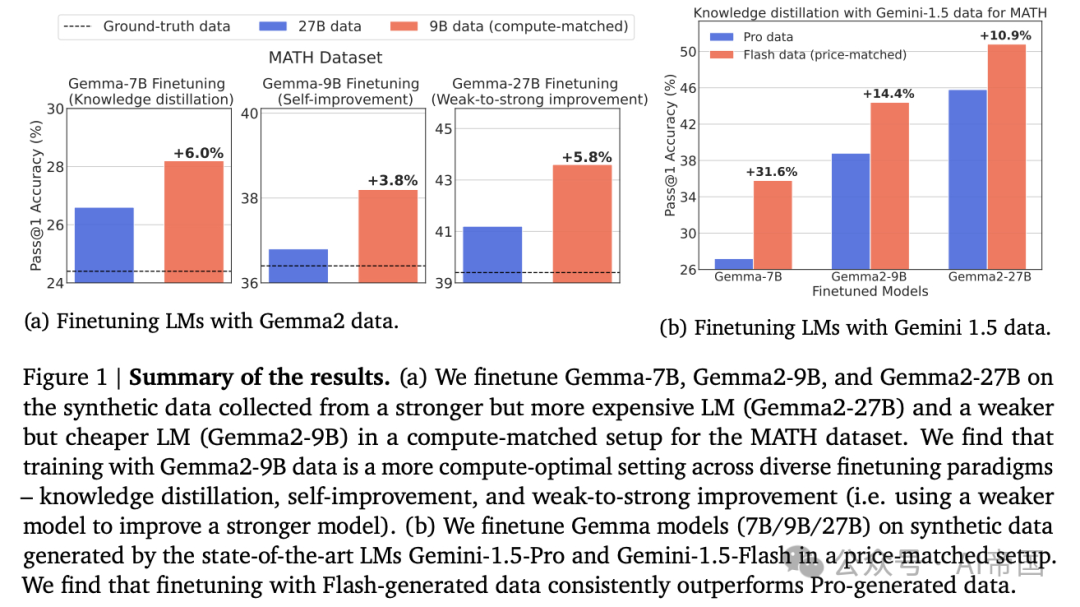

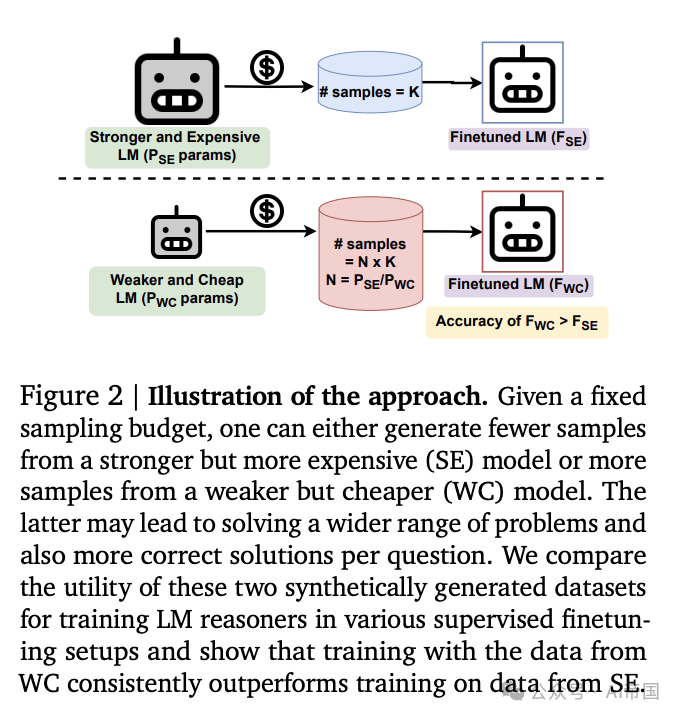

為了從D生成包含合成解決方案的數(shù)據(jù)集D_G,可以利用不同的模型來(lái)生成解決方案。具體來(lái)說(shuō),在固定的采樣預(yù)算(FLOPs)下,可以從較弱但成本較低的(a weaker but cheap,WC)模型中生成更多樣本,或者從較強(qiáng)但成本較高的(SE)模型中生成較少樣本。給定一個(gè)具有P_WC參數(shù)的WC模型和一個(gè)具有P_SE參數(shù)的SE模型,論文計(jì)算在固定預(yù)算下兩個(gè)模型的采樣比例,重點(diǎn)關(guān)注僅解碼器的Transformer模型。

根據(jù)(Kaplan et al., 2020),論文注意到每個(gè)推理token的FLOPs是2P,對(duì)于具有P參數(shù)的模型。因此,T個(gè)推理token的FLOPs是2PT。進(jìn)一步假設(shè)生成每個(gè)解決方案平均需要W個(gè)推理token,對(duì)于兩種模型都是如此。設(shè)S_WC和S_SE分別表示論文為兩個(gè)模型每個(gè)問(wèn)題生成的樣本數(shù)量。生成數(shù)據(jù)集D的樣本的總成本將是Cost_WC=n x S_WC x W x (2P_WC)和Cost_SE=n x S_SE x W x (2P_SE),分別對(duì)應(yīng)于廉價(jià)和昂貴的模型。在固定的采樣預(yù)算下,論文有:

公式1表明,在固定的采樣預(yù)算下,對(duì)于每個(gè)問(wèn)題,論文可以生成P_SE/P_WC個(gè)從WC中采樣更多樣本;比例尺與模型參數(shù)比例線性相關(guān)。從WC中采樣更多解決方案可能會(huì)增加正確解決更大子集問(wèn)題(高覆蓋率)和每個(gè)問(wèn)題獲得更多正確解決方案(高多樣性)的可能性。

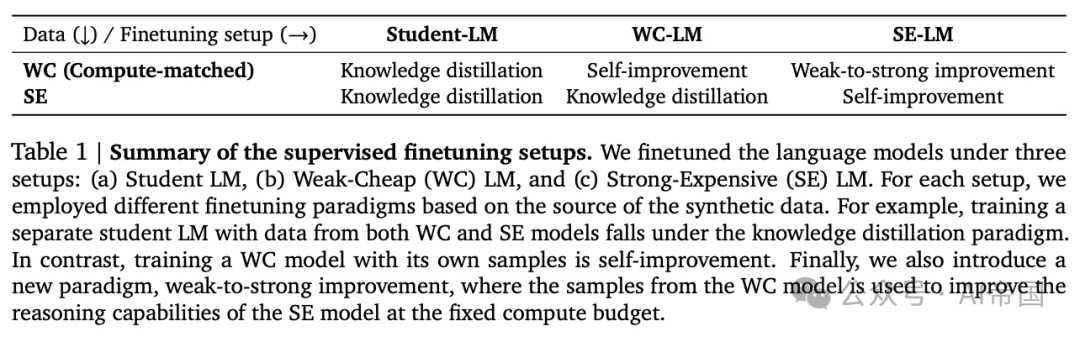

表1 監(jiān)督微調(diào)設(shè)置的總結(jié)。論文在三種設(shè)置下微調(diào)語(yǔ)言模型:(a)學(xué)生LM,(b)弱-廉價(jià)(WC)LM,和(c)強(qiáng)-昂貴(SE)LM。對(duì)于每種設(shè)置,論文根據(jù)合成數(shù)據(jù)的來(lái)源采用了不同的微調(diào)范式。例如,使用來(lái)自WC和SE模型的數(shù)據(jù)訓(xùn)練一個(gè)單獨(dú)的學(xué)生LM屬于知識(shí)蒸餾范式。相比之下,使用其自身樣本訓(xùn)練WC模型是自我改進(jìn)。最后,論文還引入了一種新的范式,即弱到強(qiáng)改進(jìn),其中WC模型的樣本被用來(lái)在固定計(jì)算預(yù)算下提高SE模型的推理能力。

在固定預(yù)算下,論文可以選擇從SE模型生成較少樣本或從WC模型生成更多樣本,然后對(duì)來(lái)自每個(gè)模型的數(shù)據(jù)進(jìn)行固定步數(shù)的微調(diào),以測(cè)量和比較每個(gè)模型數(shù)據(jù)的效用。具體來(lái)說(shuō),論文生成的樣本比WC模型比SE模型多P_S E / P_W C。論文考慮了三種包含多樣化微調(diào)范式的設(shè)置。這些范式包括廣泛使用的知識(shí)蒸餾、新興的自改進(jìn)框架,以及論文在本工作中引入的新穎的弱到強(qiáng)改進(jìn)范式。

論文將弱到強(qiáng)改進(jìn)(W2S-I)定義為使用從較弱模型生成的樣本來(lái)增強(qiáng)強(qiáng)模型的推理能力。三種設(shè)置如下:

?學(xué)生-LM微調(diào):傳統(tǒng)上,用于訓(xùn)練學(xué)生LM的監(jiān)督微調(diào)數(shù)據(jù)從SE模型獲取,以確保高質(zhì)量。然而,論文旨在理解WC模型是否能在固定采樣預(yù)算下替代SE模型進(jìn)行蒸餾。為此,論文在WC和SE數(shù)據(jù)上分別對(duì)與WC和SE模型獨(dú)立的學(xué)生LM進(jìn)行微調(diào),這在兩種情況下對(duì)應(yīng)于蒸餾。

?WG-LM微調(diào):先前的工作(Singh et al., 2023)表明,通過(guò)自生成數(shù)據(jù)微調(diào)WC模型落后于從SE數(shù)據(jù)蒸餾。然而,他們的設(shè)置在從SE模型收集數(shù)據(jù)上花費(fèi)了更高的采樣預(yù)算(FLOPs),而不是從WC模型收集SI數(shù)據(jù)。在本工作中,論文在固定采樣預(yù)算下重新審視這一微調(diào)設(shè)置,并在固定預(yù)算下對(duì)WC模型在WC和SE數(shù)據(jù)上進(jìn)行微調(diào)。注意,在自身數(shù)據(jù)上訓(xùn)練WC模型對(duì)應(yīng)于自我改進(jìn),而在SE數(shù)據(jù)上訓(xùn)練WC模型對(duì)應(yīng)于蒸餾。因此,此設(shè)置比較了WC數(shù)據(jù)上的自我改進(jìn)與SE數(shù)據(jù)上的蒸餾。

?SE-LM微調(diào):通常認(rèn)為要改進(jìn)SE模型,論文需要來(lái)自SE模型自身的合成數(shù)據(jù)或來(lái)自比SE模型更強(qiáng)(且可能更昂貴)的模型。論文采用一種方法來(lái)理解WC模型生成的合成數(shù)據(jù)是否能改進(jìn)SE模型。為此,論文在WC和SE數(shù)據(jù)上微調(diào)SE模型。在WC數(shù)據(jù)上訓(xùn)練SE對(duì)應(yīng)于W2S-I,而在SE數(shù)據(jù)上訓(xùn)練SE對(duì)應(yīng)于自我改進(jìn)。總體而言,此設(shè)置比較了WC數(shù)據(jù)上的W2S-I與SE數(shù)據(jù)上的自我改進(jìn)。

三種設(shè)置及其對(duì)應(yīng)的微調(diào)范式的總結(jié)見(jiàn)表1。

2.4. 實(shí)驗(yàn)設(shè)置

數(shù)據(jù)集:論文使用MATH和GSM-8K作為推理數(shù)據(jù)集,因?yàn)樗鼈儚V泛用于數(shù)學(xué)問(wèn)題解決。具體而言,MATH包含不同難度級(jí)別的競(jìng)賽級(jí)問(wèn)題(級(jí)別(1-5)),而GSM-8K包含小學(xué)級(jí)別的數(shù)學(xué)問(wèn)題。每個(gè)數(shù)據(jù)集在其訓(xùn)練分割中包含7500個(gè)數(shù)學(xué)問(wèn)題。論文在MATH測(cè)試分割的500個(gè)問(wèn)題和GSM-8K測(cè)試分割的1319個(gè)問(wèn)題上評(píng)估模型。此外,論文使用MATH測(cè)試分割的500個(gè)問(wèn)題和GSM-8K的500個(gè)問(wèn)題作為驗(yàn)證數(shù)據(jù)集。論文還使用Functional MATH數(shù)據(jù)集進(jìn)行遷移學(xué)習(xí)研究。此外,論文在附錄wedge中展示了一個(gè)編碼任務(wù)的結(jié)果。

數(shù)據(jù)生成:論文使用Gemma2模型進(jìn)行合成數(shù)據(jù)生成,其中預(yù)訓(xùn)練的Gemma2-9B和Gemma2-27B分別充當(dāng)WC和SE模型。論文為MATH問(wèn)題生成解決方案時(shí)采用4次提示,為GSM-8K問(wèn)題生成解決方案時(shí)采用8次提示。由于9B模型大約比27B模型小3倍,在固定的采樣計(jì)算預(yù)算下,論文可以為Gemma2-9B每問(wèn)題采樣3倍多的候選解決方案。對(duì)于論文的實(shí)驗(yàn),論文考慮兩種采樣預(yù)算:低預(yù)算,其中論文分別從Gemma2-27B和Gemma2-9B每問(wèn)題生成1個(gè)和3個(gè)候選解決方案;高預(yù)算,其中論文每問(wèn)題分別生成10個(gè)和30個(gè)候選解決方案。此外,論文研究了在功能性MATH數(shù)據(jù)集上,針對(duì)高采樣預(yù)算下訓(xùn)練的模型在推理能力上的遷移。

模型微調(diào):論文在表1中總結(jié)了微調(diào)設(shè)置的詳細(xì)信息。在學(xué)生-LM微調(diào)設(shè)置中,論文對(duì)Gemma-7B模型(Team et al., 2024a)進(jìn)行微調(diào),數(shù)據(jù)來(lái)自Gemma2-9B(WC)和Gemma2-27B(SE)。此外,論文分別使用Gemma2-9B和Gemma2-27B進(jìn)行WC-LM和SE-LM微調(diào)設(shè)置。進(jìn)一步地,論文使用人類編寫(xiě)的解決方案作為基準(zhǔn)事實(shí),對(duì)不同設(shè)置下的LM進(jìn)行訓(xùn)練。論文在附錄中提供了微調(diào)的詳細(xì)信息overlinequadquadquad。

合成數(shù)據(jù)評(píng)估:為了評(píng)估SE和WC模型生成的合成數(shù)據(jù)的質(zhì)量,論文測(cè)量了假陽(yáng)性率,以及在固定成本下的覆蓋率和多樣性。論文從7 varphi3 k 心相似的預(yù)算中為兩個(gè)模型提供相同的支持。同樣,論文比較了論文的SE和W C模型的diversity@k和diversity@3k。由于FPR不能自動(dòng)計(jì)算,論文使用兩個(gè)代理來(lái)計(jì)算它:1 - 對(duì)數(shù)據(jù)子集的人工評(píng)估,其中隨機(jī)選擇了每個(gè)模型的50個(gè)解決方案,并由作者對(duì)其推理正確性進(jìn)行評(píng)分,以及 _2 - 自動(dòng)評(píng)估,論文采樣了500個(gè)解決方案并提示Gemini-Pro-1.5(Reid et al., 2024)來(lái)評(píng)估推理路徑的正確性。為了采樣解決方案,對(duì)于MATI數(shù)據(jù)集,論文從每個(gè)多樣性級(jí)別中均勻選擇。在論文的實(shí)驗(yàn)中,論文發(fā)現(xiàn)人工和自動(dòng)評(píng)估的FPR估計(jì)值彼此接近。論文在附錄B中提供了一些假陽(yáng)性實(shí)例的定性示例。

評(píng)估微調(diào)模型:論文使用pass@1 準(zhǔn)確度來(lái)評(píng)估微調(diào)語(yǔ)言模型(LMs)的性能。具體而言,論文針對(duì)測(cè)試集中的每個(gè)問(wèn)題生成一個(gè)單一解決方案(零樣本),使用微調(diào)后的LM進(jìn)行采樣溫度為0.0(貪心解碼),并計(jì)算最終答案與標(biāo)準(zhǔn)答案匹配的問(wèn)題百分比。此外,論文還報(bào)告了maj@k ( k=1, 4, 8, 16 ) 的部分實(shí)驗(yàn)結(jié)果,其中每個(gè)問(wèn)題生成 boldsymbolk 個(gè)解決方案,采樣溫度為 0.7,并選擇在 k 個(gè)樣本中出現(xiàn)頻率最高的最終答案。小規(guī)模、弱化,但更優(yōu):通過(guò)計(jì)算優(yōu)化采樣訓(xùn)練大型語(yǔ)言模型推理器

圖 3 ~ | MATH 數(shù)據(jù)集的合成數(shù)據(jù)分析。在兩個(gè)采樣預(yù)算下,Gemma2-27B 和 Gemma2-9B 在 MATH 數(shù)據(jù)集上的正樣本率。

2.5. 實(shí)驗(yàn)與結(jié)果

論文沿著幾個(gè)軸比較了 WC 和 SE 模型的數(shù)據(jù)。首先,論文沿著各種質(zhì)量指標(biāo)分析數(shù)據(jù)。隨后,論文展示了不同設(shè)置下的監(jiān)督微調(diào)結(jié)果。最后,論文進(jìn)行了消融研究,以研究數(shù)據(jù)集大小、采樣策略和質(zhì)量維度在模型性能中的作用。

2.5.1. 合成數(shù)據(jù)分析

覆蓋率:論文的目標(biāo)是理解在固定采樣預(yù)算下,從 WC 和 SE 模型生成解決方案的優(yōu)缺點(diǎn)。論文在圖 3 中展示了 MATH 在低和高采樣預(yù)算下的覆蓋率、多樣性和假陽(yáng)性率。GSM-8K 的結(jié)果在附錄 - 圖 15 中展示。論文發(fā)現(xiàn),在覆蓋率方面,Gemma2-9B(WC)在低和高采樣預(yù)算下分別比 Gemma2-27B(SE)高出 11% 和 6%,對(duì)于 MATH 數(shù)據(jù)集,以及 8% 和 1% 對(duì)于 GSM-8K。這突顯了 WC 模型更高的樣本數(shù)量有助于解決更多獨(dú)特的推理問(wèn)題。

此外,論文觀察到,在 MATH 數(shù)據(jù)集中,WC 模型的覆蓋率在高采樣預(yù)算下隨著不同難度級(jí)別的增加而增加(見(jiàn)附錄 - 圖 16)。這突顯了在固定采樣預(yù)算下,WC 模型生成的合成數(shù)據(jù)可以解決更多不同難度級(jí)別的獨(dú)特問(wèn)題,相比之下 SE 模型。此外,論文提供了一個(gè)定性示例,該示例通過(guò) Gemma2-9B 的重復(fù)采樣得到解決,但在固定的高采樣預(yù)算下,Gemma2-27B 仍未解決(表 5)。

多樣性:Gemma2-9B 生成的數(shù)據(jù)在 MATII 數(shù)據(jù)集上的多樣性比 Gemma2-27B 高出 86% 和 125%,在 GSM-8K 數(shù)據(jù)集上則高出 134% 和 158%。這表明 W C 模型生成的合成數(shù)據(jù)中存在許多獨(dú)特的推理鏈,這些推理鏈能夠?qū)蛘_的解決方案。論文還觀察到,在高采樣預(yù)算下,MATH 數(shù)據(jù)集的絕對(duì)多樣性得分低于 GSM-8K,這表明在重復(fù)采樣時(shí),模型為更具挑戰(zhàn)性的數(shù)據(jù)集生成的正確解決方案更少。

假陽(yáng)性率(FPR):由于論文利用最終答案的正確性來(lái)篩選合成數(shù)據(jù),因此并未移除包含錯(cuò)誤中間推理步驟的解決方案。論文的人工評(píng)估顯示,在 MATH 和 GSM-8K 數(shù)據(jù)集上,WC 生成的解決方案的 FPR 分別比 SE 生成的解決方案高出 7% 和 2%。自動(dòng)評(píng)估的趨勢(shì)與人工評(píng)估相似。鑒于問(wèn)題難度的差異,論文注意到,絕對(duì)值與MATH數(shù)據(jù)集相比,GSM-8K數(shù)據(jù)集的FPR(假陽(yáng)性率)要低得多。論文還注意到,推理步驟的自動(dòng)驗(yàn)證也可能存在錯(cuò)誤,這仍然是一個(gè)開(kāi)放問(wèn)題。

圖 4 監(jiān)督微調(diào)結(jié)果(MATH)。在固定采樣預(yù)算下,對(duì)來(lái)自WC(Gemma2-9B)和SE(Gemma2-27B)模型的MATH數(shù)據(jù)進(jìn)行微調(diào)的各種語(yǔ)言模型的結(jié)果。論文觀察到,使用WC模型樣本的訓(xùn)練始終優(yōu)于使用SE數(shù)據(jù)的訓(xùn)練。

圖 5 mid 監(jiān)督微調(diào)結(jié)果(GSM-8K)。在固定采樣預(yù)算下,對(duì)來(lái)自WC(Gemma2-9B)和SE(Gemma2-27B)模型的GSM-8K合成數(shù)據(jù)進(jìn)行各種語(yǔ)言模型微調(diào)的結(jié)果。論文觀察到,使用WC模型樣本進(jìn)行訓(xùn)練的推理器比使用SE數(shù)據(jù)訓(xùn)練的推理器更強(qiáng)。

鑒于高覆蓋率和多樣性與高FPR的混合信號(hào),目前尚不清楚從WC模型還是SE模型采樣以訓(xùn)練強(qiáng)推理器是否是計(jì)算最優(yōu)的。論文將在下一節(jié)中研究這個(gè)問(wèn)題。

2.5.2. 訓(xùn)練的計(jì)算最優(yōu)性結(jié)果

論文比較了從Gemma2-9B(WC)和Gemma2-27B(SE)模型生成的合成數(shù)據(jù)在MATH和GSM-8K數(shù)據(jù)集上的效用,這些數(shù)據(jù)集涵蓋了圖4和圖5中不同的微調(diào)范式。此外,論文還展示了使用原始訓(xùn)練集中人類編寫(xiě)的思維鏈進(jìn)行訓(xùn)練的結(jié)果作為基線。

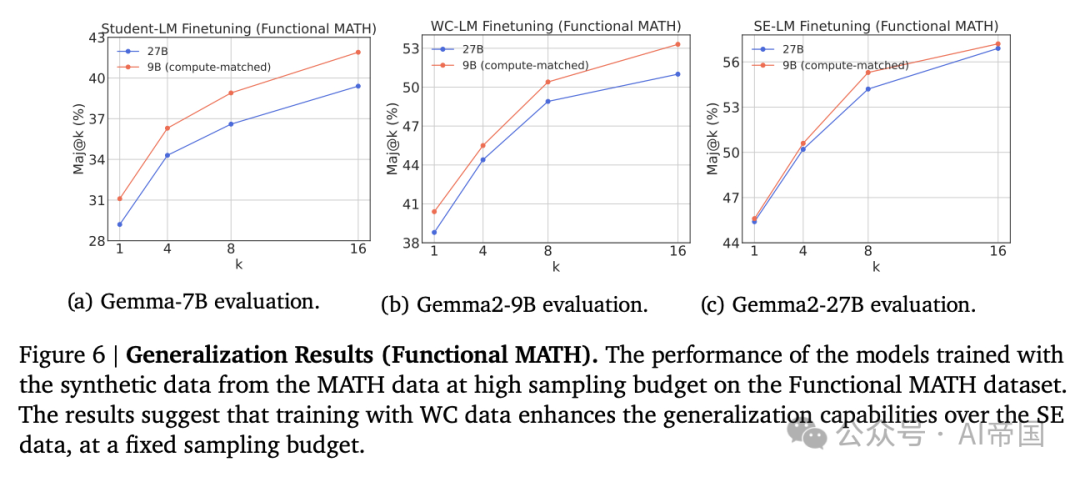

圖 6 | 泛化結(jié)果(功能性 MATH)。在功能性 MATH 數(shù)據(jù)集上,使用 MATH 數(shù)據(jù)在高采樣預(yù)算下生成的合成數(shù)據(jù)訓(xùn)練的模型的性能。結(jié)果表明,在固定采樣預(yù)算下,使用 WC 數(shù)據(jù)訓(xùn)練增強(qiáng)了模型對(duì) SE 數(shù)據(jù)的泛化能力。

學(xué)生-LM 微調(diào)。論文發(fā)現(xiàn),使用 WC 生成的合成數(shù)據(jù)微調(diào)的 Gemma-7B 模型,在性能上始終優(yōu)于使用 SC 數(shù)據(jù)微調(diào)的模型。具體而言,對(duì)于 MATH 數(shù)據(jù)集,在低和高采樣預(yù)算下分別獲得了 6% 和 5.8% 的相對(duì)增益,而對(duì)于 GSM-8K 數(shù)據(jù)集,則分別為 4.2% 和 1.3%。與普遍認(rèn)為更強(qiáng)大的模型更適合知識(shí)蒸餾的觀點(diǎn)相反,論文的結(jié)果表明,使用 WC 數(shù)據(jù)進(jìn)行微調(diào)在計(jì)算上比使用 SE 數(shù)據(jù)更為優(yōu)化。

WG-LM 微調(diào)。論文比較了Gemma2-9B在WC數(shù)據(jù)(即自生成數(shù)據(jù))和SE數(shù)據(jù)(即來(lái)自Gemma2-27B的數(shù)據(jù))微調(diào)后的性能。MATH和GSM-8K的結(jié)果分別在圖 4 和 5中報(bào)告。論文觀察到,自生成數(shù)據(jù)(WC數(shù)據(jù))相較于從強(qiáng)模型中進(jìn)行知識(shí)蒸餾(SE數(shù)據(jù))有所提升,在MATH數(shù)據(jù)集上,低和高采樣預(yù)算下分別實(shí)現(xiàn)了3.8%和2%的相對(duì)增益,而在GSM-8K數(shù)據(jù)集上,低采樣預(yù)算下實(shí)現(xiàn)了1.5%的增益。然而,論文發(fā)現(xiàn),在高采樣預(yù)算下,使用WC數(shù)據(jù)微調(diào)的WC模型在GSM-8K數(shù)據(jù)集上與SE數(shù)據(jù)相當(dāng)。這主要是因?yàn)镚SM-8k數(shù)據(jù)集的難度較低,在較高采樣預(yù)算下趨于飽和(見(jiàn)圖 15a)。有趣的是,論文的實(shí)證發(fā)現(xiàn)表明,在自身生成的合成數(shù)據(jù)上訓(xùn)練WC模型比從更強(qiáng)模型中蒸餾更為計(jì)算優(yōu)化。

SE-LM 微調(diào)結(jié)果。論文展示了使用 Gemma2-9B 生成數(shù)據(jù)和自生成數(shù)據(jù)對(duì) Gemma2-27B 進(jìn)行微調(diào)的結(jié)果。MATH 和 GSM-8K 數(shù)據(jù)集的結(jié)果分別在圖 angle_big( big) 和圖 5c 中報(bào)告。令人驚訝的是,論文觀察到使用 WC 數(shù)據(jù)微調(diào)的模型在 MATH 數(shù)據(jù)集上表現(xiàn)優(yōu)于 SE 數(shù)據(jù),在低和高采樣預(yù)算下分別實(shí)現(xiàn)了 5.8% 和 4.3% 的相對(duì)增益,而在 GSM-8K 數(shù)據(jù)集上則分別為 1.2% 和 1.5%。考慮到 Gemma2-27B 數(shù)據(jù)預(yù)期比 Gemma2-9B 數(shù)據(jù)更符合分布,這一結(jié)果更加令人意外。與普遍認(rèn)為自生成數(shù)據(jù)或來(lái)自更強(qiáng)模型的數(shù)據(jù)更好的觀點(diǎn)相反,論文的實(shí)證研究發(fā)現(xiàn),在 W2S-I 設(shè)置下使用 WC 數(shù)據(jù)訓(xùn)練模型可能比在其自身數(shù)據(jù)上進(jìn)行自我改進(jìn)訓(xùn)練更為計(jì)算優(yōu)化。這一結(jié)果還確立了一種新的范式,即通過(guò)從遠(yuǎn)小于前沿模型的模型中生成合成數(shù)據(jù),以計(jì)算高效的方式改進(jìn)前沿模型。

泛化能力。在此,論文旨在研究使用 WC 和 SE 數(shù)據(jù)訓(xùn)練的模型的遷移能力。具體而言,論文在高采樣預(yù)算下,對(duì)使用合成解決方案微調(diào)的 MATH 數(shù)據(jù)集模型在 Functional MATH 數(shù)據(jù)集上進(jìn)行評(píng)估。圖 6 的結(jié)果顯示,使用 WC 數(shù)據(jù)微調(diào)的 Gemma-7B 模型持續(xù)優(yōu)于使用 SE 數(shù)據(jù),其中,相對(duì)增益范圍在不同boldsymbolk值下為5.8%-6.5%。此外,論文觀察到,使用自生成數(shù)據(jù)微調(diào)的Gemma2-9B模型在不同boldsymbolk值下實(shí)現(xiàn)了2.5%-4.5%的相對(duì)增益,超過(guò)了使用Gemma2-27B數(shù)據(jù)進(jìn)行知識(shí)蒸餾的性能。此外,使用WC數(shù)據(jù)微調(diào)的Gemma2-27B模型與SE數(shù)據(jù)非常接近,除了k=8時(shí)存在2%的相對(duì)增益差距。論文的結(jié)果強(qiáng)調(diào),使用WC數(shù)據(jù)微調(diào)語(yǔ)言模型在固定采樣預(yù)算下增強(qiáng)了相對(duì)于SE數(shù)據(jù)的泛化能力。

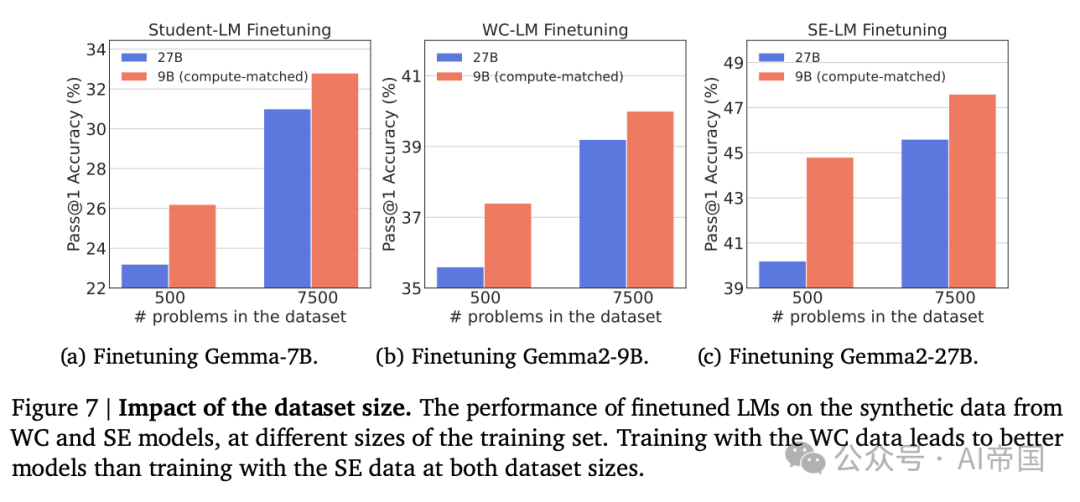

圖 7 | 數(shù)據(jù)集大小的影響。在不同訓(xùn)練集大小下,微調(diào)后的語(yǔ)言模型在來(lái)自WC和SE模型的合成數(shù)據(jù)上的性能表現(xiàn)。使用WC數(shù)據(jù)進(jìn)行訓(xùn)練的模型在兩個(gè)數(shù)據(jù)集大小上都優(yōu)于使用SE數(shù)據(jù)進(jìn)行訓(xùn)練的模型。

要點(diǎn):總的來(lái)說(shuō),論文的發(fā)現(xiàn)挑戰(zhàn)了傳統(tǒng)智慧,即主張?jiān)赟E模型樣本上進(jìn)行訓(xùn)練,通過(guò)展示在WC模型樣本上訓(xùn)練可能在各種任務(wù)和設(shè)置中更計(jì)算優(yōu)化。

2.5.3. 消融研究

數(shù)據(jù)集大小的影響:論文研究了來(lái)自WC模型的合成數(shù)據(jù)在不同數(shù)據(jù)集大小下的益處是否仍然存在。論文在高預(yù)算下對(duì)MATH數(shù)據(jù)集重復(fù)了實(shí)驗(yàn),但在僅能訪問(wèn)500個(gè)訓(xùn)練數(shù)據(jù)(從訓(xùn)練集中隨機(jī)選擇)時(shí)。論文在圖7中展示了微調(diào)模型的結(jié)果。論文觀察到,使用wC數(shù)據(jù)訓(xùn)練的模型優(yōu)于使用SE數(shù)據(jù)訓(xùn)練的模型,分別為三個(gè)范式實(shí)現(xiàn)了12.939%、11.4%和5.1%的相對(duì)增益。這突顯了在固定采樣預(yù)算的低問(wèn)題體制下,從WC模型生成更多數(shù)據(jù)而不是從SE模型生成數(shù)據(jù)的效用。

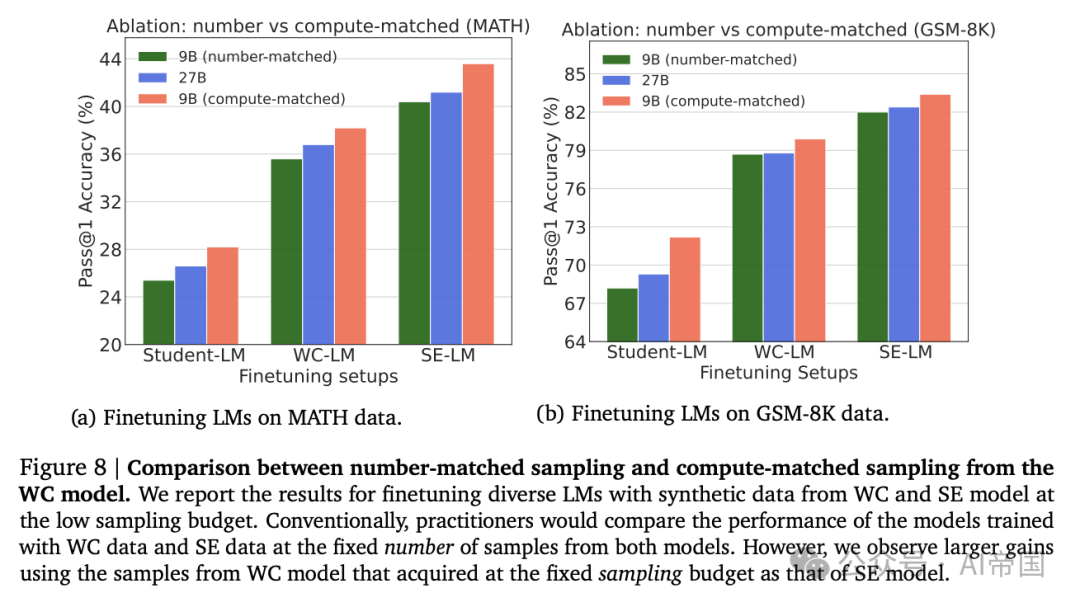

默認(rèn)與計(jì)算最優(yōu)采樣對(duì)比:廉價(jià)語(yǔ)言模型(LM)的采樣策略:論文預(yù)期,先前之所以傾向于使用強(qiáng)模型(SE)數(shù)據(jù)而非弱模型(WC)數(shù)據(jù),是因?yàn)樗鼈冊(cè)跍y(cè)試環(huán)境中采用了等量樣本生成的方式(例如,參見(jiàn)(Singh et al., 2023)),而非計(jì)算資源匹配的設(shè)置。為了驗(yàn)證這一點(diǎn),論文針對(duì)MATH和GSM-8K數(shù)據(jù)集,從WC模型中每個(gè)問(wèn)題僅生成一個(gè)解決方案(數(shù)量匹配),并在篩選出最終答案正確性的基礎(chǔ)上,對(duì)這些生成數(shù)據(jù)在三種微調(diào)設(shè)置下進(jìn)行模型訓(xùn)練。隨后,論文對(duì)比了使用合成數(shù)據(jù)訓(xùn)練的模型性能,其中每個(gè)問(wèn)題從WC模型生成3個(gè)解決方案,采樣計(jì)算量與SE模型相匹配。結(jié)果如圖8所示。論文發(fā)現(xiàn),使用數(shù)量匹配的WC數(shù)據(jù)訓(xùn)練的模型,其性能不如使用計(jì)算匹配的WC數(shù)據(jù)訓(xùn)練的模型,且相較于使用SE數(shù)據(jù)訓(xùn)練的模型效果更差。這表明,未來(lái)在比較弱模型與強(qiáng)模型生成的合成數(shù)據(jù)時(shí),應(yīng)采用計(jì)算資源匹配的采樣策略。

圖 8 數(shù)字匹配采樣與計(jì)算匹配采樣在WC模型中的比較。論文報(bào)告了在低采樣預(yù)算下,使用WC和SE模型生成的合成數(shù)據(jù)對(duì)多種語(yǔ)言模型進(jìn)行微調(diào)的結(jié)果。傳統(tǒng)上,從業(yè)者會(huì)在從兩個(gè)模型中固定數(shù)量的樣本上比較訓(xùn)練模型的性能。然而,論文觀察到,使用與SE模型相同采樣預(yù)算獲取的WC模型樣本,其性能提升更大。

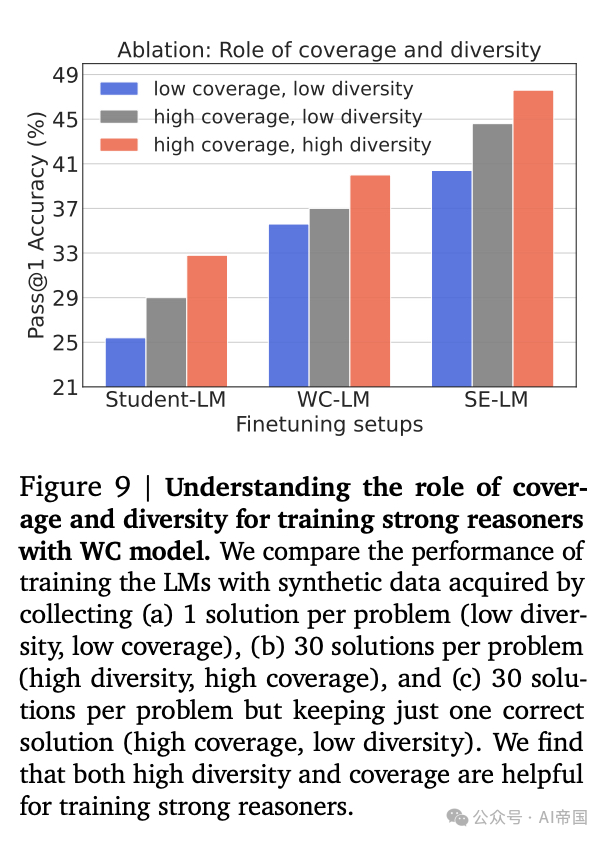

覆蓋率和多樣性:論文旨在理解覆蓋率和多樣性在提升使用WC生成合成數(shù)據(jù)訓(xùn)練模型性能中的作用。為此,對(duì)于MATH數(shù)據(jù)集,論文將原始高采樣(每個(gè)問(wèn)題30個(gè)解決方案)的WC數(shù)據(jù)集視為(高覆蓋率,高多樣性)數(shù)據(jù)集。然后,論文通過(guò)僅從樣本中選擇每個(gè)問(wèn)題的一個(gè)正確解決方案來(lái)構(gòu)建一個(gè)(高覆蓋率,低多樣性)版本。這使得原始WC數(shù)據(jù)集的多樣性從11降低到 1,同時(shí)保持了覆蓋率。論文還創(chuàng)建了一個(gè)(低覆蓋率,低多樣性)數(shù)據(jù)集,其中論文僅從WC模型生成每個(gè)問(wèn)題的一個(gè)解決方案,并對(duì)其最終答案的正確性進(jìn)行過(guò)濾。該數(shù)據(jù)集的覆蓋率(27%)低于每個(gè)問(wèn)題30個(gè)解決方案的WC數(shù)據(jù)集(43%)。論文在這些數(shù)據(jù)集上對(duì)三種微調(diào)設(shè)置進(jìn)行模型訓(xùn)練,并在圖 emptyset 中展示結(jié)果。論文的結(jié)果表明,在所有設(shè)置中,高覆蓋率和高多樣性數(shù)據(jù)優(yōu)于高覆蓋率和低多樣性數(shù)據(jù),而高覆蓋率和低多樣性數(shù)據(jù)優(yōu)于低覆蓋率和低多樣性數(shù)據(jù)。這表明覆蓋率和多樣性在從小型語(yǔ)言模型訓(xùn)練強(qiáng)大推理器時(shí)都起著關(guān)鍵作用。

圖 9 | 理解覆蓋率和多樣性在利用WC模型訓(xùn)練強(qiáng)推理器中的作用。論文比較了通過(guò)收集(a)每個(gè)問(wèn)題1個(gè)解決方案(低多樣性,低覆蓋率),(b)每個(gè)問(wèn)題30個(gè)解決方案(高多樣性,高覆蓋率),以及(c)每個(gè)問(wèn)題30個(gè)解決方案但僅保留一個(gè)正確解決方案(高覆蓋率,低多樣性)獲得的合成數(shù)據(jù)訓(xùn)練語(yǔ)言模型(LMs)的性能。論文發(fā)現(xiàn),高多樣性和覆蓋率都有助于訓(xùn)練強(qiáng)推理器。

2.6. 擴(kuò)展至SOTA的語(yǔ)言模型

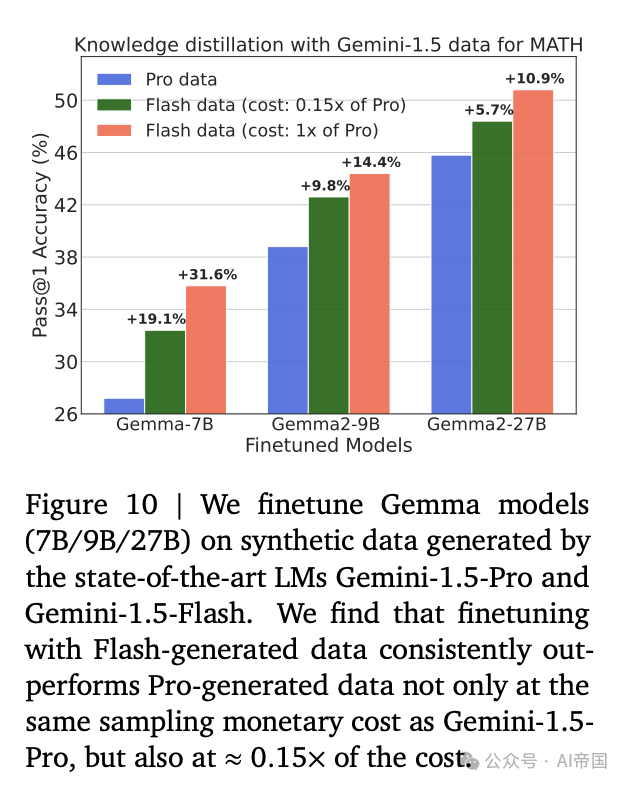

在前述實(shí)驗(yàn)中,論文專注于從開(kāi)放式LMs獲取合成數(shù)據(jù)。在這里,論文的目標(biāo)是在固定采樣預(yù)算下,展示來(lái)自較弱SoTA LM的數(shù)據(jù)能夠訓(xùn)練出比更強(qiáng)SoTA LM更好的推理器。為此,論文將論文的方法擴(kuò)展到從Gemini-1.5-Pro和Gemini-1.5-Flash采樣數(shù)據(jù)。由于模型大小未公開(kāi),論文利用每輸出token的定價(jià)比例作為代理來(lái)執(zhí)行計(jì)算匹配采樣。截至2024年8月,論文注意到每百萬(wàn)輸出token的價(jià)格分別為Gemini-1.5-Pro的10.5和Gemini-1.5-Flash的0.3。因此,論文從1.5-Pro和1.5-Flash分別采樣1個(gè)和35個(gè)解決方案。論文在MATH數(shù)據(jù)集上進(jìn)行了實(shí)驗(yàn)。

圖10 | 論文在由最先進(jìn)的語(yǔ)言模型Gemini-1.5-Pro和Gemini-1.5-Flash生成的合成數(shù)據(jù)上對(duì)Gemma模型(7B/9B/27B)進(jìn)行微調(diào)。論文發(fā)現(xiàn),使用Flash生成的數(shù)據(jù)進(jìn)行微調(diào)不僅在與Gemini-1.5-Pro相同的采樣成本下始終優(yōu)于使用Pro生成的數(shù)據(jù),而且在約0.15倍的成本下也表現(xiàn)更佳。

論文對(duì)Gemma- 7 B、Gemma2- 9 B 和 Gemma2-27B LMs 進(jìn)行了知識(shí)蒸餾,使用來(lái)自Pro(SED)和Flash(WC)模型的合成數(shù)據(jù)。論文在圖10中展示了結(jié)果。有趣的是,論文發(fā)現(xiàn)使用WC數(shù)據(jù)進(jìn)行微調(diào)優(yōu)于使用SE數(shù)據(jù),分別為Gemma- 7 B、Gemma2- 9 B 和 Gemma2-27B 分別實(shí)現(xiàn)了31.6%、14.4%和10.9%的相對(duì)增益。這可以歸因于在固定采樣預(yù)算下模型覆蓋率的差異,1.5-Pro和1.5-Flash的覆蓋率分別為61.1%和81%。

降低數(shù)據(jù)采樣的成本。此外,論文研究了使用比從SE模型中收集每個(gè)問(wèn)題一個(gè)解決方案更經(jīng)濟(jì)的WC數(shù)據(jù)來(lái)訓(xùn)練LMs。具體而言,論文通過(guò)從最先進(jìn)的LMs Gemini-1.5-Pro和Flash(WC)模型中為每個(gè)問(wèn)題采樣5個(gè)解決方案來(lái)創(chuàng)建數(shù)據(jù)集,這在價(jià)格上比從Pro(SE)模型生成一個(gè)解決方案經(jīng)濟(jì)7倍(Phi)。在訓(xùn)練LMs于0.15倍成本數(shù)據(jù)的情況下(圖10),論文發(fā)現(xiàn)使用Flash生成的數(shù)據(jù)進(jìn)行微調(diào)不僅在采樣成本上與Gemini-1.5-Pro相同,而且在0.15倍成本下也能表現(xiàn)更優(yōu)。

要點(diǎn):論文證明了從較弱的SoTA LM中進(jìn)行價(jià)格匹配采樣產(chǎn)生的推理器優(yōu)于從較強(qiáng)的SoTA模型中微調(diào)的數(shù)據(jù)

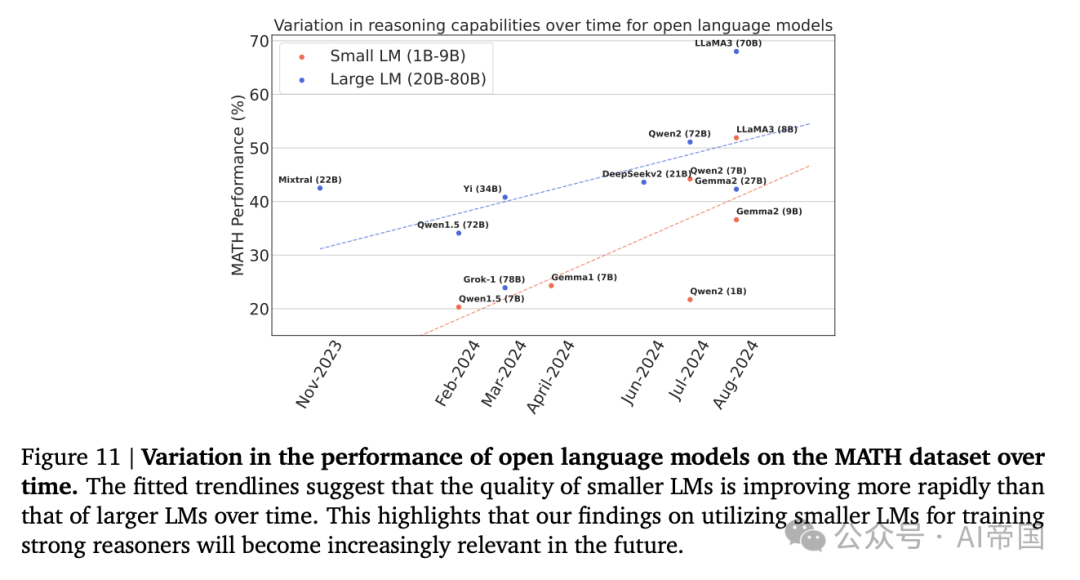

圖11 | 開(kāi)放語(yǔ)言模型在MATH數(shù)據(jù)集上性能隨時(shí)間的變化。擬合的趨勢(shì)線表明,小型語(yǔ)言模型(LM)的質(zhì)量隨時(shí)間提升速度比大型語(yǔ)言模型(LV)更快。這突顯了論文關(guān)于利用小型LM訓(xùn)練強(qiáng)大推理者的發(fā)現(xiàn)將在未來(lái)變得越來(lái)越相關(guān)。

本文轉(zhuǎn)載自 ??AI帝國(guó)??,作者:無(wú)影寺