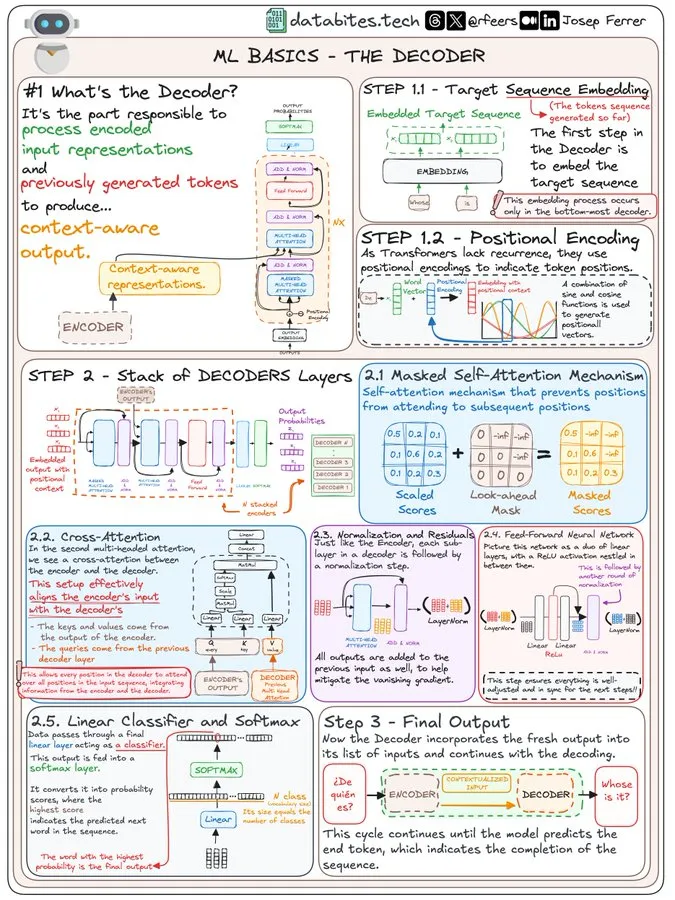

【大模型】圖解Transformers Decoder

前面圖解了Transformer整體架構和編碼器,今天圖解解碼器。

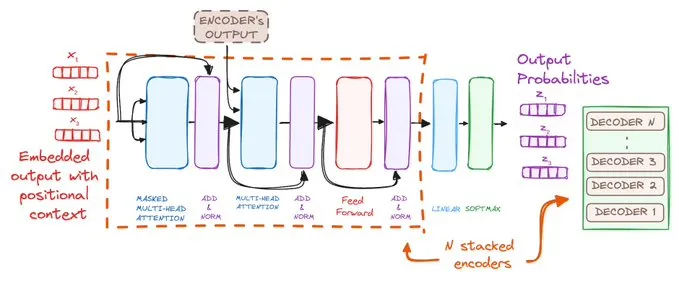

先來個整體視角:

再逐步分解開來:

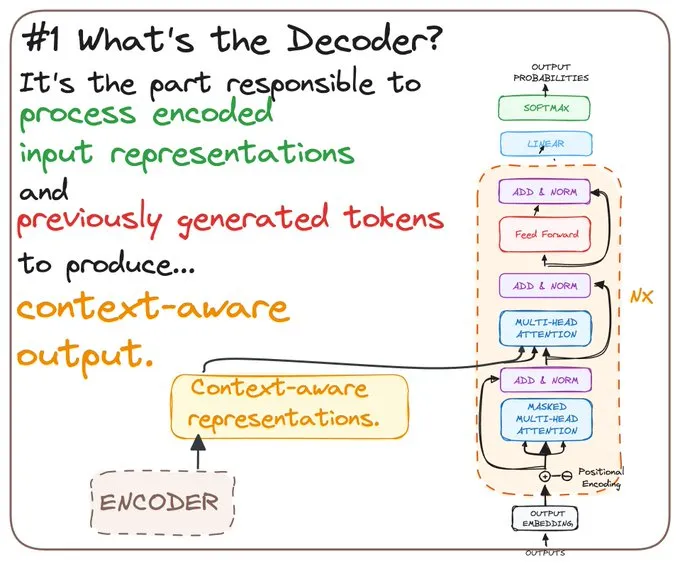

WHAT'S THE DECODER?

解碼器是將編碼輸入和先前生成的標記轉換為上下文感知輸出的關鍵所在。

可以把它想象成藝術家,從草圖中繪制出最終的畫作。???

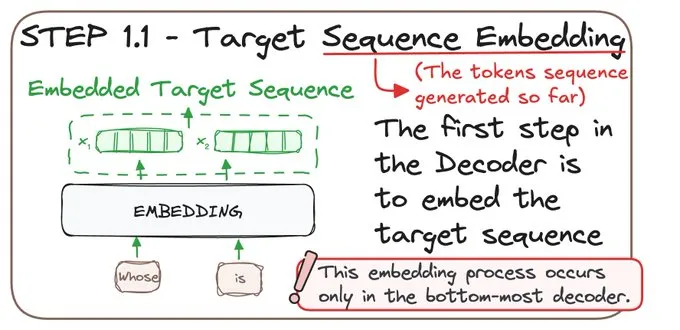

STEP 1 - PROCESSING THE TARGET SEQUENCE

STEP 1.1 Target Sequence Embedding

解碼器首先對需要處理的序列進行嵌入,將原始數據轉換為其能夠理解的格式。

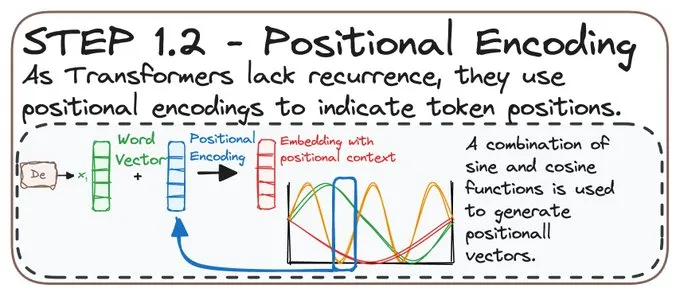

STEP 1.2 Positional Encoding

由于 Transformers 不像RNN等時序模型那樣依賴序列順序,它們使用位置編碼。

這為‘what’添加了一層‘where’——這對全面理解序列至關重要!

STEP 2 - LAYERING THE DECODERS

解碼器由多個層組成,每一層都會精煉輸出:

? Masked Self-Attention

? Cross-Attention.

? Normalization and Residuals.

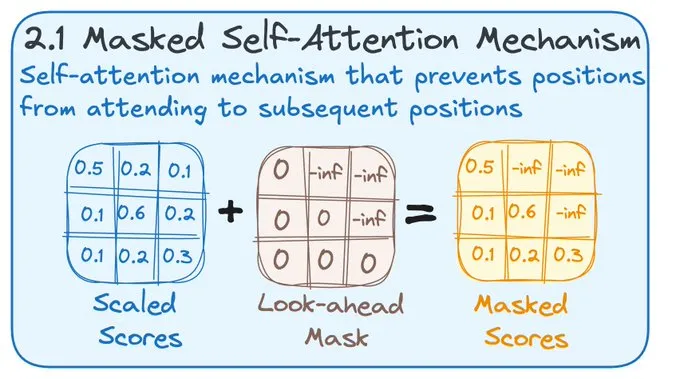

STEP 2.1 MASKED SELF-ATTENTION

在自注意力步驟中,解碼器確保不會提前查看。可以把它想象成解謎時不跳過去看整個圖案。

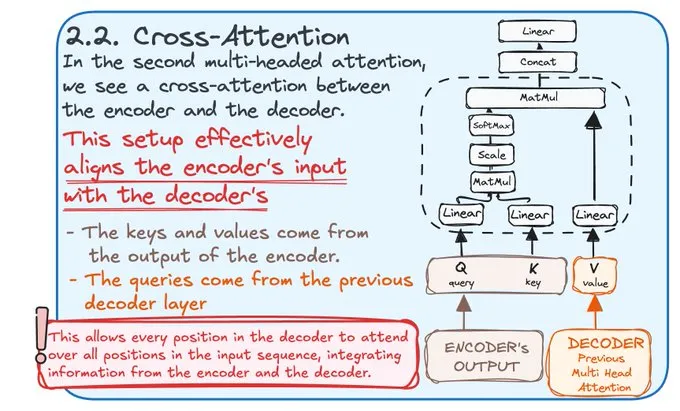

STEP 2.2 CROSS-ATTENTION

在這里,解碼器將編碼器的輸入與其處理對齊,確保每個信息片段都完美同步。

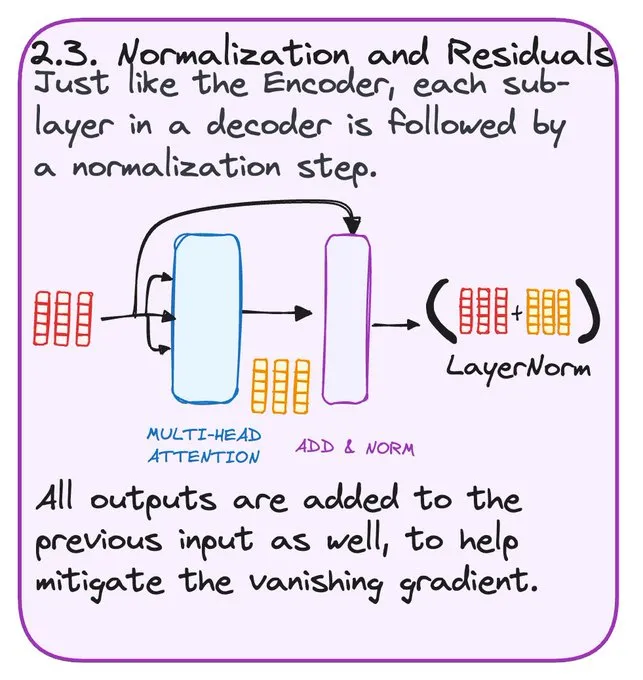

STEP 2.3 NORMALIZATION AND RESIDUALS

歸一化保持數據平滑和統一,防止任何部分壓倒其他部分。

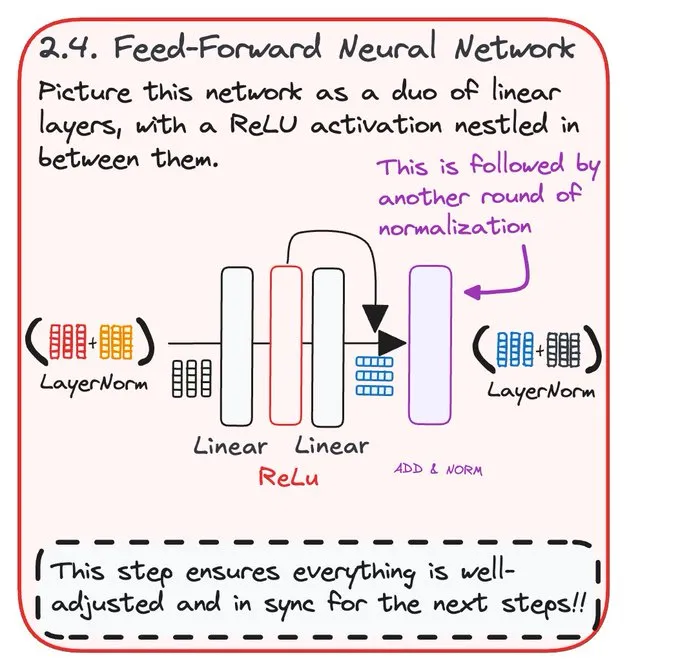

STEP 2.4 FEED-FORWARD NEURAL NETWORK

這一步通過前饋網絡增強解碼器的預測。

這確保了一切都經過調整并與后續步驟保持同步。

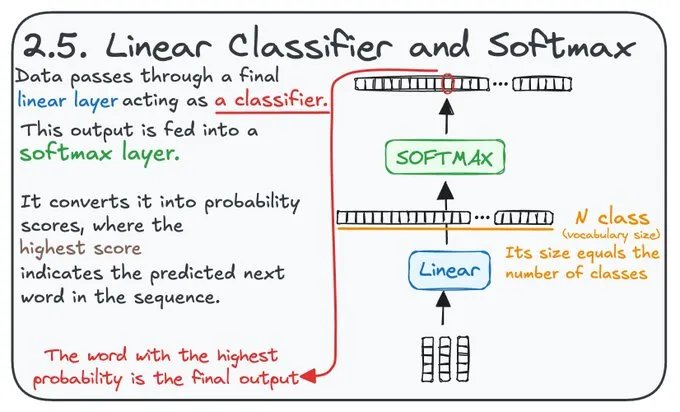

STEP 2.5 LINEAR CLASSIFIER AND SOFTMAX

將分數轉換為概率,這一步決定最可能的下一個詞。它作為分類器,概率最高的詞就是解碼器的最終輸出。

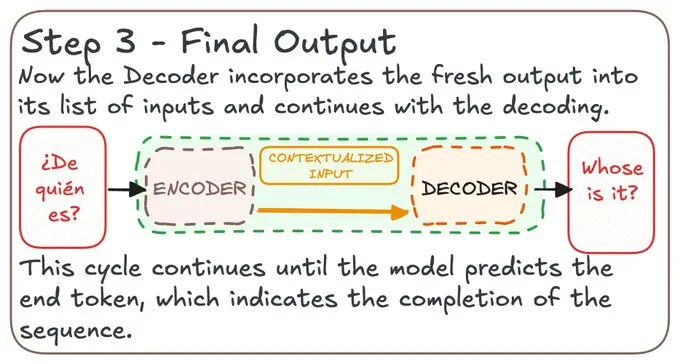

STEP 3 FINAL OUTPUT

解碼器將所有處理過的信息編織在一起,以預測序列的下一部分。

這個過程持續進行,直到序列完成,生成一個完整且富有上下文的信息輸出。??

本文轉載自公眾號人工智能大講堂

原文鏈接:??https://mp.weixin.qq.com/s/Vib688qjHRe6jhm06lDMjA???

標簽

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦