LLaMA-Omni:專為與大型語(yǔ)言模型(LLMs)進(jìn)行低延遲、高質(zhì)量的語(yǔ)音交互而設(shè)計(jì) 原創(chuàng) 精華

大型語(yǔ)言模型(LLMs)如GPT-4等,已經(jīng)在多個(gè)領(lǐng)域展示了其強(qiáng)大的能力,能夠通過(guò)對(duì)話幫助人們完成各種任務(wù)。然而,這些模型在需要語(yǔ)音輸入或輸出的場(chǎng)景中仍面臨顯著的限制。盡管最近的技術(shù)進(jìn)展,如GPT-4o,提升了語(yǔ)音交互的響應(yīng)速度,但依然存在延遲和質(zhì)量方面的挑戰(zhàn)。如何實(shí)現(xiàn)低延遲且高質(zhì)量的語(yǔ)音交互,成為開源社區(qū)亟待解決的問(wèn)題。

01、概述

為了實(shí)現(xiàn)與LLMs的語(yǔ)音交互,研究者們嘗試了多種方法,每種方法都有其局限性。最常見(jiàn)的做法是將自動(dòng)語(yǔ)音識(shí)別(ASR)和文本到語(yǔ)音(TTS)模型串聯(lián)使用,但這種方法由于逐步處理轉(zhuǎn)錄文本、生成文本響應(yīng)和語(yǔ)音響應(yīng),往往導(dǎo)致較高的延遲。為了改進(jìn)這一點(diǎn),一些研究提出了多模態(tài)語(yǔ)音-語(yǔ)言模型,嘗試將語(yǔ)音離散化為標(biāo)記,并擴(kuò)展LLM詞匯表以支持語(yǔ)音輸入和輸出。雖然理論上這些模型能夠?qū)崿F(xiàn)低延遲的語(yǔ)音到語(yǔ)音生成,但實(shí)際上仍需生成中間文本以保持高質(zhì)量,從而犧牲了一部分響應(yīng)速度。

此外,還有嘗試通過(guò)在語(yǔ)義或聲學(xué)標(biāo)記上訓(xùn)練語(yǔ)言模型,或?qū)⒄Z(yǔ)音編碼器添加到LLMs中,以提高語(yǔ)音理解能力。然而,這些方法通常需要大量的數(shù)據(jù)和計(jì)算資源,或者只專注于語(yǔ)音理解,而忽視了生成能力。

02、LLaMA-Omni的突破性創(chuàng)新

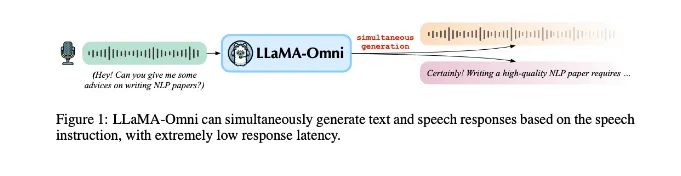

為了突破這些限制,中國(guó)科學(xué)院大學(xué)的研究團(tuán)隊(duì)推出了一種名為L(zhǎng)LaMA-Omni的全新模型架構(gòu)。LLaMA-Omni的設(shè)計(jì)目標(biāo)是實(shí)現(xiàn)與LLMs的低延遲和高質(zhì)量的語(yǔ)音交互。其創(chuàng)新之處在于集成了語(yǔ)音編碼器、語(yǔ)音適配器、LLM和流式語(yǔ)音解碼器,能夠?qū)崿F(xiàn)無(wú)縫的語(yǔ)音到語(yǔ)音通信。具體來(lái)說(shuō),該模型通過(guò)直接處理語(yǔ)音輸入繞過(guò)了中間文本轉(zhuǎn)錄的步驟,顯著減少了響應(yīng)延遲。

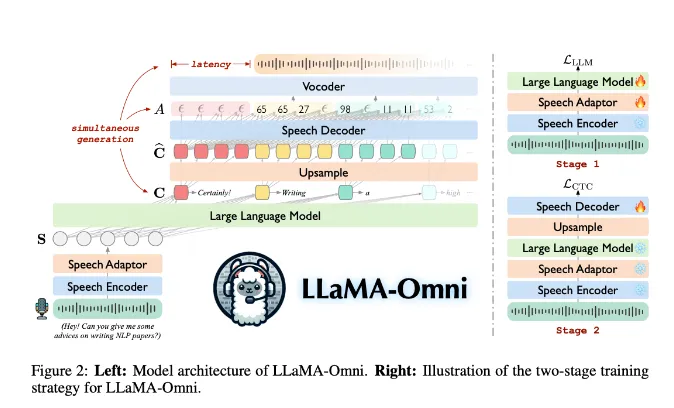

LLaMA-Omni的架構(gòu)主要包括四個(gè)部分:語(yǔ)音編碼器、語(yǔ)音適配器、LLM和語(yǔ)音解碼器。語(yǔ)音編碼器基于Whisper-large-v3,從用戶的語(yǔ)音輸入中提取有意義的表示。接著,這些表示經(jīng)過(guò)語(yǔ)音適配器處理,通過(guò)下采樣和兩層感知器映射到LLM的嵌入空間。LLM則基于Llama-3.1-8B-Instruct直接從語(yǔ)音指令生成文本響應(yīng)。而語(yǔ)音解碼器,一個(gè)非自回歸流式Transformer,利用連接時(shí)序分類(CTC)預(yù)測(cè)與語(yǔ)音響應(yīng)相對(duì)應(yīng)的離散單元,實(shí)現(xiàn)了文本和語(yǔ)音的同步生成。

03、LLaMA-Omni的訓(xùn)練與評(píng)估

LLaMA-Omni采用了兩階段的訓(xùn)練策略。第一階段關(guān)注從語(yǔ)音指令生成文本響應(yīng),第二階段則專注于生成語(yǔ)音響應(yīng)。在推理過(guò)程中,LLaMA-Omni能夠同時(shí)生成文本和語(yǔ)音響應(yīng),語(yǔ)音解碼器在LLM生成文本的同時(shí)實(shí)時(shí)轉(zhuǎn)換為語(yǔ)音波形。這種方法實(shí)現(xiàn)了極低延遲的語(yǔ)音交互,使得用戶在文本完全生成之前即可聽到響應(yīng)。

為了支持LLaMA-Omni的開發(fā)和評(píng)估,研究人員創(chuàng)建了InstructS2S-200K數(shù)據(jù)集。該數(shù)據(jù)集包含200,000個(gè)語(yǔ)音指令、文本響應(yīng)和語(yǔ)音響應(yīng)的三元組。構(gòu)建過(guò)程包括使用Llama-3-70B-Instruct重寫文本指令以適應(yīng)語(yǔ)音,生成適合語(yǔ)音的簡(jiǎn)潔響應(yīng),并使用CosyVoice-300M-SFT和VITS進(jìn)行語(yǔ)音合成。該數(shù)據(jù)集結(jié)合了Alpaca的50,000條條目和UltraChat的150,000條條目,涵蓋了廣泛的主題,為L(zhǎng)LaMA-Omni在語(yǔ)音交互任務(wù)上的訓(xùn)練提供了堅(jiān)實(shí)基礎(chǔ)。

04、未來(lái)展望

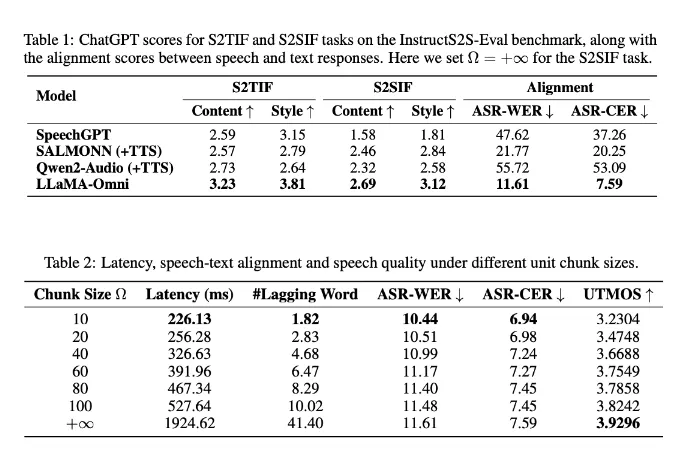

LLaMA-Omni在InstructS2S-Eval基準(zhǔn)測(cè)試中的表現(xiàn)優(yōu)于之前的模型,特別是在語(yǔ)音到文本和語(yǔ)音到語(yǔ)音指令的內(nèi)容和風(fēng)格一致性上。模型在語(yǔ)音質(zhì)量和響應(yīng)延遲之間提供了良好的權(quán)衡,延遲低至226毫秒。與其他模型相比,LLaMA-Omni的文本和語(yǔ)音同時(shí)生成能力顯著提高了解碼速度。案例研究顯示,LLaMA-Omni能夠提供更簡(jiǎn)潔、更詳細(xì)且更有幫助的響應(yīng),特別適合語(yǔ)音交互場(chǎng)景。

總之,LLaMA-Omni作為一種創(chuàng)新的AI模型架構(gòu),不僅在低延遲和高質(zhì)量的語(yǔ)音交互方面實(shí)現(xiàn)了突破,還通過(guò)創(chuàng)建專門的數(shù)據(jù)集和優(yōu)化訓(xùn)練過(guò)程,推動(dòng)了基于LLMs的語(yǔ)音交互技術(shù)的發(fā)展。其卓越的性能和高效的訓(xùn)練過(guò)程,為未來(lái)的語(yǔ)音交互模型的快速開發(fā)奠定了基礎(chǔ)。

參考:

本文轉(zhuǎn)載自公眾號(hào)Halo咯咯 作者:基咯咯

原文鏈接:??https://mp.weixin.qq.com/s/LLMNcrcjsJ47MwsaKeXDLA??