南大&阿里發(fā)布多模態(tài)大模型WINGS,解決基于LLM的多模態(tài)訓(xùn)練災(zāi)難遺忘問題

今天給大家介紹一篇南京大學(xué)、阿里巴巴聯(lián)合發(fā)表的多模態(tài)模型建模方法WINGS,解決基于LLM的多模態(tài)模型在進行跨模態(tài)建模時的災(zāi)難遺忘問題。

論文標(biāo)題:WINGS: Learning Multimodal LLMs without Text-only Forgetting

下載地址:??https://arxiv.org/pdf/2406.03496??

1.研究背景

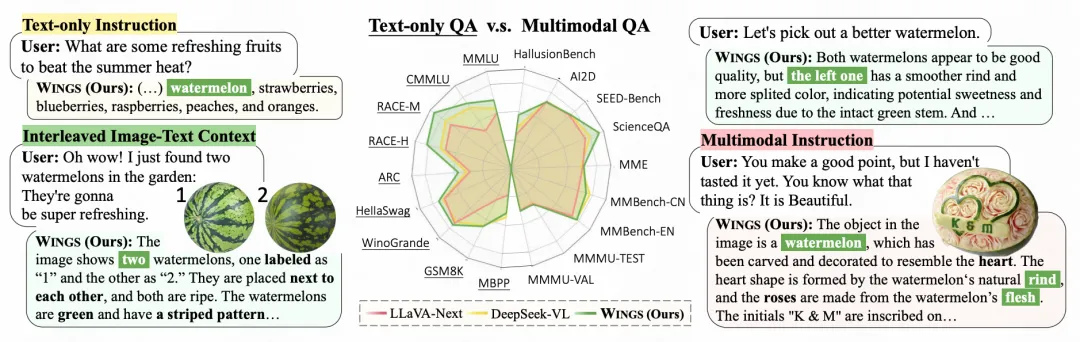

隨著人工智能技術(shù)的進步,多模態(tài)大型語言模型(MLLMs)作為大型語言模型(LLMs)的擴展,已經(jīng)在視覺相關(guān)的描述生成、理解、推理等方面展現(xiàn)出驚人的性能。這些模型通過整合視覺輸入(如圖像)和文本輸入,能夠處理更復(fù)雜的任務(wù)。

盡管MLLMs在多模態(tài)任務(wù)中表現(xiàn)出色,但研究發(fā)現(xiàn)它們在訓(xùn)練過程中會遺忘初始LLM所掌握的純文本指令。這種現(xiàn)象被稱為“災(zāi)難性遺忘”,嚴(yán)重影響了模型在僅涉及文本的任務(wù)上的性能。

為了解決災(zāi)難性遺忘問題,現(xiàn)有的方法通常需要額外的文本數(shù)據(jù)進行訓(xùn)練,這不僅增加了計算開銷,還面臨數(shù)據(jù)收集的挑戰(zhàn)。此外,一些方法通過在LLM和MLLM之間切換來處理圖像是否包含的情況,這增加了部署內(nèi)存的需求,并且在長期的視覺和語言交替對話中不太高效。

為了使MLLMs在實際應(yīng)用中更加有效,需要它們既能處理純文本任務(wù),也能處理多模態(tài)任務(wù)。用戶經(jīng)常以純文本查詢開始,如果不滿足,則可能會補充圖像內(nèi)容。因此,MLLMs需要在保持對文本信息關(guān)注的同時,也能處理視覺信息。

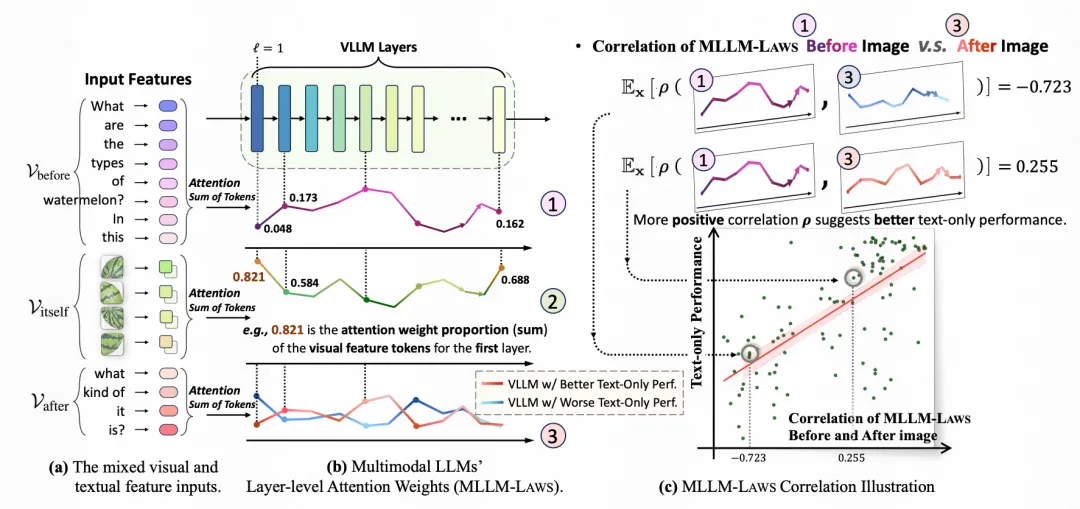

論文通過分析MLLM的注意力權(quán)重,發(fā)現(xiàn)文本遺忘現(xiàn)象與注意力從圖像前文本轉(zhuǎn)移到圖像后文本有關(guān)。這種注意力的轉(zhuǎn)移表明模型過度關(guān)注視覺元素,而忽視了文本元素。

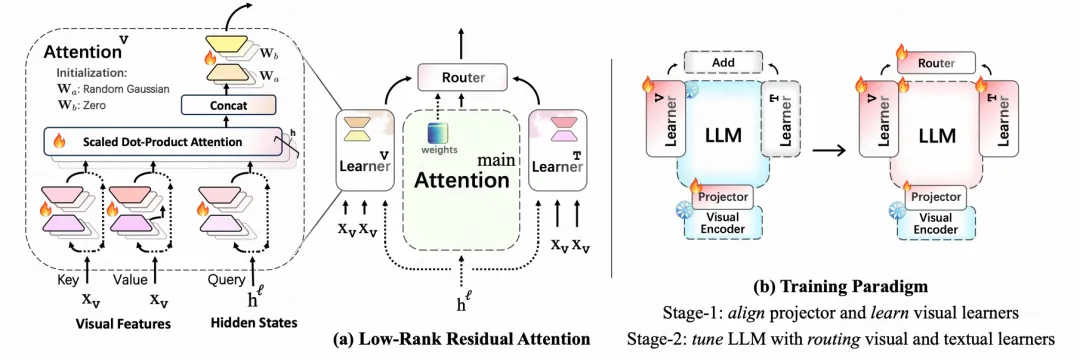

為了解決上述問題,論文提出了WINGS模型,它通過引入額外的模塊來補償注意力轉(zhuǎn)移,這些模塊作為增強學(xué)習(xí)者,與主注意力并行工作,以平衡對視覺和文本元素的關(guān)注。

WINGS模型采用了低秩殘差注意力(LoRRA)設(shè)計,以保證高效率,同時在文本和視覺問答任務(wù)中實現(xiàn)卓越的性能。

綜上所述,這篇論文的背景和動機是解決MLLMs在多模態(tài)學(xué)習(xí)中遇到的災(zāi)難性遺忘問題,并提高模型在處理純文本和多模態(tài)任務(wù)時的效率和性能,以實現(xiàn)更廣泛的應(yīng)用和更好的用戶體驗。

2.建模方法

WINGS模型和核心點包含以下幾個方面。

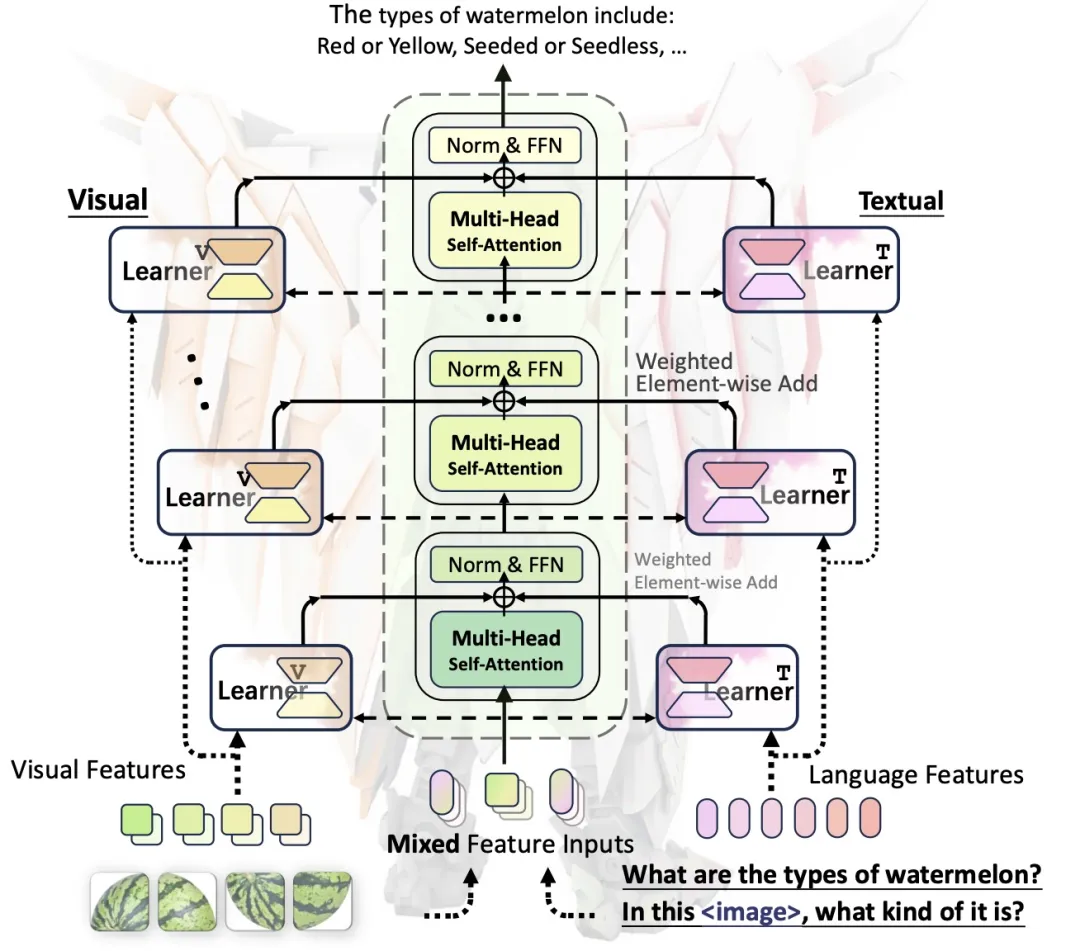

視覺和文本學(xué)習(xí)者的并行結(jié)構(gòu):WINGS通過在每個注意力層級中引入視覺學(xué)習(xí)者(LearnerV)和文本學(xué)習(xí)者(LearnerT),這兩個學(xué)習(xí)者并行工作,分別增強模型對視覺和文本特征的關(guān)注,這種結(jié)構(gòu)設(shè)計提高了模型處理多模態(tài)數(shù)據(jù)的能力。

基于注意力權(quán)重的動態(tài)路由:WINGS利用基于注意力權(quán)重的路由機制來動態(tài)調(diào)整視覺和文本學(xué)習(xí)者的輸出,這種機制可以根據(jù)當(dāng)前的注意力分布來優(yōu)化模型的響應(yīng),提高了模型的適應(yīng)性和靈活性。

低秩殘差注意力(LoRRA):WINGS采用了低秩殘差注意力(Low-Rank Residual Attention, LoRRA)架構(gòu),這種架構(gòu)通過使用低秩矩陣來減少參數(shù)數(shù)量和計算需求,同時保持了模型的效率和性能。

分階段訓(xùn)練策略:WINGS采用了分階段訓(xùn)練策略,首先對視覺學(xué)習(xí)者進行訓(xùn)練,然后逐步引入文本學(xué)習(xí)者和路由機制,這種策略有助于逐步調(diào)整和優(yōu)化模型,使其更好地適應(yīng)多模態(tài)數(shù)據(jù)。

新構(gòu)建的交錯圖像-文本(IIT)基準(zhǔn)測試:WINGS的研究人員構(gòu)建了一個新的基準(zhǔn)測試,即交錯圖像-文本(Interleaved Image-Text, IIT)基準(zhǔn)測試,這個基準(zhǔn)測試包含了從純文本到強烈圖像相關(guān)的多輪對話,用于更全面地評估模型在多模態(tài)任務(wù)上的性能。

多模態(tài)混合輸入的處理能力:WINGS能夠處理混合了視覺和文本特征的輸入,這種能力使得模型可以更靈活地應(yīng)用于各種實際場景,如視覺問答、圖像描述生成等。

模型的可擴展性和適應(yīng)性:WINGS展示了在不同規(guī)模的模型中的可擴展性,包括WINGSbase、WINGSpro和WINGS1.8B版本,這些版本適應(yīng)不同的應(yīng)用場景和設(shè)備要求,顯示了模型的廣泛適用性。

對注意力機制的深入分析和應(yīng)用:WINGS通過深入分析MLLM的注意力機制,揭示了注意力權(quán)重與模型性能之間的關(guān)系,并據(jù)此設(shè)計了模型結(jié)構(gòu)和訓(xùn)練策略,這種對注意力機制的深入理解和應(yīng)用是WINGS的一個顯著特點。

這些創(chuàng)新點共同使得WINGS模型在多模態(tài)任務(wù)中表現(xiàn)出色,不僅解決了災(zāi)難性遺忘問題,還提高了模型的效率、適應(yīng)性和泛化能力。

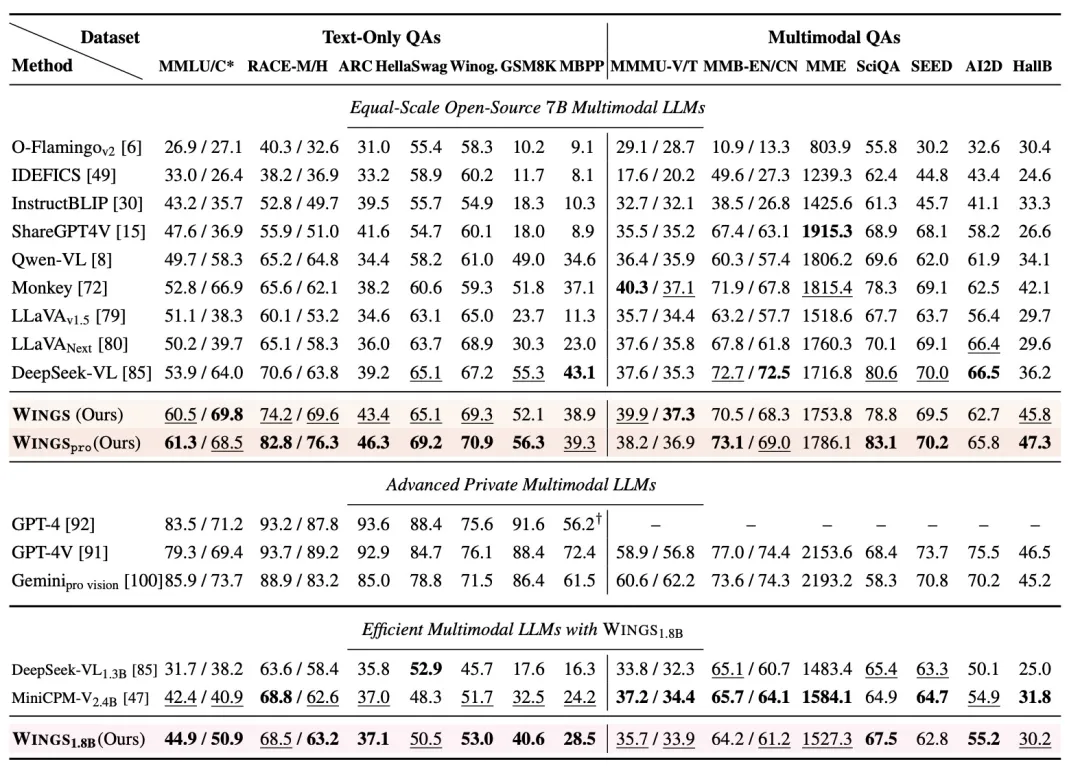

3.實驗分析

在解決多模態(tài)訓(xùn)練過程中對文本指令的災(zāi)難性遺忘問題。實驗結(jié)論主要包括以下幾點:

文本指令遺忘現(xiàn)象:論文驗證了多模態(tài)大型語言模型(MLLM)在訓(xùn)練過程中對初始大型語言模型(LLM)已掌握的純文本指令的遺忘現(xiàn)象,并將此現(xiàn)象與跨層MLLM-LAWS(Layer-level Attention Weights)前后圖像的注意力轉(zhuǎn)移相關(guān)聯(lián)。

WINGS架構(gòu)的有效性:WINGS通過引入視覺和文本學(xué)習(xí)者以及基于轉(zhuǎn)移注意力權(quán)重的路由機制,有效地補償了注意力轉(zhuǎn)移。實驗結(jié)果表明,WINGS在同等規(guī)模的MLLM中,在文本指令和視覺問答任務(wù)上均表現(xiàn)優(yōu)異。

性能比較:WINGS在多個基準(zhǔn)測試中超越了其他同等規(guī)模的MLLM,包括文本指令遺忘測試、通用多模態(tài)基準(zhǔn)測試,以及新構(gòu)建的交錯圖像-文本(IIT)基準(zhǔn)測試。WINGS在從純文本到多模態(tài)豐富的問答任務(wù)中展現(xiàn)了卓越的性能。

效率與性能:WINGS采用了低秩殘差注意力(LoRRA)設(shè)計,確保了學(xué)習(xí)者的高效率。實驗結(jié)果表明,WINGS在保持文本指令性能的同時,也能在多模態(tài)任務(wù)中提高性能,尤其是在資源受限的情況下。

可擴展性:WINGS證明了其在不同規(guī)模的模型中的可擴展性,包括WINGSbase、WINGSpro和WINGS1.8B版本,適應(yīng)不同的應(yīng)用場景和設(shè)備要求。

訓(xùn)練策略:論文還探討了不同的訓(xùn)練策略,包括學(xué)習(xí)率設(shè)置和訓(xùn)練階段,發(fā)現(xiàn)較低的學(xué)習(xí)率有助于保持文本任務(wù)的性能,而較高的學(xué)習(xí)率則有助于提升多模態(tài)任務(wù)的性能。

組件有效性:通過消融研究,論文分析了WINGS各個組件的有效性,發(fā)現(xiàn)僅包含視覺學(xué)習(xí)者可以輕微保持文本任務(wù)的性能,但會降低多模態(tài)任務(wù)的性能。

綜上所述,WINGS通過其創(chuàng)新的架構(gòu)和訓(xùn)練策略,在處理純文本和多模態(tài)任務(wù)時均展現(xiàn)出了卓越的性能和泛化能力。