vLLM 2024 年度回顧與 2025 展望:從專業(yè)引擎向開放平臺(tái)邁進(jìn)

2024 年重要成就

社區(qū)建設(shè)與生態(tài)發(fā)展

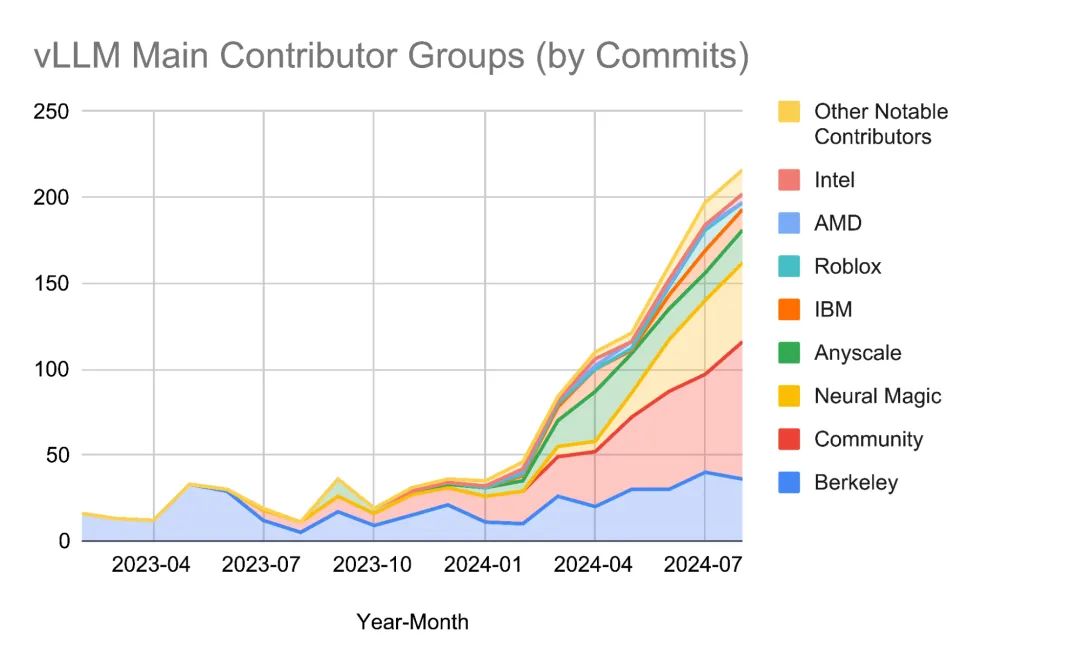

2024 年,vLLM 建立起了一個(gè)充滿活力的開源社區(qū)。目前已有超過 15 位全職貢獻(xiàn)者來自 6個(gè)以上的組織,20 多家機(jī)構(gòu)作為核心利益相關(guān)方和贊助商,包括加州伯克利大學(xué)、 Neural Magic 、Anyscale 等頂級(jí)機(jī)構(gòu)。雙周例會(huì)的良好運(yùn)作促進(jìn)了社區(qū)透明度提升和戰(zhàn)略合作的達(dá)成。

全面的模型支持

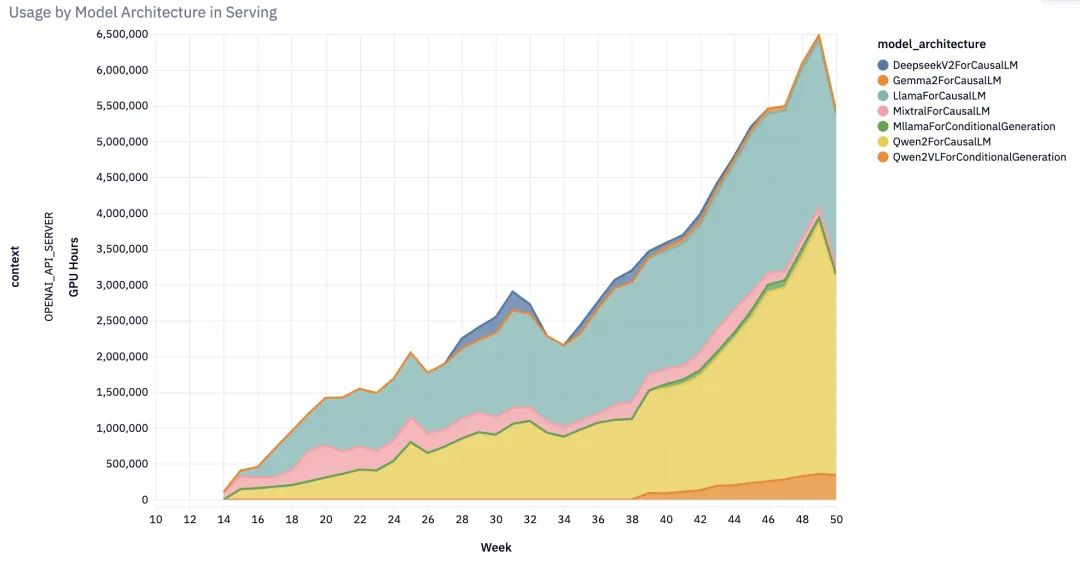

從年初僅支持少數(shù)模型,到年末已能支持近 100 種模型架構(gòu),覆蓋幾乎所有主流開源大語(yǔ)言模型、多模態(tài)模型(圖像、音頻、視頻)、編碼器-解碼器模型等。特別值得一提的是,vLLM 開創(chuàng)性地為狀態(tài)空間語(yǔ)言模型提供了生產(chǎn)級(jí)支持。

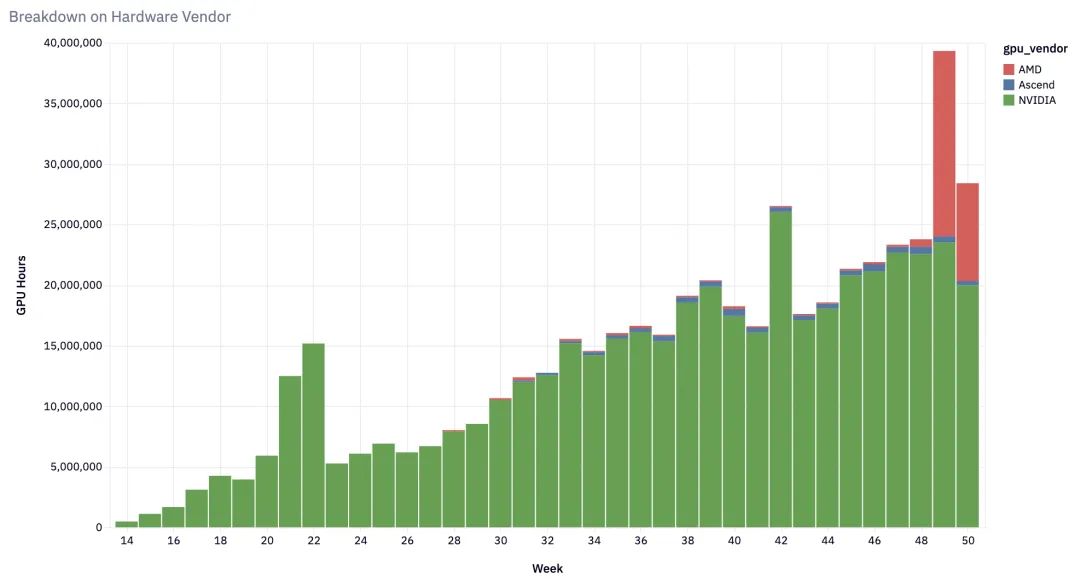

硬件兼容性突破

vLLM 實(shí)現(xiàn)了對(duì)主流 AI 硬件的全面支持:

- NVIDIA 系列:從 V100 到H100 的全系列 GPU

- AMD 產(chǎn)品線:MI200 、MI300 和Radeon RX 7900 系列

- 云服務(wù)商硬件:Google TPU 、AWS Inferentia/Trainium

- 其他平臺(tái):Intel Gaudi 、多種架構(gòu) CPU 等

核心特性持續(xù)創(chuàng)新

2024 年,vLLM 推出了多項(xiàng)重要功能升級(jí):

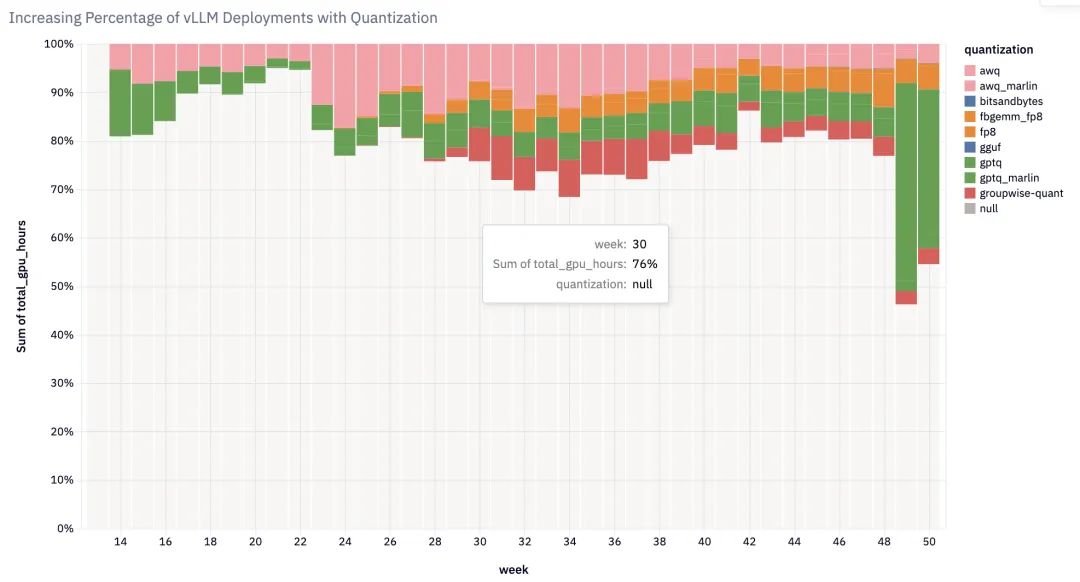

- 權(quán)重和激活量化:支持多種量化方法,提升推理效率

- 自動(dòng)前綴緩存:降低上下文處理成本

- 分塊預(yù)填充:提升交互應(yīng)用的穩(wěn)定性

- 推測(cè)解碼:通過并行預(yù)測(cè)加速生成

- 結(jié)構(gòu)化輸出:支持 JSON 等特定格式輸出

- 分布式推理:實(shí)現(xiàn)跨 GPU 和節(jié)點(diǎn)的工作負(fù)載擴(kuò)展

2025年發(fā)展愿景

模型能力升級(jí)

2025 年,vLLM 的核心目標(biāo)是在單個(gè) GPU 上實(shí)現(xiàn) GPT-4 級(jí)別的性能,并在單個(gè)節(jié)點(diǎn)上支持更大規(guī)模模型的部署。為此,團(tuán)隊(duì)將重點(diǎn)優(yōu)化以下方面:

- KV 緩存和注意力機(jī)制優(yōu)化

- 混合專家系統(tǒng)(MoE)優(yōu)化

- 擴(kuò)展長(zhǎng)上下文支持

生產(chǎn)級(jí)部署支持?jǐn)U展

隨著 LLM 成為現(xiàn)代應(yīng)用的核心,vLLM 計(jì)劃為生產(chǎn)環(huán)境提供更完善的支持:

- 量化、緩存等優(yōu)化功能將成為默認(rèn)配置

- 提供完整的集群級(jí)解決方案

- 針對(duì)不同場(chǎng)景優(yōu)化的部署方案

開放架構(gòu)

vLLM 將推出全新的 V1 架構(gòu),突出開放性和可擴(kuò)展性:

- 可插拔架構(gòu)設(shè)計(jì)

- 一流的 torch.compile 支持

- 靈活的組件系統(tǒng)

小結(jié)

大浪淘沙,vLLM成功的在大模型領(lǐng)域競(jìng)爭(zhēng)中脫穎而出。vLLM 正在從一個(gè)簡(jiǎn)單的推理引擎,發(fā)展成為連接模型開發(fā)者、硬件供應(yīng)商和應(yīng)用開發(fā)者的開放平臺(tái)。同時(shí),vLLM不忘初心,重申使命:構(gòu)建世界上最快、最容易使用的開源LLM推理和服務(wù)引擎。

期待2025年vLLM的表現(xiàn),同時(shí)也希望有更多新的框架和工具誕生,加速AI推理的發(fā)展。

原文:https://blog.vllm.ai/2025/01/10/vllm-2024-wrapped-2025-vision.html