2025首篇關于多模態(tài)大模型在富文本圖像理解上的全面研究綜述

文本豐富的圖像(如文檔、圖表、場景圖等)在現(xiàn)實場景中扮演著重要角色,準確理解這些圖像對于自動化信息提取和優(yōu)化用戶交互至關重要。文本豐富圖像理解(Text-rich Image Understanding, TIU)領域涉及兩個核心能力:

- 感知(如文本檢測、識別)

- 理解(如信息抽取、視覺問答)

多模態(tài)大語言模型(MLLMs)的出現(xiàn)為文本豐富的圖像理解(TIU)領域帶來了新的維度,系統(tǒng)地分析了該領域 MLLMs的時間線、架構、訓練流程、數(shù)據集與基準測試。

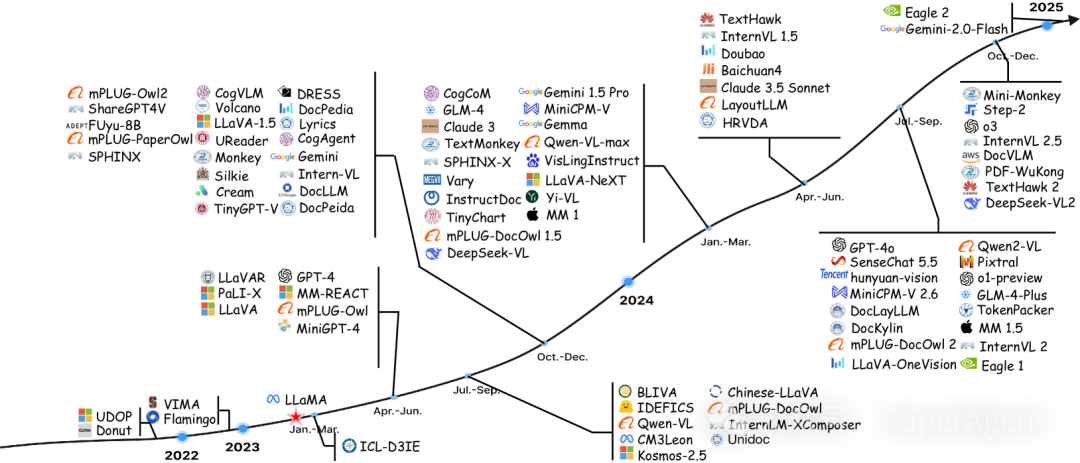

TIU MLLMs時間線

1、模型架構

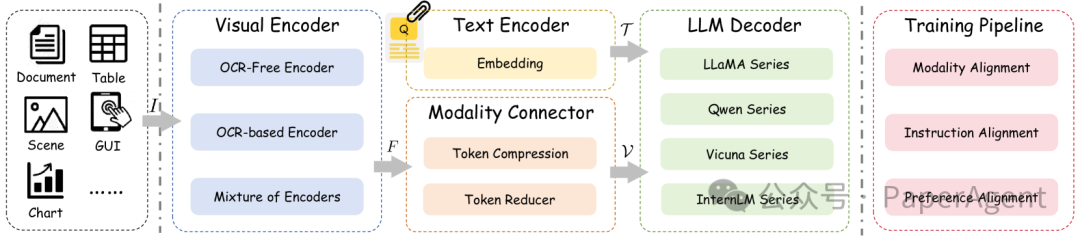

TIU MLLMs的框架通常包括三個核心組件:視覺編碼器、模態(tài)連接器和LLM解碼器。

- 視覺編碼器:負責將輸入圖像轉換為特征表示,分為OCR-free(如CLIP、ConvNeXt)和OCR-based(如LayoutLMv3)兩種方式。混合編碼器結合了兩者的優(yōu)點。

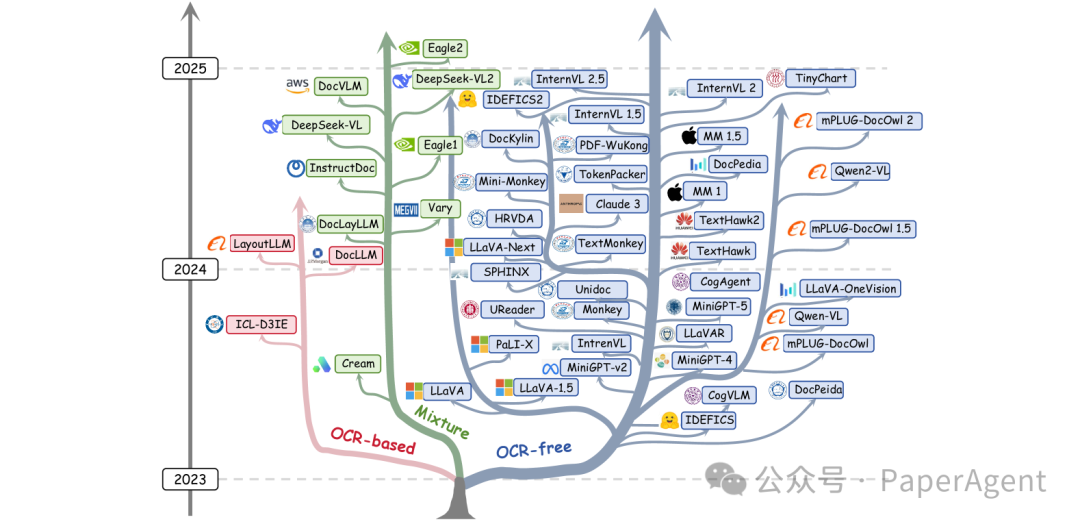

現(xiàn)代LLMs的進化樹追溯了近年來語言模型的發(fā)展,并突出了其中一些最知名的模型。根據編碼器的分類,藍色分支代表OCR-free(無OCR),粉色分支代表OCR-based(基于OCR),綠色分支代表混合編碼器。

- 模態(tài)連接器:用于將視覺特征與語言特征對齊,常見的方法包括線性投影、多層感知機(MLP)、交叉注意力等。

- LLM解碼器:將對齊后的特征輸入LLM進行推理,生成最終答案。常用的LLM包括LLaMA系列、Qwen系列、Vicuna系列和InternLM系列。

2、訓練流程

MLLM的訓練分為三個階段:模態(tài)對齊、指令對齊和偏好對齊。

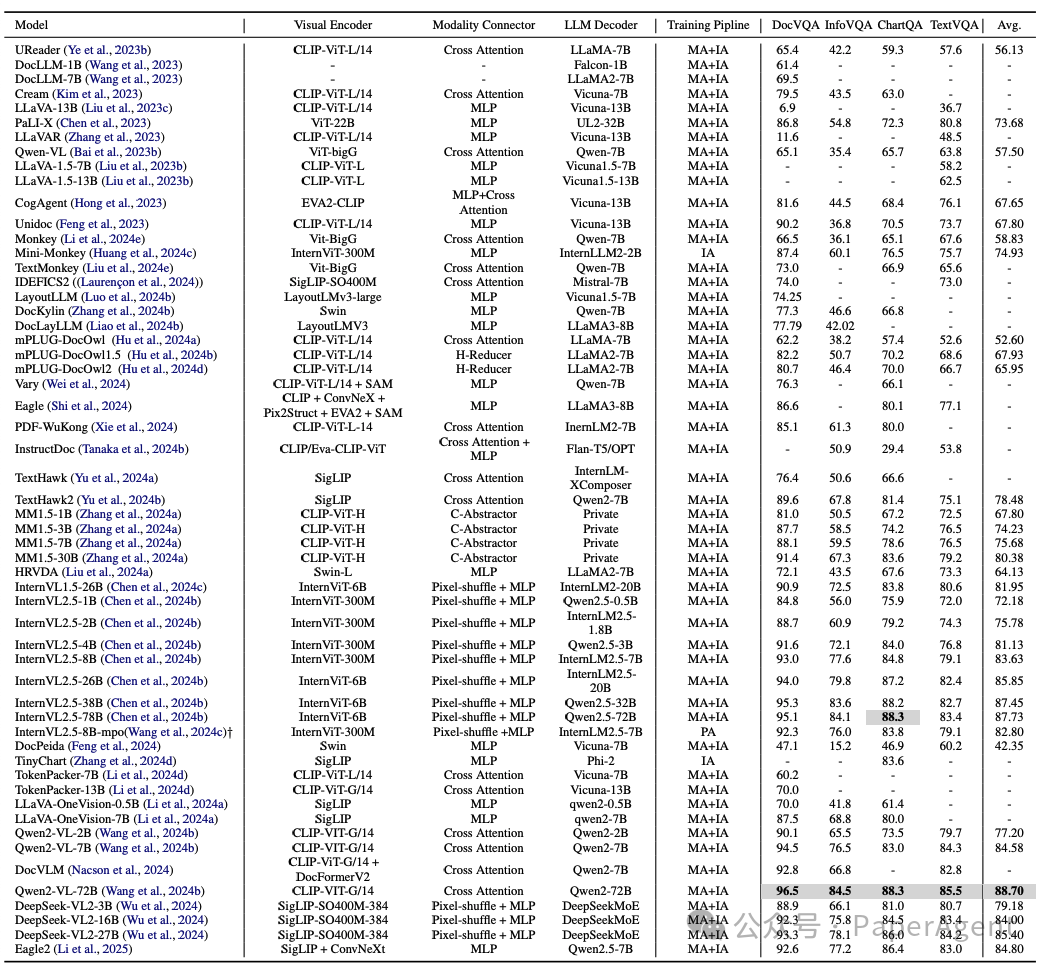

代表性主流多模態(tài)大語言模型(MLLMs)的總結,包括模型架構、訓練流程以及在TIU領域四個最受歡迎基準測試中的得分。“Private”表示該MLLM使用了專有的大型模型。“?”表示結果是通過下載官方開源模型并在本地測試獲得的。

- 模態(tài)對齊:通過OCR數(shù)據預訓練模型,彌合視覺和語言模態(tài)之間的差距。任務包括文本識別、文本定位、圖表解析等。

- 指令對齊:通過指令微調(SFT)提升模型的多模態(tài)感知、跨模態(tài)推理能力和零樣本泛化能力。分為視覺-語義錨定、提示多樣化增強和零樣本泛化三個層次。

- 偏好對齊:優(yōu)化模型輸出以符合人類價值觀和期望,如通過混合偏好優(yōu)化(MPO)提升模型性能。

3、 數(shù)據集與基準測試

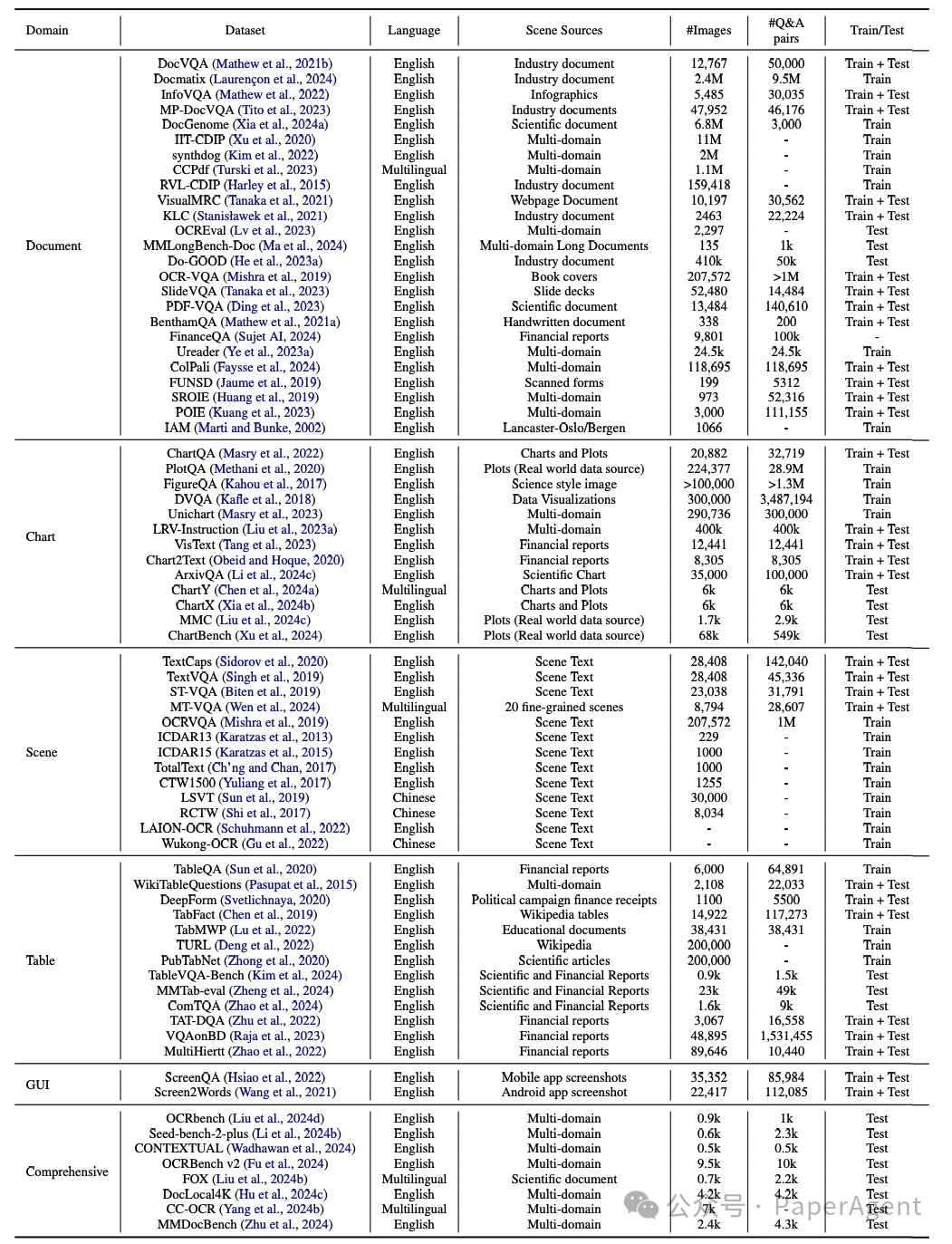

TIU任務的發(fā)展依賴于大量專門的數(shù)據集和標準化基準測試。這些數(shù)據集分為領域特定(如文檔、圖表、場景、表格、GUI)和綜合場景兩大類。

文本豐富圖像理解領域的代表性數(shù)據集和基準測試。每個數(shù)據集通常根據其內容、功能和用戶需求標記為訓練或測試用途。

例如:

- 文檔:DocVQA、InfoVQA、DocGenome等。

- 圖表:ChartQA、PlotQA、ChartBench等。

- 場景:TextCaps、TextVQA、ICDAR系列等。

- 表格:TableQA、WikiTableQuestions、TableVQA-Bench等。

- 綜合:OCRbench、Seed-bench-2-plus、MMDocBench等。

https://arxiv.org/pdf/2502.16586

Multimodal Large Language Models for Text-rich Image Understanding: AComprehensive Review本文轉載自??PaperAgent??