大模型系列:一文匯總16個深度語言模型代表工作

在這一節,重點展開為大家梳理在大模型之前的GPT、BERT等深度語言模型的發展過程。

在大模型之前,預訓練語言模型是NLP中的核心,在pretrain-finetune這一階段的NLP發展中發揮著舉足輕重的作用。預訓練語言模型的無監督訓練屬性,使其非常容易獲取海量訓練樣本,并且訓練好的語言模型包含很多語義語法知識,對于下游任務的效果會有非常明顯的提升。本文首先介紹預訓練語言模型的里程碑方法,然后進一步介紹針對預訓練語言模型中的問題提出的各種改進和創新,包括16個近幾年來的經典預訓練語言模型。

1.預訓練語言模型的里程碑

預訓練語言模型要從詞向量說起。詞向量利用文本數據,構造出詞之間的共現關系,一般將在一句話中共現的詞作為正樣本,隨機負采樣構造負樣本,采用CBOW或Skip-Gram的方式進行訓練,以此達到讓經常共現的詞,能夠具有相似向量化表示。其本質是NLP中的一個先驗:頻繁在文本中共現的兩個詞,往往語義是相近的。然而,詞向量的問題也比較明顯,同一個詞在不同的語境中,含義往往是不同的,而詞向量對于某一個詞只能生成一個固定的向量,無法結合語境上下文信息進行調整。

Deep contextualized word representations(ACL 2018)提出了ELMo模型,利用雙向LSTM模型結合上下文語境信息生成詞的embedding。ELMo和以往的詞向量模型最大的差別是,每個詞的embedding都是整個句子的一個函數,即每個詞的embedding和這個句子的上下文信息是相關的。ELMo語言模型的模型結構采用了一個正向LSTM和一個反向LSTM聯合訓練的方式,優化兩個方向的語言模型優化目標。在完成訓練后,每個單詞在每層LSTM都會產生正向、反向兩個embedding,對每個單詞所有層的embedding拼接在一起,得到這個詞在這句話中的embedding。ELMO在使用到下游任務時,會把數據每句話先過一遍ELMo,得到每個詞的embedding,然后將ELMo生成的embedding和通過詞向量得到的embedding拼接到一起,用于后續任務預測。

此后,語言模型預訓練成為NLP中的核心之一。在Improving Language Understanding by Generative Pre-Training(2018)中提出了GPT模型。相比ELMo,GPT真正意義實現了pretrain-finetune的框架,不再需要將模型中的embedding取出來,而是直接把預訓練好的模型在下游任務上finetune,對于不同任務采用不同的輸入或輸出層改造,讓下游任務更貼近上游預訓練模型。值得一提的是,在后續的prompt等優化中,又將下游任務向上游任務的貼近更近了一步,即將下游任務的輸入和輸出邏輯也進行變化去適應上游任務。讓下游任務向上游任務對齊,是一個NLP中的發展方向。GPT模型主體采用的是Attention Is All You Need(NIPS 2017)提出的Transformer模型,使用的優化目標是正向語言模型。

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding(2018)提出了Bert模型,也是目前在NLP中應用最廣泛的預訓練模型之一。相比GPT和ELMo,Bert采用了一種Mask Language Model(MLM)這一不同的目標,通過隨機mask掉輸入文本中的某些token,然后利用上下文信息進行預測,實現對數據語義關系的提取。這種MLM相比之前的語言模型優化目標優點是,可以從多個方向同時進行信息抽取來預測當前token,而傳統的語言模型(前向后后向)每一次只能從一個方向提取信息。即使將前向和后向結合,也無法實現真正意義上的同時利用前后文信息預測當前token。同時,Bert還引入了Next Sentence Prediction(NSP)任務,在預訓練階段構造了兩個文本pair對輸入,預測這兩個文本的相關性。這個任務相當于是在sentence維度的信息提取,和下游的文本匹配類任務更加契合,這在單純的語言模型中是難以學到的。

對Bert、GPT、ELMo三者模型結構圖的一個簡要對比如下,可以幫助更清晰的理解三類模型的差異。

上文介紹了ELMo、GPT、Bert等3個預訓練語言模型的代表工作。下面我們梳理一下,在此之后,學術界對這些經典的預訓練語言模型進行了哪些方面的改進和創新。

2.針對GPT的改進創新

在GPT之后,OpenAI進一步提出了GPT-2、GPT-3,旨在通過更大的模型容量、更多的訓練語料進一步提升預訓練語言的效果。Language Models are Unsupervised Multitask Learners(2018)提出了GPT-2。本文相比GPT增加了語料、增大了模型尺寸,模型的基本結構和GPT差不多。GPT-2的核心思想是,任何一個有監督NLP任務,都可以看成是語言模型的一個子集,只要預訓練語言模型的容量足夠大,理論上就能解決任何NLP任務。任何NLP任務都可以表示成p(output | input, task)的形式,語言模型就是無監督的多任務學習。因此GPT-2的核心就是提升模型的容量和數據多樣性,讓語言模型能夠達到解決任何任務的程度。

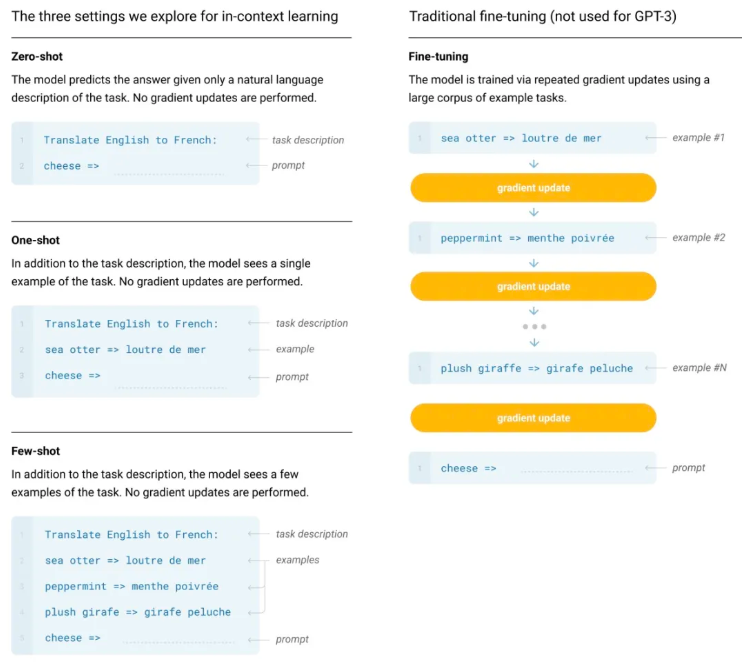

在隨后的Language Models are Few-Shot Learners(2020)中提出了GPT-3,進一步增大了模型尺寸,模型參數量是GPT-2的100倍。GPT-3的核心思想在于不進行finetune(zero-shot learning)就可以對下游任務生成預測結果,其做法為將下游任務轉換為一系列的文本,直接通過語言模型預測出結果。下圖為一個例子,對比了finetune方法和GPT-3中提出的zero-shot方法的區別,便于對這種預測方法進行理解。通過增加對任務的描述文本,來讓模型知道當前要解決什么任務,進而實現預測。

可以看出,GPT的后續優化思路,建立在不斷提升訓練語料豐富度和模型容量,使語言模型能夠從大量文本中學習到各個NLP任務的解決方法,再通過zero-shot learning的方式實現不進行finetune,而是將下游任務轉換成語言模型的輸入形式,來讓預訓練模型直接進行下游任務預測。

在GPT的基礎上,Meta在LLaMA: Open and Efficient Foundation Language Models中提出了LLaMA,LLaMA是目前很多SOTA開源大模型的基礎,包括DeepSeek、千問等在內的很多大模型的模型機構大體上都沿用了LLaMA。LLaMA的主體結構仍然基于Transformer,相比于GPT主要引入進行了一些結構上的細節優化,包括Pre-Normalization、RMSNorm、SwiGLU激活函數、Rotray Embedding等模塊進一步提升語言模型效果。

3.針對BERT的改進創新

在Bert的基礎上,有很多針對其的改進,這里我們主要介紹3個模型。RoBERTa: A Robustly Optimized BERT Pretraining Approach(2019)細致的對Bert模型的訓練方式進行了對比實驗和分析,并基于此總結出了能夠提升Bert效果的訓練方法。相比Bert,RoBerta的主要改進在于3個方面。首先采用了dynamic mask,即每個文本進入訓練時動態mask掉部分token,相比原來的Bert,可以達到同一個文本在不同epoch被mask掉的token不同,相當于做了一個數據增強。其次,分析了訓練樣本應該如何構造,原來的Bert采用segment pair的形式,訓練樣本為兩個segment組合到一起并使用NSP任務預測兩個任務是否相關。RoBERTa發現從同一個document構造輸入單句子的輸入文本而非pair對,并且不使用NSP任務,效果會有一定提升。最后,RoBERTa增大了batch size以及對BPE(輸入文本的分詞方法進行了升級。

ALBERT: A LITE BERT FOR SELF-SUPERVISED LEARNING OF LANGUAGE REPRESENTATIONS(2020)提出了一個輕量級的Bert模型,以此降低Bert的運行開銷。為了減少Bert資源開銷,本文主要提出了兩個優化:Factorized embedding parameterization以及Cross-layer parameter sharing。Factorized embedding parameterization對輸入的embedding進行分解,原始的Bert將token輸入的embedding維度E和模型隱藏層維度H綁定了,即E=H,前者表示每個token固有信息,后者表示每個token結合了上下文的動態信息,后者被證明是更重要的。因此本文提出可以讓E和H接綁,選擇一個較小的E不會影響模型效果,同時顯著降低了由于輸入詞表V變大帶來的內存開銷上升。具體的,將E變成遠小于H的維度,再用一層全連接將輸入embedding映射到H維。這樣模型embedding部分參數量從V*H下降到了V*E+E*H。Cross-layer parameter sharing讓Bert每層的參數是共享的,以此來減小模型參數量。

除了上述兩個降低Bert運行開銷的優化外,ALBERT提出了inter-senetnce loss這一新的優化目標。原來Bert中的NSP任務可以理解為topic prediction和coherence prediction兩個任務。其中topic prediction是一種特別簡單的任務,由于其任務的簡單性,導致coherence prediction學習程度不足。本文提出將coherence prediction單獨分離出來,相比Bert,正樣本仍然是一個document相鄰的兩個segment,負樣本變成這兩個segment的順序交換。

ELECTRA: PRE-TRAINING TEXT ENCODERS AS DISCRIMINATORS RATHER THAN GENERATORS(ICLR 2020)對pretrain階段的MLM任務進行了優化。該方法的核心思路采用了GAN的思路。模型包括一個generator 和一個discriminator。輸入文本仍然會被隨機mask,然后generator會生成被mask掉的token,這里和MLM類似。而discriminator會判斷每個位置的token是否是generator生成的(如果generator正好生成了正確的token,也認為其生成的是正確的)。通過這種對抗學習的方式,讓discriminator預測被mask掉的token能力逐漸增強,也即從文本中提取信息的能力增強。最終的預訓練模型使用的是discriminator部分。ELECTRA的缺點在于由于有了一個單獨的Generator,模型整體開銷會更大,Generator一般采用一個參數量較少的MLM。

4.引入知識的預訓練

ERNIE: Enhanced Language Representation with Informative Entities(2019)從知識增強的角度對Bert進行優化。相比原來的Bert,ERNIE引入了如知識圖譜等外部知識信息。這樣的好處在于,有一些文本如果不知道某些詞組代表一個實體的話,模型是很難學習的,例如一些人名、地名等。如下面的例子,不知道橘子中的這些實體是書名、歌名,就無法識別出作者的職業。

ERNIE在Bert中引入了知識圖譜中的實體信息,模型結構如下圖。模型主要分為T-Encoder和K-Encoder兩個部分。T-Encoder類似Bert,從輸入的文本上提取每個token的信息表示。K-Encoder主要是引入知識信息,將輸入文本中的實體識別出來,然后獲取這些實體的embedding(利用TransE在構造好的知識圖譜上預訓練得到),然后將token的embedding和實體的embedding進行一個融合,融合方法是將實體embedding添加到對應token序列的位置。每層融合輸入上一層的token embedding和entity embedding,生成新的token embedding和entity embedding,公式可以表示為:

此外,ERNIE在預訓練階段增加了token-entity relation mask任務,在20%的entity上,會mask掉token和entity的對齊關系,讓模型來預測當前token對應的是哪個entity。

此外,還有一個同名工作ERNIE: Enhanced Representation through Knowledge Integration(2019)也使用了類似的思路,希望通過引入外部知識信息提升預訓練模型效果。和Bert主要差別在于,本文將MLM任務分成basic-level、phrase-level、entity-level三種類型,在entity-level mask中,mask掉的不是單個token,而是輸入文本中某個entity對應的連續多個token,其和Bert的差異如下圖。

后面這篇工作后續又推出了2.0版本,ERNIE 2.0: A Continual Pre-Training Framework for Language Understanding(2019)。該工作在pretrain階段引入了很多task來輔助pretrain階段的學習。首先構造pretrain階段的任務,主要是無監督或弱監督的訓練數據容易獲得的任務,同時也會引入知識圖譜中的信息構造一些訓練任務。接下來,本文采用continual multitask learning的方式,不斷構造新的任務,并且以增量的方式進行多任務學習,每來一個任務都把歷史所有任務放到一起進行多任務學習,避免忘記歷史學到的知識。本文的核心點在于提出的多種構造預訓練任務的方式,包括Knowledge Masking Task(即上一篇ERNIE中的對entity或phrase進行mask)、Capitalization Prediction Task、Token-Document Relation Prediction Task等,感興趣的同學可以閱讀論文深入了解。

5.其他類型的預訓練語言模型

在GPT和BERT的啟發下,后續涌現了很多其他類型的預訓練語言模型,這里主要介紹UniLM、XLNet、BART、T5等4種。

Unified Language Model Pre-training for Natural Language Understanding and Generation(NIPS 2019)提出了UniLM預訓練語言模型。本文首先總結了之前語言模型的特點:EMLo采用前向+后向LSTM、GPT采用從左至右的單向Transformer、BERT采用雙向Attention。雖然BERT的雙向Attention取得很好效果,但是這種特性也導致其無法像GPT等使用單向方法的語言模型一樣適用于文本生成這種任務。UniLM融合了3種語言模型優化目標,通過精巧的控制mask方式來在一個模型中同時實現了3種語言模型優化任務,在pretrain過程交替使用3種優化目標。下圖比較形象的描述了UniLM是如何利用mask機制來控制3種不同的優化任務,核心思路是利用mask控制生成每個token時考慮哪些上下文的信息。

XLNet: Generalized Autoregressive Pretraining for Language Understanding(NIPS 2019)提出了XLNet模型,融合了BERT和GPT這兩類預訓練語言模型的優點,并且解決了BERT中pretrain和finetune階段存在不一致的問題(pretrain階段添加mask標記,finetune過程并沒有mask標記)。本文將無監督語言模型分成兩類,一類是AR自回歸模型,如GPT、ELMo這種使用單向語言模型建模概率分布的方法;另一類是AE自編嗎模型,如BERT這種通過預測句子中token的方法。XLNet融合了AR模型和AE模型各自的優點,既能建模概率密度,適用于文本生成類任務,又能充分使用雙向上下文信息。XLNet實現AR和AE融合的主要思路為,對輸入文本進行排列組合,然后對于每個排列組合使用AR的方式訓練,不同排列組合使每個token都能和其他token進行信息交互,同時每次訓練又都是AR的。但是,實現這種模式也存在很多問題,文中針對這些問題提出了解法,由于篇幅原因具體內容我們會在后續相關文章再進行詳細介紹。

BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension(2019)提出了一種新的預訓練范式,包括兩個階段:首先原文本使用某種noise function進行破壞,然后使用sequence-to-sequence模型還原原始的輸入文本。下圖中左側為Bert的訓練方式,中間為GPT的訓練方式,右側為BART的訓練方式。首先,將原始輸入文本使用某些noise function,得到被破壞的文本。這個文本會輸入到類似Bert的Encoder中。在得到被破壞文本的編碼后,使用一個類似GPT的結構,采用自回歸的方式還原出被破壞之前的文本。

文中嘗試了多種類型的noise function,如token masking、sentence permutation、text infilling等,其中sentence permutation+text infilling的方式取得了最好的效果。Text infilling指的是隨機mask某些span。下圖展示了文中提出的一些noise function方法。

Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer(2023)統一了各種類型的文本到文本任務,提出了一種統一的Encoder-Decoder語言模型,該方法也是目前業內很多其他領域的大模型使用最多的架構。文中對Encoder-Decoder、純Decoder、UniLM等方式進行了對比驗證,發現Encoder-Decoder的效果是最優的。通過prompt將所有NLP任務都統一成文本到文本的生成任務,訓練統一的T5模型。

6.總結

本文介紹了預訓練語言模型的發展歷程,包括EMLo、BERT、GPT等經典模型,也包括在此基礎上的一些改進創新。這一階段屬于深度學習語言模型高速發展的階段,整體基于pretrain-finetune的范式解決各類NLP問題。在后續的章節中,會為大家介紹大模型階段語言模型的進一步發展,包括ChatGPT、DeepSeek、PaLM等各類成熟的大模型。

想進行大模型交流的同學,可以掃碼加群(或加yuanyuanAI,備注【大模型+機構】,共同探討大模型相關技術。

本文轉載自??圓圓的算法筆記???,作者: Fareise