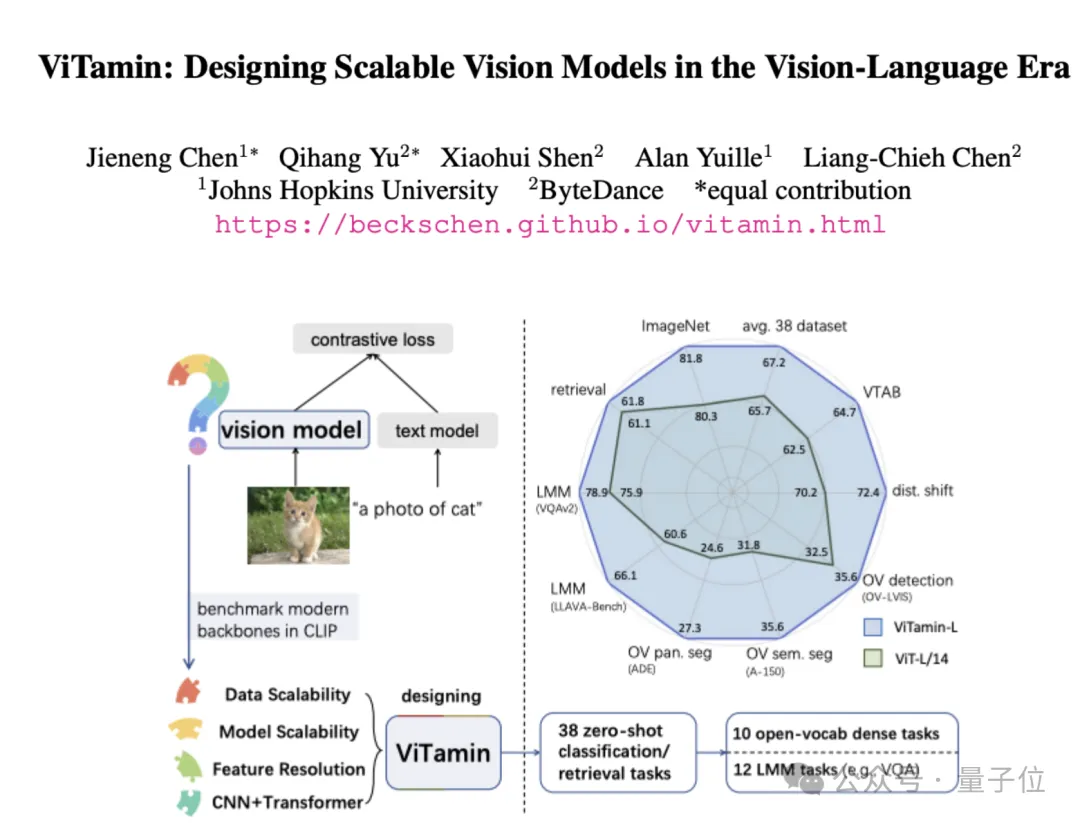

字節(jié)發(fā)布視覺基礎(chǔ)模型ViTamin,多項任務(wù)實現(xiàn)SOTA,入選CVPR2024

視覺語言模型屢屢出現(xiàn)新突破,但ViT仍是圖像編碼器的首選網(wǎng)絡(luò)結(jié)構(gòu)。

字節(jié)提出新基礎(chǔ)模型——ViTamin,專為視覺語言時代設(shè)計。

在使用相同的數(shù)據(jù)集和訓(xùn)練方案時,ViTamin在ImageNet零樣本準(zhǔn)確率上比ViT提高了2.0%。

此外在分類、檢索、開放詞匯檢測和分割、多模態(tài)大語言模型等60個不同基準(zhǔn)上都表現(xiàn)出了良好的結(jié)果。

當(dāng)進(jìn)一步擴(kuò)展參數(shù)規(guī)模時,ViTamin-XL僅有436M參數(shù),卻達(dá)到了82.9%的ImageNet零樣本準(zhǔn)確率,超過了擁有十倍參數(shù)(4.4B)的EVA-E。

最終這一成果,入選計算機(jī)視覺頂會CVPR2024。

視覺語言時代新基準(zhǔn)

在視覺語言時代下,如何設(shè)計一個更好可擴(kuò)展的視覺模型?

?

在ImageNet時代,新的視覺模型在ImageNet數(shù)據(jù)集得以驗證,也造就了不斷有新的視覺模型涌現(xiàn)。但在視覺語言時代,新的視覺模型鮮為人見。

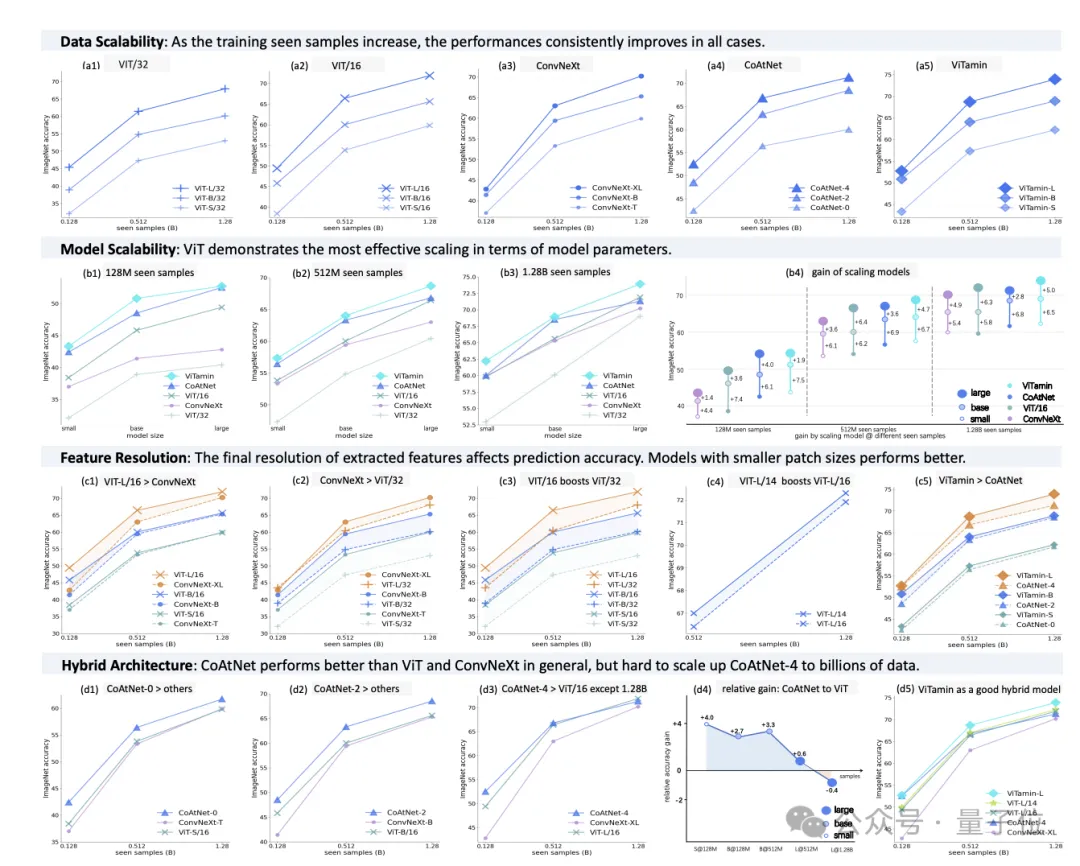

此外,基于現(xiàn)有常見視覺模型,在面對比ImageNet數(shù)據(jù)規(guī)模還大的情況下表現(xiàn)又是如何?研究團(tuán)隊們測試了幾種常見模型,包括純Transformer的ViT,純卷積網(wǎng)絡(luò)的ConvNeXt,以及混合卷積和Transformer的CoAtNet。

最終在一個公開的數(shù)據(jù)集上進(jìn)行了系統(tǒng)性的訓(xùn)練和比較,得出了一些關(guān)鍵發(fā)現(xiàn):

- 第一,模型的擴(kuò)展性:由于可擴(kuò)展的自注意力機(jī)制,ViT能最好地適應(yīng)不同規(guī)模的任務(wù)。

- 第二,數(shù)據(jù)的擴(kuò)展性:隨著訓(xùn)練數(shù)據(jù)的增加,所有模型的性能都有所提升。

- 第三,特征的分辨率:在訓(xùn)練過程中,模型需要理解更廣泛的信息,而不僅僅是簡單的類別標(biāo)簽。因此,提取的特征的分辨率對模型的預(yù)測能力有很大影響。

- 第四,混合架構(gòu):在一般情況下,CoAtNet表現(xiàn)優(yōu)于其他模型,但將其擴(kuò)展到處理數(shù)十億數(shù)據(jù)可能會有一些挑戰(zhàn)。

基于這些發(fā)現(xiàn),研究人員設(shè)計了ViTamin模型。

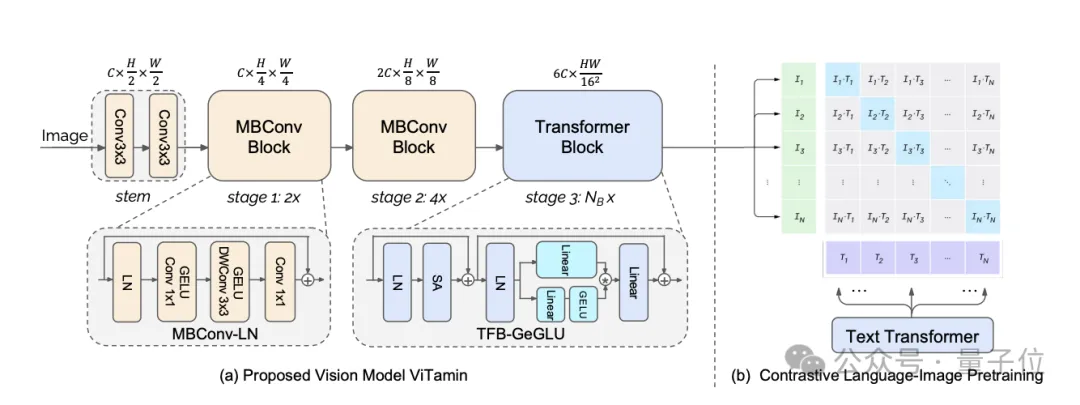

它采用了三個階段的混合架構(gòu)。前兩個階段使用了輕量級的MBConv Blocks,第三個階段包含了可擴(kuò)展的Transformer Blocks。

具體來說,一張圖片首先經(jīng)過卷積stem處理,得到2倍降采樣的特征圖。

然后,這個特征圖經(jīng)過第一階段,由兩個MBConv-LN Blocks組成,接著經(jīng)過第二階段,由四個MBConv-LN Blocks組成,然后降采樣得到16倍降采樣的二維特征。

接下來,這些特征被展平成一維,并輸入到第三階段,該階段由N_B個TFB-GeGLU Block組成。最后,通過對比圖像特征和語言特征,來學(xué)習(xí)對比損失函數(shù)。

作者們致力于簡單有效的scaling law,只考慮模型的寬度C和模型第三階段的深度N_B,因此在scaling到更大的模型中,通過模型的參數(shù)規(guī)模可以直接反推需要多大的寬度和深度,進(jìn)而實現(xiàn)模型的scaling。

多項SOTA

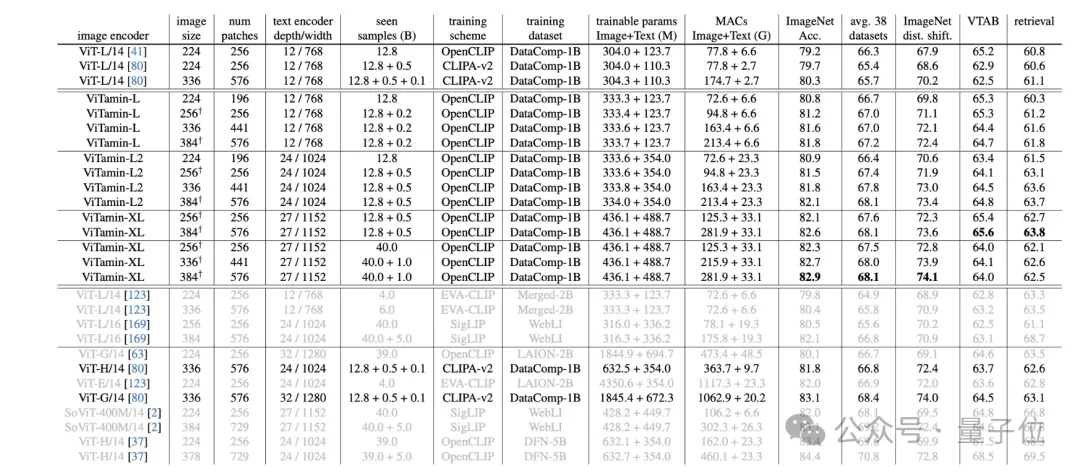

在零樣本性能上面,研究結(jié)果顯示,ViTamin-L的零樣本ImageNet準(zhǔn)確率比ViT-L/14高出了2.0%。

當(dāng)將特征分辨率增加到576個patch時,ViTamin-L的準(zhǔn)確率進(jìn)一步提高到了81.8%,比之前的ViT-L/14 CLIPA-v2高出了1.5%。在38個數(shù)據(jù)集的平均性能上,ViTamin-L比ViT-H/14模型高出了0.4%,而且參數(shù)數(shù)量只有ViT-H/14的一半。

此外,當(dāng)進(jìn)一步擴(kuò)大模型規(guī)模時,參數(shù)量為436M的ViTamin-XL達(dá)到了82.9%的ImageNet零樣本準(zhǔn)確率,超過了4.4B參數(shù)量的EVA-E取得的82.0%。

作者們進(jìn)一步驗證了ViTamin模型對下游任務(wù)而言是個強(qiáng)大的視覺編碼器。

作者們引入了一系列下游任務(wù),包括開放詞匯檢測和分割,以及多模態(tài)大模型(LMMs)。

ViTamin在開放詞匯檢測任務(wù)OV-LVIS上,相比比ViT-L模型能提高了3.1%。ViTamin在8個開放詞匯分割任務(wù)中,相比ViT-L平均提升了2.6%。

ViTamin能直接遷移到多模態(tài)大模型諸如LLaVA上,并在12個多模態(tài)問答等基準(zhǔn)上表現(xiàn)出色。值得注意的是,ViTamin在7個開放詞匯分割基準(zhǔn)上創(chuàng)造了新SOTA。

在這項工作中,作者們建立了主流視覺模型在視覺語言情境下的評估基準(zhǔn),并對它們進(jìn)行了重新基準(zhǔn)測試。作者們從數(shù)據(jù)可擴(kuò)展性、模型可擴(kuò)展性、特征分辨率和混合架構(gòu)四個方面考察了主流的視覺模型。

這四個方面的關(guān)鍵發(fā)現(xiàn)為ViTamin的設(shè)計提供指導(dǎo),ViTamin模型不僅在零樣本ImageNet準(zhǔn)確率和平均38個數(shù)據(jù)集準(zhǔn)確率方面全面超越ViT,而且在包括開放詞匯檢測和分割以及大型多模態(tài)模型在內(nèi)的22個下游任務(wù)上達(dá)到了最新的技術(shù)水平。

來自智能創(chuàng)作團(tuán)隊

智能創(chuàng)作團(tuán)隊是字節(jié)跳動 AI & 多媒體技術(shù)團(tuán)隊,覆蓋了計算機(jī)視覺、音視頻編輯、特效處理等技術(shù)領(lǐng)域。

他們借助公司豐富的業(yè)務(wù)場景、基礎(chǔ)設(shè)施資源和技術(shù)協(xié)作氛圍,實現(xiàn)了前沿算法 - 工程系統(tǒng) - 產(chǎn)品全鏈路的閉環(huán),旨在以多種形式為公司內(nèi)部各業(yè)務(wù)提供業(yè)界前沿的內(nèi)容理解、內(nèi)容創(chuàng)作、互動體驗與消費(fèi)的能力和行業(yè)解決方案。

目前,智能創(chuàng)作團(tuán)隊已通過字節(jié)跳動旗下的云服務(wù)平臺火山引擎向企業(yè)開放技術(shù)能力和服務(wù)。更多大模型算法相關(guān)崗位開放中。

論文鏈接:

???https://arxiv.org/pdf/2404.02132.pdf???

項目主頁:

???https://beckschen.github.io/vitamin??

本文轉(zhuǎn)自 量子位 ,作者:量子位