視頻去物“魔法橡皮擦”來了!MiniMax-Remover:新SOTA方法告別CFG,六步搞定

論文鏈接:https://arxiv.org/pdf/2505.24873

項目鏈接:https://minimax-remover.github.io/

亮點直擊

- 提出了一種輕量且高效的基于 DiT 的視頻目標(biāo)移除架構(gòu)。MiniMax-Remover。受到“文本提示并不適合目標(biāo)移除任務(wù)”這一觀察的啟發(fā),用可學(xué)習(xí)的對比tokens(contrastive tokens)替代了文本條件,用于控制移除過程。這些 tokens被直接集成到自注意力流中,能夠移除預(yù)訓(xùn)練視頻生成模型中的所有交叉注意力層。在第一階段中,本文模型參數(shù)更少,并且不再依賴模糊的文本指令。

- 在第二階段,在第一階段模型生成的1萬條人工篩選的視頻移除結(jié)果上進(jìn)行了蒸餾訓(xùn)練,并采用了 min-max 優(yōu)化策略。

- 在多個基準(zhǔn)測試上進(jìn)行了大量實驗,表明本文方法在推理速度和視覺保真度方面都表現(xiàn)優(yōu)越。

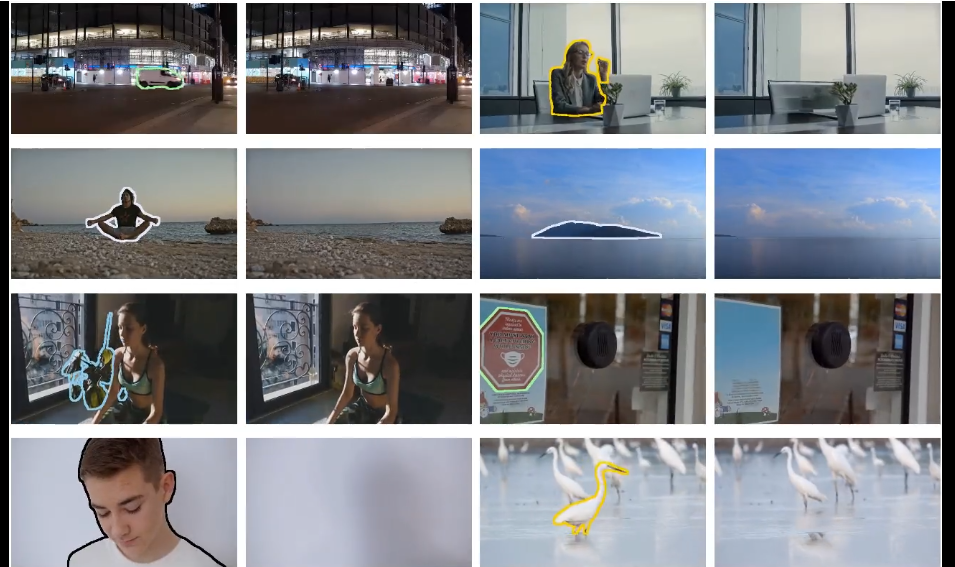

如下圖4和下表1所示,本文模型在僅使用6個采樣步驟的情況下即可生成高質(zhì)量的移除結(jié)果,并且無需依賴無分類器引導(dǎo)(CFG)。

總結(jié)速覽

解決的問題

- 視頻目標(biāo)移除中的核心挑戰(zhàn):

- 模型容易生成幻覺物體(hallucinated objects)

- 存在視覺偽影(visual artifacts)

- 現(xiàn)有方法的局限性:

- 依賴計算成本高的采樣過程

- 嚴(yán)重依賴無分類器引導(dǎo)(Classifier-Free Guidance, CFG)

- 推理速度慢,效率低

提出的方案

- 提出 MiniMax-Remover:一種兩階段的視頻目標(biāo)移除方法,包括:

- 第一階段:設(shè)計一個輕量化的視頻擴(kuò)散模型,移除文本條件輸入和交叉注意力機(jī)制,減少模型復(fù)雜度。

- 第二階段:基于第一階段生成并人工篩選的高質(zhì)量結(jié)果進(jìn)行蒸餾訓(xùn)練,引入minimax 優(yōu)化策略提升魯棒性與效果。

應(yīng)用的技術(shù)

- 架構(gòu)簡化:

- 移除文本輸入和 cross-attention 層

- 使用可學(xué)習(xí)的對比 tokens (contrastive tokens)替代文本條件,直接嵌入自注意力流中

- 蒸餾訓(xùn)練:

- 在1萬條人工篩選的成功視頻移除結(jié)果上進(jìn)行蒸餾,提升模型泛化能力

- Minimax 優(yōu)化策略:

- 內(nèi)層最大化:尋找能誘發(fā)模型失敗的“壞噪聲”

- 外層最小化:訓(xùn)練模型即使在惡劣輸入下也能生成高質(zhì)量結(jié)果

達(dá)到的效果

- 高質(zhì)量視頻目標(biāo)移除:

- 僅使用6 個采樣步即可生成高保真移除結(jié)果

- 無需依賴 CFG,減少計算資源消耗

- 推理效率顯著提升:

- 模型更輕量,處理速度更快,適合實際部署

- 廣泛實驗驗證優(yōu)越性:

- 在多個基準(zhǔn)測試中表現(xiàn)出色,如上圖4和上表1所示

- 在視覺質(zhì)量和推理速度上均優(yōu)于現(xiàn)有方法

方法論

總體框架

階段 1:訓(xùn)練一個輕量級的視頻目標(biāo)移除模型。 本文方法遵循標(biāo)準(zhǔn)的視頻修復(fù)流程,但在此基礎(chǔ)上做出了兩個簡單而有效的改進(jìn)。首先,本文通過移除無關(guān)組件設(shè)計了一個輕量級架構(gòu)。與許多現(xiàn)有方法,如[56, 53, 46, 24]不同,本文不使用文本提示或光流等額外輸入,因此可以移除所有的交叉注意力層。其次,本文引入了兩個對比條件 tokens 來引導(dǎo)修復(fù)過程:一個是正向 tokens ,用于鼓勵模型在被遮擋區(qū)域內(nèi)填充內(nèi)容;另一個是負(fù)向 tokens ,用于抑制模型在這些區(qū)域生成不需要的物體。需要注意的是,與以往工作,如[53, 54, 23] 不同,本文僅使用目標(biāo) mask ,不依賴其他附加條件。

階段 2:通過人工引導(dǎo)的 minimax 優(yōu)化增強(qiáng)模型的魯棒性與效率。 首先使用階段 1 的模型生成修復(fù)后的視頻樣本,然后請人工標(biāo)注者挑選出成功的結(jié)果。在這個經(jīng)過篩選的子集上,本文應(yīng)用 minimax 優(yōu)化訓(xùn)練策略,以增強(qiáng)模型的魯棒性和生成質(zhì)量。此外,蒸餾后的移除器在不使用 CFG 的情況下,僅需 6 步即可完成推理,從而實現(xiàn)快速推理。最終改進(jìn)后的模型被稱為 MiniMax-Remover。

階段 1:用于視頻目標(biāo)移除的簡單架構(gòu)

本文方法基于預(yù)訓(xùn)練的視頻生成模型 Wan2.1-1.3B,該模型是一個基于 DiT 架構(gòu)的 Flow Matching 模型。

模型架構(gòu)

移除預(yù)訓(xùn)練 DiT 塊中的交叉注意力。 在預(yù)訓(xùn)練的 Wan2.1-1.3B 模型中,時間信息通過 shift table 注入,該機(jī)制基于偏置來編碼時間步信息。此外,模型使用交叉注意力模塊來引入文本條件。然而,對于視頻目標(biāo)移除任務(wù)而言,文本輸入通常是多余或模糊的。因此,在本文模型中,本文移除了 DiT 塊中的文本交叉注意力層,但保留了 shift table 以保留時間信息。

從 DiT 中移除交叉注意力帶來了一個挑戰(zhàn):如何在不依賴文本提示的情況下有效注入條件信息。一個直接的方法是重用 shift table 來同時編碼時間步和條件信息。然而,本文實驗表明,這種方式會導(dǎo)致條件修復(fù)效果不佳。為了實現(xiàn)更有效的條件控制,本文選擇將對比條件 tokens 通過自注意力模塊注入到 DiT 塊中。

具體而言,本文使用一個可學(xué)習(xí)的嵌入層將條件 tokens 映射到高維特征空間,然后將該特征拆分為 6 個 token,以增強(qiáng)在注意力計算過程中的控制能力。這些條件 token 被拼接到原始的 key 和 value 中,從而在不大幅修改架構(gòu)的前提下實現(xiàn)有效的條件控制。

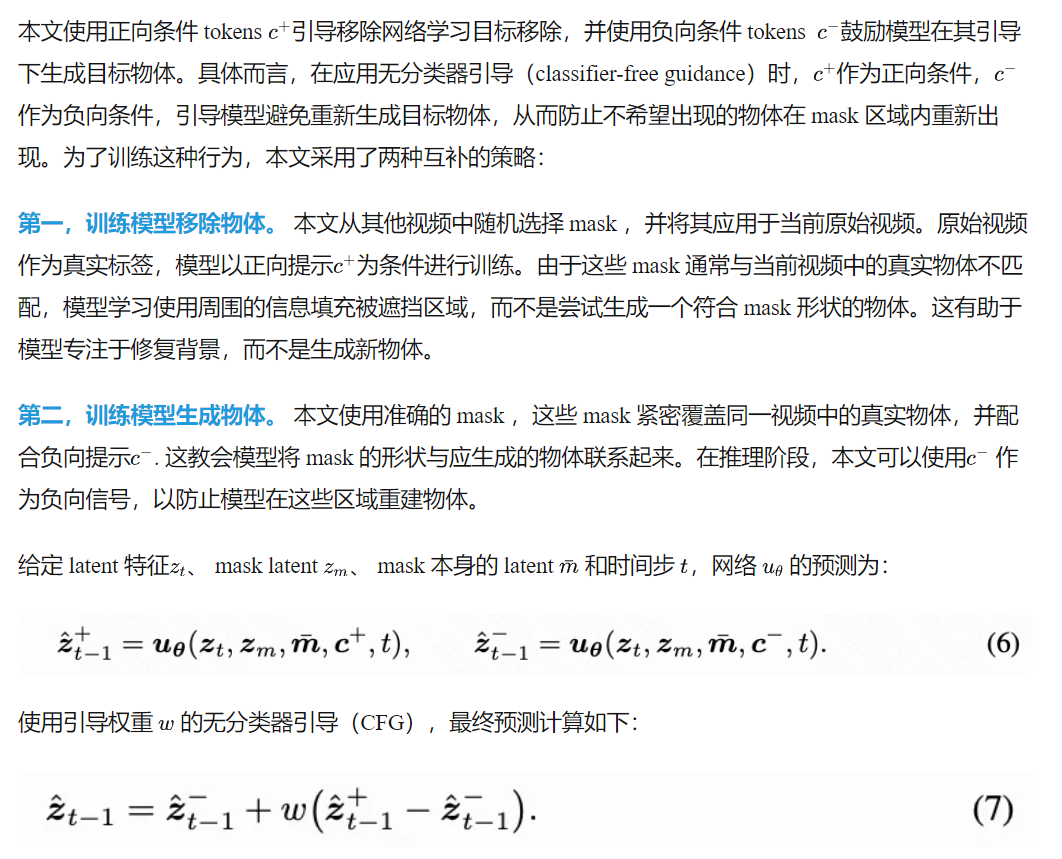

用于目標(biāo)移除的對比條件控制

正向 token 引導(dǎo)移除網(wǎng)絡(luò)學(xué)習(xí)目標(biāo)移除,而負(fù)向 token 則鼓勵模型生成目標(biāo)內(nèi)容。本文需要指出,在第一階段訓(xùn)練中本文使用了 CFG 以促進(jìn)條件學(xué)習(xí)。然而,在第二階段中 CFG 被移除,以提高推理效率。

第一階段的局限性

盡管在簡潔性和速度方面有所提升,當(dāng)前模型仍面臨三個局限性。(1) CFG 會使推理時間加倍,并且需要手動調(diào)整引導(dǎo)尺度,而該尺度在不同視頻中可能有所不同。(2) 每幀采樣 50 個擴(kuò)散步驟仍然耗時較長。(3) 在目標(biāo)移除區(qū)域內(nèi)偶爾會出現(xiàn)偽影或不希望出現(xiàn)的目標(biāo)重建,表明對比信號尚未完全發(fā)揮作用。為了解決這些問題,本文引入第二階段方法,旨在提升魯棒性、質(zhì)量和效率。

MiniMax-Remover:基于人類反饋蒸餾更強(qiáng)的視頻目標(biāo)移除器

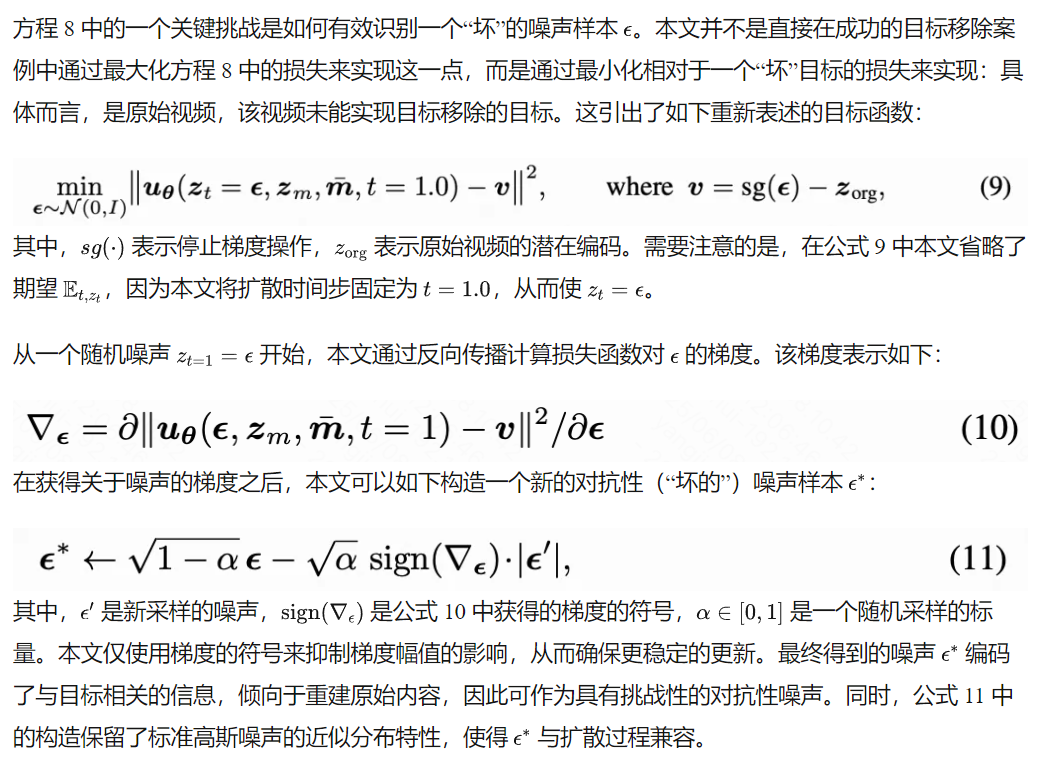

盡管本文視頻目標(biāo)移除器經(jīng)過對比調(diào)控訓(xùn)練,但它仍然會產(chǎn)生明顯偽影,甚至偶爾重建本應(yīng)被移除的目標(biāo)。進(jìn)一步觀察表明,這些失敗案例與特定的輸入噪聲模式密切相關(guān)。這一發(fā)現(xiàn)促使本文設(shè)定目標(biāo):識別這些“壞噪聲”,并訓(xùn)練目標(biāo)移除模型對其具備魯棒性。

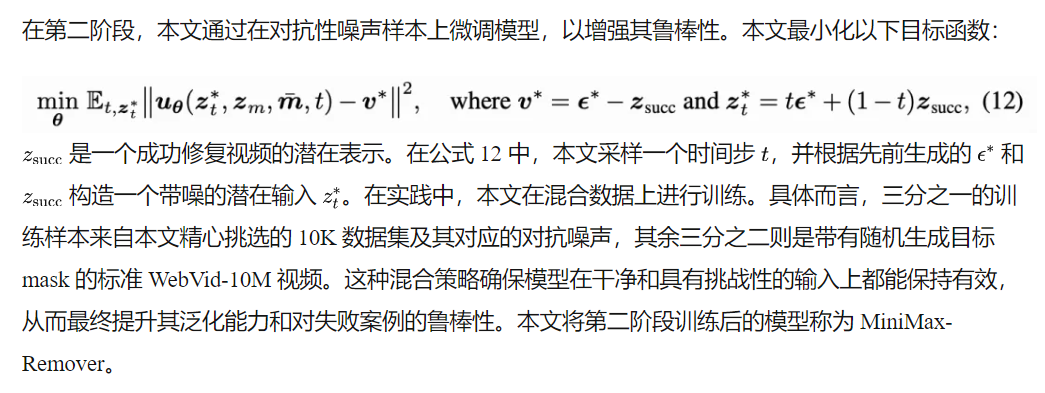

minmax 優(yōu)化也使本文能夠擺脫對 CFG 的依賴。在第二階段中,本文移除了 CFG 以提高采樣效率。具體而言,在訓(xùn)練過程中,本文省略了正向和負(fù)向條件 token。本文選擇將對此設(shè)計的更多分析放在附錄中。

搜索“壞”噪聲

針對“壞”噪聲的魯棒性優(yōu)化

MiniMax-Remover 的優(yōu)勢

MiniMax-Remover 擁有幾個關(guān)鍵優(yōu)勢:

- 低訓(xùn)練開銷。它僅需一次反向傳播來搜索“壞”噪聲,并使用簡化的架構(gòu)訓(xùn)練移除器,從而減少了內(nèi)存消耗。

- 快速推理速度。MiniMax-Remover 僅使用 6 步采樣且不依賴 CFG,相比以往方法顯著加快了推理速度。

- 高質(zhì)量。由于模型經(jīng)過訓(xùn)練能抵御“壞”噪聲,它很少在 mask 區(qū)域生成意外物體或視覺偽影,從而帶來更高的質(zhì)量。

實驗

訓(xùn)練數(shù)據(jù)集。 在第一階段,本文使用 Grounded-SAM2和 CogVLM2提供的字幕在無水印的 WebVid-10M 數(shù)據(jù)集上生成 mask 。隨機(jī)選取約 250 萬對視頻- mask 對用于訓(xùn)練。在第二階段,本文從 Pexels收集了 1.7 萬個視頻,并應(yīng)用與第一階段相同的標(biāo)注流程。這些視頻隨后使用第一階段的模型進(jìn)行處理,并手動挑選出 1 萬個視頻用于第二階段訓(xùn)練。

推理細(xì)節(jié)。 推理使用 RTX 4090 GPU 進(jìn)行。在輸入分辨率為 480p、幀長度為 81 的設(shè)置下,每個視頻推理大約耗時 24 秒,峰值 GPU 顯存消耗約為 14GB(DiT 占用 8GB,VAE 解碼占用 6GB),使用 6 步采樣。

基線方法。 本文將方法與 Propainter、VideoComposer 、COCOCO、FloED、DiffuEraser、VideoPainter和 VACE進(jìn)行比較。本文將評估幀長度設(shè)為 32。為了使用相同的幀長度進(jìn)行評估,本文擴(kuò)展了 VideoComposer和 FloED的輸入幀長度。其余的視頻修復(fù)方法則使用其代碼庫中的默認(rèn)幀長度。幀分辨率使用各自的默認(rèn)設(shè)置。

評估指標(biāo)。 本文使用 SSIM 和 PSNR 評估背景保留效果。TC 用于評估時間一致性,遵循 COCOCO 和 AVID,使用 CLIP-ViT-h-b14提取特征。GPT-O3用作客觀指標(biāo)。本文在 DAVIS 數(shù)據(jù)集和 200 個隨機(jī)選取的 Pexels 視頻上評估這些指標(biāo),以展示在不同數(shù)據(jù)集上的泛化能力。需要注意的是,這 200 個 Pexels 視頻不包含在本文訓(xùn)練數(shù)據(jù)集中,其 mask 由 GroundedSAM2 提取。在用戶研究中,參與者會看到一個多選問卷,要求識別哪個視頻最有效地移除了原始視頻中的目標(biāo)對象,同時不引入模糊、視覺偽影或 mask 區(qū)域中的幻覺內(nèi)容。

定量比較

定性結(jié)果

消融實驗

為了理解本文方法中各個組件和修改的影響,本文進(jìn)行了逐步的消融實驗。所有實驗均使用 50 步采樣。

第一階段。 本文首先考察文本編碼器和基于提示的條件的作用。在 Ab-1 和 Ab-2 的比較中(見下表 3),本文用可學(xué)習(xí)的對比 token 替換了文本編碼器和提示。結(jié)果顯示性能沒有顯著下降,說明在使用合適的可學(xué)習(xí) token 時,文本編碼器對于移除任務(wù)是冗余的。

接下來比較 Ab-2 和 Ab-3,本文在從 DiT 中移除交叉注意力模塊后觀察到輕微的性能下降。然而,當(dāng)本文在自注意力層中引入可學(xué)習(xí)的對比條件 token(Ab-4)時,結(jié)果不僅恢復(fù)了,還超過了 Ab-1。這表明本文簡化的 DiT 架構(gòu)是有效的。

第二階段。 本文比較了使用和不使用人工標(biāo)注數(shù)據(jù)訓(xùn)練的模型。結(jié)果(Ab-1 對比 Ab-2)顯示,僅使用人工標(biāo)注數(shù)據(jù)并不能顯著提升性能,這可能是由于數(shù)據(jù)集規(guī)模(1 萬個視頻)和多樣性有限,限制了泛化能力。

此外,本文比較了訓(xùn)練中使用的不同噪聲類型(Ab-2 到 Ab-3)。本文發(fā)現(xiàn)將“壞噪聲”(人為退化的輸入)加入訓(xùn)練能顯著提升性能。

結(jié)論

MiniMax Remover,一個用于視頻中目標(biāo)移除的兩階段框架。在第一階段,本文通過移除交叉注意力并用對比條件 token 替換提示嵌入,對預(yù)訓(xùn)練的 DiT 進(jìn)行了簡化。在第二階段,本文應(yīng)用最小-最大優(yōu)化:最大步驟尋找導(dǎo)致失敗案例的挑戰(zhàn)性噪聲輸入,而最小步驟訓(xùn)練模型從這些對抗輸入中成功重建目標(biāo)。通過這種兩階段訓(xùn)練,本文方法實現(xiàn)了更干凈且視覺效果更佳的移除結(jié)果。由于無需分類器自由引導(dǎo)(CFG)且僅使用 6 步采樣,推理速度顯著加快。大量實驗表明,本文模型在多個基準(zhǔn)上均實現(xiàn)了出色的移除性能。

本文轉(zhuǎn)自AI生成未來 ,作者:AI生成未來

原文鏈接:??https://mp.weixin.qq.com/s/q_WUl7xn2AvTAoIFqOhgTQ??