快手DHPS:國內首個實現基于RDMA 通信的可負載均衡高性能服務架構!

一、項目背景

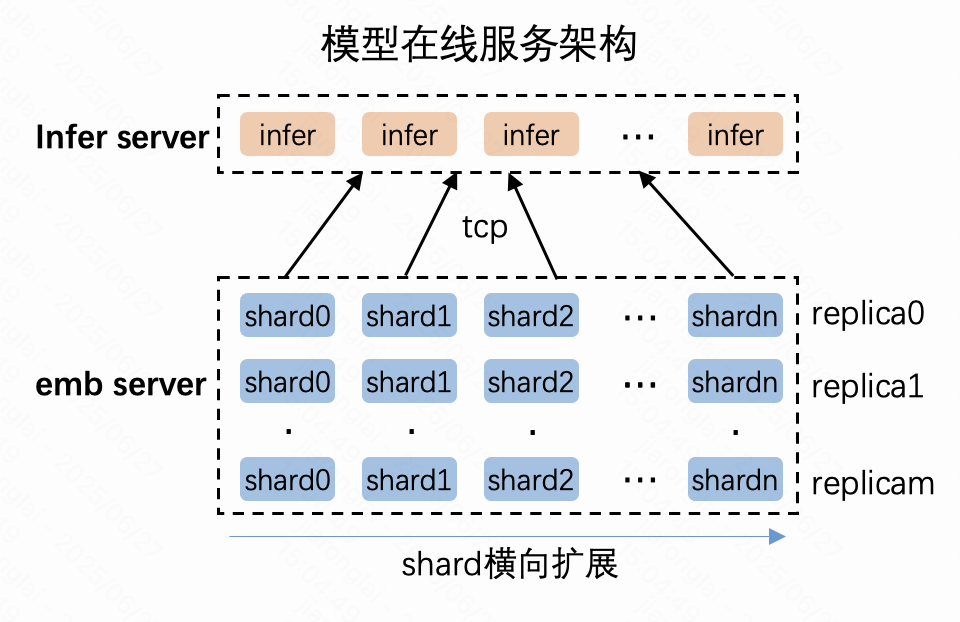

當前在線推理服務架構中,計算節點(推理服務)與存儲節點(在線 PS 服務)之間存在海量的實時數據傳輸需求。隨著模型參數量劇增,傳統分布式架構需擴展到成千上萬個服務節點,導致計算節點訪問存儲節點的帶寬散出激增,進而推高訪問延遲。加之當前主流的 TCP 網絡通信存在 CPU 占用高、延遲高、吞吐低等劣勢,嚴重制約了服務響應時間,限制了模型預估機器的橫向擴展(Scale-Out)規模。

結合快手的業務需求,我們的目標是將傳統分布式架構升級為高密計算存儲分布式架構。通過 RDMA 通信構建計算節點與存儲節點之間的高效互聯體系,節省 CPU 算力,提高 GPU 算力密度,同時顯著提升網絡傳輸效率,為未來更大規模的 AI 基礎設施建設奠定基礎。為此,我們構建了國內第一個在在線系統中實現的可負載均衡的基于 RDMA 通信的高性能服務架構 DHPS。

二、技術實現

2.1 整體架構

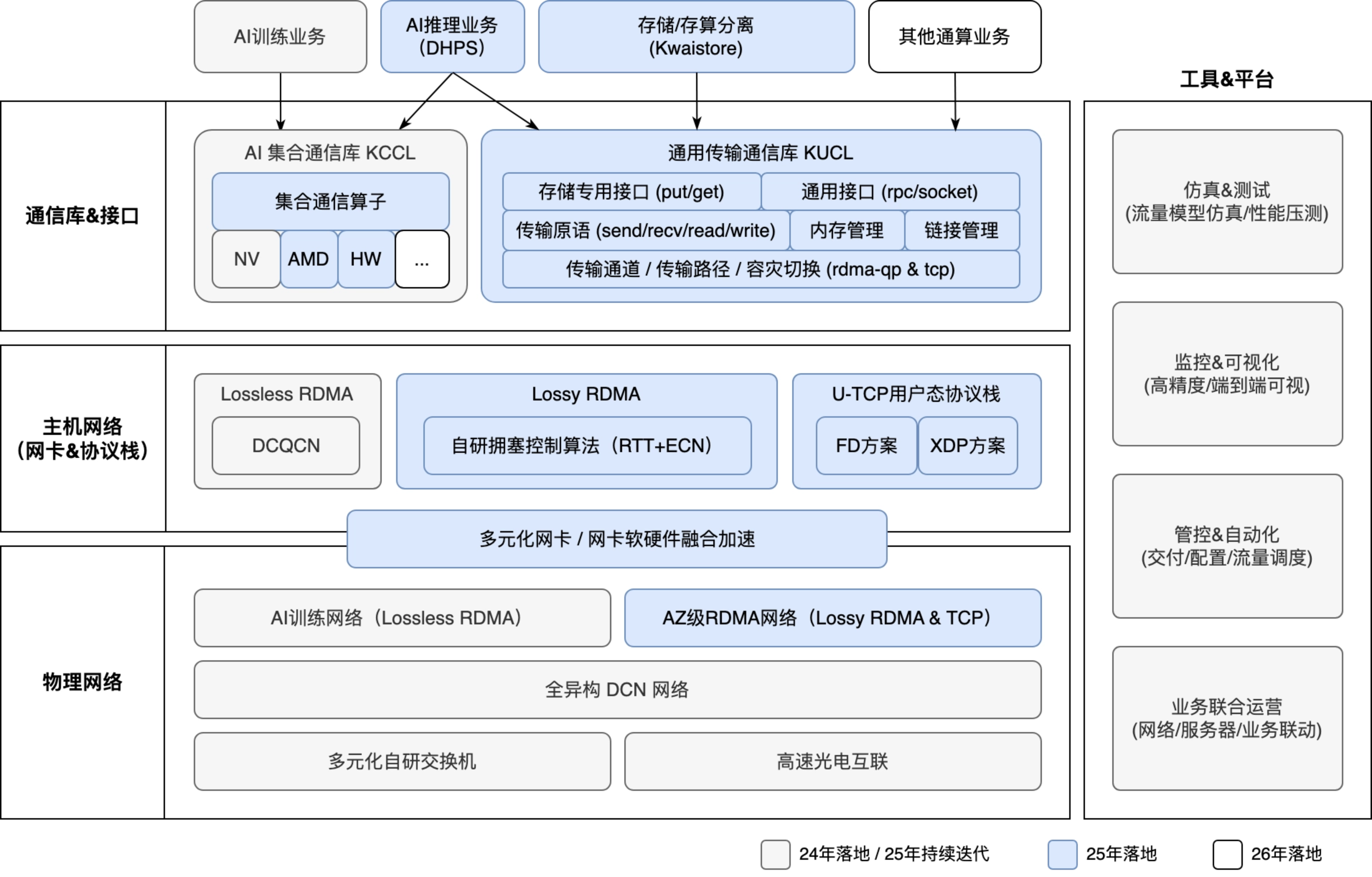

DHPS 架構通過端網協同設計,構建了覆蓋計算、存儲與網絡的全鏈路高性能體系,實現了在線服務場景下 RDMA 技術的規模化落地與智能化調度,其架構創新可歸納為三大核心模塊:

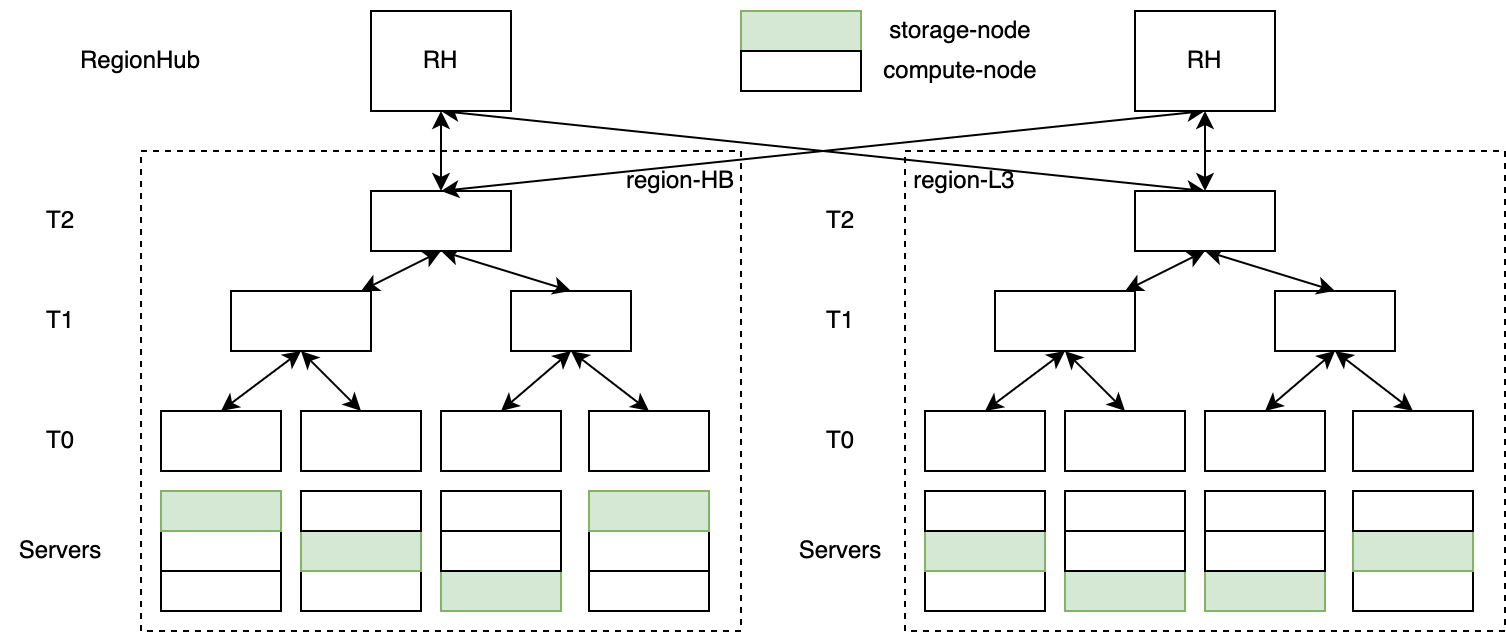

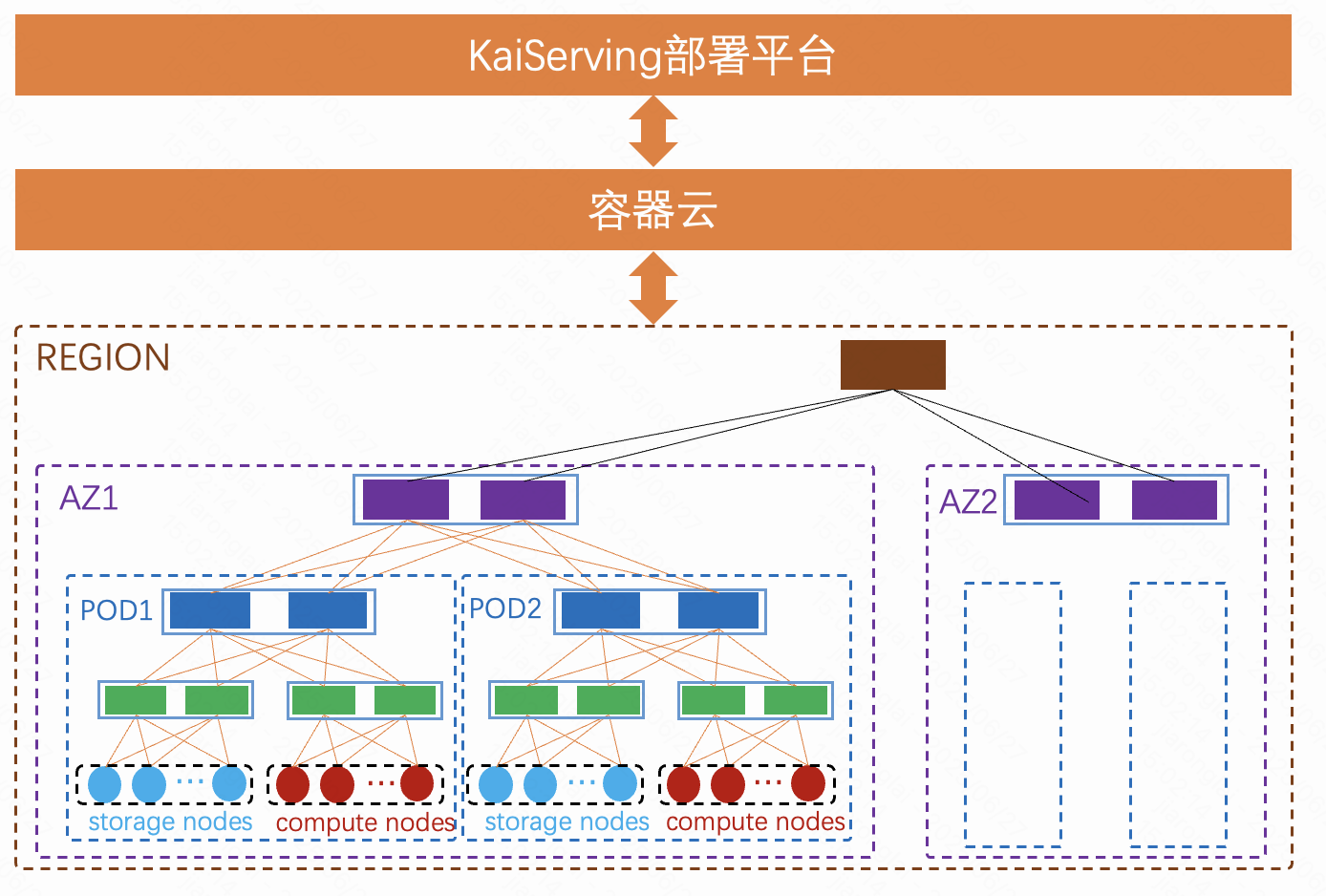

- 網絡建設:構建了支持 AZ 級部署的四層網絡,實現了超大規模 RDMA 與 TCP 混合運行能力。該架構支持業務進行 AZ 級跨 POD 高性能通信,有效降低網絡對 CPU 資源的占用,提升業務部署靈活性,將業務部署范圍擴展為 AZ 級。

- 軟件優化:為充分發揮高密度機型的資源優勢并顯著提升系統吞吐性能,我們自主研發了高性能存儲引擎和高性能 RDMA 網絡通信庫 opt-rdma。

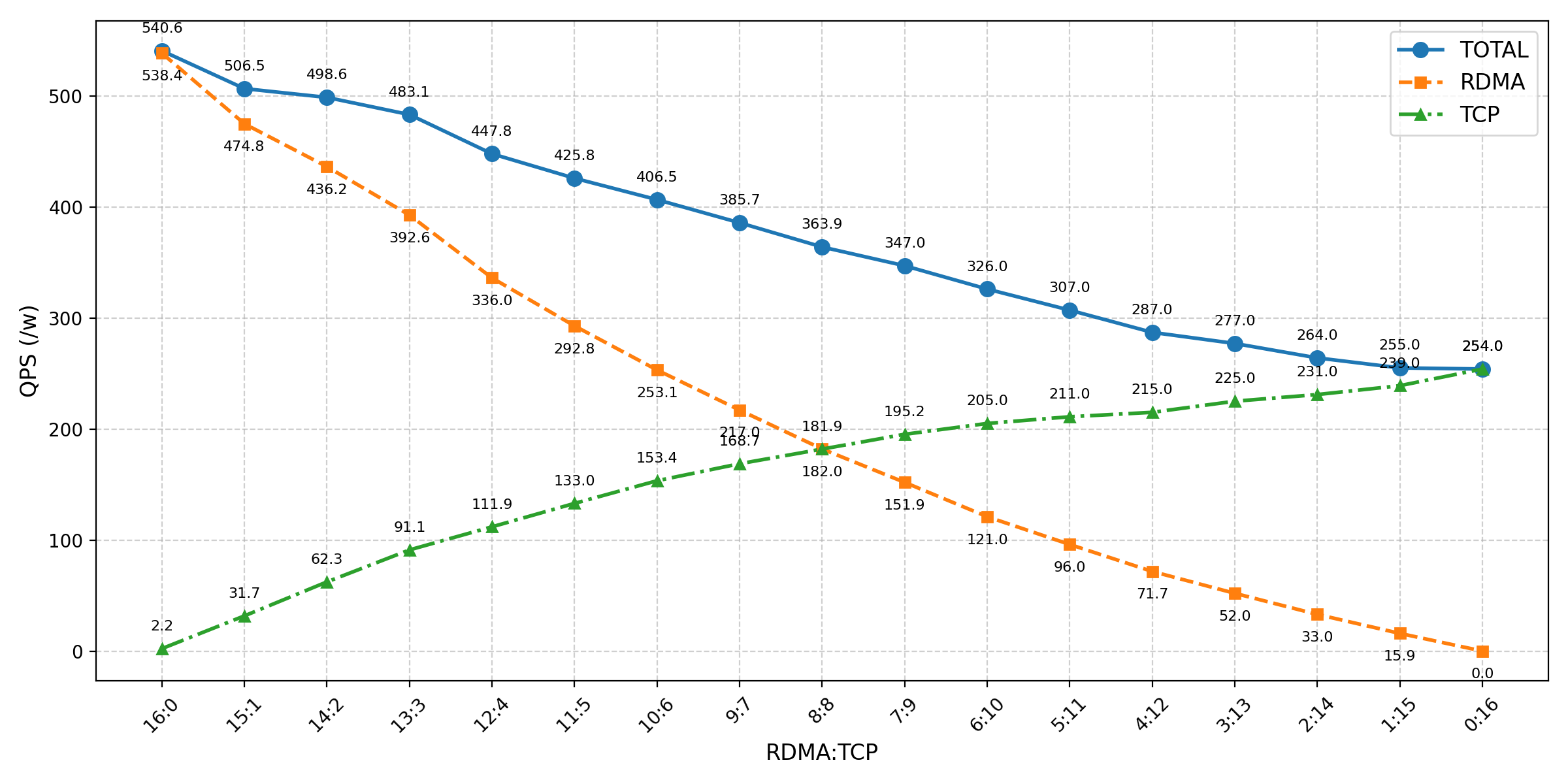

- 流量調度:基于對硬件和網絡配置的感知,優先保證流量在同 POD 或同 AZ 內調度,以最大化利用 RDMA 的高吞吐與低延遲優勢。同時,實現了用戶無感知的 RDMA/TCP 協議自動選擇和切換,通過實時采集 RDMA/TCP 耗時和可用性數據,動態調整請求策略,并在檢測到 RDMA 異常或擁塞時的自動回退。最終,實現了 RDMA 與 TCP 在 AZ 內的常態化混合流量均衡調度。

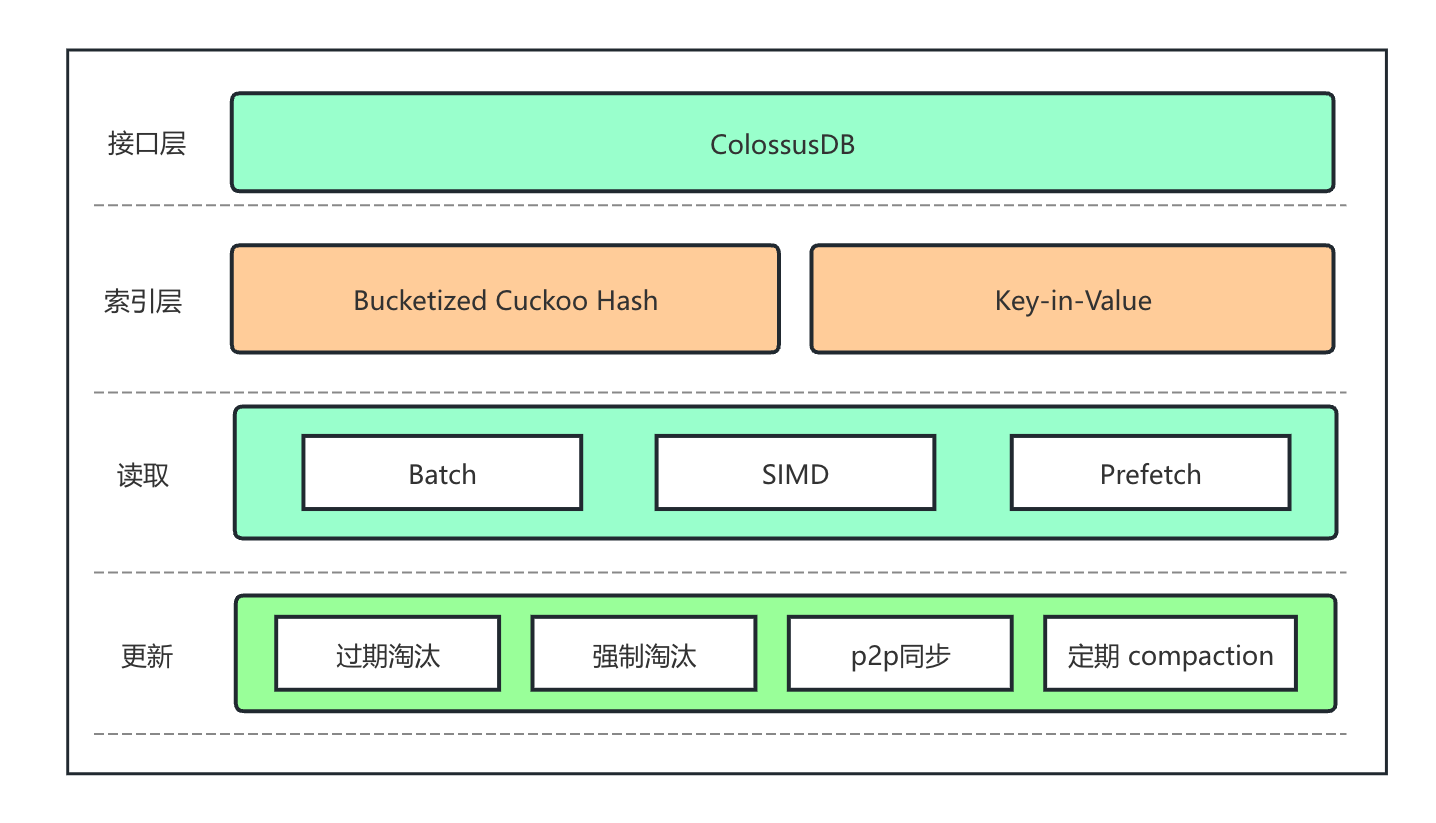

2.2 高性能存儲引擎研發

為滿足在線推理服務對支持高性能讀取且需實時更新的特征向量(Embedding)存儲需求,我們針對傳統鏈式哈希方案存在的讀路徑冗長、過期管理效率低及內存碎片嚴重等問題,設計了新一代存儲引擎。該引擎在保持原有接口兼容性的前提下,顯著提升了讀寫性能,并有效降低了運維成本,其核心優化點包括:

- 索引優化:采用 12 路 Cuckoo Hash 索引結構,并設計基于 8-bit Tag 的 SIMD 匹配算法,充分利用同一 Cache Line 內的數據,大福減少哈希沖突,縮短讀路徑長度。

- 批量讀取優化:針對批量讀場景,積極預取以隱藏內存訪問延遲,從而大幅提升讀取吞吐量。

- 過期回收機制:設計了基 TTL 分層的精確過期與強制回收方案,在確保高效回收過期數據的同時,將 CPU 開銷控制在最低水平。

- 內存管理:采用 Key-in-Value 存儲布局,并定期執行內存整理(Compaction),有效減少內存碎片,確保內存浪費率不高于 5%。

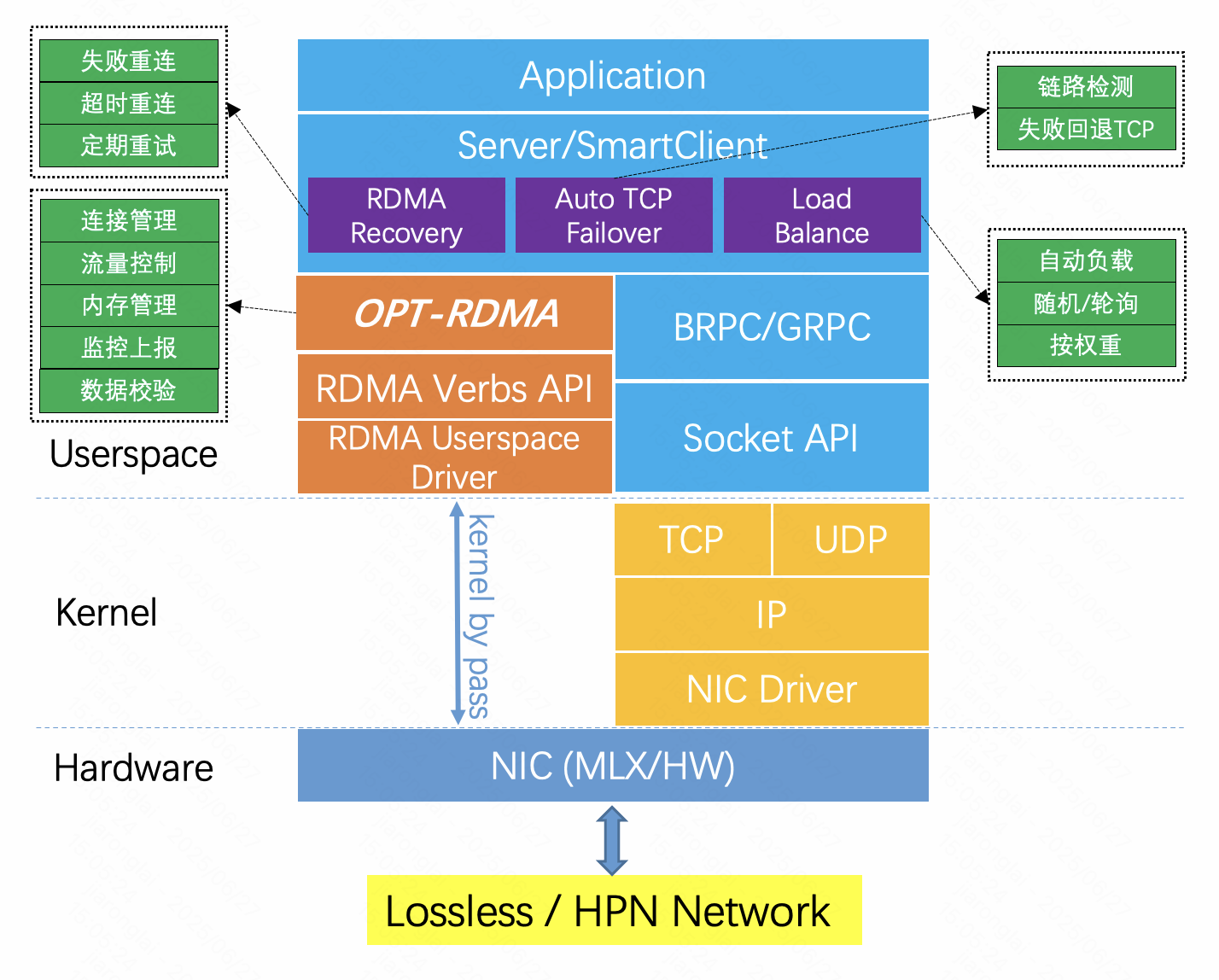

2.3 基于 RDMA 的高性能網絡通信庫

過去十幾年間,網卡帶寬已實現從千兆到 800Gb 的躍遷。然而,在網絡 I/O 密集型業務場景中,隨著網卡性能的提升,操作系統處理網絡 I/O 的開銷也同步增大,這不僅推高了通信延遲,更嚴重制約了服務整體吞吐量的提升。其根本原因在于 CPU 算力的發展速度遠滯后于網卡性能的提升。為突破這一瓶頸,亟需借助專用芯片來提升網絡傳輸效率,減少 CPU 參與度。RDMA 技術應運而生。

RDMA 是一種高性能網絡數據傳輸技術,它允許計算機繞過操作系統內核和 CPU,直接通過網絡適配器訪問遠程主機內存。其核心原理是由網卡硬件實現內存到內存的直接傳輸,徹底消除了傳統網絡通信中的性能瓶頸,具備高吞吐、低延遲、內核旁路以及近乎零 CPU 消耗等顯著優勢。

然而,RDMA 的應用也面臨兩大挑戰:

- 編程復雜性:RDMA 原生的 Verbs API 接口復雜、使用門檻高。

- 硬件依賴性:RDMA 依賴底層硬件(如支持 RDMA 的網卡、交換機等)的支持。部署 RDMA 應用時,必須確保向后兼容性,以維護原有網絡的穩定性。

為此,我們研發了一套基于 RDMA 的高性能網絡通信組件。該組件旨在:

- 簡化編程模型:封裝并屏蔽底層復雜的 RDMA Verbs API,對外提供一套完整的網絡傳輸解決方案。

- 保障兼容性與靈活性:同時兼容 TCP 協議,內部集成 RDMA 與 TCP 兩套傳輸鏈路。在運行過程中,能夠自動感知底層網絡環境與硬件能力,動態選擇最優的傳輸鏈路進行通信。

接下來,我們將從易用性、高性能和魯棒性三個方面來介紹該通信組件。

- 高易用性

- 統一協議:RDMA Verbs API 的復雜性主要源于其底層硬件交互機制和設計理念,開發者需要顯式管理十幾種資源隊形,且異步通信模式與傳統同步 Socket 編程差異顯著。

- 提供類似 RPC 的接口:為契合業務系統廣泛采用的 RPC 模式并實現用戶無感知遷移,我們封裝了底層連接管理、狀態轉換、內存管理、線程模型、流量控制等細節,對外提供與原有 RPC 框架完全兼容的統一接口。

- 監控一體化:深度集成了 kess、rpcmonitor 等本地監控組件,真正做到了“拿來即用”的用戶體驗。

- 高性能

- 無鎖機制:內部采用無鎖、全異步設計,完全運行于用戶態,徹底消除了上下文切換帶來的性能開銷;

- Zero Copy:采用了單邊通信模式,可以通過網卡直接訪問對端內存,實現了零 CPU 參與、內核旁路以及數據的零拷貝;

- QP 共享:通過鏈接資源池、注冊內存資源池等預分配策略,實現資源的“即拿即用”以及高效復用。

- 原子操作:線程模型采用 Master-Worker 模式,Master 線程以 Polling 模式從完成隊列獲取請求,交由 Worker 線程處理業務邏輯,兩類線程之間通過原子變量進行信息傳遞,從而達到超低延遲、超高吞吐,單機 QPS 輕松突破數千萬。

- 魯棒性

- 可靠性:采用 RC(Reliable Connection)通信模式,保證數據的不重、不丟、保序;

- Fallback 機制:智能感知,可動態感知底層網絡環境及硬件特性,自動選擇采用 RDMA 通信還是 TCP 通信,自動選擇最優通信路徑;

- 協議兼容:TCP 兼容,同時支持基于傳統 TCP 的 RPC 通信模式,如遇 RDMA 硬件故障、數據錯誤等,可實現失敗回退 TCP;

- 硬件兼容:硬件兼容,支持硬件混跑,對不同代際網卡、不同品牌網卡做了兼容適配。

2.4 流量調度與負載均衡

我們的業務服務(計算服務和存儲服務)采用多 AZ 部署,其中計算服務是無狀態的,而存儲服務則是有狀態的多副本多 Shard 部署,我們能夠保證在每個 AZ 內部都會至少有一個完整的存儲服務副本。

在流量調度方面,我們在遵循以下優先級規則,智能動態調整計算節點到存儲節點的流量比例來實現負載均衡:

- 最高優先級:優先網絡 POD 內調度,優先 RDMA 通信

- 次優先級:其次 AZ 內跨 POD 調度,優先 RDMA 通信

- 最低優先級:跨 AZ 調度,通過 TCP 通信

我們實現了故障檢測機制,在 RDMA 通信過程中如果遇到硬件故障、連接異常、網絡擁塞或其它原因導致 RDMA 通信失敗的情況,可以做到快速切換 TCP,保障服務性能。

?為保障服務高可用與性能穩定:

- 快速故障切換: 實現了高效的故障檢測機制。當 RDMA 通信過程中遭遇硬件故障、連接異常、網絡擁塞或其他導致通信失敗的情況時,系統可快速、自動回退至 TCP 協議。

- 智能動態調節: 鑒于網絡性能受多重因素影響,調度系統實時采集請求處理指標(如時延、成功率),并據此實施多級節點與網絡選擇策略:

- 動態流量配比: 根據目標節點的實時可用性與請求延遲等參數,動態調整發往該節點的 RDMA 與 TCP 請求比例。

- 節點級熔斷: 當針對特定存儲節點的 RDMA 和 TCP 請求均失敗時,觸發單點熔斷機制,自動將流量切換至性能更優的其他可用數據節點。

2.5 AZ 級 RDMA 高性能網絡

基礎設施打造了端網一體的高性能網絡解決方案,網絡側通過 DCN5.0 全異構網絡架構搭載自研 51.2T 網絡交換機支持高密服務器 800G 雙上聯接入,在提供超大帶寬的同時保證了網絡接入的高可靠。主機側自研擁塞控制算法和網絡協議落地行業首個基于商業非定制化網卡的 AZ 級 RDMA 多協議混跑方案,克服了 DCN Lossy 網絡的限制,實現了 PFC-Free,打破了過去 RDMA 傳輸局限于 POD 內的傳輸距離限制,拓展傳輸域實現 AZ 內 RDMA 網絡的互聯互通。對比行業基于大 buffer 交換機和自研定制網卡的昂貴方案,在大幅降低成本的同時提供了 RDMA 網絡傳輸的大連通域、低延遲、高吞吐。結合流量親和性調度,實現在數據中心內 RDMA 流量與 TCP 流量常態化混跑,并提升了其穩定性和效率。

- 全異構高性能物理網絡

- 超高帶寬網絡接入架構:

- 支持 DHPS 服務器 2x200G / 4x200G 雙上連接入

- 支持多種規模 POD ,按需靈性交付。

- 支持多交換芯片異構組網。

- AZ 級 RDMA 網絡:

- 連通域:具備 AZ 級超大 RDMA 通信域,支持業務服務端、存儲端靈活部署。長期演進到可覆蓋 Region 級。

- 吞吐:達到 4 層網絡帶寬的 80%,在滿足公平性的前提下充分利用各層級間網絡有效帶寬。在吞吐和延時的均衡條件下,達到最大利用率。

- 丟包:利用自研擁塞控制算法等軟件能力,將丟包控制在業務無感范圍內。

- 延時:POD 內的 P99 延時優于 DCQCN 30% 以上,POD 間的 P99 延時優于 TCP 30% 以上,在保持高性能前提下,不因時延抖動導致業務受損。

- 自研 51.2T 網絡設備:

- 支持 400G 端口一分二 breakout 特性。

- KNOS 網絡操作系統適配 marvel、huawei、brcm 51.2T 多元芯片。

- 支持基于 IFA2.0 INT 、UCMP 等特性。

- 交換機緩存雙棧 QOS 設計,避免 TCP 網絡抖動影響 RDMA 性能,在最大化 RDMA 性能的同時,保持 TCP 的鏈接穩定性。

- 自研主機網絡協議棧

- PCC 自研擁塞控制算法:

- 基于 RDMA RoceV2,快手自研基于 RTT + ECN + Tx_event 精細化信號的 Rate - Based 結合 window 擁塞控制。

- 算法支持 AZ 級 4 層超大網絡域,支持 POD 間 Lossy/POD 內 lossless 網絡,以及 TCP/RDMA 雙棧混跑。

- 基于 smartnic 可編程能力,實現多元化網卡基于統一擁塞控制算法的高性能、穩定互通。

- PFC-Free:

- 在 DCN 范圍,RDMA 穩定傳輸不依賴 PFC,擺脫對成本高昂的大 buffer 設備依賴。

避免了數據中心 PFC 風暴對網絡穩定性的沖擊,造成大面積故障。 - TCP/RDMA 雙棧混跑:

- 核心模型使能 RDMA 高性能連接,長尾業務常態 TCP 連接覆蓋。

RDMA 網絡可 fallback 到 TCP,異常情況下可保證高可用性。

- 多路徑:

- 通過多 QP 路徑支持網絡端到端全鏈路的負載分擔

- 通過 Multi-path 技術實現流量 QP 級調度

- 聯合業務高效高性能網絡運營

- RDMA 網絡穩定性保障能力:

- 故障預防:建立端到端的配置管理、交付驗收、巡檢機制。在交付階段使用 KNP 配置管理中心以及主機配置管理平臺統一下發權威配置,保證初始配置的正確性;在交付階段執行端到端的驗收測試以及性能壓測,提前發現并解決潛在問題;上線后定期巡檢,及時發現并糾正配置誤操作。

- 故障發現:基于 Telemetry 和 gRPC 技術,秒級采集交換機與服務器網卡關鍵指標(RDMA 流量、交換機 Buffer 使用率、PFC、CNP、OOS 等)。在 RDMA 平面部署全量 pingmesh,秒級感知 RDMA 連通性故障問題。

- 故障定位:構建 RDMA POD 網絡數據可視化系統,基于 RDMA 特點針對性開發了 ERSPAN RDMA 丟包定位工具、PFC storm 故障自動定位系統、網卡毫秒級高精度指標采集工具 Probe ,整合多維度的數據,提供直觀的 POD 全景運行狀態視圖,輔助快速定位。

- 故障恢復:詳細梳理 RDMA 故障場景及影響,制定清晰的故障處理 SOP(涵蓋交換機與網卡)及應急預案。建立網絡與業務團隊的協同運營機制,實現故障快速聯動止損與恢復。

- RDMA 網絡監控開放系統:

- 網絡構建并開放主機監控數據接入、服務器網絡信息查詢、拓撲查詢、網絡變更、故障推送等系統服務能力,加強與業務團隊的聯合運營建設,實現故障的快速發現、定位和止損恢復。

- 高效交付平臺:

- 聯合業務建立了完整交付流程,開發了自動化部署、測試驗收工具,依托于 KNP 大交付平臺實現了自動化部署、端網一體化交付、自動化網絡驗收、業務聯合驗收。經過 24 年對流程和工具優化,達成:交換機網絡交付驗收(3BD),主機網絡納管交付(分鐘級),業務聯合性能驗收(1BD)。

三、性能收益

DHPS 架構通過端到端的技術革新,在多個維度實現了性能突破,為在線服務場景提供了量化可衡量的價值提升:查詢吞吐提升 270%+,更新性能翻倍,內存碎片率下降 40%,網絡延遲降低 35%,在超大規模集群中實現 99.999% 服務可用性,為企業級應用提供業界領先的高性能在線服務解決方案;在線 GPU 機器上面因為 CPU 節省可以帶更多卡,能進一步從 4 卡機器升級到 8 卡機器甚至更多,提升大模型和搜推廣模型結合的迭代上限。

以快手推薦大模型的精排服務為例,架構升級顯著收益:

- 資源大幅縮減:老架構下存儲服務節點需要 200 臺左右 64 核 CPU 機器,新架構下只需要個位數的高密度 CPU 機器,機器成本資源節省 70%

- 延遲顯著降低:計算節點與存儲節點之間的通信延遲,由毫秒級降至百微秒級。

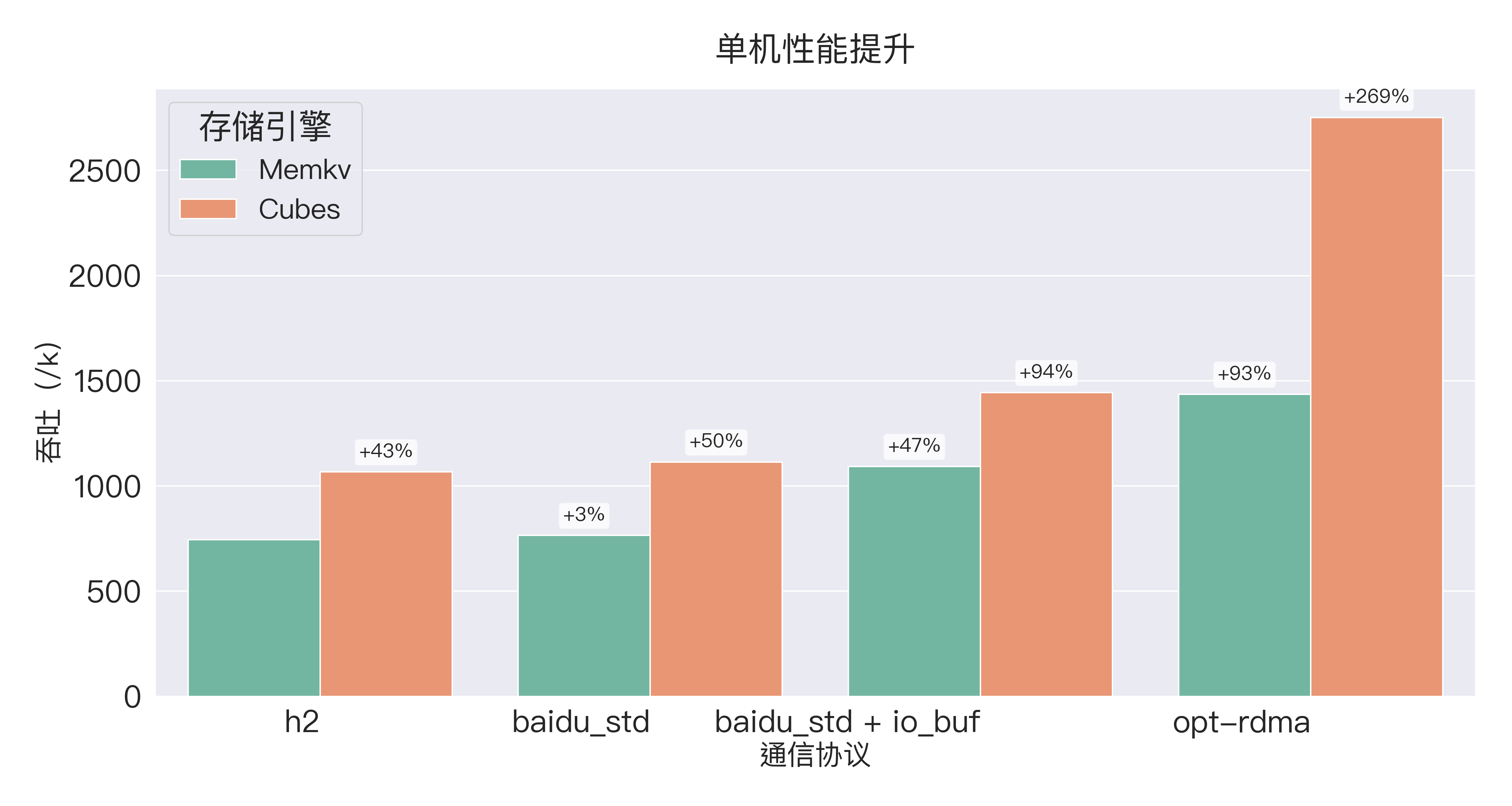

- 吞吐量大幅提升:如下表所示,通過采用新一代存儲引擎 (Cubes - Cuckoo Hash) 與 自研高性能通信庫 (opt-rdma),極限吞吐提升超過 270%。

不同存儲引擎與通信協議下的極限吞吐對比:

Infer 收益(以推全的 million interest 服務為例,同等 qps 壓力下)

- CPU 降低、延遲顯著降低,為更高密度的 GPU 機器在在線服務中的應用創造了更大空間。

此外,DHPS 架構優勢在 TCP 和 RDMA 流量常態混合狀態下穩定運行。在 TCP 與 RDMA 混跑下,CPU 機器單機極限吞吐優于單 TCP 極限吞吐。

四、未來展望

DHPS 作為國內首個在在線系統中實現的、基于 RDMA 通信的可負載均衡高性能服務架構,在滿足快手在線系統嚴苛的高穩定性要求下,不僅實現了卓越性能(查詢吞吐提升 270%),更顯著提升了業務迭代能力上限,為大模型在搜索、廣告、推薦等核心場景的落地奠定了堅實基礎。

該架構的價值遠超在線推薦場景。其 RDMA 自研通信庫已作為核心組件集成至 KESS(快手統一的服務治理平臺)。整套高性能基建設施(涵蓋網絡、存儲、通信庫)具備高度可復用性,可廣泛應用于高性能計算 (HPC)、分布式存儲系統、大規模模型推理服務等關鍵領域。這標志著搜索、廣告、推薦(搜推廣)領域的傳統分布式架構,正在向面向 AI 大模型的高密度計算分布式架構演進。