多模態(tài)大模型Keye-VL-1.5發(fā)布!視頻理解能力更強(qiáng)!

快手正式發(fā)布了多模態(tài)大語言模型 Keye-VL-1.5-8B。

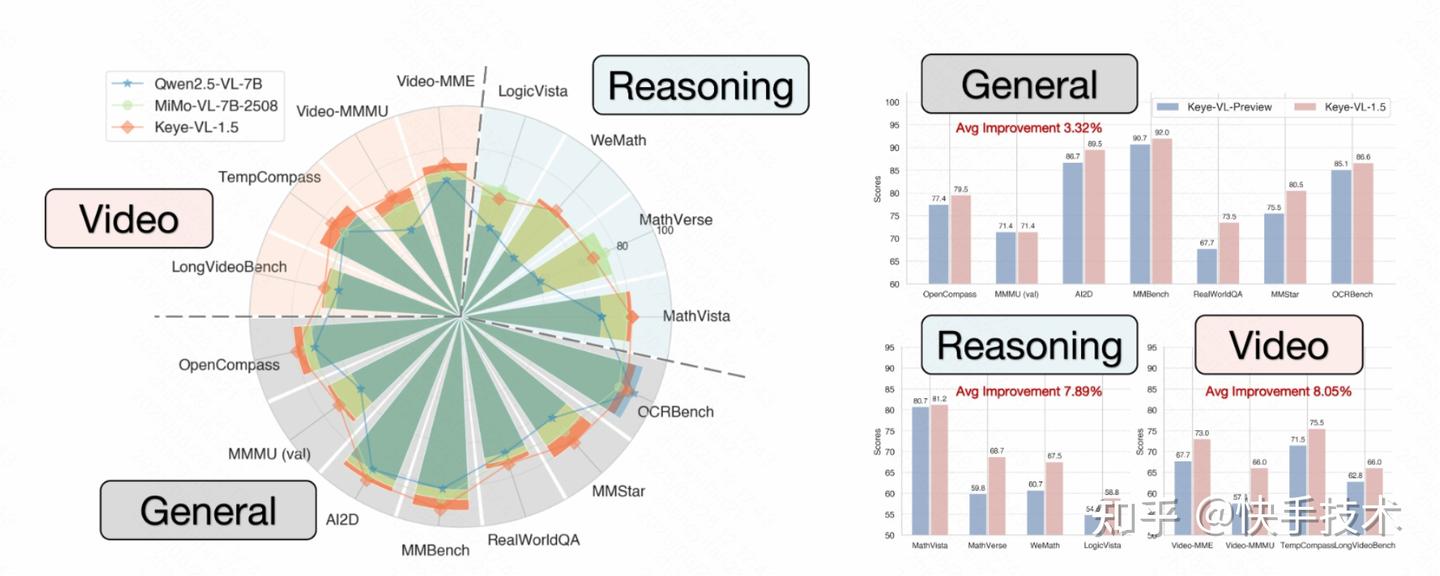

與之前的版本相比,Keye-VL-1.5 的綜合性能實(shí)現(xiàn)顯著提升,尤其在基礎(chǔ)視覺理解能力方面,包括視覺元素識別、推理能力以及對時序信息的理—表現(xiàn)尤為突出。Keye-VL-1.5 在同等規(guī)模的模型中表現(xiàn)出色,甚至超越了一些閉源模型如 GPT-4o。

Keye-VL-1.5-8B 在技術(shù)上實(shí)現(xiàn)了三項(xiàng)關(guān)鍵創(chuàng)新:

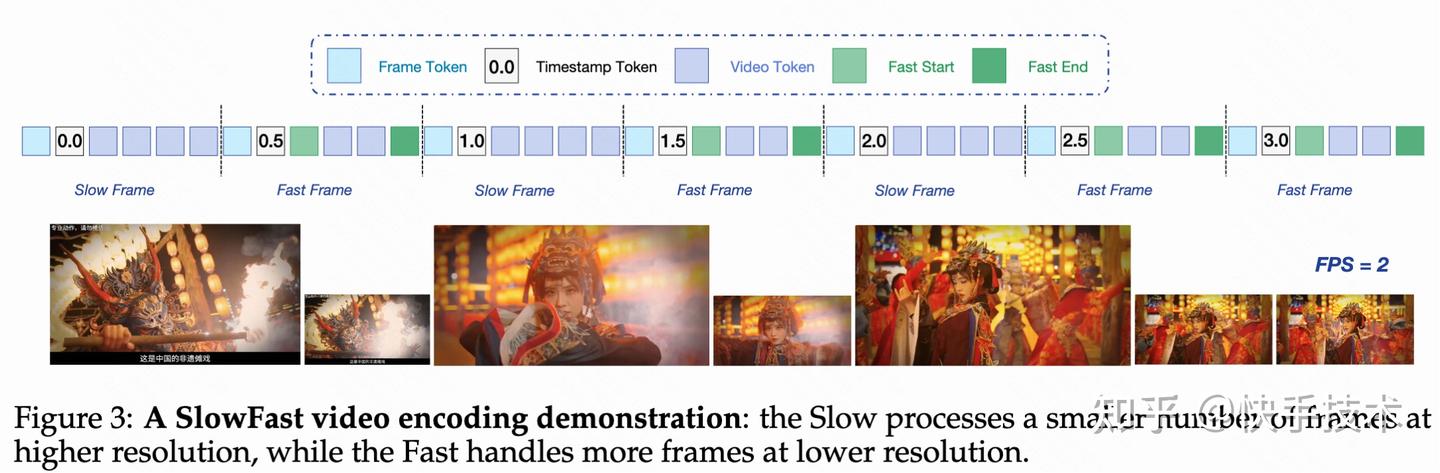

- 引入慢快編碼策略(Slow-Fast):該策略基于相似性算法自動區(qū)分慢幀與快幀,并將快幀的 token 預(yù)算控制為慢幀的 30%。同時,通過引入特殊 token 和時間戳標(biāo)記幀邊界,有效平衡了性能與計(jì)算成本。

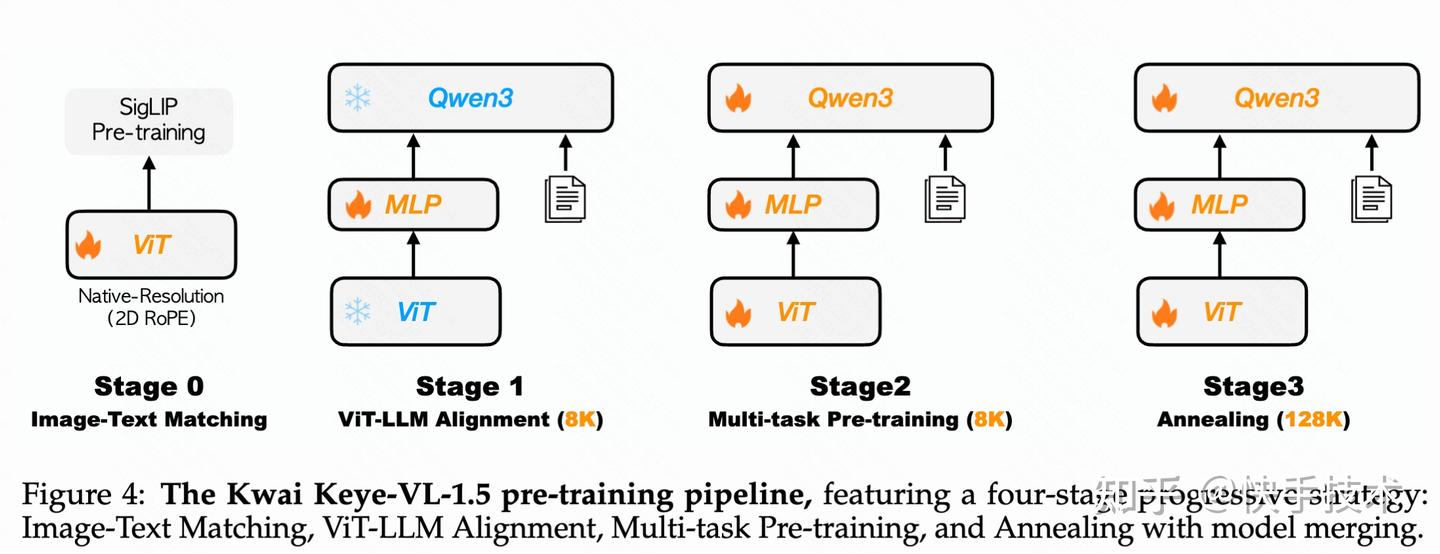

- 采用漸進(jìn)式四階段預(yù)訓(xùn)練方法:從跨模態(tài)對齊與多任務(wù)預(yù)訓(xùn)練起步,在退火階段將模型上下文長度從 8K 擴(kuò)展至 128K,使其能夠處理更長視頻和更復(fù)雜的視覺內(nèi)容,大幅增強(qiáng)視頻理解能力。最終的模型融合階段通過使用不同數(shù)據(jù)混合訓(xùn)練的模型進(jìn)行組合,以提高魯棒性并減少偏差。

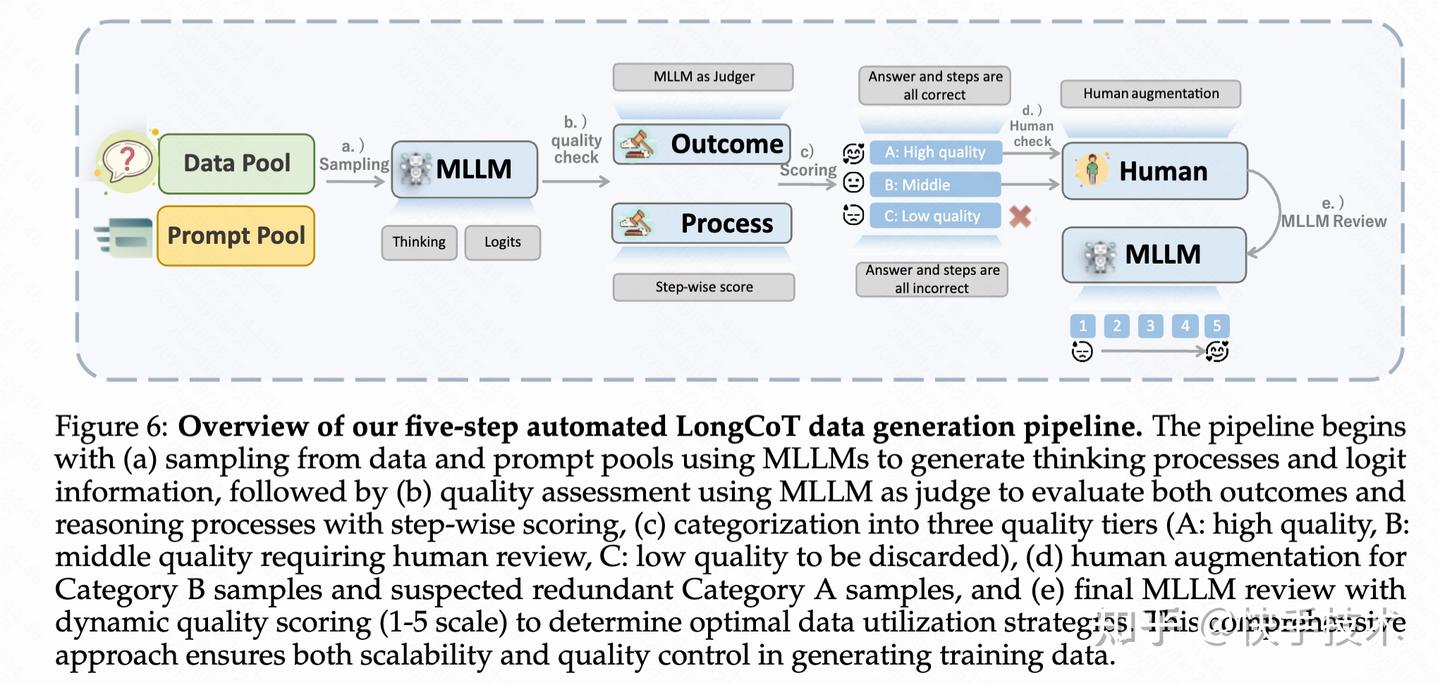

- 全面優(yōu)化后訓(xùn)練流程:提出五步自動化數(shù)據(jù)構(gòu)造流水線,基于 GSPO 算法迭代通用強(qiáng)化學(xué)習(xí)與對齊階段,全面提升模型的推理能力并與人類偏好對齊。

在多個公開的視頻基準(zhǔn)測試中,Keye-VL 1.5 8B 在同等規(guī)模的模型中性能最優(yōu),并在 MMMUval 和 AI2D 等大規(guī)模基準(zhǔn)測試中,Keye-VL 1.5 8B 取得了業(yè)界最佳成績!

Keye-VL-1.5-8B 現(xiàn)已開源,并公布了公開技術(shù)報(bào)告,歡迎各位開發(fā)者前往體驗(yàn)和交流。

項(xiàng)目主頁(可查看完整技術(shù)報(bào)告):??https://arxiv.org/pdf/2509.01563??

Github:??https://github.com/Kwai-Keye/Keye??

Model:??https://huggingface.co/Kwai-Keye/Keye-VL-1.5-8B??

先來看三個案例:

案例一:時序信息理解

Prompt:視頻中包出現(xiàn)的時間段是多少?

keye:視頻中包出現(xiàn)的時間段是 22.3 秒至 23.8 秒

案例二:推理能力

Prompt:視頻里大狗咬小狗的耳朵是為什么?

keye:視頻中,小狗試圖扒著桌子夠取食物,大狗(狗爸)通過輕咬小狗耳朵的行為,實(shí)則是在**糾正小狗的不當(dāng)行為**。這種輕咬是狗群中常見的“教育”方式,成年狗會用它告訴幼崽“這樣做不對”,需遵守規(guī)則。當(dāng)小狗收到這一信號后,便從站立夠食的狀態(tài)逐漸坐下來,最終躺下服從管理,說明大狗的行為成功傳遞了“不能偷食桌上食物”的警告。 \boxed{大狗咬小狗耳朵是糾正其試圖偷吃桌上食物的錯誤行為,通過輕咬傳遞警告讓小狗服從管理。}

案例三:描述能力

Prompt:請仔細(xì)描述視頻中的場景內(nèi)容?

keye:視頻的主要場景是一個被茂密森林環(huán)繞的潮濕角落,畫面中間是一條破損的老舊石階,石板的石板有裂,表面長滿綠色苔蘚和雜草,顯得斑駁滄桑。周圍是高大的深色樹木,樹枝上掛著鮮綠色的樹葉,樹葉間透出柔和的散射光,給場景增添了一層朦朧感。地面上散落著許多小白花或菌類,與綠色苔蘚交織,形成生機(jī)盎然的地面覆蓋。背景中森林延伸至遠(yuǎn)方,樹木逐漸模糊,展示出場景的深度與神秘感。空氣中似乎帶著細(xì)密的雨霧,地面和石階都顯得潮濕,偶爾有雨滴落下,進(jìn)一步強(qiáng)化了潮濕的氣氛。整體色調(diào)綠色和棕色為主,呈現(xiàn)出一種靜謐。自然且略帶荒涼的原始森林景象。

「核心技術(shù)架構(gòu)全公開」

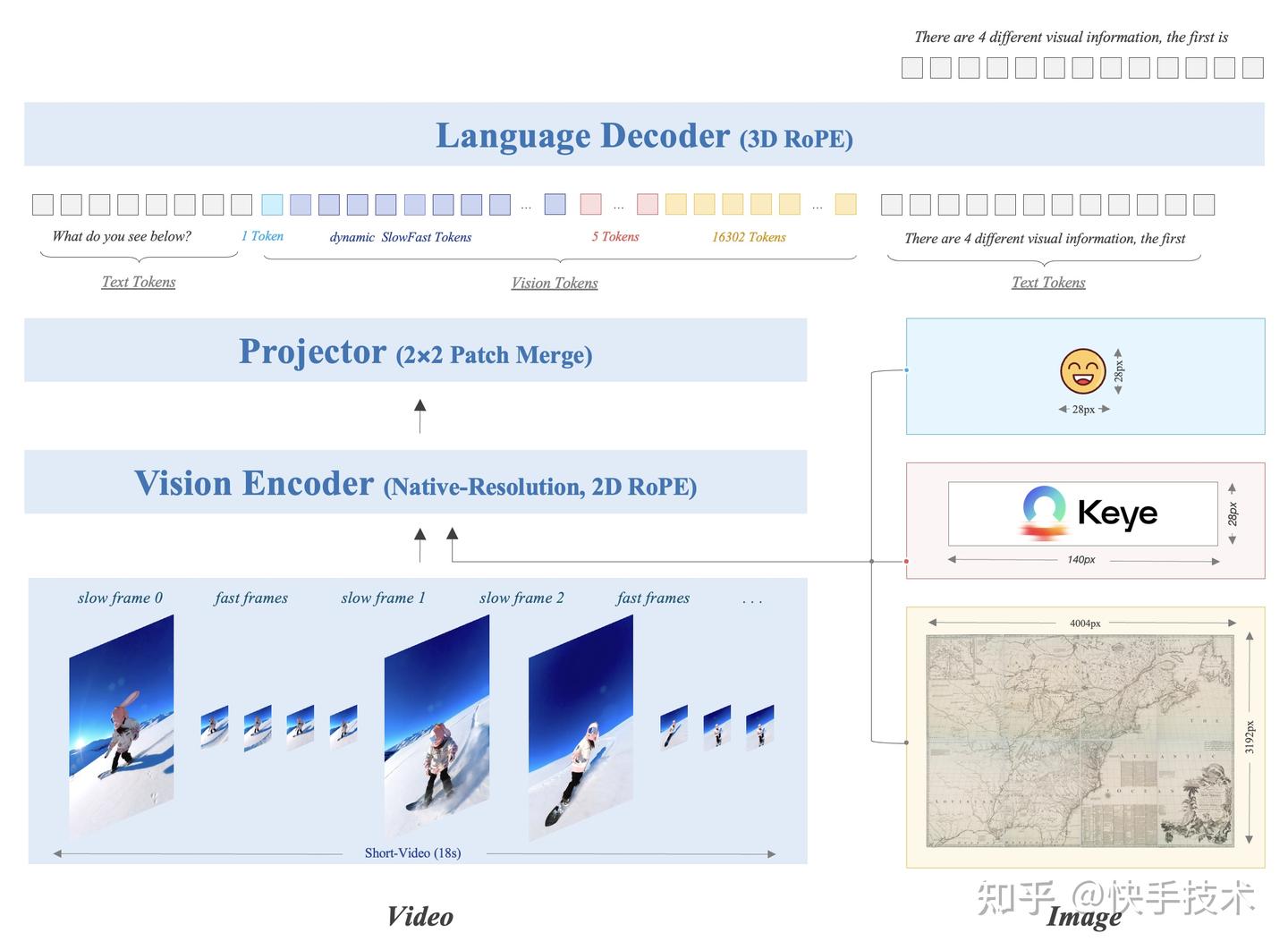

Keye-VL-1.5 采用經(jīng)典的多模態(tài)大語言模型架構(gòu),由三個核心組件構(gòu)成:視覺 Transformer(ViT)、MLP 投影器和語言解碼器。該模型使用 SigLIP-400M-384-14 作為視覺編碼器,Qwen3-8B 作為語言解碼器。在 Vision encoder 方面,采取了原生分辨率 ViT,2D ROPE 增強(qiáng)高分圖像理解,使用了 500B Token 的多源數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練。在視覺特征處理方面,針對不同視覺輸入采用差異化編碼策略。對于圖像,每張圖像使用 20,480 個 token 來保證細(xì)節(jié)捕獲。

一、慢快編碼策略:兼顧性能與成本

視頻內(nèi)容通常包含兩種類型的畫面:一種是快速變化、富含細(xì)節(jié)的畫面(如運(yùn)動場景),另一種是相對靜態(tài)的畫面(如靜止風(fēng)景)。為了在短視頻理解任務(wù)中同時實(shí)現(xiàn)高準(zhǔn)確性與高效率。Keye-VL-1.5 創(chuàng)新性地提出了

慢快編碼策略 (slow-fast),該策略設(shè)置慢通路處理快速變化幀(低幀數(shù)-高分辨率),快通路處理靜態(tài)幀(高幀數(shù)-低分辨率),從而在節(jié)省計(jì)算資源的同時保留關(guān)鍵信息。

具體來說,通過基于圖片相似性的算法自動識別慢快幀,快幀的 token 預(yù)算設(shè)為慢幀的 30%,并引入特殊 token 和時間戳來標(biāo)識幀邊界,實(shí)現(xiàn)了性能與計(jì)算成本的有效平衡。

二、Pretrain 策略:漸進(jìn)式四階段預(yù)訓(xùn)練方法

Keye-VL-1.5 采用精心設(shè)計(jì)的四階段漸進(jìn)式訓(xùn)練流水線,確保每個階段都有清晰且相互關(guān)聯(lián)的目標(biāo)。

視覺編碼器預(yù)訓(xùn)練:使用 SigLIP-400M 權(quán)重初始化 ViT,通過 SigLIP 對比損失函數(shù)進(jìn)行持續(xù)預(yù)訓(xùn)練,適應(yīng)內(nèi)部數(shù)據(jù)分布。

第一階段 - 跨模態(tài)對齊:專注優(yōu)化投影 MLP 層,建立跨模態(tài)特征的穩(wěn)固對齊基礎(chǔ)。

第二階段 - 多任務(wù)預(yù)訓(xùn)練:解凍所有模型參數(shù)進(jìn)行端到端優(yōu)化,顯著增強(qiáng)模型的基礎(chǔ)視覺理解能力。

第三階段 - 退火訓(xùn)練:在精選高質(zhì)量數(shù)據(jù)上進(jìn)行微調(diào),解決第二階段大規(guī)模訓(xùn)練中高質(zhì)量樣本接觸不足的問題。同時將序列長度從 8K 擴(kuò)展至 128K,RoPE 逆頻率從 100 萬重置為 800 萬,并引入長視頻、長文本和大尺度圖像等長上下文模態(tài)數(shù)據(jù)。

模型融合:為減少固定數(shù)據(jù)比例帶來的內(nèi)在偏差,在預(yù)訓(xùn)練最終階段采用同質(zhì)-異質(zhì)融合技術(shù),對不同數(shù)據(jù)混合比例下退火訓(xùn)練的模型權(quán)重進(jìn)行平均,保持多樣化能力的同時減少整體偏差,增強(qiáng)模型魯棒性。

三、Post-training 策略:全面提升推理能力與人類偏好對齊

Keye-VL-1.5 的訓(xùn)練后處理包含四個主要階段:

Stage 1:監(jiān)督微調(diào)與多偏好優(yōu)化

使用 750 萬個多模態(tài)問答樣本進(jìn)行監(jiān)督微調(diào),然后通過 MPO 算法進(jìn)一步提升性能。

Stage 2:長鏈思考冷啟動

為了獲取高質(zhì)量的冷啟動訓(xùn)練數(shù)據(jù),Keye-VL-1.5 提出了一個全面的五步自動化流水線來生成高質(zhì)量長鏈思考數(shù)據(jù)。首先從多個挑戰(zhàn)性領(lǐng)域收集多模態(tài)問答數(shù)據(jù),并使用專有模型進(jìn)行問題重寫和任務(wù)合并以增加復(fù)雜性;然后為每個問答對生成多個推理軌跡并量化模型置信度;接著實(shí)施雙層質(zhì)量評估框架,同時評估答案正確性和推理過程有效性,將樣本分為高質(zhì)量(A 類)、中等質(zhì)量(B 類)和低質(zhì)量(C 類)三個等級;對于 B 類樣本和部分 A 類樣本,采用人工指導(dǎo)的改進(jìn)過程來提升推理質(zhì)量;最后實(shí)施五點(diǎn)質(zhì)量評分系統(tǒng)和自適應(yīng)數(shù)據(jù)利用策略,讓高質(zhì)量樣本在訓(xùn)練中被更頻繁使用。

Stage 3:迭代通用強(qiáng)化學(xué)習(xí)

使用 GSPO 算法進(jìn)行可驗(yàn)證獎勵強(qiáng)化學(xué)習(xí)訓(xùn)練,采用漸進(jìn)提示采樣處理困難樣本(對于模型多次 rollout 都回答不對的樣本,在 prompt 中給予不同程度的提示),通過多輪迭代持續(xù)優(yōu)化模型推理能力。這個階段和 long cot sft 迭代進(jìn)行,使用 RL 模型 rollout 更好的 response(reward model 打分)進(jìn)行 SFT,然后使用 SFT 模型進(jìn)行下一階段的 RL 數(shù)據(jù)篩選與訓(xùn)練。

Stage 4:對齊強(qiáng)化學(xué)習(xí)

重點(diǎn)增強(qiáng)模型在指令遵循(生成滿足用戶內(nèi)容、格式、長度要求的回應(yīng)),instruction following(確保回應(yīng)符合預(yù)定義格式如思考-回答等模式)和偏好對齊(提高開放式問題回應(yīng)的可靠性和交互性)三個維度的能力。

四、實(shí)驗(yàn)效果

Keye-VL 在多模態(tài) AI 領(lǐng)域取得突破性進(jìn)展

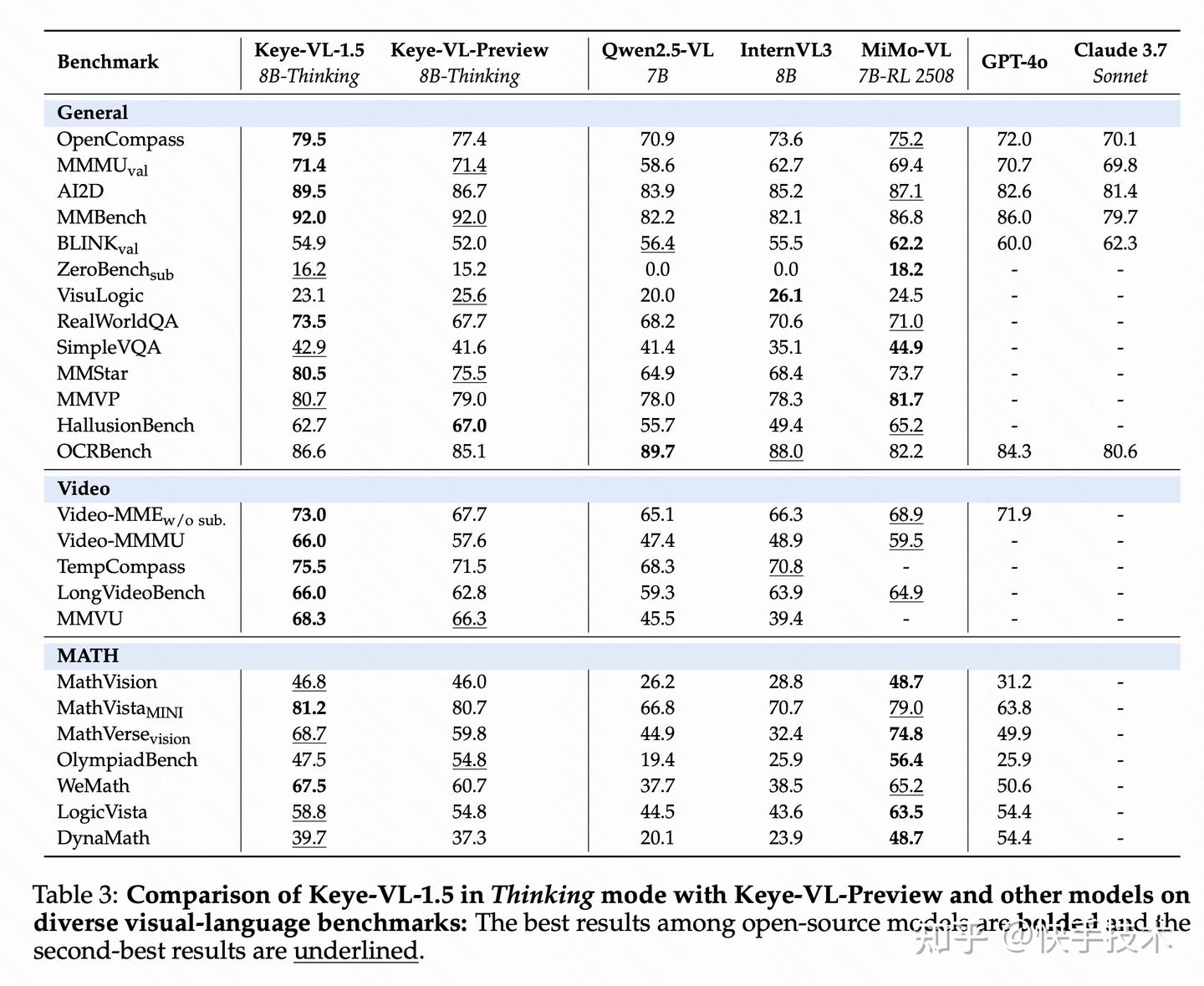

在通用視覺語言任務(wù)中,該模型在思考模式下于 MMMUval 和 OpenCompass 等大規(guī)模基準(zhǔn)測試中分別獲得 71.4%和 79.5%的同等 scale 的業(yè)界最佳成績,在 ZeroBenchsub 和 MMVP 等挑戰(zhàn)性測試中同樣表現(xiàn)卓越,并在 HallusionBench 中實(shí)現(xiàn) 62.7%準(zhǔn)確率,顯著降低 AI 幻覺現(xiàn)象。在視頻理解領(lǐng)域,Keye-VL 表現(xiàn)更佳,在 Video-MMMU 測試中達(dá)到了 66 分,充分證明了其在視頻內(nèi)容理解方面的技術(shù)優(yōu)勢。

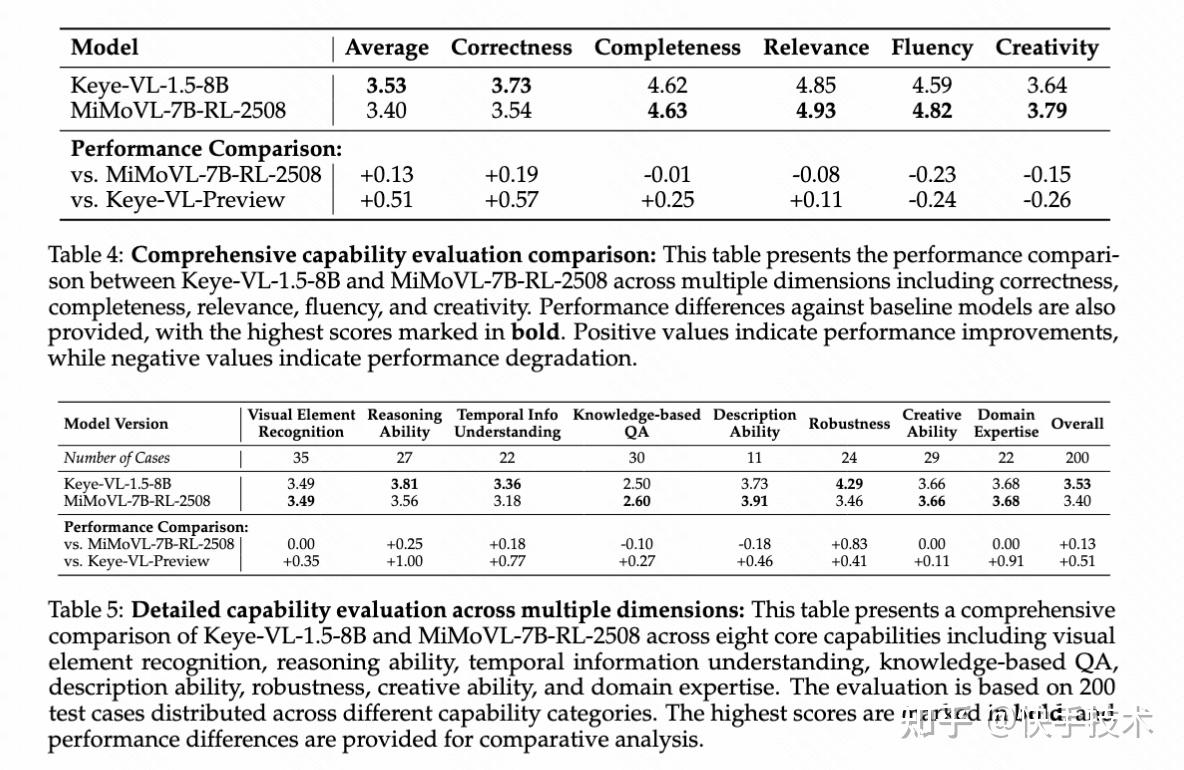

Keye-VL 內(nèi)部人工基準(zhǔn)測試顯示顯著性能提升

為了全面評估模型能力,快手 Keye 團(tuán)隊(duì)構(gòu)建了嚴(yán)格的內(nèi)部視頻評估基準(zhǔn),解決了公開基準(zhǔn)測試存在的任務(wù)覆蓋有限、問題格式過于簡化、答案方法受限、數(shù)據(jù)污染風(fēng)險(xiǎn)和語言文化偏見等問題。該基準(zhǔn)涵蓋視覺元素識別、推理能力、時序信息理解、基于知識的問答、描述能力、魯棒性、創(chuàng)造能力和領(lǐng)域?qū)I(yè)知識八個維度,采用多模型對比評估和 GSB 偏好選擇的評分方法。

評估結(jié)果顯示,

Keye-VL-1.5-8B 取得了顯著的性能提升:總體綜合得分達(dá)到 3.53,相比 Keye-VL-Preview 提升 0.51 分,在正確性(+0.57)和完整性(+0.25)方面表現(xiàn)尤為突出。與行業(yè)基準(zhǔn) MiMoVL-7B-RL-2508 的直接對比中,Keye-VL-1.5-8B 獲得更高的總體得分(3.53 對 3.40),在正確性方面領(lǐng)先 0.19 分。詳細(xì)能力分析顯示,該模型在推理能力(3.81)、時序信息理解(3.36)和魯棒性(4.29)方面表現(xiàn)卓越,其中魯棒性相比競品領(lǐng)先 0.83 分,充分證明了模型在處理復(fù)雜分析任務(wù)和保持穩(wěn)定性能方面的強(qiáng)大優(yōu)勢。相比前版本,模型在基礎(chǔ)視覺理解能力方面建立了堅(jiān)實(shí)基礎(chǔ),視覺元素識別提升 0.35 分,推理能力提升 1.00 分,時序信息理解提升 0.77 分,為處理復(fù)雜多模態(tài)推理任務(wù)提供了強(qiáng)大的技術(shù)支撐。

展望未來,依托快手在短視頻領(lǐng)域深厚的技術(shù)積累,Kwai Keye-VL 在視頻理解方面具備獨(dú)特優(yōu)勢。該模型的發(fā)布與開源,標(biāo)志著多模態(tài)大語言模型在視頻理解新紀(jì)元的探索邁出了堅(jiān)實(shí)一步。