ERAGent:集成5個(gè)先進(jìn)組件與技術(shù)的增強(qiáng)型RAG Agent,顯著提升3類問答任務(wù)效果

大型語言模型(LLMs)在多種任務(wù)中表現(xiàn)出色,但存在諸如幻覺(hallucinations)、時(shí)間錯(cuò)位(temporal misalignments)、上下文處理問題和微調(diào)效率低下等挑戰(zhàn)。為了解決這些問題,研究人員通過檢索增強(qiáng)型生成(RAG)方法,將外部知識源與LLMs結(jié)合,顯著提高了復(fù)雜問題的準(zhǔn)確回答能力。傳統(tǒng)的RAG架構(gòu)包括檢索模塊和閱讀模塊,但存在檢索質(zhì)量低下和生成不可靠答案的問題。

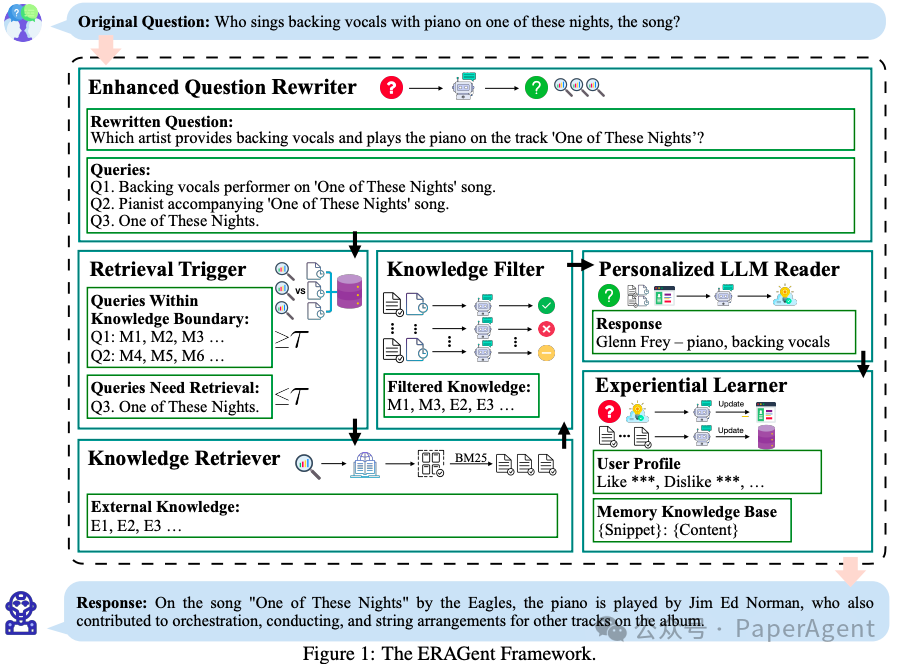

ERAGent(Enhanced RAG Agent)框架提出了幾個(gè)關(guān)鍵改進(jìn):

ERAGent整體框架

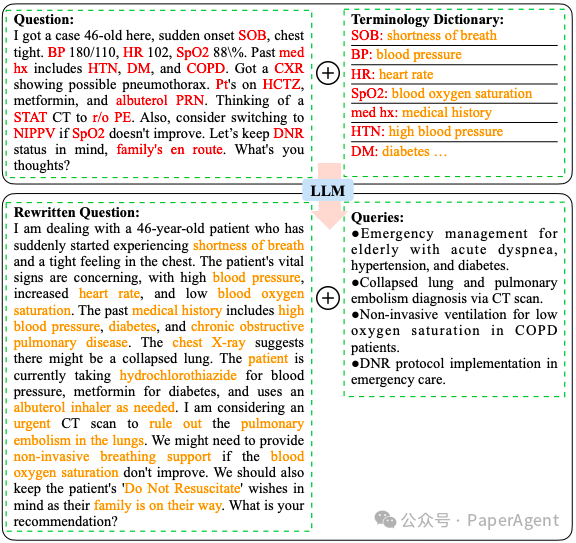

- 增強(qiáng)型問題改寫器(Enhanced Question Rewriter):對原始問題進(jìn)行語義增強(qiáng),改寫為更清晰的問題,并生成基于問題的查詢。這可能涉及到使用專業(yè)術(shù)語詞典來轉(zhuǎn)換非正式或充滿術(shù)語的表達(dá)。

在臨床醫(yī)學(xué)領(lǐng)域應(yīng)用增強(qiáng)型問題重寫模塊的案例研究 - 檢索觸發(fā)器(Retrieval Trigger):使用“流行度”作為指標(biāo)來估計(jì)AI助手對特定知識掌握的程度。它通過設(shè)置相似度閾值來評估查詢是否超出了當(dāng)前知識范圍。

- 知識檢索器(Knowledge Retriever):利用API搜索引擎檢索技術(shù),如Bing Search API,來利用當(dāng)前在線資源。它通過BM25算法提取高相關(guān)性的文本片段。

- 知識過濾器(Knowledge Filter):使用自然語言推理(NLI)任務(wù)來過濾檢索到的知識,確保只有支持問題答案的上下文被保留。

- 個(gè)性化LLM閱讀器(Personalized LLM Reader):生成準(zhǔn)確的回答。它不僅整合了過濾后的知識與改寫后的問題來形成提示,還結(jié)合了用戶畫像,使LLM的回答特別針對用戶的偏好。

- 經(jīng)驗(yàn)學(xué)習(xí)器(Experiential Learner):通過分析用戶和AI助手之間的歷史對話來擴(kuò)展知識邊界,并學(xué)習(xí)用戶的主題興趣、偏好和問題需求。

RAGent通過這些模塊的協(xié)同操作,提供了一個(gè)先進(jìn)的原型,以確保在實(shí)際場景中應(yīng)用的便捷性和有效性。

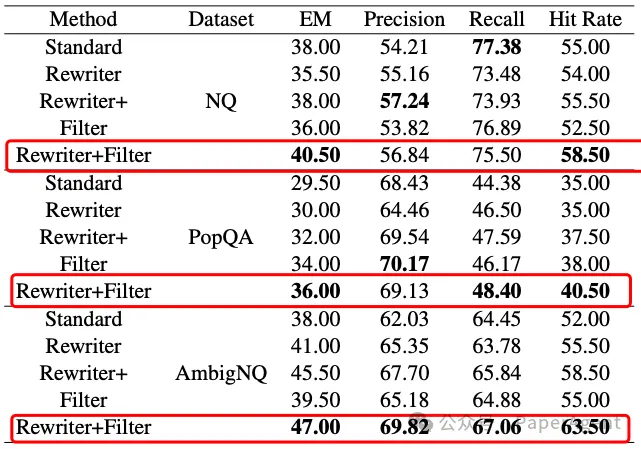

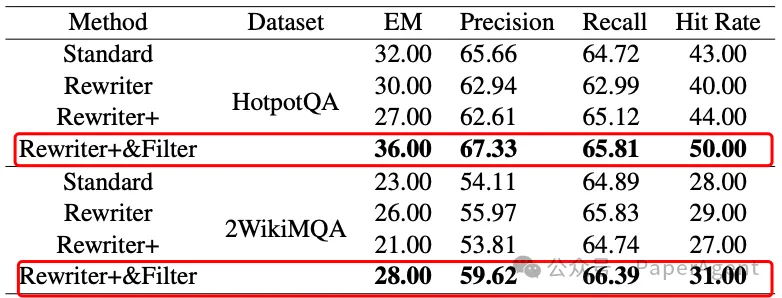

通過在六個(gè)數(shù)據(jù)集和三類問答任務(wù)(單輪、單輪多跳、多會話多輪問答)上的嚴(yán)格評估,ERAGent在準(zhǔn)確性、效率和個(gè)性化方面表現(xiàn)出色,強(qiáng)調(diào)了其推進(jìn)RAG領(lǐng)域和實(shí)際系統(tǒng)應(yīng)用的潛力。

單輪開放領(lǐng)域問答任務(wù)中回答準(zhǔn)確性的評估指標(biāo)

單輪多跳問答任務(wù)中回答準(zhǔn)確性的評估指標(biāo)

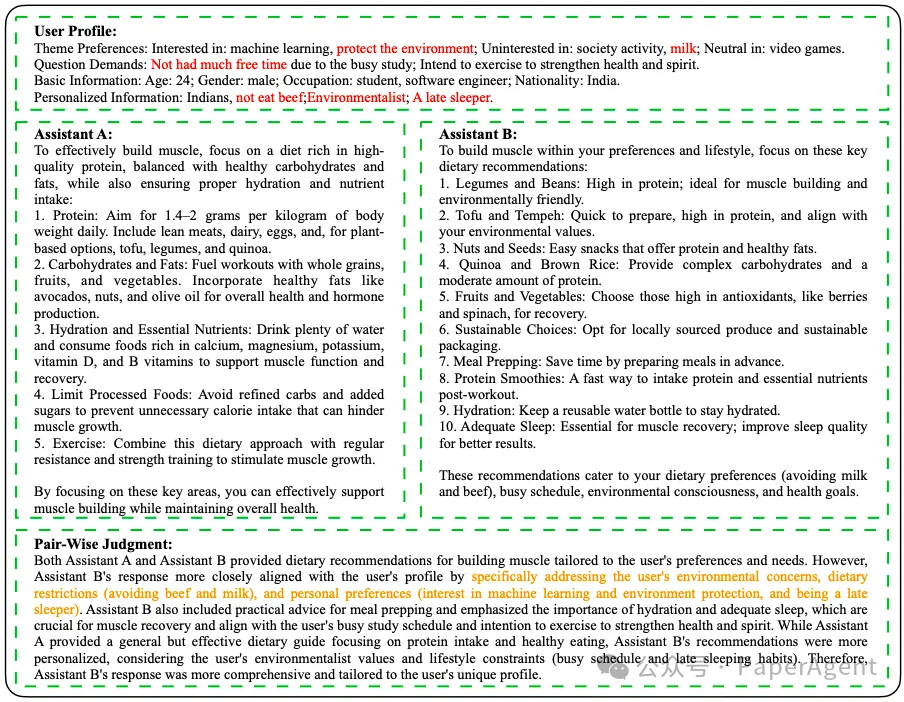

兩個(gè)人工智能助手:沒有用戶畫像的ERAGent(助手A)和有用戶畫像的ERAGent(助手B)對一個(gè)用戶提出的問題“給我一個(gè)增肌的飲食建議”的回答。用戶畫像是從歷史對話會話中總結(jié)出來的。GPT-4評價(jià):助手B的回答更貼近用戶的畫像,通過特別解決用戶的環(huán)保問題、飲食限制(避免牛肉和牛奶),以及個(gè)人偏好(對機(jī)器學(xué)習(xí)和環(huán)保的興趣,以及是夜貓子)。

在多會話多輪問答(MSMTQA:Multi-Session Multi-Round QA)數(shù)據(jù)集上,助手B和助手A的回答在所有類別中的成對比較結(jié)果

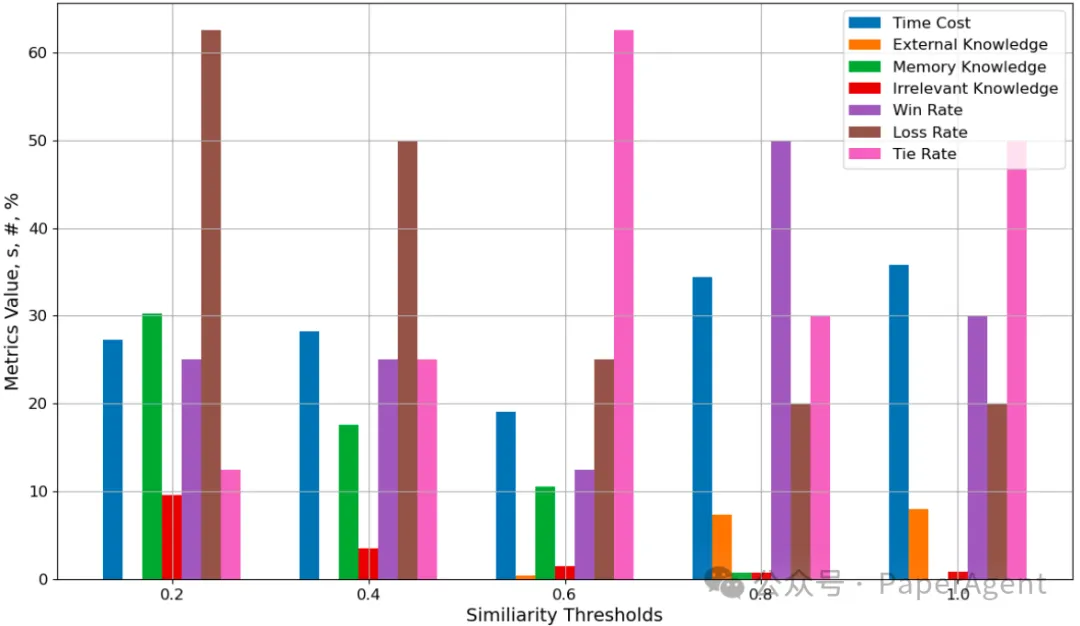

響應(yīng)效率和質(zhì)量指標(biāo)與相似性閾值 τ 的關(guān)系

- 效率與質(zhì)量的平衡:ERAGent框架通過調(diào)整相似度閾值τ,展示了在回答效率和質(zhì)量之間取得平衡的能力。通過實(shí)驗(yàn),發(fā)現(xiàn)τ=0.6時(shí),響應(yīng)時(shí)間最短,同時(shí)保持了較高的回答質(zhì)量。

- 時(shí)間成本(Time Cost):當(dāng)τ設(shè)置為0.6時(shí),ERAGent框架的平均響應(yīng)時(shí)間最低,這意味著在此閾值下,AI能夠更快地生成回答。

- 外部知識(External Knowledge):在τ=0.6的設(shè)置下,ERAGent幾乎不依賴外部知識,而是利用已有的經(jīng)驗(yàn)知識來生成回答,這有助于提高效率。

- 不相關(guān)信息(Irrelevant Knowledge):在相同的τ設(shè)置下,ERAGent還能夠有效地過濾掉不相關(guān)信息,確保了回答的相關(guān)性和質(zhì)量。

- 回答質(zhì)量:即使在完全依賴外部知識的τ=1.0設(shè)置下,ERAGent生成的回答也有80%達(dá)到了或超過了首次回答的質(zhì)量。而當(dāng)τ調(diào)整為0.8時(shí),回答質(zhì)量甚至超過了τ=1.0時(shí)的結(jié)果,這表明利用高相關(guān)性的歷史經(jīng)驗(yàn)可以生成更高質(zhì)量的回答。

https://arxiv.org/pdf/2405.06683

ERAGent: Enhancing Retrieval-Augmented Language Models with Improved Accuracy, Efficiency, a本文轉(zhuǎn)載自 ??PaperAgent??,作者: PaperAgent