全球首發,國產開源「文本-視頻生成」模型!免費在線體驗,一鍵實現視頻生成自由

去年4月,OpenAI發布的DALL-E 2用更高的分辨率、更真實的圖像生成以及更準確地理解自然描述,橫掃整個AIGC領域。

不過圖像生成真正進入全民化還要數Stable Diffusion的開源,僅在消費級的GPU上即可運行,用戶可以在自己的數據集上進行微調,也不用忍受各大繪畫網站為了「安全」設立的各種過濾詞表,真正實現了「繪畫自由」。

而在視頻生成領域,目前各家大廠還是只敢拿demo出來演示,普通用戶還無法使用。

最近阿里達摩院在ModelScope上首發開源了「基于文本的視頻生成」的模型參數,一起實現「視頻自由」!

模型鏈接:?https://modelscope.cn/models/damo/text-to-video-synthesis/files?

體驗鏈接:?https://huggingface.co/spaces/damo-vilab/modelscope-text-to-video-synthesis?

只需要輸入文本,即可返回符合文本描述的視頻,并且該模型能夠適用于「開放領域」的視頻生成,能夠基于文本描述進行推理,不過目前只支持英文輸入。

比如說輸入經典的「an astronaut riding a horse」,直接讓宇航員動起來!

或者輸入「a panda eating bamboo on a rock」,可以得到下面的視頻。

也可以根據huggingface上提供的接口自行輸入prompt,比如輸入「a dog eating a cake」,就可以得到2秒鐘的視頻,不過由于計算資源不足,可能需要排隊等待一會。

國內首發「文本-視頻生成」

文本到視頻生成擴散模型由「文本特征提取」、「文本特征到視頻隱空間擴散模型」、「視頻隱空間到視頻視覺空間」三個子網絡組成,整體模型參數約17億。

多階段文本到視頻生成擴散模型采用Unet3D結構,通過從純高斯噪聲視頻中迭代去噪的過程,實現視頻生成的功能。

在實現上參考的相關論文主要有兩篇。

高分辨率圖像合成與潛擴散模型?

通過將圖像形成過程分解為自動編碼器去噪的順序應用,擴散模型實現了對圖像數據和其他數據的最新合成結果,并且擴散模型的公式能夠接受一個引導機制來控制圖像生成過程,而不需要重新訓練。

不過由于這些模型通常直接在像素空間中運行,因此對強大的擴散模型進行優化通常需要耗費數百 GPU 天的時間,并且由于順序評估而導致推理成本高昂。

論文鏈接:?https://arxiv.org/pdf/2112.10752.pdf?

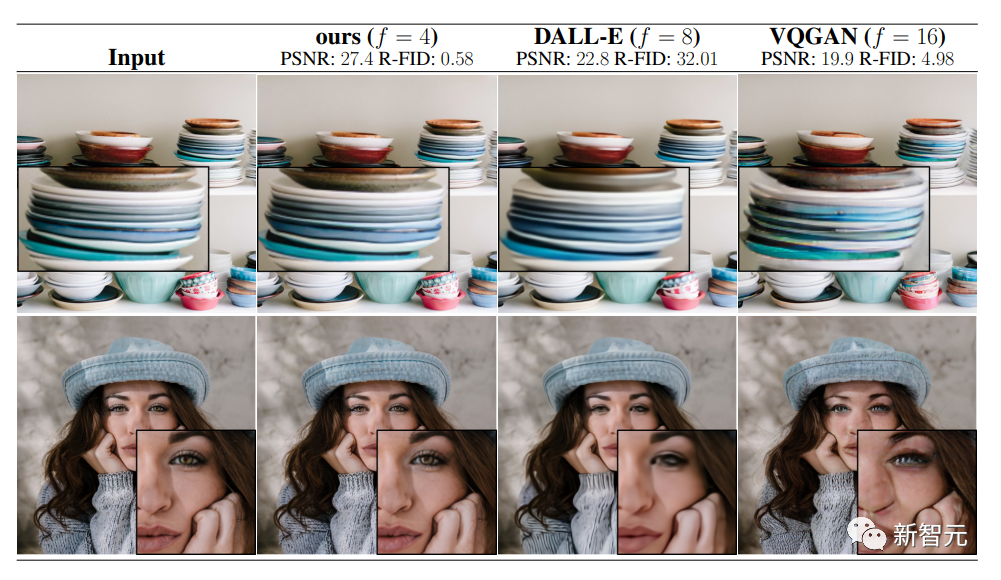

為了能夠在有限的計算資源上進行擴散模型訓練,同時保持其質量和靈活性,研究人員將其應用于強大的預訓練自動編碼器的潛空間。

與以往的工作相比,在這種表征上的訓練擴散模型可以在降低復雜度和保持細節之間達到接近最佳的點,大大提高了視覺保真度。

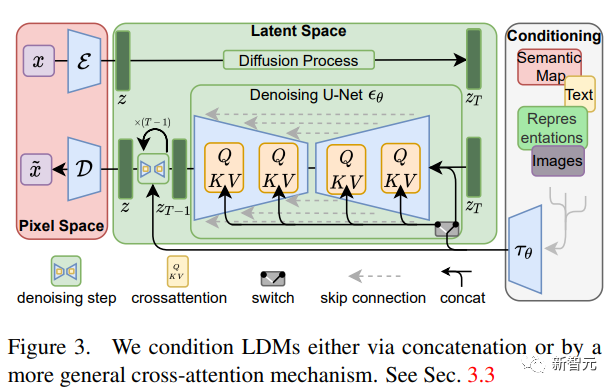

通過在模型結構中引入交叉注意層,可以將擴散模型轉化為功能強大且靈活的生成器,用于一般條件輸入(如文本或邊界框) ,并使得以卷積方式進行高分辨率合成成為可能。

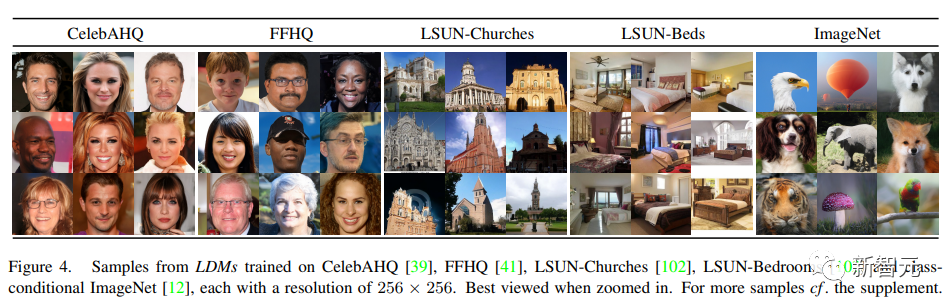

文中提出的潛擴散模型(LDM)在圖像修復和各種任務(包括無條件圖像生成、語義場景合成和超分辨率)的高度競爭性性能方面取得了新的進展,同時與基于像素的潛在擴散模型相比,顯著降低了計算需求。

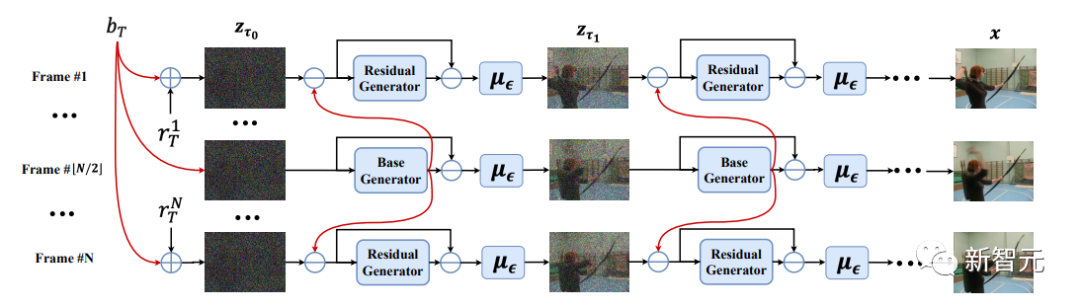

VideoFusion:用于高質量視頻生成的分解擴散模型

擴散概率模型(DPM)通過逐漸向數據點添加噪聲來構造正向擴散過程,并學習反向去噪過程以生成新樣本,已被證明能夠處理復雜的數據分布。

盡管最近在圖像合成方面取得了成功,但是由于視頻的數據空間維度更高,將DPM應用于視頻生成仍然具有挑戰性。

以往的方法通常采用標準的擴散過程,即用獨立的噪聲破壞同一視頻片段中的幀,忽略了內容冗余和時間相關性。

論文鏈接:?https://arxiv.org/pdf/2303.08320v2.pdf?

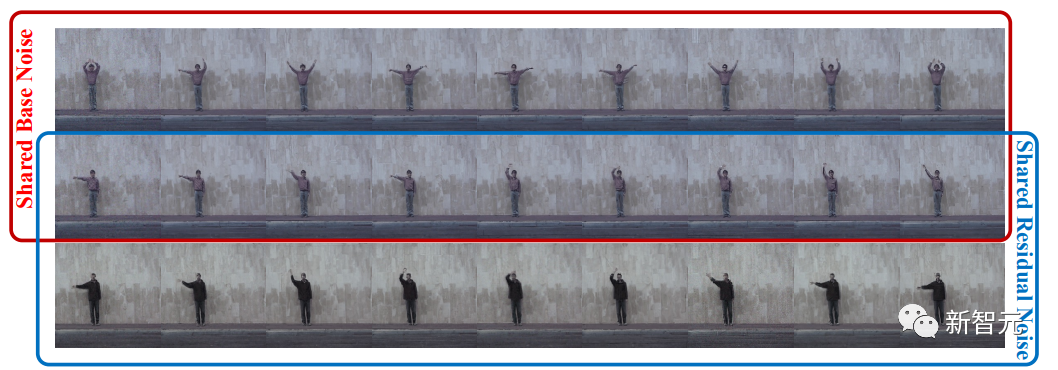

這篇論文提出了一種分解擴散過程,通過將每幀噪聲分解為一個在所有幀之間共享的基本噪聲和一個沿著時間軸變化的殘余噪聲;去噪pipeline采用兩個聯合學習的網絡來相應地匹配噪聲分解。

在不同數據集上的實驗證實了文中的方法VideoFusion,在高質量視頻生成方面優于基于GAN和基于擴散的替代方法。

實驗中進一步表明,分解公式可以受益于預先訓練的圖像擴散模型和良好的支持文本條件下的視頻生成。

使用方法

在ModelScope框架下,通過調用簡單的Pipeline即可使用當前模型,其中,輸入需為字典格式,合法鍵值為'text',內容為一小段文本。

該模型暫僅支持在GPU上進行推理,模型需要硬件配置大約是 16GB 內存和 16GB GPU顯存。

輸入具體代碼示例如下。

運行環境 (Python Package)

代碼范例 (Demo Code)

查看結果 (View Results)

上述代碼會展示輸出視頻的保存路徑,目前編碼格式采用VLC播放器可以正常播放。

模型的限制與偏見

- 模型基于Webvid等公開數據集進行訓練,生成結果可能會存在與訓練數據分布相關的偏差。

- 該模型無法實現完美的影視級生成。

- 該模型無法生成清晰的文本。

- 該模型主要是用英文語料訓練的,暫不支持其他語言。

- 該模型在復雜的組合性生成任務上表現有待提升。

訓練數據

訓練數據包括 LAION5B、 ImageNet、 Webvid 等公共數據集。圖像和視頻濾波是經過美學評分、水印評分和重復數據刪除等預訓練后進行的。