如何用Python輕松檢測文本相似性:原理與方法

文本查重

文本查重,也稱為文本去重(Plagiarism Detection),是一項旨在識別文本文檔之間的相似性或重復性的技術或任務。它的主要目標是確定一個文本文檔是否包含與其他文檔相似或重復的內容,通常是為了檢測抄襲、重復、剽竊等不當行為。

文本查重的重要性和應用領域

文本查重在今天的信息時代具有重要性,并在多個應用領域中發揮關鍵作用。以下是文本查重的重要性以及一些主要應用領域:

1. 學術研究和教育領域

- 抄襲檢測:在學術研究中,文本查重用于檢測學生論文、學術論文和研究報告中的抄襲行為,以確保學術誠實性。

- 學術評估:學術評估機構和期刊使用文本查重來驗證論文的原創性,以確保高質量的學術出版物。

2. 新聞和媒體領域

- 新聞稿件驗證:新聞編輯和出版商使用文本查重來驗證新聞稿件的原創性,以避免不實報道和抄襲。

- 內容質量控制:維護在線新聞和媒體平臺上的高質量內容,以提供可信賴的信息。

3. 內容管理和版權保護

- 網站內容管理:網站管理員使用文本查重來管理網站上的重復內容,提供更好的用戶體驗。

- 版權保護:內容創作者和版權持有者使用文本查重來監測和保護其知識產權。

4. 搜索引擎和信息檢索

- 搜索結果提升:搜索引擎公司使用文本查重來消除重復內容,從而提高搜索結果的質量。

- 搜索引擎優化:網站管理員使用文本查重來改進其內容,以提高在搜索引擎中的排名。

5. 法律和知識產權領域

- 知識產權保護:律師和知識產權專業人員使用文本查重來監測和保護專利、商標和版權等知識產權。

- 法庭證據:文本查重用于法庭案件中,以確定證據是否存在抄襲或知識產權侵權。

6. 廣告和市場營銷

- 廣告監管:廣告行業使用文本查重來驗證廣告內容的原創性,以確保合規性和消費者保護。

- 品牌聲譽:企業使用文本查重來監測和保護其品牌聲譽,以避免負面廣告。

總的來說,文本查重在多個領域中都具有廣泛的應用,以確保內容的原創性、知識產權的保護、信息質量的提高和法律合規性的維護。它有助于維護信任、保護知識產權和提供更高質量的信息。

文本查重的原理

基本原理

文本相似性的確定是文本查重任務的核心,它涉及了多種原理和方法。下面是關于如何確定文本相似性的基本原理:

- 向量空間模型 (Vector Space Model):

- 文本文檔通常被表示為向量,其中每個維度對應一個特定的詞語或特征。

- 文檔中的詞語在向量中的權重通常使用詞頻(詞出現的次數)或 TF-IDF(詞頻-逆文檔頻率)等統計信息來表示。

- 這樣,每個文檔都成為高維向量空間中的一個點,而文本相似性問題就可以轉化為在這個向量空間中的距離或角度問題。

- 相似性度量 (Similarity Measurement):

- 相似性度量是用來比較文本文檔之間的相似性的方法。

- 常見的相似性度量包括余弦相似度、Jaccard相似性、編輯距離等。

- 這些度量方法用于計算文檔向量之間的相似性分數,根據分數的高低來判斷文本的相似性。

常見的相似性度量方法

- 余弦相似度 (Cosine Similarity):

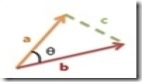

- 余弦相似度是一種常用的文本相似性度量方法,用于比較兩個文本向量之間的夾角。

- 具體來說,余弦相似度度量了兩個文本向量之間的夾角余弦值,值越接近1表示文本越相似。

- Jaccard相似性 (Jaccard Similarity):

- Jaccard相似性用于比較兩個集合的相似性。

- 它是通過計算兩個集合的交集元素數目除以它們的并集元素數目來確定相似性的。

- 編輯距離 (Edit Distance):

- 編輯距離度量了兩個字符串之間的相似性,它代表將一個字符串轉換為另一個所需的最小編輯操作次數。

- 編輯操作包括插入、刪除、替換字符等。

- 基于詞袋的方法 (Bag of Words):

- 基于詞袋的方法將文本視為詞匯的集合,通過統計詞頻或使用TF-IDF等方法來比較文本相似性。

- 詞袋方法忽略了詞語的順序,僅考慮詞語出現的頻率。

余弦相似度

余弦相似度是一種常用的方法,它測量兩個文本向量之間的夾角。

import numpy as np

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.metrics.pairwise import cosine_similarity

documents = ["This is the first document.", "This document is the second document.", "And this is the third one."]

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(documents)

cosine_sim = cosine_similarity(X, X)

print(cosine_sim)Jaccard相似性

Jaccard相似性用于比較兩個集合的相似性。

def jaccard_similarity(set1, set2):

intersection = len(set1.intersection(set2))

union = len(set1.union(set2))

return intersection / union

text1 = set("This is the first document.".split())

text2 = set("This document is the second document.".split())

similarity = jaccard_similarity(text1, text2)

print(similarity)編輯距離

編輯距離用于比較兩個字符串之間的相似性。

import nltk

from nltk.metrics import edit_distance

str1 = "kitten"

str2 = "sitting"

distance = edit_distance(str1, str2)

print(distance)基于詞袋的方法

基于詞袋的方法將文本視為詞匯的集合,并使用詞頻或TF-IDF等方法來比較文本相似性。

from sklearn.feature_extraction.text import TfidfVectorizer

corpus = ["This is the first document.", "This document is the second document.", "And this is the third one."]

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(corpus)方法一:基于哈希的文本查重

哈希函數

哈希函數是一種數學函數,它將輸入數據(或"消息")映射到固定長度的二進制序列,通常稱為哈希值或摘要。哈希函數的關鍵特性是,對于給定的輸入,它始終生成相同長度的哈希值,而且即使輸入的微小變化也會導致生成的哈希值發生顯著變化。

哈希函數的主要用途包括數據完整性驗證、密碼學安全、數據存儲和檢索優化等。

MinHash算法的原理和實現

MinHash算法是一種基于哈希的文本查重方法,它通過隨機排列文檔中的詞項并使用哈希函數來比較文檔的相似性。

from datasketch import MinHash, MinHashLSH

# 創建MinHash對象

m1 = MinHash()

m2 = MinHash()

# 添加元素到MinHash

for d in data1:

m1.update(d.encode('utf8'))

for d in data2:

m2.update(d.encode('utf8'))

# 創建MinHash LSH索引

lsh = MinHashLSH(threshold=0.5, num_perm=128)

lsh.insert("m2", m2)

# 查詢相似的MinHash

result = lsh.query(m1)

print("Approximate Jaccard:", len(result) / float(len(m1)))使用示例:使用MinHash檢測文本相似性

使用MinHash和MinHash LSH(局部敏感哈希)來檢測文本相似性是一種快速和有效的方法。MinHash是一種數據結構,用于估計兩個集合的Jaccard相似度,而MinHash LSH是一種索引結構,用于快速查找具有相似MinHash值的文本文檔。

下面是一個使用MinHash檢測文本相似性的示例:

from datasketch import MinHash, MinHashLSH

# 創建MinHash對象和MinHash LSH索引

m1 = MinHash()

m2 = MinHash()

lsh = MinHashLSH(threshold=0.5, num_perm=128) # threshold是相似性閾值

# 文本數據

data1 = ["apple", "banana", "cherry", "date"]

data2 = ["banana", "date", "fig", "grape"]

# 添加元素到MinHash

for d in data1:

m1.update(d.encode('utf8'))

for d in data2:

m2.update(d.encode('utf8'))

# 插入MinHash到LSH索引

lsh.insert("m2", m2)

# 查詢相似的MinHash

result = lsh.query(m1)

# 計算相似性

similarity = len(result) / float(len(m1))

print("Approximate Jaccard Similarity:", similarity)上述代碼示例演示了如何使用MinHash和MinHash LSH來檢測兩個文本文檔的相似性。在此示例中,首先創建了兩個MinHash對象(m1和m2),然后將文本數據添加到這些對象中。接下來,使用MinHash LSH索引來插入一個MinHash(m2),并使用查詢來查找與m1相似的MinHash。最后,計算相似性得分,根據相似性閾值來判斷文本文檔是否相似。

方法二:基于特征提取的文本查重

文本特征提取的方法

TF-IDF(詞頻-逆文檔頻率)

TF-IDF是一種用于表示文本的方法,它考慮了詞在文檔中的頻率以及在整個語料庫中的重要性。

from sklearn.feature_extraction.text import TfidfVectorizer

corpus = ["This is the first document.", "This document is the second document.", "And this is the third one."]

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(corpus)Word2Vec和詞嵌入

Word2Vec是一種用于將詞匯映射到連續向量空間的方法,可以用于比較文本相似性。

from gensim.models import Word2Vec

sentences = [["this", "is", "the", "first", "sentence"],

["this", "is", "the", "second", "sentence"],

["is", "this", "the", "third", "sentence"]]

model = Word2Vec(sentences, vector_size=100, window=5, min_count=1, sg=0)使用示例:使用TF-IDF比較文本相似性

使用TF-IDF(詞頻-逆文檔頻率)來比較文本文檔之間的相似性是一種常見的方法。TF-IDF是一種用于衡量詞語在文檔集合中的重要性的技術,它可以將文本轉化為向量表示,并計算向量之間的相似性。

下面是一個使用TF-IDF比較文本相似性的示例:

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.metrics.pairwise import cosine_similarity

# 示例文本數據

documents = [

"Python is a popular programming language",

"Java is another widely used language",

"Programming languages are essential for software development",

"Python and Java are both used in web development"

]

# 創建TF-IDF向量化器

tfidf_vectorizer = TfidfVectorizer()

# 將文本數據轉化為TF-IDF向量

tfidf_matrix = tfidf_vectorizer.fit_transform(documents)

# 計算文檔之間的余弦相似性

similarity_matrix = cosine_similarity(tfidf_matrix)

# 打印相似性矩陣

print("Similarity Matrix:")

print(similarity_matrix)

# 查找最相似的文檔

most_similar = similarity_matrix.argsort()[:, -2]

# 打印最相似的文檔

for i, doc_index in enumerate(most_similar):

print(f"Document {i} is most similar to Document {doc_index} (Similarity Score: {similarity_matrix[i][doc_index]:.2f})")在上述示例中,首先定義了一組文本文檔,然后使用TfidfVectorizer將文本數據轉化為TF-IDF向量。接下來,使用cosine_similarity函數計算文檔之間的余弦相似性。最后,查找每個文檔的最相似文檔,并打印它們之間的相似性分數。

方法三:基于深度學習的文本查重

深度學習在文本查重中的應用

深度學習模型如卷積神經網絡(CNN)和循環神經網絡(RNN)在文本查重中表現出色。

使用卷積神經網絡(CNN)進行文本查重

CNN可以用于提取文本特征并進行文本相似性比較。

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Embedding, Conv1D, GlobalMaxPooling1D, Dense

model = Sequential()

model.add(Embedding(input_dim=vocab_size, output_dim=embed_size, input_length=max_sequence_length))

model.add(Conv1D(filters=128, kernel_size=5, activation='relu'))

model.add(GlobalMaxPooling1D())

model.add(Dense(1, activation='sigmoid'))

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])使用循環神經網絡(RNN)進行文本查重

RNN可以捕捉文本之間的上下文信息。

from tensorflow.keras.layers import LSTM

model = Sequential()

model.add(Embedding(input_dim=vocab_size, output_dim=embed_size, input_length=max_sequence_length))

model.add(LSTM(128))

model.add(Dense(1, activation='sigmoid'))

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])使用示例:使用深度學習模型檢測文本相似性

使用深度學習模型來檢測文本相似性通常需要大規模的訓練數據和計算資源。

以下是一個示例,演示了如何使用預訓練的BERT模型來檢測文本相似性。在這個示例中,將使用Hugging Face Transformers庫,該庫提供了輕松訪問多種預訓練的NLP模型。

請確保已安裝transformers庫,使用以下命令安裝:

pip install transformers然后,使用以下示例代碼:

from transformers import AutoTokenizer, AutoModel

import torch

from scipy.spatial.distance import cosine

# 加載預訓練的BERT模型和分詞器

model_name = "bert-base-uncased"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModel.from_pretrained(model_name)

# 示例文本數據

text1 = "Python is a popular programming language"

text2 = "Java is another widely used language"

# 對文本進行分詞和編碼

inputs1 = tokenizer(text1, return_tensors="pt", padding=True, truncation=True)

inputs2 = tokenizer(text2, return_tensors="pt", padding=True, truncation=True)

# 使用BERT模型獲取文本嵌入

outputs1 = model(**inputs1)

outputs2 = model(**inputs2)

# 獲取文本的嵌入向量

embedding1 = outputs1.last_hidden_state.mean(dim=1).detach().numpy()[0]

embedding2 = outputs2.last_hidden_state.mean(dim=1).detach().numpy()[0]

# 計算余弦相似度

similarity = 1 - cosine(embedding1, embedding2)

# 打印相似性分數

print("BERT Similarity:", similarity)在上述示例中,使用BERT模型對兩個文本文檔進行編碼,然后計算它們的余弦相似度。這是一個基本示例,實際應用中,可以根據任務和數據集的需求選擇不同的預訓練模型,并可能需要進行更多的微調。深度學習模型通常在大型文本數據上表現出色,但需要適當的資源和時間用于訓練和調優。