大模型底座之向量化,以及向量化的原理 原創

“ 向量化是一切大模型技術的基礎,大模型中的一切都是向量。”

在之前的文章曾不止一次的講過向量,向量作為大模型的基礎數據格式,其重要性不言而喻;但大部分人對向量還是沒有一個深刻的認識。

所以,今天我們就來討論一個問題,那就是向量化,大模型的入口。

向量化

向量的概念這里就不解釋了,有問題的可以看之前的文章,或者自己去找一下向量,矩陣的內容看看。

先來討論第一個問題,為什么要向量化?

原因在于計算機無法直接處理非數值性計算,所以的計算都需要轉換成數值運算才行;但數值計算的方式有很多,為什么會選擇向量作為載體?

原因就在于向量的幾個基本特性:

- 第一就是向量便于計算機進行處理;

- 第二就是向量能夠表示文本,圖像等之間的語義關系

- 第三就是使用矩陣來表示向量,計算效率更高

什么是向量化?

簡單來說向量化就是把其它格式的數據轉換為向量形式,這里的其它格式包括我們常見的一切格式的數據,文本,圖像,視頻,音頻等等;因此,可以直接把向量化理解為一種數據格式轉換的技術。

在大模型中哪些地方需要進行向量化?

簡單來說,任何需要輸入到大模型的數據都需要向量化;其次,需要記錄語義關系的也都需要向量化,比如RAG,向量數據庫等。

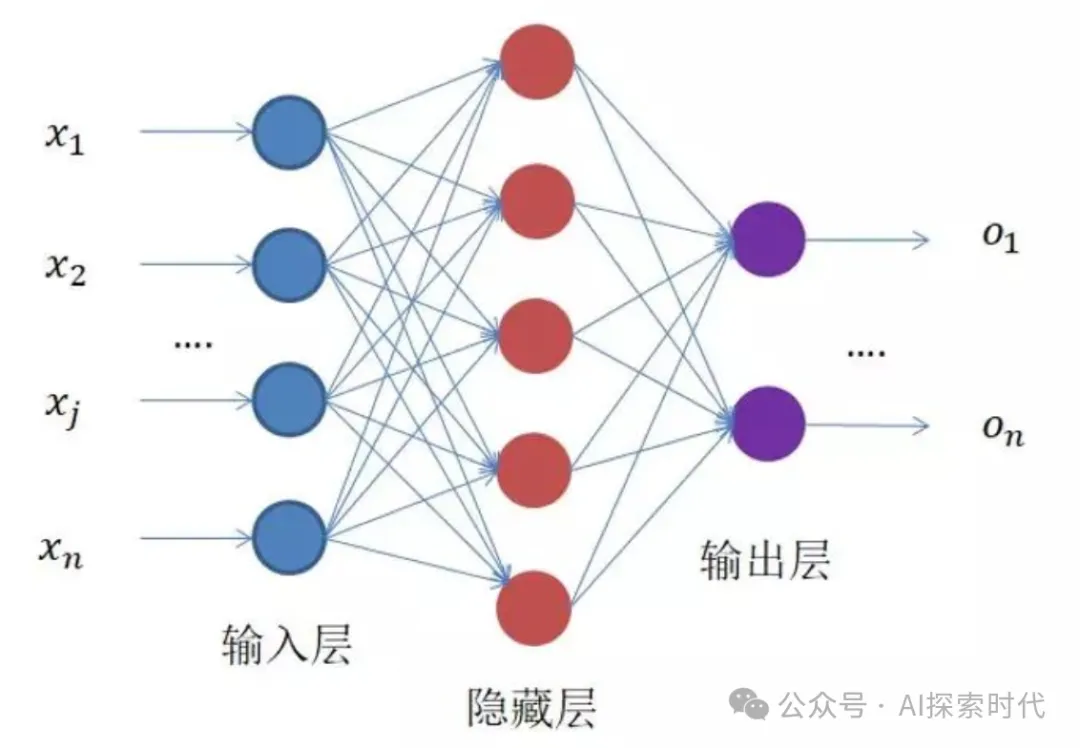

眾所周知,大模型是由一個輸入層,一個隱藏層,一個輸出層組成;而其中隱藏層包括一個或多個神經網絡層。其中,輸入層需要做的一件事就是把輸入數據向量化,只有這樣才能被隱藏層接受和處理。

記住一句話,在大模型中一切都是向量。

那怎么實現向量化?

在不同的技術階段,向量化的方式也有所不同;以文本向量化來說,文本向量化一般有三種方式:

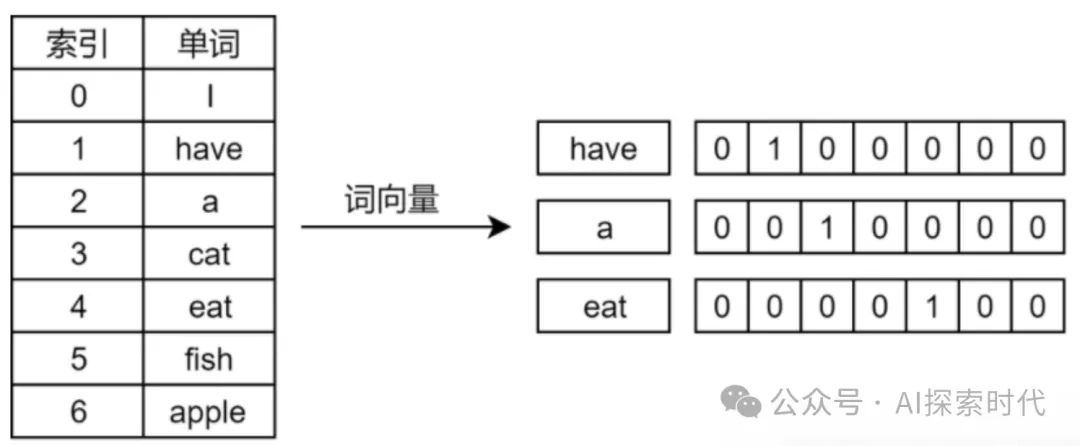

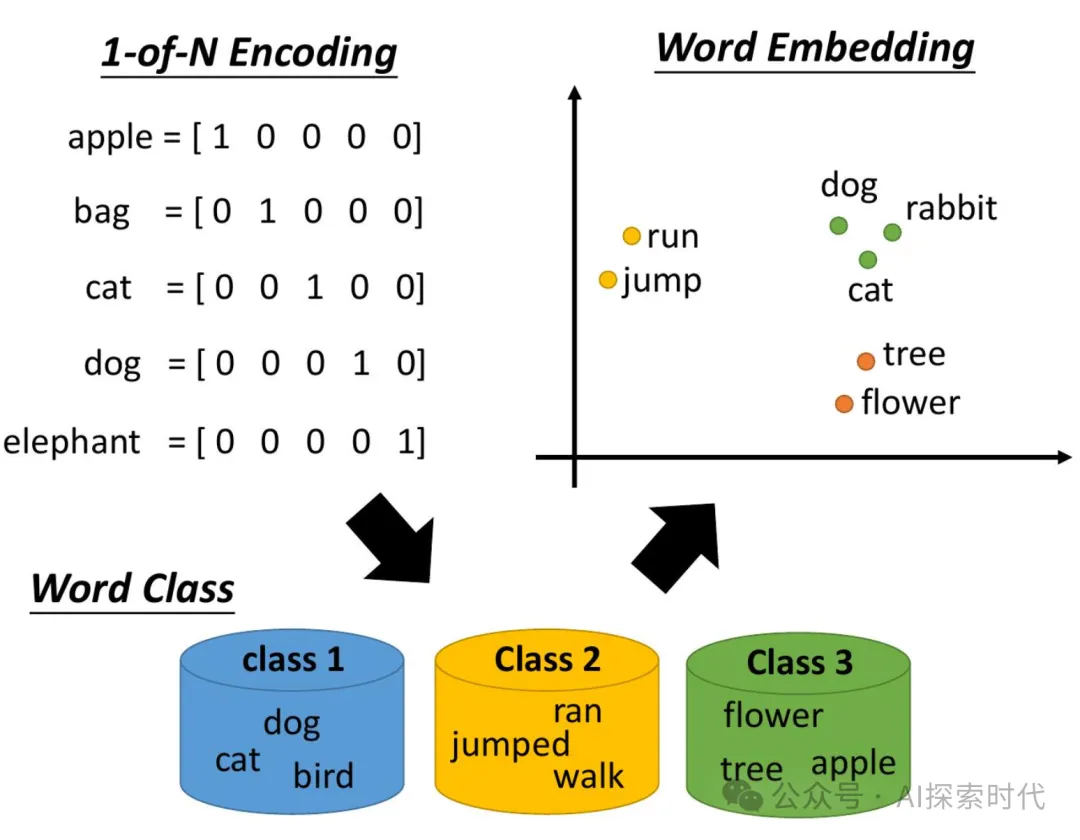

- one-hot編碼

- 詞匯映射(Word2Vec)

- Word Embedding(廣義上Word2Vec也屬于Word Embedding的一種)

詞嵌入是文本向量化的一種常見方式,一般情況下會將一個單詞映射到一個高維向量中來代表這個詞,這就是詞向量。

而文本嵌入層的作用就是,將文本中詞匯的數字表示轉變為高維的向量表示,旨在高維空間捕捉詞匯間的關系。

Embedding 可以說是目前比較常見的一種向量化的方式,各大模型服務商,以及開源社區都發布了大量的Embedding模型來提供給用戶使用;而Embedding嵌入就是一種經過專門訓練的用來向量化數據的神經網絡模型。

只不過Embedding嵌入模型經過矩陣算法的優化,比傳統的向量化方式效率更高,效果更好。

而且,Embedding的應用非常廣泛,其不僅是大模型的基礎技術之一;事實上,Embedding也是大模型技術的應用場景之一。比如在圖像搜索,推薦系統,廣告,搜索等業務中,Embedding都發揮著重要的作用。

了解了文本向量化的工具之后,那么思考一下圖像和視頻是怎么實現向量化的?

在圖像向量化的過程中,卷積神經網絡和自編碼器都是用于圖像向量化的有效工具;前者通過訓練提取圖像特征并轉換為向量;后者則學習圖像的壓縮編碼以生成低維向量表示。

- 卷積神經網絡(CNN):通過訓練卷積神經網絡模型,我們可以從原始圖像數據中提取特征,并將其表示為向量。例如,使用預訓練的模型(如VGG16, ResNet)的特定層作為特征提取器。

- 自編碼器(Autoencoders):這是一種無監督的神經網絡,用于學習輸入數據的有效編碼。在圖像向量化中,自編碼器可以學習從圖像到低維向量的映射

本文轉載自公眾號AI探索時代 作者:DFires