大模型技術(shù)學(xué)習(xí)之——大模型常用架構(gòu)以及技術(shù)難點 原創(chuàng)

“ 不同的架構(gòu),適合不同的任務(wù)”

很多人對人工智能以及大模型都有一定的誤解,那就是弄不明白其中各種專業(yè)名詞,以及關(guān)系。甚至很多人認為大模型就是人工智能,人工智能就是大模型。

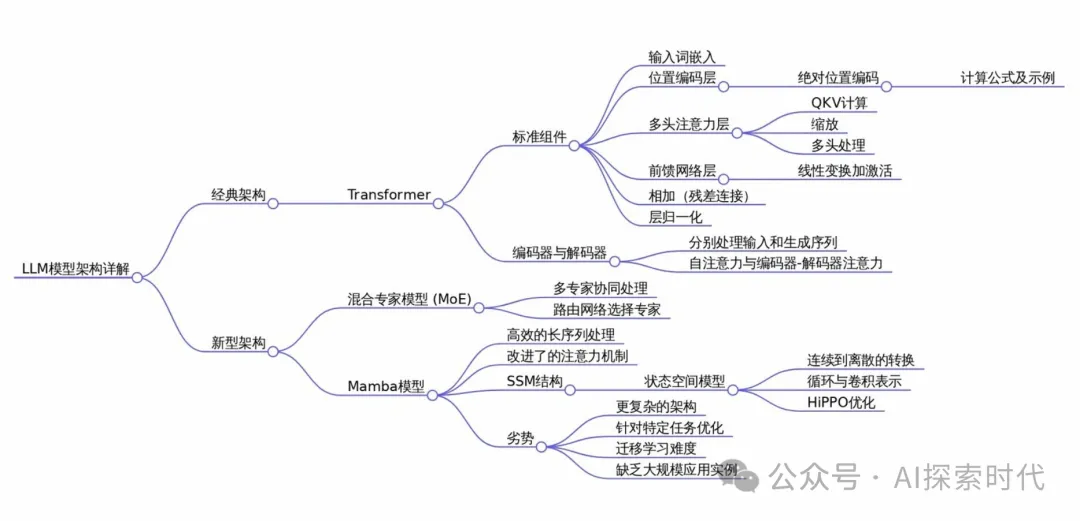

也有人認為只有transformer架構(gòu)的才是大模型,因此,今天就來了解一下模型的架構(gòu)。

大模型的架構(gòu)及優(yōu)缺點

首先,人工智能(AI)有多種實現(xiàn)方式,而機器學(xué)習(xí)是其中的一種;而基于機器學(xué)習(xí)又延伸出了深度學(xué)習(xí),深度學(xué)習(xí)的思想就是分層,通過多個層的疊加實現(xiàn)對數(shù)據(jù)的分級表達。

而神經(jīng)網(wǎng)絡(luò)又是深度學(xué)習(xí)的一種表現(xiàn)形式,是由模仿人腦神經(jīng)元的機制而得名,又由于多層的神經(jīng)網(wǎng)絡(luò)具有龐大的參數(shù),因此叫做大模型(龐大參數(shù)量的機器學(xué)習(xí)(神經(jīng)網(wǎng)絡(luò))模型)。

所以,大模型的核心是層次堆疊;因此,為了實現(xiàn)這種效果就有了多種神經(jīng)網(wǎng)絡(luò)的大模型架構(gòu)。

大模型的常用架構(gòu)主要包括Transformer,BERT,GPT,T5等;每種架構(gòu)都有其獨特的設(shè)計理念和應(yīng)用場景;以下是對這些架構(gòu)的詳細介紹以及它們的優(yōu)缺點分析。

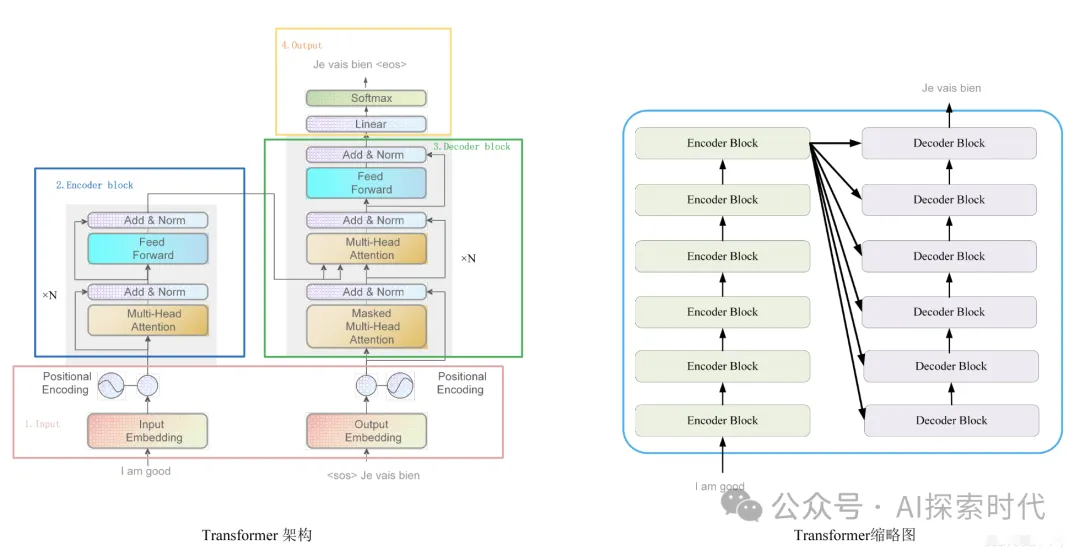

Transformer架構(gòu)

簡介

Transformer是目前大模型的主流架構(gòu),由Vaswani等人于2017年提出。它使用了注意力機制替代了傳統(tǒng)的RNN和LSTM,能夠更好的捕捉長距離依賴關(guān)系。

關(guān)鍵組件

自注意力機制:計算序列中各元素之間的相關(guān)性,生成每個元素的加權(quán)表示。

多頭注意力機制:將注意力機制并行化處理,提高模型的表示能力

位置編碼:由于模型本身不具備順序信息,位置編碼用于為序列添加位置信息

應(yīng)用

Transformer本身用于各種自然語言處理認為,如機器翻譯,文本分類等。

優(yōu)點:模型可以并行處理序列,訓(xùn)練效率高,能夠很好的捕捉長距離依賴。

缺點:在處理長序列時,計算復(fù)雜度高,內(nèi)存占用大

BERT(Bidirectional Encoder Representations from Transformers)

簡介

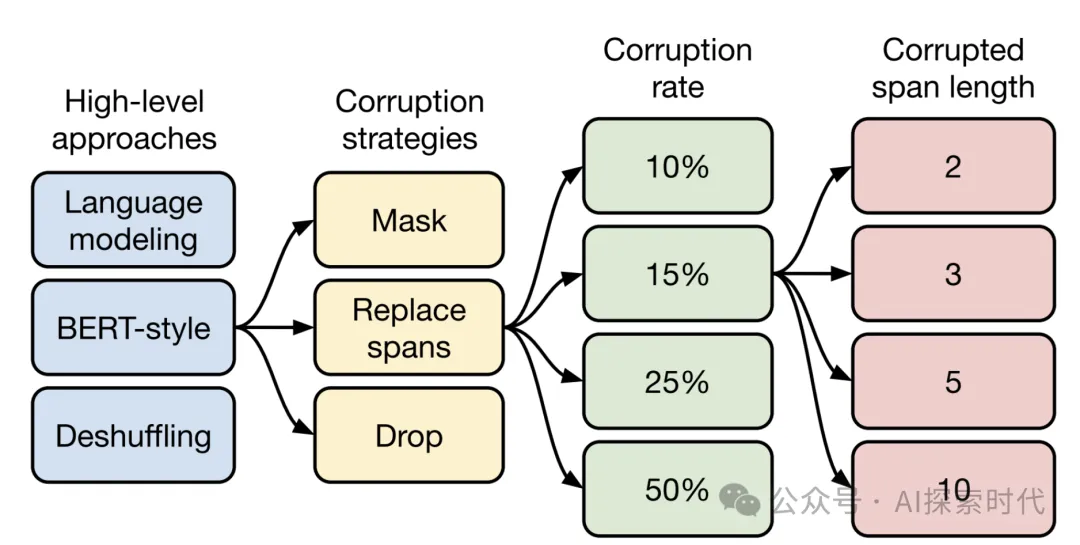

BERT是一種雙向Transformer架構(gòu),擅長處理自然語言理解認為。它通過遮蓋語言模型,和下一句預(yù)測進行訓(xùn)練。

特點

雙向性允許BERT同時考慮左側(cè)和右側(cè)的上下文,增強了理解能力。

應(yīng)用

情感分析,問答系統(tǒng),文本分類,命名體識別等

優(yōu)缺點

優(yōu)點:雙向編碼器能夠更好的理解上下文,尤其適合理解復(fù)雜的語言現(xiàn)象

缺點:生成能力較弱,主要適用于理解認為;模型計算成本較高

GPT(Generative Pretrained Transformer)

簡介

GPT是一種基于Transformer的自回歸模型,專注于文本生成任務(wù),與BERT不同,GPT是單向的,即只使用過去的上下文來預(yù)測當前的單詞。

關(guān)鍵特點

自回歸生成:依次預(yù)測下一個單詞,適合文本生成任務(wù)

Transformer解碼器:采用Transformer架構(gòu)中的解碼器部分

應(yīng)用

對話系統(tǒng),文本生成,文章撰寫,翻譯等

優(yōu)缺點

優(yōu)點:生成文本時能保持一致性和流暢性,適用于多種生成任務(wù)

缺點:由于單向性,在理解復(fù)雜等上下文時效果不如BERT

T5(Text-To-Text Transfer Transformer)

簡介

T5是一種統(tǒng)一的文本到文本的模型架構(gòu),可以將所有任務(wù)都轉(zhuǎn)換為文本生成任務(wù);例如翻譯任務(wù)中的輸入是原文,輸出是譯文;文本分類任務(wù)中的輸入是句子,輸出是類別標簽

關(guān)鍵特點

統(tǒng)一框架:所有任務(wù)都表示為文本轉(zhuǎn)換任務(wù),簡化了模型設(shè)計和訓(xùn)練流程

預(yù)訓(xùn)練目標:使用多任務(wù)預(yù)訓(xùn)練,包括翻譯,摘要生成等

應(yīng)用

翻譯,摘要生成,文本分類,多任務(wù)學(xué)習(xí)等

優(yōu)缺點

優(yōu)點:統(tǒng)一框架便于跨任務(wù)的知識遷移,模型更具有通用性

缺點:對生成任務(wù)過于依賴,可能不適合一些特定的理解任務(wù)

DistilBERT

簡介

DistilBERT是BERT的精簡版,通過蒸餾技術(shù)減小模型規(guī)模,同時保留了大部分性能

關(guān)鍵特點

模型蒸餾:通過從大模型中學(xué)習(xí),精簡模型參數(shù),減少計算需求

應(yīng)用

與BERT類似的任務(wù),但適用于計算資源有限的場景

優(yōu)缺點

優(yōu)點:計算成本低,適合移動設(shè)備或?qū)崟r應(yīng)用

缺點:精度略低于完整的BERT模型

給大家推薦一本書,以下是一本學(xué)習(xí)大模型架構(gòu)的書,里面詳細介紹了大模型的核心架構(gòu)以及實現(xiàn)原理,感興趣的朋友可以點擊購買:

不同架構(gòu)的優(yōu)缺點對比

- BERT vs. GPT:BERT 適合理解任務(wù),如文本分類、問答系統(tǒng);GPT 適合生成任務(wù),如文本生成、對話系統(tǒng)。BERT 的雙向編碼使其在理解上下文時更強,而 GPT 在生成流暢自然的文本時更有優(yōu)勢。

- Transformer vs. RNN/LSTM:Transformer 可以并行處理,提高了訓(xùn)練效率,且更好地捕捉長距離依賴,但在處理超長序列時計算復(fù)雜度較高。RNN/LSTM 則天然適合處理序列數(shù)據(jù),但容易出現(xiàn)梯度消失問題。

- T5 vs. BERT/GPT:T5 的統(tǒng)一框架使其在多任務(wù)學(xué)習(xí)中表現(xiàn)出色,但在專門的理解或生成任務(wù)中,可能不如專門設(shè)計的 BERT 或 GPT。

本文轉(zhuǎn)載自公眾號AI探索時代 作者:DFires

原文鏈接:??https://mp.weixin.qq.com/s/z_00RltivZy0SWNWqSlw2Q??