外國專家解讀DeepSeek:預算有限,如何復制R1推理模型?純強化學習不現(xiàn)實! 原創(chuàng)

出品 | 51CTO技術棧(微信號:blog51cto)

?Sebastian Raschka?是一位外國知名的AI專家。特別在大型語言模型(LLM)研究方面,有著豐富的研究經(jīng)驗。近日DeepSeek-R1推理模型的推出,將“任何一款不是o1的模型快速蒸餾成具備強推理能力的o1”成為了可能,而且所需的成本和算力都大大降低。

但爆火有一個地方不好,就是很容易讓我們迷失在炒作的海洋中,尋找不到有價值的信息。Raschka?非常nice,昨天發(fā)布了一篇有關DeepSeek推理模型的深度總結文章,信息密度極高,內(nèi)容來源包含大量的技術Paper,圖文并茂,非常適合想了解DeepSeek R1背后真相的朋友們。

話不多說,這就為諸君奉上。

本文介紹了構建推理模型的四種主要方法,或者我們?nèi)绾瓮ㄟ^推理能力增強 LLM。我希望這能提供有價值的見解,并幫助您駕馭圍繞該主題的快速發(fā)展的文獻和炒作。

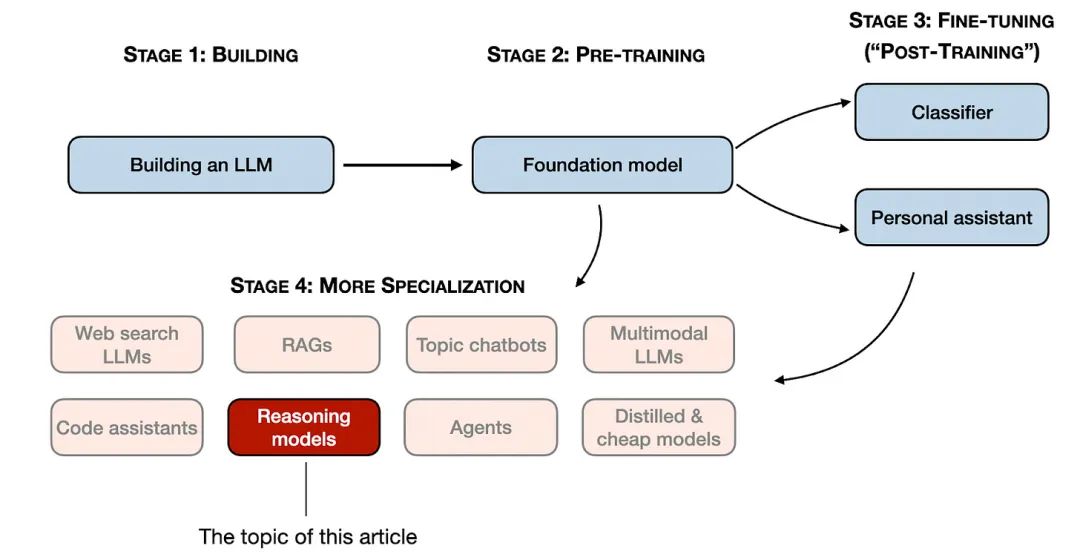

2024 年,LLM領域的專業(yè)化程度不斷提高。除了預訓練和微調之外,我們還見證了從 RAG 到代碼助手等專業(yè)應用程序的興起。我預計這一趨勢將在 2025 年加速,并更加注重特定領域和應用程序的優(yōu)化(即“專業(yè)化”)。

第 1-3 階段是開發(fā) LLM 的常見步驟。 第 4 階段針對特定用例專門開發(fā) LLM。?

第 1-3 階段是開發(fā) LLM 的常見步驟。 第 4 階段針對特定用例專門開發(fā) LLM。?

推理模型的開發(fā)就是這些專業(yè)化之一。這意味著我們改進 LLM,使其擅長處理復雜任務,這些任務最好通過中間步驟來解決,例如謎題、高級數(shù)學和編碼挑戰(zhàn)。然而,這種專業(yè)化并不能取代其他 LLM 應用程序。因為將 LLM 轉換為推理模型也會帶來某些缺點,我將在后面討論。

下面簡要列出本文主要探討的幾塊內(nèi)容。在本文中,我將:

- 解釋“推理模型”的含義

- 討論推理模型的優(yōu)點和缺點

- 概述 DeepSeek R1 背后的方法

- 描述建立和改進推理模型的四種主要方法

- 分享對 DeepSeek V3 和 R1 發(fā)布后 LLM 前景的看法

- 提供在預算緊張的情況下開發(fā)推理模型的技巧

希望這篇文章對你會有用,因為人工智能今年依舊會繼續(xù)快速發(fā)展!

我們?nèi)绾味x“推理模型”?

如果你從事人工智能(或一般機器學習)工作,可能對模糊且備受爭議的定義并不陌生。術語“推理模型”也不例外。最終,有人會在一篇論文中正式定義它,但在下一篇論文中又會重新定義它,依此類推。

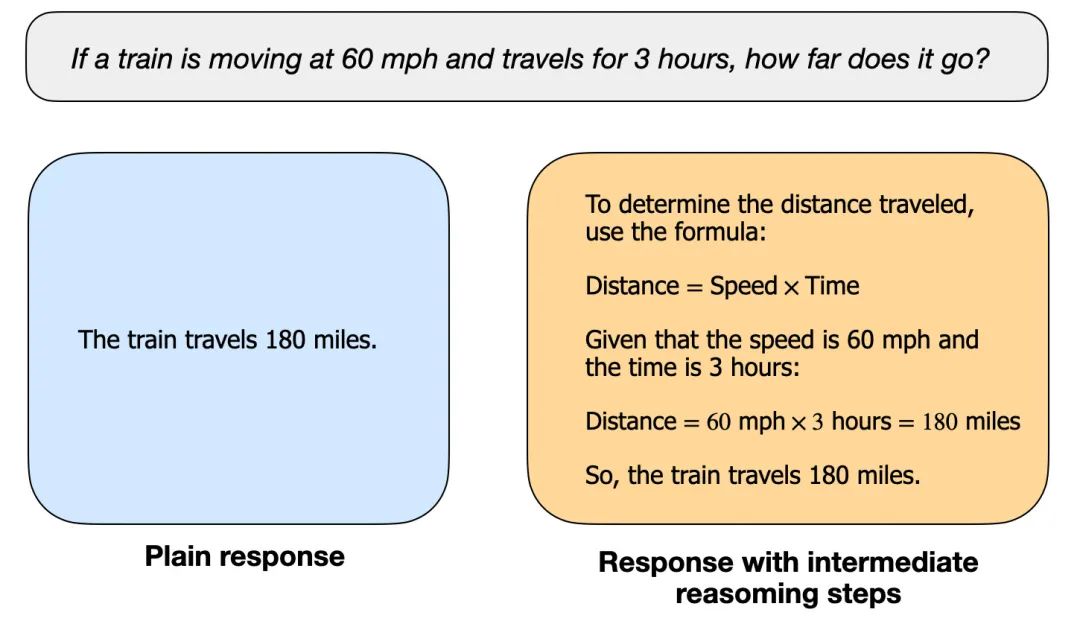

在本文中,我將“推理”定義為回答需要復雜、多步驟生成且包含中間步驟的問題的過程。例如,像“法國首都是哪里?”這樣的事實性問答不需要推理。相比之下,像“如果一列火車以 60 英里/小時的速度行駛 3 個小時,它會行駛多遠?”這樣的問題需要一些簡單的推理。例如,它需要識別距離、速度和時間之間的關系,然后才能得出答案。

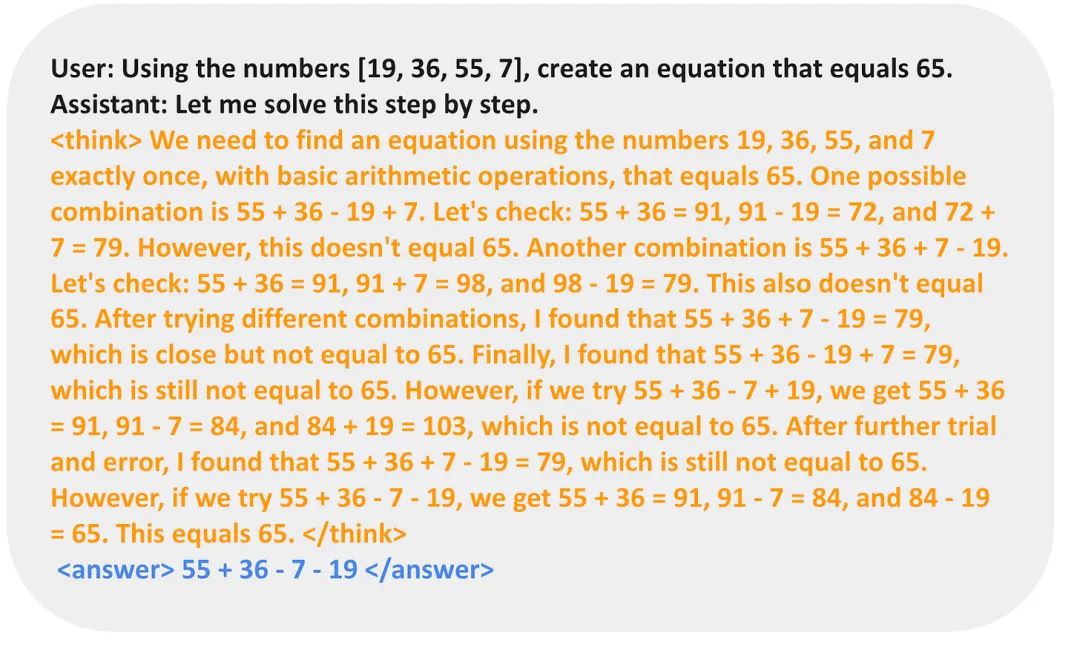

普通的 LLM 可能只提供簡短的答案(如左圖所示),而推理模型通常包括揭示部分思維過程的中間步驟。

(注意,許多未專門為推理任務開發(fā)的 LLM 也可以在其答案中提供中間推理步驟。)

大多數(shù)現(xiàn)代大型語言模型都具備基本的推理能力,能夠回答像“如果一列火車以每小時60英里的速度行駛了3小時,它走了多遠?”這樣的問題。因此,如今當我們提到推理模型時,我們通常指的是那些在更復雜的推理任務(如解謎題、猜謎語和數(shù)學證明)中表現(xiàn)出色的大型語言模型。

此外,如今大多數(shù)被標記為推理模型的大型語言模型在其回應中都包含一個“思考”或“思維”過程。大型語言模型是否以及如何真正“思考”則是另一個討論話題。

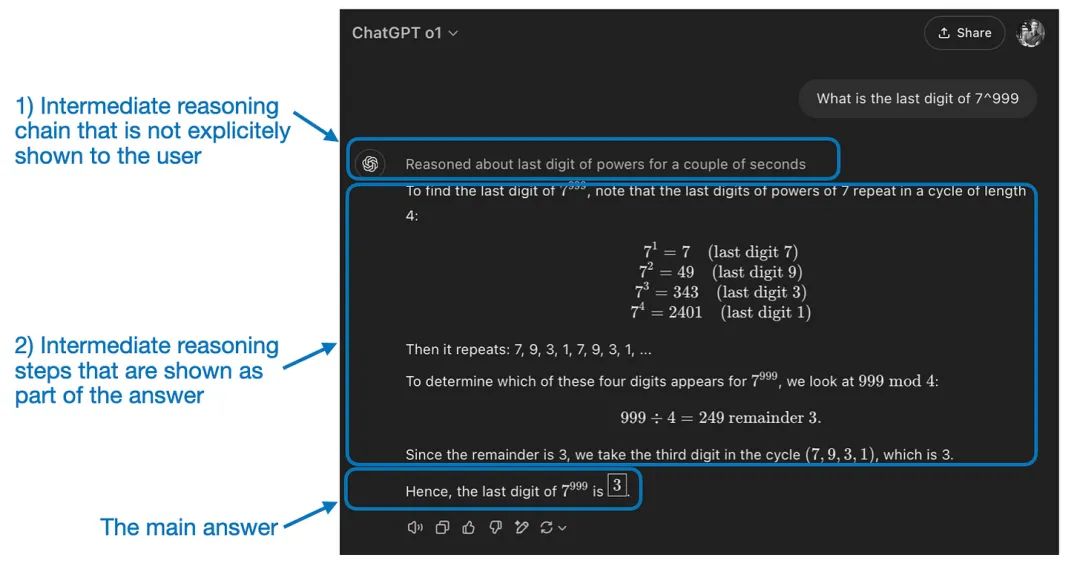

推理模型中的中間步驟可以以兩種方式出現(xiàn)。首先,它們可以明確地包含在回應中,如前圖所示。其次,一些推理型大型語言模型(例如OpenAI的o1)會進行多次迭代,其中的中間步驟不會展示給用戶。

“推理”用于兩個不同的層面:1)處理輸入并通過多個中間步驟生成;2)提供某種推理作為對用戶的響應的一部分。

我們什么時候應該使用推理模型?

現(xiàn)在我們已經(jīng)定義了推理模型,我們可以進入更有趣的部分:如何構建和改進用于推理任務的 LLM。然而,在深入研究技術細節(jié)之前,重要的是要考慮何時真正需要推理模型。

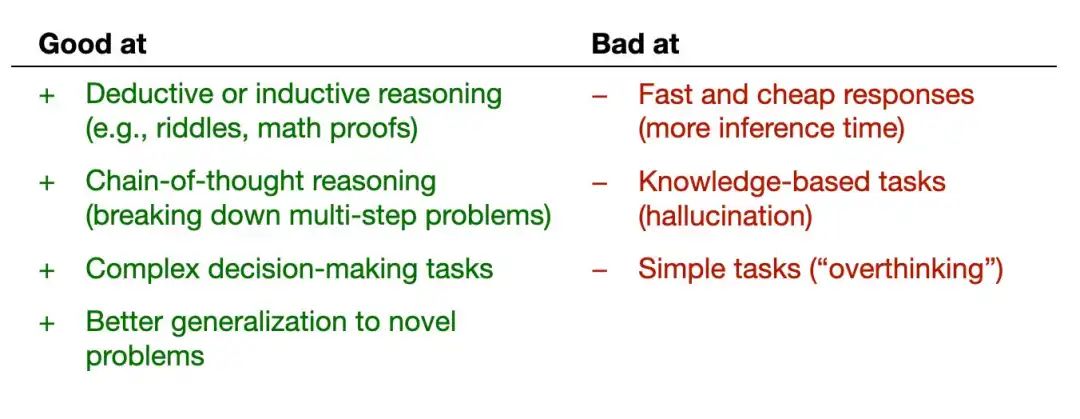

我們什么時候需要推理模型?推理模型旨在擅長解決復雜任務,例如解決難題、高級數(shù)學問題和具有挑戰(zhàn)性的編碼任務。但是,對于總結、翻譯或基于知識的問答等簡單任務,它們并不是必需的。

事實上,將推理模型用于所有事情可能效率低下且成本高昂。例如,推理模型通常使用起來更昂貴、更冗長,有時由于“過度思考”而更容易出錯。這里也適用一條簡單的規(guī)則:使用正確的工具(或 LLM 類型)來完成任務。

下圖總結了推理模型的主要優(yōu)勢和局限性。

推理模型的主要優(yōu)勢和劣勢

推理模型的主要優(yōu)勢和劣勢

簡要介紹一下 DeepSeek 的訓練流程

在下一節(jié)討論構建和改進推理模型的四種主要方法之前,我想簡要概述一下 DeepSeek R1 流程,如DeepSeek R1 技術報告中所述。該報告既是一個有趣的案例研究,也是開發(fā)推理 LLM 的藍圖。

請注意,DeepSeek 并沒有發(fā)布單個 R1 推理模型,而是引入了三種不同的變體:DeepSeek-R1-Zero、DeepSeek-R1 和 DeepSeek-R1-Distill。

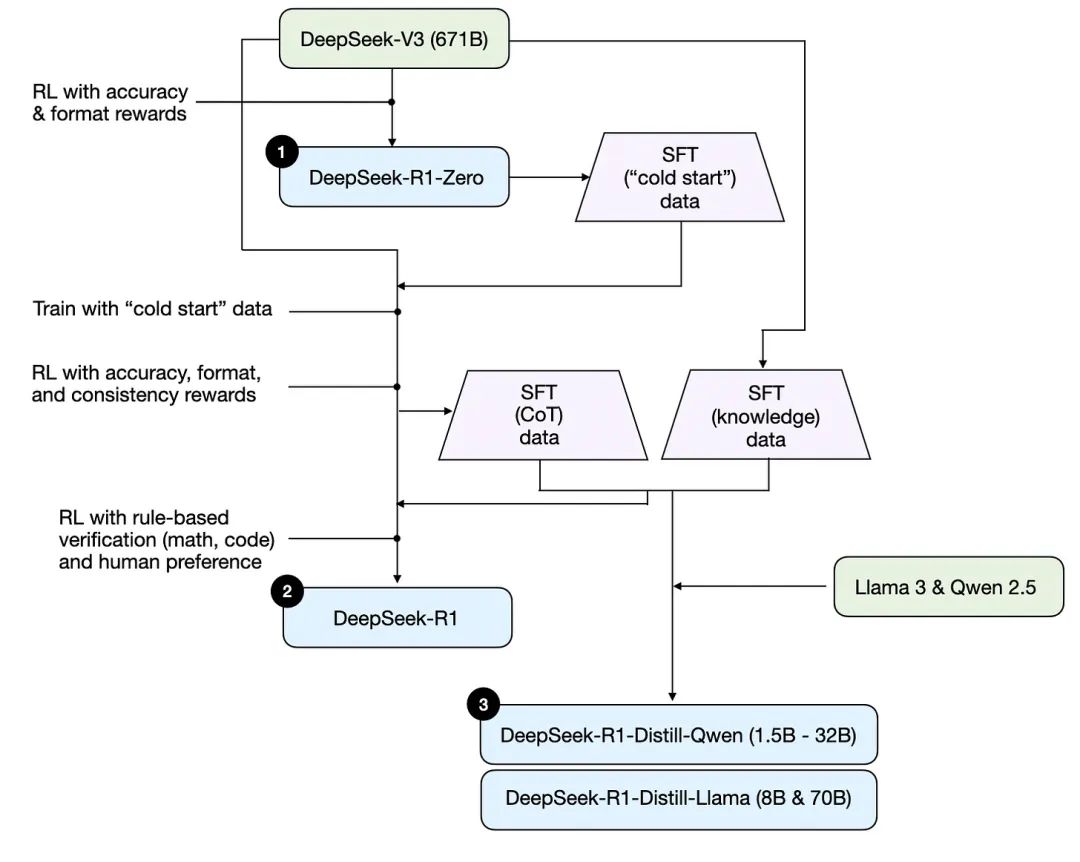

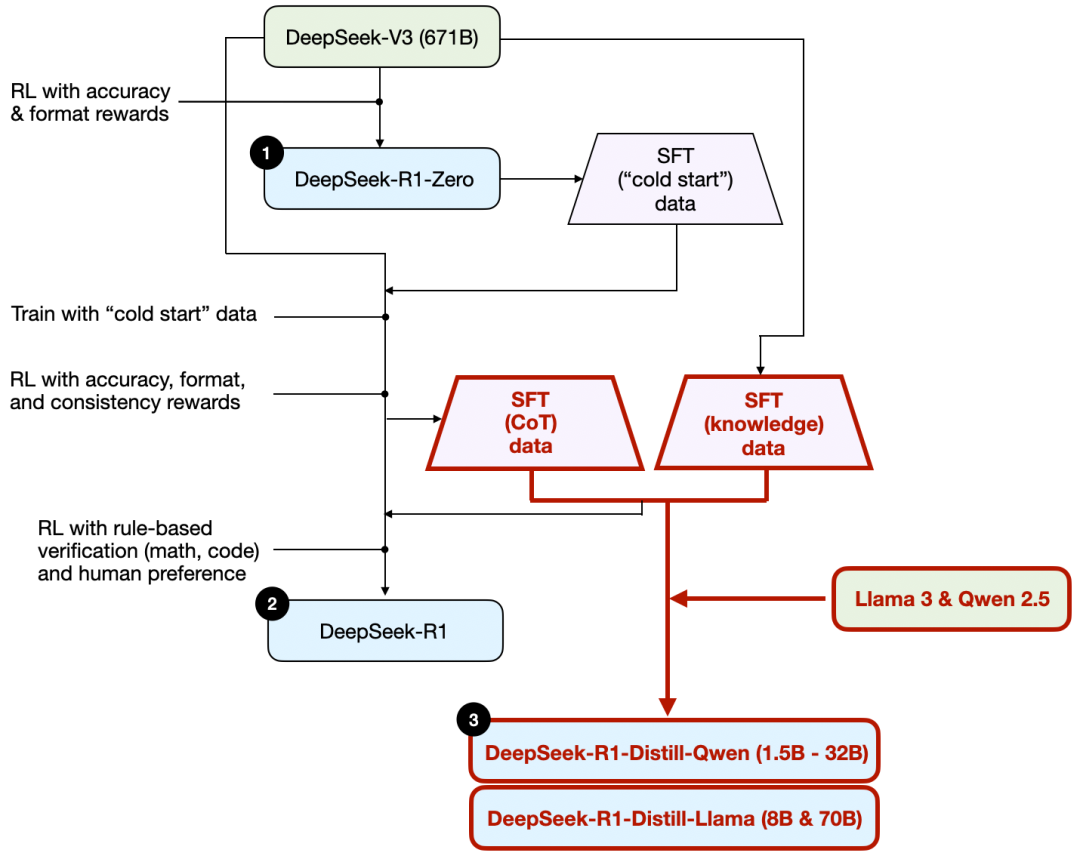

根據(jù)技術報告中的描述,我在下圖中總結了這些模型的發(fā)展過程。

DeepSeek R1 技術報告中討論了 DeepSeeks 的三種不同推理模型的開發(fā)過程。

接下來我們先簡單回顧一下上圖所示的流程,下一節(jié)會詳細介紹構建和改進推理模型的四種主要方法。

(1)DeepSeek-R1-Zero:該模型基于 2024 年 12 月發(fā)布的 671B 預訓練 DeepSeek-V3 基礎模型。研究團隊使用強化學習 (RL) 對其進行訓練,并采用兩種類型的獎勵。這種方法被稱為“冷啟動”訓練,因為它不包括監(jiān)督微調 (SFT) 步驟,而這通常是帶人工反饋的強化學習 (RLHF) 的一部分。

(2)DeepSeek-R1:這是 DeepSeek 的旗艦推理模型,基于 DeepSeek-R1-Zero 構建。團隊通過增加 SFT 階段和進一步的 RL 訓練對其進行了進一步完善,從而改進了“冷啟動”的 R1-Zero 模型。

(3)DeepSeek-R1-Distill*:DeepSeek 團隊利用前面步驟生成的 SFT 數(shù)據(jù)對 Qwen 和 Llama 模型進行微調,以增強其推理能力。雖然這不是傳統(tǒng)意義上的蒸餾,但這個過程涉及在較大的 DeepSeek-R1 671B 模型的輸出上訓練較小的模型(Llama 8B 和 70B,以及 Qwen 1.5B–30B)。

建立和改進推理模型的四種主要方法在本節(jié)中,我將概述當前用于增強 LLM 推理能力和構建專門推理模型(如 DeepSeek-R1、OpenAI 的 o1 和 o3 等)的關鍵技術。

注意:o1 和 o3 的具體工作原理在 OpenAI 之外仍不得而知。不過,據(jù)傳它們將同時利用推理和訓練技術。

1)推理時間擴展

提高 LLM 推理能力(或一般任何能力)的一種方法是推理時間擴展。這個術語可能有多種含義,但在這種情況下,它指的是在推理過程中增加計算資源以提高輸出質量。

粗略地類比一下,當人們有更多時間思考復雜問題時,他們往往會做出更好的反應。同樣,我們可以應用一些技巧,鼓勵LLM在回答問題時更多地“思考”。(不過,LLM是否真的“思考”是另一個話題。)

推理時間擴展的一個直接方法是巧妙的提示工程。一個典型的例子是思路鏈 (CoT) 提示,其中輸入提示中包含“逐步思考”等短語。這鼓勵模型生成中間推理步驟,而不是直接跳到最終答案,這通常(但并非總是)可以在更復雜的問題上產(chǎn)生更準確的結果。(請注意,對于更簡單的基于知識的問題,例如“法國的首都是什么”,采用這種策略是沒有意義的,這又是一個很好的經(jīng)驗法則,可以找出推理模型是否適合你的輸入查詢。)

2022 年大型語言模型中的經(jīng)典 CoT 提示的一個示例是零樣本推理器論文 (https://arxiv.org/abs/2205.1191)

上述 CoT 方法可以看作是推理時間擴展,因為它通過生成更多的輸出標記使推理更加昂貴。

另一種推理時間擴展方法是使用投票和搜索策略。一個簡單的例子是多數(shù)投票,我們讓 LLM 生成多個答案,然后我們通過多數(shù)投票選擇正確的答案。同樣,我們可以使用集束搜索和其他搜索算法來生成更好的響應。

我強烈推薦我在之前的《2024 年值得關注的 AI 研究論文(第二部分)》文章中描述的《擴展 LLM 測試時間計算優(yōu)化比擴展模型參數(shù)更有效》論文,以了解有關這些不同策略的更多詳細信息。

文章鏈接:??https://magazine.sebastianraschka.com/p/ai-research-papers-2024-part-2??

不同的基于搜索的方法依賴于基于過程獎勵的模型來選擇最佳答案。

注釋圖來自 LLM Test-Time Compute 論文,https://arxiv.org/abs/2408.03314

DeepSeek R1 技術報告指出,其模型不使用推理時間縮放。然而,這種技術通常在 LLM 之上的應用層實現(xiàn),因此 DeepSeek 有可能在其應用程序中應用它。

我懷疑 OpenAI 的 o1 和 o3 模型使用了推理時間縮放,這可以解釋為什么它們與 GPT-4o 等模型相比相對昂貴。除了推理時間縮放之外,o1 和 o3 可能使用與 DeepSeek R1 類似的 RL 管道進行訓練。下面兩節(jié)將詳細介紹強化學習。

2)純強化學習(RL)

我個人對DeepSeek R1 論文的亮點之一是他們發(fā)現(xiàn)推理是純強化學習 (RL) 的一種行為。讓我們更詳細地探討一下這意味著什么。

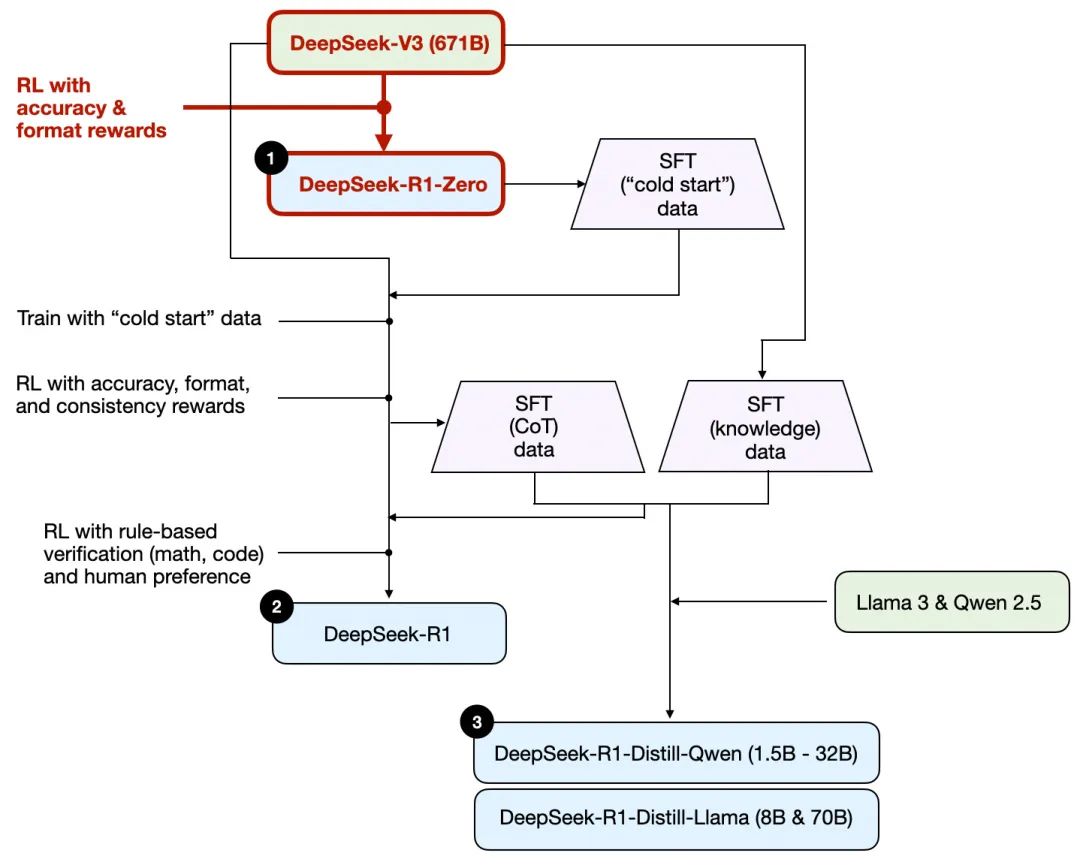

如前所述,DeepSeek 開發(fā)了三種類型的 R1 模型。第一種是DeepSeek-R1-Zero ,它建立在 DeepSeek-V3 基礎模型之上,這是他們于 2024 年 12 月發(fā)布的標準預訓練 LLM。與典型的 RL 流程不同,在 RL 之前應用監(jiān)督微調 (SFT),DeepSeek-R1-Zero僅使用強化學習進行訓練,沒有初始 SFT 階段,如下圖所示。

DeepSeek-R1-Zero模型的開發(fā)過程

DeepSeek-R1-Zero模型的開發(fā)過程

不過,這種 RL 過程類似于常用的 RLHF 方法,后者通常應用于偏好調整 LLM。(我在我的文章《LLM 訓練:RLHF 及其替代方案》中更詳細地介紹了 RLHF 。)

但是,如上所述,DeepSeek-R1-Zero的關鍵區(qū)別在于它們跳過了用于指令調整的監(jiān)督微調 (SFT) 階段。這就是為什么他們將其稱為“純”RL。(盡管 LLM 背景下的 RL 與傳統(tǒng) RL 有很大不同,這是另一個話題。)

對于獎勵,他們沒有使用根據(jù)人類偏好訓練的獎勵模型,而是采用了兩種類型的獎勵:準確性獎勵和格式獎勵。

- 準確性獎勵使用LeetCode 編譯器來驗證編碼答案,并使用確定性系統(tǒng)來評估數(shù)學響應。

- 格式獎勵依賴于 LLM 評委來確保響應遵循預期格式,例如將推理步驟放在 <think> 標簽內(nèi)。

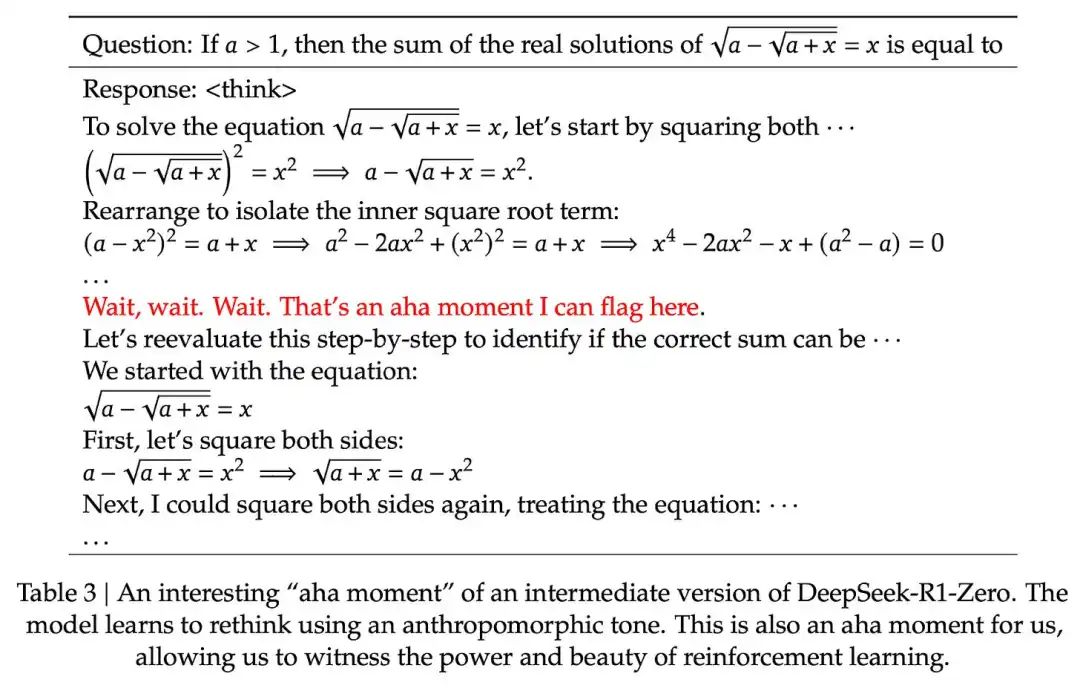

令人驚訝的是,這種方法足以讓 LLM 培養(yǎng)基本的推理能力。研究人員觀察到一個“啊哈!”時刻,盡管模型沒有經(jīng)過明確的訓練,但它開始在其反應中生成推理痕跡,如下圖所示。

DeepSeek R1 技術報告 (https://arxiv.org/abs/2501.12948) 中的一張圖展示了“啊哈”時刻的出現(xiàn)。

雖然 R1-Zero 并不是表現(xiàn)最好的推理模型,但它確實通過生成中間“思考”步驟展示了推理能力,如上圖所示。這證實了使用純 RL 開發(fā)推理模型是可能的,而 DeepSeek 團隊是第一個展示(或至少發(fā)布)這種方法的團隊。

3)監(jiān)督微調和強化學習(SFT + RL)

接下來我們來看看 DeepSeek 的旗艦推理模型 DeepSeek-R1 的開發(fā)歷程,它是構建推理模型的藍圖。該模型在 DeepSeek-R1-Zero 的基礎上進行了改進,加入了額外的監(jiān)督微調 (SFT) 和強化學習 (RL),以提高其推理性能。

請注意,在 RL 之前包含 SFT 階段實際上很常見,如標準 RLHF 管道中所示。OpenAI 的 o1 很可能是使用類似的方法開發(fā)的。

DeepSeek-R1模型的開發(fā)過程

DeepSeek-R1模型的開發(fā)過程

如上圖所示,DeepSeek 團隊使用 DeepSeek-R1-Zero 生成所謂的“冷啟動”SFT 數(shù)據(jù)。術語“冷啟動”指的是這些數(shù)據(jù)是由 DeepSeek-R1-Zero 生成的,而 DeepSeek-R1-Zero 本身并未接受過任何監(jiān)督微調 (SFT) 數(shù)據(jù)的訓練。

使用此冷啟動 SFT 數(shù)據(jù),DeepSeek 隨后通過指令微調訓練模型,然后進行另一個強化學習 (RL) 階段。此 RL 階段保留了 DeepSeek-R1-Zero RL 過程中使用的相同準確度和格式獎勵。但是,他們添加了一致性獎勵以防止語言混合,當模型在響應中在多種語言之間切換時會發(fā)生這種情況。

強化學習階段之后是另一輪 SFT 數(shù)據(jù)收集。在此階段,使用最新的模型檢查點生成 600K 個思路鏈 (CoT) SFT 示例,同時使用 DeepSeek-V3 基礎模型創(chuàng)建另外 200K 個基于知識的 SFT 示例。

然后,這 600K + 200K SFT 樣本被用于另一輪強化學習。在此階段,他們再次使用基于規(guī)則的方法對數(shù)學和編碼問題進行準確率獎勵,而對其他問題類型使用人類偏好標簽。

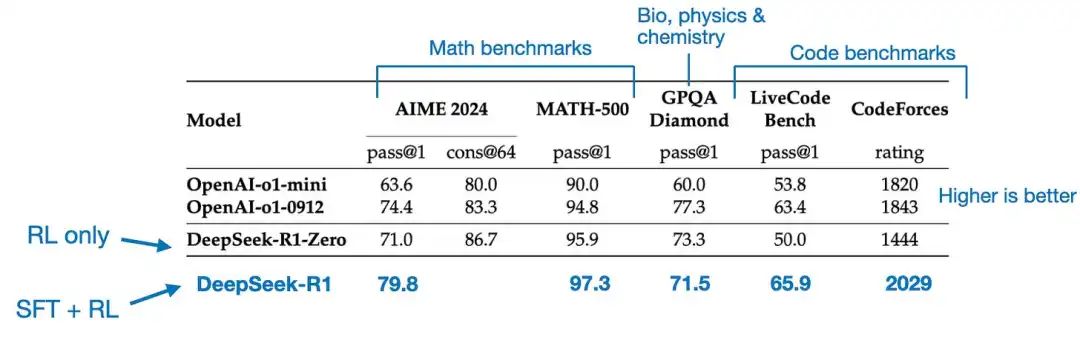

最終模型 DeepSeek-R1 由于增加了 SFT 和 RL 階段,性能較 DeepSeek-R1-Zero 有明顯提升,如下表所示。

OpenAI A1 和 DeepSeek R1 模型的基準比較。注釋圖來自 DeepSeek-R1 技術報告 (https://arxiv.org/abs/2501.12948)。

4)純監(jiān)督微調(SFT)和蒸餾

到目前為止,我們已經(jīng)介紹了構建和改進推理模型的三種主要方法:

1. 推理時間擴展,一種無需訓練或以其他方式修改底層模型即可提高推理能力的技術。

2. 純強化學習 (RL),如 DeepSeek-R1-Zero,它表明推理可以作為一種學習行為出現(xiàn),而無需監(jiān)督微調。

3. 監(jiān)督微調(SFT)加上 RL,這產(chǎn)生了 DeepSeek 的旗艦推理模型 DeepSeek-R1。

那么,還剩下什么呢?模型“蒸餾”。

令人驚訝的是,DeepSeek 還發(fā)布了通過他們稱之為“蒸餾”的過程訓練的較小模型。然而,在大型語言模型的背景下,蒸餾并不一定遵循深度學習中使用的經(jīng)典知識蒸餾方法。傳統(tǒng)上,在知識蒸餾中(如我的《機器學習問答與人工智能》一書第 6 章中簡要描述的那樣),較小的學生模型在較大的教師模型和目標數(shù)據(jù)集的對數(shù)上進行訓練。

相反,這里的蒸餾是指在由較大的 LLM 生成的 SFT 數(shù)據(jù)集上對較小的 LLM(例如 Llama 8B 和 70B 以及 Qwen 2.5 模型(0.5B 到 32B))進行指令微調。具體來說,這些較大的 LLM 是 DeepSeek-V3 和 DeepSeek-R1 的中間檢查點。事實上,用于此蒸餾過程的 SFT 數(shù)據(jù)與用于訓練 DeepSeek-R1 的數(shù)據(jù)集相同,如上一節(jié)所述。

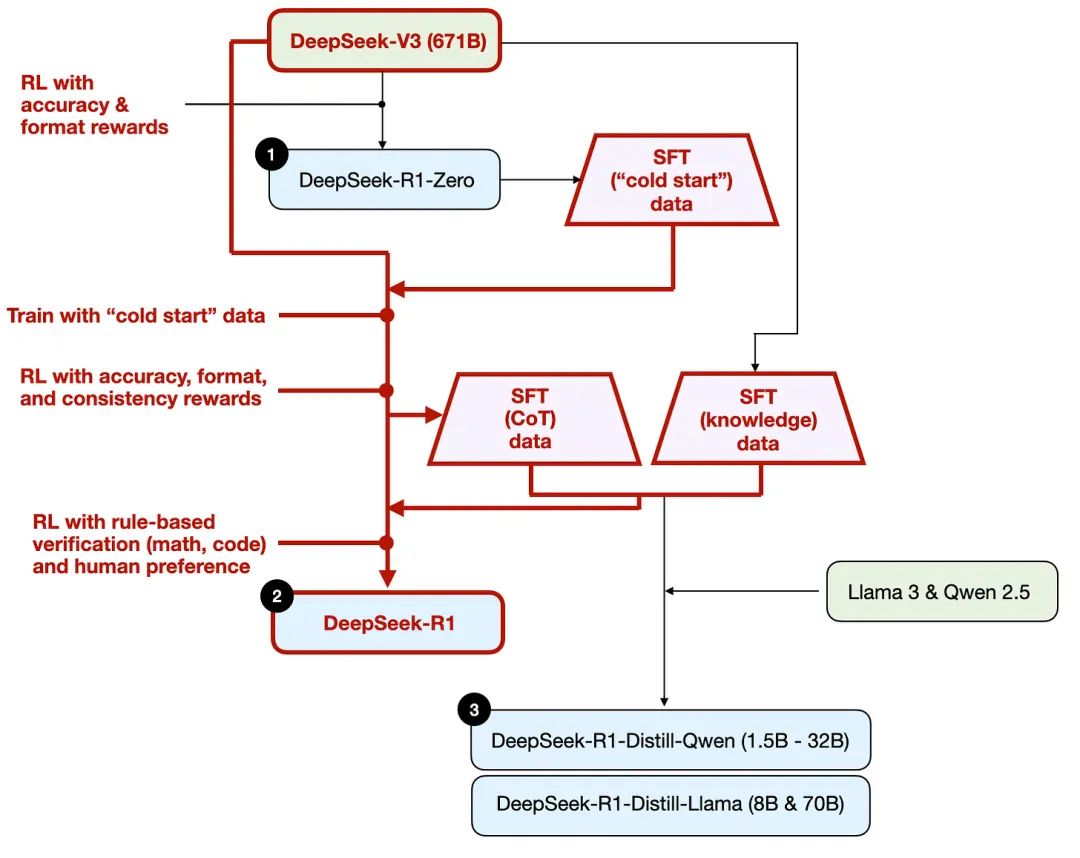

為了闡明這一過程,我在下圖中突出顯示了蒸餾部分。

DeepSeek-R1-Distill模型的開發(fā)過程。

DeepSeek-R1-Distill模型的開發(fā)過程。

他們?yōu)槭裁匆_發(fā)這些蒸餾模型?我認為有兩個主要原因:

1. 較小的模型效率更高。這意味著它們運行起來更便宜,但它們也可以在低端硬件上運行,這對許多像我一樣的研究人員和修補匠來說尤其有趣。

2. 純 SFT 案例研究。這些蒸餾模型可作為有趣的基準,展示純監(jiān)督微調 (SFT) 在沒有強化學習的情況下可以讓模型走多遠。

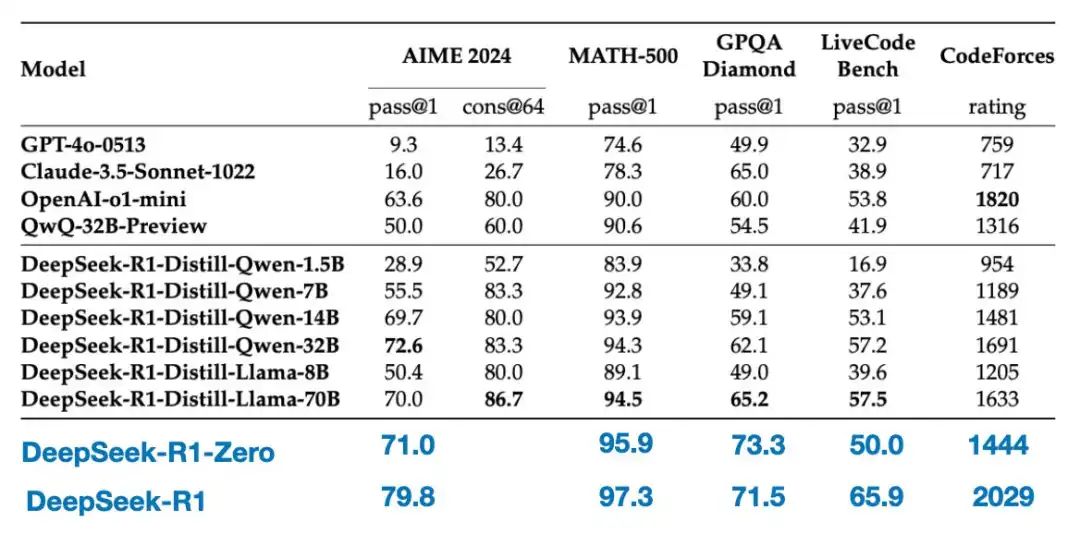

下表比較了這些蒸餾模型與其他流行模型以及 DeepSeek-R1-Zero 和 DeepSeek-R1 的性能。

蒸餾模型與非蒸餾模型的基準比較。

注釋圖來自 DeepSeek-R1 技術報告 (https://arxiv.org/abs/2501.12948)。

我們可以看到,精簡后的模型明顯弱于 DeepSeek-R1,但與 DeepSeek-R1-Zero 相比,它們卻出奇地強大,盡管規(guī)模小了幾個數(shù)量級。值得注意的是,這些模型與 o1 mini 相比表現(xiàn)得非常好(我懷疑 o1-mini 本身可能是 o1 的一個類似的精簡版本)。

在用結論結束本節(jié)之前,還有一個有趣的比較值得一提。DeepSeek 團隊測試了 DeepSeek-R1-Zero 中出現(xiàn)的新興推理行為是否也會出現(xiàn)在較小的模型中。為了研究這一點,他們將 DeepSeek-R1-Zero 中相同的純 RL 方法直接應用于 Qwen-32B。

下表總結了本次實驗的結果,其中 QwQ-32B-Preview 是 Qwen 團隊基于 Qwen 2.5 32B 開發(fā)的參考推理模型(我認為訓練細節(jié)從未披露過)。此比較提供了一些額外的見解,即純 RL 是否可以在比 DeepSeek-R1-Zero 小得多的模型中誘導推理能力。

在較小的 32B 模型上對蒸餾和 RL 進行基準比較。

注釋圖來自 DeepSeek-R1 技術報告 (https://arxiv.org/abs/2501.12948)。

有趣的是,結果表明,對于較小的模型,蒸餾比純強化學習更有效。這與以下觀點一致:單靠強化學習可能不足以在這種規(guī)模的模型中產(chǎn)生強大的推理能力,而使用高質量推理數(shù)據(jù)進行 SFT 在使用小模型時可能是一種更有效的策略。

為了完整性,查看表格中的其他比較將會很有用:

1. Qwen-32B 使用 SFT + RL 進行訓練,類似于 DeepSeek-R1 的開發(fā)方式。這將有助于確定當 RL 與 SFT 結合時,與純 RL 和純 SFT 相比可以取得多大的改進。

2. DeepSeek-V3 使用純 SFT 進行訓練,與創(chuàng)建蒸餾模型的方式類似。這樣可以直接比較,看看 RL + SFT 相對于純 SFT 的效果如何。

結論

在本節(jié)中,我們探討了構建和改進推理模型的四種不同策略:

1. 推理時間擴展不需要額外的訓練,但會增加推理成本,隨著用戶數(shù)量或查詢量的增加,大規(guī)模部署的成本會更高。不過,對于已經(jīng)很強大的模型來說,提高性能仍然是明智之舉。我強烈懷疑 o1 利用了推理時間擴展,這有助于解釋為什么與 DeepSeek-R1 相比,它在每 token 基礎上的成本更高。

2. 純 RL 對于研究目的來說很有趣,因為它提供了對推理作為一種新興行為的洞察。然而,在實際模型開發(fā)中,RL + SFT 是首選方法,因為它可以產(chǎn)生更強大的推理模型。我強烈懷疑 o1 也是使用 RL + SFT 進行訓練的。更準確地說,我相信 o1 從比 DeepSeek-R1 更弱、更小的基礎模型開始,但通過 RL + SFT 和推理時間縮放進行了補償。

3. 如上所述,RL + SFT 是構建高性能推理模型的關鍵方法。DeepSeek-R1 是一個很好的藍圖,展示了如何做到這一點。

4. 蒸餾是一種有吸引力的方法,尤其是用于創(chuàng)建更小、更高效的模型。然而,蒸餾的局限性在于它不會推動創(chuàng)新或產(chǎn)生下一代推理模型。例如,蒸餾總是依賴于現(xiàn)有的、更強大的模型來生成監(jiān)督微調 (SFT) 數(shù)據(jù)。

我預計接下來會看到的一個有趣的方面是將 RL + SFT(方法 3)與推理時間擴展(方法 1)相結合。這很可能是 OpenAI o1 正在做的事情,只不過它可能基于比 DeepSeek-R1 更弱的基礎模型,這解釋了為什么 DeepSeek-R1 表現(xiàn)如此出色,同時在推理時間上保持相對便宜。

關于 DeepSeek R1 的思考

最近幾周,很多人都問我對 DeepSeek-R1 模型的看法。簡而言之,我認為它們是一項了不起的成就。作為一名研究工程師,我特別欣賞這份詳細的技術報告,它提供了我可以從中學習的方法論見解。

最令人著迷的收獲之一是推理是如何從純強化學習中發(fā)展成為一種行為的。令人印象深刻的是,DeepSeek 已根據(jù)寬松的 MIT 開源許可證對其模型進行了開源,該許可證的限制甚至比 Meta 的 Llama 模型還要少。

與 o1 相比如何?

DeepSeek-R1 比 o1 好嗎?我認為兩者大致相同。然而,最突出的是 DeepSeek-R1 在推理時間上更高效。這表明 DeepSeek 可能在訓練過程中投入了更多,而 OpenAI 可能更多地依賴于 o1 的推理時間擴展。

盡管如此,很難直接比較 o1 和 DeepSeek-R1,因為 OpenAI 尚未披露有關 o1 的太多信息。例如,我們不知道:

- o1 也是專家混合體 (MoE) 嗎?

- o1 有多大?

- o1 可能只是 GPT-4o 的稍微改進版本,具有最少的 RL + SFT 和僅廣泛的推理時間擴展嗎?

如果不知道這些細節(jié),直接的比較就只是蘋果和橘子之間的比較。

訓練 DeepSeek-R1 的成本

另一個討論點是開發(fā) DeepSeek-R1 的成本。有人提到訓練成本約為 600 萬美元,但他們可能將 DeepSeek-V3(去年 12 月發(fā)布的基礎模型)和 DeepSeek-R1 混為一談。

600 萬美元的估算是基于每 GPU 小時 2 美元的假設以及 DeepSeek-V3 最終訓練運行所需的 GPU 小時數(shù),該估算最初于 2024 年 12 月進行討論。

然而,DeepSeek 團隊從未透露 R1 的具體 GPU 小時數(shù)或開發(fā)成本,因此任何成本估算都還只是純粹的猜測。

無論如何,最終,DeepSeek-R1 是開放權重推理模型的一個重要里程碑,并且其推理時間的效率使其成為 OpenAI o1 的一個有趣替代品。

在有限的預算下開發(fā)推理模型開發(fā) DeepSeek-R1 級推理模型可能需要數(shù)十萬到數(shù)百萬美元,即使從像 DeepSeek-V3 這樣的開放權重基礎模型開始也是如此。對于預算有限的研究人員或工程師來說,這可能會令人沮喪。

好消息:蒸餾可以發(fā)揮很大作用

幸運的是,模型蒸餾提供了一種更具成本效益的替代方案。DeepSeek 團隊通過他們的 R1 蒸餾模型證明了這一點,盡管比 DeepSeek-R1 小得多,但其推理性能卻出奇地強大。然而,即使是這種方法也并不完全便宜。他們的蒸餾過程使用了 800K SFT 樣本,這需要大量計算。

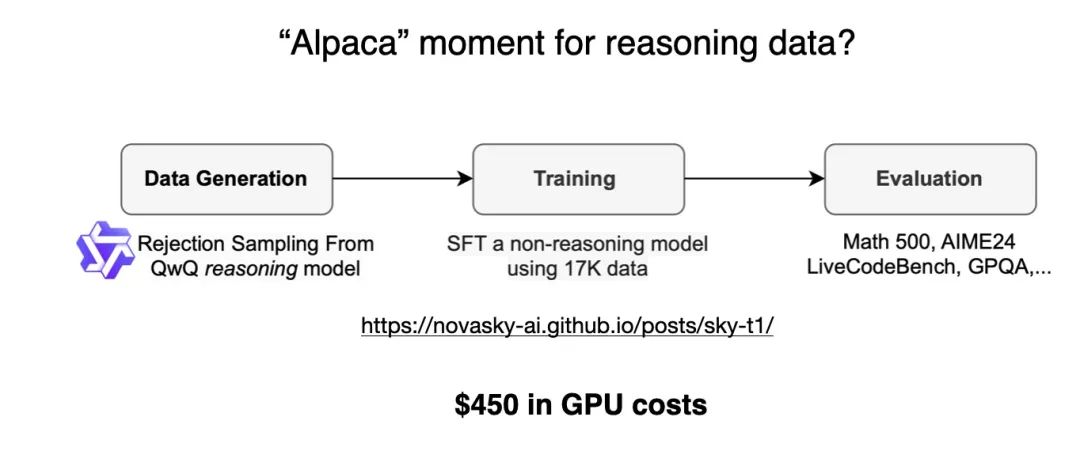

有趣的是,就在 DeepSeek-R1 發(fā)布前幾天,我偶然看到了一篇關于 Sky-T1 的文章,這是一個令人著迷的項目,一個小團隊僅使用 17K SFT 樣本訓練了一個開放權重 32B 模型。總成本是多少?僅需 450 美元,這比大多數(shù) AI 會議的注冊費還低。

這個例子表明,盡管大規(guī)模訓練仍然昂貴,但較小規(guī)模、有針對性的微調工作仍然可以以極低的成本產(chǎn)生令人印象深刻的結果。

圖源:《Sky-T1:450 美元以內(nèi)訓練你自己的 O1 預覽模型》

??https://novasky-ai.github.io/posts/sky-t1/??

根據(jù)他們的基準測試,Sky-T1 的表現(xiàn)與 o1 大致相當,考慮到其低訓練成本,這令人印象深刻。

預算內(nèi)的純 RL:TinyZero

雖然 Sky-T1 專注于模型提煉,但我也在“純 RL”領域發(fā)現(xiàn)了一些有趣的工作。一個值得注意的例子是TinyZero ,這是一個 3B 參數(shù)模型,它復制了 DeepSeek-R1-Zero 方法(附注:訓練成本不到 30 美元)。

令人驚訝的是,即使只有 3B 參數(shù),TinyZero 也表現(xiàn)出一些突發(fā)的自我驗證能力,這支持了推理可以通過純 RL 出現(xiàn)的想法,即使在小模型中也是如此。

TinyZero 存儲庫提到研究報告仍在進行中,我一定會密切關注更多細節(jié)。

TinyZero 存儲庫 (https://github.com/Jiayi-Pan/TinyZero) 中的一張圖片顯示該模型能夠進行自我驗證。(相比之下,看看基礎模型的響應會很有趣。)

上述兩個項目表明,即使預算有限,也可以在推理模型上開展有趣的工作。雖然這兩種方法都復制了 DeepSeek-R1 的方法,一種專注于純 RL(TinyZero),另一種專注于純 SFT(Sky-T1),但探索如何進一步擴展這些想法將非常有趣。

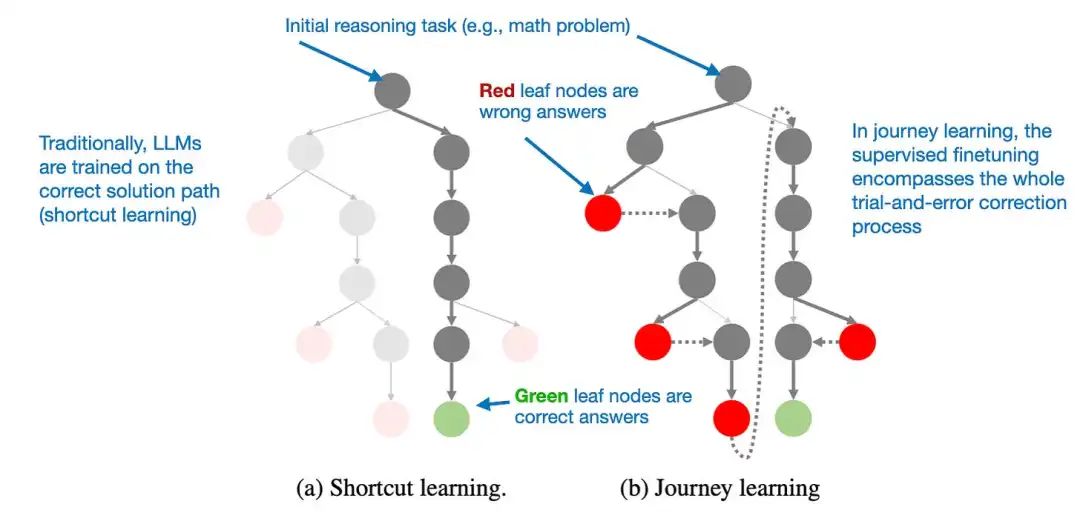

超越傳統(tǒng) SFT:旅程學習

去年我偶然發(fā)現(xiàn)一種特別有趣的方法,論文《O1 復制之旅:戰(zhàn)略進展報告 - 第 1 部分》中對此進行了描述。盡管標題如此,但該論文實際上并沒有復制 o1。相反,它介紹了一種改進蒸餾(純 SFT)過程的另一種方法。

論文的核心思想是用“旅程學習”(Journey Learning)替代“捷徑學習”。

- 捷徑學習是指指令微調的傳統(tǒng)方法,其中僅使用正確的解決方案路徑來訓練模型。

- 另一方面,旅程學習也包括錯誤的解決路徑,讓模型從錯誤中學習。

這種方法與 TinyZero 的純 RL 訓練中觀察到的自我驗證能力有點相似,但它專注于完全通過 SFT 改進模型。通過讓模型接觸錯誤的推理路徑及其修正,旅程學習還可以增強自我修正能力,從而可能通過這種方式使推理模型更加可靠。

與傳統(tǒng)的捷徑學習不同,旅程學習在 SFT 數(shù)據(jù)中包含了錯誤的解決方案路徑。

注釋圖來自《O1 復制之旅:戰(zhàn)略進展報告 - 第 1 部分》(https://arxiv.org/abs/2410.18982)

這可能是未來工作的一個令人興奮的方向,特別是對于低預算推理模型開發(fā),因為基于 RL 的方法在計算上可能不切實際。

無論如何,推理模型方面目前正在發(fā)生很多有趣的工作,我相信我們將在接下來的幾個月里看到更多令人興奮的工作!

參考鏈接:??https://magazine.sebastianraschka.com/p/understanding-reasoning-llms??

本文轉載自??51CTO技術棧??