OpenAI前CTO Ilya推薦的30篇文章,認真讀完將理解當下90%的AI技術(1-11)

近日,網上流傳一份ilya推薦給John Carmack的閱讀清單,該清單包含了當今與AI相關30篇頂級文章,并稱如果真的將它們讀完,就能理解當下90%的AI技術。

下面筆者帶大家速覽這40篇文章內容概要。

1)Attention Is All You Need

不解釋了,transformer開山論文,不得不看。

地址:https://arxiv.org/pdf/1706.03762

2)The Annotated Transformer

該文章是由康奈爾大學副教授 Alexander Rush 等研究者在 2018 年撰寫的博客文章 ,該文章對transformer進行了逐行級的解釋,并利用 Python 完整實現了 Transformer架構,可以幫助讀者在了解理論的同時,結合實踐加深認識。

文章:https://arc.net/folder/D0472A20-9C20-4D3F-B145-D2865C0A9FEE

代碼:??https://github.com/harvardnlp/annotated-transformer/??

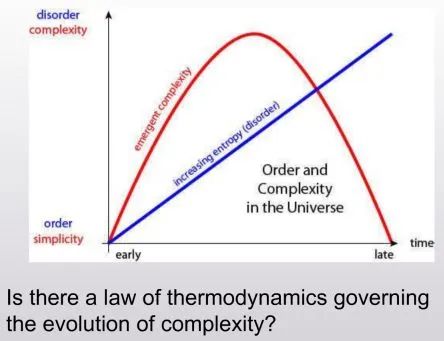

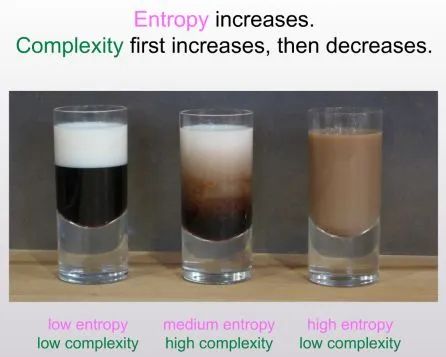

3)The First Law of Complexodynamics

這是Scott Aaronson 的名為《復雜動力學第一定律》的文章,討論了為什么物理系統的“復雜性”或“趣味性”似乎隨著時間的推移而增加,然后達到最大值,再逐漸減少,而熵當然是單調增加的?Aaronson 試圖用 Kolmogorov 復雜性和相關概念來解釋這一現象,并指出了這一領域的若干挑戰和可能的解決方案。

文章:https://scottaaronson.blog/?p=762

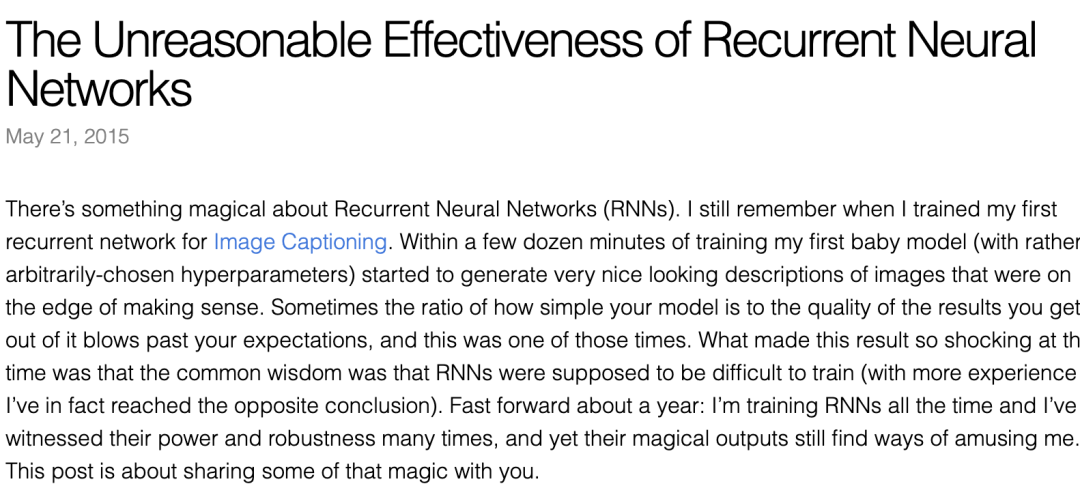

3)The Unreasonable Effectiveness of Recurrent Neural Networks(RNN不可以思議的有效性)

該文章是由Andrej Karpathy 2015 年撰寫的一篇博客,強調 RNN 的有效性,文章探討了 RNN 處理序列數據的強大能力。

地址:https://karpathy.github.io/2015/05/21/rnn-effectiveness/

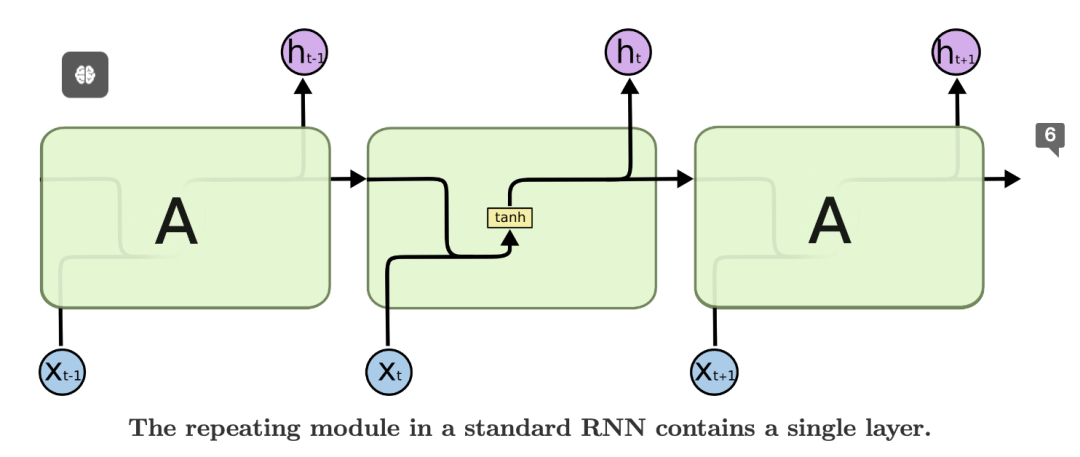

4)Understanding LSTM Networks(理解LSTM)

該文由Anthropic 聯合創始人、Ilya 和 Christopher Olah 于 15 年撰寫,本文介紹了LSTM長短期記憶,它是一種特殊的循環神經網絡,能夠處理長期依賴關系。它在語音識別、語言建模、翻譯、圖像描述等領域取得了巨大成功。

地址:https://colah.github.io/posts/2015-08-Understanding-LSTMs/

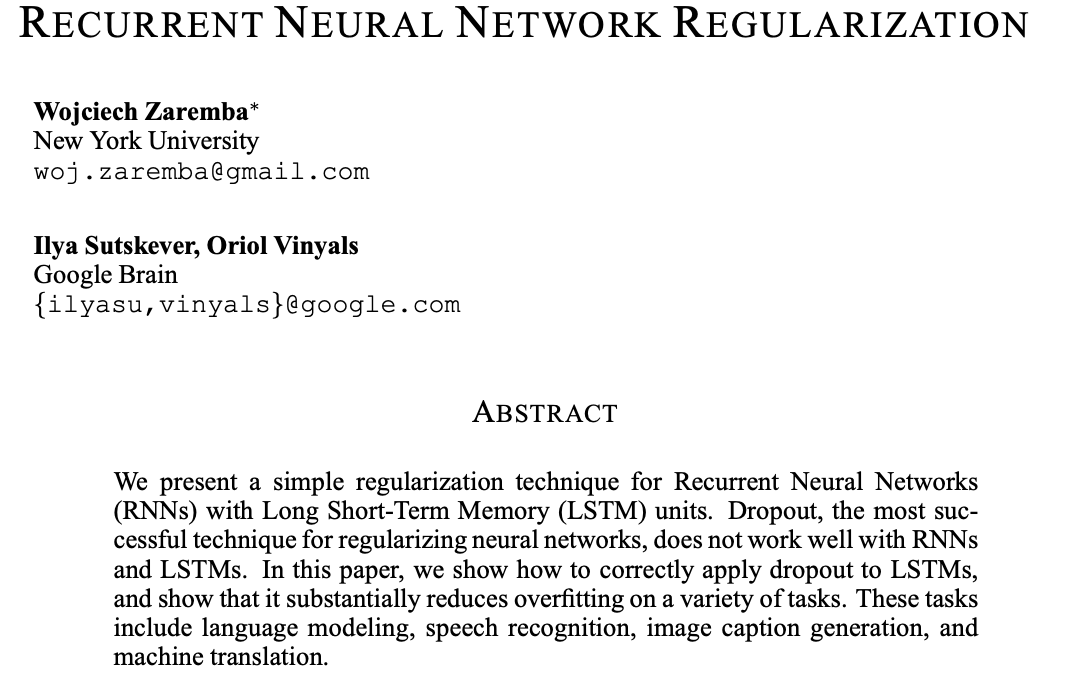

5)RECURRENT NEURAL NETWORK REGULARIZATION(RNN正則化)

本文是由ilya 2015年撰寫的,提出了一種遞歸神經網絡的簡單正則化技術(RNN)與長短期存儲器(LSTM)單元。Dropout是正則化神經網絡最成功的技術,但它不能很好地與RNN配合使用和LSTM。在本文中我們展示了如何正確地將dropout應用于LSTM,并表明它大大減少了對各種任務的過擬合。這些任務包括語言建模、語音識別、圖像字幕生成,以及機器翻譯。

地址:https://arxiv.org/pdf/1409.2329.pdf

6)Keeping Neural Networks Simple by Minimizing the Description Length of the Weights(通過最小化權重的描述長度來保持神經網絡的簡單性)

如果相較于訓練案例的輸出向量,權重包含更少的信息,那么有監督的神經網絡的泛化能力通常會更好。因此,在學習階段,懲罰權重的信息量以保持權重簡潔是關鍵。可以通過加入高斯噪聲來控制權重的信息量,而且學習過程中可以適應性地調節噪聲水平,以達到網絡預期平方誤差與權重信息量之間最佳的平衡。我們提出了一種方法,可以計算包含非線性隱藏層的網絡中,受噪聲影響的權重所包含信息量以及期望平方誤差的導數。只要輸出單元保持線性,就能夠高效準確地計算出這些導數,無需依賴于耗時的蒙特卡洛模擬。追求降低神經網絡權重傳輸所需信息量的理念催生了許多有趣的權重編碼方案。

地址:https://www.cs.toronto.edu/~hinton/absps/colt93.pdf

7)Pointer Networks

論文引入了一種新的神經網絡架構,該架構旨在學習輸出序列的條件概率,其中輸出序列由代表輸入序列位置的離散Token(代幣)組成。現有的方法,如序列到序列轉換 和神經圖靈機,無法輕易解決這類問題,因為輸出序列中每一步的目標類別數依賴于可變的輸入長度。例如,排序可變長度序列和各類組合優化問題都屬于這種問題。我們的模型利用最近提出的神經注意機制解決了可變長度輸出字典的問題。與以前的注意力機制不同,我們的方法不是將注意力用于融合編碼器的隱藏單元到每個解碼步驟的上下文向量中,而是將注意力用作一個指針,選取輸入序列中的元素作為輸出。我們將這種架構稱為指針網絡(Ptr-Net)。通過只使用訓練實例,我們證明了Ptr-Net能夠學習到三個復雜幾何問題-計算平面凸包、Delaunay三角剖分以及平面旅行商問題-的近似解。Ptr-Net不僅改進了帶輸入注意力的序列到序列模型,還實現了輸出字典規模可變性的泛化。我們進一步展示了,這些學習到的模型能夠泛化到超出訓練時的最大長度。我們希望這些任務上的結果能鼓勵對離散問題的神經網絡學習方法進行更深入的研究。

地址:https://arxiv.org/pdf/1506.03134

8)ImageNet Classification with Deep Convolutional Neural Networks

本文圖靈獎得主 Geoffrey Hinton ,ilya等撰寫,提出 AlexNet,顛覆圖像識別領域,開啟了深度學習革命。他們訓練了一種龐大的深度卷積神經網絡來對ImageNet LSVRC-2010競賽的1.2百萬張高清圖像進行分類,這些圖像被分為1000個不同類別。在測試數據集上,實現了37.5%的top-1錯誤率和17.0%的top-5錯誤率,顯著優于之前的最佳水平。該神經網絡擁有60,000,000個參數和650,000個神經元,由五個卷積層組成,部分卷積層后接最大池化層,還包括三個全連接層以及最后的1000維softmax輸出層。為了加快訓練速度,采用了非飽和神經元以及高效的GPU卷積操作實現。此外,為了降低全連接層的過擬合,采用了一種名為“dropout(隨機失活)”的新近開發的正則化技術,這一技術非常有效。在ILSVRC-2012比賽中提交了這個模型的改進型,并以15.3%的top-5測試錯誤率贏得了冠軍,較第二名低了10.9個百分點,這表明了模型的顯著提升。

地址:https://proceedings.neurips.cc/paper_files/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

9)ORDER MATTERS: SEQUENCE TO SEQUENCE FOR SETS

隨著循環神經網絡的興盛,序列在有監督學習中越發重要。現在,許多復雜的任務,如映射觀察序列,都可以通過使用序列到序列轉換(seq2seq)框架來構建,該框架采用鏈式法則高效表示序列的聯合概率。但在某些情況下,可變長度的輸入/輸出并不適合以序列形式表現。比如,對于排序任務,還不清楚如何把一組數字輸入模型;相似地,當任務涉及建模隨機變量的未知聯合概率時,我們也不知道應如何組織輸出。在這篇論文中,我們首先通過多個例子證明了輸入/輸出數據組織順序對學習底層模式的顯著影響。我們接著探討了seq2seq框架的一種擴展,它能夠超越序列處理,按照原理性的方法處理輸入集。另外,我們提出了一種損失函數,它通過在訓練過程中探討不同的數據序列,解決輸出集合結構缺失的問題。我們提供了關于訂單重要性的實證證據,并展示了在語言建模和解析任務的基準測試,以及兩個人造任務——數字排序和估計未知圖模型的聯合概率上對seq2seq框架所做的修改。

地址:https://arxiv.org/pdf/1511.06391

10)GPipe: Easy Scaling with Micro-Batch Pipeline Parallelism

提升深度神經網絡的計算容量已證明是提高多種機器學習任務中模型性能的有效辦法。然而,在很多情況下,增加模型的計算力以超越單個加速設備的內存限制,通常需要開發專門的算法或基礎架構。這些方案往往依賴于特定的硬件架構,且難以應用于其他任務。為了應對這種對于高效且與任務無關的模型并行性需求,文中介紹了GPipe,這是一個實現流水線并行化的庫,它能使任何可以表示為層序列的網絡進行規模化擴展。利用GPipe,通過在不同加速設備上對不同的層子序列進行流水線作業,可以靈活且高效地擴大各種網絡的規模至巨大程度。此外,GPipe采用了一種創新的批處理分流算法,在將模型分配到多個加速設備時,幾乎可實現線性的加速效果。通過在具有不同網絡架構的兩項不同任務上訓練大規模神經網絡來展示GPipe的優勢:一是圖像分類,訓練了一個參數量達到5.57億的AmoebaNet模型,在ImageNet-2012數據集上獲得了84.4%的top-1準確率;二是多語言神經機器翻譯,訓練了一個包含128層Transformer結構、6億參數量,覆蓋超過100種語言的巨型模型,其表現超越了所有雙語模型。

地址:https://arxiv.org/pdf/1811.06965

本文轉載自 ??AI工程化??,作者: ully