GPT-4o熱潮來襲:探索圖生文本的奧秘(多模態大模型系列之一) 原創 精華

我在專欄[大語言模型的技術原理和應用]中介紹了大語言模型(LLM)原理和應用,LLM對語言建模,輸入輸出都是文本,屬于單模態模型。

LLM的出現讓人們看到了AGI的希望,但要實現AGI,就要讓機器像人類一樣實現多種感官協作,所以多模態是AGI必經之路。從今天開始我們將進入多模態領域。openAI剛剛發布的GPT-4o就是一種多模態大模型。

一、初識多模態大模型

1.1多模態大模型定義

所謂“多模態”簡單來講就是模型能夠處理多種數據模態,例如,文本、圖像、視頻、音頻等。

因為視頻是由多幀圖像組成,音頻轉化為頻譜圖后也可以看作是一種特殊的圖像,所以多模態主要關注圖像和文本這兩種數據模態。

*openAI的文生視頻模型Sora,則是將圖像看作是一種特殊的視頻*

所謂“大模型”是相對傳統機器學習模型而言的,傳統機器學習模型使用特定數據完成特定任務,一旦訓練完成很難泛化到其它任務,大模型是在海量數據下進行預訓練使其具備通用能力,然后通過微調完成某一個任務。

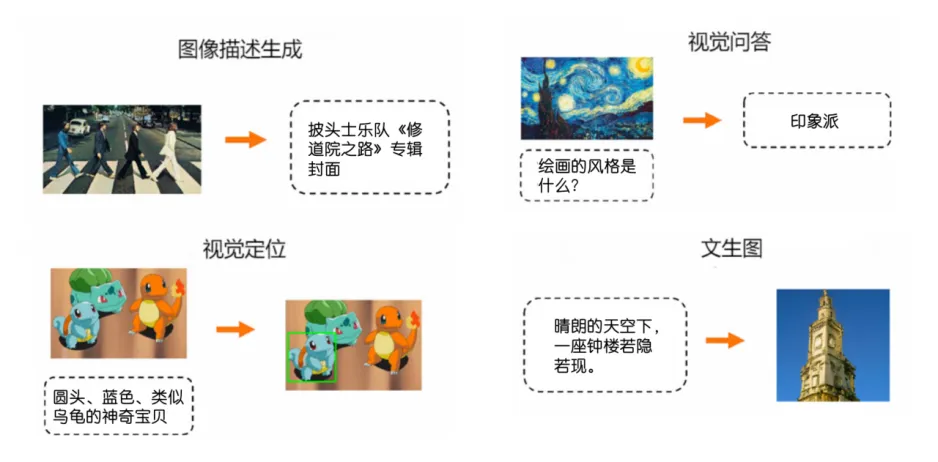

1.2多模態任務類型

了解完多模態大模型的定義,接下來看看多模態大模型到底能干什么。這也是學好多模態以及能夠順利讀完后續內容的重要前提。

多模態任務大體可以分為理解和生成兩大類。

圖文檢索,即給定文本或者圖片,檢索出與之匹配的圖片或文本。本質上就是分類任務,在這個過程中沒有新內容生成,只是基于輸入做出判斷,所以被視為理解型任務,

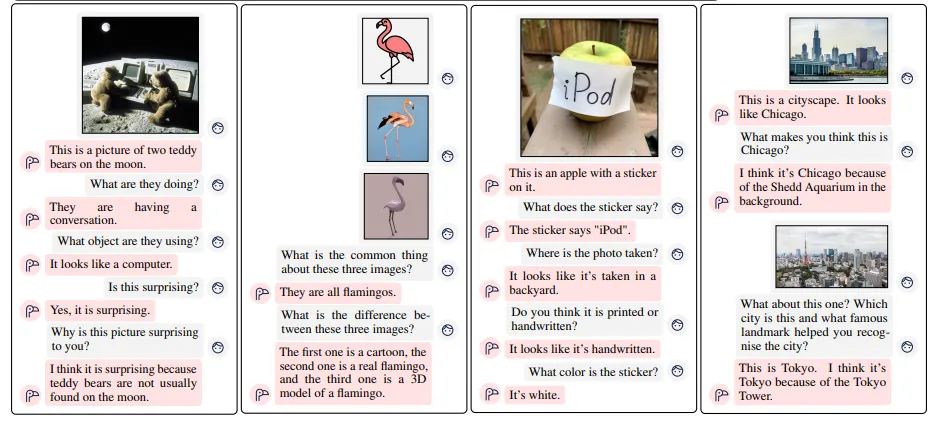

視覺推理、視覺問答都是圖生文任務,與之對應的是文生圖任務,像這種有新內容生成的則被視為生成型任務。

文生圖,例如,Stable Diffusion和DALL-E,輸入一段描述文字,模型輸出一張圖片。

圖生文,例如,視覺問答,輸入一張圖片,再輸入一個問題,模型輸出答案。

除此之外,多模態還有很多應用,文生視頻、Lanuguage Guided Detection、Lanuguage Guided Segmentation等等。

1.3多模態大模型在線體驗

理解這些任務類型的最好方式就是親身體驗一下,這里給大家介紹幾個在線體驗的網址。

GPT-4o:OpenAI,受限免費

https://chatgpt.com/

Gemini 1.5 pro: Google 免費

https://aistudio.google.com/app/prompts/new_chat

騰訊混元大模型:騰訊,免費

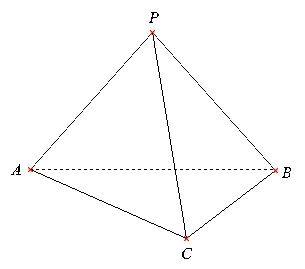

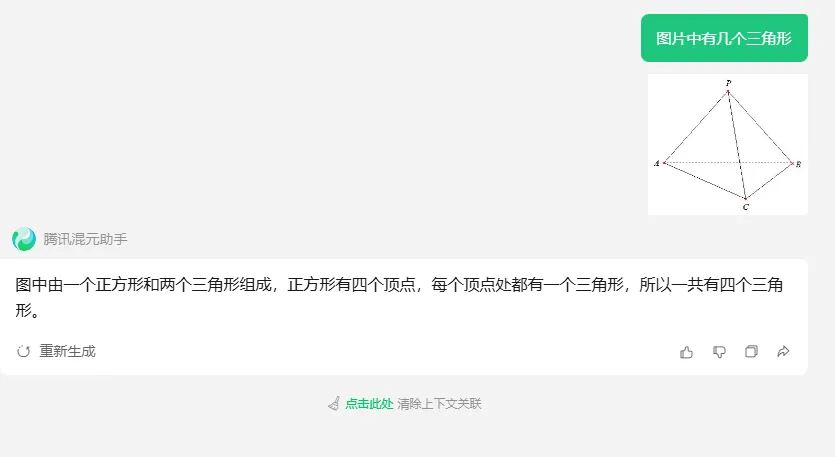

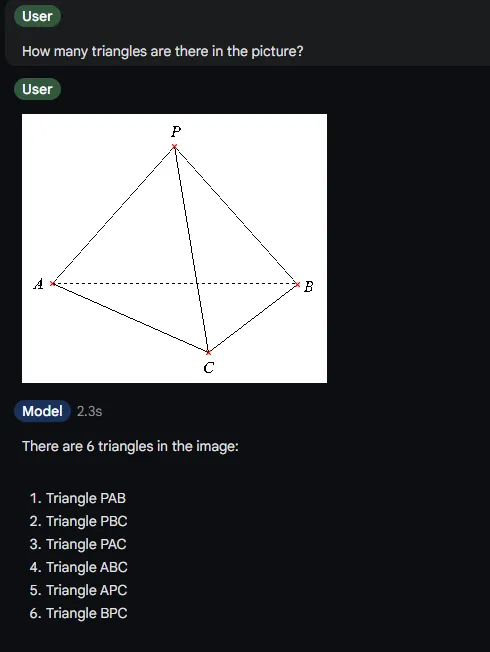

https://hunyuan.tencent.com/bot/chat為了測試到底哪家強?我決定考考它們,讓它們分析下面圖片中的四面體有幾個三角形?還是有點難度的,要識別三角形,就得能識別出這是個多面體,要識別多面體,就得能區分實現和虛線的意義,并且還得排除由于圖像質量引起的鋸齒干擾。

下面分別是它們的回答。

目前看,還是GPT-4o略勝一籌。

二、多模態大模型結構

人腦可以同時處理多種模態輸入,并且各種模態起到相互輔助理解的作用,人類大腦皮層中的不同功能區負責處理不同的信號,在多模態大模型中,處理不同的數據模態,也需要不同的模型架構。

*題外話:馬斯克的腦機接口就是將極細的電極一端插入到控制行為的大腦皮層中,將收集到的信號傳送給機械設備替代人類完成動作,或者跳過壞死的脊柱,將電極另一端連接到完好的脊柱上進行信號傳遞*

如果有圖片輸入,則需要有能理解圖像的組件,我們稱之為圖像編碼器;如果有文本輸入,則需要有能理解文本的組件,我們稱之為文本編碼器;如果有圖片輸出,則需要有能生成圖像的組件,我們稱之為圖像解碼器;如果有文本輸出,則需要有能生成文本的組件,我們稱之為文本解碼器。

*對于解碼器,有的地方也會叫生成器*

以視覺問答為例,它是一種圖生文任務,輸入是圖像,還會輸入一個問題,輸出是文本。

2.1圖像編碼器

圖像編碼器負責提取視覺表征,也就是理解圖像上有什么。無論是CV中的圖像分類、目標檢測、圖像分割,表征提取都是必要步驟,甚至可以說深度學習其實就是表征學習。

*題外話:如果你去相親,回來后父母問你對方怎么樣?你說濃眉大眼櫻桃口,這就是一種外貌表征,就算只有一面之緣,過了很久再次碰到你也能瞬間認出,這是視覺提取表征后與記憶匹配了。*

能夠提取圖像特征的,首先想到的肯定是卷積神經網絡CNN,圖像經過卷積層后輸出特征圖,在淺層網絡(靠近輸入端)會提取一些具體的特征,例如邊緣、角點或簡單的紋理,隨著層數的加深,特征會變得抽象。如物體的整體形狀和結構。

在NLP中,當Transformer處理一個單詞時,它會計算這個單詞與其它所有詞的注意力分數,而CNN只會考慮卷積核范圍內的像素,即使特征圖的感受野會隨著層數增加越來越大,但CNN仍是局部注意力,而Transformer則是全局注意力,全局注意力能更好的提取圖像特征。

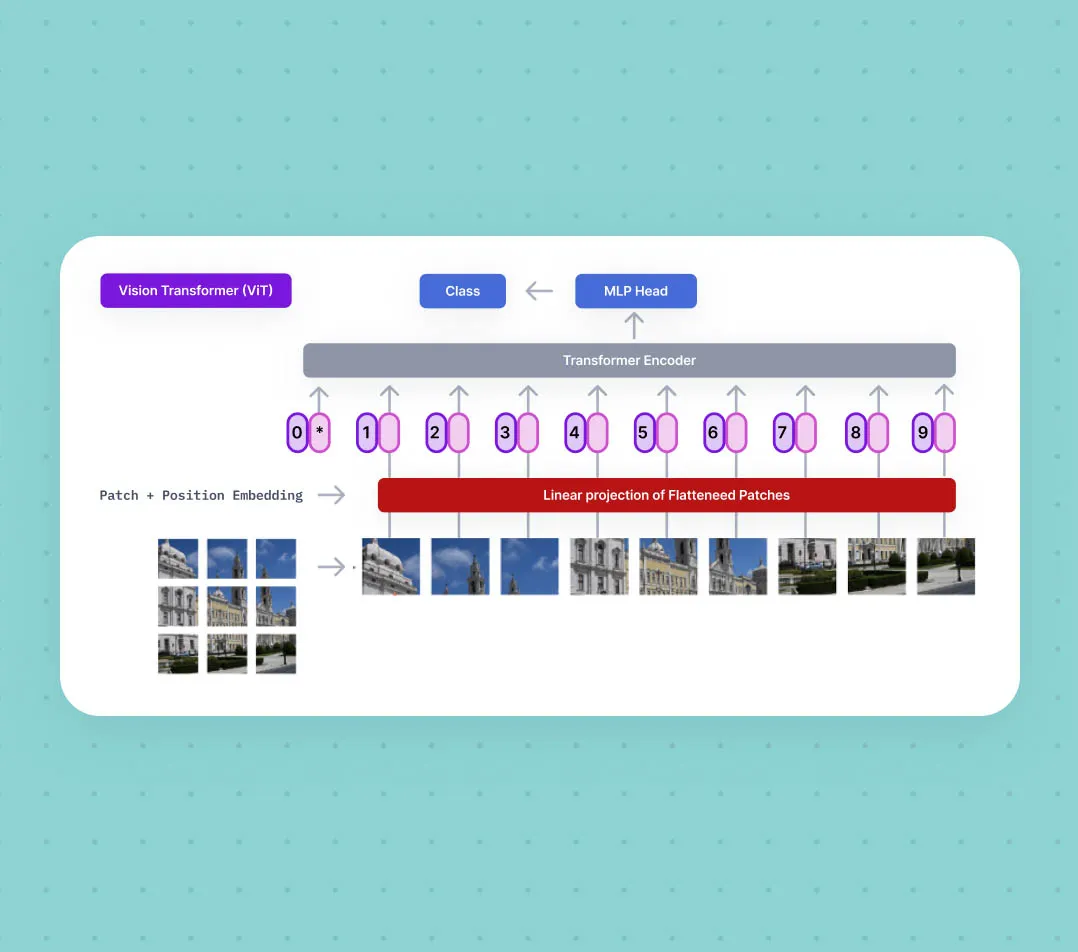

隨著Transformer在NLP中取得成功,有人將這種架構遷移到了CV領域,就有了ViT(Vision Transformer)。

ViT

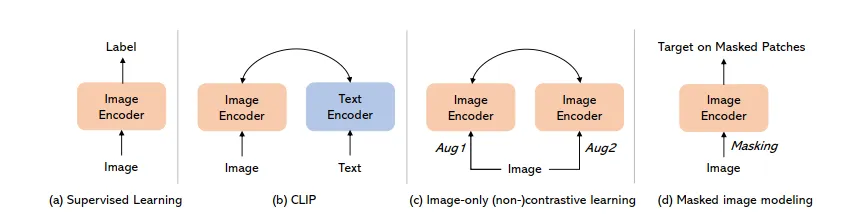

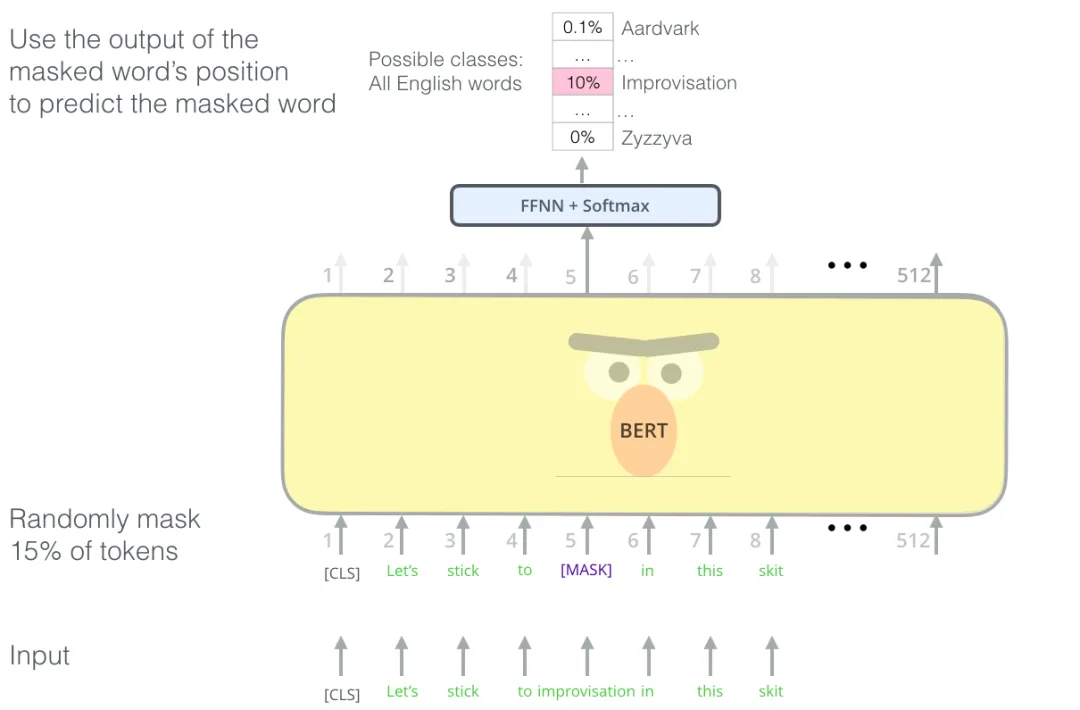

除了模型架構,成為大模型的另一個因素是能在大規模語料上預訓練,有人將NLP中的預訓練方法照搬到了CV中,在NLP中,BERT在預訓練時會將句子中的單詞進行隨機掩碼,通過反向傳播調整模型參數,讓模型去準確預測出掩碼的token,ViT則是將圖像劃分為patches,再對patches進行隨機掩碼,然后讓模型去預測缺失部分,這個過程是自監督的。

但是在ViT之前,CV中使用的是另一種更常用的預訓練方法,就是先在ImageNet這種大規模數據上預訓練,讓模型學習到一些提取基本特征的能力,然后在專用數據上進行微調。

總結一下,圖像編碼器通常采用ViT架構,并且采用掩碼的方式預訓練。

2.2文本編碼器

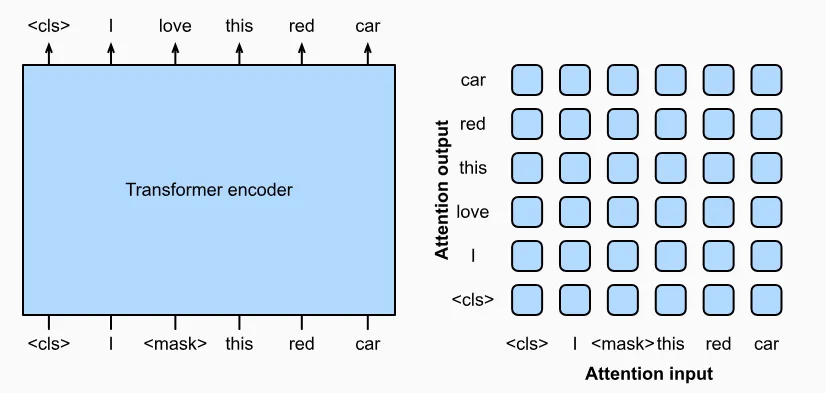

對于VQA任務,還會輸入一個問題,所以還需要文本編碼器對文本進行表征提取,文本編碼器通常采用Tranformer Encoder架構,因為Encoder在處理每個token時會考慮所有詞,所以擅長理解任務。

對文本編碼到底是什么意思?這個我在動畫講解Tranformer一,動畫講解Tranformer二中講的很清楚了。

舉個例子,“一個棕色的臘腸狗”,在進入Transformer編碼器前,先轉換成Tokens,假設基于詞的Tokenlization,{“一個”,“棕色的”,“臘腸狗”},然后轉換成詞嵌入,假設詞嵌入維度為2,假設采用word2vec進行初始化{(0.1,0.2),(0.3,0.4),(0.5,0.6)},經過多頭注意力和MLP后輸出{(0.1,0.2),(0.3,0.4),(0.48,0.56)},“臘腸狗”的詞嵌入被修改了,新的詞嵌入具有了棕色臘腸的含義了。這里我們假設詞嵌入一個維度編碼了狗的品種,第二個維度則編碼了顏色。而最初那個詞嵌入,也就是在這個二維空間中(0.5,0.6)這個點則表示狗。

這里我們僅使用了2維的詞嵌入,GPT3的詞嵌入維度是12288,12288維度空間能表達很豐富的語義信息,人類很難想象高維度空間,因為借助計算機也只能顯示三維空間,對于這個例子,在12288維空間中,別說是“棕色的臘腸狗”就算是“脾氣暴躁棕色的臘腸狗”,““脾氣暴躁棕色皮毛藍色眼睛的臘腸狗””等等,即使添加多個修飾詞也都能在這個高維空間中找到對應的點。

*將Token轉換成詞嵌入,通常LLM會有一個嵌入層,也就是一個矩陣,我叫它詞嵌入轉換表,矩陣的高度是訓練數據中所有唯一詞的個數,矩陣的寬度是詞嵌入維度,根據token id去查找這個表就能獲取詞嵌入向量了,這個表中的值在訓練開始時是隨機初始化的,并在訓練過程中進行更新*

2.3文本解碼器

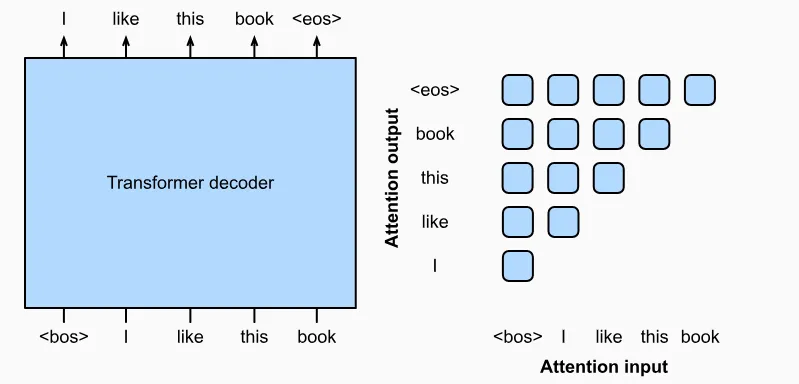

VQA任務的輸出也是文本,這個任務由文本解碼器來完成,文本解碼器通常采用Tranformer Decoder架構,因為這種自回歸模型擅長文本生成,一個典型的例子就是GPT。

對于預測下一個詞,一開始是用統計學的方法實現的,如果訓練數據中出現“臘腸狗”的次數比較多,那么,當出現“臘腸”時,模型很可能就會預測下一個詞是“狗”,這個例子是通過前面兩個詞預測下一個詞,也可以通過前面一個詞預測下一個詞,這個被稱為多元文法,當然也可以通過前后兩個詞預測中間詞,當給出“臘”和“狗”時,很容易預測中間詞是“腸”,你發現沒,BERT和GPT的預訓練方法跟這個很像啊!。

2.4多模態融合

多模態融合的目的是,讓圖像編碼器對一幅狗的圖像的編碼輸出和文本編碼器對“一只狗”的編碼輸出不僅維度相同,而且在向量空間中越接近越好。否則你干你的,我干我的,就沒辦法將多模態融合在一起。

當獲得了這只臘腸狗的圖像編碼后,讓它分別與“一只臘腸狗”,“一只加菲貓”等的文本編碼進行相似度計算,就能夠實現圖像分類和檢索的任務。

如果將圖像編碼作為文本解碼器交叉注意力模塊的K,V,“what is in the picture?”作為文本解碼器交叉注意力模塊的Q,就實現了一個視覺問答任務。

而如果圖像編碼與“一只棕色臘腸狗在草坪上玩耍”更接近,這就實現了更深層次融合,這對于視覺問答和推理這種生成任務更友好。

2.5圖像解碼器

VAE,GAN,Stable Diffusion將在下一篇文章介紹。

多模態大模型的發展過程中,圖像編碼器,文本編碼器,文本解碼器比較穩定,基本上就是ViT和Transformer,主要變化的是多模態融合模塊,下面就來看一下多模態發展史。

三、多模態發展史

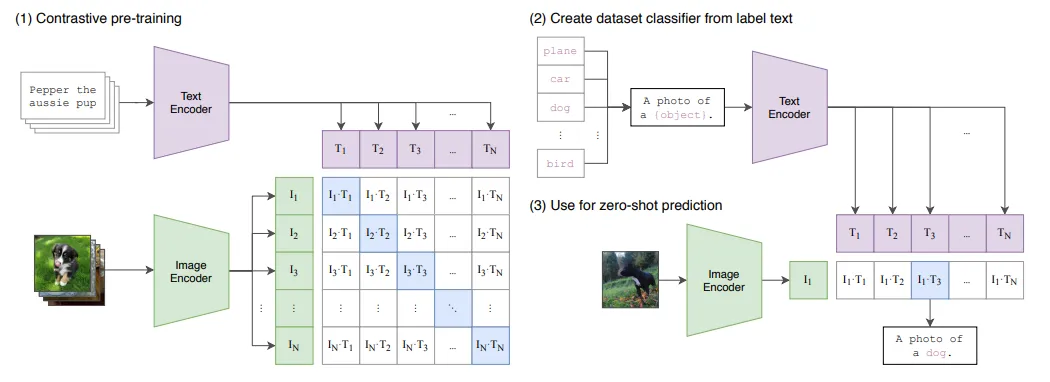

CLIP:Learning Transferable Visual Models From Natural Language Supervision(2021)

??https://arxiv.org/pdf/2103.00020??

我們都知道,機器學習分為監督學習、無監督學習、強化學習。而在多模態領域,更確切地說在多模態的開山之作CLIP中又提出了一個叫做對比學習的概念,對比學習是一種自監督學習方法,也是一種特殊的無監督學習方法。

對比學習最重要的是要構造正負樣本對。

拿ImageNet為例,每一張圖像和它的標簽就是一個正樣本對,和其它標簽就是負樣本,一幅狗的圖像和“a dog”就是正樣本,從不同角度拍攝的狗的圖像和“a dog”也是正樣本,但和“a cat”就是負樣本。

在訓練過程中,CLIP通過對比學習不僅將圖像和文本編碼統一到一個向量空間中,而且通過對比損失函數調整模型參數,讓正樣本的距離拉進,同時負樣本的距離疏遠。

距離的衡量是通過計算向量的余弦夾角也就是向量的點乘。

那如何獲取整個句子或者整個圖片的編碼呢?我們都知道編碼器輸出每個單詞的詞嵌入,答案是CLS token,它編碼了整個句子,或者更直接的將所有詞的向量加權平均。

圖像編碼器:ResNet或者ViT

文本編碼器:Tranformer

對比學習充當了多模態融合的作用。

經過預訓練后的CLIP可以直接用于zero shot分類任務,將閉集模型擴展到開集模型,將標簽替換成語言。例如,ImageNet分類。給一張圖像,先用圖像編碼器提取特征,然后構造文本a photo of{class},并用文本編碼器編碼,計算余弦相似度,找到相似度最大的類別。

CLIP還有一個好處是可以提前計算好圖像和文本的編碼并存儲起來,當來一個新的圖像和文本時,可以直接拿出來用,并不需要重新計算。

所以,CLIP對于圖文檢索任務特別友好。

但道有所能,則必有所不能,通過簡單的向量點乘實現多模態融合對檢索任務非常友好,但對于生成任務就有點力不從心了。

從此進入了融合能力提升時代,也就是需要一個更復雜的多模態融合模塊。

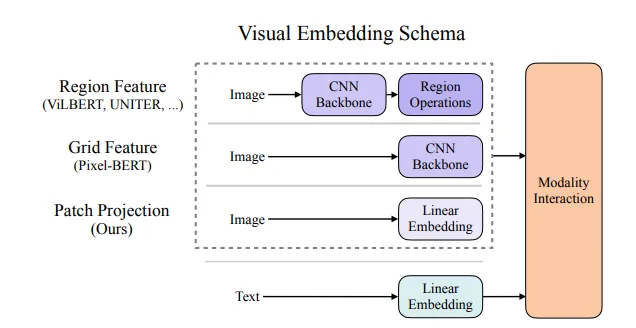

ViLT:Vision-and-Language Transformer Without Convolution or Region Supervision(2021)

??https://arxiv.org/pdf/2102.03334??

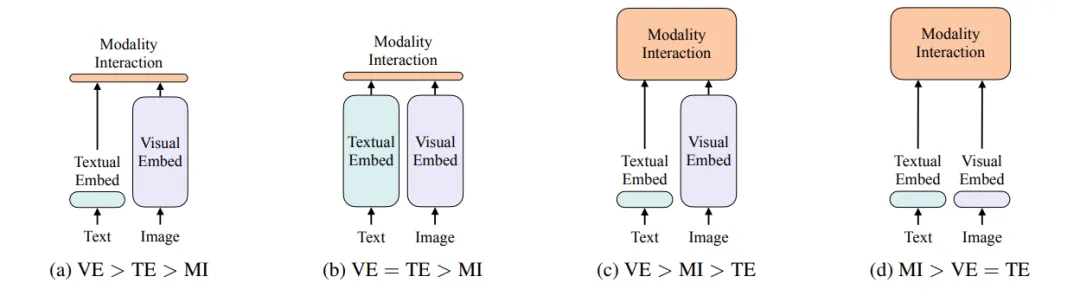

ViLT首先在模型結構上做了改進,在ViT出現之前,圖像編碼器用的是CNN,具體來說是一個目標檢測模型或者直接使用像ResNet這樣的骨干網絡提取特征,無論對于訓練還是推理效率都很低。所以ViLT文本編碼器和圖像編碼器使用簡單的線性映射層。

ViLT另一大貢獻是改進了CLIP的缺點,也就是強化了多模態融合模塊,來增強多模態融合能力。所以,ViLT使用Transformer Encoder作為融合模塊。

正是由于ViLT模型圖像編碼器過于簡單,使其跟復雜的視覺文本編碼器的模型比,效果不理想。而且實驗證明,其訓練過程中模型收斂的也很慢。

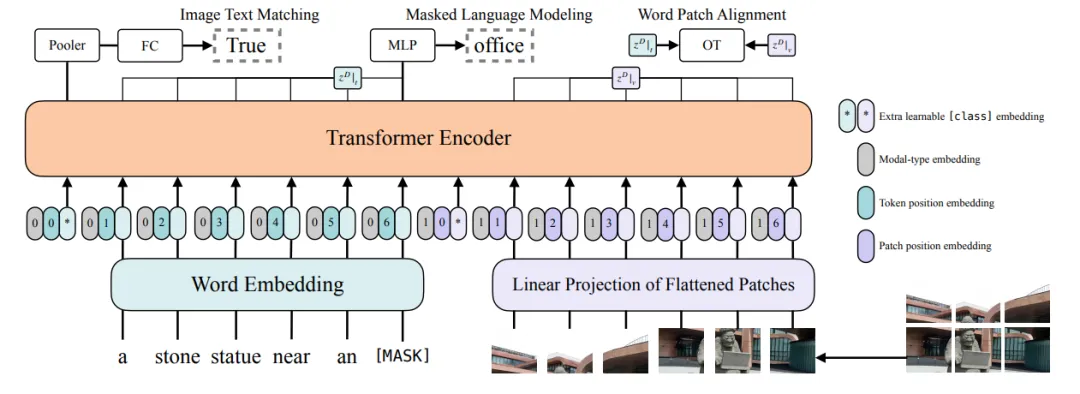

在損失函數上,ViLT沒有使用CLIP中的ITC(Image-Text Contrast)損失函數,而是使用了ITM(Image Text Matching)損失函數和MLM(Masked Language Modeling)損失函數,還有一個Word Patch Alignment損失函數。

MLM損失函數:

對于一個Transformer Encoder模型,例如Bert,在預訓練過程中會通過對序列中的token進行掩碼方式進行預訓練,讓模型預測缺失的被掩碼token,這個損失函數也是評估模型的這個能力的。

ITM損失函數:

如上圖,BERT編碼器有個CLS Token,這個損失函數用于判斷圖文匹配程度。通過最小化這個損失函數來達到融合的目的。

雖然ViLT沒有達到預期,但在ViLT這篇論文中,對多模態模型也進行了經驗性總結,也為后續模型發展定下了基調。也就是在模型結構上視覺編碼器要比文本編碼器大,而且模態融合也要強,不能只是簡單的使用向量余弦夾角。

對于損失函數,ITC,ITM和MLM這三個也被認定是最有效的。

為什么視覺編碼器要比文本編碼器大?

文字是人造的,圖像是自然的,每個詞包含的語義信息要比圖像的單個像素更豐富,你可以做個實驗,你把文本和圖像都做隨機遮擋,把圖像遮擋80%仍可分析圖像中的是什么,但文本就做不到了。

從此之后,多模態大模型朝著大一統的方向發展。

模型結構上的統一,例如,都使用無論視覺編碼器,文本編碼器還是多模態融合編碼器,都統一使用Transformer架構。

任務上的統一,用同一個模型完成理解和生成任務,圖文檢索,分類,VR,VE,VQA等。

ALBEF:Align before Fuse: Vision and Languag Representation Learning with Momentum Distillation(2021)

??https://arxiv.org/pdf/2107.07651??

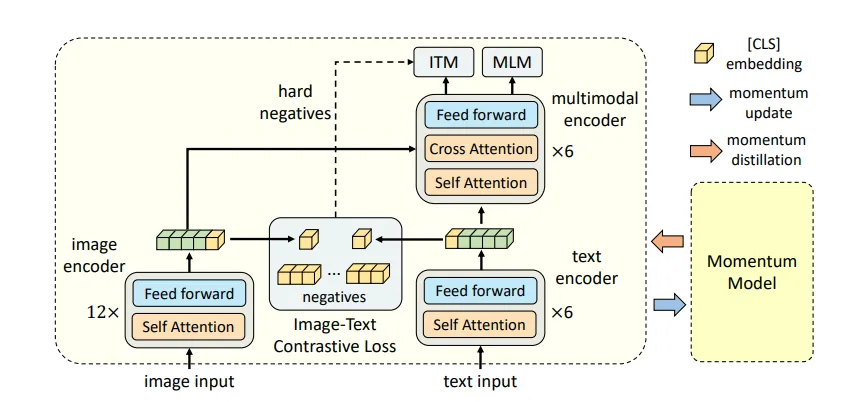

ALBEF模型符合我們在ViLT中對一個好的多模態模型的定義,就是視覺編碼器要比文本編碼器強,多模態融合能力要強,并且模型既能很好的用于圖文檢索又能用于生成任務。

但有人會問了,生成任務是需要解碼器的,可到目前為止用的都是Transformer編碼器啊,而且編碼器也主要用于多模態融合任務。

那是如何實現VQA的?

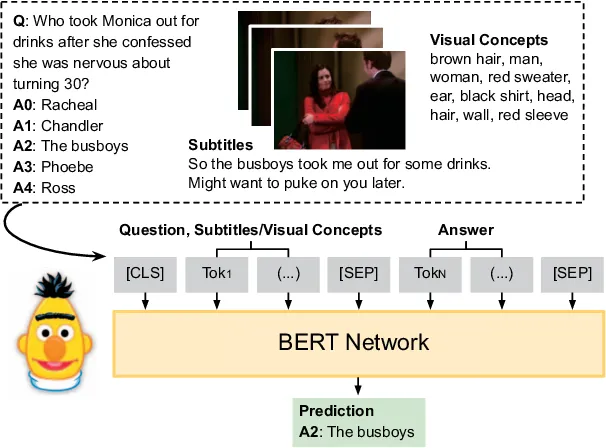

其實也可以變相實現的,我們稱之為閉集VQA。

在此之前,先來說一下如何使用Bert實現問答,本質上就是將其轉換成一個分類任務,例如將CLS Embedding后面加一個多分類模型,或者將問題和一個上下文一起發給Bert,然后通過一個二分類預測答案在上下文中的起始位置和結束位置。

對于VQA而言,也可以看作一個分類任務,也就是事先準備好答案,例如一共10個答案,然后將圖像編碼作為交叉注意力模塊的K,V,問題作為Q,然后將融合模塊的CLS token的輸出輸入到一個10分類MLP中。

但這種方法的缺點顯而易見了,不夠靈活,后面我們會看到將使用帶有Transformer解碼器的模型,這類模型就能夠靈活的生成文本了。

ALBEF全部采用Transformer架構,圖像編碼器有12層,將另一個12層的Transformer編碼器拆開,一半用于文本編碼,一半用于多模態融合。視覺編碼器要比文本編碼器復雜,使用編碼器作為融合模塊,這都符合前面對于“一個合理的多模態大模型”的預期。

視覺編碼器會使用DeiT預訓練模型,文本編碼器和融合模塊用Bert預訓練模型參數進行初始化,如果直接將視覺文本特征送入融合模塊,效果不會很好,因為他們不是對齊的,所以在進入融合模塊之前,先采用前面提到的對比學習進行多模態對齊。

損失函數同樣使用了ITC,MLM和ITM。

從網上爬下來的圖像文本對往往帶有很嚴重的噪聲,例如,華山的宣傳畫,描述的是青山綠水,有人嬉戲玩耍,但為了提高檢索率,往往只會用華山等關鍵詞。但關鍵詞往往不能描述圖像中的內容,所以使用Momentum Model去生成為標簽,本質上就是為了生成高質量的訓練數據。

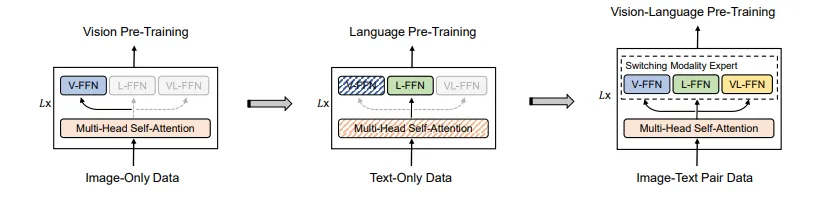

VLMO: Unified Vision-Language Pre-Training with Mixture-of-Modality-Experts(2022)

??https://arxiv.org/pdf/2111.02358??

前面的CLIP是一種雙塔對偶結構,一個圖像編碼器和一個文本編碼器,然后采用向量點乘實現模態之間的交互,好處是可以預先計算所有圖文的向量,來加快圖文檢索任務。但缺點也很明顯,不善于生成任務。

為了增強融合能力以適應生成任務,后續都是單塔模型,將一個Transformer分成兩部分,一部分用于文本編碼器,另一部分用于多模態編碼器,雖然提升了融合能力,但不靈活,對于圖文檢索任務,需要計算Transformer Encoder融合編碼器的相似度分數,但這對圖文檢索不友好。

那能不能把雙塔和單塔的優點結合起來呢?既能單獨用來對文本視覺編碼,又能融合。

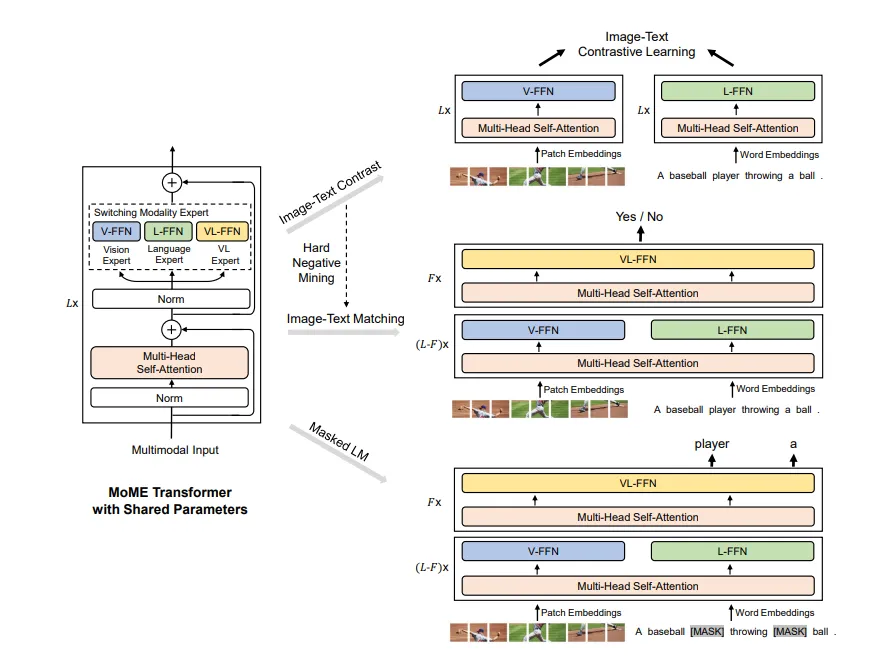

所以VLMO中提出了混合專家模型(MOE)。

(對于MOE,這是一種思想,大家可以回想下傳統機器學習中的集成學習,在VLMO中,不同專家能夠處理不同的數據模態,架構不同,還有一種MOE思想是采用同一種架構,但每個專家去學習不同領域的知識,例如,馬斯克開源的Grok大模型)

MOME整體上就是一個Transformer Encoder結構,這實現了模型架構上的統一,但是對Transformer Block里面做了改動,主要是對MLP層做了改動,多頭注意力層共享參數。其MLP層劃分為三種模態專家,分別是視覺專家(V-FFN)用于圖像編碼,語言專家(L-FFN)用于文本編碼,以及視覺-語言專家(VL-FFN)用于圖像-文本融合。

訓練時,也是迭代進行,先像BEiT那樣視覺預訓練,然后,凍結MSA和V-FFN參數,再像BERT那樣文本預訓練,最后輸入圖像文本對視覺語言預訓練。

VLMO不僅實現了模型架構上的統一,而且也實現了任務上的統一,既能像CLIP那樣實現圖文檢索,也能處理生成任務。

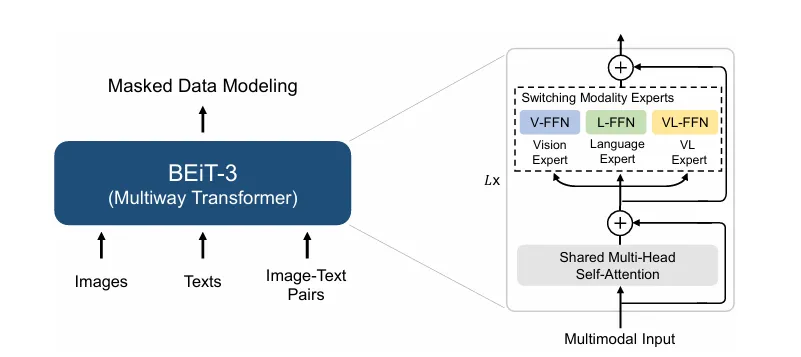

BeiT v3:Image as a Foreign Language: BEIT Pretraining for All Vision and Vision-Language Tasks(2022)

??https://arxiv.org/pdf/2208.10442??

以前我們使用ViT作為圖像編碼器,使用Transformer處理文本,兩者本質上還是不同的,為了實現大一統,能不能把圖像也看做是一種特殊的語言?

多模態繼續朝大一統的方向努力。

BEiT-3出現了,它將圖像看作是一種特殊的語言(Imglish)。

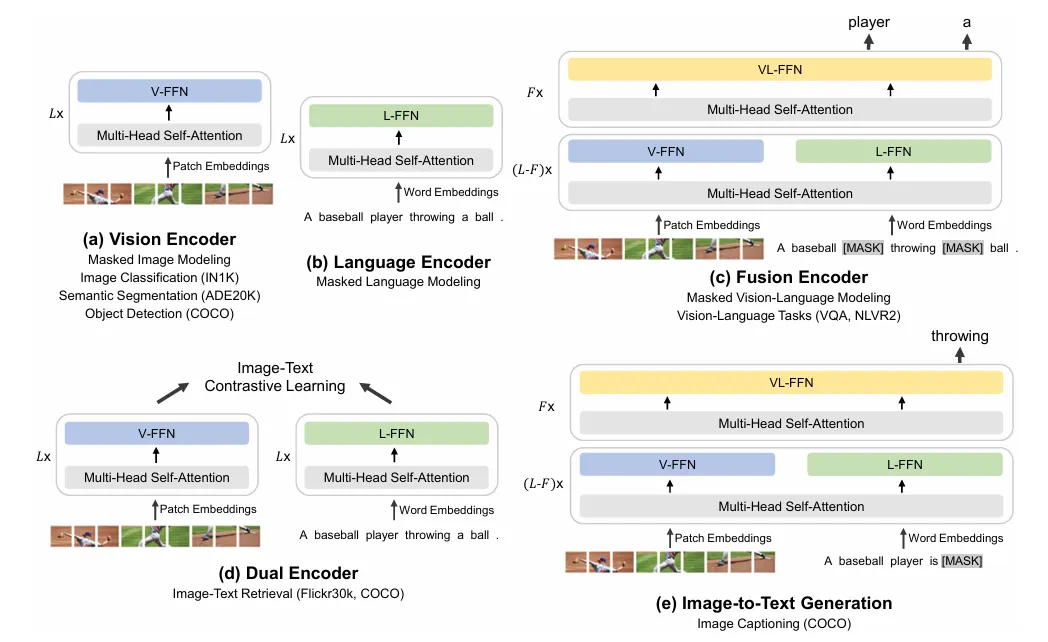

它與VLMO在模型架構上很類似,也使用了MoE架構,所以可以適用于不同下游任務,例如,a和b中用于分別編碼圖像和文本,c中用于視覺和文本融合,d中類似CLIP的對比學習,以及e中的文本生成。

損失函數不需要ITM和ITC,只要MLM損失。

但前面我們也說過,只有編碼器的模型在處理生成任務上是不靈活的,接下來我們將看到帶有Transformer解碼器的模型,這類模型就能夠靈活的生成文本了。

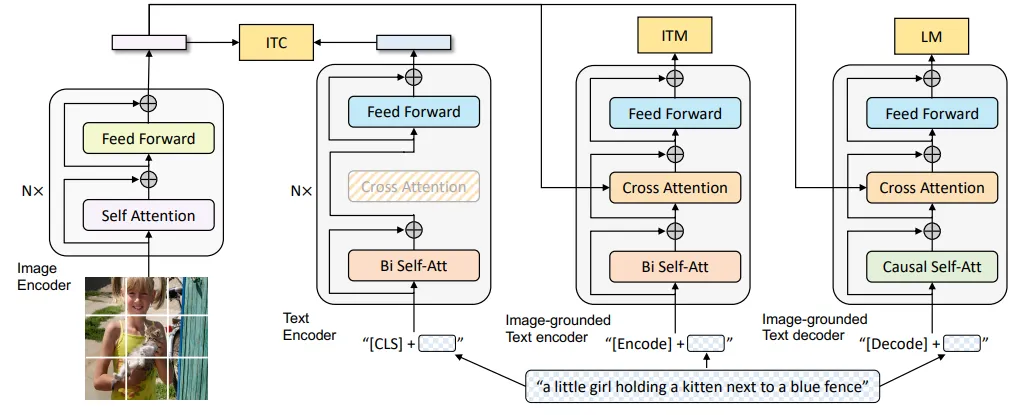

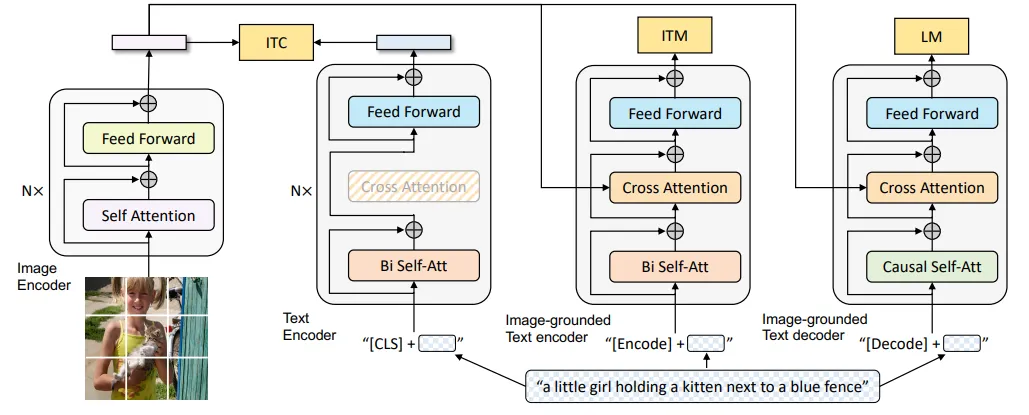

BLIP: Bootstrapping Language-Image Pre-training for Unified Vision-Language Understanding and Generation(2022)

??https://arxiv.org/pdf/2201.12086??

BLIP這篇論文有兩個貢獻點,一個是從模型,二個是數據。

前面提到的這些模型只使用了Transformer Encoder,適合理解任務,不能直接用于生成任務。這時候需要加一個Decoder模塊。并且提出了一個統一的模型來處理不同的任務。

BLIP包括三個編碼器和一個解碼器,編碼器負責編碼圖像和文本,解碼器負責根據編碼器的輸出生成文本。

損失函數ITC和ITM,LM。通過ITC損失函數對齊圖像和文本;圖像編碼特征通過交叉注意力與文本特征融合。生成多模態特征,通過image-ground Text encoder去計算ITM損失。因為是Transformer Decoder,用于文本生成,而不是預測掩碼,所以損失函數由MLM變成了LM。

注意,顏色相同的模塊參數是共享的。圖片經歷一次前向過程,文本需要經歷三次。

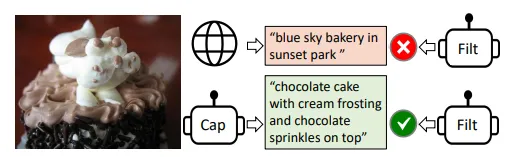

在數據上,提升預訓練數據質量對于多模態性能提升很重要,但從網上下載的圖像文本對有噪音,還是通過有個方法提升訓練數據質量。論文提出了Captioner和Filter。

如上圖,從互聯網爬下來的圖像描述是“blue sky bakery in sunset park”,這句話更適合搜索引擎,并沒有很好的描述圖片。

下面是Captioner模塊根據圖片生成的文本描述,很好的描述了圖片中的內容。Filter則會判斷是互聯網上爬的好還是Cap生成的好,最后過濾掉質量不好的。

具體過程是,Cap中用最大的BLIP模型生成40描述,Filter中用CLIP檢索出質量最好的5個。再用CLIP ResNet找到最好的。

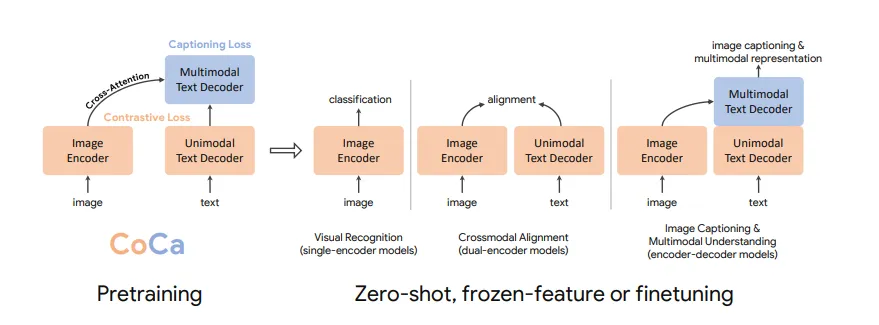

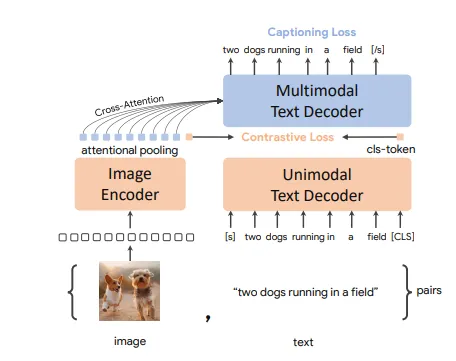

CoCa:Contrastive Captioners are Image-Text Foundation Models(2022)

??https://arxiv.org/pdf/2205.01917??

與ALBEF很像,一個圖像編碼器,一個Transformer decoder分兩半。

只使用Decoder,只使用ITC和LM損失,解決訓練效率問題。其它模型都要forward好幾次。

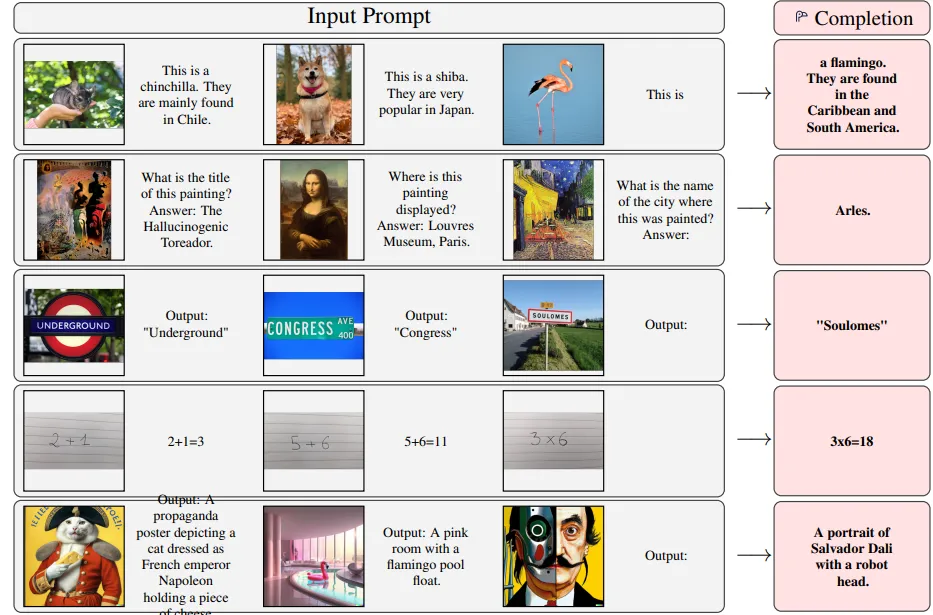

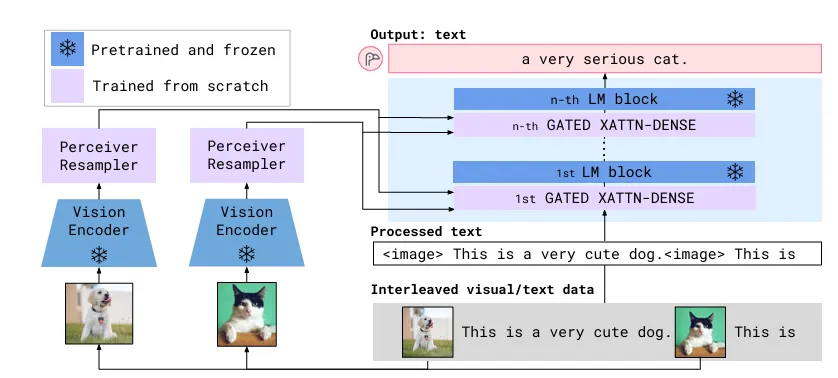

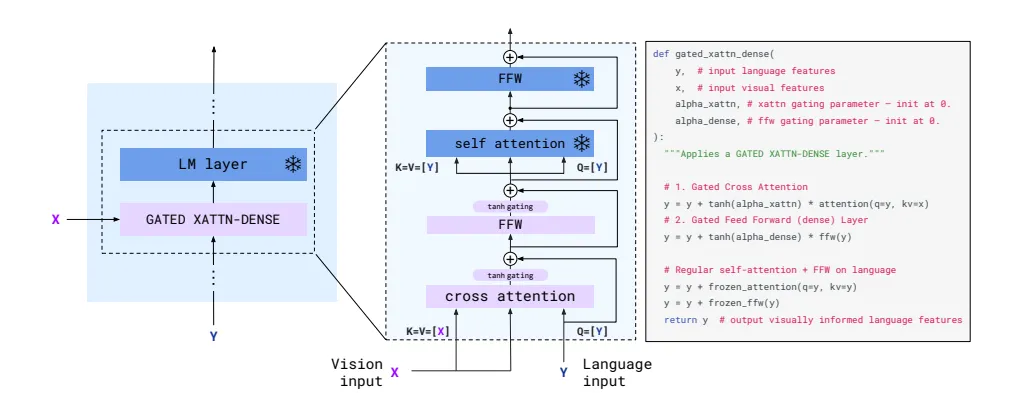

Flamingo: a Visual Language Model for Few-Shot Learning(2022)

??https://arxiv.org/pdf/2204.14198??

當前大語言模型就有很強的語言理解和生成能力,具有in context few-shot推理能力,那能不能利用這些LLM資源呢?

Flamingo借鑒LLM的Few-Shot推理能力,使其善于VR VE VQA等生成任務。

視覺編碼器也是用預訓練好的ViT模型,例如BeiT,如果訓練過程中參數保持不變,直接將視覺編碼器的輸出給LLM肯定不是對齊的,那如何實現多模態的融合?

要么微調ViT的參數,要么中間加一個Adapter。

Flamingo選擇凍結大語言模型以及視覺預訓練模型參數,然后通過加一個Adapter實現模態之間的對齊。

從此進入大語言模型加持時代。

視覺問答

下圖是Flamingo的模型結構,藍色的模型參數是凍結的。

視覺編碼器是一個預訓練的ResNet。

Perceiver Resampler就是Adapter,將ResNet的輸出特征映射成視覺tokens。

GATED XATTN-DENSE layers:類似交叉注意力,視覺tokens作為LLM的條件輸入。

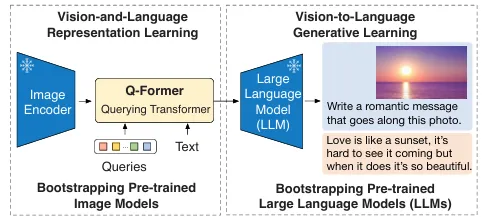

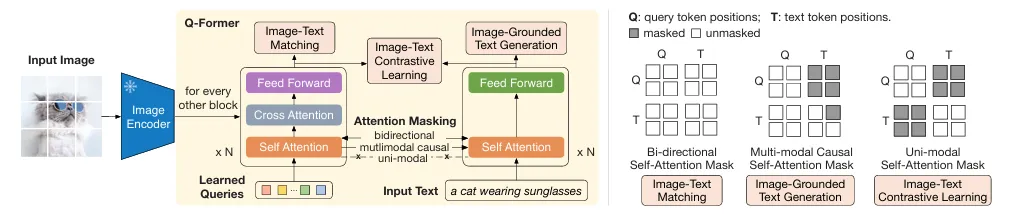

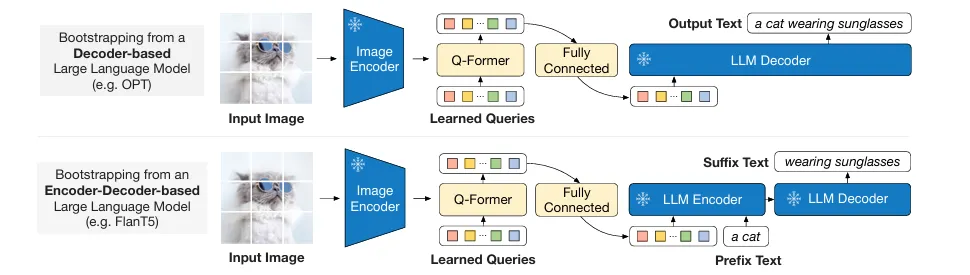

BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models(2023)

??https://arxiv.org/pdf/2301.12597??

BLIP-2與BLIP相比,也是引入了LLM,總體上就是圖像編碼器提取圖像表征,然后將表征與用戶Query一起輸入到類似GPT的大語言模型,然后以自回歸的方式生成文本。這里圖像的表征,就像是RAG中的上下文,也就是告訴大語言模型,要基于圖像表征的內容,針對我的問題給出答案。

BLIP2同樣凍結了圖像編碼器和LLM的參數,然后讓Querying Transformer充當Adapter的角色。

預訓練分兩個階段,第一個階段,視覺文本表示學習,讓Querying Transformer學習到的視覺表示與文本靠近,第二階段讓LLM理解Querying Transformer的輸出。這兩個過程都是調節Querying Transformer的參數,其它都是凍結參數的。

下圖是第一階段訓練過程。輸入圖像文本對,損失函數ITC,ITM以及ITG。

下圖是第二階段預訓練,全連接層的目的是將Q-Former的輸出維度調整到LLM的輸入維度。

同樣使用Cap Filter模塊去除互聯網數據的噪聲,生成質量更好的圖像文本對。

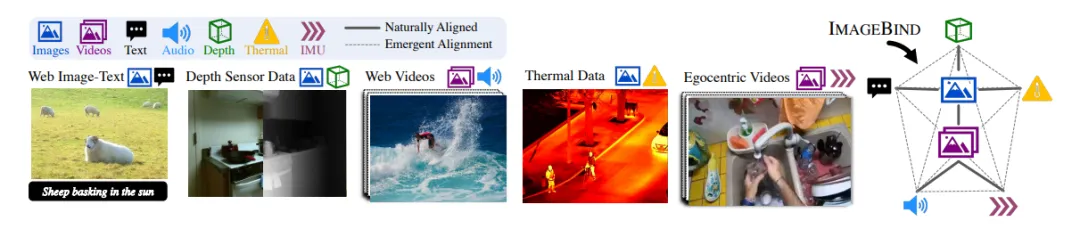

上述模型雖然是多模態,但大多聚焦在文本和圖像,下面的模型能夠處理,語音,點云,紅外線,射線,圖,時序,視頻,是真正意義上的多模態。

IMAGEBIND: One Embedding Space To Bind Them All(2023)

??https://arxiv.org/pdf/2305.05665??

ImageBind的核心思想是,雖然有多種數據模態,如果實現兩兩對齊很復雜,如果能找到一個中間人,也就是Image,讓其它模態與Image對齊,那么其它模態間也就能實現對齊了。

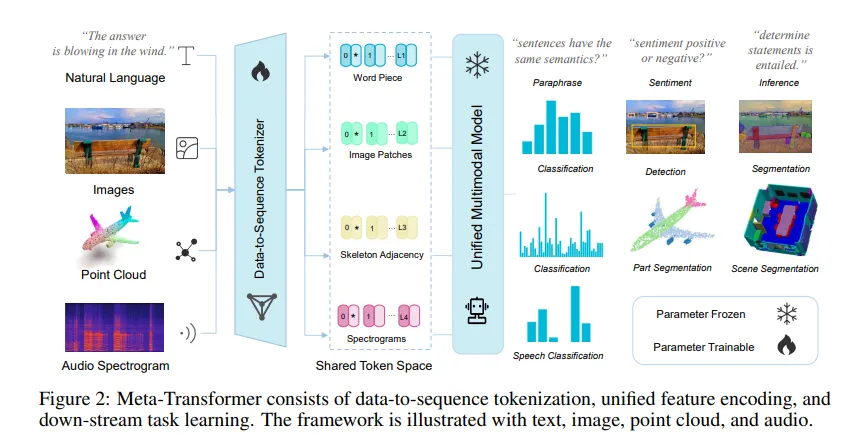

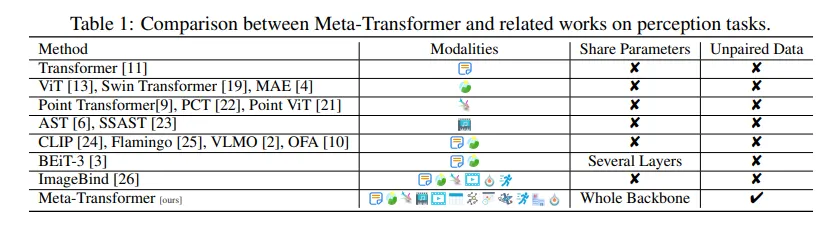

Meta-Transformer: A Unified Framework for Multimodal Learning (2023)

??https://arxiv.org/pdf/2307.10802??

前面所有模型都需要構造圖像文本對,Meta-Transformer不需要構造多模態輸入配對訓練數據,它通過Data-to-Sequence Tokenization將不同模態映射到同一個嵌入空間,然后通過Unified Encoder提取表征,最后通過Task-Specific Heads處理不同任務,Meta-Transformer雖然不需要配對多模態數據,但需要與任務相關的標簽信息來訓練模型。

下圖是Meta-Transformer與其它模型的對比。

本文轉載自公眾號人工智能大講堂