端到端短視頻多目標排序機制框架EMER詳解 原創

當你打開短視頻 App,手指上下滑動的每一秒,背后都藏著一套決定 “你接下來看什么” 的排序邏輯。

過去十年,行業里的推薦排序大多依賴 “人工設計公式”—— 工程師們把 “用戶會不會點贊”、“能看多久” 等指標,按經驗分配權重、套進公式,算出每個視頻的 “優先級分數”。

但這套模式正在遭遇瓶頸:有人喜歡 “短平快” 的搞笑視頻,有人偏愛 “慢節奏” 的生活記錄,一套公式怎么滿足千萬用戶的個性化需求?當 “留存”、“時長”、“播放量” 等目標沖突時,比如推長視頻能提升時長,卻可能降低播放量,人工調權重又該如何平衡?

為解決這些問題,快手策略算法團隊

設計并落地基于模型的端到端多目標融合排序機制框架 EMER。它用 “會比較、能進化的 AI 模型”,徹底替代了傳統推薦排序,實驗推全前的 Launch 實驗和推全后的反轉實驗,均觀察超過一個月,從反轉實驗數據來看,用戶體驗提升顯著:

- 快手極速版 App:七日留存+0.302%,App 停留時長+1.392%,單列短視頻觀看次數+1.044%;

- 快手主 App:七日留存+0.231%,App 停留時長+1.199%,單列短視頻觀看次數+2.996%;

- EMER 還適配到了快手端到端生成式推薦系統 OneRec 鏈路的獎勵模型中,使得 App 停留時長提升 0.56%,留存有顯著正向趨勢,反轉實驗長期觀察中。

論文題目:An End-to-End Multi-objective Ensemble Ranking Framework for Video Recommendation

論文地址:??https://arxiv.org/pdf/2508.05093??

【主要貢獻】

在項目推進中,快手策略算法團隊重點關注了真實工業場景落地的現實難題。把落地過程中的經驗總結并發布出來,希望能給大家提供一些參考:

1、短視頻推薦場景中,用戶滿意度難定義。不同用戶表達滿意的行為模式迥異,甚至同一個用戶對不同類別的短視頻也有不一樣的滿意度表達方式。這就導致模型的學習目標是很難定義的。

2、排序的本質是“比較”,同一個請求內候選適配之間的比較關系是非常重要的,模型如何感知此類信息也是一個難點。

3、模型的學習目標難定義,也意味著模型的評估 Metric 難設計。

針對上述落地時的三個現實挑戰,快手設計了一套系統性的解法。實際上,在機制模型化的同時,還推進了“群治+自治”的多業務迭代排序機制,實現以留存貢獻度為流量分配依據,驅動在單列迭代的多個業務聚焦內部提效和內外部協同。EMER 則具體指消費業務內部的機制模型化,多業務間仍保留較大的白盒化程度。

一、讓模型學會 “比較”,而不是 “單獨打分”

工業界廣泛應用的推薦排序模塊范式是兩階段的,第一階段通過大體量模型預估用戶在多個維度上的滿意度,第二階段將多目標標量化作為最終排序依據,即多目標融合排序。工業界普遍采用的標量化方法是人工設計的啟發式排序公式,排序公式應用成本低、調整靈活、可解釋性強,但個性化和非線性空間都很有限。

傳統推薦排序模型的優點很明顯 ——成本低、調整靈活、可解釋性強。但缺點也同樣突出:

- 個性化不足:一套公式覆蓋所有用戶,無法適配 “有人愛刷短劇、有人愛刷知識” 的差異需求。

- 非線性能力弱:公式只能處理簡單的線性關系,沒法捕捉 “用戶看了 A 視頻后,更可能喜歡 B 視頻” 這類復雜關聯。

- 多目標平衡難:當 “留存” 和 “播放量” 沖突時,只能靠工程師反復試錯調權重,既耗時又難找到最優解。

過去的排序模型,本質是 “給每個視頻打個獨立的分,按分數排序”。快手提出的端到端多目標融合排序 EMER 的核心思路是 ——排序的本質是 “比較”,得讓模型看多個視頻之間的相對好壞。

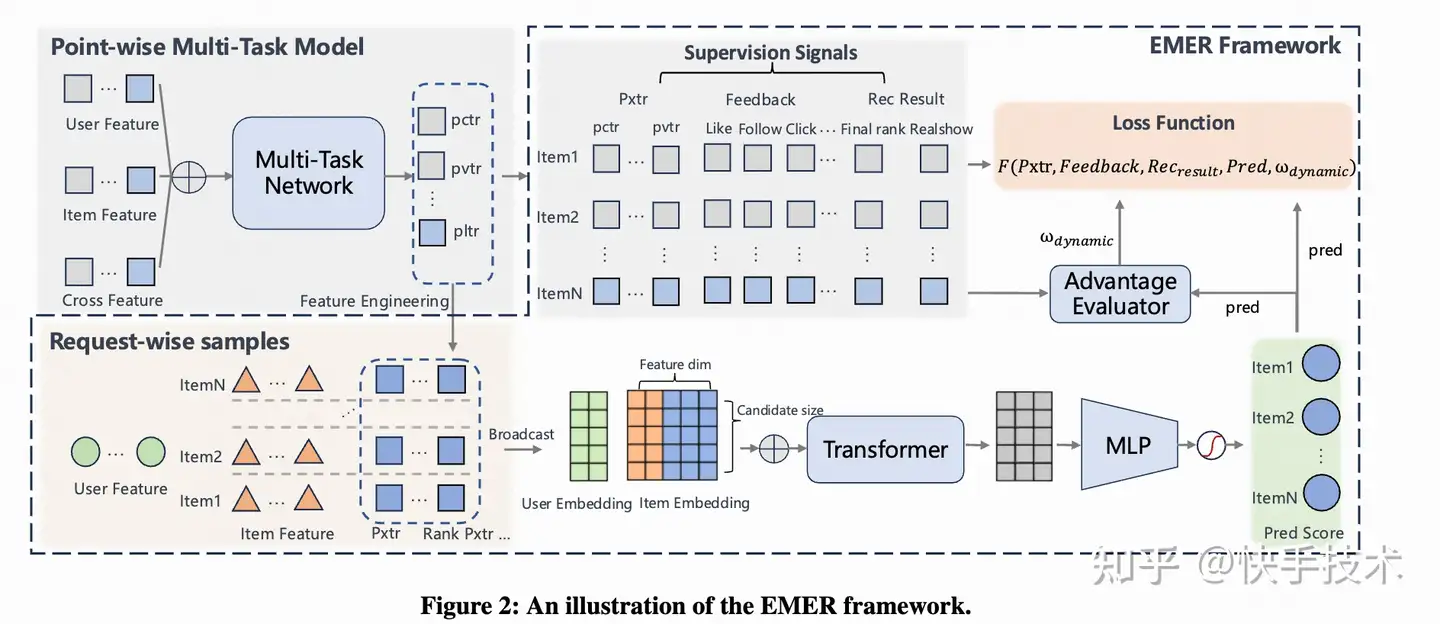

為了讓模型學會比較,EMER 從數據、特征、模型三個層面做了重構:

- 樣本組織:傳統方法只看用戶互動過的少數幾個 item。但我們知道,用戶的一次請求中,其實有大量候選 item。EMER 是把一次請求的所有候選 item(無論是否曝光)都打包成一個樣本。這不僅能解決曝光偏差問題,還直接為模型提供了豐富的比較對象,并且與在線對所有候選的比較排序過程更加一致。

- 特征設計:EMER 不只給模型提供單個 item 自身的特征,還引入了Normalized Ranks(original item rank/total number of candidate items)這種相對位置特征。簡單來說,就是告訴模型:“這個視頻在這一批候選中的排名是第幾(從某單一維度的信號來看)”,讓模型明確知道每個 item 在當前候選集中的相對地位。

- 模型架構:為了處理這種帶“比較關系”的數據,EMER 基于Transformer 的網絡架構。本身 Transformer 天然就擅長處理序列和關系。它能顯式地捕捉候選 item 之間的復雜關系,評估每個 item 對其他 item 的影響。最終,模型給出的得分,不再僅僅是 item 本身的質量分,更包含了它在當前上下文中的相對價值。

二、怎么讓模型知道 “用戶滿意嗎?

解決了數據和模型的基礎問題后,下一個難點來了:如何量化用戶滿意度,以及如何處理多目標間的沖突。

在推薦系統領域,一個長期存在的挑戰是如何構建一個有效的監督目標,以準確量化和優化用戶滿意度。由于用戶行為的個性化和多樣性,簡單地用單一指標或絕對分數來衡量滿意度是極其困難的。EMER 框架針對這一挑戰,提出了基于

相對優勢滿意度 + 多維滿意度代理指標的方法:

相對優勢滿意度 :

用戶對 item 的多維后驗(如點贊、觀看時長等)都能用戶某個維度的滿意度,基于用戶的多種反饋很難定義一個用戶滿意度的絕對水平。但是但可以基于用戶在收到推薦后的后驗反饋來判斷一個一個 item 是否相對更優于另一個 item。我們定義了層次化的滿意度關系:“多重正反饋 > 單一正反饋 > 無正反饋”。對于單個 item 而言,收到的正反饋數量越多,其相對滿意度反映。

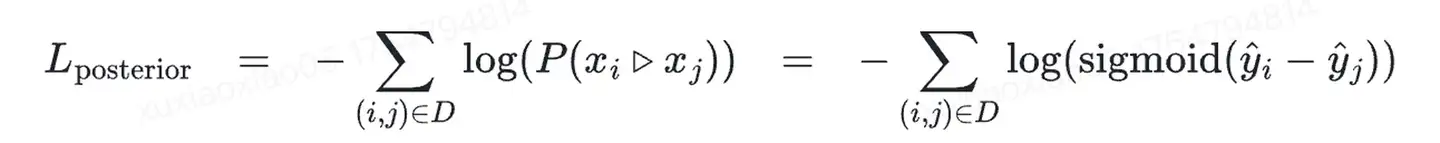

基于此,我們采用 Pairwise Logistic Loss 來訓練模型,使其能夠學習并區分這些不同層次的滿意度偏好:

其中 D 代表了所有的正樣本對。

多維滿意度代理指標:

盡管后驗反饋為滿意度的量化提供了寶貴的洞察信息,但其固有的

曝光偏差和

信號稀疏性是無法回避的局限。因此,EMER 從多目標優化的角度引入了互補的解決方案。

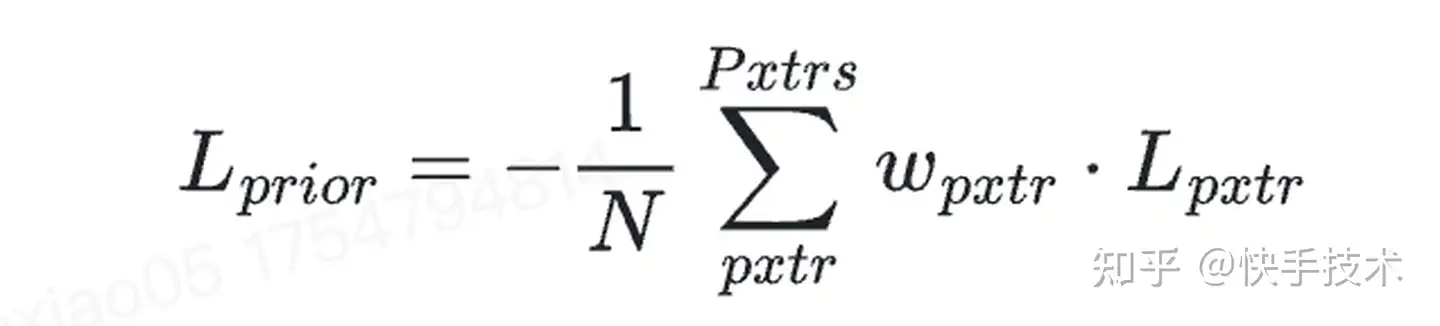

在大規模推薦系統中,多任務模型能為每個候選項提供豐富的先驗信號(Pxtrs)。這些信號本質上都反映了用戶滿意度的不同維度。我們認為,提升某個信號的排序效果,就能提升相應維度的用戶滿意度,所有信號的排序效果同時提升,將共同促進整體用戶滿意度的提高。基于此,EMER 沒有這些信號簡單地融合成一個標簽,而是將每個先驗信號作為一個獨立的監督目標,旨在優化每一個信號的排序性能 AUC,鑒于 AUC 的不可微,我們采用了可微分的 pairwise 代理損失函數來近似 AUC 最大化,從而鼓勵模型對 Pxtr 優 item 給出更高的分數。

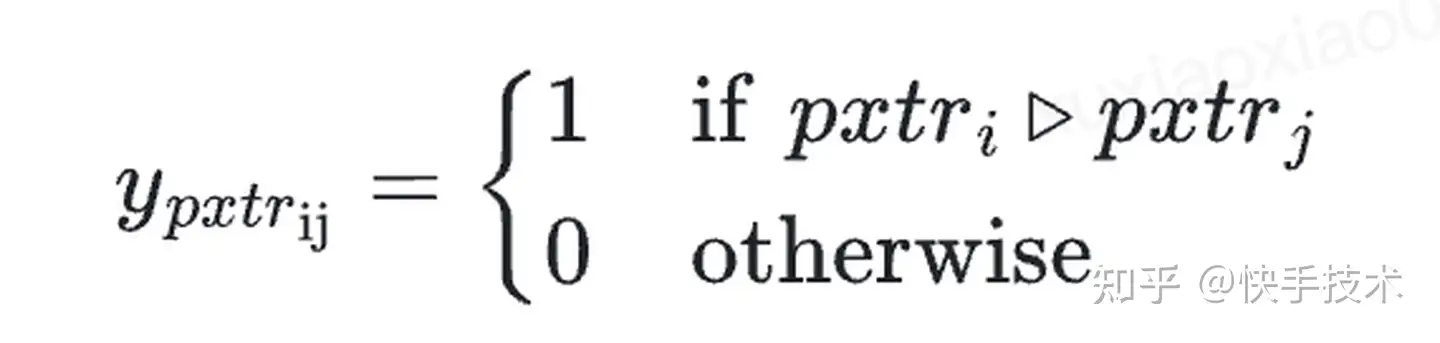

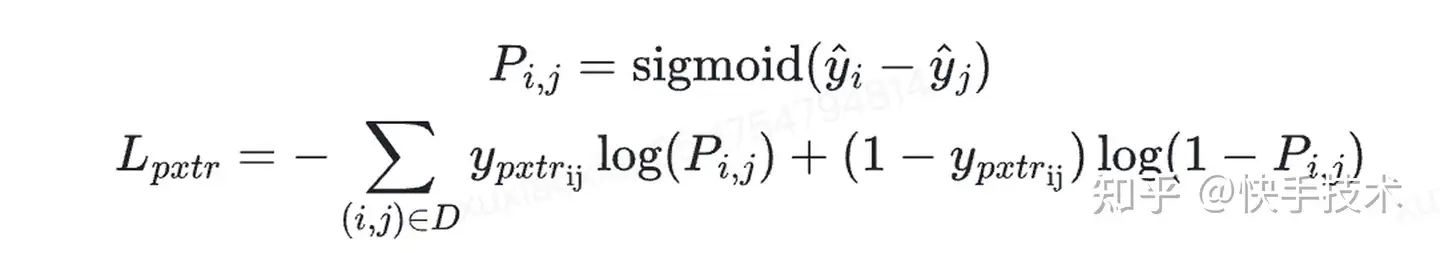

label :

單個 pxtr 的 loss:

其中 是模型預估分。所有 Pxtrs 的整體 loss 為:

其中是不同指標 loss 權重,具體計算邏輯將在“自我進化”方案中展開討論。

多維滿意度代理指標除了解決基于后驗的曝光偏差和信號稀疏性問題,同時能夠將更多維度(包含深層轉化和延遲反饋的信號的預估值等信號,此類如果直接學后驗信號,存在天級以上的延遲會丟失推薦系統的實時性;基于不同領域專業知識構建的跨團隊、跨業務的信號)引入,讓模型能更及時地、全面地理解用戶滿意度,從而在排序時做出更精準的權衡和決策。

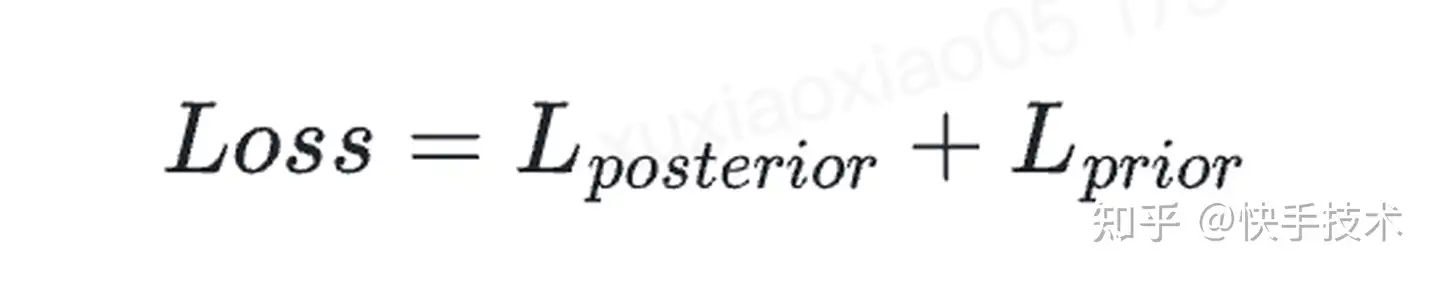

最終 loss 為相對滿意度和多維滿意度代理指標的 loss 總和:

三、智能優化:讓模型“自我進化”,平衡多目標

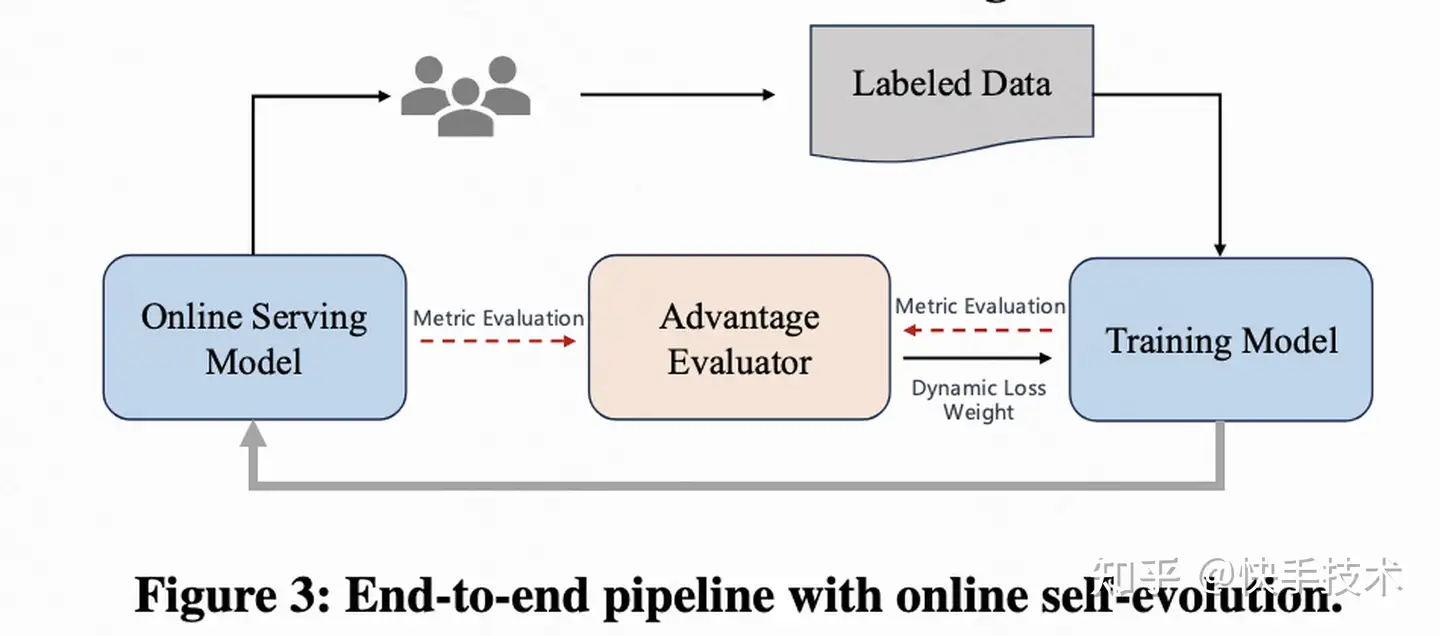

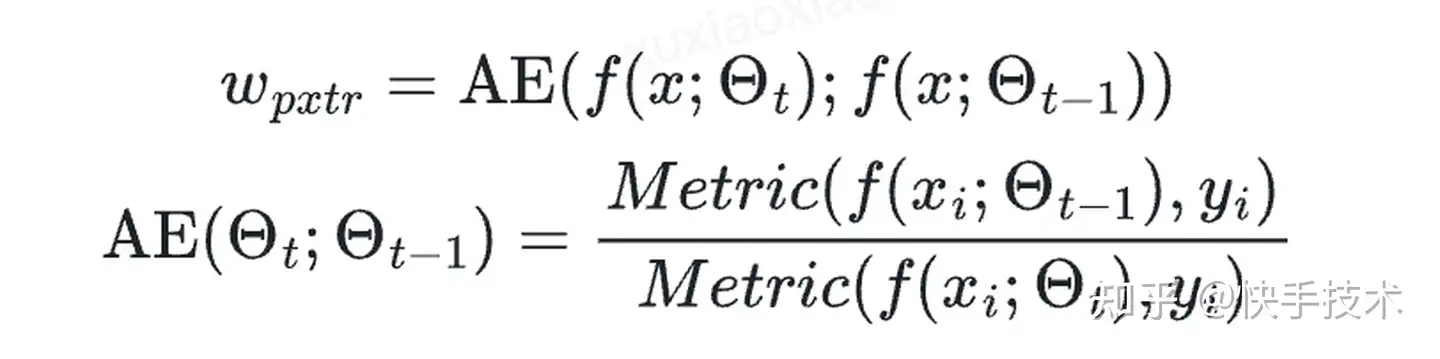

在多目標優化中,不同目標間通常存在沖突,這使得尋求最優解成為一個巨大的挑戰。為了解決這一問題,EMER 提出了一個名為

“自我進化”的優化方案,其核心是一個

“優勢評估器”(Advantage Evaluator,簡稱 AE),它能夠動態、自適應地計算各目標損失的權重。

3.1 對比 “新舊模型”,自動調權重

其原理是:不同于依賴靜態權重配置的傳統方法,EMER 能夠根據

當前模型相對于之前版本模型的性能表現,自動調整不同損失的權重。當某個目標表現下降時,優勢評估器會增加其權重,促使模型集中優化;反之,則會減少其權重,去關注其他效果更差的目標。

其中代表了評估模型效果的評估指標,針對不同的業務問題可以嘗試不同的指標,本次我們也將在消融實驗本分進行簡單的討論。分別代表當前模型和舊模型。由于模型實時訓練,可以保存模型在線預估的結果作為而無需保存舊模型版本。

自我進化在多目標融合中具備明顯優勢:

- 高效且自適應:無需人工調參,即可高效優化大量多樣的目標,在初版模型中成功完成了多達78 個目標的融合且取得了全面提升。

- 動態與個性化:以按請求級別的細粒度計算,確保模型能持續適應不同用戶的個性化偏好和同一個用戶隨時間不斷變化的行為。

- 公平和準確性:每個 pxtr 通過基于時間的自我比較,有效解決了不同目標間數值范圍不一致的問題,確保權重計算的公平和準確。

這種“自我進化”的訓練方案使得 EMER 具備了“

學習如何學習”的能力,從而實現了持續和自適應的性能提升。

3.2 離在線一致性:解決“解耦悖論”

“離在線不一致”是一個業界常見挑戰。在實踐中,我們遇到了一個經典的“

解耦悖論”問題:離線時長和互動 AUC 都很好,但上線后總互動量顯著卻下降了,出現了“離在線不一致”的問題。這背后隱藏著一個根本性的問題,互動 pxtr 中存在著觀看時間的混淆因素:離線優化的

單個 item 的互動累計概率(pxtr),和線上追求的

單位時間內的互動密度(total interactions),目標從根本上就不一致。

- 離線訓練目標:優化單個 item 的互動概率(pxtr),其目標是讓用戶對每個獨立的推薦 item 產生互動的可能性最大化。

- 在線業務目標:用戶有限的會話時間內,最大化總互動次數。這意味著我們需要增加互動的“概率密度”,即在單位時間內的互動效率。

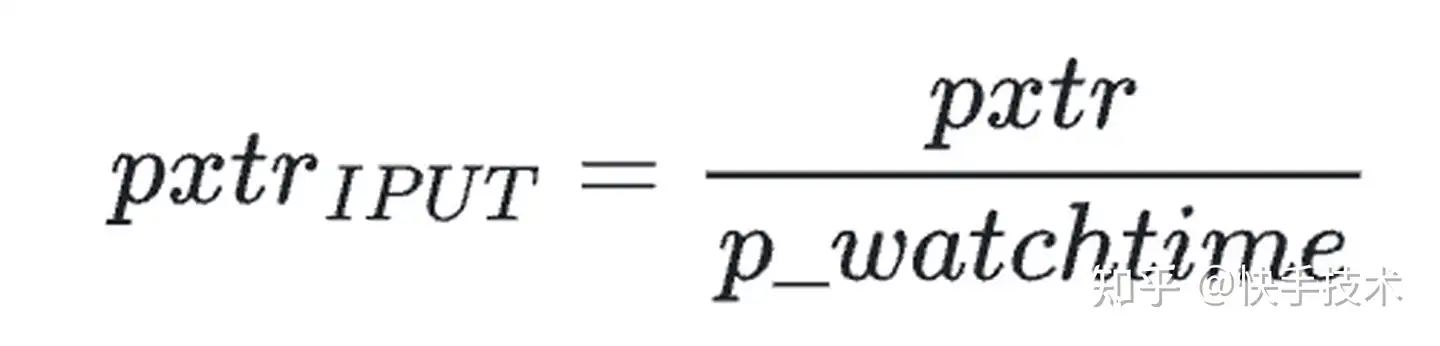

為了緩解這個問題,我們提出了一個更合理的指標:

單位時間互動概率(IPUT):

通過將優化目標從 pxtr 轉化為 IPUT,我們將模型的學習方向從“最大化單次互動的可能性”

,精準地調整為“最大化單位時間內的互動效率”。這一方法從根本上消除了“解耦悖論”,顯著提升了離線評估與在線業務表現的一致性,為模型離線的高效迭代奠定了堅實基礎。

四、落地效果和實驗分析

4.1 線上 AB 實驗

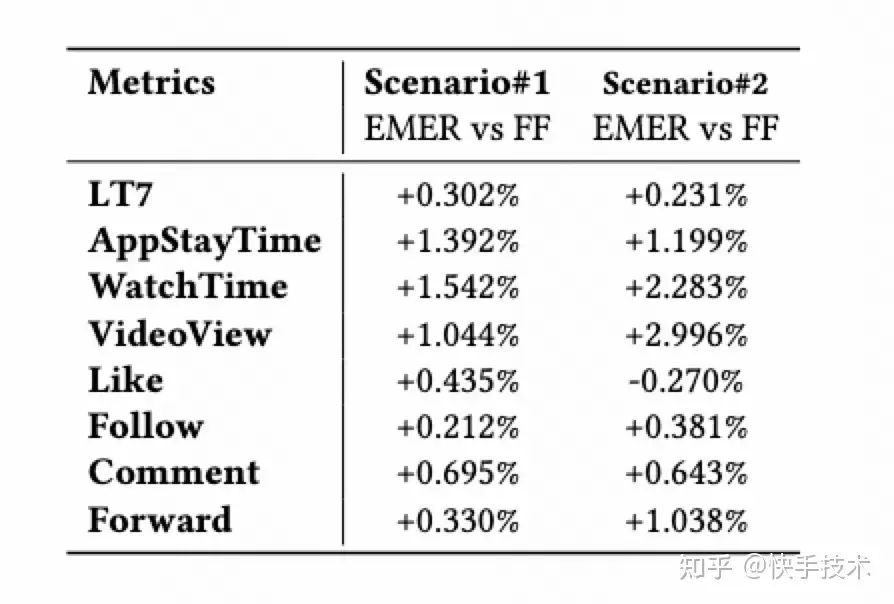

此前,快手精排的最終排序是基于融合公式(fusion formula,后面簡稱 FF),對每個 PXTR 進行變換后,通過相乘得到最終的排序分數。即一次請求中每個視頻的打分可以形式化地寫為。本次實驗,我們在快手兩個主要場景(快手極速版和快手主 APP)上分別使用了機制模型進行打分,并且進行了線上的 AB 實驗。

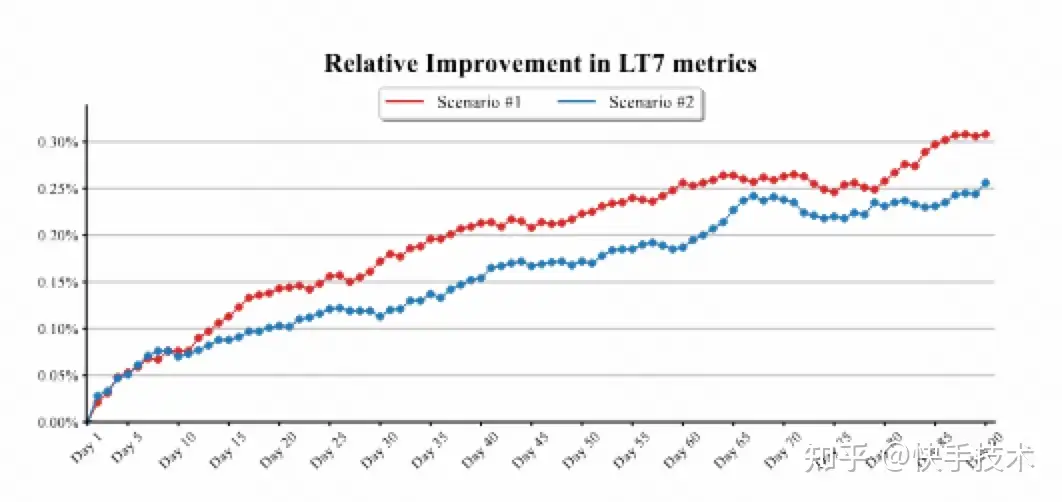

下面的表格是 AB 實驗的雙重差分結果。可以看到,EMER 相較于融合公式的方法,在推薦系統的核心指標如 LT、時長、vv 和互動等指標上都取得了顯著的提升!而目前的 LT 折線圖結果則表明,LT 仍然有不斷上升的趨勢。

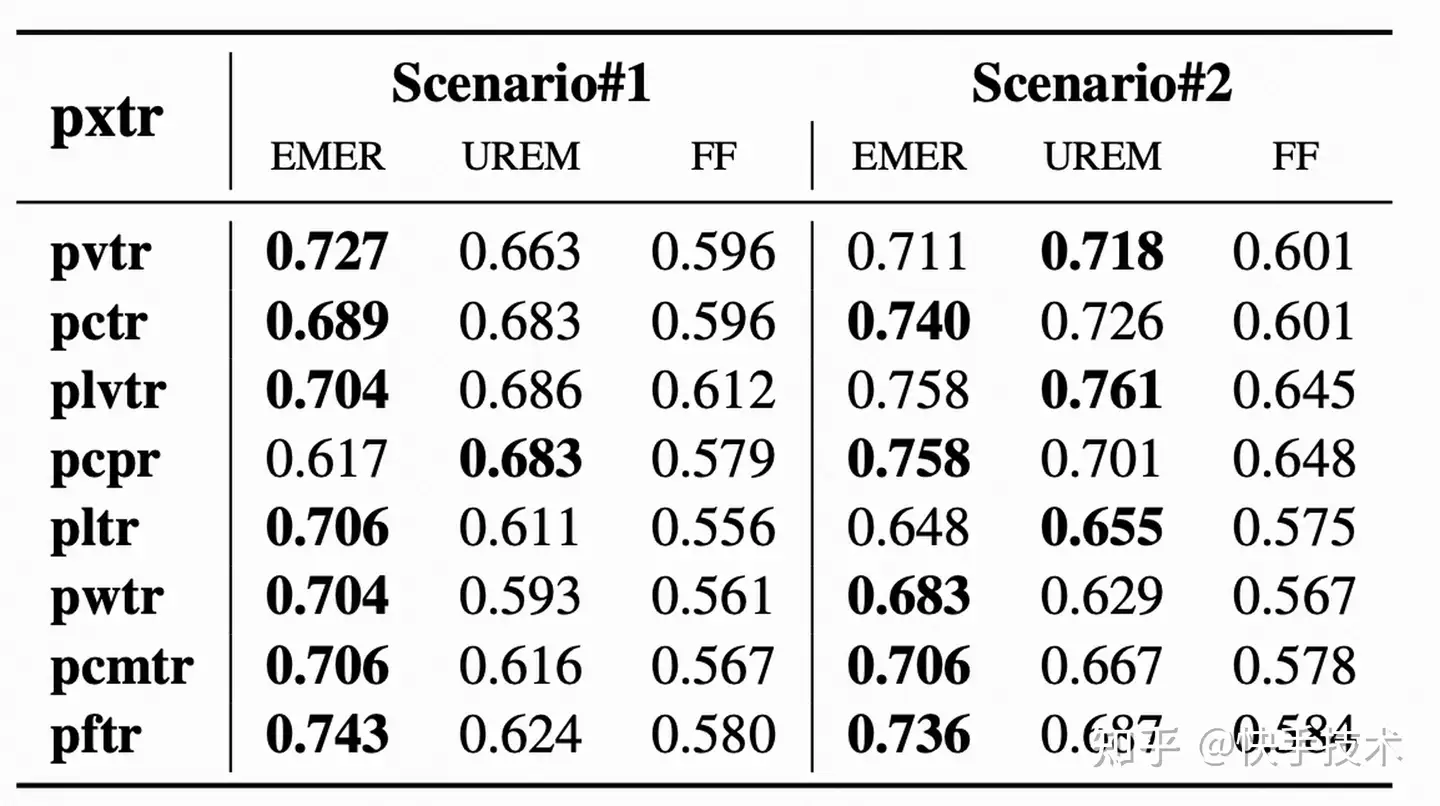

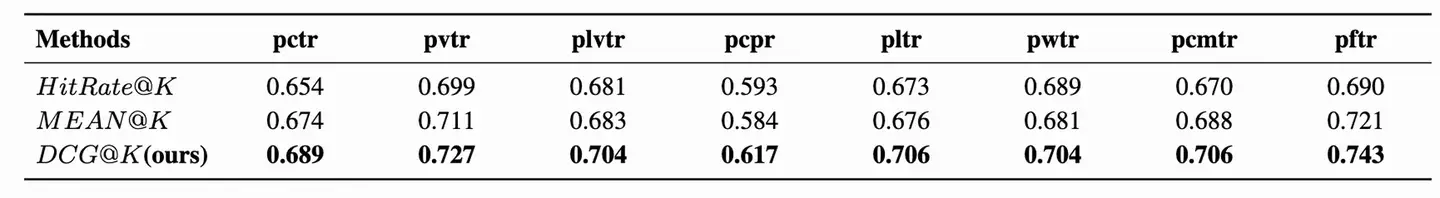

4.2 PXTR 的一致性分析/模型在用戶各維度滿意度上的排序能力

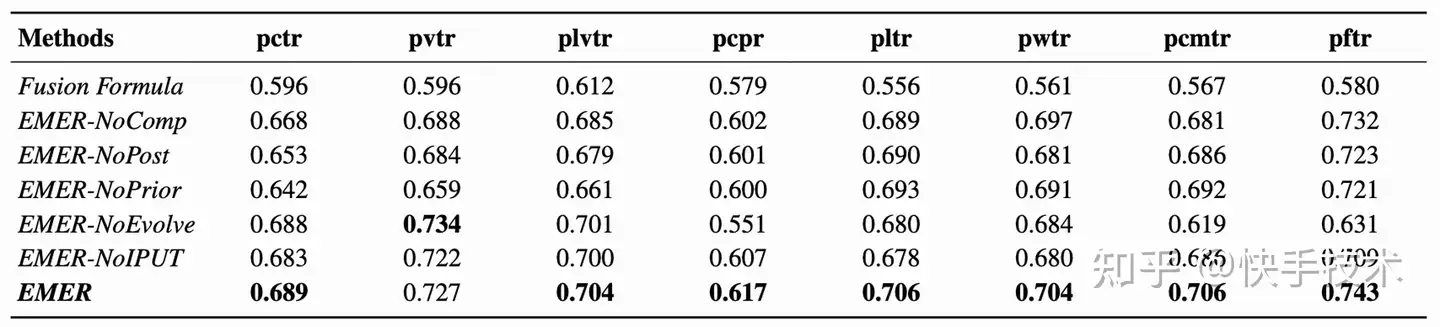

為了評估最終的排序結果和主要 PXTR 信號之間的一致性,我們計算了不同的排序融合方式得到的最終排序和不同 pxtr(主要包括觀看時長 pvtr,有效播/長播/完播 pctr/plvtr/pcpr,點贊/關注/評論/轉發 pltr/pwtr/pcmtr/pftr)之間的 GAUC。數據如下表(表中 UREM 為業界最新的使用模型融合的嘗試)所示,EMER 方法得到的排序在大部分 pxtr 上均取得了最好的一致性。

4.3 OneRec 鏈路中的落地嘗試

我們同時將該方案在 OneRec 鏈路中上線,作為 reward model 來生效。實驗結果顯示,我們的適配方案可提升 App 停留時長+0.56%,七日留存提升 0.149%。同時,該方法在快手其他業務場景也在積極嘗試中。

4.4 消融實驗分析

為了驗證 EMER 模型里,到底是哪些設計在 “真正發力”,快手策略算法團隊做了一組 “消融實驗”。實驗結果表明,模型中各個設計均對最終性能具有顯著影響。

表 1: EMER 和消融版本的離線 GAUC 比較

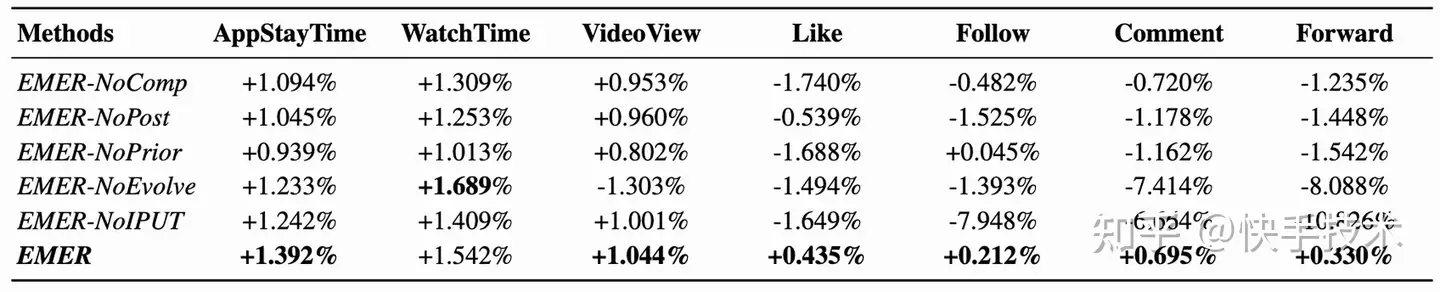

表 2:EMER 和消融版本的在線 A/B 效果比較

1. 顯式建模比較關系至關重要

EMER 通過請求級分組、Transformer 交互網絡和歸一化排名(Normalized Ranks),顯式建模候選集內部的相對排序關系。為了驗證該機制的作用,構建變體模型 EMER-NoComp,對每個候選對象進行獨立打分。

結果顯示,EMER-NoComp 在離線指標(見表 1)與線上 A/B 測試(見表 2)中均出現性能下降。這說明孤立地評估候選對象會丟失其在上下文中的相對信息。因此,

顯式建模候選對象間的比較關系對于提升排序質量具有關鍵作用。

2. 多維監督信號的協同作用

EMER 的監督信號由兩部分構成:基于用戶實際行為的

后驗的相對滿意度信號(Posterior)與基于

多維先驗的滿意度代理信號(Prior)。為評估其各自貢獻,分別構建 EMER-NoPost(移除后驗信號)與 EMER-NoPrior(移除先驗信號)變體。

實驗結果顯示,

移除任一信號均導致性能下降,表明兩類信號在模型訓練中均發揮重要作用。其中,EMER-NoPrior 的性能衰退更為顯著。

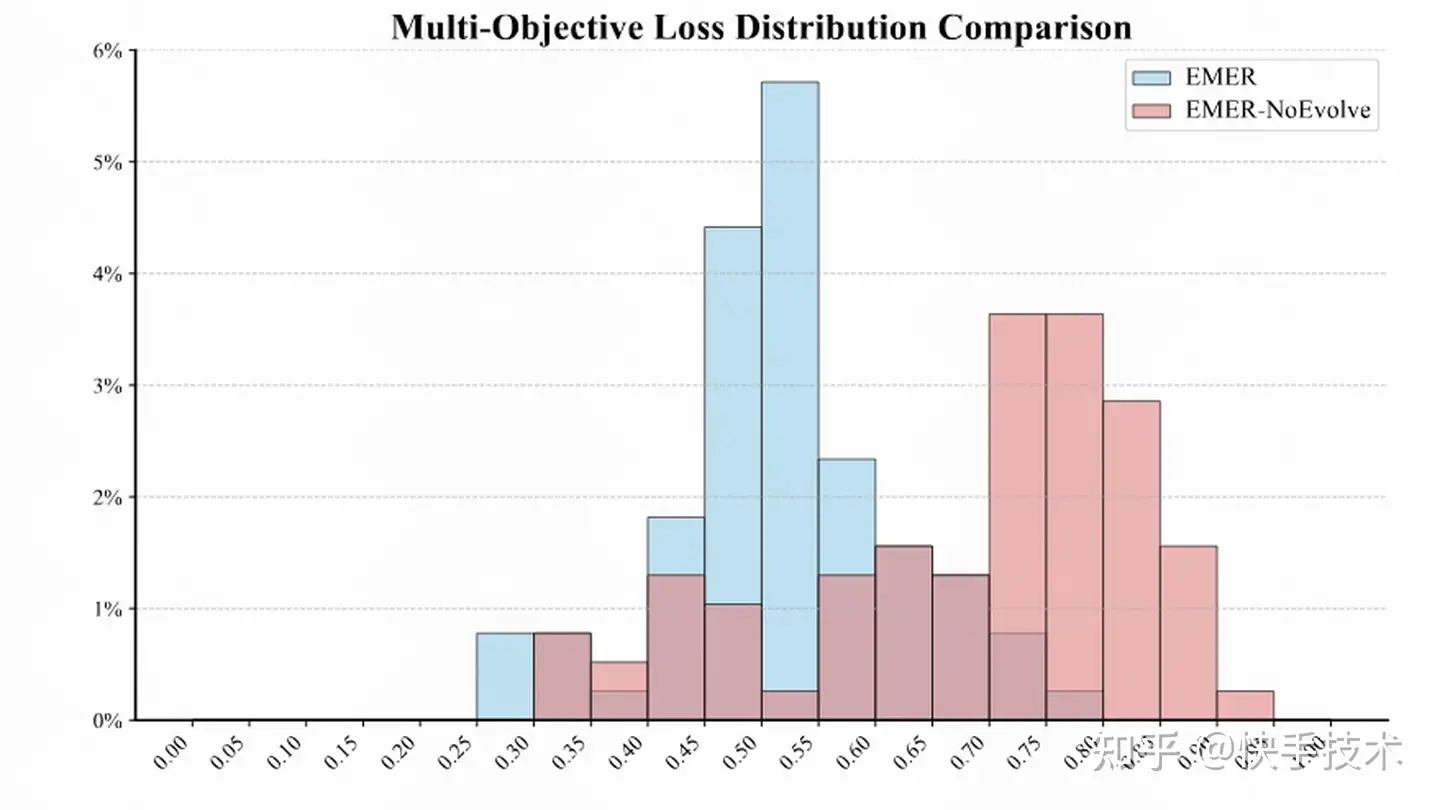

3. 自進化機制保障多目標均衡

為驗證自進化優化的作用,構建 EMER-NoEvolve 變體,采用固定權重訓練。結果顯示,該變體出現嚴重指標失衡:觀看時長上升,但播放量(-2.347%)、轉發(-8.418%)和評論(-8.109%)顯著下降。即便我們嘗試進行進行大量人工調參,靜態權重方案仍無法超越自進化策略,驗證了其在動態權衡多目標中的必要性。

進一步分析(見圖 1)表明,EMER 的多目標損失分布更均勻、集中且整體值更低,而 EMER-NoEvolve 損失波動大、分布分散。這說明這說明,自進化機制不只是在“調權重”,更是在

持續引導模型的學習方向,避免某些目標“搶跑”或“躺平”,提升訓練穩定性。

圖 1:loss 分布比較:EMER vs. 消融版本 EMER-NoEvolve

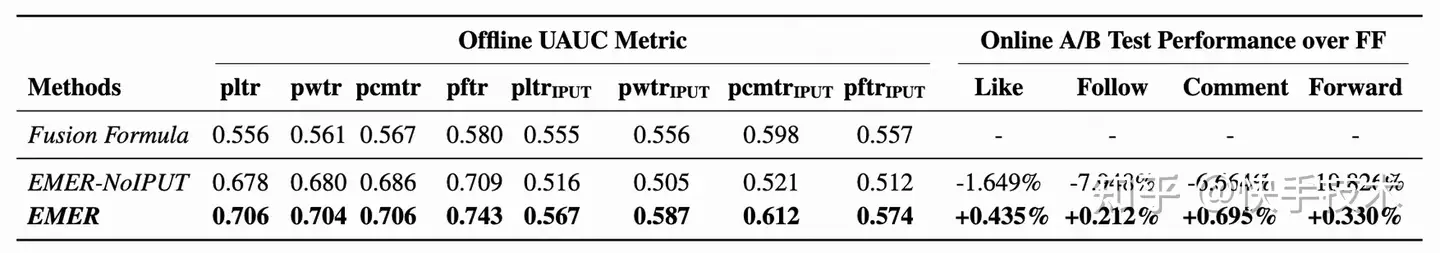

4. IPUT 對齊離線與線上效果

為驗證 IPUT(單位時間交互概率)的作用,構建 EMER-NoIPUT。相比之下,基于 IPUT 構建的 ,其離線增益與線上表現高度一致。這說明

IPUT 通過建模即時反饋密度,有效對齊了離線訓練目標與真實用戶滿意度,是保障模型實用性的關鍵設計。

4.5 度量分析

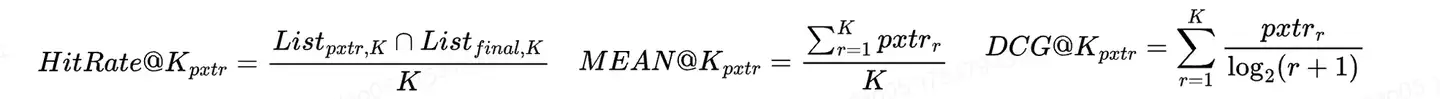

在自進化框架中,優勢評估器需準確判斷模型改進程度。我們對比了 HitRate@K 、MEAN@K 和 DCG@K 三種評估方式(以 pxtr 為正信號):

結果表明(見下表),DCG@K

在幾乎所有 GAUC 指標上表現最佳。因其同時考慮 item 相關性與排序位置,更能反映真實場景下的用戶注意力分布。最終,EMER 采用 DCG@K 作為優勢評估的默認指標,以確保模型向“高質量 item 前置”的方向優化。

五、總結

從 “人工調公式” 到 “AI 自進化”,EMER 為排序模型的優化帶來了一種全新范式。首次系統性提出個性化多目標排序場景下用戶滿意度缺乏統一監督信號、離在線指標不一致、候選集間關系建模不足三大核心難題。并提供了可落地、可驗證的一體化解決方案。

目前,EMER 已全面部署于快手主站和極速版單列場景,取得了顯著消費和留存收益,驗證其在真實業務場景中的實用性和大規模可落地性。我們仍在持續探索模型學習目標的優化,比如如何定義并挖掘更能代表用戶滿意度的信號。對于行業來說,這套 “可落地、可驗證” 的方案,或許能為更多企業的推薦系統優化,提供一份切實可行的參考。后續有進展也會發布出來跟大家交流。