我們距離GPT-4V真的很近了嗎? 原創

在 ChatGPT 引爆 AI 圈之后,很多人預言 2024 年將會是多模態的元年。的確,我們在 23 年的最后一季度見證了 GPT-4V 的發布,前不久Google 家的 Gemini 和 Anthropic 的 Claude 3 也同樣支持多模態(Multimodal to Text),并且 Gemini 1.5 中能夠從兩小時的視頻中準確“撈針”出其中一幀包含的畫面。

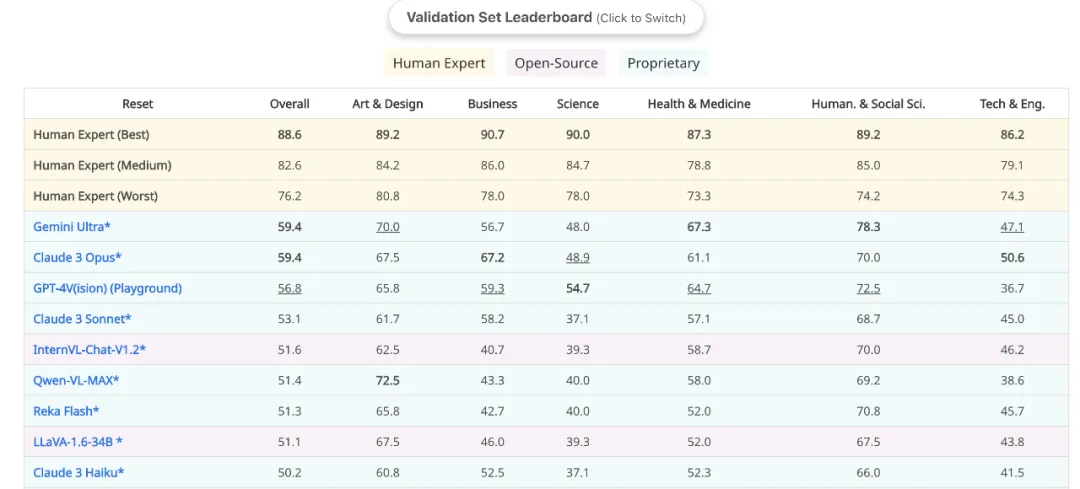

國內這方面的工作以 Qwen-VL 為代表,也同樣取得了非常不錯的效果。我們最近也在大視覺語言模型(LMM)做了一些嘗試,發布了 Reka Flash,能夠接受圖片、音頻和視頻的輸入,在 MMMU 上也靠著相對較小的基礎語言模型(21B)也排名能夠排名靠前(截至 2024 年 3 月 9 日,這各領域變化太快了誰知道明天會是什么樣呢哈哈),且 vibe test 下來感覺還行)。

但是我們真的距離 GPT-4V 很近了嗎?The Dawn of LMMs 展現了很多目前無法被 benchmark 分數所涵蓋的能力,似乎還在提醒著我們,前面的路還很長。這篇文章,我將嘗試結合自己的經歷和公開的資料,分享一下對未來視覺語言模型發展的一些想法。

01 Why LMMs?

?

為什么大家都會預測視覺語言模型會在 2024 年爆發?我覺得原因主要有兩點:

1. 視覺的基礎模型眾多 + 數據充足:CV 的自監督學習隨著 BERT 開始就已經有一系列工作,CLIP、MAE 、DINO 等能夠很好地編碼圖片,很好地起到了 visual tokenizer 的效果。

此外,應對上下文的限制,QFormer、Perceiever 也已經被廣泛地驗證了其有效性。除了純文本以外,圖文對也是少數我們能夠輕易獲取到的大量的數據 (e.g,Laion5B),image captioning 本質也是一種 next token prediction。

2. 應用場景廣泛:這個也很直接,日常生活中大多數數據的呈現方式就是,圖片 + 文本 -> 文本的范式能夠極大擴充模型處理任務的范圍。

另外,隨著大語言模型發展催生出的一系列 Agent 研究,在瀏覽網頁的時候會依賴 html 作為輸入。如果能夠直接讓 Agent 看到屏幕,輸出對應的操作坐標,更加簡潔優雅。進一步地,Deepmind 的 RT 2 也驗證了視覺語言模型能夠很快地遷移到諸如 robotic 場景,在 embodied 環境中發揮重要的作用。

這兩個條件可謂是大視覺語言模型發展的天時和地利,我們也同樣可以用這一條路徑來進一步驗壓縮即智能這一想法,看看這一框架是否能夠在具備了更豐富模態信息后,背后世界模型的學習速率是否會進一步加快。

關于這一點,之前我們的一個工作 VEC 就發現即使基于純文本 NTP 訓練的 LLMs 也能夠學習到視覺世界的一些基礎概念,但更 embodied 的一些知識則很難(或者以相當低的速率)被學習到,需要借助視覺語言模型來輔助學習。

02 模型架構

目前主流的 LMM 架構基本上是以大語言模型 LLM 為核心骨架,然后將圖片視覺信息整合到 LLM 的預測過程中,因而這個框架里一般有以下幾個組件:

1. 基座語言模型:負責處理多模態的 embedding,并且執行預測推理的功能。一般選擇能夠獲取到的最強、大小最合適的語言模型即可;

2. 視覺編碼器:負責將圖片信息編碼成一組向量,常用的選擇是 CLIP-style 的各個模型(e.g., CLIP-ViT-L/14),最新的 Prismatic VLM 表明,CLIP 得到的圖片表示缺少細粒度的信息,可以通過和另外的視覺編碼器結合來提升在 grounding 等任務上的性能。

3. 模態橋接(Modality Bridge):負責將視覺編碼器得到的圖片表示進行變換映射到新的空間方便 LLM 進行處理。這里的做法有一些不同的方案:

- Image as Word Embedding:一種經典的嘗試是將視覺編碼器得到的圖片向量通過簡單的 MLP 映射到對應的 word embedding 維度,隨后就可以將圖片作為多個 word embeddings 進行統一的處理。這一方面的局限是視覺編碼器的分辨率往往是固定且比較小的(224 和 336)。

?

而在很多場景下這樣的分辨率完全不夠用(OCR 識別、Agent 瀏覽等),可以通過 post-training 來提升圖片的分辨率也可以 bypass 掉 image encoder(沒有了預訓練分辨率的限制),直接將圖片切成小塊,隨后映射到 word embedding 空間。

Fuyu-8B 就是這樣一個思路,在高分辨率的場景下展現出了非常出色的性能。分辨率提升帶來的圖片向量數量平方級增長帶來的計算開銷,可以通過利用 QFormer 或者是 Perceiver 來映射到固定數量來解決。

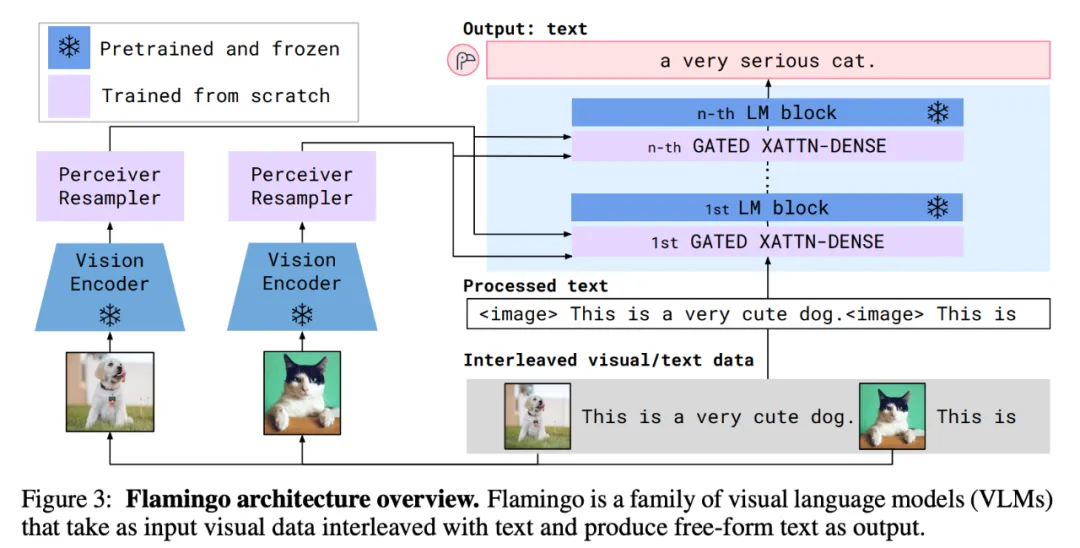

- Cross Attention to Visual Embedding:Deepmind 最早搞的 Flamingo就是通過在 LLM 中引入額外的 Gated Cross-Attention Layer,來在文本生成的過程中整合視覺端的信息:

這種方案對區分不同模態有著更加強的先驗,但后續看到的一些開源實現和改進,都很難超越前一種方案。如果訓練量足夠大,那么在前一種方案中 LLM 也能夠自適應地學習到這種先驗,因而我個人覺得這個方案或許在 2 年前是有道理,但在今天 scaling law 的暴力美學下,可能更少先驗,更多數據會是樸實且有效的方案。

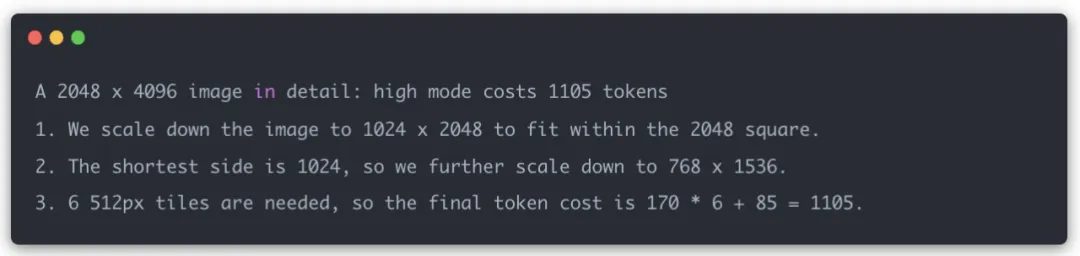

GPT-4V 是什么架構?雖然 tech report 里啥也沒說,但是我們從 GPT-4V 的收費計算的方式以及 API Doc,可能可以猜測一下背后視覺模塊的方案。收費模式分兩種:

- Low Resolution: 這種模式下圖片會被算作 85 input token 進行收費;

- High Resolution: 圖片首先在保持長寬比會被縮放 2K x 2K 的方塊內(花費 85 個 token)然后圖片的短邊將會被縮放到 768px,并且計算縮放后的圖片需要多少個 512 x 512 的 grid 來覆蓋。

- ?

官方給出的示例:

由此我們可以看到,一個 512 x 512 的 image tile 被 170 個 token 所表示。假設背后也是 VIT,那我們可以推測:

- 如果使用 QFormer 對輸出的 visual token 做降采樣,那原先的 visual tokens 在 300 - 1000 左右(參考 Qwen-VL 的 report,1024 個 patch 被壓縮到 256 個的效果相對最好),則意味著 VIT 的 patch size 最大可能是 28,最小可能是 16 的樣子;

- 如果沒有使用 QFormer 進行壓縮,那么以為著 512 x 512 的圖片可能被用了一個 40 的 patch size 。如果是用了這樣的 patch size,那么我們可以進一步推測 low resolution 原始的圖片可能會被統一放縮到 384 x 384 ,因此我們可以用差不多 85 個 token 來表示每個圖片。

最近開源的 LLaVA-Next 也采用了類似的方案,并且在一種 benchmark 上都取得了出色的性能,側面驗證了這種方法的有效性。還有一種是 adaptive 的搜索式的方案 V*,根據需要來切分圖片里的小塊重新交給模型,類似起到 re-attention 的效果,在小物體的檢測問題上面有很大的潛力。總的來說,這些方案都是為了解決輸入圖片分辨率不夠的問題。

03 數據

數據一直是這波大語言模型發展的重中之重,從訓練和測評的角度,目前我個人的感受是:

- LMM 依舊能夠通過構建高質量的訓練數據獲取性能躍遷的階段;

- LMM 測評基準有了不少進展,但是依舊無法比較全面的 cover 多模態的能力。多模態下的 language modeling loss 也許依舊是一個金指標。

訓練數據

?

我們大致的可以將訓練分成兩個階段:Modality Alignment Training 和 Supervised fine tuning(SFT),前者為了圖片映射到 LLM 的語義空間,而后者則是激發模型的能力來做各種下游任務。

Alignment Dataset: 這塊早先大家會用開源的 Laion400M 和 Laion5B 進行對齊訓練,但實際情況可能是這些數據集中的 image-text pair 都過于 noisy,對于學習模態的 alignment 效率并不高。

一種解決思路是對 alignment數據集進行更加細粒度的表述,進而能夠幫助模型更好地學習圖片中物體的相關位置等關系,和LLM原先的知識掛上鉤。ShareGPT4V 就是一個很好的嘗試,驗證了利用 GPT-4V 重新標注 image captions,就能夠帶來明顯的提升。除了 ShareGPT4V 以外,CapsFusion 也展現了用更豐富的 caption 帶來的提升。

SFT Dataset: 學術界開源的比較好的訓練數據目前主要是 LLaVA 系列,其利用 bounding box 等輔助信息將圖片文本化后,利用 ChatGPT/GPT-4 來生成了大量的 pseudo multimodal pair (detailed captioning, reasoning and conversation)。

這個范式非常有效,也是為什么 LLaVA 系列一出來效果很驚艷的原因。但他依舊存在著一些問題:

- 既然是 pseudo multimodal,那必然會引發 hallucination 問題(因為 ChatGPT 并沒有真正的 see the image)。這一點也是目前大家關注的重點。解決的方案有 LLaVA-RLHF,通過額外引入一個 Factual reward model 來提升 hallucination;Volcano 則是用 self-feedback 來 revise 輸出。或者更直接一點,我們用早先人工標注的數據做一下統一格式,在保真度方面就會有很大的提升,這方面我們做了 M3IT 來方便大家重新利用之前的數據集來做 SFT 。

- 任務的覆蓋面不夠廣,在重要的 OCR、Chart 場景下能力都有所欠缺。這點我們對比 Qwen、LLaVA 1.5 以及 LLaVA-Next 的性能就能看出來,使用了更多更豐富的多模態數據集,基本上都能對下游如 MMMU、MathVista 等測評數據集有所提升。

通過這些研究我們可以猜測,GPT-4V 背后一定是大量的數據工程,具體地可能體現在:

Alignment 端:相比于開源模型利用 CLIP 等作為 vision encoder,OpenAI 應該采用了強化版的 CLIP 模型(畢竟現在的 CLIP 還都是他們 2021 年的成果)。之前的 CLIP 不夠好的很大原因就在于圖片和文本的信息量不對等,caption 大多是簡單的幾個詞來描述物體,而圖片中則有豐富的顏色、位置等時空信息。

不妨可以想象一下,我們用現在的 GPT-4V 標注整個 web images(~ 10B level ?),提升文本端的豐富度并對 hallucination 做控制。在此數據集基礎上我們訓練一個 vision encoder,再迭代地更新 GPT-4V,相信會有一個明顯的提升;

SFT 端:我認為在足夠好的對齊 + 在基模型足夠強大這兩個條件下,可能只需要足夠多樣的(質量 >> 數量)的 prompting 數據就能夠在現在的 VQA、Captioning benchmark 上表現出色。因為客觀來說,現在的測評數據集也都集中在這兩個任務形式上,因此少量的 prompt 就能夠泛化到下游的數據集上。

測評基準

?

目前關注 LMM 測評的工作有很多,大致歸類一下:

綜合性 Benchmark:融合了各種多模態任務,綜合地評估 LMM 各個方面的能力,主要形式是 VQA,給定問題和圖片讓模型回答 Yes/No 或者是給出選項,代表的工作有 MME 還有 MM-Vet。

這里有一些有意思的事情是 MME 采用 Yes/No parsing 來評估,而 MM-Vet 則會采用 ChatGPT 打分的方式評估,前者其實對 GPT-4V 喜歡給出帶理由的回答的模型并不友好,模型可能回答正確但沒有被正確解析;而后者則容易傾向于 prefer ChatGPT style 的模型,偏好使用了接近數據的模型。

特定領域的 Benchmark:hallucination 是多模態更容易體現出來的一個問題,造成的潛在后果也挺大,這方面測評的 benchmark 像 POPE 和 MMHal。但是 POPE 有個問題這個數據集依賴于 COCO 的 tag,就我個人的經驗而言,那個 tag 的準確率并不高,POPE 上的分數因而會收到一定程度的影響。

此外,大家認為 math reasoning 可能是比較有挑戰性的任務,因此像 MMMU 和 MathVista 的關注度都比較高,目前 GPT-4V 也距離人類還是有很大差距。這塊我們最近的一個工作是意識到 ArXiv 上的很多 paper 天然也是多模態的,并且涵蓋了豐富的學科內容,因而我們構建了一個 Multimodal ArXiv,提供 captioning 和 QA (GPT-4V generated) 的數據集,能夠很有效地提升模型數學推理的能力。

這些基準上的分數依舊很難比較全面的反應模型的能力,模型會做題不代表這個模型可用性高。能夠給用戶體驗讓用戶有 wow 感覺的模型,才可能說真的是看到了 GPT-4V 的尾巴,而目前能做到這點的模型,還不多。

04 Future Directions

?

總體來看,我認為我們和 GPT4-V 的差距在于 (i) 基模型的指令跟隨和理解能力;(ii) 模態對齊的訓練質量和數量,以及 (iii) 多樣的 SFT 數據的構建。

其中 (i) 是國內很多公司和研究組努力的方向,相信在大伙的努力下我們會有一個強大的基模型,現在有的 Qwen 、Deepseek、Skywork 等系列模型都很有機會。

(ii) 目前開源出來數據集的量級還不夠大,而這件事情的投入(re-annotating the image world)應該也是巨大。但值得注意的是,DALLE 3 和 Sora 也是用了類似的方案來對 image/video的描述進行細節化,因而進一步提升了生成圖片和視頻的質量。做這件事情的意義可能對于我們去建模一個高分辨率的世界模型是有重大意義的。

(iii) 這件事情或許可以交給學術界來搞,定義和標注有意義的多模態任務,進而整合到 SFT 過程中即可。

除去這些看似比較 boring 的搞數據以外,還有什么值得探索的方向呢,這邊我也分析一些我個人比較感興趣的問題(帶貨環節):

1. LMM Hallucination 形成的原因?在文本領域的 Hallucination 的原因大家也都還在廣泛地討論中,那引入一個額外模態之后,hallucination 的來源會更多了嗎?是數據還是模型架構帶來的問題?如果我們能夠更清晰的看到模型內部的一些信號,或許會對理解這些問題更有幫助。

2. LMM 的安全性:ChatGPT 出來之后就有很多 Red Teaming 和 Jailbreaking的嘗試,那 GPT-4V 會不會也有這種安全性上的 concern 呢?

Red Teaming VLM 提供了一個很好的 benchmark 來做這方面的探索;此外,ImgTrojan 也發現之前 NLP 廣泛存在的后門攻擊同樣適用于 LMM,并且會成為更為隱蔽的特洛伊木馬來規避掉 safe alignment。這里后續的研究又可以進行攻擊、防御、消除的探索。

3. RLHF/DPO for LMM:前面提到的 alignment 和 sft 更多地還是依賴于人類標注的數據,當人類無法給出 ground-truth 的標注的時候,我們就需要構建一個 reward model 來告訴我們哪些回復是更合適的。

RLHF 和 DPO 已經在大語言模型上被驗證了有效性,但當存在額外的模態的時候,如何定義哪個回復是更好的(例如會有更多樣的偏見),如何更好地協調一致的 reward label 的標注等等都會帶來新的問題和挑戰。

我們的 VLFeedback 提供了一個很直給的方案,讓 GPT-4V 來標注不同的方面,并且也驗證了這個框架的有效性。但最近我們也發現 DPO 在不同基模型上的效果還不太一樣,依舊存在很多細節的問題,值得進一步的分析。

總的來說,LMM 在無論是學術界還是工業界,都依舊大有可為。

希望能和這一領域的研究者們一起,接近 GPT-4V,超越 OpenAI!

本文轉自 PaperWeekly ,作者:李磊