GitHub萬星NLP資源大升級:Pytorch和TF深度互操作,32個最新模型

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

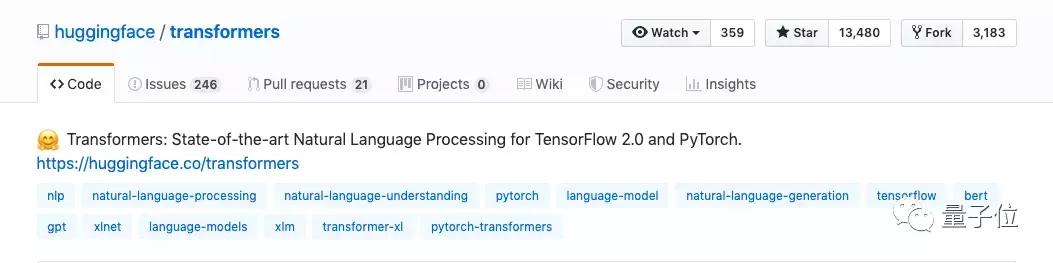

GitHub上最火的NLP項目,標星13000+,現在迎來重大更新。

剛剛, 抱抱臉(Hugging Face)團隊,放出了transformers 2.0版本。

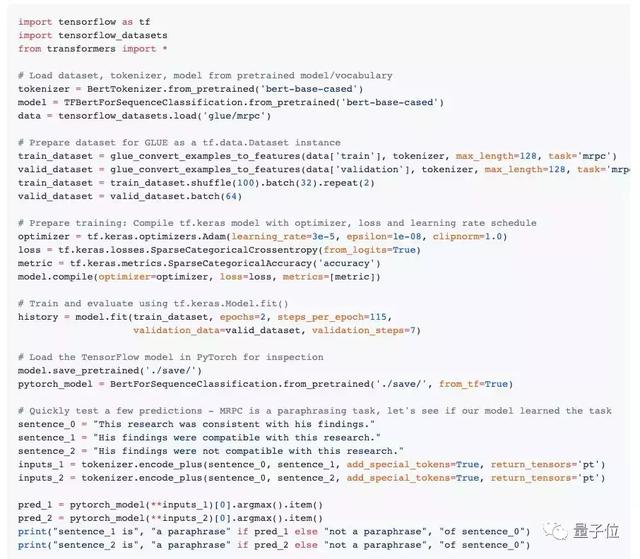

一方面,實現了TensorFlow 2.0和 PyTorch 之間的深度互操作性。

你可以在TPU上訓練模型,然后再Pytorch上測試,最后通過TensorFlow部署。

另一方面,也集成了超過32個經過100多種語言預訓練的模型。最新的NLP架構,比如BERT、GPT-2、XLNet、RoBERTa、DistilBert、XLM等等通通在內。

更新放出之后,業內人士紛紛送上各種感嘆:

This is so cool! Good job!、That’s awesome、Hot damn this is amazing!、Jesus christ.

transformers 2.0,最全的NLP庫

更直接一點說,transformers 2.0項目,就是一個NLP領域的SOTA的集合。

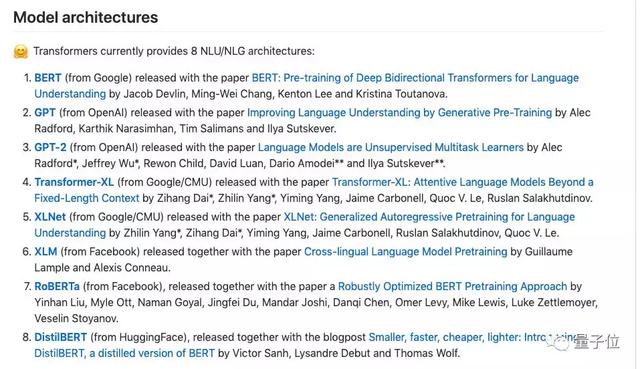

SQuAD排行榜上的選手們通通收編在內,一共有8大架構可供調用:

BERT、XLNet這幾位重量級選手自不必說。

最新鮮的RoBERTa、GPT-2 774M版本都已更新在列。

還有兩個XLM架構,它們在XNLI跨語言分類任務中擁有比多語言BERT更優秀的表現。

此外,還有抱抱臉自家的DistilBERT,這是一個更小、更快、更便宜、更輕量級的BERT蒸餾版。

七月底剛把BERT拉回GLUE榜首的RoBERTa也幾乎是在第一時間被整合到了pytorch-transformers庫中。

所有這些架構,都已經在SQuAD數據集上進行了測試,均與原始實現的性能相匹配。

在這些架構之下,一共有超過32個經過100多種語言預訓練的模型。

使用起來也非常方便,只需一個API,就能調用。

在線Demo,當場試用

NLP界的超強模型們到底有什么高招?抱抱臉也在官網上搭建了Write With Transformer,真·AI幫你在線寫論文,在線編故事。

不過,在線服務的模型只有GPT,GPT-2和XLNet。

想要完整使用整個Transformer庫,安裝也并不困難。

官方提供的repo已經在Python 2.7和3.5+、PyTorch 1.0.0+、TensorFlow 2.0.0-rc1中進行了測試。

在安裝了TensorFlow 2.0和/或PyTorch之后,可以通過pip安裝:

- pip install transformers

然后把庫克隆到本地:

- pip install [—editable] .

樣本測試則可以在pytest上運行:

- python -m pytest -sv ./transformers/tests/

- python -m pytest -sv ./examples/

甚至,你還可以在移動設備上運行這些模型,repo地址:

https://github.com/huggingface/swift-coreml-transformers

從pytorch-transformers到transformers

這一項目,一開始名為pytorch-pretrained-bert,在1.2版本時更名為pytorch-transformers,現在變為transformers。

從名字的變遷中,也能夠看出它的功能也越來越強大。在2.0版本中,實現了TensorFlow 2.0和 PyTorch 之間的深度互操作性,這也可能是在名字中去掉“pytorch-”的直接原因。

在GitHub項目中,他們也當場演示了如何用12行代碼訓練TensorFlow 2.0模型,然后將其放到PyTorch進行快速檢測和測試:

當然,這一庫還有更多強大的功能等待你發掘,如果你是NLP領域的從業者或者研究者,千萬不要錯過。

項目鏈接:

https://github.com/huggingface/transformers

關于抱抱臉

雖然看上去很萌,但Hugging Face可不是興趣小團體,而是個正經的AI創業公司。

他們的目標是建設真正的社會人工智能,并在這一過程中不斷貢獻技術力量。在NLP領域,他們的論文登上過ICLR,NeurIPS ,AAAI等國際頂會。

而他們在transformers這個廣受歡迎的項目上付出的持續努力,正是其堅持的體現,而且也已經贏得了廣泛的聲譽。

在看到transformers 2.0項目更新的時候,就有網友評論稱:

每次我聽到 Huggingface,就好像看到“悟空”(龍珠)從訓練營回來后的行動一樣。每個人都對他們的進步感到敬畏和難以置信。