訓練速度遠超3D CNN,提速3倍!Transformer

Facebook AI推出了全新的視頻理解架構TimeSformer,這也是第一個完全基于Transformer的視頻架構。視頻剪輯上限可達幾分鐘,遠遠超過當下最好的3D CNN,且成本更低。

TimeSformer即Time-Space Transformer,這是第一個完全基于Transformer的視頻架構,近年來已經成為許多自然語言處理(NLP)應用程序的主要方法,包括機器翻譯和通用語言理解。

論文鏈接:

https://arxiv.org/pdf/2102.05095.pdf

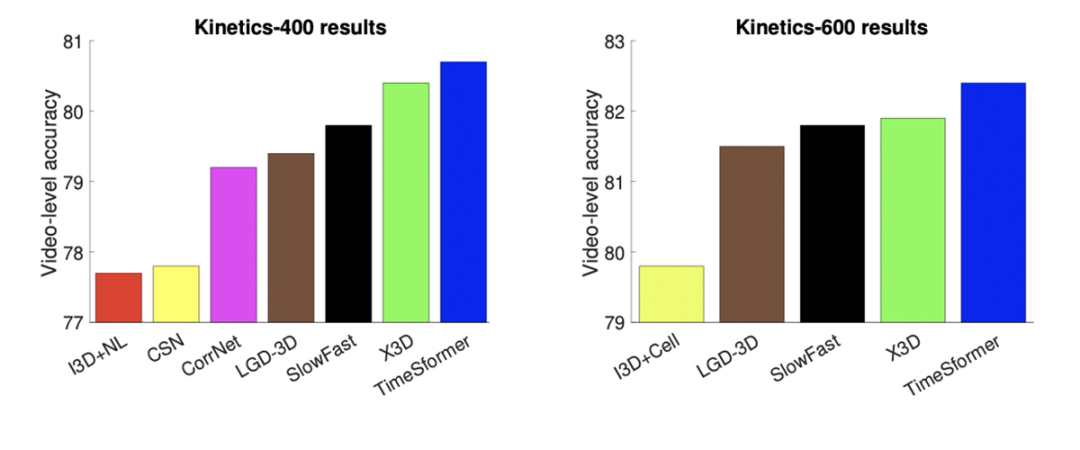

TimeSformer 在幾個難度系數比較高的動作識別基準上獲得了最好的效果,包括 Kinetics-400動作識別數據集。此外,與現代3D 卷積神經網絡(CNN)相比,TimeSformer 的訓練速度提高了大約3倍,推理所需計算量不到原來的十分之一。這是支持需要實時或按需處理視頻的應用程序的重要一步。

此外,TimeSformer具有可伸縮性,可以用來訓練更長的視頻剪輯中的更大模型。這使得人工智能系統可以理解視頻中更復雜的人類行為,例如涉及多個原子步驟的活動(修理汽車,準備食物等)。許多需要理解復雜人類行為的人工智能應用程序都能從中獲益。

TimeSformer 與先進的3D 卷積神經網絡在 Kinetics-400(左)和 Kinetics-600(右)動作識別基準上的視頻分類精度。TimeSformer在兩個數據集上都實現了最高的準確度。

分時空注意力

傳統的視頻分類模型利用3D 卷積濾波器。雖然這些濾波器在捕捉局部時空區域內的短期模式方面有效,但是它們不能對超出其接受域的時空依賴關系進行建模。

然而,TimeSformer完全建立在Transformer使用的自注意機制之上,這使得捕獲整個視頻的時空依賴性成為可能。

為了將Transformer應用于視頻,TimeSformer將輸入視頻解釋為從單個幀中提取的圖像塊的時空序列。這種格式類似于NLP中使用的格式,即Transformer將句子視為從單個單詞計算出來的特征向量序列。

正如NLP Transformer通過將每個單詞與句子中的所有其他單詞進行比較來推斷其含義一樣,這一模型通過將每個patch與視頻中的其他patch進行明確的比較來捕捉每個patch的語義。這使得捕獲相鄰patch之間的短期依賴以及遠距離patch之間的長期相關成為可能。

傳統的3D卷積神經網絡由于需要在視頻的所有時空位置上使用大量的濾波器,所以計算成本也很高。

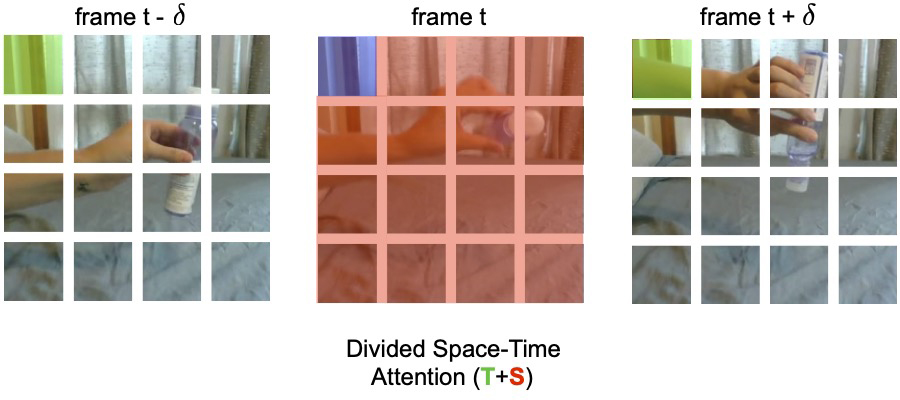

TimeSformer 通過1)將視頻分解成一小組不重疊的patch,2)應用一種自注意的形式,避免對所有patch進行詳盡的比較,從而保持了較低的計算成本。我們稱這種方案為「分時空注意力」。這個想法是依次應用時間注意力和空間注意力。

當應用時間注意力時,每個patch(例如,下圖中藍色正方形)僅與其他幀中同一空間位置的補丁(綠色的正方形)進行比較。如果視頻包含 t 幀,則只對每個patch進行 t次時間的比較。

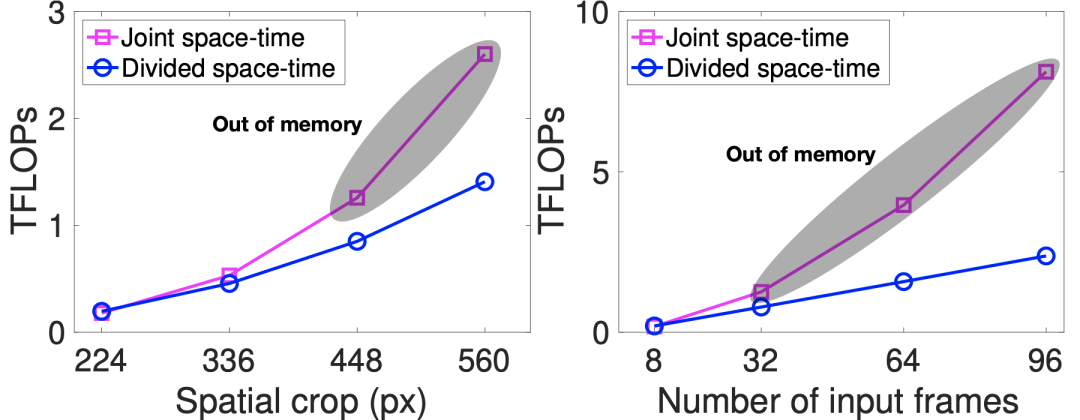

當應用空間注意力時,每個patch僅與同一框架內的patch(紅色補丁)進行比較。因此,如果 n 是每一幀中的patch數,分時空注意力在每個patch中只能執行(t + n)次比較,而聯合時空注意力窮舉法則需要(t * n)次比較。此外,該研究發現分時空注意不僅比聯合時空注意更有效率,而且更準確。

TimeSformer 具有可伸縮性,可以在非常長的剪輯上運行(例如,跨越102秒時間范圍的96幀序列) ,以便執行超長時間范圍的建模。這與目前的3D CNN有很大不同,后者僅限于處理最多幾秒的片段,而且是識別長時間活動的關鍵要求。

例如,看一段演示如何制作法式吐司的視頻。人工智能模型一次分析幾秒鐘可能會識別一些原子動作(例如,打雞蛋或者把牛奶倒進碗里)。但是對每個個體行為進行分類并不足以對復雜的活動進行分類(許多食譜都涉及到打蛋)。TimeSformer 可以在更長的時間范圍內分析視頻,揭示原子動作之間的清晰的依賴關系(例如,將牛奶和打碎的雞蛋混合)。

TimeSformer 的效率使得它能夠訓練高空間分辨率的模型(例如,幀高達560x560像素)和超長視頻(高達96幀)。這些圖表顯示視頻分類成本(TFLOPs)作為空間分辨率(左)和視頻長度(右)的函數。通過這些圖,我們可以觀察到,分散的時空注意力比耗盡的時空聯合注意力節省了大量的計算能力,特別是當應用于大幀或長視頻時。在實際應用中,當空間幀分辨率達到448像素或幀數增加到32幀時,聯合時空注意會導致 GPU 內存溢出,有效地使其不適用于大幀或長視頻。

該圖提供了 TimeSformer 學習的自注意力熱度圖的可視化。第一行顯示原始幀,第二行根據自注意力對視頻分類的重要性(被認為不重要的像素變暗)對每個像素的顏色進行加權。如圖所示,TimeSformer 學習關注視頻中的相關區域,以執行復雜的時空推理。

TimeSformer視頻剪輯上限可達幾分鐘

為了訓練視頻理解模型,現在最好的3D CNN只能使用幾秒鐘長的視頻片段。有了TimeSformer,我們可以訓練更長的視頻剪輯,最長可達幾分鐘。這可能極大地促進機器理解視頻中復雜的長動作的研究,這對于許多理解研究人類行為的人工智能應用程序來說是重要的一步。

此外,TimeSformer的低推理成本是支持未來實時視頻處理應用的一個重要步驟,如 AR/VR,或基于可穿戴攝像機拍攝的視頻智能助手。TimeSformer降低了成本,這將使更多的研究人員能夠解決視頻分析問題,從而加快這一領域的進展。