僅需2張圖,AI便可生成完整運(yùn)動(dòng)過(guò)程

本文經(jīng)AI新媒體量子位(公眾號(hào)ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

先給一張側(cè)臉(關(guān)鍵幀1):

再給一張正臉(關(guān)鍵幀2):

然后僅僅根據(jù)這兩張圖片,AI處理了一下,便能生成整個(gè)運(yùn)動(dòng)過(guò)程:

而且不只是簡(jiǎn)單的那種,連在運(yùn)動(dòng)過(guò)程中的眨眼動(dòng)作也“照顧”得很到位。

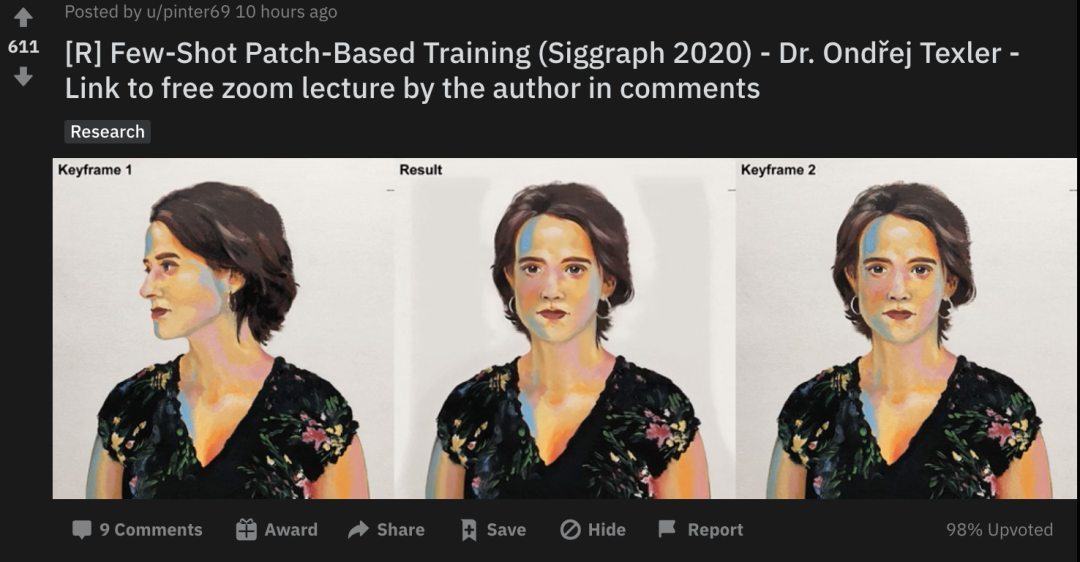

效果一出,便在Reddit上引發(fā)了不少熱議:

僅需2個(gè)關(guān)鍵幀,如何實(shí)現(xiàn)完整運(yùn)動(dòng)?

不需要冗長(zhǎng)的訓(xùn)練過(guò)程。

不需要大量的訓(xùn)練數(shù)據(jù)集。

這是論文作者對(duì)本次工作提出的兩大亮點(diǎn)。

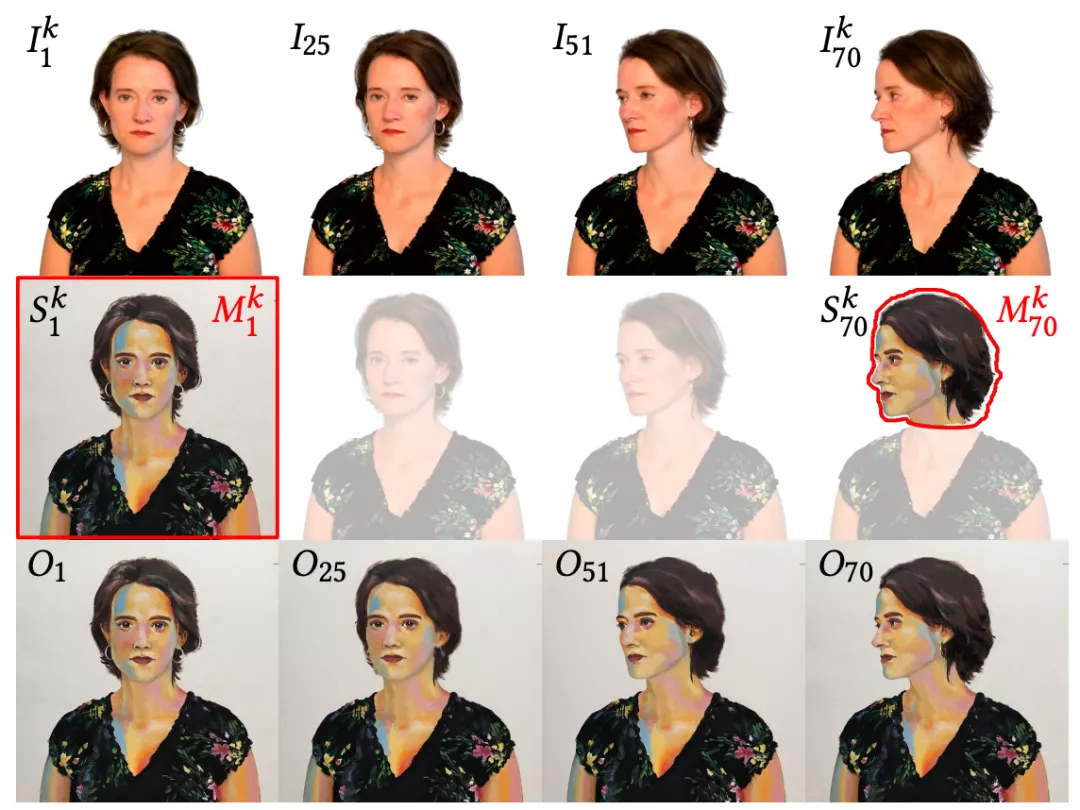

具體而言,這項(xiàng)工作就是基于關(guān)鍵幀將視頻風(fēng)格化。

先輸入一個(gè)視頻序列 I ,它由N個(gè)幀組織,每一幀都有一個(gè)掩膜Mi來(lái)劃分感興趣的區(qū)域。

與此前方法不同的是,這種風(fēng)格遷移是以隨機(jī)順序進(jìn)行的,不需要等待順序靠前的幀先完成風(fēng)格化,也不需要對(duì)來(lái)自不同關(guān)鍵幀的風(fēng)格化內(nèi)容進(jìn)行顯式合并。

也就是說(shuō),該方法實(shí)際上是一種翻譯過(guò)濾器,可以快速?gòu)膸讉€(gè)異構(gòu)的手繪示例 Sk 中學(xué)習(xí)風(fēng)格,并將其“翻譯”給視頻序列 I 中的任何一幀。

這個(gè)圖像轉(zhuǎn)換框架基于 U-net 實(shí)現(xiàn)。并且,研究人員采用基于圖像塊 (patch-based)的訓(xùn)練方式和抑制視頻閃爍的解決方案,解決了少樣本訓(xùn)練和時(shí)間一致性的問(wèn)題。

而為了避免過(guò)擬合,研究人員采用了基于圖像塊的訓(xùn)練策略。

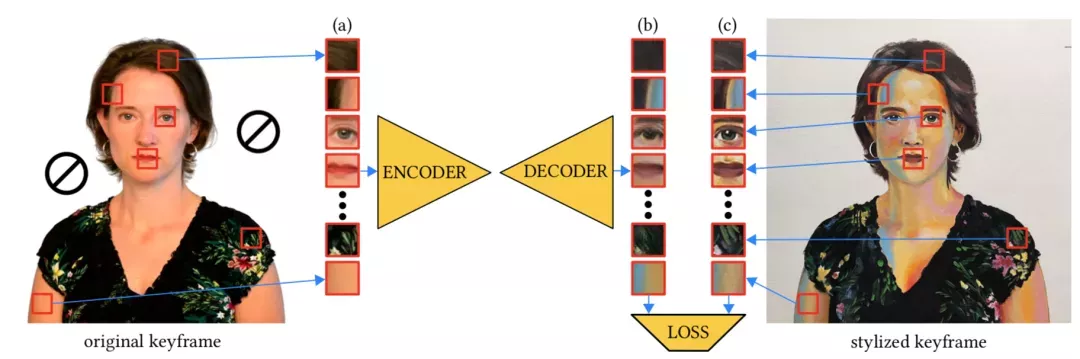

從原始關(guān)鍵幀(Ik)中隨機(jī)抽取一組圖像塊(a),在網(wǎng)絡(luò)中生成它們的風(fēng)格化對(duì)應(yīng)塊(b)。

然后,計(jì)算這些風(fēng)格化對(duì)應(yīng)塊(b)相對(duì)于從風(fēng)格化關(guān)鍵幀(Sk)中取樣對(duì)應(yīng)圖像塊的損失,并對(duì)誤差進(jìn)行反向傳播。

這樣的訓(xùn)練方案不限于任何特定的損失函數(shù)。本項(xiàng)研究中,采用的是L1損失、對(duì)抗性損失和VGG損失的組合。

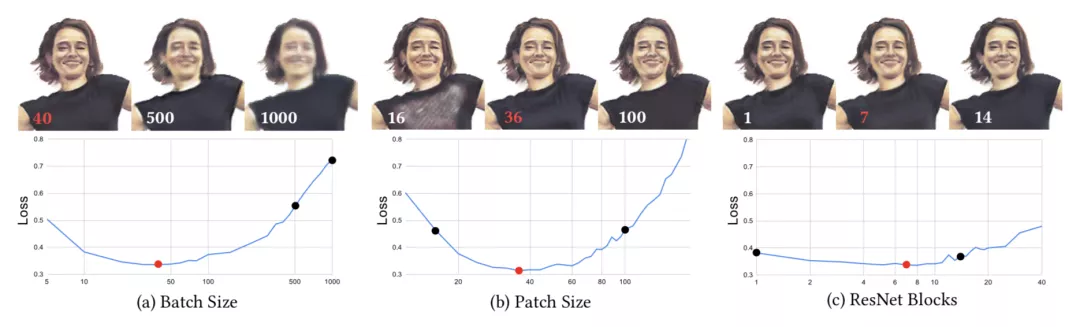

另一個(gè)問(wèn)題便是超參數(shù)的優(yōu)化。

這是因?yàn)椴划?dāng)?shù)某瑓?shù)可能會(huì)導(dǎo)致推理質(zhì)量低下。

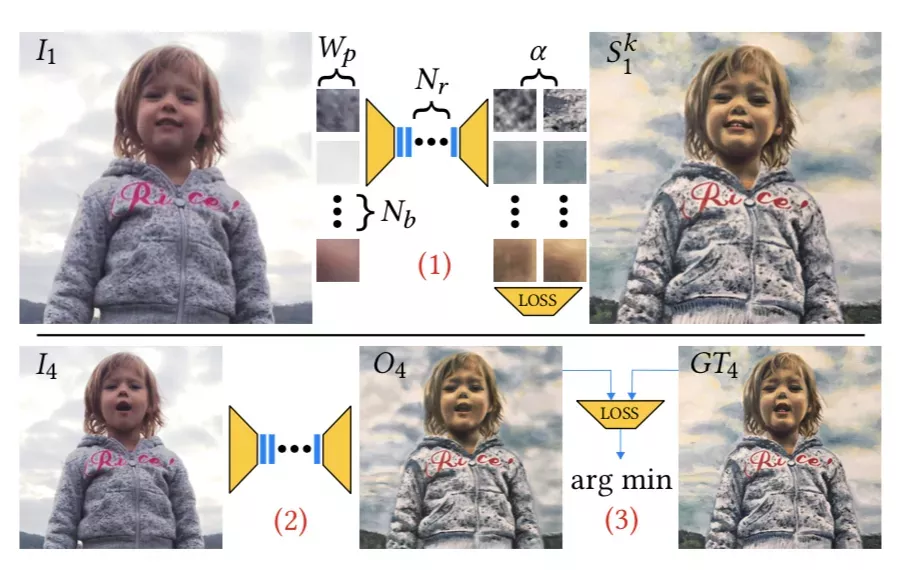

研究人員使用網(wǎng)格搜索法,對(duì)超參數(shù)的4維空間進(jìn)行采樣:Wp——訓(xùn)練圖像塊的大小;Nb——一個(gè)batch中塊的數(shù)量;α——學(xué)習(xí)率;Nr——ResNet塊的數(shù)量。

對(duì)于每一個(gè)超參數(shù)設(shè)置:

(1)執(zhí)行給定時(shí)間訓(xùn)練;

(2)對(duì)不可見幀進(jìn)行推理;

(3)計(jì)算推理出的幀(O4)和真實(shí)值(GT4)之間的損失。

而目標(biāo)就是將這個(gè)損失最小化。

團(tuán)隊(duì)介紹

這項(xiàng)研究一作為Ondřej Texler,布拉格捷克理工大學(xué)計(jì)算機(jī)圖形與交互系的博士生。

而除了此次的工作之外,先前他和團(tuán)隊(duì)也曾做過(guò)許多有意思的工作。

例如一邊畫著手繪畫,一邊讓它動(dòng)起來(lái)。

再例如給一張卡通圖片,便可讓視頻中的你頂著這張圖“聲情并茂”。

想了解更多有趣的研究,可戳下方鏈接。

參考鏈接:

[1]https://www.reddit.com/r/MachineLearning/comments/n3b1m6/r_fewshot_patchbased_training_siggraph_2020_dr/

[2]https://ondrejtexler.github.io/patch-based_training/index.html