清華AIR開源輕量版BioMedGPT!聶再清:最終目標是生物醫(yī)藥領(lǐng)域基礎(chǔ)大模型

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

生物醫(yī)藥研發(fā)領(lǐng)域,一個名為BioMedGPT-1.6B的輕量級科研版基礎(chǔ)模型剛剛開源。

參數(shù)16億,最大特點是跨模態(tài)與知識融合。

訓練數(shù)據(jù)中,包含分子、文獻、專利、知識庫等多尺度跨模態(tài)的生物醫(yī)藥大數(shù)據(jù),并融合分子結(jié)構(gòu)、知識圖譜和文獻文本中的知識,用于增強模型的泛化能力和可解釋性。

應用任務上,BioMedGPT-1.6B則展現(xiàn)出了通用能“打”的效果,可以處理藥物性質(zhì)預測、自然語言類、跨模態(tài)等多種任務。

打造這個BioMedGPT-1.6B生物醫(yī)藥基礎(chǔ)模型的團隊,來自清華智能產(chǎn)業(yè)研究院(AIR)。

項目負責人聶再清,清華大學國強教授、AIR首席研究員,主要研究領(lǐng)域是大數(shù)據(jù)與AI的前沿創(chuàng)新,以及在健康醫(yī)療領(lǐng)域的產(chǎn)業(yè)應用,更早之前則以阿里達摩院大牛、天貓精靈首席科學家為人熟知。

△聶再清

此次開源的BioMedGPT-1.6B,其實是他和團隊正在做的BioMedGPT的單機輕量版,后者是一個適用于生物醫(yī)藥領(lǐng)域研發(fā)的通用大模型。

1.6B版本先行開源,目的是小試牛刀,同時讓行業(yè)相關(guān)科研人員有東西可用。

所以,這個BioMedGPT究竟是做什么的,團隊目前進展如何?在業(yè)界已有不少生物醫(yī)藥專業(yè)大模型的情況下,做通用大模型的考量是什么,又要如何去做?

聶再清教授向我們解答了背后的思考。

生物醫(yī)藥版GPT,也應具備“涌現(xiàn)”潛力

先來看看BioMedGPT究竟是個什么項目,進展到了哪一階段。

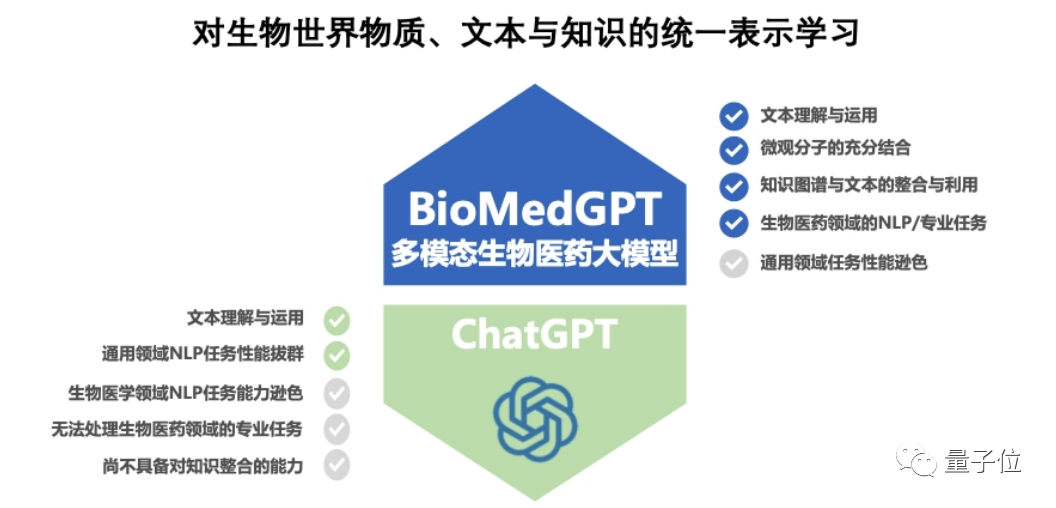

聶再清教授認為,就像ChatGPT成為了NLP領(lǐng)域的基礎(chǔ)大模型一樣,BioMedGPT也會成為生物醫(yī)藥領(lǐng)域的基礎(chǔ)大模型。

但在這里,“像ChatGPT”并不僅僅意味著BioMedGPT=生物醫(yī)學大模型+對話能力,而是和ChatGPT一樣,會出現(xiàn)智力涌現(xiàn)的情況。

只不過,這里的“智力”,指的是生物醫(yī)學領(lǐng)域方面知識的理解、規(guī)律的發(fā)現(xiàn)與靈感的啟迪。

這個基礎(chǔ)模型的底座能夠給藥物發(fā)現(xiàn)、分子/蛋白質(zhì)設(shè)計等應用提供底層能力,同時能夠成為生物醫(yī)藥研究者的助手(Copilot)輔助研究者更高效的開展研究探索。

所以,能實現(xiàn)這種效果的BioMedGPT,架構(gòu)上究竟長啥樣?

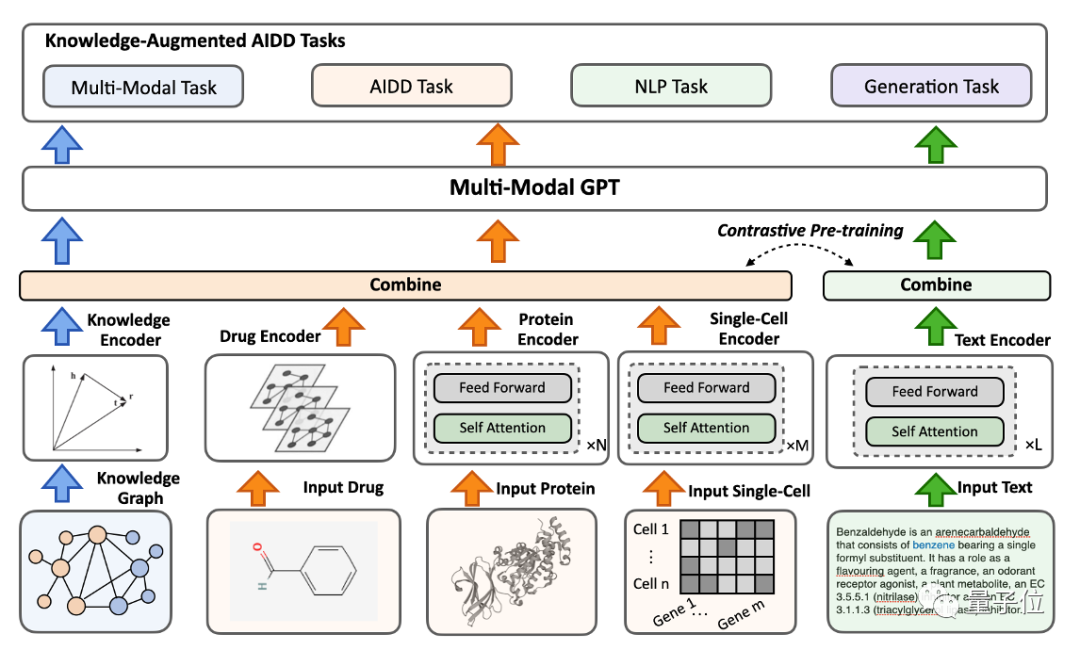

整體來看,它是一個具備多個輸入Encoder的模型,這些Encoder會先分別處理不同模態(tài)的輸入,如分子、蛋白質(zhì)和文獻等。

然后,將這些不同模態(tài)的輸入,進行統(tǒng)一表示處理,這樣就能學習到不同模態(tài)之間的關(guān)聯(lián)知識。

這給了模型“融會貫通”的能力,既可以讀文獻、查專利,又可以讀分子序列、蛋白結(jié)構(gòu)、實驗數(shù)據(jù)。

不僅如此,BioMedGPT也是首個將多模態(tài)知識引入模型構(gòu)建的項目,通過知識圖譜的方式將生物醫(yī)藥領(lǐng)域的知識注入到模型中,以增強模型的泛化能力和可解釋性,同時能夠應對科研領(lǐng)域知識的快速更迭,讓模型持續(xù)學習,變得更“聰明”。

基于這種融會貫通與知識增強的能力,BioMedGPT在下游的多項任務中表現(xiàn)出了整體的效果提升。

目前團隊已經(jīng)完成了實驗驗證階段,用一個比較小的端到端模型證明了這種思路的可行性。

那么最終能在生物醫(yī)藥方面表現(xiàn)出“智力涌現(xiàn)”的模型,預計在什么規(guī)模?

聶再清教授認為,模型參數(shù)量級預計在幾百億左右,而訓練這一模型達成“涌現(xiàn)”效果的數(shù)據(jù)量,幾十億到百億級應該也就夠了。

事實上,在ChatGPT出現(xiàn)之前,也就是一年多以前,聶再清和團隊就已經(jīng)在籌備這一項目,目前清華AIR生命科學相關(guān)團隊規(guī)模已經(jīng)達到50人左右。

對于BioMedGPT的未來,聶再清教授很有信心:

預計兩年內(nèi),這個模型應該會在小范圍內(nèi)具備一定影響力,至于像ChatGPT那樣成為行業(yè)通用大模型,做到那樣的影響力可能至少還需要3~5年。

但即便如此,BioMedGPT模型究竟能否成功,目前仍舊是一個未知數(shù)。

同時對于大模型訓練必不可少的算力和數(shù)據(jù)等方面,也仍然是業(yè)界關(guān)注的話題。

對于這些觀點和想法,聶再清教授又是如何看待的?

“一個理性而大膽的嘗試”

大模型的發(fā)展和AI技術(shù)的更迭組成了ChatGPT為首的一波AI新浪潮。

但早在聶再清教授動念要將生物醫(yī)藥學科知識“塞”進大模型里時,ChatGPT還沒打破沉寂。

所以為什么要做?為什么敢做?

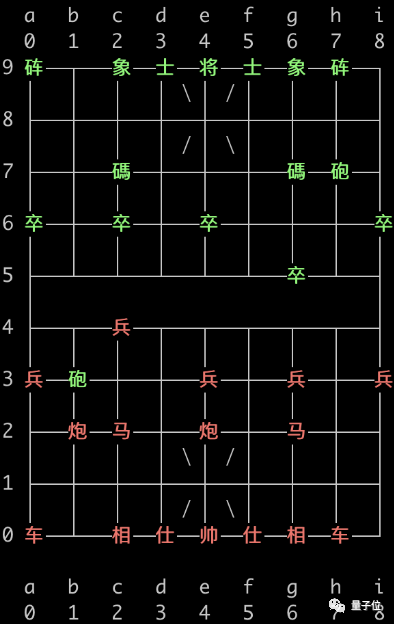

時間回到ChatGPT刮大風之前。當時,GPT-2已經(jīng)可以編故事,下象棋;等到1750億參數(shù)GPT-3出現(xiàn),已經(jīng)博得眾人矚目:不僅延續(xù)了前代編故事的能力,還能寫代碼、答問題……

利用大規(guī)模文本數(shù)據(jù)學習語言知識和規(guī)律,加上狂疊參數(shù)的暴力美學,GPT-3已經(jīng)在通用領(lǐng)域任務中出現(xiàn)涌現(xiàn)能力,到GPT-3.5,基本的邏輯推理能力突然出現(xiàn)。

在生物和化學領(lǐng)域,生命的本質(zhì)可以看做一種精密的編碼語言,尤其是生命科學領(lǐng)域中微觀世界的分子序列數(shù)據(jù)。

聶再清教授認為,自然語言同樣也是一種非常精密的序列,缺一點或少一絲都會讓意思變得不一樣,因此二者具有類似的特征。

基于此,大模型的底層思想或許有用于生命科學微觀數(shù)據(jù)處理的可能。如果能實現(xiàn),就能利用生物醫(yī)藥領(lǐng)域的專業(yè)知識,幫助完成科研任務。

工作正式開始之前,團隊將微觀(基因、分子、蛋白質(zhì)、細胞)與文獻知識壓縮到一個端到端的模型里,用實驗驗證了這條思路的可能性——確實在部分藥物研發(fā)關(guān)鍵下游任務中取得SOTA效果。

于是,做一個適用于生物醫(yī)藥領(lǐng)域研發(fā)的基礎(chǔ)大模型這事,正式開始了。

此前,無論是單獨針對分子、蛋白質(zhì)還是生物醫(yī)藥領(lǐng)域文獻,都有團隊單獨打造過大模型,但還沒有人做一個行業(yè)通用的多模態(tài)版本。而現(xiàn)在的開源版本BioMedGPT-1.6B,并非一個接近AGI甚至與ChatGPT能力媲美的版本。

“畢竟大家的期待比較高,我們還是要把期待降下來,”聶再清教授解釋選擇現(xiàn)在向外界告知進度的原因,大方表示目前還達不到理想狀態(tài)的能力,“實際上,我們最主要還是想把現(xiàn)有工作服務到正在進行相關(guān)研究的科研人員。”

但這樣的嘗試,被聶再清教授稱為一種理性而大膽的選擇。

理性,是因為通過實驗,確實發(fā)現(xiàn)人類知識經(jīng)過encoder后,能夠產(chǎn)生幫助;大膽,是因為一方面還未完全證明這個工作的商業(yè)實用價值,工作還在初步階段,模型的規(guī)模和模態(tài)的種類都有待擴大。

但在這個樂觀的估計下,工作還是推進了;不僅推進,還快速拿出了輕量級版本。

樂觀倒不是因為沒由來的盲目,聶再清教授表示,數(shù)據(jù)、算力和成本上,BioMedGPT暫時都不存在什么擔憂:

數(shù)據(jù)質(zhì)量上,生物醫(yī)學領(lǐng)域的論文和專利質(zhì)量“還是很高的”,不必過于擔心訓練語料質(zhì)量不高的情況,并且目前已公開的PubMedQA等數(shù)據(jù)集,數(shù)據(jù)量“已經(jīng)足夠”。

同時,團隊集合了具有生物醫(yī)學專業(yè)背景的同學,對數(shù)據(jù)集的構(gòu)建做了精細專業(yè)的設(shè)計和專業(yè)的標注。

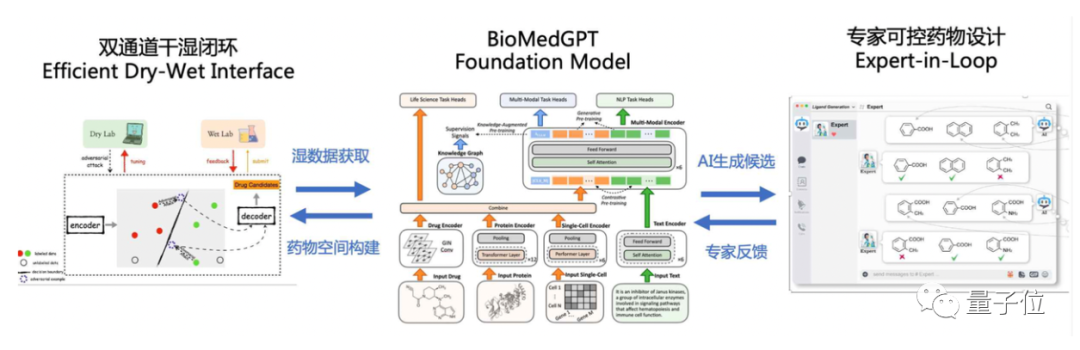

當然,還有一些任務所需的私有數(shù)據(jù),BioMedGPT希望通過未來的雙通道干濕閉環(huán)得到補充。

算力層面,聶再清教授是這樣表示的:

目前國內(nèi)敢跳出來宣布入局大模型的團隊,背后肯定已經(jīng)有足夠的算力支撐規(guī)劃。

數(shù)據(jù)豐富但公開,算力稀缺但不是無法解決,日后入局者紛至沓來,是不是會在壁壘很薄的情況下形成不必要的行業(yè)競爭?

聶再清教授表示了對這個問題的否定,他認為做的人越多,意味著關(guān)注度越高,最終的結(jié)果就是利好行業(yè)內(nèi)所有的AI制藥公司。

最后,我們也朝聶再清教授拋出了那個靈魂問題——

生物醫(yī)藥研發(fā)階段,一切都容不得半點差錯,怎么約束大模型的幻覺?

聶再清教授說了段繞口令般的話:

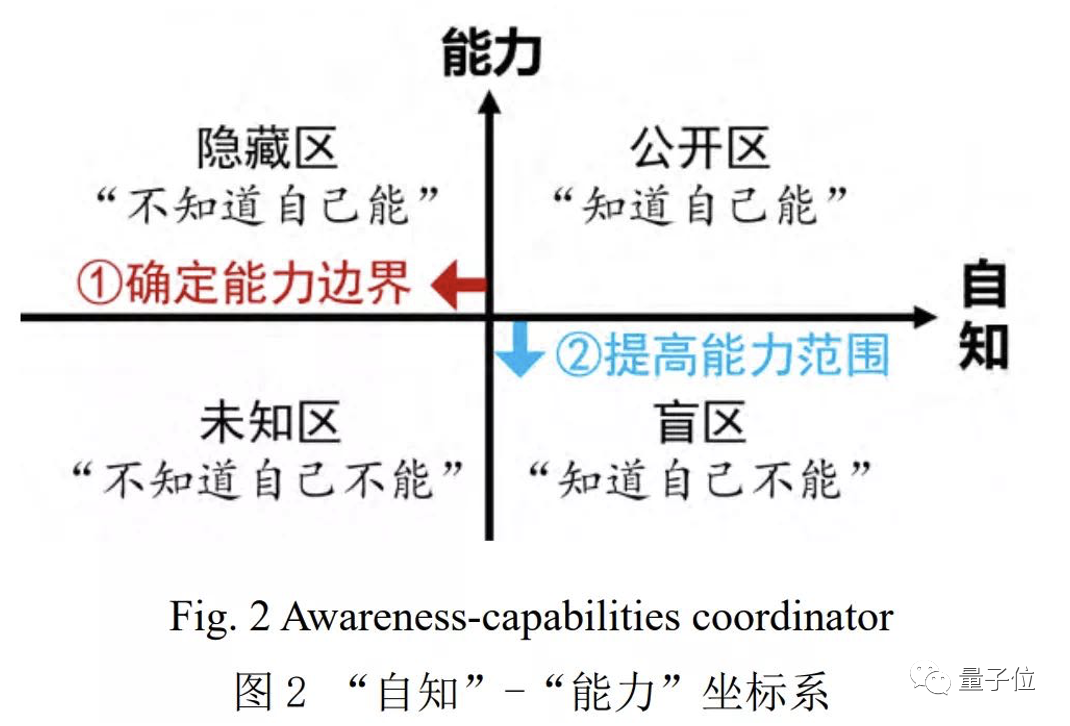

我們當然希望,大模型知道“自己知道什么事”,也知道“它知道自己不知道什么事”。但,目前確實也會出現(xiàn)大模型“不知道自己不知道”的情況。

而大模型“不知道自己不知道”,就是我們常見的大模型幻覺——它以為自己知道,其實它不知道。

針對生物醫(yī)藥領(lǐng)域解決的思路,是通過兩個閉環(huán)來實現(xiàn)對模型的“糾偏”。?

干濕實驗驗證通過濕實驗,將模型真實性趨近物理真實世界;專家在環(huán)可控的設(shè)計,則通過專家instruct,讓模型與人類專家認知趨近。

換言之,通過“做實驗”和“跟專家學”兩個環(huán)路,讓AI模型幻覺降低。

聶再清與團隊的下一站,就是通過兩個閉環(huán),盡可能擴大“大模型知道自己能做啥”的范圍,以進一步降低大模型“不知道自己不知道”的比例。

對于此次開源,中國工程院院士、清華大學講席教授、AIR院長張亞勤院士表示:

將大模型范式應用于生命科學是理性又大膽的探索。

AIR的研究團隊以構(gòu)建生物醫(yī)藥領(lǐng)域大模型為目標,相繼研發(fā)了多個生物醫(yī)藥專業(yè)領(lǐng)域的AI模型,在蛋白質(zhì)結(jié)構(gòu)預測、抗體設(shè)計等領(lǐng)域取得了不錯的成果。

此次開源的輕量級科研版基礎(chǔ)模型BioMedGPT-1.6B是在生命科學領(lǐng)域的重要進展。

未來,研究團隊將繼續(xù)用BioMedGPT進一步整合領(lǐng)域內(nèi)多源異構(gòu)的數(shù)據(jù),將知識融入模型構(gòu)建之中,實現(xiàn)生物世界文本和知識的統(tǒng)一表示學習,帶來生物醫(yī)藥領(lǐng)域的“智能涌現(xiàn)”。?

?開源地址:https://github.com/BioFM/OpenBioMed