大語(yǔ)言模型的進(jìn)化樹(shù),這是一份超詳細(xì)ChatGPT「食用」指南

而在實(shí)際探索的過(guò)程中,實(shí)踐者可能會(huì)苦于尋找適合自己應(yīng)用的 AI 模型:是選擇 LLM 還是微調(diào)模型?如果用 LLM,又該選擇哪一種?

近日,來(lái)自亞馬遜、德州農(nóng)工大學(xué)、萊斯大學(xué)等機(jī)構(gòu)的學(xué)者對(duì) ChatGPT 等語(yǔ)言模型的發(fā)展歷程進(jìn)行了一番討論,其文章也得到了 Yann LeCun 的轉(zhuǎn)推。

論文:https://arxiv.org/abs/2304.13712

相關(guān)資源:https://github.com/Mooler0410/LLMsPracticalGuide

本文將從實(shí)際應(yīng)用角度出發(fā),探討適用 LLM 的任務(wù)以及在選擇模型時(shí)需要考慮的模型、數(shù)據(jù)和任務(wù)等方面實(shí)際問(wèn)題。

1 引言

近年來(lái),發(fā)展迅猛的大型語(yǔ)言模型(LLM)已然引發(fā)了自然語(yǔ)言處理(NLP)領(lǐng)域的革命。這些模型非常強(qiáng)大,有望解決許多不同種類的 NLP 任務(wù) —— 從自然語(yǔ)言理解(NLU)到生成任務(wù),甚至鋪就了通往通用人工智能(AGI)之路。但是,為了有效且高效地利用這些模型,我們需要立足實(shí)際地理解它們的能力和局限,還要理解 NLP 所涉及的數(shù)據(jù)和任務(wù)。

這篇論文重點(diǎn)著眼于在下游 NLP 任務(wù)中實(shí)際應(yīng)用 LLM 的各個(gè)方面,以給實(shí)踐者和最終用戶提供指引。本指南的目標(biāo)是為讀者提供實(shí)際有用的建議,以助其了解是否應(yīng)該為給定任務(wù)選用 LLM 以及如何選擇最適用的 LLM—— 這其中需要考慮諸多因素,比如模型大小、計(jì)算需求、具體領(lǐng)域是否已有預(yù)訓(xùn)練模型等。本文還會(huì)從實(shí)際應(yīng)用角度介紹和解釋 LLM,這些實(shí)用知識(shí)能助力實(shí)踐者和最終用戶成功利用 LLM 的力量來(lái)解決他們自己的 NLP 任務(wù)。

本文的結(jié)構(gòu)為:本文首先會(huì)簡(jiǎn)要介紹 LLM,其中主要會(huì)討論最重要的 GPT 式和 BERT 式架構(gòu)。然后會(huì)深入介紹數(shù)據(jù)方面影響模型性能表現(xiàn)的關(guān)鍵因素,包括預(yù)訓(xùn)練數(shù)據(jù)、訓(xùn)練數(shù)據(jù) / 調(diào)優(yōu)數(shù)據(jù)、測(cè)試數(shù)據(jù)。在最后也是最重要的部分,本文會(huì)深入各種具體的 NLP 任務(wù),介紹 LLM 是否適用于知識(shí)密集型任務(wù)、傳統(tǒng) NLU 任務(wù)和生成任務(wù),此外還會(huì)描述這些模型不斷獲得的新能力以及具有挑戰(zhàn)性的現(xiàn)實(shí)世界應(yīng)用場(chǎng)景。我們會(huì)提供詳細(xì)的案例,以彰顯 LLM 在實(shí)踐中有用和有局限的地方。

為了分析大型語(yǔ)言模型的能力,本文會(huì)將它們與微調(diào)模型(fine-tuned model)進(jìn)行比較。對(duì)于 LLM 和微調(diào)模型的定義,目前而言我們還沒(méi)有一個(gè)得到廣泛認(rèn)可的標(biāo)準(zhǔn)。為了實(shí)際有效地區(qū)分,本文給出的定義如下:LLM 是指在大規(guī)模數(shù)據(jù)集上預(yù)訓(xùn)練得到的大型語(yǔ)言模型并且沒(méi)有針對(duì)具體任務(wù)調(diào)整數(shù)據(jù);微調(diào)模型則通常更小一些,它們?cè)诮?jīng)過(guò)預(yù)訓(xùn)練后還會(huì)在更小的具體任務(wù)數(shù)據(jù)集上做進(jìn)一步微調(diào),以優(yōu)化它們?cè)谠撊蝿?wù)上的表現(xiàn)。

本文總結(jié)了在以下方面使用 LLM 的實(shí)用指南:

- 自然語(yǔ)言理解。當(dāng)實(shí)際數(shù)據(jù)不在訓(xùn)練數(shù)據(jù)的分布范圍內(nèi)或訓(xùn)練數(shù)據(jù)非常少時(shí),可利用 LLM 那出色的泛化能力。

- 自然語(yǔ)言生成。使用 LLM 的能力為各種應(yīng)用創(chuàng)造連貫的、上下文相關(guān)的和高質(zhì)量的文本。

- 知識(shí)密集型任務(wù)。利用 LLM 中存儲(chǔ)的廣博知識(shí)來(lái)處理需要特定專業(yè)知識(shí)或一般性世界知識(shí)的任務(wù)。

- 推理能力。理解和利用 LLM 的推理能力來(lái)提升各種情形中制定決策和解決問(wèn)題的能力。

2 模型方面的實(shí)用指南

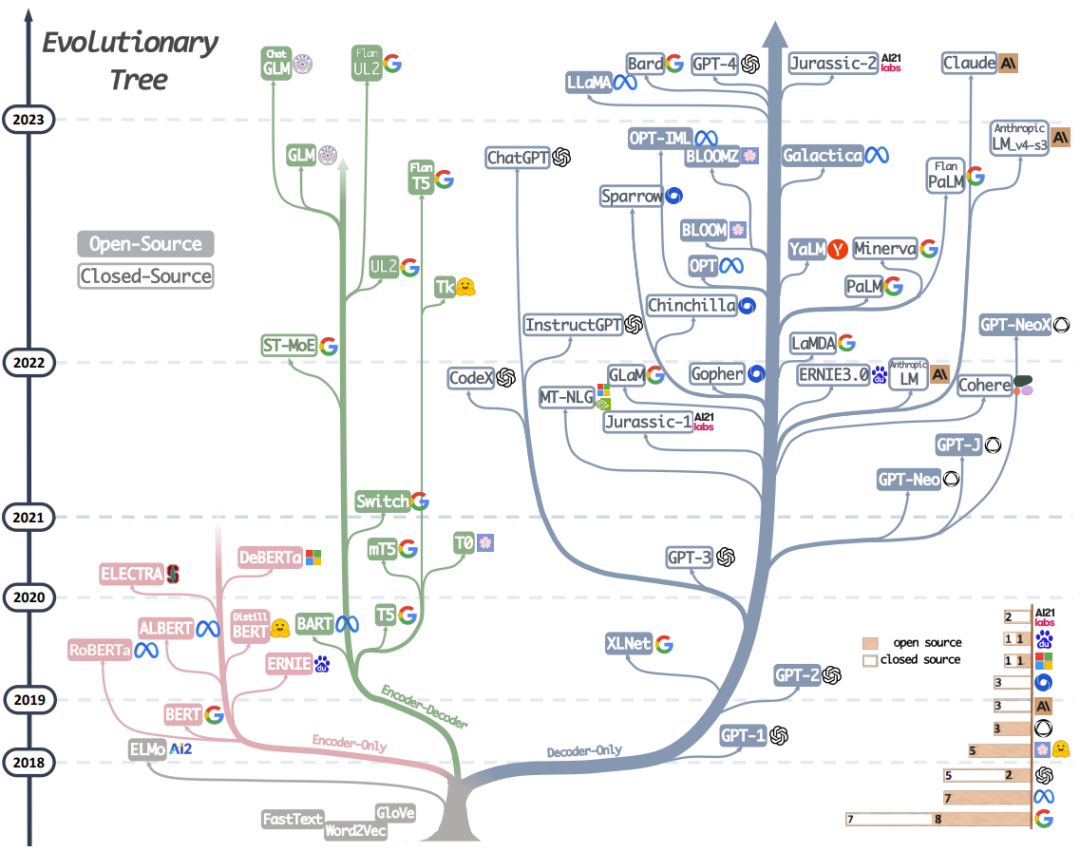

圖 1:這幅現(xiàn)代 LLM 的進(jìn)化樹(shù)追溯了近些年語(yǔ)言模型的發(fā)展歷程,其中重點(diǎn)凸顯了某些最知名的模型。同一分支上的模型關(guān)系更近。基于 Transformer 的模型都不用灰色表示:僅解碼器模型是藍(lán)色分支,僅編碼器模型是粉色分支,編碼器 - 解碼器模型是綠色分支。模型在時(shí)間軸的豎直位置表示其發(fā)布時(shí)間。實(shí)心方塊表示開(kāi)源模型,空心方塊則是閉源模型。右下角的堆積條形圖是指各家公司和機(jī)構(gòu)的模型數(shù)量。

這一節(jié)會(huì)簡(jiǎn)要介紹當(dāng)前表現(xiàn)最佳的 LLM。這些模型有著各不相同的訓(xùn)練策略、模型架構(gòu)和用例。為了更清晰地理解 LLM 的整體圖景,我們可將其分為兩大類:編碼器 - 解碼器或僅編碼器(encoder-only)語(yǔ)言模型和僅解碼器(decoder-only)語(yǔ)言模型。圖 1 詳細(xì)展示了語(yǔ)言模型的演化過(guò)程。基于這幅進(jìn)化樹(shù),我們可以觀察到一些有趣的結(jié)論:

a)僅解碼器模型正逐漸成為 LLM 發(fā)展的主導(dǎo)模型。在 LLM 的早期發(fā)展階段,僅解碼器模型的流行程度趕不上僅編碼器和編碼器 - 解碼器模型。但在 2021 年之后,GPT-3 的出現(xiàn)改變了行業(yè)圖景,僅解碼器模型經(jīng)歷了爆發(fā)式的發(fā)展。與此同時(shí),BERT 也為僅編碼器模型帶來(lái)了初始的爆發(fā)式增長(zhǎng),但在那之后,僅編碼器模型卻漸漸淡出了視野。

b)OpenAI 持續(xù)保持著其在 LLM 方向上的領(lǐng)先地位,現(xiàn)在如此,未來(lái)很可能也是如此。為了開(kāi)發(fā)可與 GPT-3 和 GPT-4 媲美的模型,其它公司和機(jī)構(gòu)正在奮力追趕。OpenAI 的領(lǐng)先地位可能需要?dú)w功于其在技術(shù)上持續(xù)不懈的投入,即便該技術(shù)在早期時(shí)并未得到廣泛認(rèn)可。

c)Meta 在開(kāi)源 LLM 和推動(dòng) LLM 研究方面貢獻(xiàn)卓越。在對(duì)開(kāi)源社區(qū)(尤其是與 LLM 相關(guān)的)的貢獻(xiàn)方面,Meta 尤為突出,是最慷慨的商業(yè)公司之一,因?yàn)?Meta 開(kāi)源了其開(kāi)發(fā)的所有 LLM。

d)LLM 開(kāi)發(fā)有閉源的趨勢(shì)。在 LLM 發(fā)展的早期階段(2020 年之前),絕大部分模型都是開(kāi)源的。但是,隨著 GPT-3 的推出,公司越來(lái)越傾向于選擇閉源他們的模型,比如 PaLM、LaMDA 和 GPT-4。也因此,學(xué)術(shù)研究者越來(lái)越難以進(jìn)行 LLM 訓(xùn)練實(shí)驗(yàn)。這就導(dǎo)致了一個(gè)結(jié)果:基于 API 的研究可能會(huì)成為學(xué)術(shù)界的主導(dǎo)方法。

e)編碼器 - 解碼器模型依然有發(fā)展前景,因?yàn)楣竞蜋C(jī)構(gòu)依然在積極探索這類架構(gòu),并且大部分模型都是開(kāi)源的。谷歌在開(kāi)源編碼器 - 解碼器方面有重大貢獻(xiàn)。但是,由于僅解碼器模型的靈活性和通用性,谷歌在這個(gè)方向上堅(jiān)持成功的希望似乎更小一些。

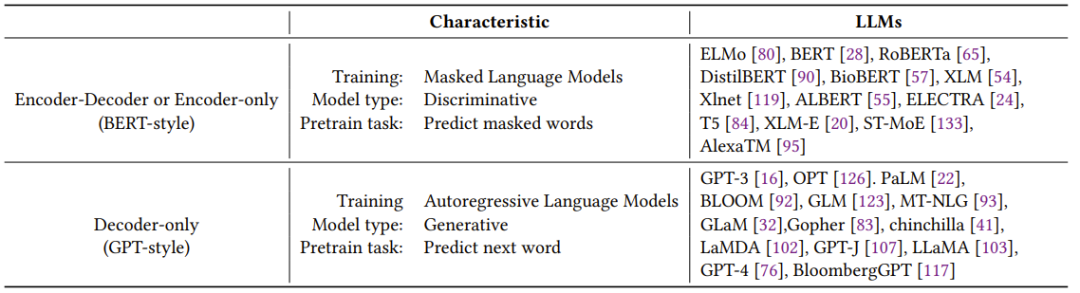

表 1 簡(jiǎn)要總結(jié)了各種代表性 LLM 的特點(diǎn)。

表 1:大型語(yǔ)言模型的特點(diǎn)

2.1 BERT 式語(yǔ)言模型:編碼器 - 解碼器或僅編碼器

由于自然語(yǔ)言數(shù)據(jù)很容易獲得,并且還能使用無(wú)監(jiān)督訓(xùn)練范式來(lái)更好地利用超大規(guī)模數(shù)據(jù)集,因此最近一段時(shí)間,自然語(yǔ)言無(wú)監(jiān)督學(xué)習(xí)的發(fā)展獲得了長(zhǎng)足的進(jìn)步。一種常用方法是基于上下文來(lái)預(yù)測(cè)句子中被遮掩的詞。這種訓(xùn)練范式被稱為掩碼語(yǔ)言模型(Masked Language Model)。這種訓(xùn)練方式讓模型能更深刻地理解詞與其上下文之間的關(guān)系。這些模型是在大型文本語(yǔ)料上訓(xùn)練的,使用了 Transformer 架構(gòu)等技術(shù),并且在許多 NLP 任務(wù)上達(dá)到過(guò)最佳表現(xiàn),比如情感分析和命名實(shí)體識(shí)別。著名的掩碼語(yǔ)言模型有 BERT、RoBERTa 和 T5。由于其在多種任務(wù)上的成功表現(xiàn),掩碼語(yǔ)言模型已經(jīng)成為自然語(yǔ)言處理領(lǐng)域的一種重要工具。

2.2 GPT 式語(yǔ)言模型:僅解碼器

盡管語(yǔ)言模型的架構(gòu)通常與具體任務(wù)無(wú)關(guān),但這些方法需要基于具體下游任務(wù)的數(shù)據(jù)集進(jìn)行微調(diào)。研究者發(fā)現(xiàn)擴(kuò)增語(yǔ)言模型的規(guī)模就能顯著提升其在少樣本或零樣本時(shí)的表現(xiàn)。在提升少樣本和零樣本時(shí)的表現(xiàn)方面,最成功的模型是自回歸語(yǔ)言模型,它的訓(xùn)練方式是根據(jù)給定序列中前面的詞來(lái)生成下一個(gè)詞。這些模型已被廣泛用于文本生成和問(wèn)答等下游任務(wù)。自回歸語(yǔ)言模型包括 GPT-3、OPT、PaLM 和 BLOOM。變革性的 GPT-3 首次表明通過(guò)提示和上下文學(xué)習(xí)能在少 / 零樣本時(shí)給出合理結(jié)果,并由此展現(xiàn)了自回歸語(yǔ)言模型的優(yōu)越性。

另外還有針對(duì)具體任務(wù)優(yōu)化的模型,比如用于代碼生成的 CodeX 以及用于金融領(lǐng)域的 BloombergGPT。近期的重大突破是 ChatGPT,該模型是針對(duì)對(duì)話任務(wù)優(yōu)化的 GPT-3,其能為多種現(xiàn)實(shí)世界應(yīng)用生成更具交互性、更連貫且更貼合上下文的對(duì)話。

3 數(shù)據(jù)方面的實(shí)用指南

本節(jié)將介紹在為下游任務(wù)選擇合適模型時(shí)數(shù)據(jù)的關(guān)鍵性作用。數(shù)據(jù)對(duì)模型有效性的影響從預(yù)訓(xùn)練階段就開(kāi)始了,并會(huì)一直持續(xù)到訓(xùn)練和推理階段。

重點(diǎn) 1

(1)當(dāng)下游任務(wù)會(huì)用到分布之外的數(shù)據(jù)時(shí),比如使用對(duì)抗樣本或數(shù)據(jù)域變化時(shí),LLM 的泛化能力優(yōu)于微調(diào)模型。

(2)當(dāng)已標(biāo)注數(shù)據(jù)有限時(shí),LLM 優(yōu)于微調(diào)模型;當(dāng)有豐富的已標(biāo)注數(shù)據(jù)時(shí),兩者都是合理選擇,這取決于具體的任務(wù)需求。

(3)建議選擇預(yù)訓(xùn)練使用的數(shù)據(jù)域與下游任務(wù)數(shù)據(jù)域相似的模型。

4 NLP 任務(wù)方面的實(shí)用指南

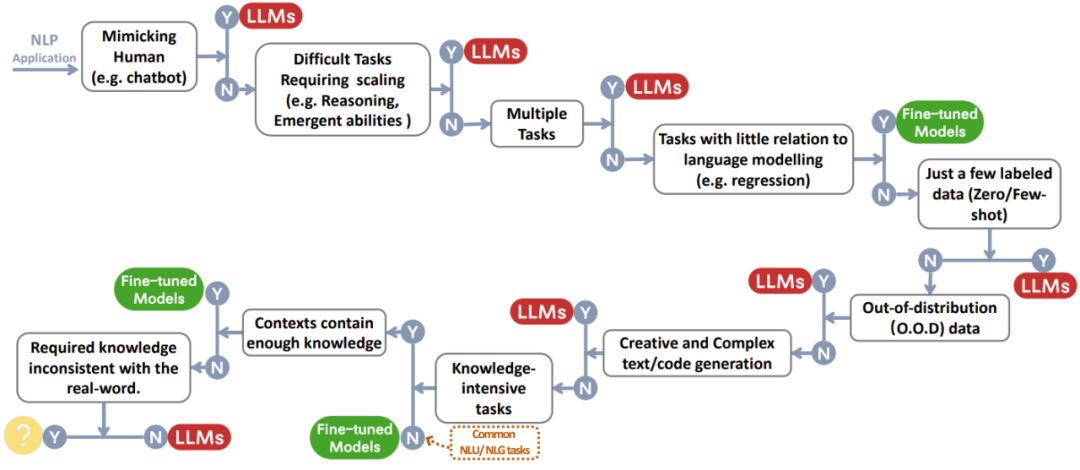

本節(jié)將詳細(xì)討論 LLM 在多種下游 NLP 任務(wù)上是否有用以及對(duì)應(yīng)的模型能力。圖 2 是將所有討論總結(jié)成的一張決策流程圖。當(dāng)面對(duì)某個(gè)任務(wù)時(shí),可基于該流程進(jìn)行快速?zèng)Q策。

圖 2:用戶為 NLP 應(yīng)用選擇 LLM 或微調(diào)模型時(shí)的決策流程。這張決策流程圖可幫助用戶評(píng)估他們手頭的下游 NLP 任務(wù)是否滿足特定條件,并且還能基于評(píng)估結(jié)果確定他們的應(yīng)用最適合選擇 LLM 還是微調(diào)模型。在圖中的決策流程中,Y 表示符合條件,N 表示不符合條件。最后一個(gè)條件的 Y 旁的黃色圓圈表示目前還沒(méi)有很適合這類應(yīng)用的模型。

4.1 傳統(tǒng)的 NLU 任務(wù)

傳統(tǒng) NLU 任務(wù)是 NLP 領(lǐng)域中一些基本任務(wù),包括文本分類、命名實(shí)體識(shí)別(NER)、蘊(yùn)含預(yù)測(cè)(entailment prediction)等。這些任務(wù)中的許多都可用作更大型 AI 系統(tǒng)的中間步驟,比如將 NER 用于知識(shí)圖譜構(gòu)建。

不適用 LLM:對(duì)于大多數(shù)自然語(yǔ)言理解任務(wù),比如 GLUE 和 SuperGLUE 中的任務(wù),如果該任務(wù)已有豐富的標(biāo)注良好的數(shù)據(jù)并且測(cè)試集中僅有非常少的數(shù)據(jù)在分布之外,那么微調(diào)模型的表現(xiàn)依然更好。當(dāng)任務(wù)與數(shù)據(jù)集各不相同時(shí),小型微調(diào)模型和 LLM 之間的差距也會(huì)不同。

適用 LLM:但是,也有些 NLU 任務(wù)更適合用 LLM 處理。其中兩項(xiàng)代表性任務(wù)是繁雜文本的分類問(wèn)題和對(duì)抗式自然語(yǔ)言推理。

重點(diǎn) 2

對(duì)傳統(tǒng)自然語(yǔ)言理解任務(wù)而言,微調(diào)模型通常是比 LLM 更好的選擇,但如果該任務(wù)需要強(qiáng)大的泛化能力,那么 LLM 可提供幫助。

4.2 生成任務(wù)

自然語(yǔ)言生成的目標(biāo)是創(chuàng)建連貫的、有意義的且符合上下文的符號(hào)序列,其大致上包含兩大類任務(wù)。第一類任務(wù)關(guān)注的重心是將輸入文本轉(zhuǎn)換成新的符號(hào)序列,例子包括段落摘要和機(jī)器翻譯。第二類任務(wù)則是「開(kāi)放式生成」,目標(biāo)是從頭開(kāi)始生成文本或符號(hào),使之準(zhǔn)確匹配輸入的描述,比如編寫(xiě)電子郵件、撰寫(xiě)新文章、創(chuàng)造虛構(gòu)故事以及寫(xiě)代碼。

適用 LLM:生成任務(wù)需要模型全面理解輸入的內(nèi)容或需求并且還需要一定程度的創(chuàng)造力。這正是 LLM 擅長(zhǎng)的。

不適用 LLM:在大多數(shù)有豐富資源的翻譯任務(wù)和資源很少的翻譯任務(wù)上,微調(diào)模型的表現(xiàn)更佳,比如 DeltaLM+Zcode。對(duì)于有豐富資源的機(jī)器翻譯,微調(diào)模型稍微優(yōu)于 LLM。對(duì)于資源極少的機(jī)器翻譯,比如英語(yǔ) - 哈薩克語(yǔ)翻譯,微調(diào)模型顯著優(yōu)于 LLM。

重點(diǎn) 3

得益于強(qiáng)大的生成能力和創(chuàng)造力,LLM 在大多數(shù)生成任務(wù)上都有優(yōu)勢(shì)。

4.3 知識(shí)密集型任務(wù)

知識(shí)密集型 NLP 任務(wù)是指非常依賴背景知識(shí)、特定領(lǐng)域?qū)I(yè)知識(shí)或一般性真實(shí)世界知識(shí)的任務(wù)類別。這些任務(wù)需要的不僅僅是模式識(shí)別或句法分析。它們高度依賴記憶和適當(dāng)利用知識(shí),這些知識(shí)關(guān)聯(lián)著我們的真實(shí)世界的特定實(shí)體、事件和常識(shí)。

適用 LLM:一般來(lái)說(shuō),如果有數(shù)以十億計(jì)的訓(xùn)練 token 和參數(shù),LLM 所包含的真實(shí)世界知識(shí)量可遠(yuǎn)遠(yuǎn)超越微調(diào)模型。

不適用 LLM:某些其它任務(wù)需要的知識(shí)不同于 LLM 學(xué)習(xí)到的知識(shí)。所需的知識(shí)不是 LLM 學(xué)習(xí)到的關(guān)于真實(shí)世界的知識(shí)。在這樣的任務(wù)中,LLM 沒(méi)有明顯優(yōu)勢(shì)。

重點(diǎn) 4

(1)得益于龐大的真實(shí)世界知識(shí),LLM 擅長(zhǎng)處理知識(shí)密集型任務(wù)。(2)當(dāng)知識(shí)需求與所學(xué)知識(shí)不匹配時(shí),LLM 會(huì)遇到困難;或者當(dāng)任務(wù)只需要上下文的知識(shí)時(shí),微調(diào)模型可以達(dá)到與 LLM 同等的表現(xiàn)。

4.4 在擴(kuò)展規(guī)模方面的能力

擴(kuò)展 LLM 的規(guī)模(比如參數(shù)、訓(xùn)練計(jì)算等)可以極大助力預(yù)訓(xùn)練語(yǔ)言模型。通過(guò)擴(kuò)大模型規(guī)模,模型處理多種任務(wù)的能力通常能得到提升。反映到某些指標(biāo)上,模型的性能表現(xiàn)與模型規(guī)模呈現(xiàn)冪律關(guān)系。舉個(gè)例子,用于度量語(yǔ)言建模性能的交叉熵?fù)p失會(huì)隨模型規(guī)模的指數(shù)級(jí)增長(zhǎng)而線性下降,這也被稱為「標(biāo)度律(scaling-law)」。對(duì)于推理等某些關(guān)鍵能力,擴(kuò)大模型規(guī)模就能逐漸將這些能力從非常低的水平提升到一個(gè)可使用的水平,甚至可接近人類水平。本小節(jié)將從規(guī)模對(duì) LLM 的能力和行為的影響方面介紹 LLM 的使用。

推理方面的 LLM 用例:推理涉及到理解信息、進(jìn)行推論和做出決定,是人類智力的一大核心能力。對(duì) NLP 而言,推理卻極具挑戰(zhàn)性。現(xiàn)有的許多推理任務(wù)可以分為常識(shí)推理和算術(shù)推理兩類。模型增大能極大提升 LLM 的算術(shù)推理能力。常識(shí)推理不僅需要 LLM 記住事實(shí)性知識(shí),還需要 LLM 執(zhí)行一些有關(guān)事實(shí)的推理步驟。常識(shí)推理能力會(huì)隨模型大小的增長(zhǎng)而逐漸提升。相比于微調(diào)模型,LLM 在大多數(shù)數(shù)據(jù)集上都表現(xiàn)更優(yōu)。

涌現(xiàn)能力方面的 LLM 用例:擴(kuò)增模型規(guī)模還能賦予模型一些超越冪律規(guī)則的前所未有的奇妙能力。這些能力被稱為「涌現(xiàn)能力(emergent ability)」。正如論文《Emergent Abilities of Large Language Models》中定義的那樣:LLM 的涌現(xiàn)能力是指小規(guī)模模型不具備但出現(xiàn)在大規(guī)模模型中的能力。(有關(guān)該論文的更多解讀可參閱《Jeff Dean 等人新作:換個(gè)角度審視語(yǔ)言模型,規(guī)模不夠發(fā)現(xiàn)不了》)這意味著我們無(wú)法基于小規(guī)模模型的性能提升而推斷預(yù)測(cè)出這種能力;而在某些任務(wù)上,模型的規(guī)模一旦超過(guò)一定程度,就可能突然獲得優(yōu)異表現(xiàn)。涌現(xiàn)能力通常不可預(yù)測(cè)并且出人意料,這可能導(dǎo)致模型有能力處理隨機(jī)出現(xiàn)或意料之外的任務(wù)。

不適用 LLM 以及理解涌現(xiàn):盡管大多數(shù)情況下,模型更大,表現(xiàn)也更優(yōu),但也依然存在例外情況。

在某些任務(wù)上,隨著 LLM 規(guī)模的提升,模型表現(xiàn)會(huì)開(kāi)始下降。這也被稱為反標(biāo)度現(xiàn)象(Inverse Scaling Phenomenon)。此外研究者還觀察到另一個(gè)有關(guān)規(guī)模的有趣現(xiàn)象,即 U 形現(xiàn)象(U-shaped Phenomenon)。顧名思義,該現(xiàn)象是指隨著 LLM 模型增大,其在特定任務(wù)上的表現(xiàn)一開(kāi)始會(huì)提升,然后會(huì)開(kāi)始下降,之后又會(huì)再次提升。

為了推進(jìn)該領(lǐng)域的研究,我們必需更深入地理解涌現(xiàn)能力、反標(biāo)度現(xiàn)象和 U 形現(xiàn)象。

重點(diǎn) 5

(1)隨著模型規(guī)模的指數(shù)級(jí)增長(zhǎng),LLM 的算術(shù)推理和常識(shí)推理能力也會(huì)上升。(2)隨著 LLM 規(guī)模的擴(kuò)增,涌現(xiàn)能力能機(jī)緣巧合地發(fā)現(xiàn)新用途,比如詞處理能力和邏輯能力。(3)模型的能力并不總是會(huì)隨規(guī)模提升,而且我們對(duì)大型語(yǔ)言模型的能力與規(guī)模的關(guān)系的理解還很有限。

4.5 雜項(xiàng)任務(wù)

為了更好地理解 LLM 的優(yōu)勢(shì)和短板,下面會(huì)談?wù)勆厦鏇](méi)有涉及到的其它任務(wù)。

不適用 LLM:如果模型目標(biāo)與訓(xùn)練數(shù)據(jù)有差異,那么 LLM 在這些任務(wù)上通常會(huì)遇到困難。

適用 LLM:LLM 尤其適用于某些特定任務(wù)。舉些例子,LLM 非常擅于模仿人類、LLM 還可用于評(píng)估摘要和翻譯等某些 NLG 任務(wù)的質(zhì)量、LLM 的某些能力還能帶來(lái)性能提升之外的其它好處,如可解釋性。

重點(diǎn) 6

(1)對(duì)于遠(yuǎn)離 LLM 的預(yù)訓(xùn)練目標(biāo)和數(shù)據(jù)的任務(wù)而言,微調(diào)模型和特定領(lǐng)域模型仍有一席之地。(2)LLM 擅于模仿人類、數(shù)據(jù)標(biāo)注和生成。它們也可用于 NLP 任務(wù)的質(zhì)量評(píng)估,并且有可解釋性等好處。

4.6 真實(shí)世界「任務(wù)」

本小節(jié)最后討論一下 LLM 和微調(diào)模型在真實(shí)世界「任務(wù)」上的應(yīng)用。這里所用的「任務(wù)」一詞并不嚴(yán)謹(jǐn),因?yàn)椴煌趯W(xué)術(shù)場(chǎng)景,真實(shí)世界場(chǎng)景通常缺乏形式優(yōu)良的定義。對(duì)模型的很多需求甚至不能被視為 NLP 任務(wù)。模型面臨的真實(shí)世界挑戰(zhàn)來(lái)自以下三方面:

- 有噪聲的 / 非結(jié)構(gòu)化的輸入。真實(shí)世界的輸入來(lái)自真實(shí)世界的人,他們大都不是專家。他們并不了解如何與模型適當(dāng)交互,甚至都可能無(wú)法流暢地使用文本。因此,真實(shí)世界的輸入數(shù)據(jù)可能很混亂、帶有拼寫(xiě)錯(cuò)誤、口語(yǔ)化文本和多語(yǔ)言混雜,這不同于預(yù)訓(xùn)練或微調(diào)使用的定義格式良好的數(shù)據(jù)。

- 未被學(xué)術(shù)界形式化的任務(wù)。真實(shí)世界場(chǎng)景中的任務(wù)通常沒(méi)有得到學(xué)術(shù)界的良好定義,并且多樣性也遠(yuǎn)遠(yuǎn)超出學(xué)術(shù)研究場(chǎng)景的定義。用戶通常提出的查詢或請(qǐng)求并不能很好地歸入預(yù)定義的類別,并且有時(shí)單個(gè)查詢會(huì)包含多項(xiàng)任務(wù)。

- 遵從用戶的指令。用戶的請(qǐng)求可能會(huì)包含多個(gè)隱含意圖(比如對(duì)輸出格式有具體要求),或者如果沒(méi)有后續(xù)問(wèn)題,不清楚用戶期望的預(yù)測(cè)結(jié)果。模型需要理解用戶的意圖并提供與這些意圖一致的輸出。

本質(zhì)上講,來(lái)自用戶請(qǐng)求的這些真實(shí)世界難題是因?yàn)槠x了針對(duì)特定任務(wù)設(shè)計(jì)的任何 NLP 數(shù)據(jù)集的分布。公共 NLP 數(shù)據(jù)集并不能反映這些模型的使用方式。

重點(diǎn) 7

相比于微調(diào)模型,LLM 更適合用于處理真實(shí)世界場(chǎng)景。但是,評(píng)估模型在真實(shí)世界中的有效性依然是一個(gè)懸而未決的問(wèn)題。

5 其它方面

盡管 LLM 適用于多種下游任務(wù),但也有其它一些因素需要考慮,比如效率和可信度。效率方面涉及到的問(wèn)題包括 LLM 的訓(xùn)練成本、推理延遲度以及高效利用參數(shù)的調(diào)優(yōu)策略。在可信度方面則需要考慮 LLM 的穩(wěn)健性和校準(zhǔn)能力、公平和偏見(jiàn)、潛在的錯(cuò)誤相關(guān)性以及安全性難題。重點(diǎn) 8(1)如果任務(wù)對(duì)成本敏感或有嚴(yán)格延遲要求,那么應(yīng)該優(yōu)先考慮輕量的本地微調(diào)模型。在部署和交付模型時(shí),可考慮進(jìn)行調(diào)優(yōu)以高效利用參數(shù)。(2)LLM 的零樣本方法能防止其從具體任務(wù)的數(shù)據(jù)集中學(xué)習(xí)捷徑,而這種情況對(duì)微調(diào)模型來(lái)說(shuō)卻很常見(jiàn)。盡管如此,LLM 仍會(huì)表現(xiàn)出一定的捷徑學(xué)習(xí)問(wèn)題。(3)由于 LLM 潛在的有害或有偏見(jiàn)輸出以及幻覺(jué)(hallucination)問(wèn)題可能導(dǎo)致嚴(yán)重后果,因此與 LLM 相關(guān)的安全問(wèn)題應(yīng)得到最大重視。人類反饋等方法有望緩解這些問(wèn)題。

6 總結(jié)和未來(lái)挑戰(zhàn)

這份實(shí)用指南提供了有關(guān) LLM 的洞見(jiàn)以及在各種 NLP 任務(wù)上使用 LLM 的最佳實(shí)踐方法。希望這能幫助研究者和實(shí)踐者利用 LLM 的潛力并推動(dòng)語(yǔ)言技術(shù)的創(chuàng)新。

當(dāng)然,LLM 也還有一些有待解決的挑戰(zhàn):

- 在真實(shí)世界數(shù)據(jù)集上對(duì)模型進(jìn)行評(píng)估。盡管現(xiàn)有的深度學(xué)習(xí)模型主要是在 ImageNet 等標(biāo)準(zhǔn)學(xué)術(shù)數(shù)據(jù)集上進(jìn)行評(píng)估,但標(biāo)準(zhǔn)學(xué)術(shù)數(shù)據(jù)集是有局限的,并不能確切反映模型在真實(shí)世界中的表現(xiàn)。隨著模型的進(jìn)步,有必要在反映真實(shí)需求的更多樣化、復(fù)雜和真實(shí)的數(shù)據(jù)上評(píng)估它們。在學(xué)術(shù)數(shù)據(jù)集和真實(shí)世界數(shù)據(jù)集上評(píng)估模型,能模型得到更嚴(yán)格的測(cè)試,還能讓我們更好地理解它們?cè)谡鎸?shí)世界應(yīng)用中的有效性。這能確保模型有能力解決真實(shí)世界難題并交付實(shí)際可用的解決方案。

- 模型合準(zhǔn)(Model Alignment)。確保日益強(qiáng)大和自動(dòng)化的模型與人類價(jià)值觀和優(yōu)先項(xiàng)保持一致是非常重要的。我們必須想出辦法,確保模型的行為符合預(yù)期,并且不要為我們不想要的結(jié)果而優(yōu)化模型。要從模型開(kāi)發(fā)過(guò)程一開(kāi)始就整合合準(zhǔn)技術(shù),這是很重要的。在評(píng)估和確保合準(zhǔn)方面,模型透明性和可解釋性也很重要。此外,著眼未來(lái),還有更加艱巨挑戰(zhàn)正在顯現(xiàn):對(duì)超人類的系統(tǒng)執(zhí)行合準(zhǔn)。盡管目前這一任務(wù)超出了我們的需求,但重點(diǎn)是要考慮到合準(zhǔn)這樣先進(jìn)的系統(tǒng)并為此做準(zhǔn)備,因?yàn)樗鼈兛赡軙?huì)帶來(lái)獨(dú)特的復(fù)雜性和道德倫理問(wèn)題。

- 安全性合準(zhǔn)(Safety Alignment)。盡管討論 AI 帶來(lái)的存在主義風(fēng)險(xiǎn)很重要,但我們還是需要切實(shí)的研究來(lái)確保能安全地開(kāi)發(fā)先進(jìn) AI。這包括用于可解釋性、可擴(kuò)展監(jiān)督與治理以及模型屬性的形式驗(yàn)證的技術(shù)。在模型的構(gòu)建過(guò)程中,安全不應(yīng)被視為一個(gè)附加組件,而應(yīng)是整體的組成部分。

- 在模型規(guī)模變化時(shí)預(yù)測(cè)其表現(xiàn)。當(dāng)模型大小和復(fù)雜性顯著提升時(shí),我們很難預(yù)測(cè)模型會(huì)有何表現(xiàn)。應(yīng)當(dāng)開(kāi)發(fā)技術(shù)來(lái)更好預(yù)測(cè)模型規(guī)模提升或使用新架構(gòu)時(shí)模型的表現(xiàn)情況,這能讓我們更高效地使用資源以及加快開(kāi)發(fā)進(jìn)程。有這樣一些可能性:訓(xùn)練一個(gè)更小的「種子」模型并通過(guò)外推方式預(yù)測(cè)其增長(zhǎng)情況,模擬擴(kuò)大規(guī)模或調(diào)整模型的效果,以及對(duì)不同規(guī)模的模型的測(cè)試基準(zhǔn)進(jìn)行迭代以構(gòu)建標(biāo)度律。這能讓我們?cè)跇?gòu)建模型之前就對(duì)模型的性能表現(xiàn)有所了解。