LeCun高徒超詳筆記曝光,Meta世界模型首揭秘!首個「類人」模型怎么來的?

LeCun究竟是經過了怎樣的思考,才得出了世界模型是AI大模型未來最理想道路的結論?

很幸運,去年曾聽過他在暑假學校關于統(tǒng)計物理和機器學習演講的學生Ania Dawid,將他的觀點仔細地整理和發(fā)表出來。

LeCun對于她的工作也表示了盛贊。

這篇筆記解釋了當前機器學習方法的局限性,并且介紹了LeCun在2022年的論文<A Path Towards Autonomous Machine Intelligence>中提出的autonomous AI所需的核心概念,以及設計背后的主要思想。

論文地址:https://arxiv.org/abs/2306.02572

類人智能的可能性

在AI達到類人水平并帶來新的技術革新之前,當前的自動化系統(tǒng)仍然有重大的局限性。

最理想的情況下,會出現(xiàn)L5自動駕駛、家用機器人、虛擬助理,這些機器人會學習可靠的世界模型,然后進行推理,對復雜的行動序列做出計劃。

在這些筆記中,Ania Dawid總結了LeCun提出未來自主智能架構背后的主要思想,引入了基于能力的潛變量模型,在LeCun建議構建的模塊——分層聯(lián)合嵌入預測架構(H-JEPA)中結合了它們的優(yōu)勢。

在過去十年中,機器學習方法迅速普及,ML模型在圍棋、國際象棋和Shogi等戰(zhàn)略游戲中都表現(xiàn)出了專家級的性能。

作為交換,創(chuàng)建深度學習模型需要在大量數據集上訓練,這是一種極端的計算成本。

相比之下,人類的學習卻十分高效,我們可以快速直觀地找到方法來完成任務,連嬰兒都能很快獲得對物理世界的直觀理解。

如何讓AI模型發(fā)展出像人類一樣的潛能?在這些課堂講稿中,LeCun與學生們探索了autonomous intelligence的概念。

他們希望能夠實現(xiàn)一個充分自主的AI,他通過轉移知識和自動適應新情況而在通用任務上表現(xiàn)良好,無需首先嘗試很多解決方案。

自主機器智能

當前機器學習的局限性

到目前為止,機器學習系統(tǒng)仍然在很大程度上依賴于SL,這就需要大量的標記樣本,而RL需要大量的試驗,這在當前的現(xiàn)實中不切實際。在現(xiàn)實世界中,每個行動都需要時間和成本。

相比之下,人類和動物主要依靠對環(huán)境的積極觀察,并以此建立世界模型。

嬰兒就幾乎完全通過觀察來學習,他們的學習過程與SSL最相似,只有一點點SL(和家長互動)或RL(通過實踐嘗試各種解釋方案)。

實際上,人類是想象和推演大部分結果,而不是全部嘗試一遍。

因此,實現(xiàn)完全自主類人智能的道路主要有三個挑戰(zhàn):

1.學習世界的表征和預測模型,使AI系統(tǒng)能夠預測未來,特別是自己行動會導致的結果。

最有可能的方法就是自監(jiān)督學習(SSL),因為SL和RL需要太多的成本或試驗。

2.學習以一種與DL兼容的方式推理。推理需要考慮到與前饋潛意識計算相反的意圖。最可能的方法就是像energy minimization那樣設計推理和規(guī)劃。

3.學習規(guī)劃復雜動作序列,這個過程中需要行動計劃的分層(hierarchical)表征。

自主智能的新范式

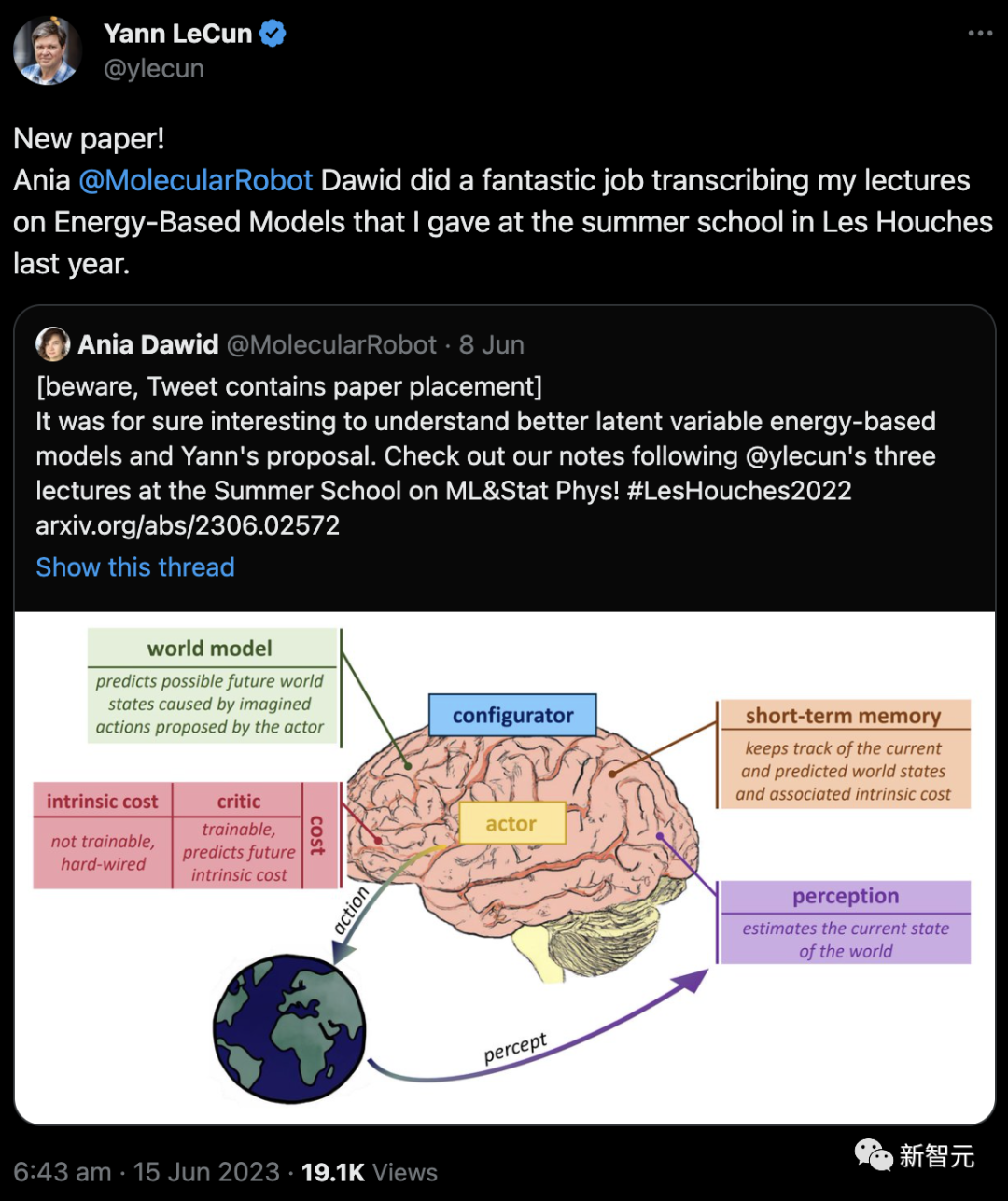

在論文中,LeCun提出了自主AI應該有的模塊化結構。

這個AI架構由多個相互連接的模塊組成。

Perception模塊估計世界的當前狀態(tài),actor可以使用該狀態(tài),并在world model的指導下提出最佳動作序列,根據actor的動作預測或「想象」未來可能的世界狀態(tài)。

這些聯(lián)系被稱為「感知-計劃-行動循環(huán)」。

在想象actor行為的可能后果時,世界模型使用cost推理模塊。

它可以分成兩個子模塊——對痛苦、快樂、饑餓等基本需求進行建模的intrinsic cost,以及預測內在成本未來值的critic。

Short-term memory模塊用于預測未來世界狀態(tài)。Configurator模塊通過配置所有其他模塊來實現(xiàn)任務之間的切換。

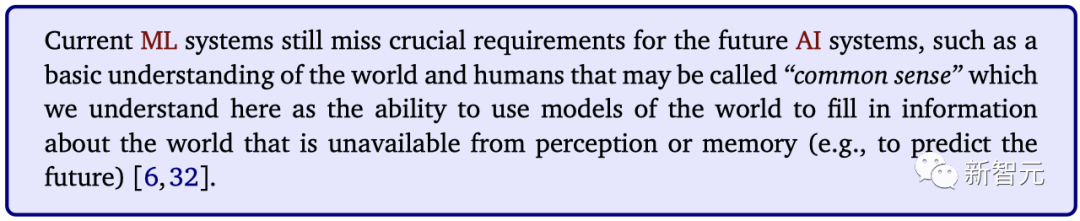

a.在SSL中,系統(tǒng)經過訓練,可以從輸入的可見部分(藍色)預測輸入的隱藏部分(橙色)。b. SSL將在未來的AI系統(tǒng)中發(fā)揮核心作用,SSL是蛋糕,SL是糖衣,RL是櫻桃

模型中的「感知-計劃-行動循環(huán)」類似于最優(yōu)控制中的model-predictive control(MPC)。關鍵的區(qū)別在于,世界模型預測未來是通過學習。

它也不同于RL,因為在這里成本函數是已知的,所有模塊都是可微的,在現(xiàn)實中不需要采取行動。

自監(jiān)督學習與不確定性表征

自監(jiān)督學習的主要目的,就是重建輸入或預測輸入的缺失部分,如上圖a所示。

輸入可以是圖像、視頻或文本。在訓練中,模型學習數據的分層表征,因此,SSL的預訓練通常先于SL或RL階段。

它還用于學習預測(前向)模型MPC,或者學習控制策略,或基于模型的RL。

自監(jiān)督學習對于文本非常有效,但對于圖像來說,當模型被訓練進行單一預測時,訓練使它們預測的是所有可能的平均值,因此,SSL產生了模糊的預測。

不過,做決定通常不需要預測世界上所有可能的細節(jié),只需要預測與任務相關的細節(jié)即可。

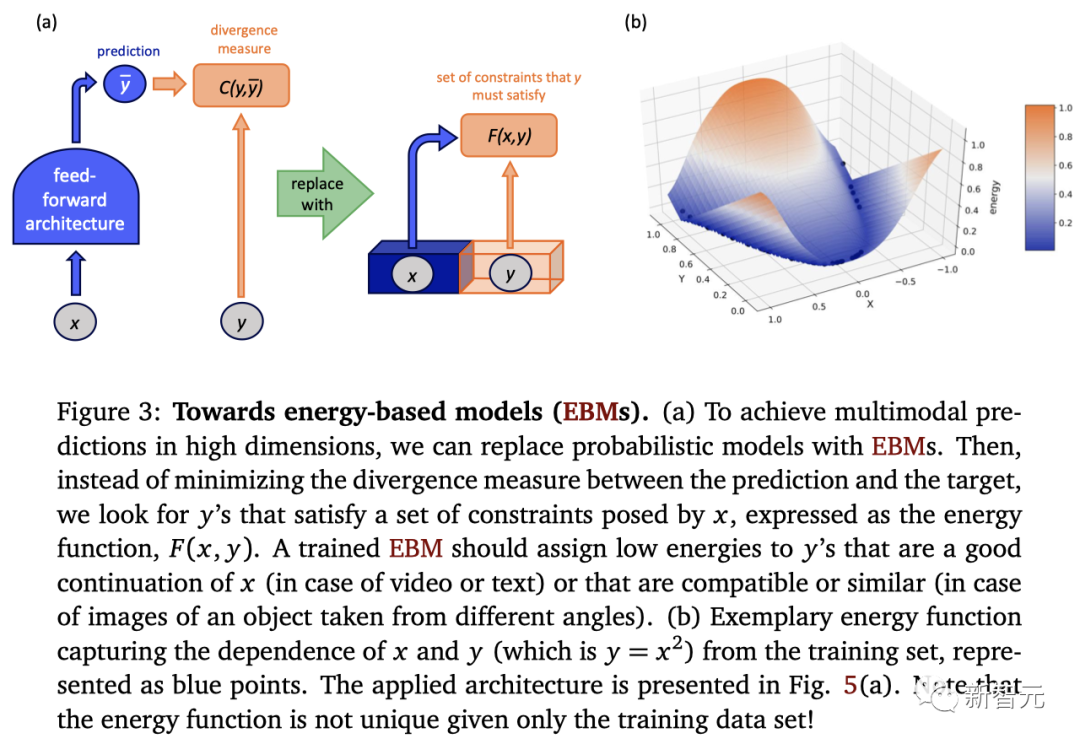

基于能量的模型

概率模型需要規(guī)范化,因此在高維數據的限制下,可能變得難以處理。

然而,在駕駛汽車的決策任務中,系統(tǒng)只需要選擇正確的答案,其他答案的概率是無關緊要的。

因此,我們可以讓模型通過能量函數來表示變量之間的依賴關系(例如下圖a所示的決策y和條件x)。

在這種情況下,能量指導模型只需要將最低的能量分配給正確的答案,將較大的能量分配給不正確的答案即可。

圖b中的能量函數,表示了x和y之間的二次依賴關系。推理涉及為給定的x找到最小能量值。

EBM的一個優(yōu)點是,可以表示多模態(tài)的依賴關系。理論上,還可以以各種形式(文本、視覺等)描述數據之間的依賴關系。

基于能量的模型與概率模型

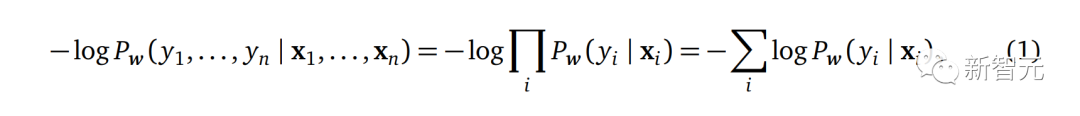

在概率設置中,訓練包括找到這樣的模型參數w,使給定輸入的觀察輸出的可能性最大(或負可能性最小)。

第一個等式是基于數據點之間相互獨立的假設,而進行第二個變換,是因為求和計算比乘法計算更容易。

對于概率模型,訓練僅限于從負對數似然(如交叉熵)生成的損失函數。

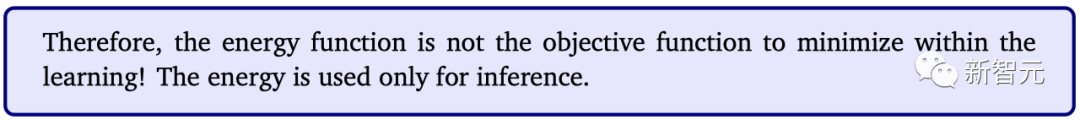

雖然放棄概率設置可能會令人驚訝,但請注意,做決策可以被視為選擇得分最高的選項,而不是最有可能的選項。

比如在下棋的時候,如果查看所有可能性來決定下一步怎么走,顯然非常棘手。

相反,可以通過探索可能性樹的一部分,比如用蒙特卡洛樹搜索的最短路徑,給出最小能量。

因此,沒有必要使用概率框架。

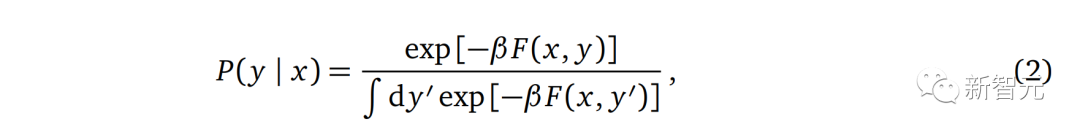

不過,如果需要的話,也可以通過將能量考慮為非歸一化的負對數概率,在EBM和概率模型之間建立聯(lián)系。

最常見的方法是通過Gibbs-Boltzmann distribution:

基于隱變量能量的模型

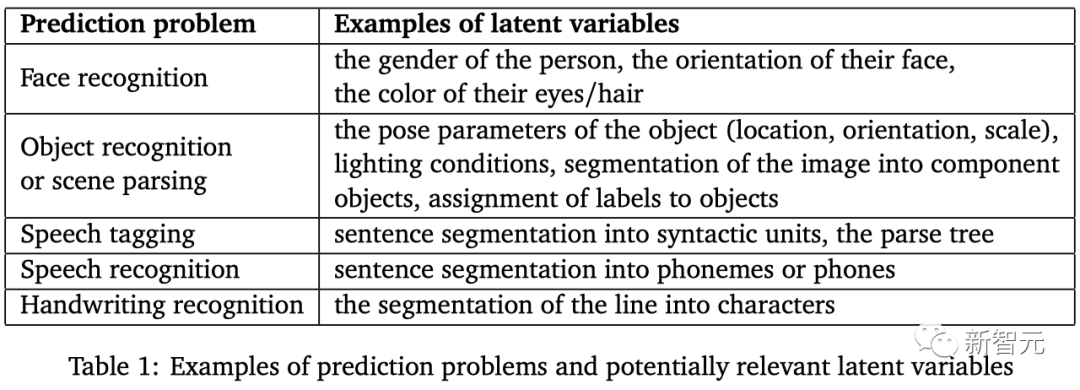

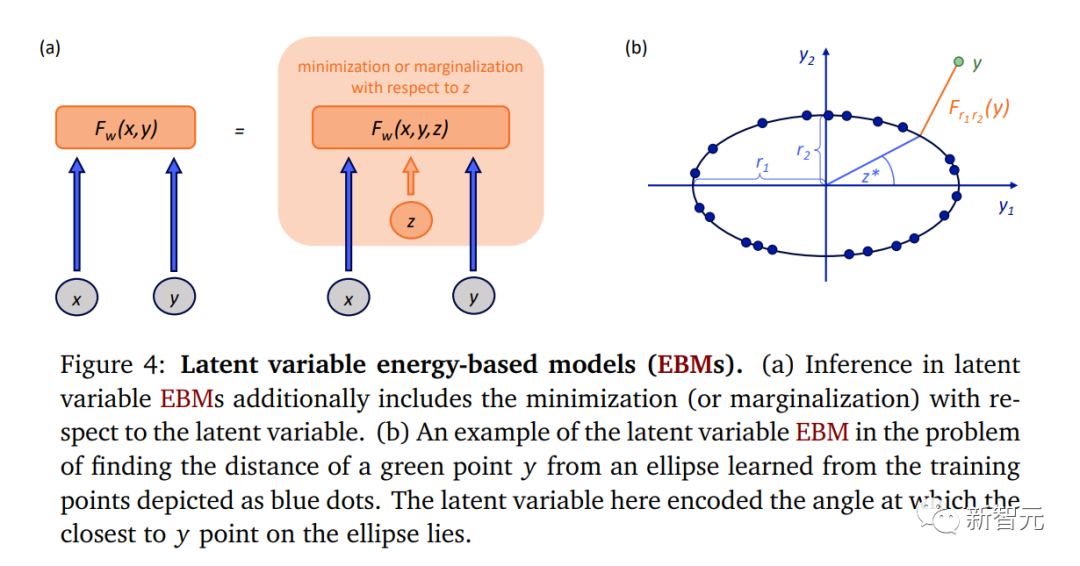

通過使用依賴于一組潛變量z的額外能量函數,我們可以擴展EBM的可能性。

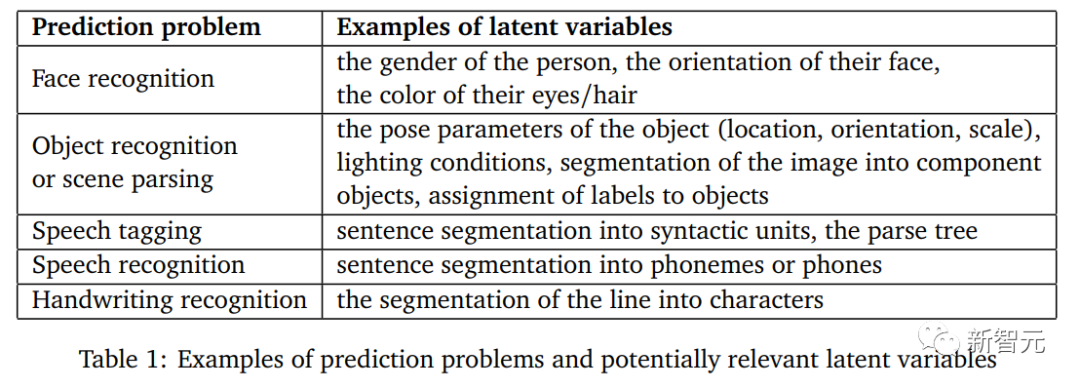

這些隱藏變量通常被稱為潛變量(latent variables),旨在捕捉在x中無法直接獲得的y的信息。

在人臉檢測任務中,這些潛變量的示例可能是性別、姿勢或發(fā)色。

在自動駕駛汽車的情況下,潛變量可以參數化其他駕駛者的可能行為。

因此,它們?yōu)槲覀兲幚憩F(xiàn)實世界的不確定性提供了一種方法。

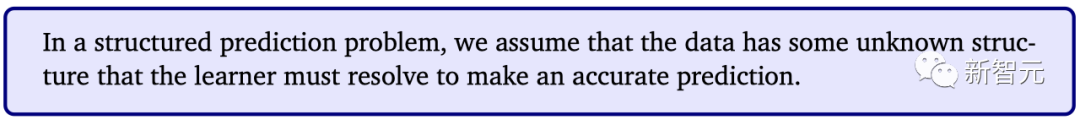

在結構化預測問題中,我們假設數據具有一些未知的結構,學習器必須解析這些結構才能進行準確的預測

最后,潛變量在所謂的結構化預測問題中非常有用。

a.潛變量推斷EBM還包括潛變量的最小化(或邊緣化)。b. 一個潛變量EBM的例子,在尋找綠色點y和橢圓距離的問題中,它會從訓練點(藍點)學習

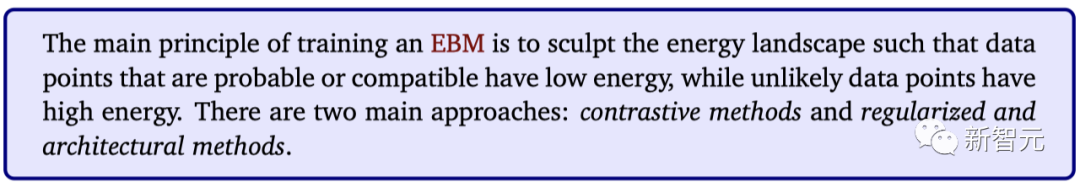

訓練基于能量的模型

到目前為止,我們已經討論了如何使用EBM,特別是潛變量EBM進行推理。

在本節(jié)中,我們將介紹如何訓練EBM。

訓練技術的選擇,取決于EBM架構的選擇。

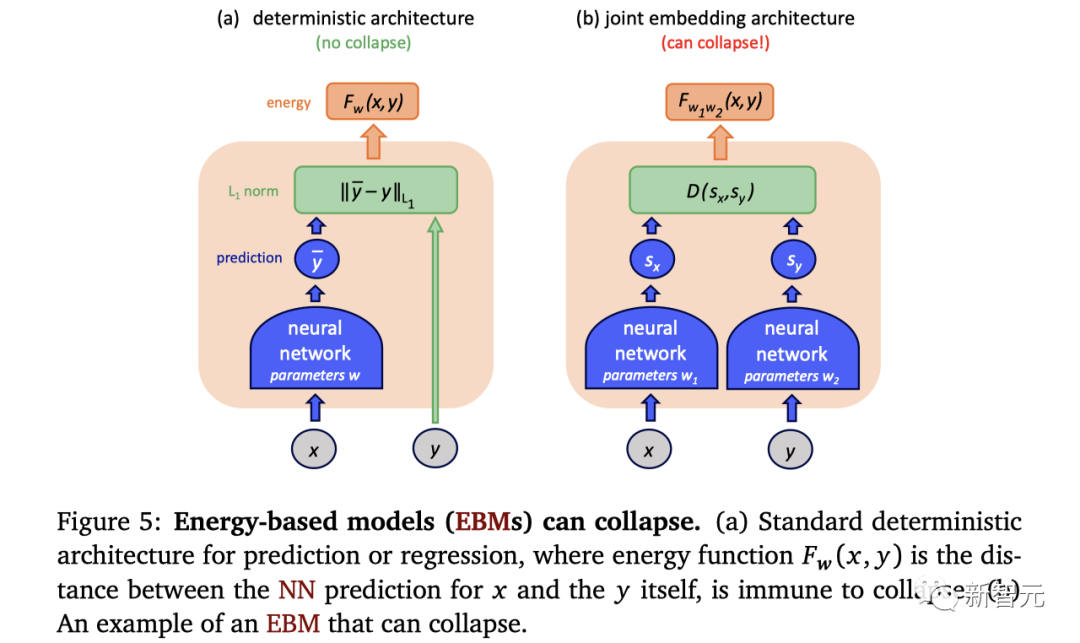

讓我們比較下圖中的兩種EBM架構。

能量模型(EBM)可能會發(fā)生能量崩潰。(a)標準的確定性預測或回歸架構,其中能量函數Fw(x, y)是x的神經網絡預測與y本身之間的距離,不容易發(fā)生能量崩潰。(b)一個可能發(fā)生能量崩潰的EBM示例

在第一種情況下,能量函數只是數據點y和數據點x的編碼器(如NN)輸出之間的距離。

這種架構可以被認為是一個回歸模型,并通過簡單地最小化訓練樣本的能量來訓練。

然而,對于其他架構,這樣的訓練可能會導致能量函數的崩潰,即給定一個x,能量(energy)可能會變得「平坦」,為 y 的所有值提供基本相同的能量。

例如,圖b中的聯(lián)合嵌入架構,將輸入x和y分別編碼為

、

,目標是找到這樣的

和

,這樣它們的x和y的表示就是接近的。

如果我們訓練模型只是為了最小化編碼器輸出之間的距離,那么兩個編碼器可能會完全忽略輸入而只產生相同的恒定輸出。

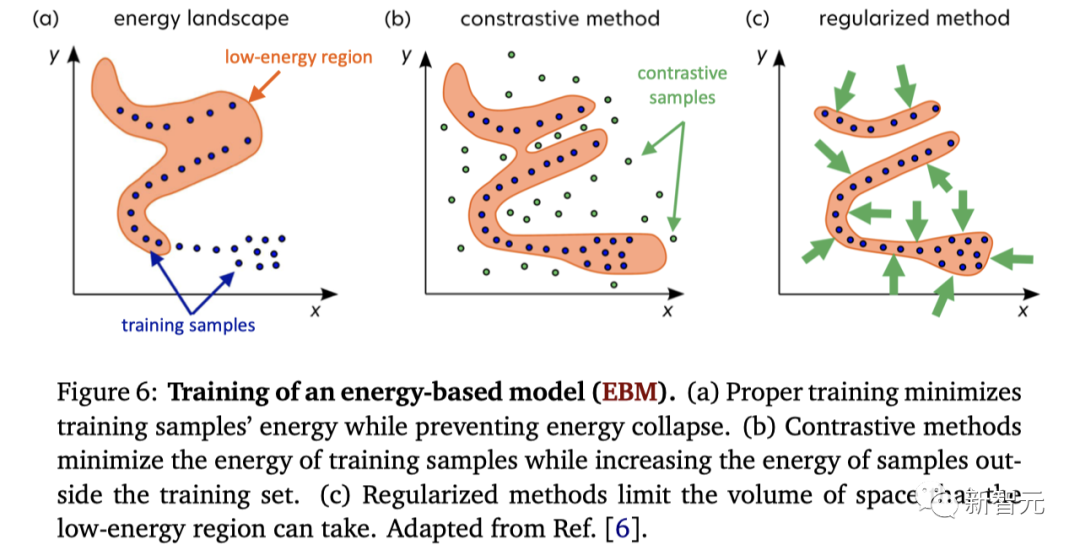

對比式方法

為了防止能量崩潰,我們可以采取對比式方法。

x和y是我們希望降低能量的訓練數據點,在下圖b中表示為藍點。

?y是一個對比點,在下圖b中表示為綠點,我們需要增加其能量。

能量模型(EBM)的訓練:(a) 正確的訓練方式在最小化訓練樣本的能量的同時防止能量崩潰。(b) 對比式方法通過最小化訓練樣本的能量同時增加訓練集之外樣本的能量。(c) 正則化方法限制了低能量區(qū)域所占據的空間體積

當最小化

時,我們需要確保訓練樣本的能量雄安與訓練樣本和對比樣本的能量,至少是邊際m,這取決于y和?y之間的距離。

適當的對比損失函數需要確保非零邊界,以避免能量崩潰。

對比損失函數可以像下面這個方程中的鉸鏈損失,那樣針對特定數據集進行成對計算。

對比性方法最核心的問題是如何生成對比性點,然后最大可能性就可以被解釋為對比方性方法的特例。

架構方法和正則化方法

我們的主要挑戰(zhàn)在于,選擇如何限制低能量空間的體積。

一種方法是構建低能量空間體積受限的體系結構。

另一種方法是添加一個正則化項,該項最小化低能量空間的某種度量。

最后,評分匹配(score matching)是一種正則化技術,它最小化數據點周圍能量景觀的梯度并最大化曲率。

幾個能量模型的實例

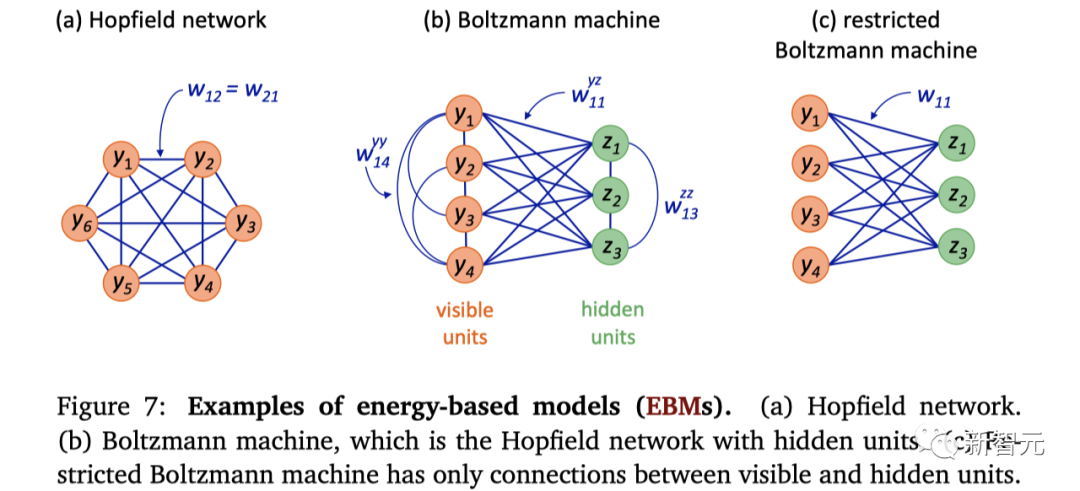

Hopfield網絡

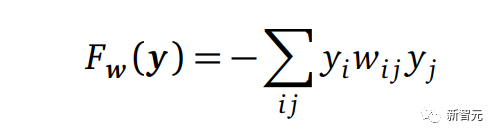

Hopfield網絡網絡是由John Hopfield在1982年推廣的全連接循環(huán)網絡,方案如圖a所示,能量函數如下:

但是因為它會出現(xiàn)虛假最小值,使得在實踐中可用性不強。

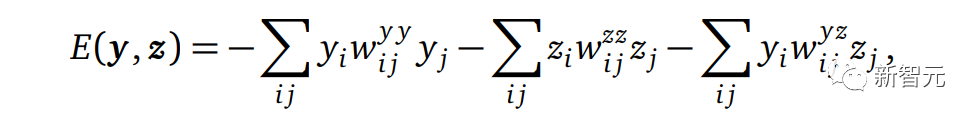

玻爾茲曼機

在1983年,由Geoffrey Hinton和Terrence Sejnowski提出了Hopfield網絡的擴展,稱為玻爾茲曼機。

它引入了被稱為隱藏單元的神經元,如下圖7(b)所示。

它的能量函數及其自由能如下:

這個提議對整個機器學習社區(qū)來說非常重要,因為它首次引入了隱藏單元的概念,即那些輸入和輸出不可觀測的神經元。

這些隱藏單元也可以理解為模型的潛變量。

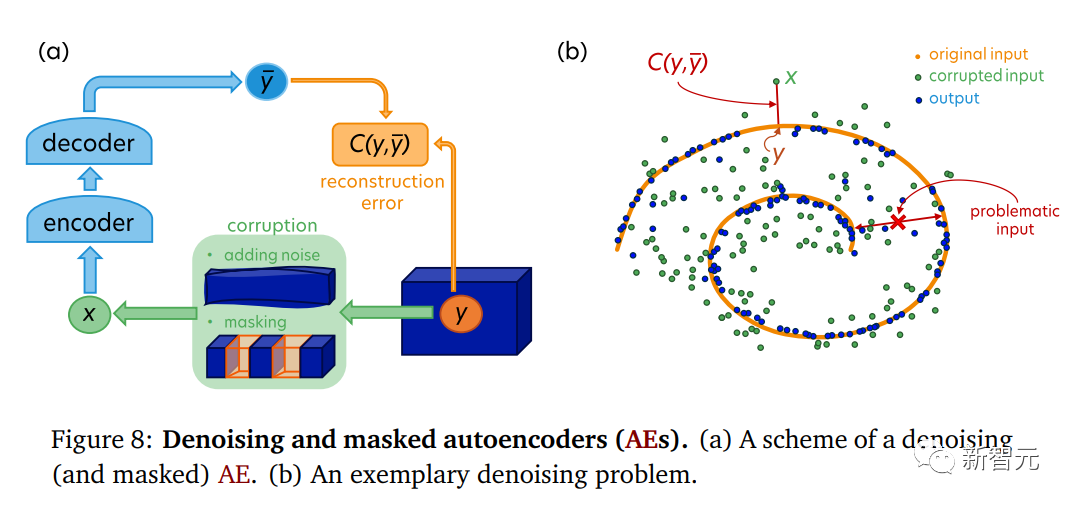

去噪自編碼器

去噪自編碼器(Denoising Autoencoder,AE)是一種對比式EBM。

它是一種經過訓練的自編碼器,用于恢復被損壞輸入的干凈版本。

其架構示意圖如下圖8(a)所示。

例如,該自編碼器可以經過訓練,使數據點在添加隨機噪聲后恢復到其原始位置,如圖8(b)所示。

原始數據點來自橙色螺旋線,并通過在其位置上添加一些噪聲進行損壞。

然后,將損壞的綠色數據點作為x輸入到下圖8(a)中的去噪自編碼器,同時提供其干凈版本y。

重構誤差是損壞點與原始點之間的距離,當最小化時,去噪自編碼器輸出的藍色數據點將回到螺旋線上。

需要注意的是,在同一個問題中,也存在對于去噪自編碼器可能無法處理的問題點。例如,自編碼器無法重構位于螺旋線兩個分支之間、與它們等距離的數據點。

這個問題是由數據的折疊結構導致的,然而,在真實世界的數據中很少出現(xiàn)這種情況。

未來自主系統(tǒng)的構建模塊

在上文中,我們看到了EBM如何克服概率模型的局限性之后,并且對于高維數據,可能應該使用正則化方法而不是對比式方法來訓練它們。

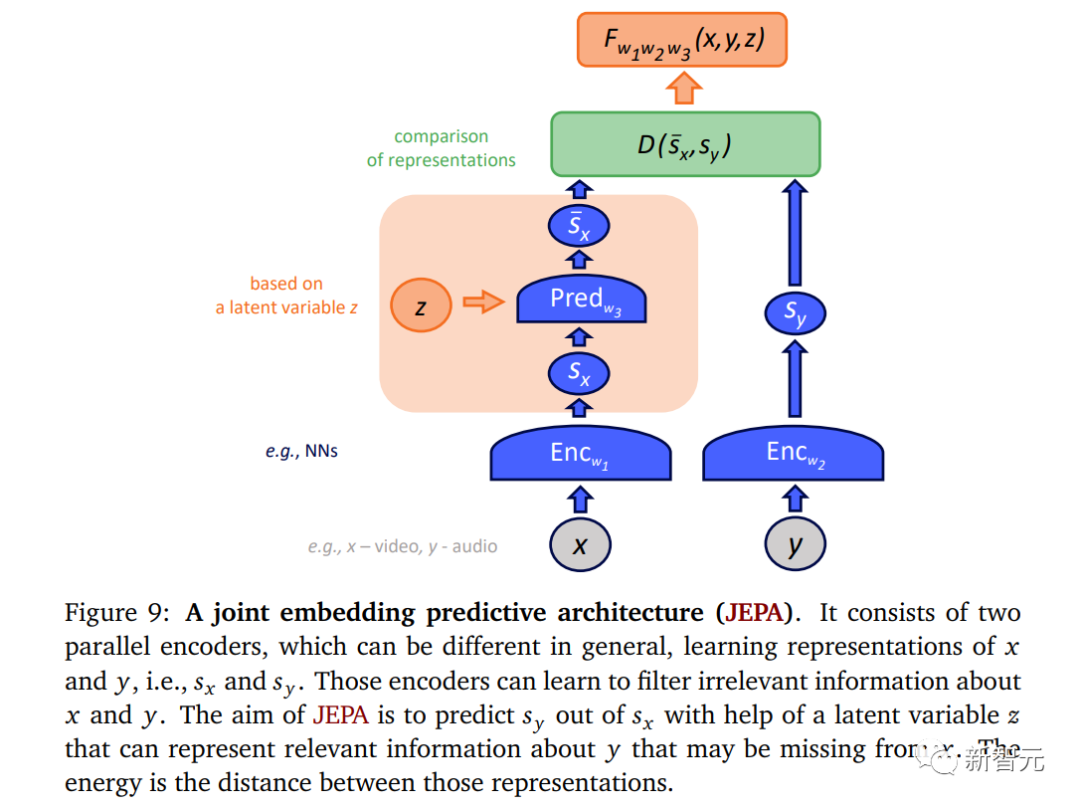

討論了潛變量模型并解釋了它們在結構化預測問題或融入不確定性方面的用途之后,可以這些優(yōu)勢結合到一種稱為聯(lián)合嵌入預測架構(JEPA)的架構中。

這就是昨天Meta發(fā)布的I-JEPA模型的原理。

聯(lián)合嵌入預測架構

聯(lián)合嵌入預測架構(JEPA)是一種將嵌入模塊與潛變量結合的EBM,如圖9所示。

作為一個EBM,JEPA學習輸入數據x和y之間的依賴關系,但是在學習的內部表示Sx和Sy的層次上進行比較,其中si = Enc(i)。

產生表示sx和sy的兩個編碼器可以不同,特別是具有不同的架構,并且不共享參數。

由于這一點,輸入數據可以具有各種格式(例如視頻和音頻)。

此外,JEPA自然地處理多模態(tài)數據。

首先,x和y的編碼器可以具有不變性特性,例如,將各種y映射到相同的Sy。

訓練JEPA的最終目標是使表示Sx和Sy可以相互預測。

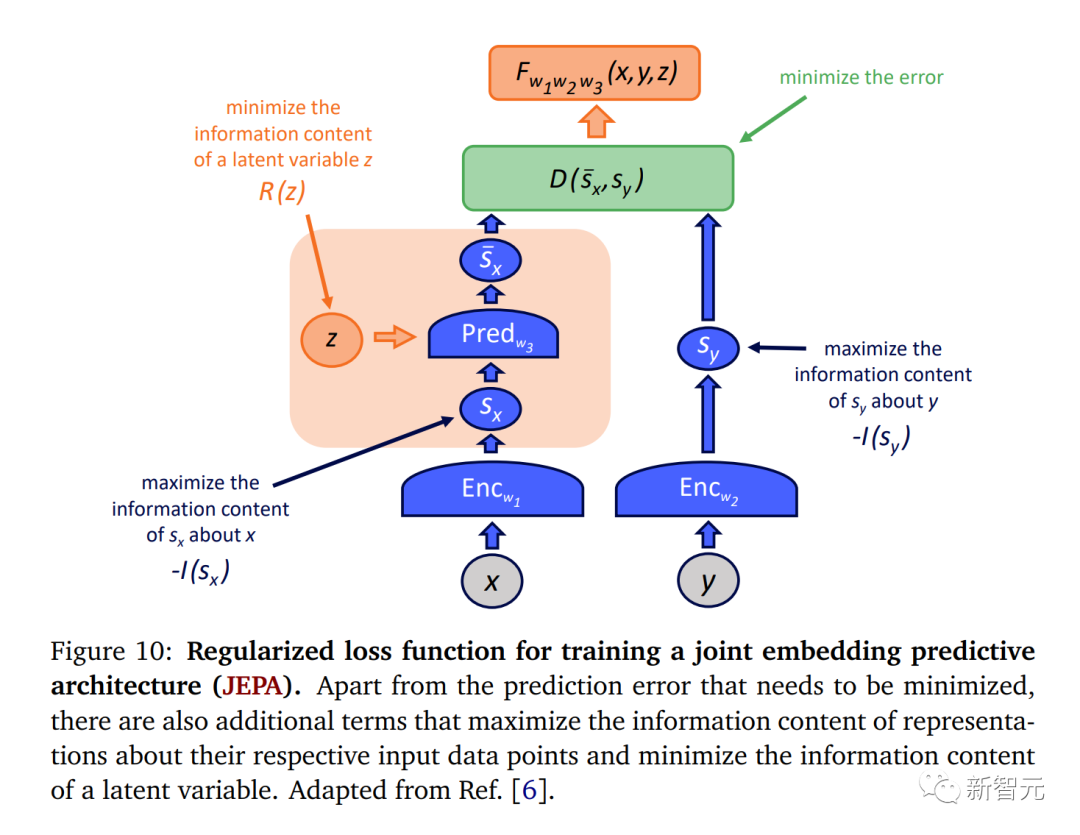

如我們在第4節(jié)中討論的,EBM可以使用對比式方法和正則化方法進行訓練,但對比式方法在高維情況下往往效率非常低下。

因此,JEPA可以使用損失函數進行訓練,該損失函數除了包括預測誤差外,還包括如下圖10所示的正則化項。

特別是為了防止信息能量崩潰,我們需要確保sx和sy盡可能多地攜帶關于x和y的信息。

否則,訓練過程可能會導致編碼器成為常數。

最后,我們需要最小化或限制潛變量的信息內容,以防止模型僅僅依賴于其中的信息。

結論

在筆記中,我們總結了LeCun的主要觀點,解決了上邊提到的AI現(xiàn)在發(fā)展中的局限性。

在第3節(jié)中,我們解釋了由于現(xiàn)實世界的數據(如視頻或文本)通常具有高維度,基于能量模型的發(fā)展方向(EBM)可能是比概率模型更有前景的發(fā)展方向。

在第4節(jié)中,我們介紹了對訓練EBM的對比和正則化方法,并解釋了由于在高維度中生成對比樣本的成本巨大,正則化方法似乎更有前景用于訓練未來的EBM。

在第5節(jié)中,我們給出了EBM的歷史和現(xiàn)實的實際用例。

最后,第6節(jié)集中討論了這個事實:人類決策過程基于各種格式和模態(tài)的數據,其結構通常需要解碼才能進行預測,而且還包含可能是多余的信息。

這種多模態(tài)的障礙可以通過LeCun提出的一種新架構,在3個維度解決,這種構架被稱為聯(lián)合嵌入預測架構(JEPAs)。

最終,我們將要面對的挑戰(zhàn)是使未來的自主AI能夠對各種時間尺度和抽象級別上的世界狀態(tài)進行預測。這種多層次的預測可以通過分層聯(lián)合嵌入預測架構(H-JEPA)來實現(xiàn)。

通過正則化方法訓練的這種架構,可能是設計能夠在不確定性下的預測世界模型的起點,這將成為未來自主AI發(fā)展中取得突破。