擠爆服務(wù)器,北大法律大模型ChatLaw火了:直接告訴你張三怎么判

大模型又「爆了」。

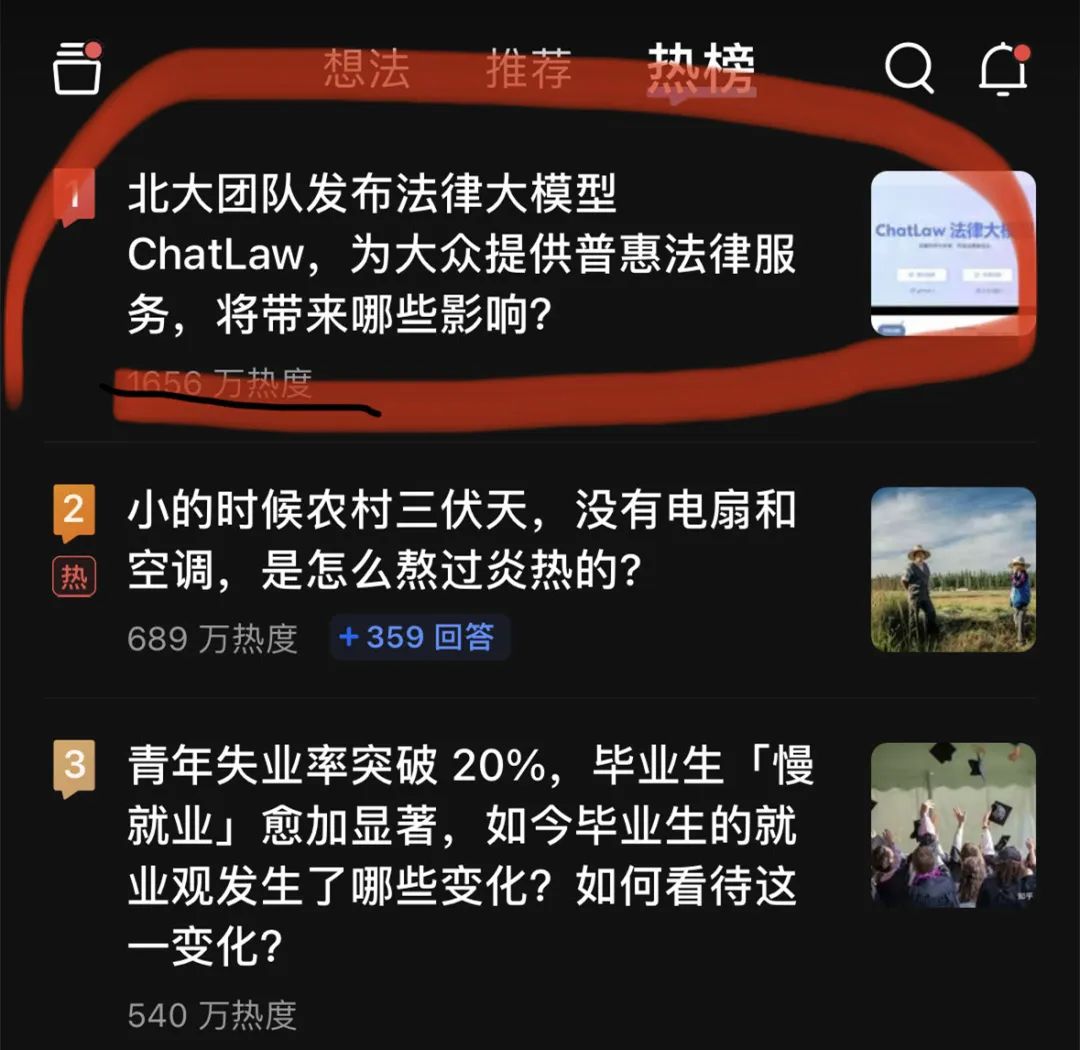

昨晚,一個(gè)法律大模型 ChatLaw 登上了知乎熱搜榜榜首。熱度最高時(shí)達(dá)到了 2000 萬左右。

這個(gè) ChatLaw 由北大團(tuán)隊(duì)發(fā)布,致力于提供普惠的法律服務(wù)。一方面當(dāng)前全國(guó)執(zhí)業(yè)律師不足,供給遠(yuǎn)遠(yuǎn)小于法律需求;另一方面普通人對(duì)法律知識(shí)和條文存在天然鴻溝,無法運(yùn)用法律武器保護(hù)自己。

大語言模型最近的崛起正好為普通人以對(duì)話方式咨詢法律相關(guān)問題提供了一個(gè)絕佳契機(jī)。

目前,ChatLaw 共有三個(gè)版本,分別如下:

- ChatLaw-13B,為學(xué)術(shù) demo 版,基于姜子牙 Ziya-LLaMA-13B-v1 訓(xùn)練而來,中文各項(xiàng)表現(xiàn)很好。但是,邏輯復(fù)雜的法律問答效果不佳,需要用更大參數(shù)的模型來解決;

- ChatLaw-33B,也為學(xué)術(shù) demo 版,基于 Anima-33B 訓(xùn)練而來,邏輯推理能力大幅提升。但是,由于 Anima 的中文語料過少,問答時(shí)常會(huì)出現(xiàn)英文數(shù)據(jù);

- ChatLaw-Text2Vec,使用 93w 條判決案例做成的數(shù)據(jù)集,基于 BERT 訓(xùn)練了一個(gè)相似度匹配模型,可以將用戶提問信息和對(duì)應(yīng)的法條相匹配。

根據(jù)官方演示,ChatLaw 支持用戶上傳文件、錄音等法律材料,幫助他們歸納和分析,生成可視化導(dǎo)圖、圖表等。此外,ChatLaw 可以基于事實(shí)生成法律建議、法律文書。該項(xiàng)目在 GitHub 上的 Star 量達(dá)到了 1.1k。

圖片

圖片

官網(wǎng)地址:https://www.chatlaw.cloud/

論文地址:https://arxiv.org/pdf/2306.16092.pdf

GitHub 地址:https://github.com/PKU-YuanGroup/ChatLaw

目前,由于 ChatLaw 項(xiàng)目太過火爆,服務(wù)器暫時(shí)崩潰,算力已達(dá)上限。該團(tuán)隊(duì)正在修復(fù),感興趣的讀者可以在 GitHub 上部署測(cè)試版模型。

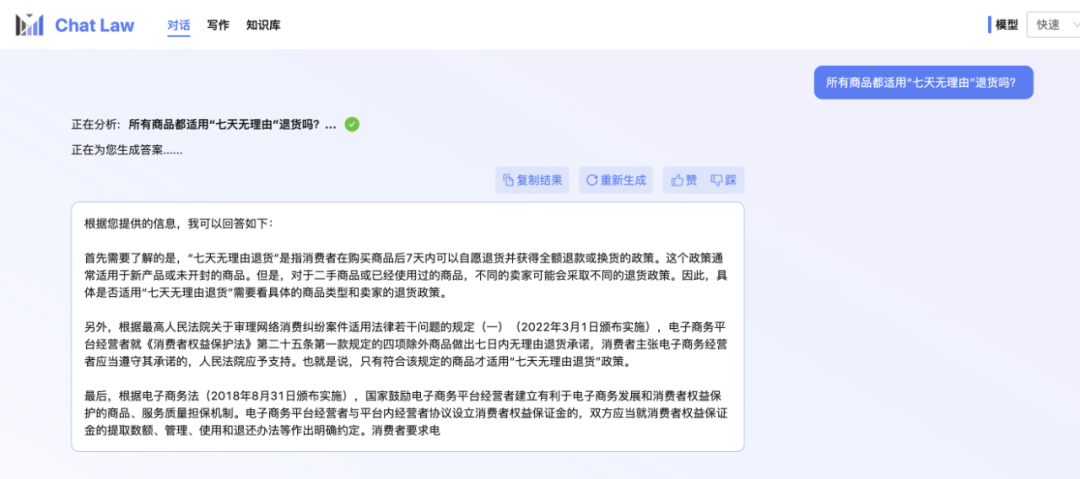

小編本人也還在內(nèi)測(cè)排隊(duì)中。所以這里先展示一個(gè) ChatLaw 團(tuán)隊(duì)提供的官方對(duì)話示例,關(guān)于日常網(wǎng)購(gòu)時(shí)可能會(huì)遇到的「七天無理由退貨」問題。不得不說,ChatLaw 回答挺全的。

圖片

圖片

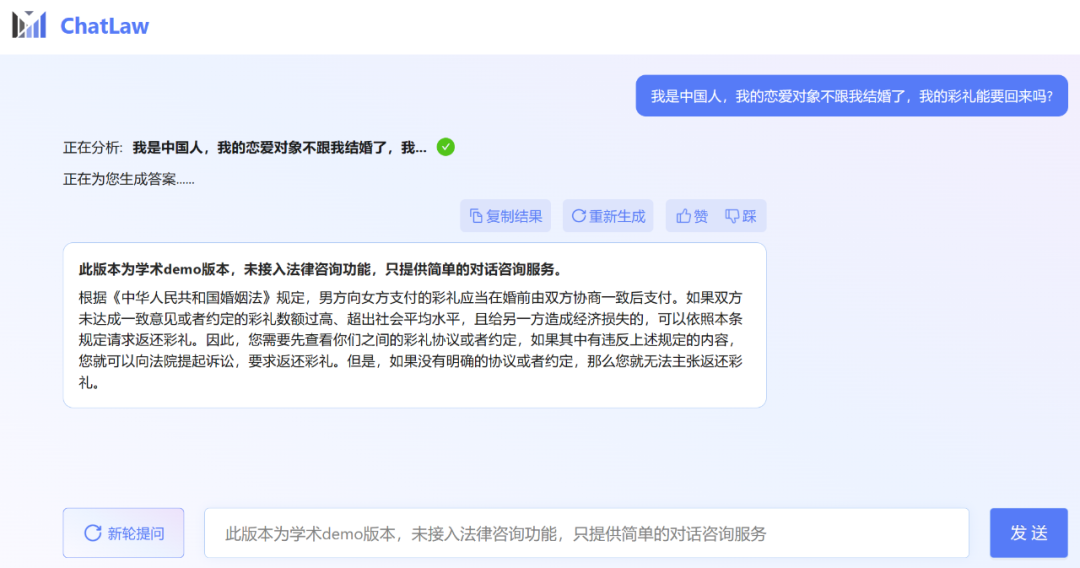

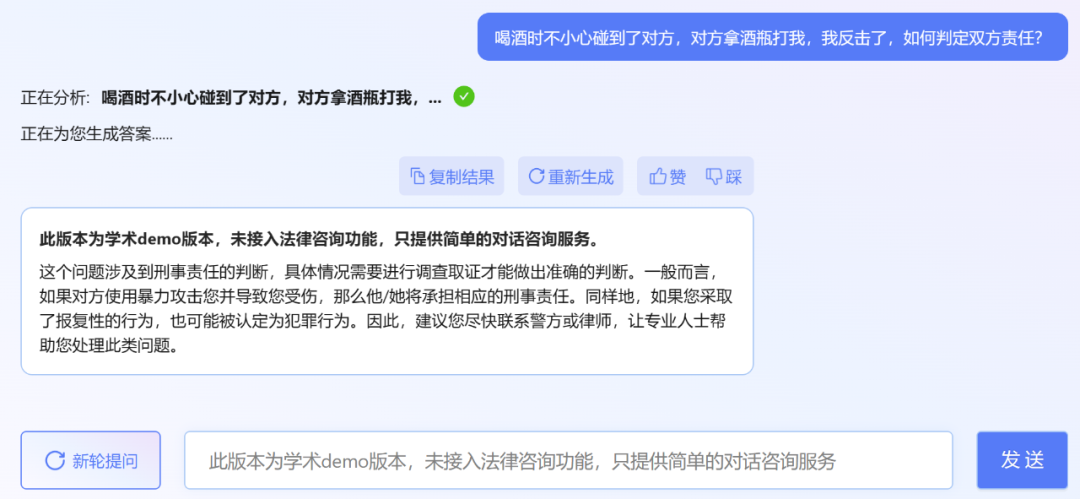

不過,小編發(fā)現(xiàn),ChatLaw 的學(xué)術(shù) demo 版本可以試用,遺憾的是沒有接入法律咨詢功能,只提供了簡(jiǎn)單的對(duì)話咨詢服務(wù)。這里嘗試問了幾個(gè)問題。

圖片

圖片

其實(shí)最近發(fā)布法律大模型的不只有北大一家。上個(gè)月底,冪律智能聯(lián)合智譜 AI 發(fā)布了千億參數(shù)級(jí)法律垂直大模型 PowerLawGLM。據(jù)悉該模型針對(duì)中文法律場(chǎng)景的應(yīng)用效果展現(xiàn)出了獨(dú)特優(yōu)勢(shì)。

ChatLaw 的數(shù)據(jù)來源、訓(xùn)練框架

首先是數(shù)據(jù)組成。ChatLaw 數(shù)據(jù)主要由論壇、新聞、法條、司法解釋、法律咨詢、法考題、判決文書組成,隨后經(jīng)過清洗、數(shù)據(jù)增強(qiáng)等來構(gòu)造對(duì)話數(shù)據(jù)。同時(shí),通過與北大國(guó)際法學(xué)院、行業(yè)知名律師事務(wù)所進(jìn)行合作,ChatLaw 團(tuán)隊(duì)能夠確保知識(shí)庫(kù)能及時(shí)更新,同時(shí)保證數(shù)據(jù)的專業(yè)性和可靠性。下面我們看看具體示例。

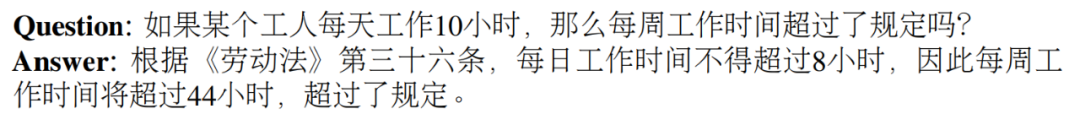

基于法律法規(guī)和司法解釋的構(gòu)建示例:

抓取真實(shí)法律咨詢數(shù)據(jù)示例:

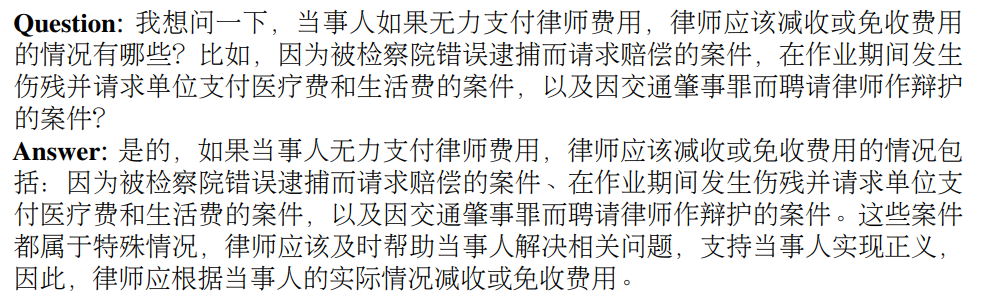

律師考試多項(xiàng)選擇題的建構(gòu)示例:

圖片

圖片

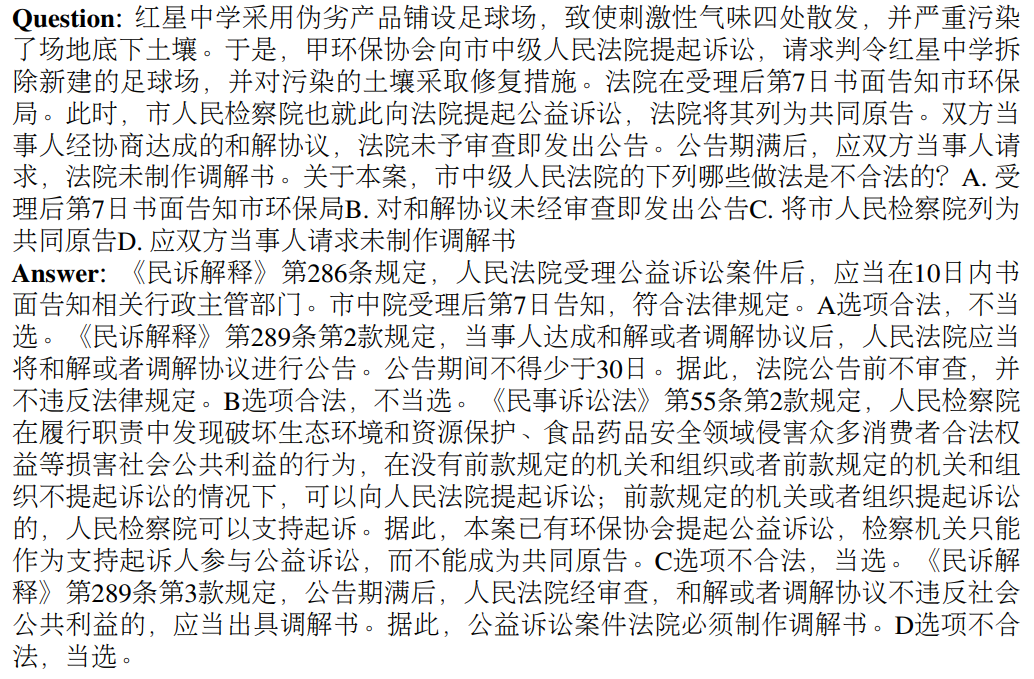

然后是模型層面。為了訓(xùn)練 ChatLAW,研究團(tuán)隊(duì)在 Ziya-LLaMA-13B 的基礎(chǔ)上使用低秩自適應(yīng) (Low-Rank Adaptation, LoRA) 對(duì)其進(jìn)行了微調(diào)。此外,該研究還引入 self-suggestion 角色,來緩解模型產(chǎn)生幻覺問題。訓(xùn)練過程在多個(gè) A100 GPU 上進(jìn)行,并借助 deepspeed 進(jìn)一步降低了訓(xùn)練成本。

如下圖為 ChatLAW 架構(gòu)圖,該研究將法律數(shù)據(jù)注入模型,并對(duì)這些知識(shí)進(jìn)行特殊處理和加強(qiáng);與此同時(shí),他們也在推理時(shí)引入多個(gè)模塊,將通識(shí)模型、專業(yè)模型和知識(shí)庫(kù)融為一體。

該研究還在推理中對(duì)模型進(jìn)行了約束,這樣才能確保模型生成正確的法律法規(guī),盡可能減少模型幻覺。

圖片

圖片

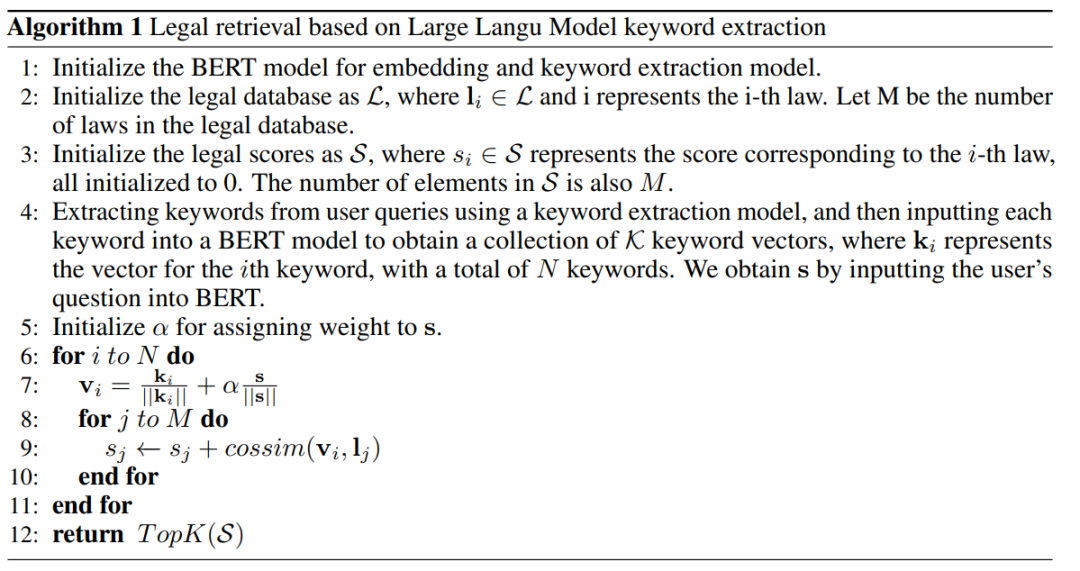

一開始研究團(tuán)隊(duì)嘗試傳統(tǒng)的軟件開發(fā)方法,如檢索時(shí)采用 MySQL 和 Elasticsearch,但結(jié)果不盡如人意。因而,該研究開始嘗試預(yù)訓(xùn)練 BERT 模型來進(jìn)行嵌入,然后使用 Faiss 等方法以計(jì)算余弦相似度,提取與用戶查詢相關(guān)的前 k 個(gè)法律法規(guī)。

當(dāng)用戶的問題模糊不清時(shí),這種方法通常會(huì)產(chǎn)生次優(yōu)的結(jié)果。因此,研究者從用戶查詢中提取關(guān)鍵信息,并利用該信息的向量嵌入設(shè)計(jì)算法,以提高匹配準(zhǔn)確性。

由于大型模型在理解用戶查詢方面具有顯著優(yōu)勢(shì),該研究對(duì) LLM 進(jìn)行了微調(diào),以便從用戶查詢中提取關(guān)鍵字。在獲得多個(gè)關(guān)鍵字后,該研究采用算法 1 檢索相關(guān)法律規(guī)定。

圖片

圖片

實(shí)驗(yàn)結(jié)果

該研究收集了十余年的國(guó)家司法考試題目,整理出了一個(gè)包含 2000 個(gè)問題及其標(biāo)準(zhǔn)答案的測(cè)試數(shù)據(jù)集,用以衡量模型處理法律選擇題的能力。

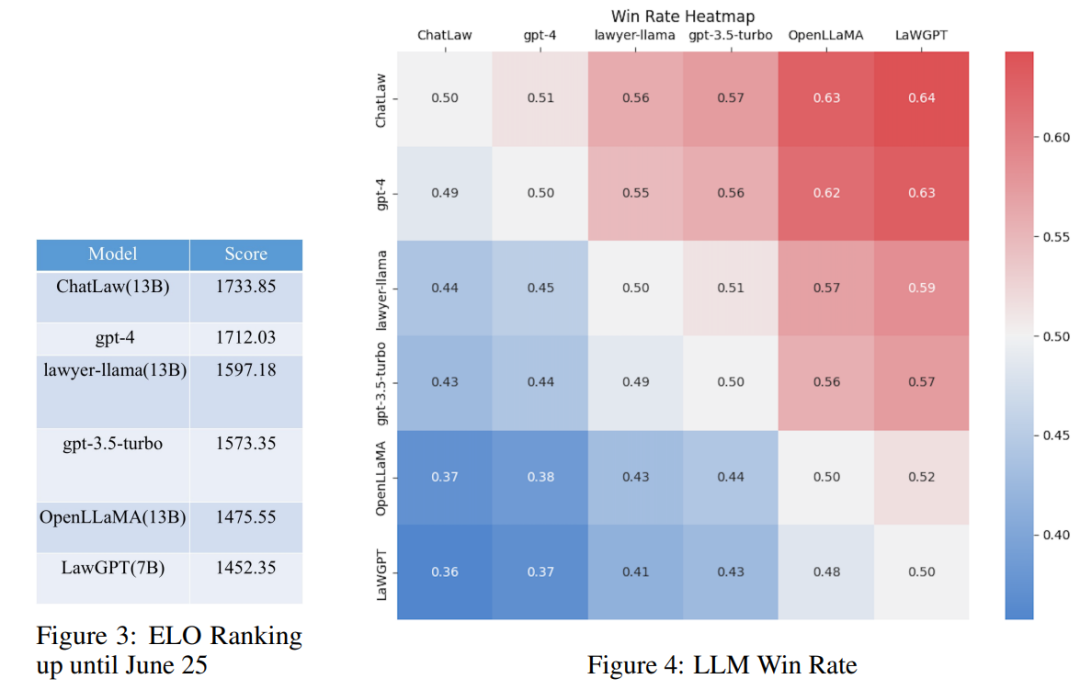

然而,研究發(fā)現(xiàn)各個(gè)模型的準(zhǔn)確率普遍偏低。在這種情況下,僅對(duì)準(zhǔn)確率進(jìn)行比較并無多大意義。因此,該研究借鑒英雄聯(lián)盟的 ELO 匹配機(jī)制,做了一個(gè)模型對(duì)抗的 ELO 機(jī)制,以便更有效地評(píng)估各模型處理法律選擇題的能力。以下分別是 ELO 分?jǐn)?shù)和勝率圖:

圖片

圖片

通過對(duì)上述實(shí)驗(yàn)結(jié)果的分析,我們可以得出以下觀察結(jié)果

(1)引入與法律相關(guān)的問答和法規(guī)條文的數(shù)據(jù),可以在一定程度上提高模型在選擇題上的表現(xiàn);

(2)加入特定類型任務(wù)的數(shù)據(jù)進(jìn)行訓(xùn)練,模型在該類任務(wù)上的表現(xiàn)會(huì)明顯提升。例如,ChatLaw 模型優(yōu)于 GPT-4 的原因是文中使用了大量的選擇題作為訓(xùn)練數(shù)據(jù);

(3)法律選擇題需要進(jìn)行復(fù)雜的邏輯推理,因此,參數(shù)量更大的模型通常表現(xiàn)更優(yōu)。

參考知乎鏈接:

https://www.zhihu.com/question/610072848

其他參考鏈接:

https://mp.weixin.qq.com/s/bXAFALFY6GQkL30j1sYCEQ