12種模態,一個學習框架,Meta-Transformer實現骨干網絡大一統

在邁向通用人工智能(AGI)的諸多可能的方向中,發展多模態大模型(MLLM)已然成為當前炙手可熱的重要路徑。在 GPT4 對圖文理解的沖擊下,更多模態的理解成為學術界關注的焦點,通感時代真要來了嗎?

我們知道,人類在學習的過程中不僅僅會接觸到文字、圖像,還會同時接觸聲音、視頻等各種模態的信息,并在腦中對這些信息同時進行加工處理和統一學習。

那么:人工智能可以具備人類統一學習多模態信息的能力嗎?事實上,多模態之間的互補性可以增強人工智能的學習能力,比如,CLIP 將圖像與文本進行統一學習的方式就取得了巨大的成功。但受限于多種模態之間巨大的差異性以及現有多模態模型對配對數據的依賴性,實現模態通用感知存在著艱巨挑戰。

為了解決上述挑戰,近日,香港中文大學多媒體實驗室聯合上海人工智能實驗室的研究團隊提出一個統一多模態學習框架 ——Meta-Transformer,采用全新的設計思路,通過統一學習無配對數據,可以理解 12 種模態信息。

圖片

圖片

- 網站地址:https://kxgong.github.io/meta_transformer/

- 代碼地址:https://github.com/invictus717/MetaTransformer

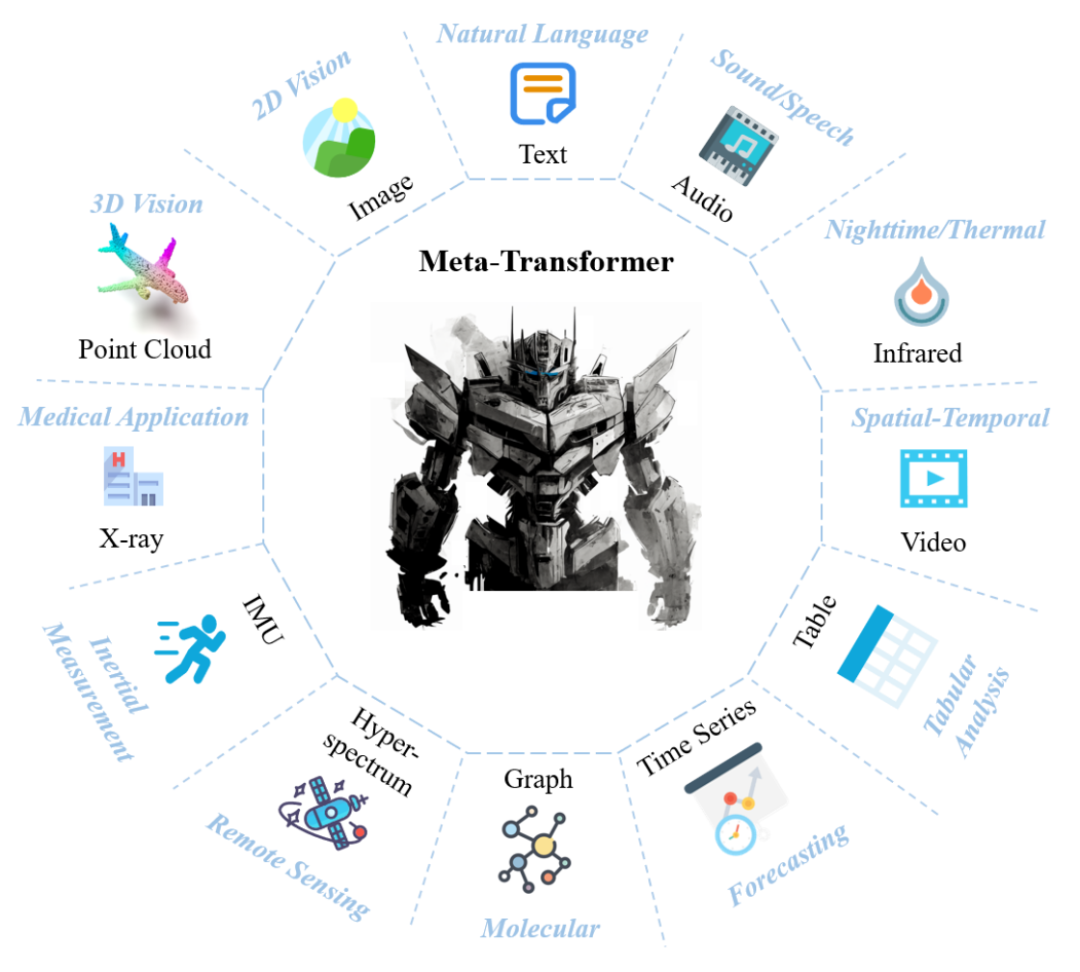

Meta-Transformer 實現骨干網絡的大一統,具有一個模態共享編碼器,并且無需配對數據,能夠在 12 個不同的模態上完成 16 個不同的感知任務。該工作不僅為當前多模態學習提供了強大的工具,也給多模態領域帶來新的設計思路。

圖 1:Meta-Transformer 框架下統一的多模態感知,能夠處理 12 種不同的模態

圖 1:Meta-Transformer 框架下統一的多模態感知,能夠處理 12 種不同的模態

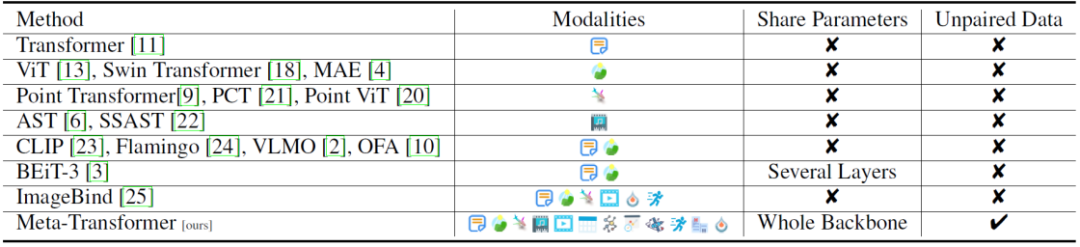

表 1:相比于現有工作,Meta-Transformer 可以利用統一的模態共享編碼器來處理更多的模態,并且擺脫了多模態訓練過程中對于配對數據的依賴性。

接下來,一起詳細看一看 Meta-Transformer 的創新與貢獻體現在哪些方面。

Meta-Transformer 通向無限模態的感知范式

1、統一的模態共享編碼器

相比于先前 CLIP 使用不同的圖像和文本編碼器,以及 BEIT-3 的部分共享編碼器框架,Meta-Transformer 的核心設計在于一個所有模態完全共享的編碼器。該設計在編碼器層面統一多達 12 個模態,證明了多模態數據完全共享編碼器的可行性。共享編碼器有助于在編碼器階段減小由不同的網絡參數引入的表征差異,這離統一的多模態感知智能更近了一步,即一個通用的網絡結構處理任意模態的信息。

Meta-Transformer 可以有效地處理和學習高達 12 種模態的數據,從常見的文本、圖像到音頻、視頻,甚至在其他更復雜的數據類型上也有所突破,如點云和高光譜數據。該設計有助于拓寬未來的多模態工作的設計思路。

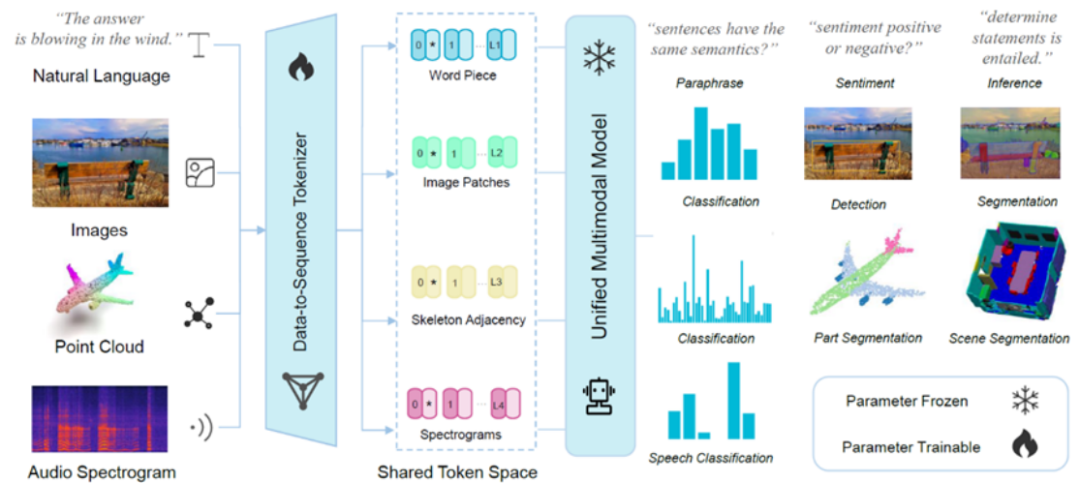

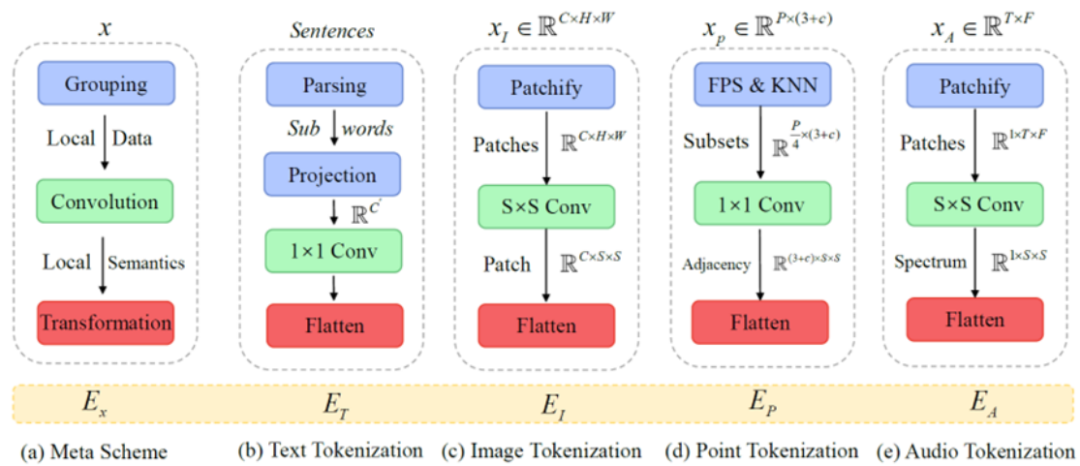

圖 2:Meta-Transformer 的框架圖:對于不同模態的數據,研究人員基于不同模態的信息特性設計了相應的特征序列構造方式,接著將得到的特征序列輸入到預訓練后參數凍結的編碼器中,由此提取的表征能夠在多個模態上解決下游多個任務。

2、無需配對數據:更加靈活的訓練方式

當前許多模態工作依賴于內容配對的多模態數據來語義對齊兩個模態,但收集生成多個模態兩兩之間配對的數據的高難度限制了當前的多模態工作推廣到更廣泛的數據模態上。為了緩解這一限制,該研究提出 Data2Seq 方法, 將不同模態的原數據嵌入到一個共同編碼空間,轉換成各自對應 token 序列,隨后使用統一的模態共享編碼器繼續編碼 token 序列,因而任一模態的數據就可以訓練 Meta-Transformer 感知相應的模態的能力。實驗表明,Meta-Transformer 能夠在缺少配對數據訓練場景下展現優異性能。

3、更多模態:通向模態通用感知

現有的多模態模態框架多側重于視覺和語言,較少衍生到更多其他模態。相比之下,Meta-Transformer 能夠對于 12 種不同的數據模態提供一套統一的學習框架,包括文本、圖像、點云、音頻、視頻、紅外、超光譜、X 射線、表格、圖形、時間序列和慣性測量單元(IMU)數據。這種廣泛的數據模態覆蓋,極大擴展了 Meta-Transformer 的應用范圍,并且 Meta-transformer 框架對于擴展到更多的模態有著易擴展、低成本、高訓練效率的優勢。

Meta-Transformer 的方法介紹

Meta-Transformer 統一處理來自不同模態的數據,并通過共享編碼器完成對十二種模態的編碼。為了實現這一目標,Meta-Transformer 由三個部分組成:Data2Seq tokenization 模塊、統一的共享編碼模塊和下游任務學習模塊。

首先,研究人員提出了一套處理多模態數據的核心方案:數據分組 — 卷積提取局部語義 — 語義聚合 —— 空間映射,將各種模態的數據轉換為在同一個共享的嵌入空間內的 token 序列。

圖 3:Data-to-Sequence 的設計方案能夠有效地將不同模態的數據轉化為同一個流行嵌入空間內的 token 序列,具有極強的模態拓展性。

緊接著,Meta-Transformer 將使用統一的共享編碼器對上一步得到的的不同模態的 token 序列進行編碼。研究人員使用 LAION-2B 數據集對于骨干網絡進行預訓練,在預訓練之后凍結了模型參數,得到深度為 L 的 Transformer 編碼器由多個堆疊的多頭自注意力(MSA)層和 MLP 塊組成。輸入的 token 首先進入 MSA 層,然后進入 MLP 塊。然后第 (?- 1) 個 MLP 塊的輸出作為第?個 MSA 層的輸入,層歸一化(LN)被添加到每一層之前。MLP 包含兩個線性 FC 層和一個 GELU 非線性激活層。

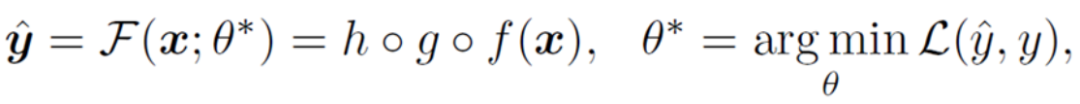

最后,在獲得學習表征后,研究人員將表征輸入特定任務的頭,它主要由 MLP 組成,因模態和任務而異。Meta-Transformer 的學習目標可以概括為

其中 h (?),g (?),與 f (?),分別表示 tokenizer,模型骨干網絡,以及下游任務網絡中的運算過程。

實驗結果

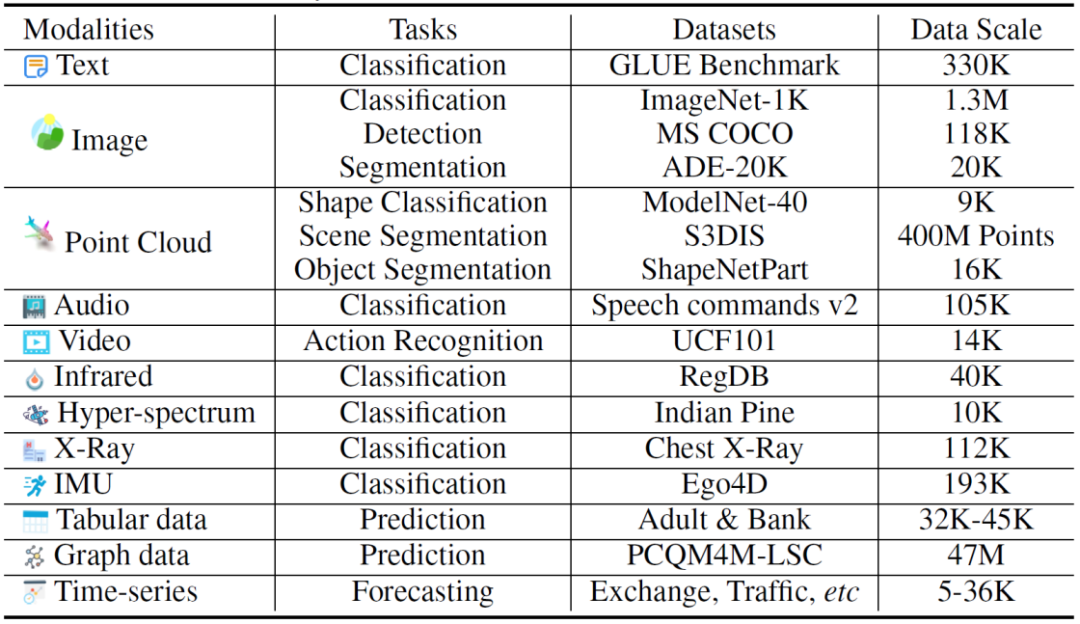

Meta-Transformer 具有豐富且優秀的實驗結果。下表 2 展示了 Meta-Transformer 在不同模態上的實驗內容。可以看出,Meta-Transformer 從 12 種模態中提取表征信息,能夠有效地服務 16 個不同模態的下游任務,且擁有出色的性能。

表 2:Meta-Transformer 能處理 12 個模態的 16 個感知任務.

圖片

圖片

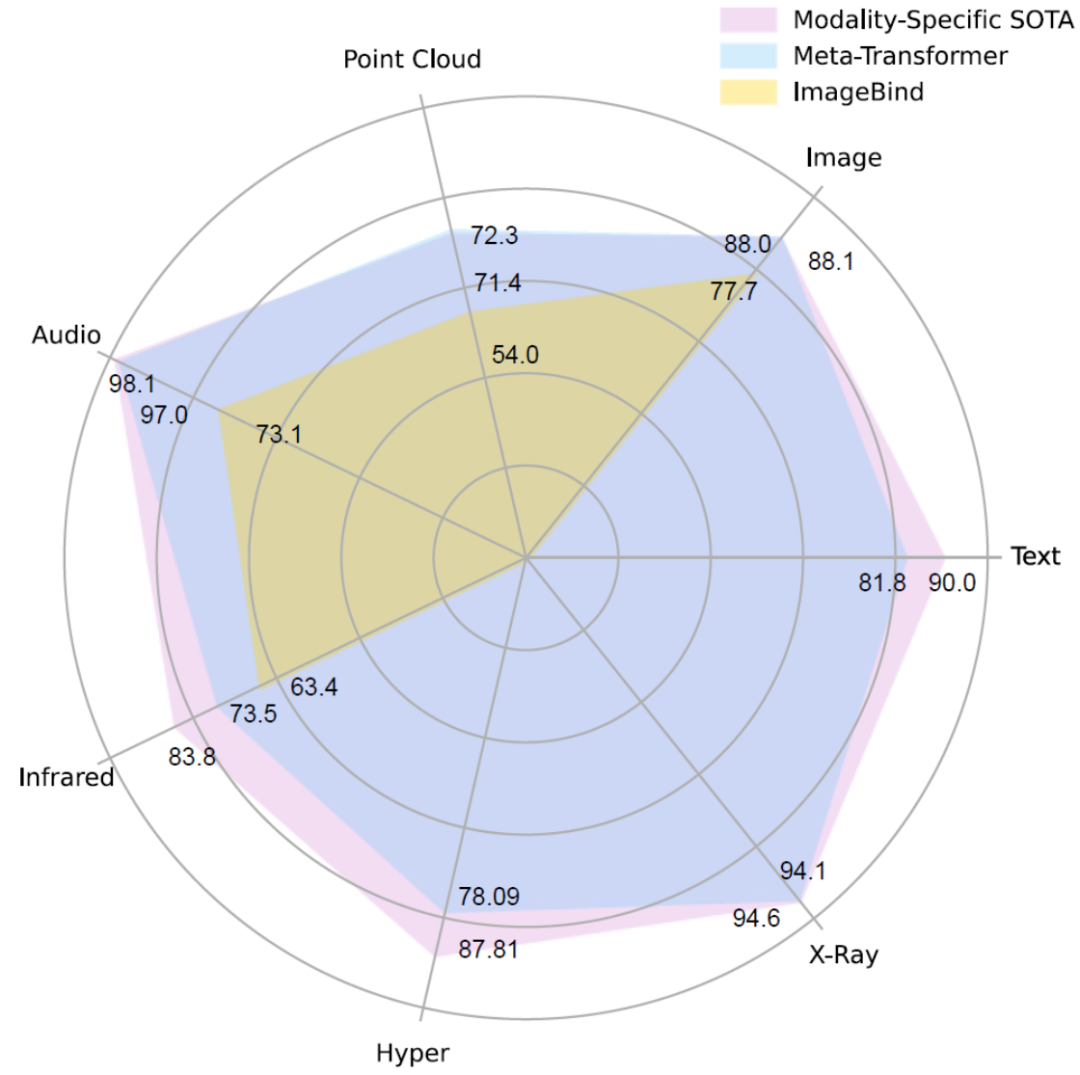

圖 3:Meta-Transforme 有著優秀的多模態感知能力,在文字、圖像、點云、聲音、紅外、高光譜以及醫療 X 光圖像理解任務方面與現有的單模態 SOTA 模型性能相接近,并且在多模態理解能力方面大幅領先 ImageBind.

對于圖像理解:

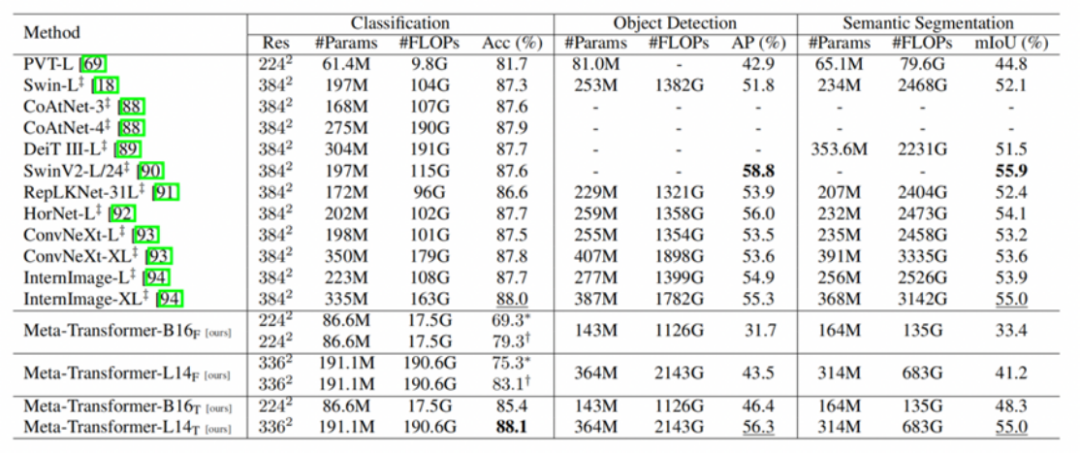

如下表 3 所示,與 Swin Transformer 系列和 InternImage 相比,Meta-Transformer 在圖像理解任務中表現突出。在分類任務中,Meta-Transformer 與 Meta-Transformer-B16F 和 Meta-Transformer-L14F 在零鏡頭分類下的表現非常好,分別達到了 69.3% 和 75.3%。與此同時,當調整預訓練參數時,Meta-Transformer-B16T 和 Meta-Transformer-L14T 分別達到 85.4% 和 88. 1% 的準確率,超越了現有最先進的方法。在目標檢測與語義分割方面,Meta-Transformer 也提供了出色的性能,進一步證明了其對圖像理解的通用能力。

表 3:Meta-Transformer 對于圖像理解方面的能力,分別在 ImageNet-1K 圖像分類,MS COCO 目標檢測,以及 ADE-20K 的語義分割上進行了評估。

對于點云理解:

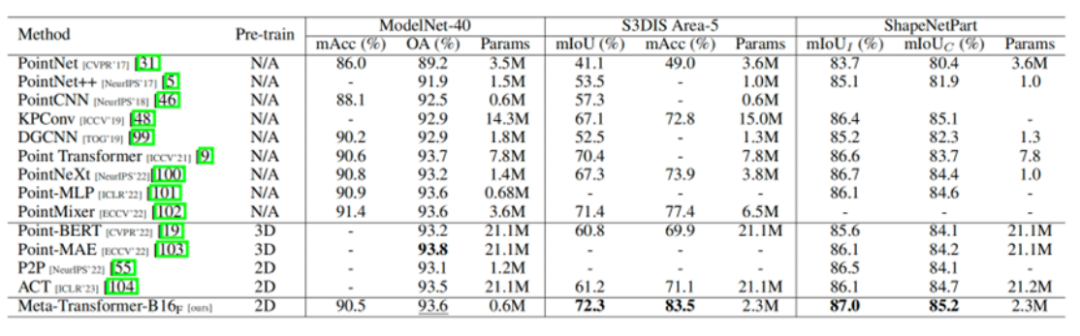

表 4 展示了 Meta-Transformer 在點云上的實驗結果。當在二維數據上進行預訓練時,Meta-Transformer 在 ModelNet-40 上僅用 0.6M 可訓練參數就達到了 93.6% 的總體準確率(OA),與表現最好的模型不相上下。此外,Meta-Transformer 在 ShapeNetPart 數據集中表現出色,僅訓練 2.3M 參數的情況下,在實例 mIoU 和類別 mIoU 方面都獲得了最好的實驗結果,分別為 87.0% 和 85.2%。由此可見,Meta-Transformer 在點云理解任務中表現出了顯著的優勢,在可訓練參數較少的情況下提供了具有競爭力的性能。

表 4:Meta-Transformer 對于點云理解方面的能力,分別在 ModelNet-40 形狀分類,S3DIS 室內場景分割,以及 ShapeNet Part 物體分割任務上進行了評估。

研究結論

Meta-Transformer 是一種統一的多模態學習框架,它能處理并關聯來自多種模態的信息,包括自然語言、2D 圖像、3D 點云、音頻、視頻等。它實現了無配對訓練數據的場景下進行多模態感知,是第一個能夠在 12 種模態上進行統一學習的框架。Meta-Transformer 能夠有助于將多模態大模型推廣至更多模態,也為實現統一的多模態智能提供了參考。Meta-Transformer 具有的多模態感知理解能力也會為人工智能技術作為服務全社會的基礎設施,對于教育、醫療、娛樂等領域提供更智能、更便捷、更豐富多元的服務。