RLHF缺陷完整揭示!MIT哈佛等32位學(xué)者聯(lián)合發(fā)布

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

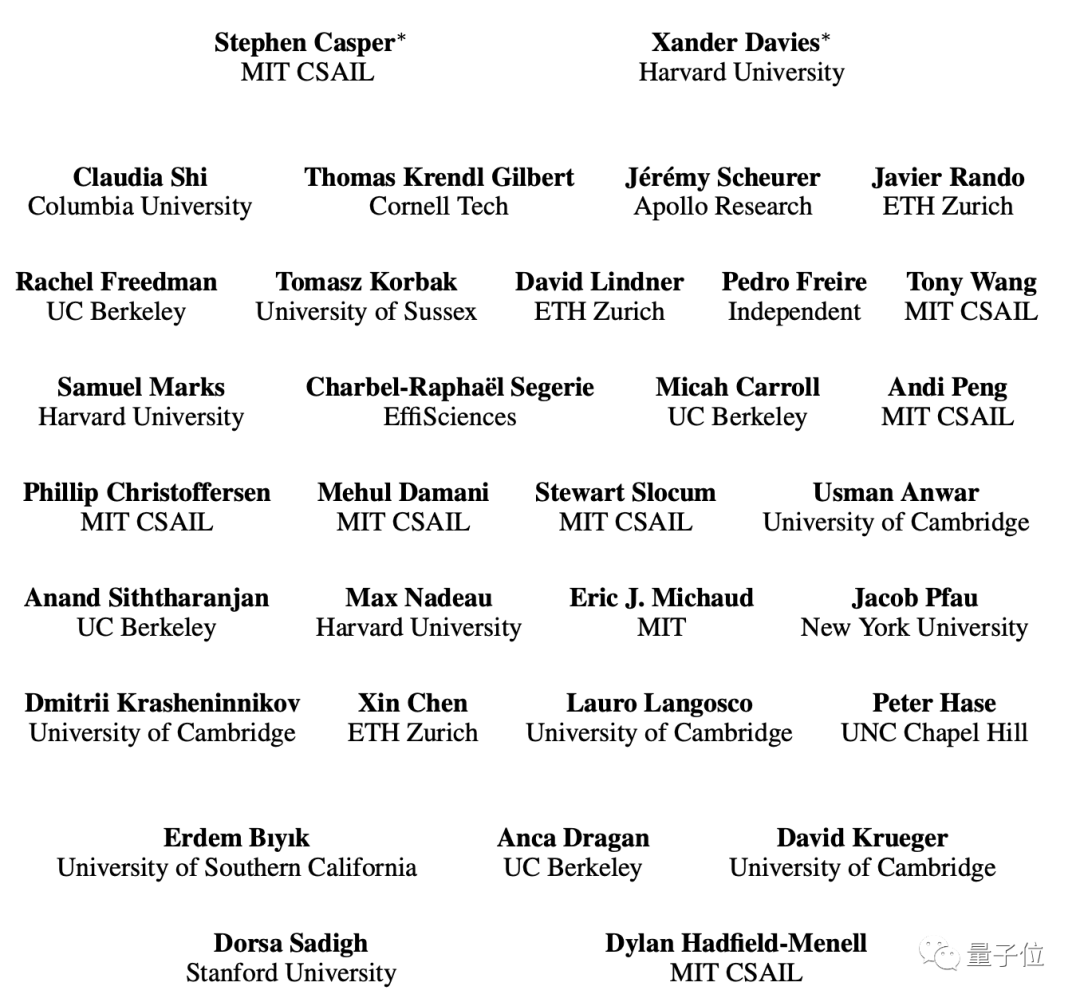

MIT哈佛斯坦福等機構(gòu)在內(nèi)的32位科學(xué)家聯(lián)合指出:

被視作ChatGPT成功關(guān)鍵的RLHF,存在缺陷,而且分布在各個環(huán)節(jié)。

他們調(diào)查翻閱了250篇相關(guān)論文,僅研究正文就長達18頁,其中7頁描述了具體缺陷。

此研究一經(jīng)發(fā)出,就受到大量關(guān)注。

有網(wǎng)友表示:這是一次偉大嘗試。所有這些都是為了幫助啟動 RLHF 的學(xué)術(shù)議程。

第一作者Casper還給了RLHF一個「新的解釋」:

Rehashing Lessons from Historical Failures

從歷史的失敗中汲取經(jīng)驗

不僅指出問題,還有解決方案

作者在論文中表示,這項研究主要有三項貢獻。

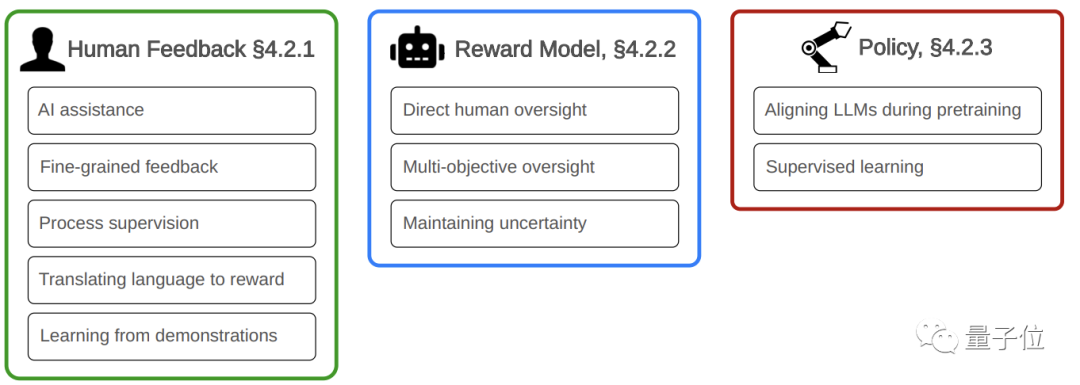

第一是指出了RLHF在人類反饋、獎勵模型和決策三個主要環(huán)節(jié)中的缺陷。

第二點則是針對這些問題,提供了具體的解決思路。

第三則是呼吁提高RLHF訓(xùn)練出的模型的透明度,并表示訓(xùn)練信息公開有助于提高企業(yè)責(zé)任感。

我們先來看看作者在各個環(huán)節(jié)中都指出了哪些具體缺陷。

人類反饋的局限性

RLHF區(qū)別于其他強化學(xué)習(xí)方式的關(guān)鍵之處就在于人類反饋。

但作者認(rèn)為,人類反饋很容易存在不準(zhǔn)確的情況,因而是缺陷的一大重要來源。

在人類反饋環(huán)節(jié)中,作者首先提到的是人類會產(chǎn)生誤導(dǎo)性評價。

對大模型而言,所涉及的專業(yè)領(lǐng)域涵蓋了方方面面,沒有人能做到樣樣精通。

因此需要在不同領(lǐng)域選擇有代表力的人物,并讓他們給出高質(zhì)量的反饋。

但實際上這項工作是十分困難的。

此外由于人并非完全理性,個別評價者的觀點難免帶有偏見,甚至可能產(chǎn)生毒害。

除了觀念問題引起的「故意」偏差,還有一些偏差是「不小心」的。

由于時間、注意力的不足,人類犯錯誤的情況是很難避免的

而一些帶有迷惑色彩的信息,也可能導(dǎo)致人類被誤導(dǎo)。

而一些對于有一定困難的任務(wù),人類甚至難以對其做出評價。

論文介紹,不只是做出評價時會產(chǎn)生偏見,評價收集的過程同樣是偏見的一大來源。

收集過程中需要對評價的有用性進行評估,所以評估人員的主觀想法同樣可能帶來影響。

在這個過程當(dāng)中,還不可避免地存在成本與質(zhì)量之間的權(quán)衡,影響準(zhǔn)確程度。

除了反饋的內(nèi)容,反饋的形式也存在一定的局限性,這也是出于成本的考慮。

獎勵模型和策略也需改善

接著,作者又指出,除了人類的反饋,RLHF本身的獎勵模型和決策方式也有需要改進之處。

其中獎勵函數(shù)可能難以準(zhǔn)確描述價值判斷,單個函數(shù)更是無法代表整個人類社會的價值觀。

獎勵模型還有泛化能力差的問題,存在獎勵機制被惡意利用的風(fēng)險。

此外,獎勵模型的質(zhì)量也難以評估,即使能夠?qū)崿F(xiàn)也需要很高的成本。

因為真實的獎勵函數(shù)通常是不可知的,只能通過策略優(yōu)化進行間接評估。

策略方面,論文指出很難高效地對策略進行優(yōu)化,難以保證策略的魯棒性。

在策略執(zhí)行階段,可能會出現(xiàn)與獎勵階段的差異,此前處理得很好的內(nèi)容突然出現(xiàn)問題。

而策略階段可能使用一些預(yù)訓(xùn)練模型,這同樣可能引入其中所包含的偏見信息。

另外,在對獎勵模型和決策方式進行協(xié)同訓(xùn)練時,會出現(xiàn)漂移問題,在效率和避免過擬合之間找到平衡點也存在困難。

如何解決

根據(jù)論文內(nèi)容我們可以看到,從人類反饋到RLHF自身的獎勵模型和決策方式,都存在不同程度的問題。

那么該如何解決呢?作者為我們提供了一些思路。

比如針對人類反饋的局限性問題,作者的策略是可以引入另一套AI系統(tǒng)或獎勵模型,對反饋進行評價。

還有對過程進行監(jiān)督指導(dǎo)、要求提供更精細化的反饋等措施。

另外兩個環(huán)節(jié),作者同樣給出了解決方案。

對于可以獎勵模型,把讓AI協(xié)助人類反饋這個思路調(diào)換一下,讓人類直接監(jiān)督其表現(xiàn)。

而對于決策方式問題,可以在預(yù)訓(xùn)練階段就對模型進行對齊,并在訓(xùn)練中加入指導(dǎo)。

作者還指出,除了RLHF,其他AI領(lǐng)域存在的安全問題同樣需要引起重視,并提出了相應(yīng)的對策。

RLHF is Not All You Need

作者簡介

領(lǐng)銜的兩位作者分別是MIT CSAIL實驗室的Stephen Casper和哈佛大學(xué)的Xander Davies。

Casper的主要研究方向是對齊算法,此前曾發(fā)表過關(guān)于擴散模型評估的論文并獲得ICML的Spotlight Paper獎。

Davies的主要研究方向是AI安全,今年有兩篇論文被ICML Workshop收錄。

其他作者當(dāng)中,還可以看到不少華人的名字。

論文地址:https://arxiv.org/pdf/2307.15217.pdf