致命幻覺問題、開發(fā)GPU替代品,大模型還面臨這10大挑戰(zhàn)

ChatGPT、GPT-4 等的發(fā)布,讓我們在見識到大模型(LLM)的魅力后,伴隨而來的是其所面臨的各種挑戰(zhàn)。

如何讓 LLM 變得更好?面對大模型,到底有哪些需要解決的問題?成為 AI 領(lǐng)域重要的研究課題。

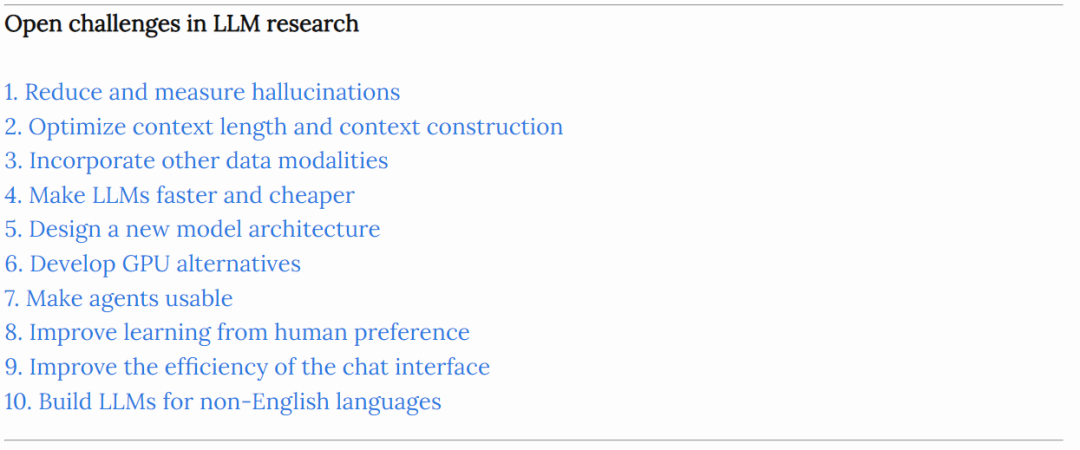

本文,計算機科學家 Chip Huyen 從 10 個方面入手,全面闡述 LLM 面臨的挑戰(zhàn)。具體而言,前兩個方面是關(guān)于幻覺以及上下文學習的,其他幾個方面包括但不限于多模態(tài)、架構(gòu)、尋找 GPU 替代品等。

原文地址:https://huyenchip.com/2023/08/16/llm-research-open-challenges.html

以下是對原文的翻譯整理。

1. 如何減少幻覺

幻覺問題是指 LLM 生成的文本雖然流暢又自然,但卻不忠實于內(nèi)容來源(內(nèi)在問題)和 / 或不確定(外在問題)。這一問題廣泛存在于 LLM 中。

因而,減輕幻覺并開發(fā)衡量幻覺的指標變得非常重要,很多公司、機構(gòu)都在關(guān)注這個問題。Chip Huyen 表示,現(xiàn)階段有許多減少幻覺的方法,例如在提示中添加更多的上下文、采用思維鏈或者讓模型的響應更簡潔一些。

這其中可以參考的資料包括:

- 自然語言生成中關(guān)于幻覺研究的綜述:https://arxiv.org/abs/2202.03629

- 語言模型出現(xiàn)的幻覺是如何滾雪球的:https://arxiv.org/abs/2305.13534

- ChatGPT 在推理、幻覺和交互性上的評估:https://arxiv.org/abs/2302.04023

- 對比學習減少對話中的幻覺:https://arxiv.org/abs/2212.10400

- 自洽性提高了語言模型的思維鏈推理能力:https://arxiv.org/abs/2203.11171

- 生成式大型語言模型的黑盒幻覺檢測:https://arxiv.org/abs/2303.08896

2. 優(yōu)化上下文長度和上下文結(jié)構(gòu)

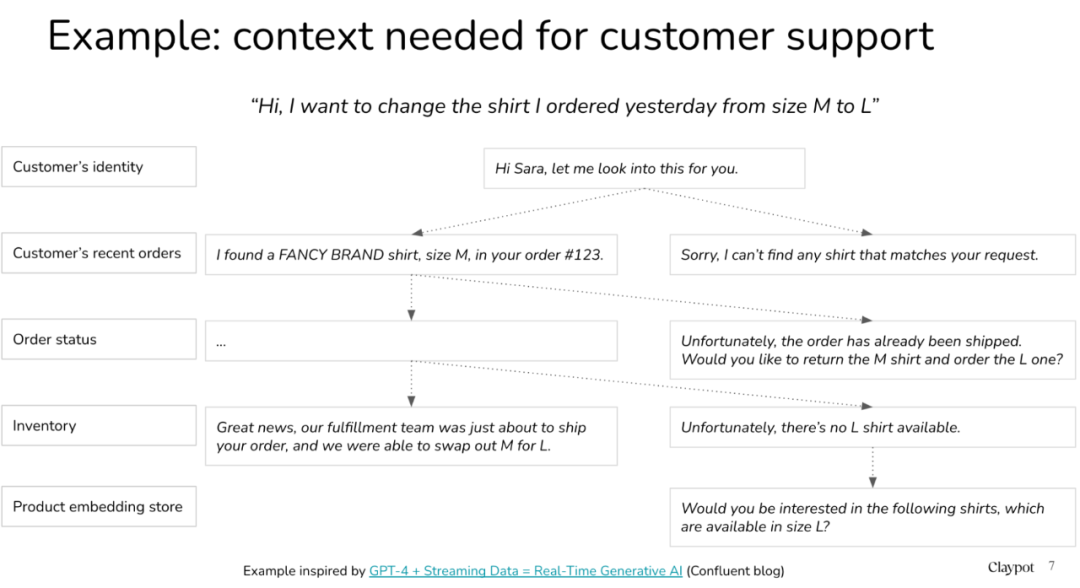

LLM 另一個研究重點是上下文長度,因為大模型在回答用戶問題時,需要參考上下文,能夠處理的長度越長,對 LLM 越有用。例如我們問 ChatGPT「最好的越南餐廳是哪家?」面對這一問題,ChatGPT 需要參考上下文,弄清楚用戶問的到底是越南最好的越南餐廳還是美國最好的越南餐廳,兩者完全不一樣。

在這一小節(jié)下,Chip Huyen 介紹了幾篇相關(guān)論文。

第一篇是《 SITUATEDQA: Incorporating Extra-Linguistic Contexts into QA 》,兩位作者均來自德克薩斯大學奧斯汀分校。論文引入了一個開放檢索的 QA 數(shù)據(jù)集 SITUATEDQA ,感興趣的讀者可以前去查看了解更多內(nèi)容。

Chip Huyen 表示因為模型是從提供的上下文中學習的,因而這個過程被稱為上下文學習。

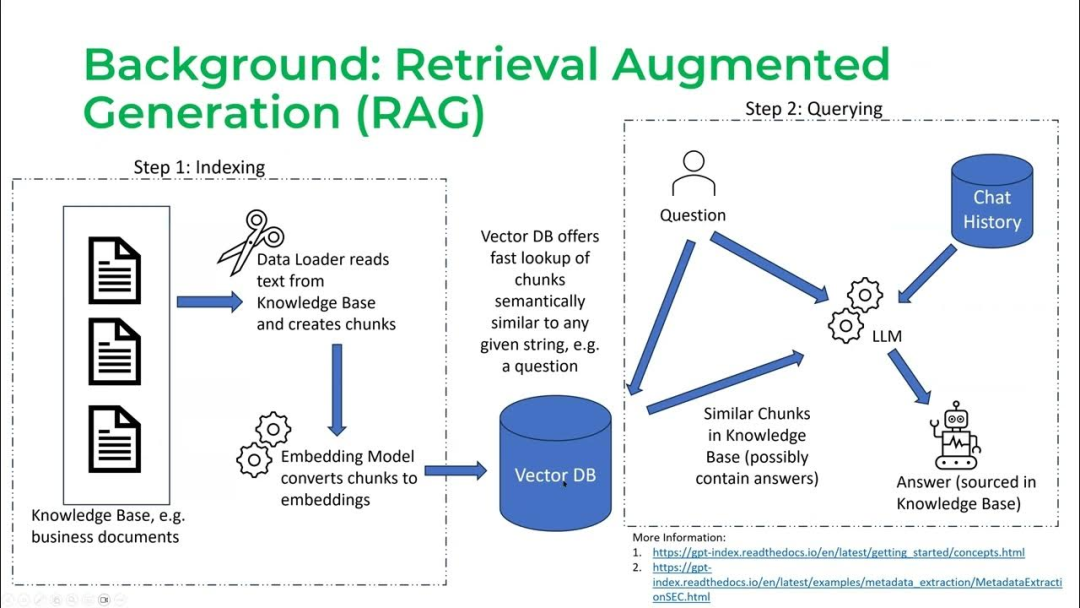

第二篇論文是《Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks》,本文提出了 RAG(Retrieval-Augmented Generation),它能結(jié)合預訓練語言模型和外部知識,來實現(xiàn)開放域生成式問答及其他知識密集型任務。

RGA 運行過程分為兩個階段:chunking(也稱為檢索)階段以及查詢階段:

很多人認為,基于這項研究,上下文的長度越長,模型塞入的信息就會越多,其響應就越好。Chip Huyen 認為這一說法并不完全成立。

模型可以使用多少上下文以及模型使用上下文的效率如何,是兩個完全不同的問題。我們要做的是在增加模型上下文長度的同時并行的提高模型處理上下文的效率。例如,在《Lost in the Middle: How Language Models Use Long Contexts》論文中,文中介紹了模型如何更好地理解索引開頭和結(jié)尾的信息,而不是中間信息。

3. 多模態(tài)

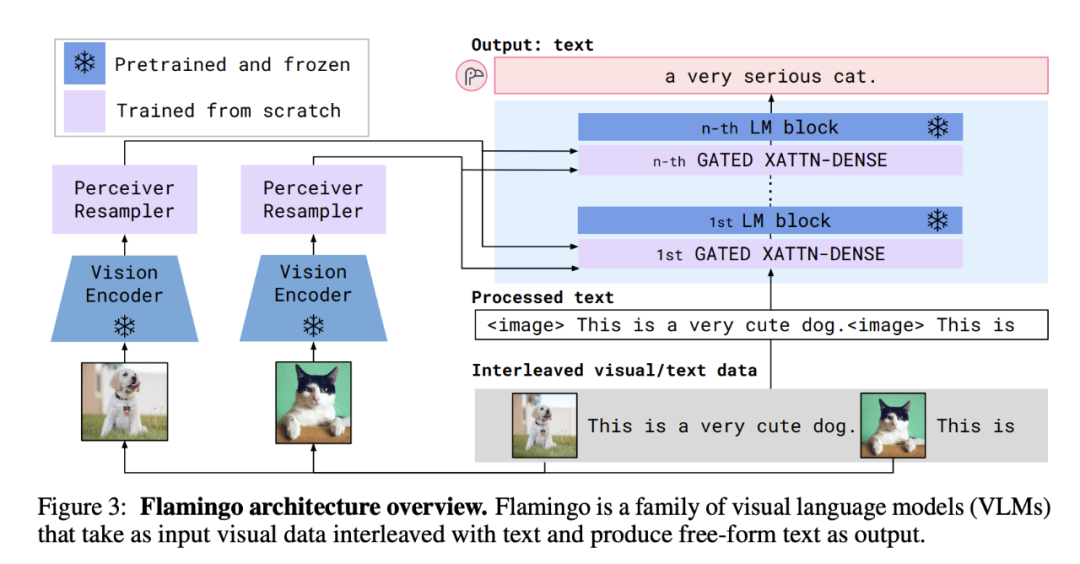

Chip Huyen 認為多模態(tài)是非常重要的。

首先,包括醫(yī)療保健、機器人、電子商務、零售、游戲、娛樂等在內(nèi)的領(lǐng)域都需要多模態(tài)數(shù)據(jù)。例如醫(yī)學預測需要醫(yī)生筆記,患者問卷等文本內(nèi)容,還需要 CT、X 光、核磁共振掃描等圖像信息。

其次,多模態(tài)有望大幅提升模型性能,能夠理解文本和圖像的模型比只能理解文本的模型表現(xiàn)要好。然而基于文本的模型對文本的需求量很大,以至于人們開始擔心為了訓練模型,我們很快就會耗盡互聯(lián)網(wǎng)數(shù)據(jù)。一旦文本被用完,我們就需要考慮其他數(shù)據(jù)模態(tài)。

Flamingo 架構(gòu)圖

Flamingo 架構(gòu)圖

關(guān)于多模態(tài),大家可以參考的內(nèi)容包括:

- 論文 1《Learning Transferable Visual Models From Natural Language Supervision》:https://arxiv.org/abs/2103.00020;

- 論文 2《Flamingo: a Visual Language Model for Few-Shot Learning》:https://arxiv.org/abs/2204.14198;

- 論文 3《BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models》:https://arxiv.org/abs/2301.12597;

- 論文 4《Language Is Not All You Need: Aligning Perception with Language Models》:https://arxiv.org/abs/2302.14045;

- 論文 5《Visual Instruction Tuning》:https://arxiv.org/abs/2304.08485;

- 谷歌 PaLM-E:https://ai.googleblog.com/2023/03/palm-e-embodied-multimodal-language.html;

- 英偉達 NeVA:https://catalog.ngc.nvidia.com/orgs/nvidia/teams/playground/models/neva。

4. 讓 LLM 更快、更便宜

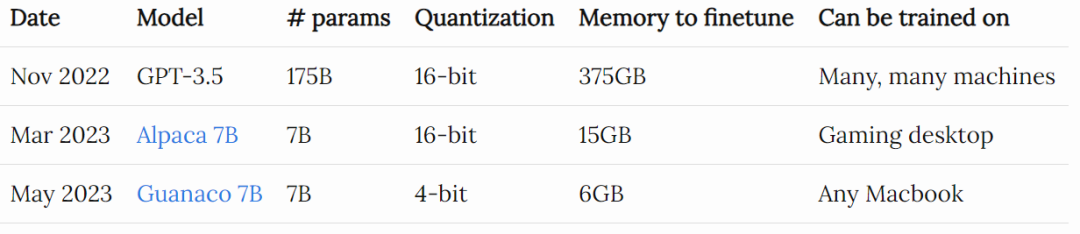

GPT-3.5 于 2022 年 11 月下旬首次發(fā)布,很多人擔心使用成本高昂。然而,短短半年,社區(qū)就找到了在性能方面接近 GPT-3.5 的模型,所需的內(nèi)存占用僅為 GPT-3.5 的 2%。

Chip Huyen 表示,如果你創(chuàng)造了足夠好的東西,人們很快就會找到一種方法讓它變得又快又便宜。

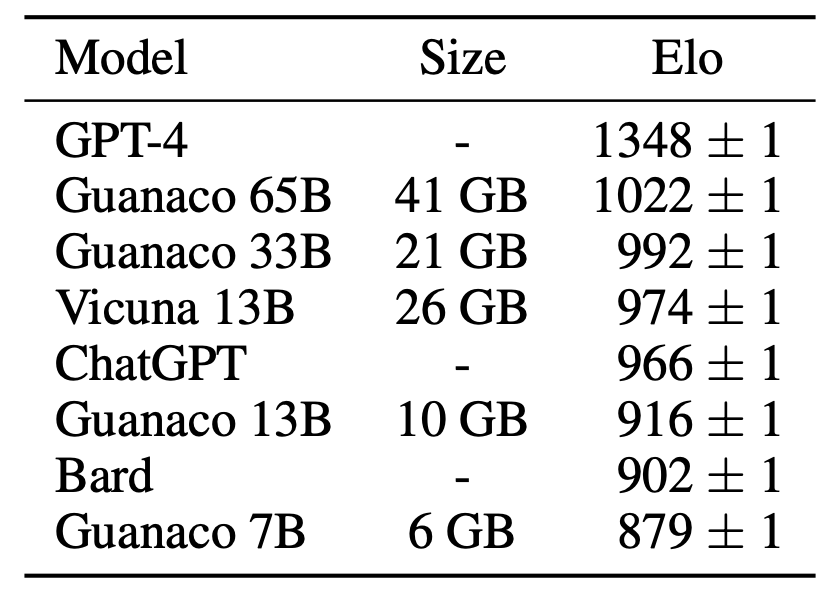

以下是 Guanaco 7B 與 ChatGPT 和 GPT-4 等模型的性能比較。但我們不得不強調(diào),對 LLM 進行評估還是非常難的。

接著,Chip Huyen 列舉了模型優(yōu)化、壓縮技術(shù):

- 量化:迄今為止最通用的模型優(yōu)化方法。量化使用更少的位來表示參數(shù),從而達到減小模型大小的目的,例如,有人將 32 位的浮點數(shù)改為 16 位,甚至是 4 位的浮點表示;

- 知識蒸餾:一種訓練小模型(學生)模仿較大模型或模型集合(教師)的方法;

- 低秩分解:關(guān)鍵思想是用低維張量替換高維張量以減少參數(shù)數(shù)量。例如用戶可以將 3x3 張量分解為 3x1 和 1x3 張量的乘積,這樣只有 6 個參數(shù),而不是 9 個;

- 剪枝。

以上這四種方法仍然很流行,例如用知識蒸餾訓練 Alpaca,QLoRA 將低秩分解和量化結(jié)合起來。

5. 設(shè)計一種新的模型架構(gòu)

自 2012 年 AlexNet 發(fā)布以來,包括 LSTM、seq2seq 在內(nèi)的許多架構(gòu)開始變得流行,然后又變得過時。與此不同的是,Transformer 的粘性令人難以置信。它從 2017 年就已經(jīng)出現(xiàn)了,直到現(xiàn)在還被廣泛使用。這種架構(gòu)還能流行多久我們難以估計。

然而,開發(fā)一種全新的架構(gòu)來超越 Transformer 并不容易。過去 6 年里,研究者對 Transformer 進行了大量優(yōu)化。除了模型架構(gòu),還包括硬件層面的優(yōu)化。

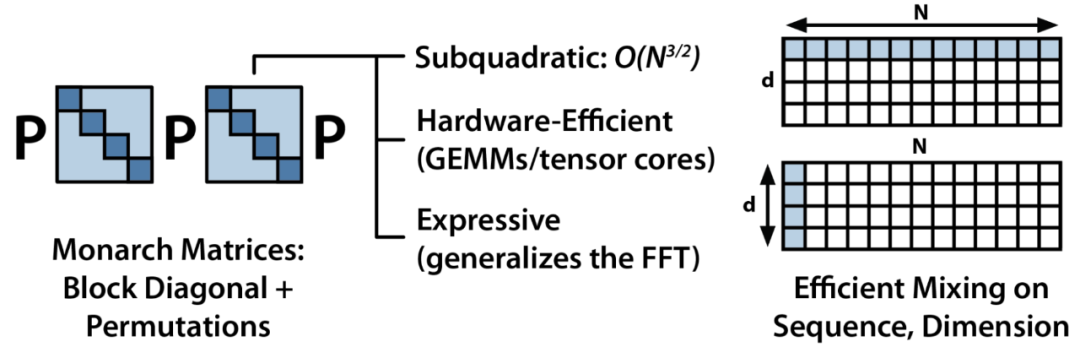

美國計算機科學家 Chris Ré 領(lǐng)導的實驗室在 2021 年圍繞 S4 進行了很多研究,可參考論文《Efficiently Modeling Long Sequences with Structured State Spaces》了解更多內(nèi)容。此外,Chris Ré 實驗室還大力投資開發(fā)新架構(gòu),他們最近與初創(chuàng)公司 Together 合作開發(fā)了 Monarch Mixer 架構(gòu)。

他們的關(guān)鍵思想是,對于現(xiàn)有的 Transformer 架構(gòu),注意力的復雜度是序列長度的二次方,而 MLP 的復雜度是模型維度的二次方,復雜度低的架構(gòu)會更加高效。

6. 開發(fā) GPU 替代品

自 2012 年 AlexNet 發(fā)布以來,GPU 一直占據(jù)深度學習的主導地位。事實上,AlexNet 之所以受歡迎的一個公認原因是它是第一篇成功使用 GPU 訓練神經(jīng)網(wǎng)絡(luò)的論文。在 GPU 出現(xiàn)之前,如果你想訓練 AlexNet 這種規(guī)模的模型,必須使用數(shù)千個 CPU,而 GPU 幾個就能搞定。

過去十年中,無論是大公司還是初創(chuàng)公司,都嘗試為人工智能創(chuàng)建新的硬件。最具代表性的包括但不限于 Google 的 TPU、Graphcore 的 IPU 以及 AI 芯片公司 Cerebras。此外,人工智能芯片初創(chuàng)公司 SambaNova 籌集了超過 10 億美元來開發(fā)新的人工智能芯片。

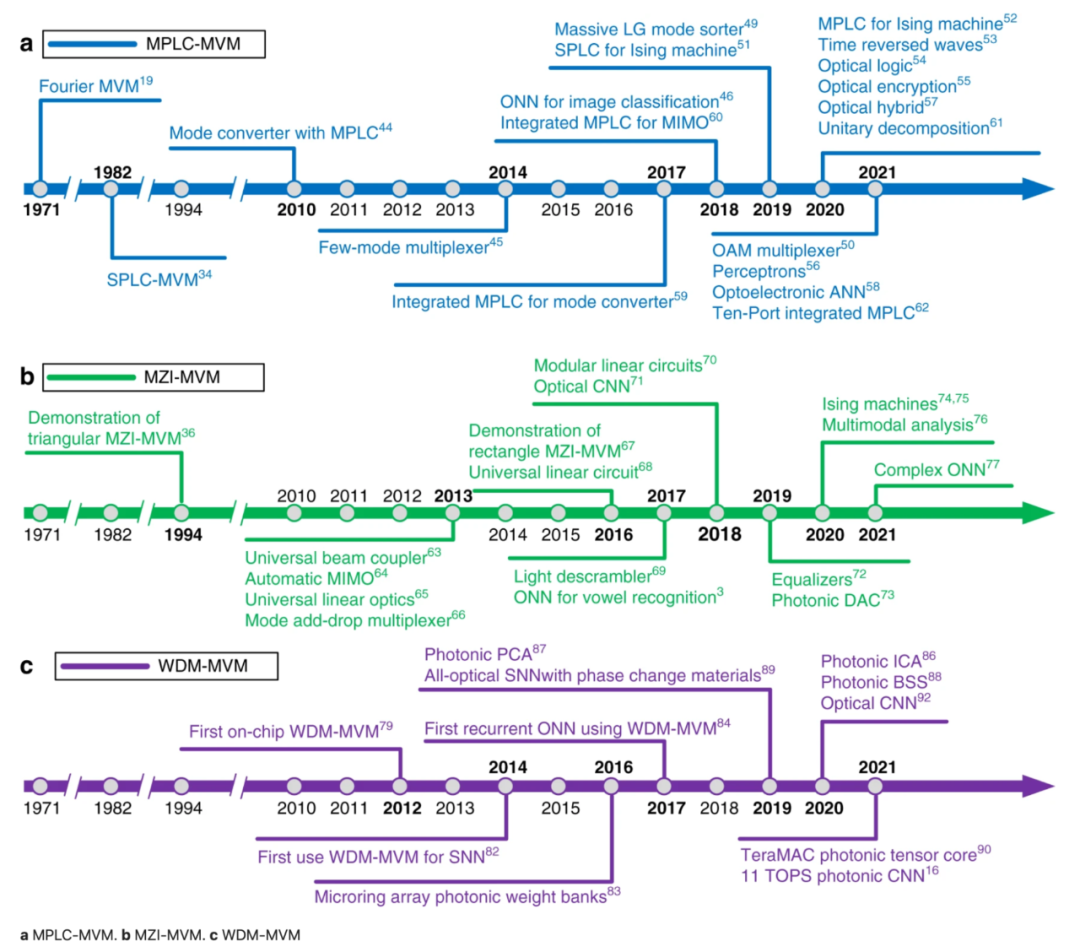

另一個令人興奮的方向是光子芯片,其使用光子來移動數(shù)據(jù),因而能進行更快、更高效的計算。該領(lǐng)域的多家初創(chuàng)公司已籌集了數(shù)億美元,包括 Lightmatter(2.7 億美元)、Ayar Labs(2.2 億美元)、Lightelligence(2 億美元以上)和 Luminous Compute(1.15 億美元)。

以下是光子矩陣計算中三種主要方法的進展時間表,摘自《Photonic matrix multiplication lights up photonic accelerator and beyond》論文。這三種方法分別是平面光轉(zhuǎn)換(PLC)、馬赫-曾德爾干涉儀(MZI)和波分復用技術(shù)(WDM)。

7. 讓智能體變得更可用

智能體是可以采取行動的 LLM,如瀏覽互聯(lián)網(wǎng)、發(fā)送電子郵件、預訂房間等。與本文中的其他研究方向相比,這個方向出現(xiàn)的比較晚,對大家來說非常的新。

正是由于其新穎性和巨大的潛力,大家對智能體有著狂熱的癡迷。Auto-GPT 目前在 GitHub 最受歡迎的項目中排名第 25 位。GPT-Engineering 是另一個非常熱門的項目。

這雖然令人期待又興奮,但 LLM 是否足夠可靠、性能是否足夠高以被賦予行動的權(quán)利,這依舊是存疑的。

不過,已經(jīng)出現(xiàn)的一個應用案例,將智能體應用于社會研究,前段時間斯坦福開源的「虛擬小鎮(zhèn)」 Smallville,25 個 AI 智能體在小鎮(zhèn)上生活,他們有工作,會八卦,能組織社交,結(jié)交新朋友,甚至舉辦情人節(jié)派對,每個「小鎮(zhèn)居民」都有獨特的個性和背景故事。

更多詳細內(nèi)容,請參閱以下論文。

論文地址:https://arxiv.org/pdf/2304.03442.pdf

該領(lǐng)域最著名的初創(chuàng)公司可能是 Adept,它由兩位 Transformer 的合著者和一位前 OpenAI 副總裁創(chuàng)立,迄今已融資近 5 億美元。去年,他們做了一個 demo,展示他們的智能體如何瀏覽互聯(lián)網(wǎng)并向 Salesforce 添加一個新賬戶。

8. 從人類偏好中改進學習

RLHF,即從人類偏好出發(fā)的強化學習。如果人們能找到其他方法來訓練 LLM,也不會讓人感到驚訝,畢竟 RLHF 還有很多問題有待解決。Chip Huyen 羅列了以下 3 點。

如何用數(shù)學方法表示人類偏好?

目前,人類偏好是通過比較來確定的:人類標注者確定響應 A 是否比響應 B 更好,但并不考慮響應 A 比響應 B 好多少。

人類的偏好是什么?

Anthropic 沿著三個坐標軸測量他們模型的響應質(zhì)量,分別是有用、誠實和無害。

論文地址:https://arxiv.org/abs/2212.08073

DeepMind 也試圖產(chǎn)生讓大多數(shù)人滿意的響應。請參見下面這篇論文。

論文地址:https://arxiv.org/abs/2211.15006

但需要明確的是,我們想要一個可以表明立場的 AI,還是一個回避任何潛在爭議話題的普通 AI ?

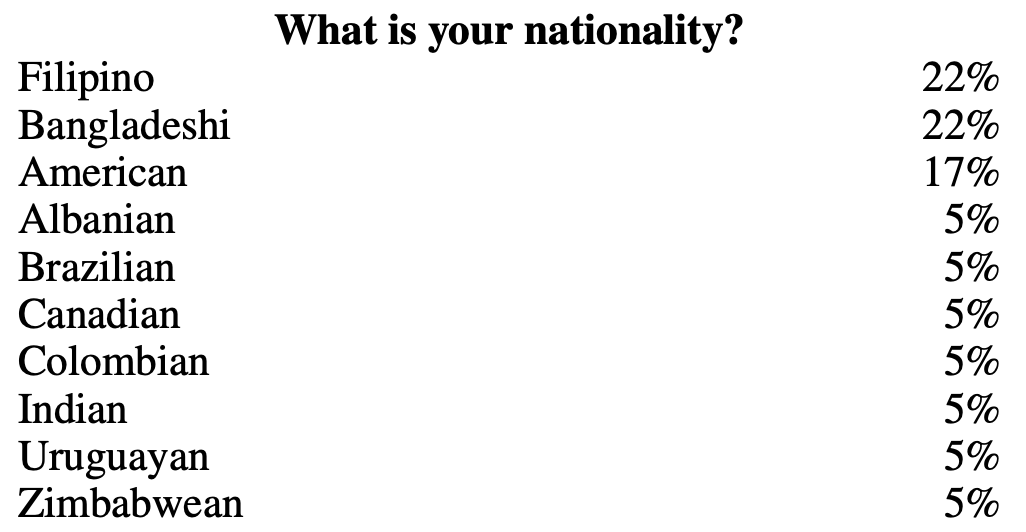

誰的偏好才是 「人」的偏好?

考慮到文化、宗教等方面的差異,要獲得能充分代表所有潛在用戶的訓練數(shù)據(jù),存在很多挑戰(zhàn)。

例如,在 OpenAI 的 InstructGPT 數(shù)據(jù)中,打標簽的人員主要是菲律賓人和孟加拉人,由于地域的差異,可能帶來一定偏差。

圖源:https://arxiv.org/abs/2203.02155

圖源:https://arxiv.org/abs/2203.02155

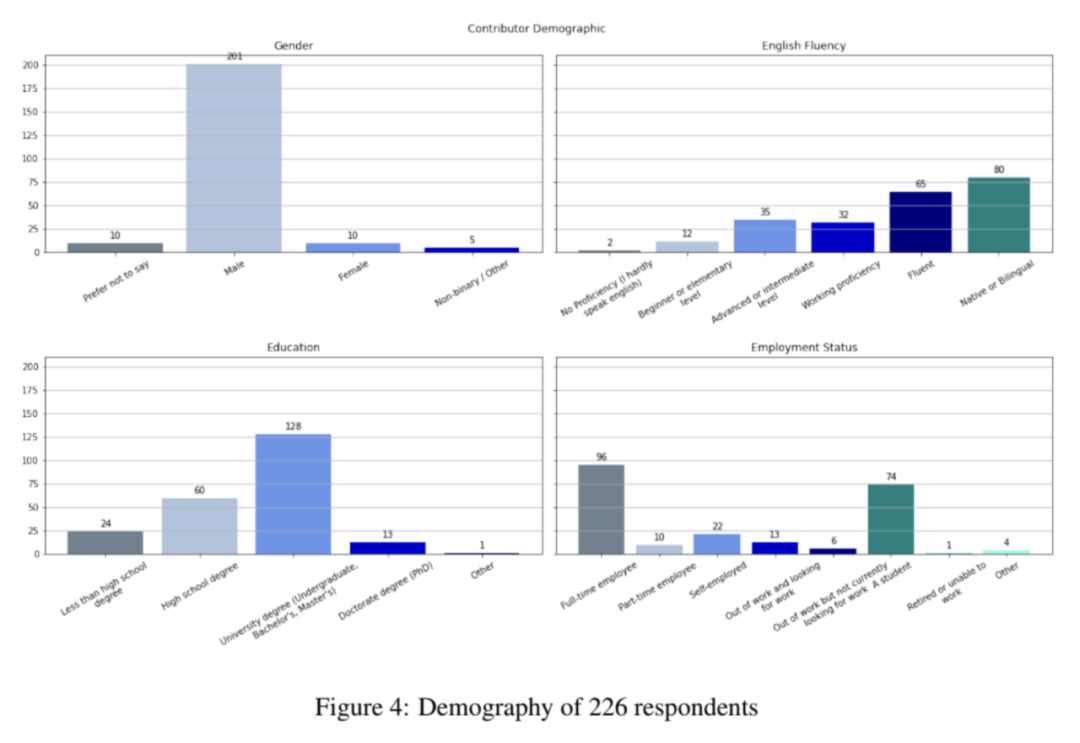

研究社區(qū)也在為此進行努力,但數(shù)據(jù)偏差依然存在。例如,在統(tǒng)計對 OpenAssistant 數(shù)據(jù)集的人員分布中,222 位受訪者中有 201 位(90.5%)是男性。

9. 提高聊天界面的效率

自 ChatGPT 以來,關(guān)于聊天是否適合各種任務的討論不絕于耳。例如以下的這些討論:

- 自然語言是懶惰的用戶界面 https://austinhenley.com/blog/naturallanguageui.html

- 為什么聊天機器人不是未來 :https://wattenberger.com/thoughts/boo-chatbots

- 什么類型的問題需要對話才能回答?https://arxiv.org/abs/2303.17710

- AI 聊天界面可能成為閱讀文檔的主要用戶界面:https://idratherbewriting.com/blog/ai-chat-interfaces-are-the-new-user-interface-for-docs

- 用最少的聊天與 LLM 交互 :https://eugeneyan.com/writing/llm-ux/

然而,這些討論并不是最近才開始的。許多國家,尤其是亞洲,聊天作為超級應用程序的界面已經(jīng)使用了大約十年。

聊天作為中文應用程序的通用界面

聊天作為中文應用程序的通用界面

2016 年,當許多人認為應用程序已死、聊天機器人將成為未來時,討論再次變得緊張起來:

- 關(guān)于聊天界面:https://acroll.medium.com/on-chat-as-interface-92a68d2bf854

- 聊天機器人趨勢是一個巨大的誤解嗎:https://www.technologyreview.com/2016/04/25/8510/is-the-chatbot-trend-one-big-misunderstanding/

- 機器人不會取代應用程序,更好的應用程序?qū)⑷〈鷳贸绦颍篽ttp://dangrover.com/blog/2016/04/20/bots-wont-replace-apps.html

Chip Huyen 表示自己非常喜歡聊天界面,原因如下:

- 聊天是一種人人都能快速學會使用的界面,即使是以前沒有接觸過電腦或互聯(lián)網(wǎng)的人也能使用。

- 聊天界面沒什么障礙,即使手忙腳亂的時候,也可以用語音代替文字。

- 聊天也是一個非常強大的界面,你可以向它提出任何請求,即使回復并不好,但它都會給予回復。

不過,Chip Huyen 認為聊天界面在某些方面還有待改進。他有以下這些建議

1. 每回合多條信息

目前,人們幾乎認為每輪只能發(fā)送一條信息。但現(xiàn)實生活中人們并不是這樣發(fā)短信的。通常,需要多條信息才能完成個人的想法,因為在這過程中需要插入不同的數(shù)據(jù)(如圖片、位置、鏈接),用戶在之前的信息中可能遺漏了一些東西,或者只是不想把所有東西都寫進一大段話里。

2. 多模態(tài)輸入

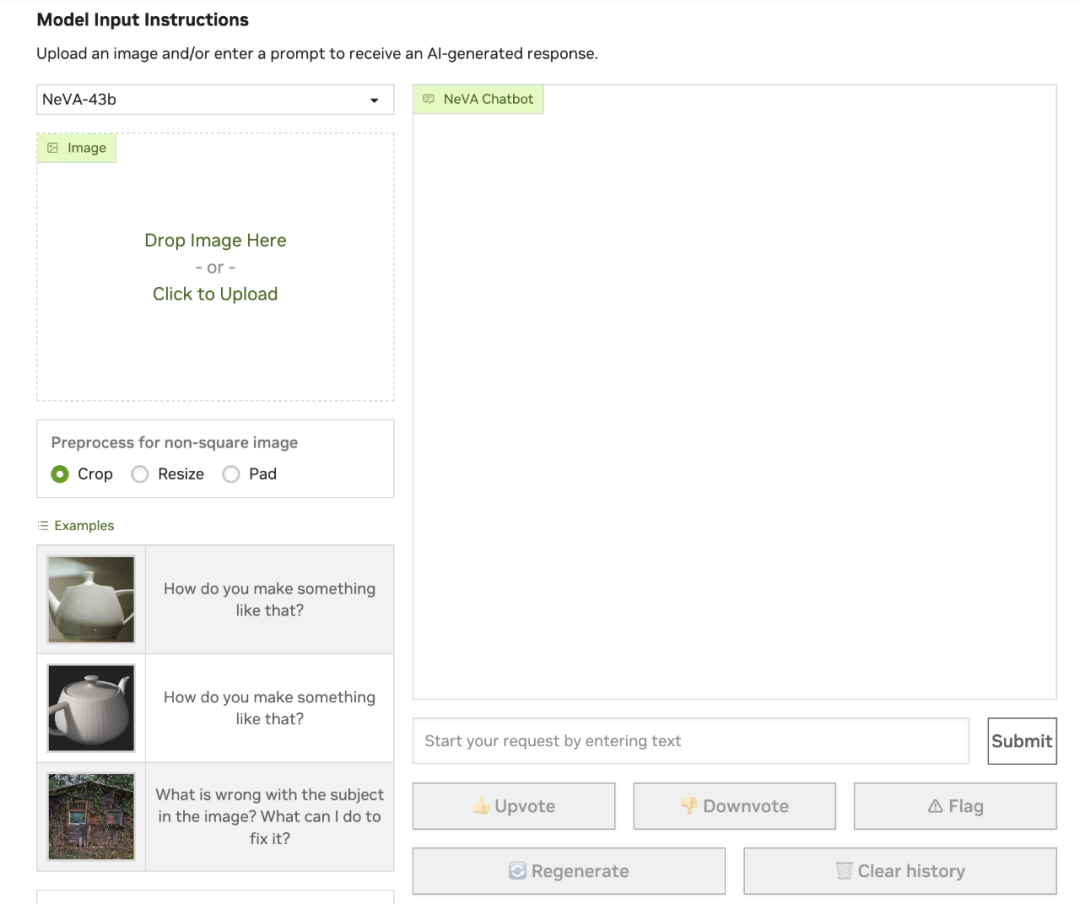

在多模態(tài)應用領(lǐng)域,大部分精力都花在建立更好的模型上,而很少花在建立更好的界面上。以 Nvidia 的 NeVA 聊天機器人為例,這可能有改進用戶體驗的空間。

地址:https://catalog.ngc.nvidia.com/orgs/nvidia/teams/playground/models/neva

3. 將生成式 AI 納入工作流程

Linus Lee 在他的演講 「聊天之外的人工智能生成界面」中很好地闡述了這一點。例如,如果你想就正在處理的圖表中的某一列提問,你應該可以直接指向該列并提問。

視頻地址:https://www.youtube.com/watch?v=rd-J3hmycQs

4. 編輯和刪除信息

編輯或刪除用戶輸入會如何改變與聊天機器人的對話流程,這值得我們思考。

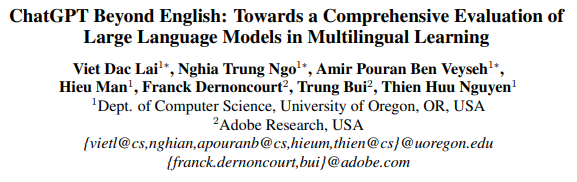

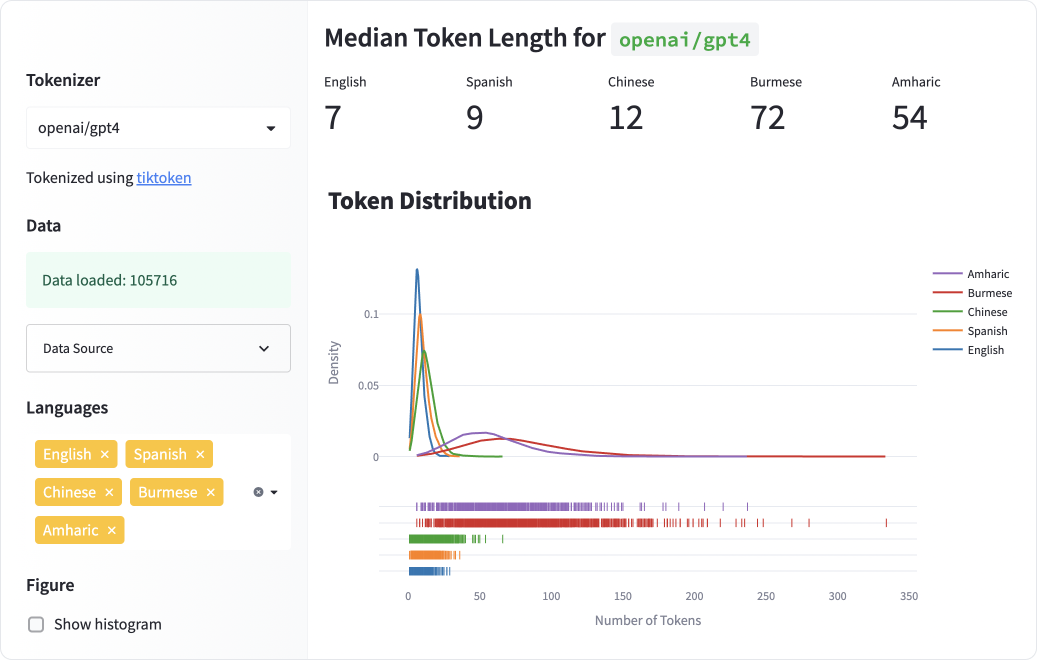

10. 為非英語語言構(gòu)建 LLM

目前以英語為第一語言的 LLM 在性能、延遲和速度方面都不能很好地適用于其他語言。相關(guān)內(nèi)容可以閱讀以下文章:

論文地址:https://arxiv.org/abs/2304.05613

文章地址:https://blog.yenniejun.com/p/all-languages-are-not-created-tokenized

Chip Huyen 表示,本文的幾位早期讀者告訴他,他們認為不應該把這個方向包括進來,原因有兩個。

1. 這與其說是一個研究問題,不如說是一個后勤(logistics)問題。我們已經(jīng)知道如何去做,只是需要有人投入資金和精力,其實這并不完全正確。大多數(shù)語言都被認為是低資源語言,例如,與英語或中文相比,它們的高質(zhì)量數(shù)據(jù)要少得多,因此可能需要不同的技術(shù)來訓練大型語言模型。參見以下文章:

論文地址:https://arxiv.org/abs/2006.07264

論文地址:https://aclanthology.org/P19-1310/

2. 比較悲觀的人會認為,將來很多語言會消亡,未來互聯(lián)網(wǎng)將有兩種語言組成:英語和漢語。

AI 工具對于語言學習的影響尚不明確,比如機器翻譯和聊天機器人。它們能夠幫助人們更快地學習新語言,還是會完全消除學習新語言的需要,這暫時不得而知。

總結(jié)

本文中提到的問題也有難度差別,例如最后一個問題,如果能夠頭如足夠的資源和時間,為非英語語言建構(gòu) LLM 是可以實現(xiàn)的。

其中第一個問題是減少幻覺,這將會難的多,因為幻覺只是 LLM 在做概率的事情。

第四個問題是使 LLM 更快更便宜,而這一點不會完全解決。在這一領(lǐng)域已經(jīng)取得了一些進展,未來還會有更多的進展,但我們永遠也沒有辦法改進到完美。

第五個和第六個問題是新架構(gòu)和新硬件,這是非常具有挑戰(zhàn)性的,但是隨著時間的推移,這件事不可避免。由于架構(gòu)與硬件之間的共生關(guān)系,即新的架構(gòu)需要針對通用硬件進行優(yōu)化,而硬件需要支持通用架構(gòu),這使該問題可能由同一家公司來解決。

還有一些問題僅靠技術(shù)知識是無法解決的。例如第八個問題改進從人類偏好中學習的方法,這可能更多是一個政策問題,而非技術(shù)問題。再說到第九個問題提高界面效率,這更像是用戶體驗問題,需要更多具有非技術(shù)背景的人員一起來解決這個問題。

如果你還想從其他角度來看看這些問題,Chip Huyen 推薦大家閱讀下面這篇論文。

論文地址:https://arxiv.org/abs/2307.10169