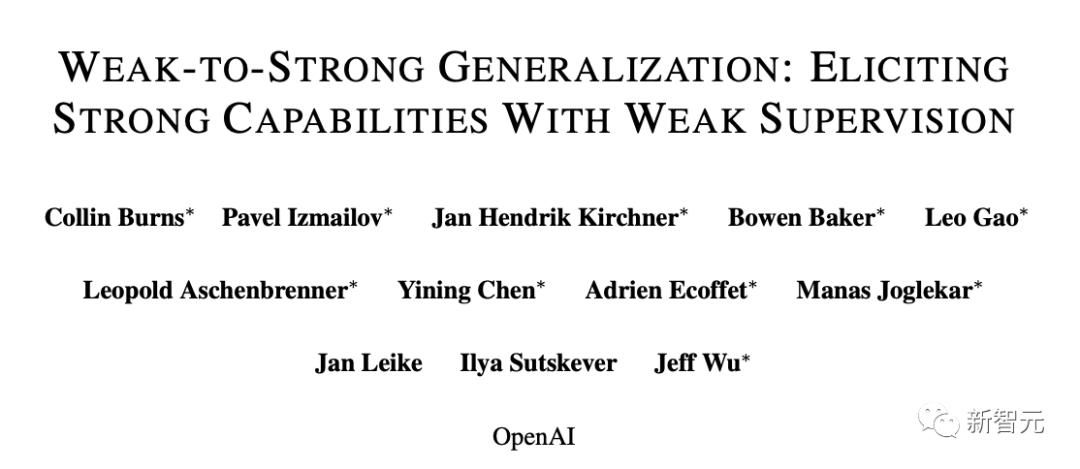

用GPT-2監督GPT-4,防止AI毀滅人類? OpenAI Ilya超級對齊團隊首篇論文出爐

就在剛剛,OpenAI首席科學家Ilya領銜的超級對齊團隊,發布了成立以來的首篇論文!

團隊聲稱,已經發現了對超人類模型進行實證對齊的新研究方向。

未來超級AI系統對齊的一個核心挑戰——人類需要監督比自己更聰明人工智能系統。

OpenAI的最新研究做了一個簡單的類比:小模型可以監督大模型嗎?

論文地址:https://cdn.openai.com/papers/weak-to-strong-generalization.pdf

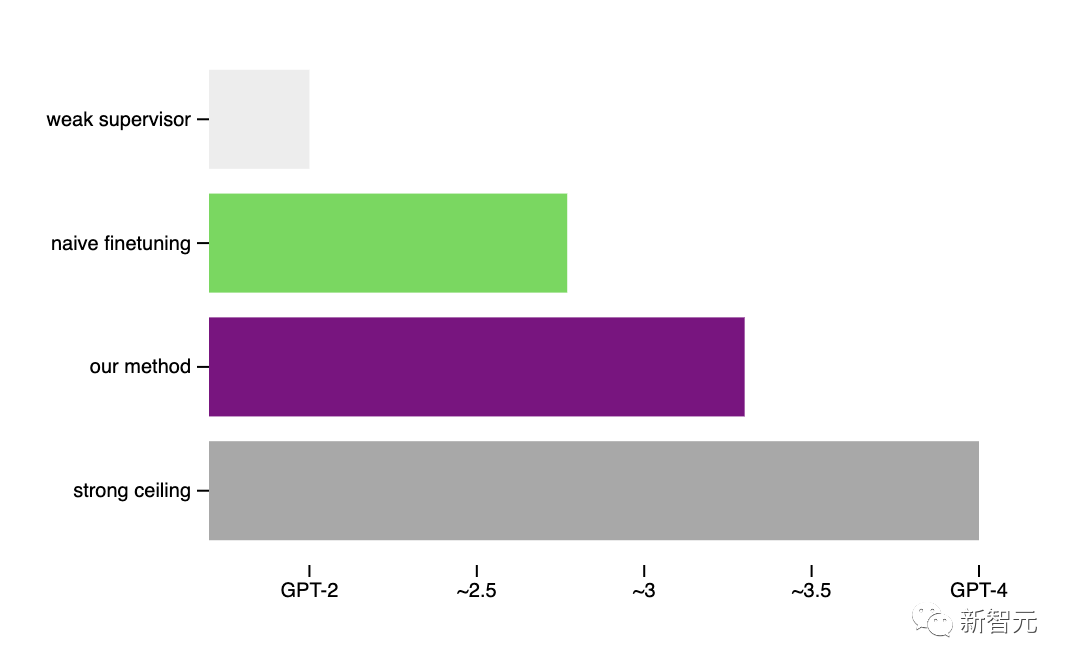

經驗證,通過GPT-2可以激發出GPT-4的大部分能力(接近GPT-3.5的性能),甚至可以正確地泛化到小模型失敗的難題上。

OpenAI此舉開辟了一個新的研究方向,讓我們能夠直接解決一個核心挑戰,即調整未來的超級AI模型,同時在迭代的實證中取得進展。

為了便于大家理解,超級對齊共同負責人Jan Leike,也發表了對這項研究的簡要概括:

人類如何控制比自己更智能的AI?

OpenAI認為,超級智能(比人類聰明得多的人工智能),很可能在未來十年內出現。

然而,人類卻仍然不知道,該如何可靠地引導和控制超人AI系統。

這個問題,對于確保未來最先進的AI系統安全且造福人類,是至關重要的。

解決這個問題對于確保未來最先進的人工智能系統仍然安全并造福人類至關重要。

為此,今年7月OpenAI成立了「超級對齊團隊」,來解決這類超級智能的對齊難題。

5個月后,團隊發表第一篇論文,介紹了實證對齊超人模型的新研究方向。

當前的對齊方法,例如基于人類反饋的強化學習 (RLHF),非常依賴于人類的監督。

但未來的人工智能系統,顯然能夠做出極其復雜且極具創造性的行為,而這將使人類很難對其進行可靠的監督。

比如,超人模型寫出了數百萬行新穎的且具有潛在危險的計算機代碼,即便是專業人士也難以完全理解,這時人類該怎么辦呢?

可見,相比于超人的AI模型,人類將成為一個「弱監督者」。

而這正是AGI對齊的核心挑戰——「弱小」的人類,如何信任并控制比他們更智能的AI系統?

超級對齊:用小模型監督大模型?

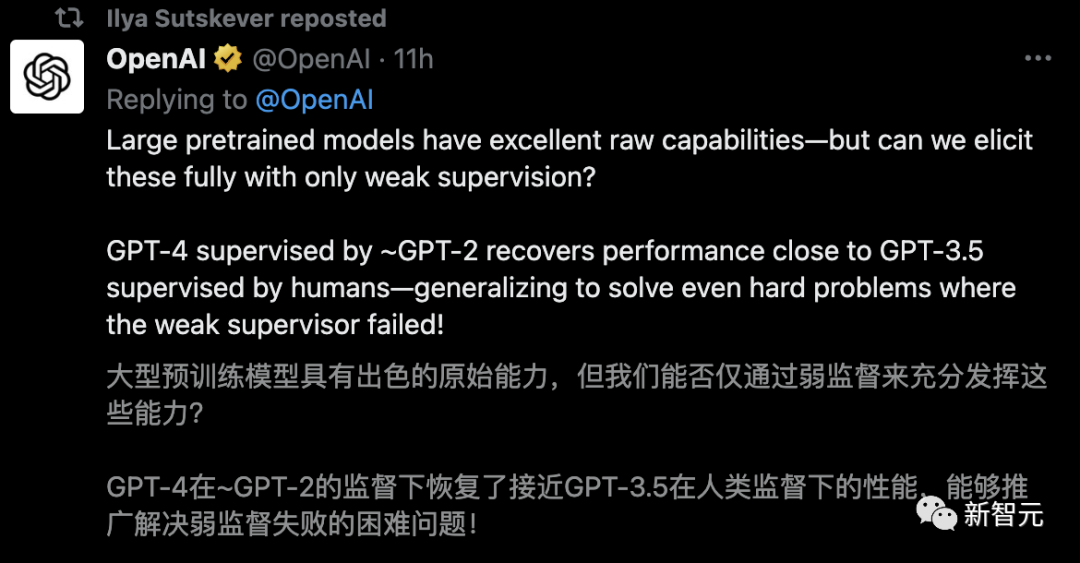

為了在這個核心挑戰上取得進展,OpenAI提出了一可以實證研究的類比:能否用一個更小(能力較弱)的模型來監督一個更大(能力更強)的模型?

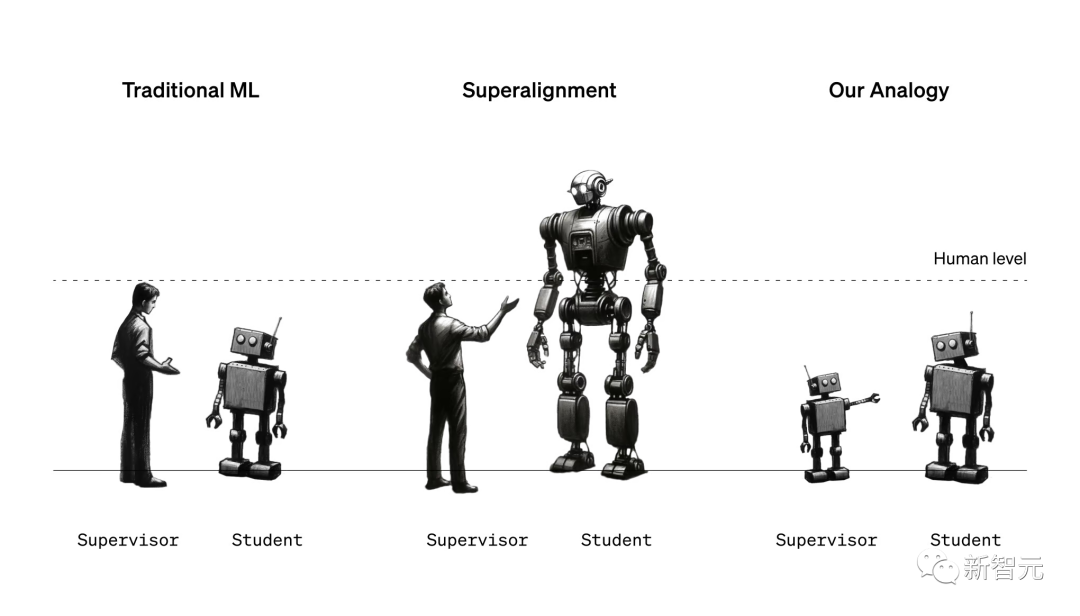

超級對齊的簡單類比:在傳統的ML中,人類監督的人工智能系統比自己弱(左)。為了對齊超級智能,人類將需要監督比他們更聰明的人工智能系統(中)。我們今天無法直接研究這個問題,但我們可以研究一個簡單的類比:小模型能否監督大模型(右圖)?

我們可能會天真的認為,一個強大的模型不會比提供訓練信號的弱監督表現得更好。它可能只是學會模仿弱監督所犯的所有錯誤。

另一方面,強大的預訓練模型具有出色的原始能力——不需要從頭開始教它們新任務,只需要引出其潛在知識。

那么關鍵的問題是:強模型是否會根據弱監督的潛在意圖進行泛化,利用其全部能力來解決任務,即使是在弱監督只能提供不完整或有缺陷的訓練標簽的難題上?

團隊放出首個成果:用GPT-2監督GPT-4

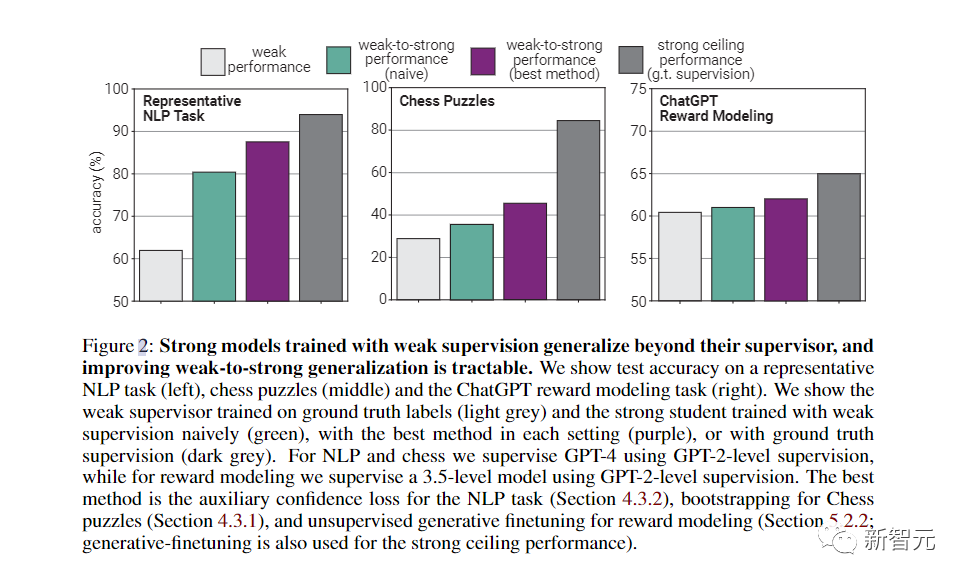

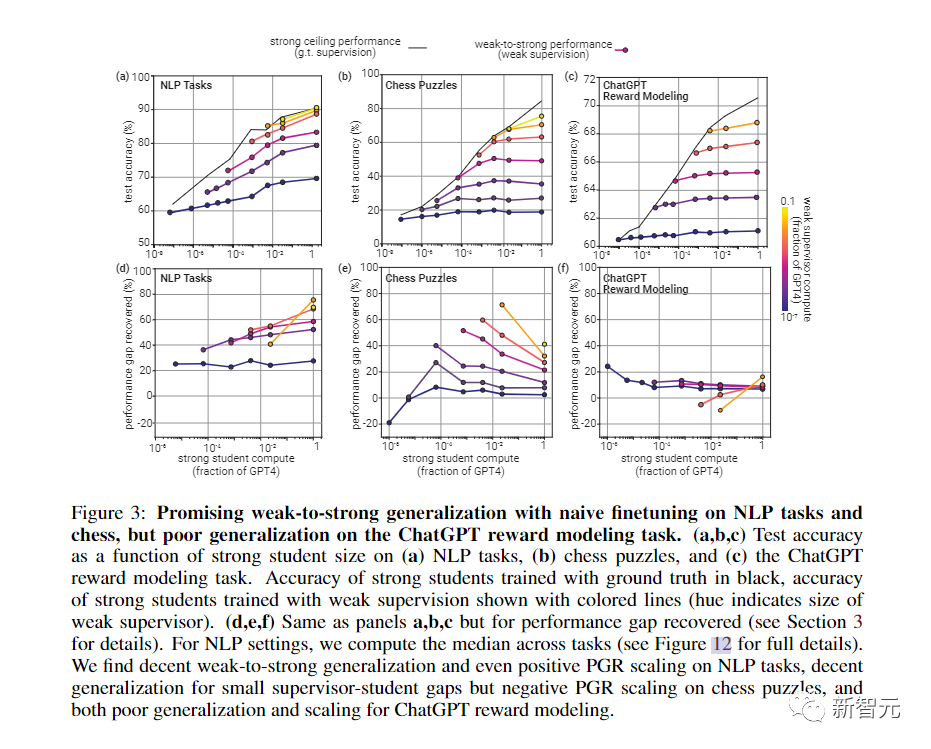

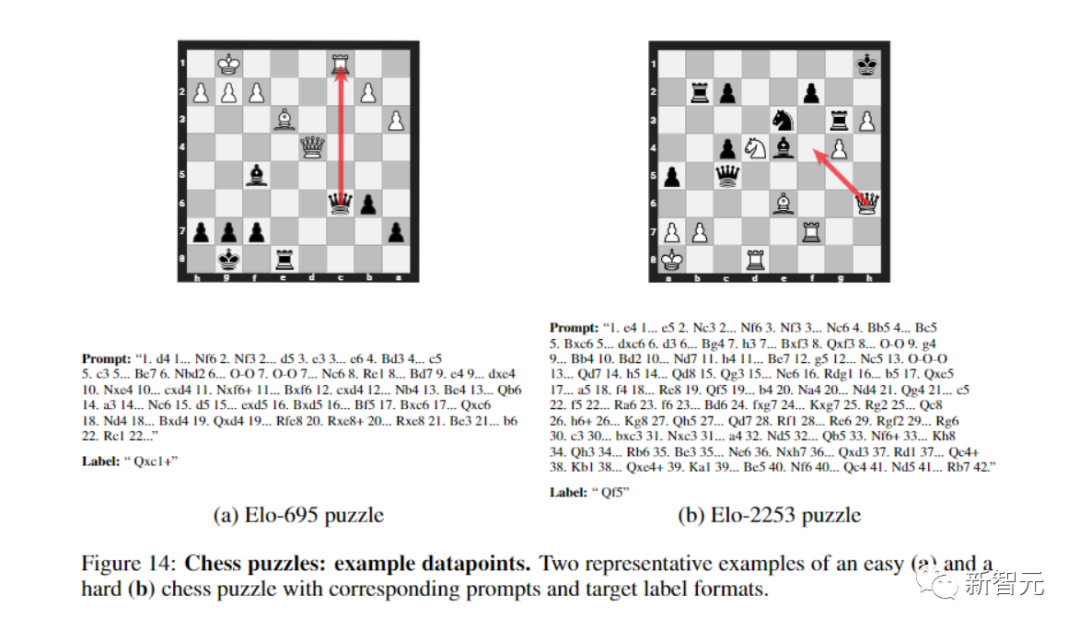

對此,團隊使用了NLP基準測試的典型弱到強泛化——用GPT-2級別的模型作為弱監督,來微調GPT-4。

在很多情況下,這種方法都能顯著提高泛化能力。

使用一種簡單的方法,就鼓勵性能更強的模型更加自信,包括在必要時自信地說出與弱監督意見不同的意見。

在NLP任務上使用這種方法用GPT-2級模型監督GPT-4時,生成的模型通常在GPT-3和GPT-3.5之間。

而在更弱的監督下,就可以恢復GPT-4的大部分功能。

當然,這種方法更像是概念證明,具有很多局限性,比如,它并不適用于ChatGPT偏好數據。

不過,團隊也發現了其他方法,比如最佳的早期停止和從小型到中型再到大型模型的引導。

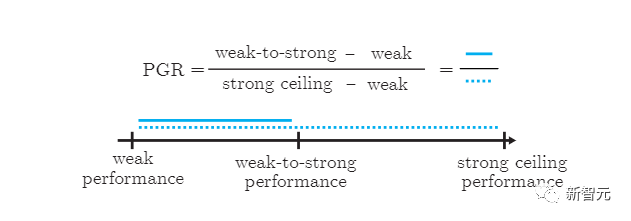

總的來說,結果表明,(1)幼稚的人類監督(比如RLHF)可以在沒有進一步工作的情況下。很好地擴展到超人模型,但(2)大幅改善弱到強的泛化是可行的。

代碼開源,社區共創

OpenAI目前的經驗設置與對齊超級模型的終極問題之間,仍然存在重要的差異。

比如,未來的模型可能比當前強模型,模仿當前的弱模型錯誤更容易,這可能會使未來的泛化更加困難。

盡管如此,OpenAI團隊相信實驗設置,抓住了對齊未來超級模型的一些關鍵難點,使OpenAI能夠在這個問題上取得可以驗證的進展。

同時,他們還透露了未來工作方向,包括修正設置,開發更好的可擴展方法,以及推進對何時以及如何獲得良好的「弱到強」泛化的科學理解。

OpenAI表示,他們正在開源代碼,讓機器學習社區研究人員立即輕松開始從弱到強的泛化實驗。

1千萬美元資助,解決超級對齊難題

這次,OpenAI還與Eric Schmidt合作,啟動了一個價值1000萬美元的資助計劃,支持確保超人類AI系統對齊并安全的技術研究:

- OpenAI為學術實驗室、非營利組織和個人研究人員提供10萬至200萬美元的資助。

- 對于研究生,OpenAI設立了為期一年、總額為15萬美元的OpenAI Superalignment獎學金,包括7.5萬美元的津貼和7.5萬美元的計算及研究資金。

- 申請者無需有對齊工作經驗;OpenAI會特別支持首次從事對齊研究的研究人員。

- 申請過程簡潔高效,具體回復將會在申請截止后的四周內給出。

OpenAI尤其關注以下幾個研究方向:

- 弱到強的泛化:面對超人類模型,人類將是相對弱勢的監督者。人類能否理解并控制強大模型是如何從弱監督中學習和泛化的?

- 可解釋性:人類如何理解模型的內部工作原理?人類能否利用這種理解來開發像AI謊言檢測器這類的工具來幫助人類?

- 可擴展的監督:人類如何利用AI系統幫助人類評估其他AI系統在復雜任務上的表現?

- 還有包括但不限于以下方向的多個研究領域:誠實度、思維鏈的誠實度、對抗魯棒性(adversarial robustness)、評估和測試平臺等等方向。