強(qiáng)化學(xué)習(xí)和世界模型中的因果推斷

一、世界模型

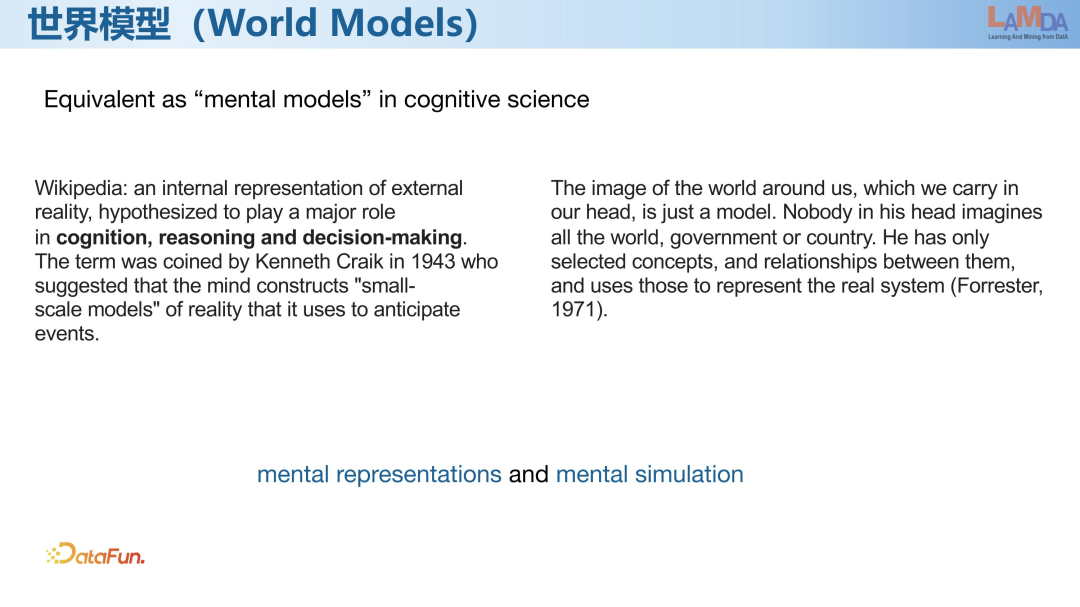

“世界模型”源于認(rèn)知科學(xué),在認(rèn)知科學(xué)里面有一個(gè)等價(jià)的詞匯 mental models,也就是心智模型。那么什么是心智模型?在認(rèn)知科學(xué)里有一個(gè)假設(shè),認(rèn)為人在大腦內(nèi)部會(huì)有一個(gè)對于真實(shí)外在世界的表征,它對于認(rèn)知這個(gè)世界,特別是推理和決策有很關(guān)鍵的作用。

在心理學(xué)中認(rèn)為 mental model 的核心有兩個(gè)部分,第一個(gè)叫 mental representation,即大腦中對于真實(shí)世界是怎么表征的;第二個(gè)叫做 mental simulation,即在大腦中對真實(shí)世界的運(yùn)轉(zhuǎn)生成一個(gè)模擬。Kenneth Craik 是動(dòng)力學(xué)系統(tǒng)的開創(chuàng)人之一,他認(rèn)為 mental model 是對這個(gè)世界的一個(gè)鏡像(image),即世界是如何表征和運(yùn)轉(zhuǎn)的。關(guān)于 mental model 的研究在上世紀(jì)就已經(jīng)開始。

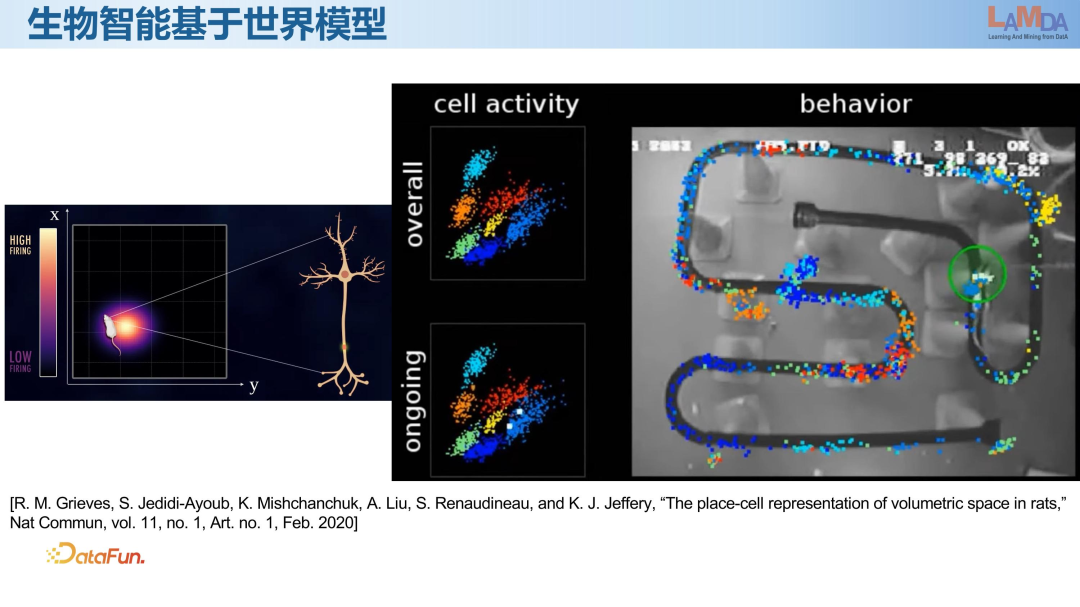

近些年認(rèn)知科學(xué)領(lǐng)域用動(dòng)物進(jìn)行了一些實(shí)驗(yàn),發(fā)現(xiàn)在動(dòng)物的大腦中確實(shí)會(huì)對真實(shí)世界有一些表征和模擬。比如有研究發(fā)現(xiàn),老鼠的大腦能夠?qū)κ澜邕M(jìn)行比較準(zhǔn)確的觀測,具體的,海馬體是大腦的一部分,它可以形成對世界的一個(gè)編碼,如果老鼠在世界里面運(yùn)動(dòng),那么對應(yīng)的海馬體就會(huì)編碼出所在位置。海馬體編碼除了能捕獲老鼠的運(yùn)動(dòng),還能夠通過激活編碼,識別這個(gè)老鼠的狀態(tài)。

其中有一個(gè)實(shí)驗(yàn),首先使老鼠在環(huán)境中運(yùn)動(dòng),同時(shí)收集到一些數(shù)據(jù),通過數(shù)據(jù)解碼老鼠的運(yùn)動(dòng)狀態(tài),基本上能夠通過解碼還原出老鼠所在的位置。有趣的是當(dāng)老鼠在睡覺的時(shí)候,它的大腦并沒有完全地休息,可能會(huì)有一些活動(dòng)例如做夢,這能夠通過 mental model 解釋。通過解碼看到老鼠在做夢時(shí),同樣也在環(huán)境里面跑,而且很有可能是倒著跑,這在一定程度上說明生物是有 mental model 的,這是生物智能的一方面。

而 mental model 和今天講的世界模型具有相同的含義,生物智能通常都是基于內(nèi)在世界模型的還原。

二、關(guān)于強(qiáng)化學(xué)習(xí)

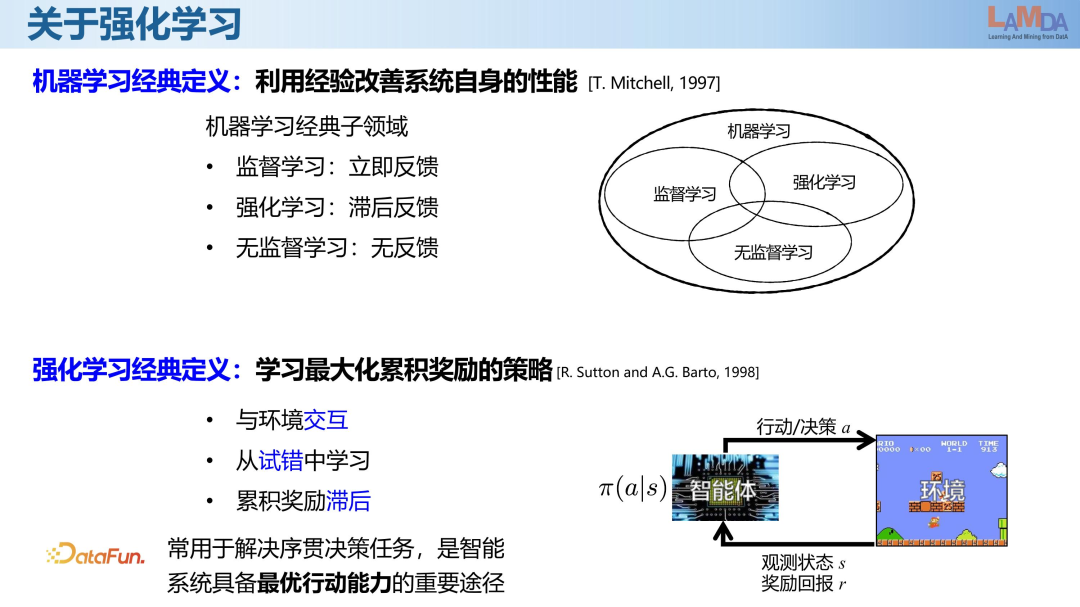

強(qiáng)化學(xué)習(xí)是機(jī)器學(xué)習(xí)的一個(gè)經(jīng)典子領(lǐng)域,是關(guān)于決策方向的。很多其他機(jī)器學(xué)習(xí)技術(shù),是監(jiān)督學(xué)習(xí),是關(guān)于預(yù)測、模式識別方向的。關(guān)于在決策方向上如何完成決策的任務(wù),并學(xué)習(xí)最大化累積獎(jiǎng)勵(lì)的策略,這是強(qiáng)化學(xué)習(xí)要去解決的目標(biāo)。另一方面,監(jiān)督學(xué)習(xí)的訓(xùn)練需要一批有標(biāo)記的數(shù)據(jù)。而強(qiáng)化學(xué)習(xí)需要我們在具體的環(huán)境中考慮智能體的決策,以模擬生物和環(huán)境之間的關(guān)系,智能體可以在環(huán)境里面產(chǎn)生一系列的行動(dòng)或者決策,智能體在環(huán)境中產(chǎn)生行動(dòng)以后,會(huì)觀測到環(huán)境狀態(tài)的變化和環(huán)境反饋的獎(jiǎng)勵(lì)。

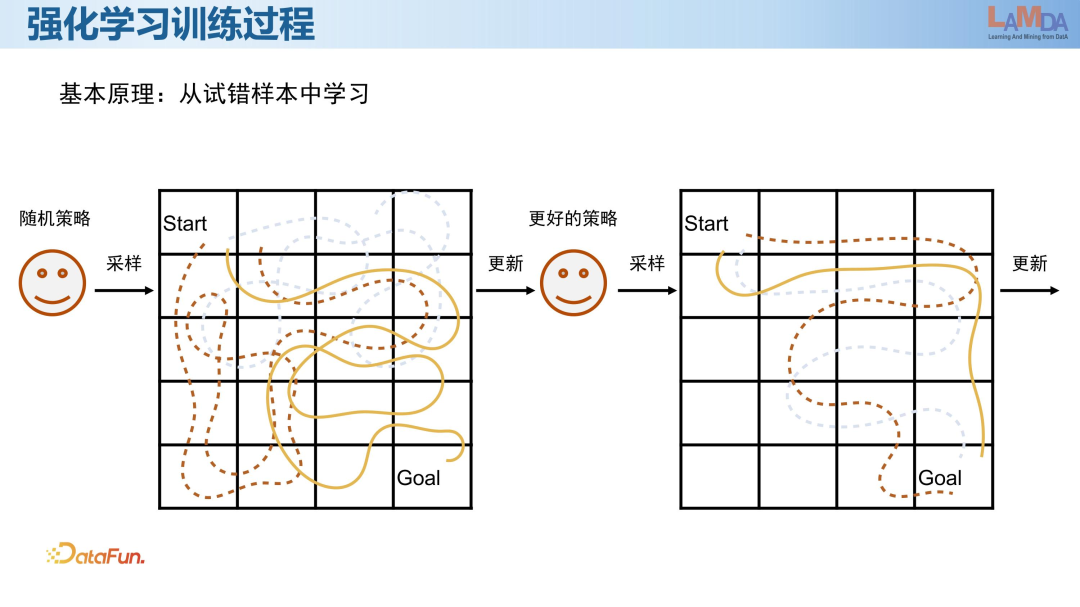

強(qiáng)化學(xué)習(xí)的學(xué)習(xí)思路是從試錯(cuò)樣本中學(xué)習(xí)。如圖所示,強(qiáng)化學(xué)習(xí)隨機(jī)采樣并產(chǎn)生一些從起點(diǎn)到終點(diǎn)的軌跡策略,當(dāng)它發(fā)現(xiàn)一些軌跡策略比另外一些軌跡策略更好,那么強(qiáng)化學(xué)習(xí)就會(huì)根據(jù)數(shù)據(jù)更新自己的策略,更新以后這個(gè)策略的效率就會(huì)更高,不斷這樣更新下去,最終能夠收斂到一個(gè)比較好的策略。

強(qiáng)化學(xué)習(xí)的一個(gè)核心問題在于它的采樣效率,完全隨機(jī)采樣的效率是很低的,對數(shù)據(jù)的利用程度不高,能夠?qū)W的東西也沒有那么多,就會(huì)導(dǎo)致強(qiáng)化學(xué)習(xí)需要大量的采樣,這里面有大量的試錯(cuò)。所謂的試錯(cuò)是在已經(jīng)能夠推斷出哪些地方不可以走之后,由于模型的學(xué)習(xí)能力不足,導(dǎo)致還要在錯(cuò)誤的軌跡再試一下,當(dāng)觀察到有錯(cuò)誤的結(jié)果,模型才知道這個(gè)地方是不能走的。這個(gè)問題就會(huì)導(dǎo)致強(qiáng)化學(xué)習(xí)在應(yīng)用上受到很大的阻礙,因?yàn)閷?shí)際上大部分的應(yīng)用場景都不允許過多的試錯(cuò),甚至有些情況下是完全不允許試錯(cuò)的,只有在允許試錯(cuò)的條件下面,強(qiáng)化學(xué)習(xí)才能發(fā)揮得比較好。

今天的強(qiáng)化學(xué)習(xí)在游戲環(huán)境能做得很好,是因?yàn)橛螒颦h(huán)境是允許試錯(cuò)的,而一旦我們的環(huán)境不允許試錯(cuò),那么強(qiáng)化學(xué)習(xí)應(yīng)用起來就會(huì)很困難,所以這里的核心就是如何提高強(qiáng)化學(xué)習(xí)的樣本效率。如果從生物的啟發(fā)來看,像老鼠那樣,跑了一下真實(shí)的環(huán)境以后,就可以在自己的 mental world 里面進(jìn)行訓(xùn)練和學(xué)習(xí),不需要真正地和環(huán)境進(jìn)行交互就能學(xué)到很好,那么樣本效率就能夠得到大幅的提高,應(yīng)用起來也會(huì)變得非常方便。

Mental world 在強(qiáng)化學(xué)習(xí)的發(fā)展歷史中一直在被研究,這一分支叫做 Model-based reinforcement learning,即有模型的強(qiáng)化學(xué)習(xí),這里的模型是專指對于我們的應(yīng)用問題的建模。

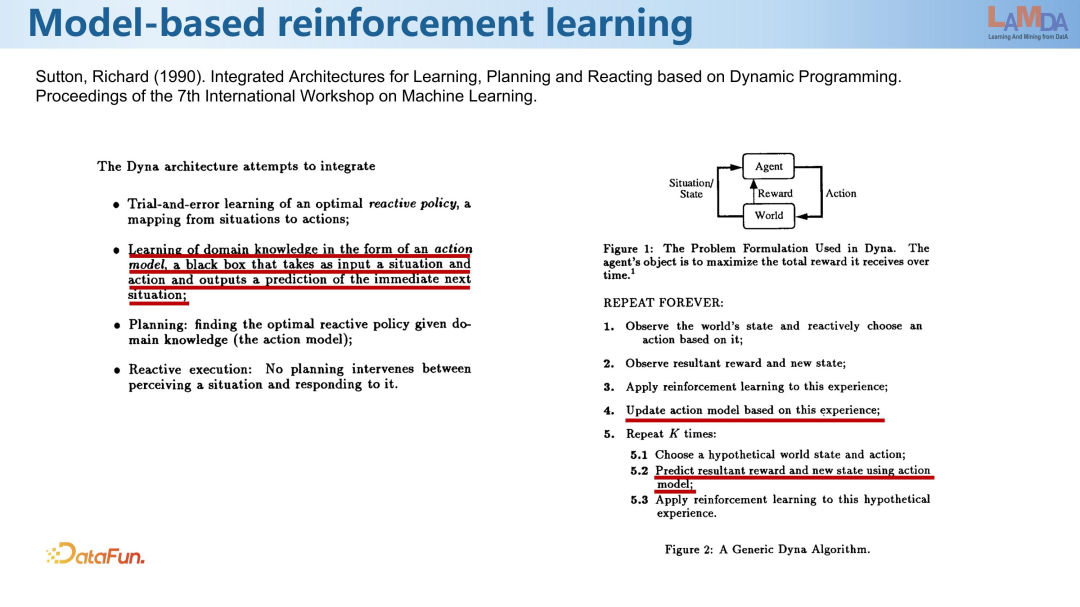

比較經(jīng)典的框架是 Dyna 架構(gòu),是 1990 年沙特提出來的。在這個(gè)框架里除了在環(huán)境里面進(jìn)行試錯(cuò),去收集數(shù)據(jù)以外,還專門有一步是要去學(xué)習(xí) domain knowledge,它并不是直接從知識里面去學(xué)習(xí),它是一個(gè) action model,是一個(gè)黑盒,主要做的是將當(dāng)前環(huán)境面臨的條件作為輸入,預(yù)測接下來的環(huán)境的條件。

類似于上圖右邊所示的強(qiáng)化學(xué)習(xí)框架,Agent 在我們的世界里面要執(zhí)行一系列的動(dòng)作,然后環(huán)境能夠反饋出下一個(gè)狀態(tài)是什么,那么在 Agent 的大腦里面能不能有一個(gè) model 來建模這個(gè)世界是怎么運(yùn)轉(zhuǎn)的。在具體的算法框架里面就有怎么用數(shù)據(jù)去 update model,并且在學(xué)習(xí)策略的時(shí)候,要用 model 去產(chǎn)生更多的數(shù)據(jù)出來。更多的數(shù)據(jù)就相當(dāng)于在 mental world 里面想象出來的數(shù)據(jù),我們希望用這些想象出來的數(shù)據(jù)去幫助學(xué)習(xí),從而大幅減少和真實(shí)環(huán)境的交互,提高強(qiáng)化學(xué)習(xí)的樣本效率。

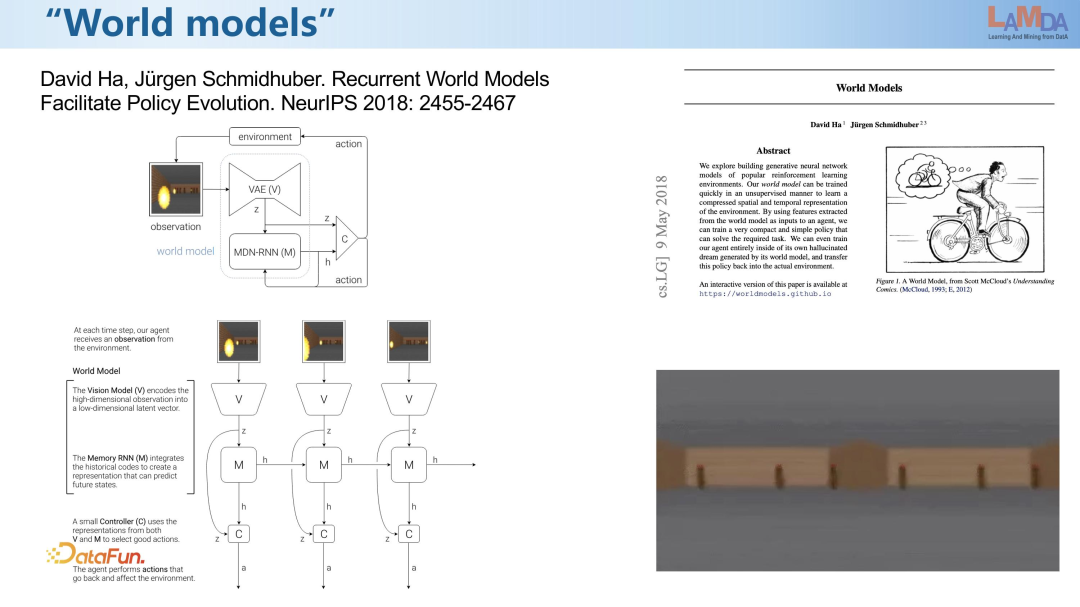

關(guān)于 world model,強(qiáng)化學(xué)習(xí)從幾十年前就一直有 model-based 的方向。在 2018 年時(shí),有一個(gè)工作,就是希望對觀測狀態(tài)進(jìn)行壓縮和表征,其中包括兩塊,一塊是使用 VAE 模型對高維的觀測進(jìn)行一個(gè)低維的表征,然后使用一個(gè) RNN 模型建模狀態(tài)和動(dòng)作。狀態(tài)輸入以后先壓縮到一個(gè)低維表征,再通過 RNN預(yù)測下一個(gè)狀態(tài),然后進(jìn)行決策推斷。在這個(gè)工作里面,作者為了更明確 model 指什么,所以這個(gè)工作里面就把 model 叫做 world model 世界模型。其實(shí)在強(qiáng)化學(xué)習(xí)里面,它就是對于世界怎么表征和怎么運(yùn)轉(zhuǎn)的建模。

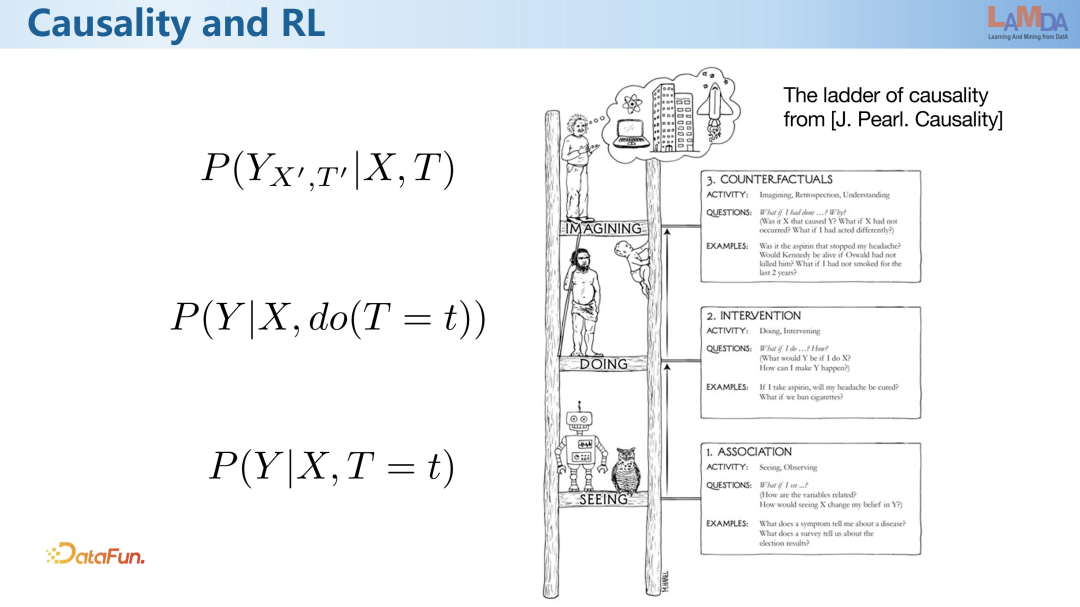

上圖是來自 J.Pearl 的因果階梯,以解釋因果學(xué)習(xí)和其他理論有什么不同。因果階梯從下往上三層分別是 association(相關(guān)性)、interventions(干預(yù))、counterfactuals(反事實(shí))。

可以從強(qiáng)化學(xué)習(xí)的角度理解因果階梯,在強(qiáng)化學(xué)習(xí)算法中是真的在實(shí)施干預(yù),為了了解不同決策產(chǎn)生的后果,就可以真正的在模擬環(huán)境里面做一下相關(guān)決策。在強(qiáng)化學(xué)習(xí)中可以收集到智能體在不同的干預(yù)下的數(shù)據(jù)。最上層是反事實(shí),也就是數(shù)據(jù)上面沒有體現(xiàn)出,還不知道一個(gè)決策會(huì)產(chǎn)生什么樣的結(jié)果,但是我們希望能夠在看到真實(shí)數(shù)據(jù)之前,將它推理出來。這在強(qiáng)化學(xué)習(xí)中,正好對應(yīng)的就是 model-based reinforcement learning,因?yàn)橹挥?model 出來以后,才能夠產(chǎn)生出沒有見過的數(shù)據(jù)。

從圖中可以看出,因果學(xué)習(xí)和 world model 中都有對真實(shí)世界的建模,世界模型的建模也是對應(yīng)到因果模型里面的 counterfactual 層。

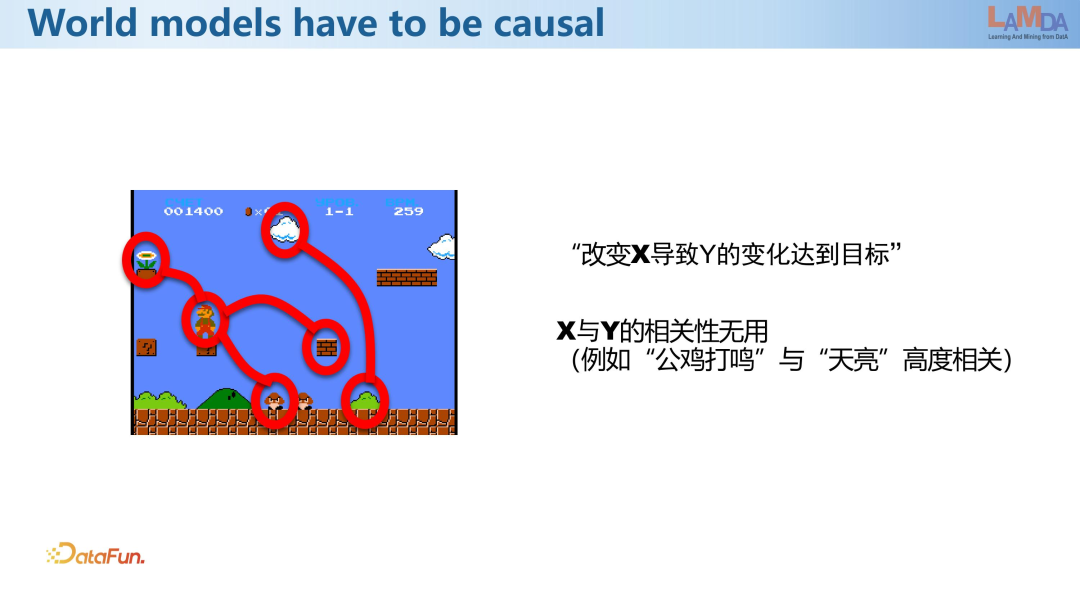

從因果推斷和 world model 兩種理論的定義可以看出,世界模型一定是需要用因果關(guān)系進(jìn)行建模的,它一定要關(guān)注到?jīng)Q策對于環(huán)境變化的因果性的影響。在 world model 構(gòu)建出以后,如果需要去做決策,就需要明確地知道動(dòng)作和結(jié)果之間的關(guān)系。比如可以通過公雞打鳴來預(yù)測接下來一兩個(gè)小時(shí)天會(huì)亮,這樣一個(gè)關(guān)聯(lián)關(guān)系用來做預(yù)測是沒有問題的,但它不是一個(gè)因果關(guān)系,所以對于決策來說是沒有用處的,不可能把公雞殺掉以后天就不亮了,所以無法對環(huán)境進(jìn)行改造,進(jìn)行干預(yù)。因此如果我們想要做決策,就一定需要 world model 符合因果關(guān)系。

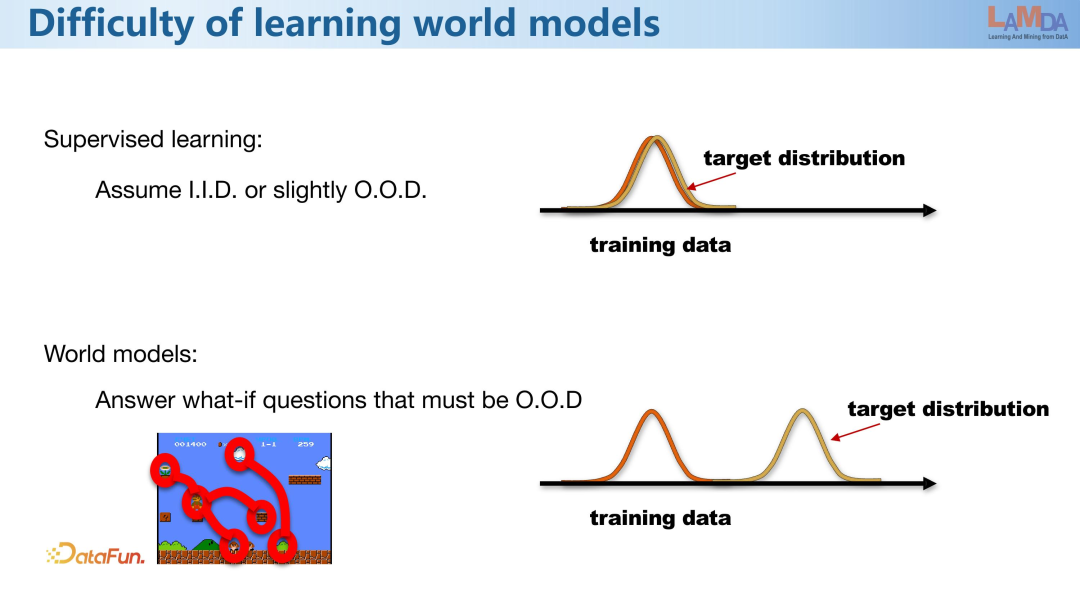

上述問題導(dǎo)致對因果關(guān)系的學(xué)習(xí)有著很大的難度,因?yàn)榻裉齑蟛糠謾C(jī)器學(xué)習(xí)技術(shù)都是發(fā)現(xiàn)相關(guān)性,換而言之就是在監(jiān)督學(xué)習(xí)里面,經(jīng)常會(huì)假定數(shù)據(jù)是獨(dú)立同分布的。我們會(huì)假定訓(xùn)練數(shù)據(jù)和預(yù)測數(shù)據(jù)的分布要有一定的規(guī)律。但是 world model 不是用來做預(yù)測的,它最核心的事情是要去回答 what if 這樣的問題。比如股市中,如果我今天買,之后會(huì)怎么樣?如果沒買,又會(huì)怎樣?只有回答大量的 what if question,才能幫助我們?nèi)プ鰶Q策。這種 what if question,就使得我們總是對那些數(shù)據(jù)之外的事情很感興趣,特別是在倒推的時(shí)候,我們總會(huì)假設(shè)如果做出另外一種決策,會(huì)不會(huì)更好。

而 world model 能夠支撐我們?nèi)?what if question,就意味著 world model 不管是從什么數(shù)據(jù)上面學(xué)出來的,總會(huì)關(guān)心那些數(shù)據(jù)以外的問題,所以我們一定要用 world model 去回答 out of data distribution 的數(shù)據(jù)上面的推理,所以它和我們今天所熟悉的大部分技術(shù)都不太一樣。

world model 需要回答當(dāng)決策者做另外一個(gè)決策時(shí)的結(jié)果,這樣的預(yù)測實(shí)際上是非常難做的,它和經(jīng)典的監(jiān)督學(xué)習(xí)的假設(shè)是不一樣的。

三、基于環(huán)境模型的強(qiáng)化學(xué)習(xí)框架

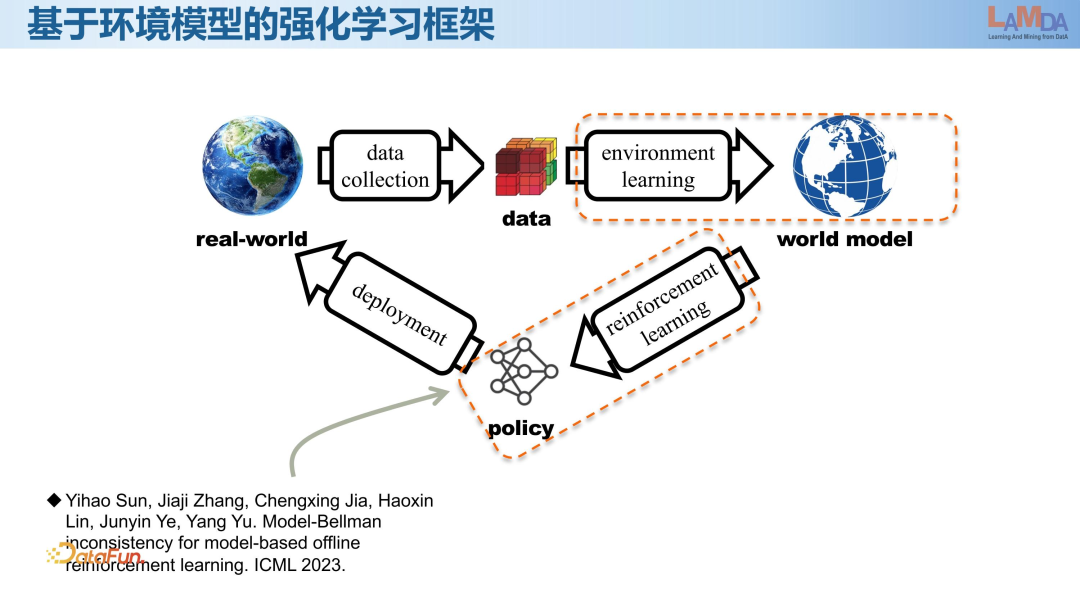

下面講一下 world model 的框架。首先從真實(shí)事件里面采到了一些數(shù)據(jù),通過環(huán)境學(xué)習(xí)的方式構(gòu)建一個(gè) world model,然后在 world model 里進(jìn)行強(qiáng)化學(xué)習(xí),以得到更好的策略,這個(gè)策略將會(huì)部署到真實(shí)環(huán)境里面去用,我們特別期待的是這個(gè)策略不需要做更多的探索,就直接可以部署到環(huán)境里面,做更好的決策。

當(dāng)我們構(gòu)建出 world model 之后,怎樣在 world model 里去做更好的強(qiáng)化學(xué)習(xí),哪怕這個(gè) world model 并不是那么完美,或者遠(yuǎn)離數(shù)據(jù)以后就表現(xiàn)得不那么好。我們更關(guān)注的是怎樣將 world model 構(gòu)建得更好,從而使整個(gè)強(qiáng)化學(xué)習(xí)做得更好。在做很多復(fù)雜的決策時(shí),特別是真實(shí)世界的復(fù)雜決策時(shí),我們就可以用這樣的技術(shù)去解決問題。

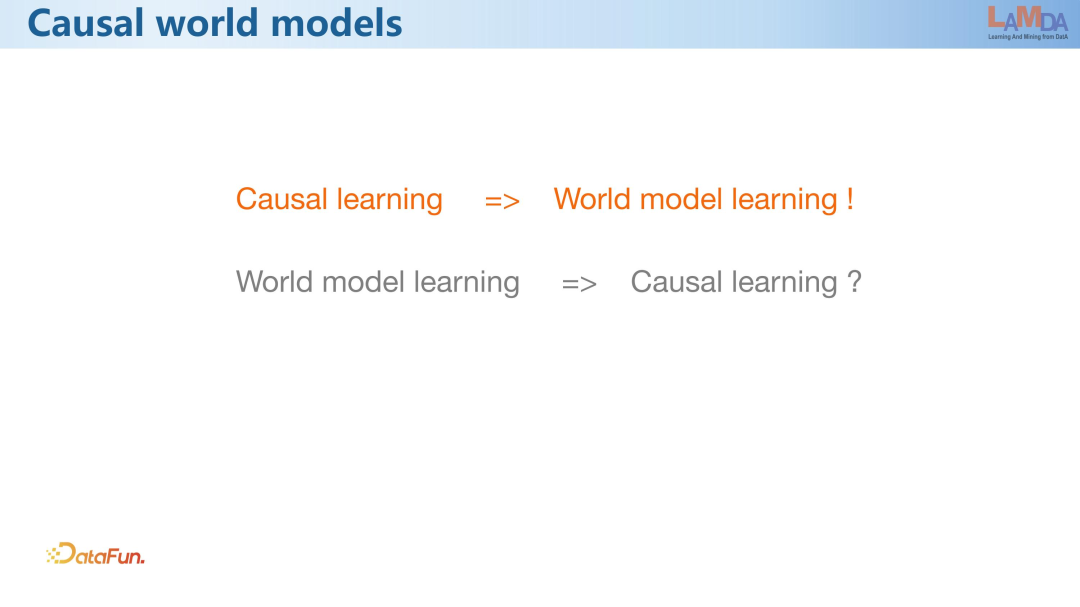

我們希望 world model 能夠和因果結(jié)合起來。如果將因果學(xué)習(xí)的技術(shù)放到 world model 中去,是否能讓 world model 學(xué)得更好。

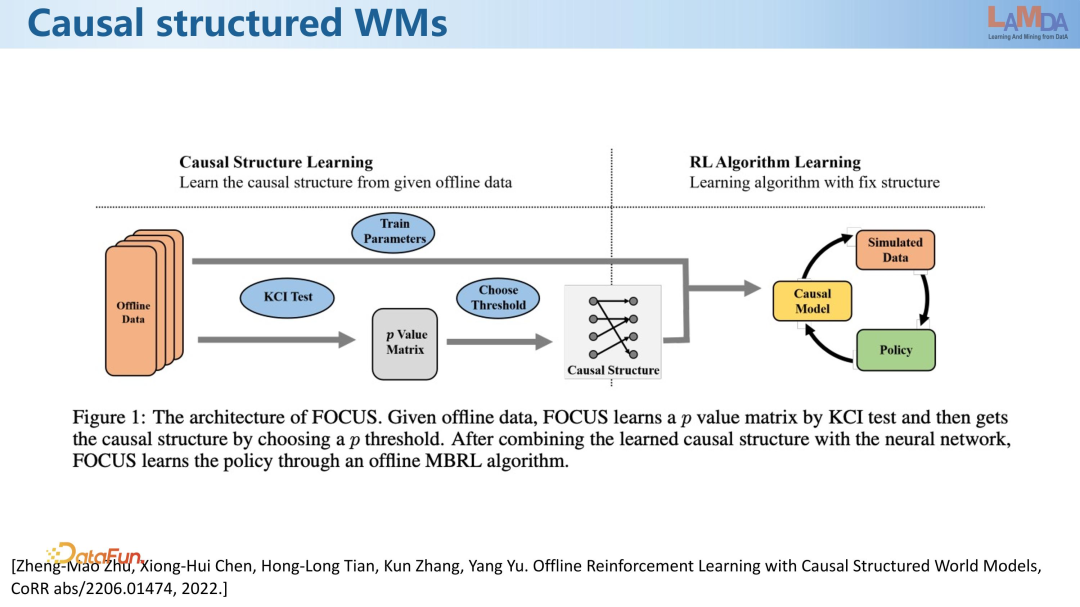

起初的想法是,通過因果結(jié)構(gòu)學(xué)習(xí),能夠把 world model 的結(jié)構(gòu)發(fā)現(xiàn)得更好。World model 中哪些實(shí)體有因果關(guān)系,我們就將相應(yīng)的邊連上,沒有因果關(guān)系的就把邊去掉。這件事情其實(shí)看起來很簡單,但是在強(qiáng)化學(xué)習(xí)里面去學(xué) model 時(shí),很久以來一直都是全連接的 model 的學(xué)習(xí),就是上一個(gè)時(shí)刻的所有的變量,去預(yù)測下一個(gè)時(shí)刻的所有的變量,不太關(guān)注中間的關(guān)系,如果有一些假的因果關(guān)系在里面,就會(huì)導(dǎo)致 world model 學(xué)得不夠好。

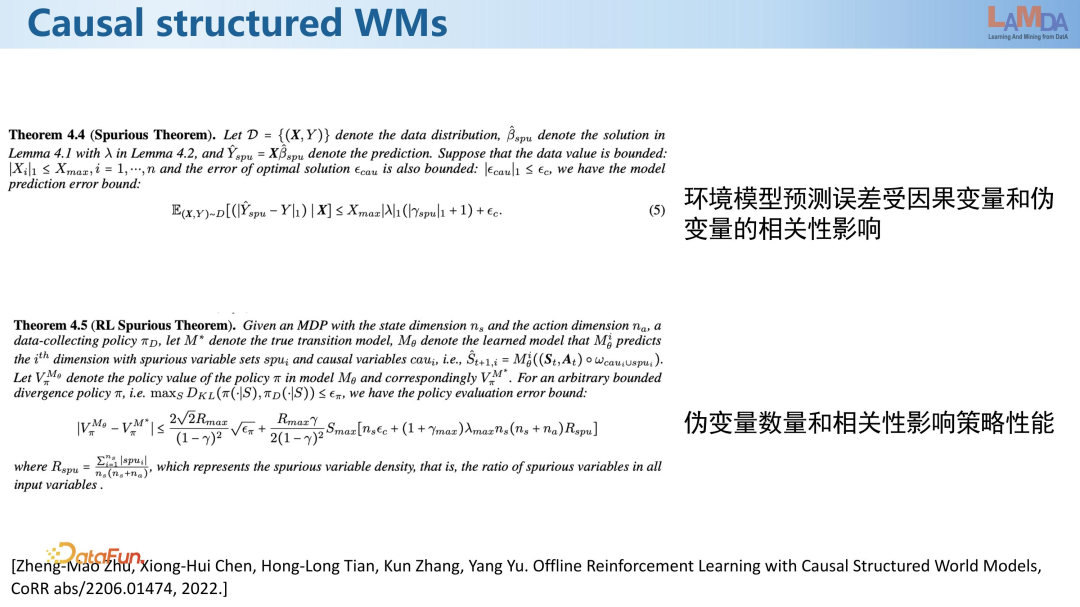

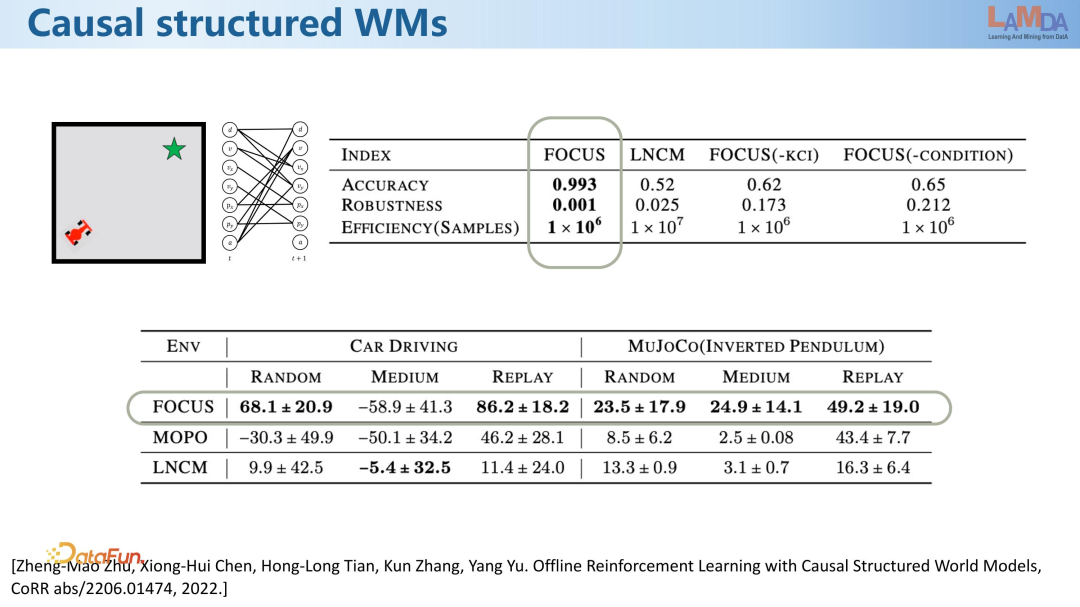

因此我們探索能否通過更好的因果結(jié)構(gòu)的學(xué)習(xí),獲得一個(gè)更好的 world model。我們將變量劃分為因果變量和偽變量。真實(shí)環(huán)境模型與學(xué)到的環(huán)境模型去評估同一策略時(shí),性能差異與引入的偽變量數(shù)量相關(guān)。能夠排除的偽變量越多,該策略的性能會(huì)越好。

從實(shí)驗(yàn)中也會(huì)發(fā)現(xiàn),在比較好地還原因果關(guān)系以后,得到的模型性能確實(shí)是能夠有提升的。這是關(guān)于如何使用因果發(fā)現(xiàn)來幫助我們把這個(gè) world model 里面的結(jié)構(gòu)呈現(xiàn)出來。

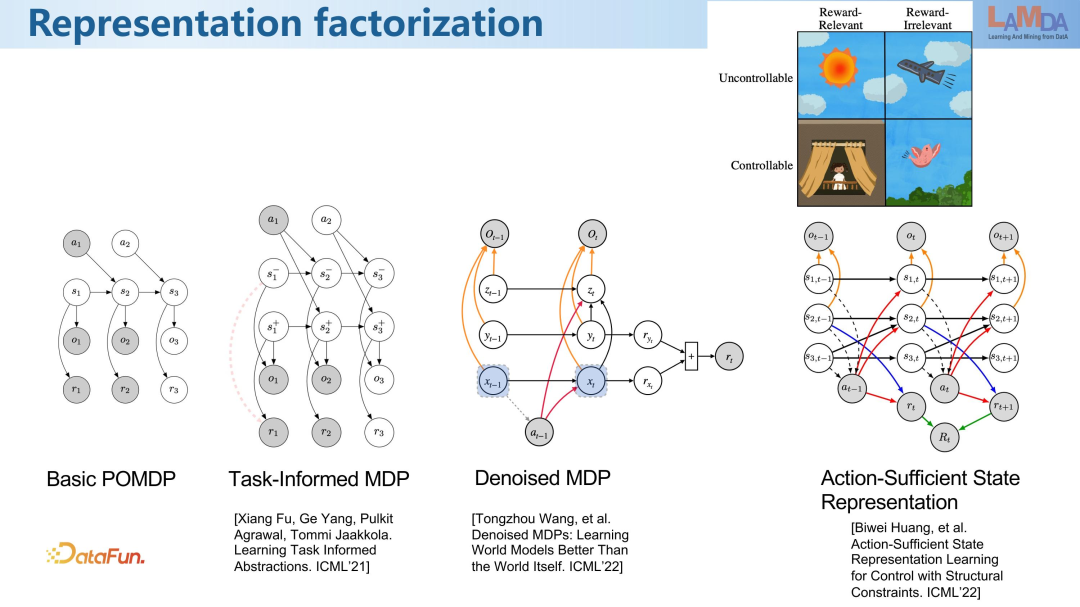

在 2022 年前后,有更多的工作集中在 word model 的學(xué)習(xí)上,實(shí)質(zhì)上是在關(guān)注強(qiáng)化學(xué)習(xí)下的表征學(xué)習(xí)。盡管文章標(biāo)題可能未明確提及"world model"這一術(shù)語,但其實(shí)際上是在進(jìn)行 world model 的學(xué)習(xí)。在基本的強(qiáng)化學(xué)習(xí)表征中,將世界視為一個(gè)具有狀態(tài)的實(shí)體,這個(gè)狀態(tài)會(huì)隨著時(shí)間步驟的推移而變化。然而,我們可能無法直接觀察到這個(gè)狀態(tài),而只能觀察到其一些表征。因此,在執(zhí)行決策后,決策和前一個(gè)時(shí)刻的狀態(tài)將影響下一個(gè)時(shí)刻的狀態(tài)。這個(gè)決策是由某個(gè)策略學(xué)得的,該策略可能基于觀測來決定采取什么動(dòng)作。在經(jīng)典的強(qiáng)化學(xué)習(xí)中,決策通常被視為自由變量,即由個(gè)體自行選擇。

同時(shí),與決策相關(guān)的是獎(jiǎng)勵(lì)(reward)。獎(jiǎng)勵(lì)可能與狀態(tài)的出現(xiàn)有關(guān),也可能與動(dòng)作和下一個(gè)狀態(tài)的共同作用有關(guān),決定獎(jiǎng)勵(lì)的是一個(gè) reward 函數(shù)。然而,在面對復(fù)雜環(huán)境時(shí),觀測中可能包含與任務(wù)關(guān)系不大的信息。因此,某些研究考慮將 MDP 中的任務(wù)信息對狀態(tài)進(jìn)行拆分,使其中一部分與獎(jiǎng)勵(lì)無關(guān),從而使建模更加穩(wěn)定。近期的研究如 ICML 22 中的兩篇相關(guān)工作,也在致力于進(jìn)一步優(yōu)化這個(gè)模型。

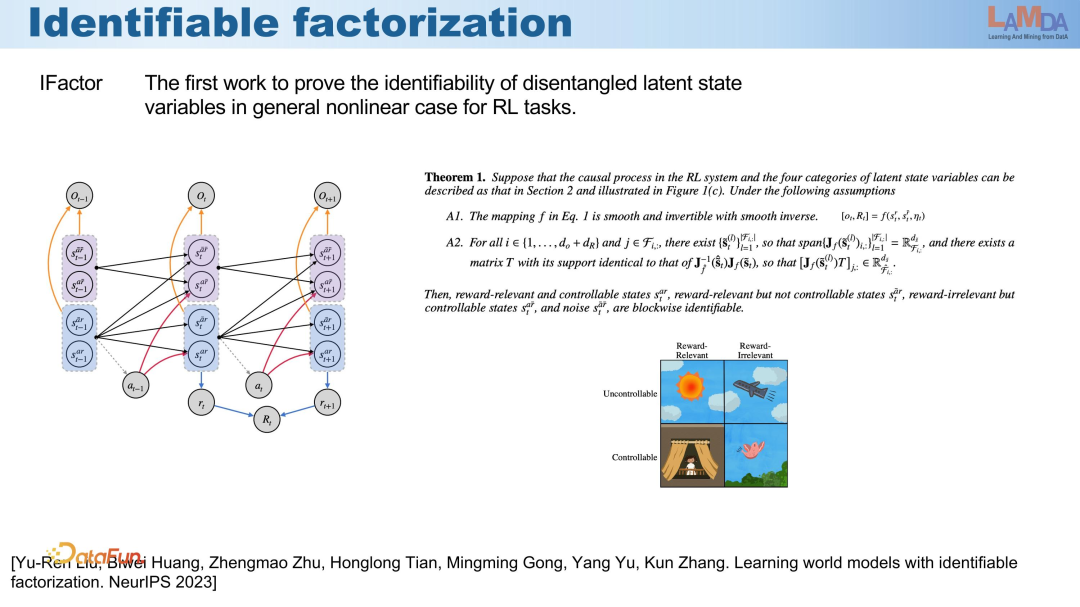

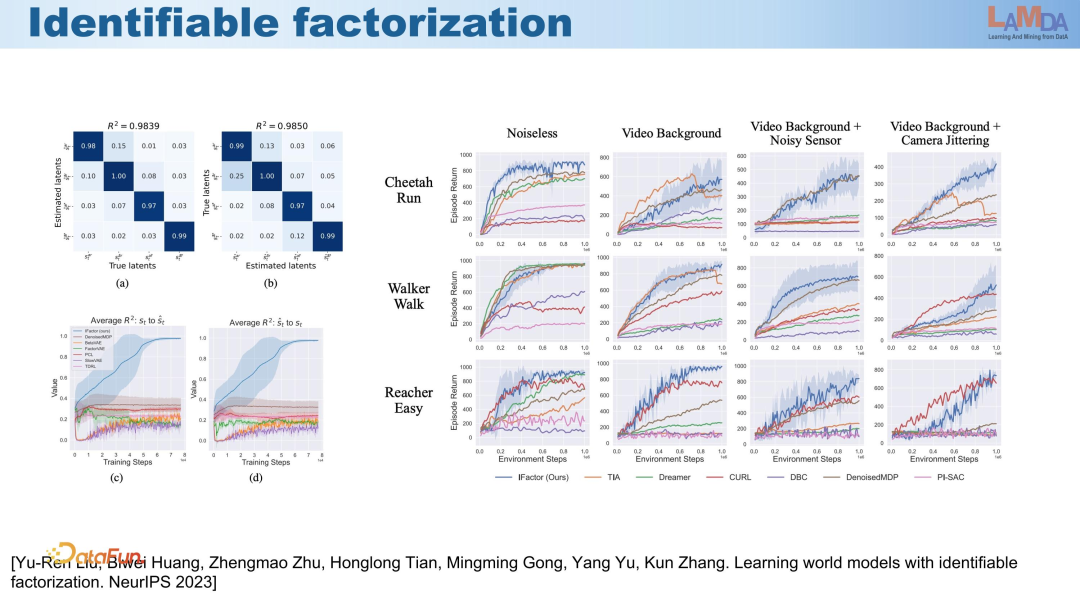

綜合而言,觀測變量可以分為四類:受決策影響的、不受決策影響的、與獎(jiǎng)勵(lì)相關(guān)的和與獎(jiǎng)勵(lì)無關(guān)的。在強(qiáng)化學(xué)習(xí)的后續(xù)階段,我們主要關(guān)注的是通過決策可以影響的獎(jiǎng)勵(lì)最大化的部分。然而,我們發(fā)現(xiàn)在先前的分解中,其因果關(guān)系的可識別性可能是不足的。

因此,在我們新的工作中發(fā)現(xiàn),在建模過程中,上述四個(gè)方面都是不可或缺的。在這種情況下,能夠?qū)崿F(xiàn)以塊狀方式可辨識(block-wise identifiable),也就是說,在這種結(jié)構(gòu)下,它才能夠正確地識別這四個(gè)變量。識別出來后,就可以在此基礎(chǔ)上進(jìn)行魯棒的強(qiáng)化學(xué)習(xí)訓(xùn)練。

從實(shí)驗(yàn)中也可以看到,如果能正確地對這四個(gè)方面進(jìn)行分解,在進(jìn)行接下來的強(qiáng)化學(xué)習(xí)步驟時(shí),所有方法在沒有噪音的情況下表現(xiàn)都差不多。然而,當(dāng)引入更多噪音時(shí),它能夠?qū)⑴c獎(jiǎng)勵(lì)無關(guān)且與我們的控制無關(guān)的部分分離出來,從而使后續(xù)決策更加精準(zhǔn)。

因此,對于 world model,對這些變量進(jìn)行分解,呈現(xiàn)出變量之間的因果關(guān)系是非常必要的。

前述工作主要是關(guān)于因果結(jié)構(gòu),而后續(xù)可能會(huì)朝著 Rubin 的因果性方向發(fā)展。

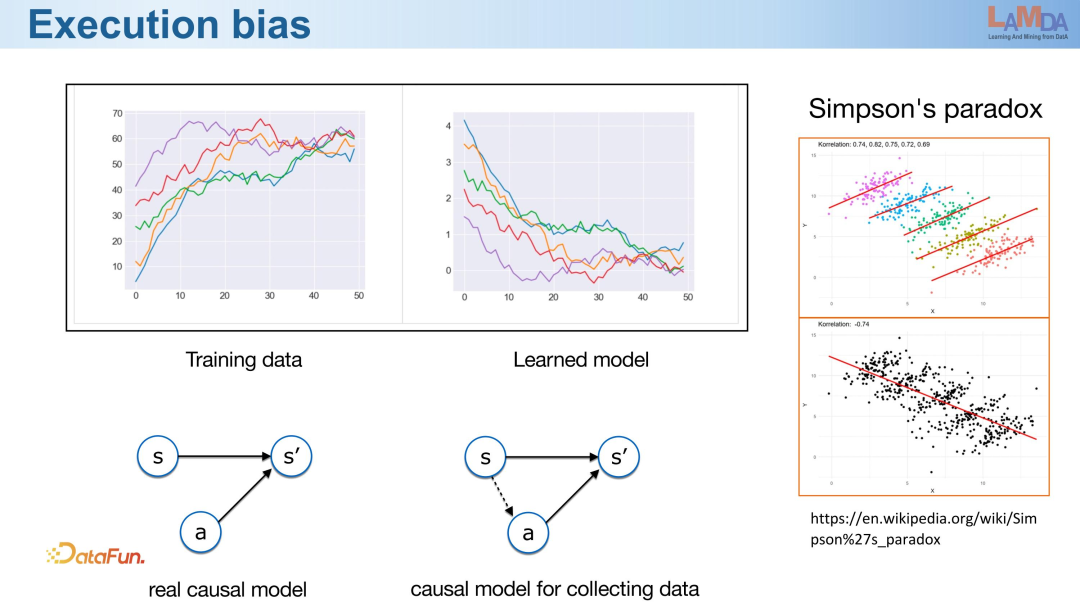

我們在一些真實(shí)環(huán)境中觀察到了因果建模錯(cuò)誤的現(xiàn)象。例如上圖所示,在與美團(tuán)的合作中,當(dāng)為騎手提供更高的價(jià)格時(shí),我們預(yù)期騎手的效率應(yīng)該更高。然而,監(jiān)督學(xué)習(xí)的結(jié)果卻截然相反,即價(jià)格越高騎手的效率反而降低。這顯然與直覺相悖。

為什么會(huì)出現(xiàn)這種情況呢?我們在強(qiáng)化學(xué)習(xí)中默認(rèn)假定動(dòng)作是自由變量,然而實(shí)際收集到的數(shù)據(jù)并非如此,動(dòng)作是根據(jù)策略從狀態(tài)中生成的。因此,如果假設(shè)它是自由變量,當(dāng)我們試圖學(xué)習(xí)這種關(guān)系時(shí),就會(huì)將隱含的關(guān)系納入學(xué)習(xí),導(dǎo)致問題的產(chǎn)生。這與我們經(jīng)典的辛普森悖論有直接的聯(lián)系。狀態(tài)到動(dòng)作之間存在多個(gè)不同的狀態(tài)到動(dòng)作映射,分開看時(shí),每個(gè)映射都是正確的,但如果將所有數(shù)據(jù)合并來看,就會(huì)發(fā)現(xiàn)這是一個(gè)錯(cuò)誤的關(guān)系。

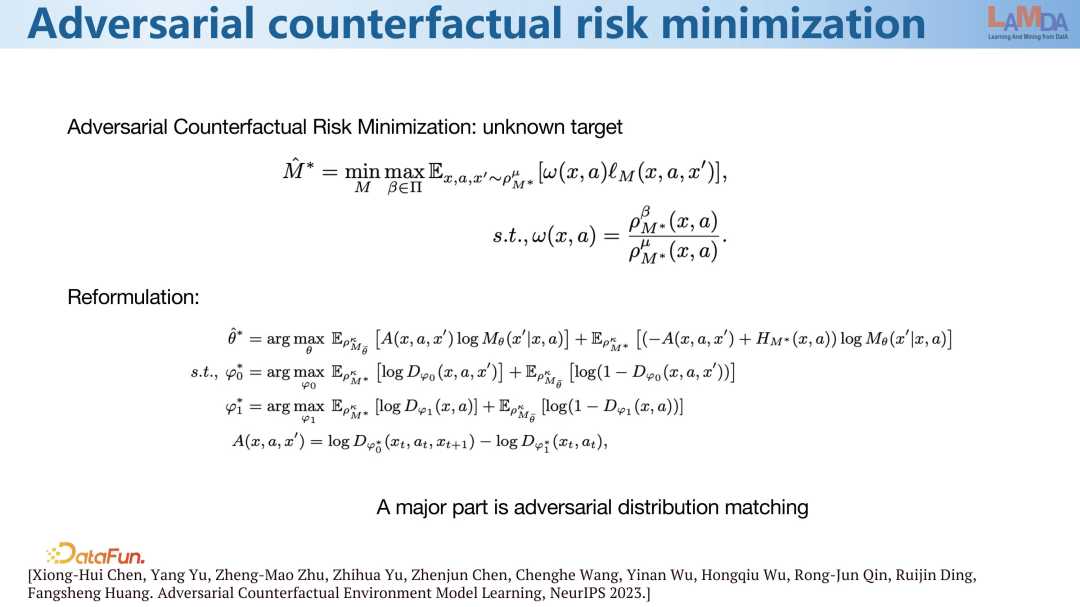

為了解決這一問題,一種經(jīng)典的方法是分布修正,即通過調(diào)整采集到的數(shù)據(jù)分布與目標(biāo)分布之間的偏移,從一定程度上緩解這一問題。

然而,對于強(qiáng)化學(xué)習(xí)而言,目標(biāo)分布實(shí)際上是不清楚的,因?yàn)槲覀儾恢滥繕?biāo)是什么,目標(biāo)取決于策略,而策略尚未生成。因此,需要考慮對目標(biāo)策略的最壞情況,希望在任何目標(biāo)策略的情況下都能夠?qū)崿F(xiàn)較好的分布修正。

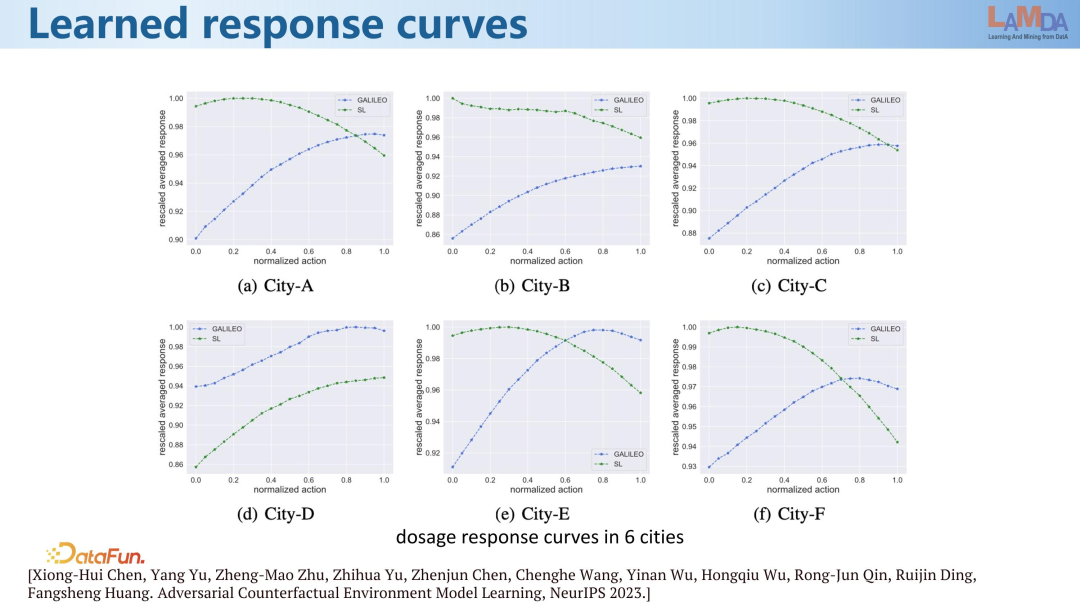

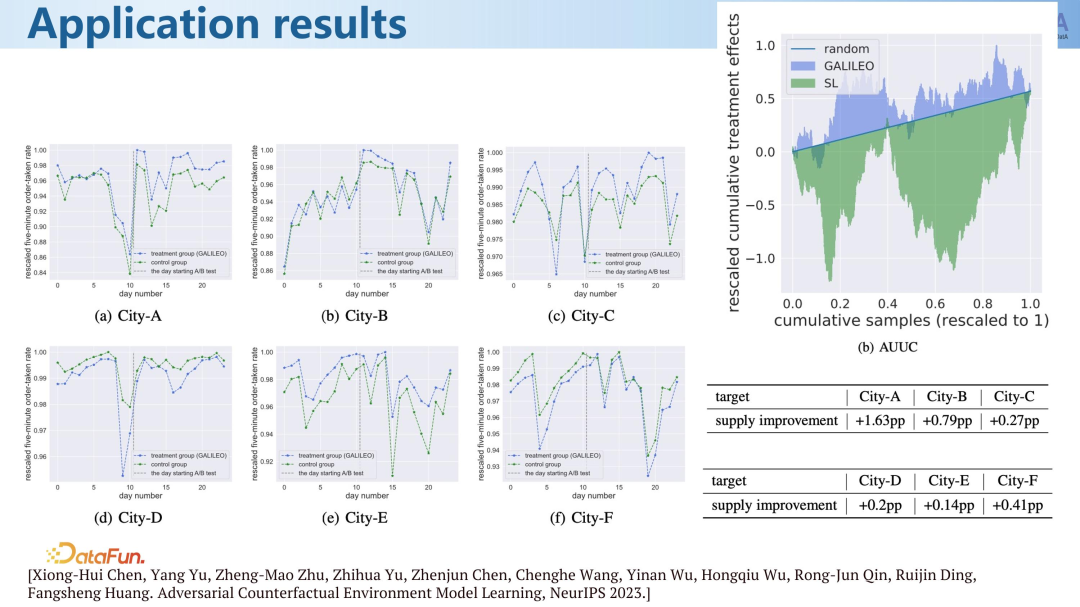

在進(jìn)行修正后,我們在六個(gè)實(shí)際城市中觀察到,綠色線所代表的是監(jiān)督學(xué)習(xí)提取的關(guān)系。在其中五個(gè)城市中,關(guān)系都是錯(cuò)的,即騎手薪酬越高其效率越低。而經(jīng)過修正后,可以觀察到這些線都呈遞增趨勢。因此,修正后的結(jié)果能夠更好地輔助我們進(jìn)行 world model 的建模。

完成建模后,我們注意到在六個(gè)城市中,能夠在決策層面取得更好的效果。在圖中,豎線表示我們引入了新的決策,在兩個(gè)不同的城市和區(qū)域之間進(jìn)行了對比,之前的藍(lán)色區(qū)域位于紅綠色區(qū)域下方,但在應(yīng)用新決策后,藍(lán)色區(qū)域移動(dòng)到了綠色社區(qū)域上方,進(jìn)一步提高了我們的效率。因此,我們可以觀察到監(jiān)督學(xué)習(xí)所建立的模型實(shí)際上導(dǎo)致了效率的降低。這是基于真實(shí)隨機(jī)數(shù)據(jù)的實(shí)驗(yàn)結(jié)果。收集隨機(jī)數(shù)據(jù)是需要成本的,因此在實(shí)際業(yè)務(wù)中,我們不希望在真實(shí)環(huán)境中進(jìn)行試錯(cuò)。可以看到,如果使用監(jiān)督學(xué)習(xí)模型,其效果實(shí)際上比隨機(jī)方法更差。而通過更好的建模,我們能夠獲得比隨機(jī)方法更好的效果。因此,因果關(guān)系的修正在這個(gè)過程中至關(guān)重要。

接下來介紹一個(gè)最新的研究工作。雖然在這個(gè)工作中我們并沒有直接使用因果學(xué)習(xí)的技術(shù),但我們考慮的是,如果我們能夠更好地學(xué)習(xí) world model,其中是否蘊(yùn)含了一些迄今尚未被充分發(fā)現(xiàn)的強(qiáng)化學(xué)習(xí)相關(guān)的信息。

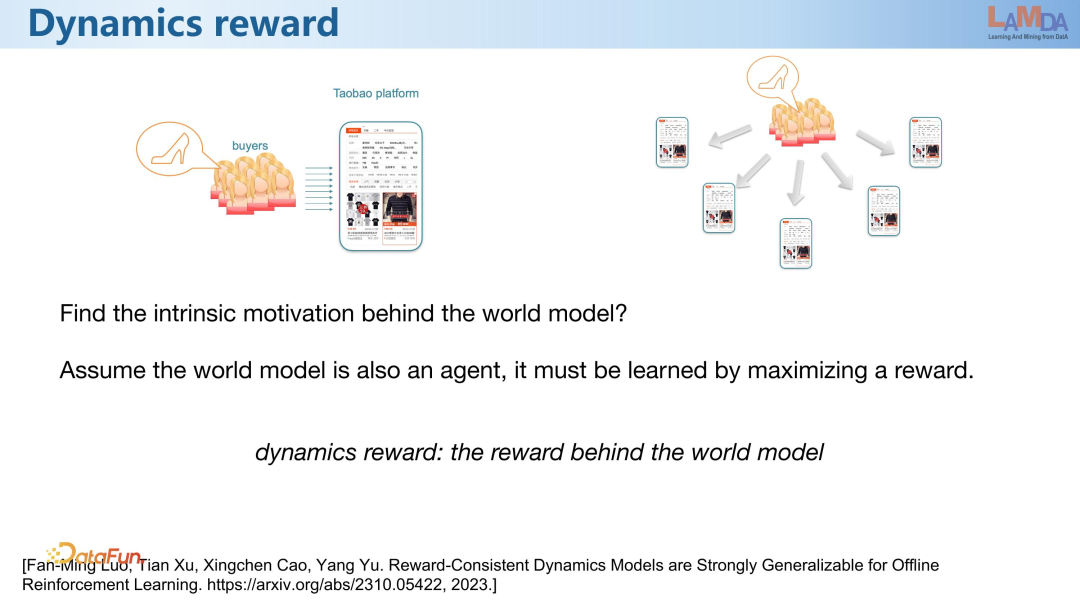

最初我們與淘寶合作,開始應(yīng)用強(qiáng)化學(xué)習(xí)時(shí),我們認(rèn)識到必須能夠成功學(xué)習(xí) world model,否則這個(gè)任務(wù)就無法完成。在這個(gè)學(xué)習(xí)過程中,我們產(chǎn)生了一個(gè)思考:為什么我們能夠?qū)崿F(xiàn)泛化?因?yàn)槲覀兛偸瞧谕?what model 能夠回答那些不在我們數(shù)據(jù)集中的 what if 問題。那么,有什么原理能夠使我們能夠泛化到這些數(shù)據(jù)之外呢?

以購物場景為例,我們將平臺(tái)視為策略,即 agent,而購物的客戶則是我們的環(huán)境。由于 world model 需要包含大量虛擬客戶來進(jìn)行購物,我們關(guān)注的是在我們已經(jīng)采集數(shù)據(jù)的推薦情況之外,當(dāng)我們試圖回答那些未見過的數(shù)據(jù)時(shí),系統(tǒng)將如何運(yùn)作。我們考慮的一個(gè)想法是,由于這里涉及到人類,我們可以將其看作是一個(gè) agent。既然它是一個(gè) agent,那么它應(yīng)該是在最大化某種 reward 的基礎(chǔ)上做出其行為決策的。

換句話說,我們可以將我們的環(huán)境也看作是一個(gè)需要通過強(qiáng)化學(xué)習(xí)來學(xué)習(xí)的 agent。在購物環(huán)境下,這種觀點(diǎn)可能更加直觀。由于我們的環(huán)境中存在人,我們可以假設(shè)這個(gè)人背后有 reward,有動(dòng)機(jī)。如果我們直接從數(shù)據(jù)中觀察,我們很難將數(shù)據(jù)泛化到其他場景中。

但是,如果我們能夠?qū)W到這個(gè) agent 背后的 reward,那么在面對其他未曾見過的場景時(shí),我們就能夠直接通過最大化這個(gè) reward 來生成消費(fèi)者行為數(shù)據(jù)。如果這個(gè)數(shù)據(jù)符合對該 agent 的假設(shè),那么我們就能夠在未曾見過的場景中生成數(shù)據(jù),從而實(shí)現(xiàn)數(shù)據(jù)的泛化。我們將這樣的 reward 稱為 Dynamics reward。

后來我們發(fā)現(xiàn),這個(gè)假設(shè)不僅對人類有效,對于其他環(huán)境,比如機(jī)械環(huán)境,也同樣有效。因此,我們開發(fā)了一項(xiàng)技術(shù),從有限的數(shù)據(jù)中還原 world model 背后的 reward 函數(shù),并使用這個(gè) reward 函數(shù)生成更多數(shù)據(jù)。

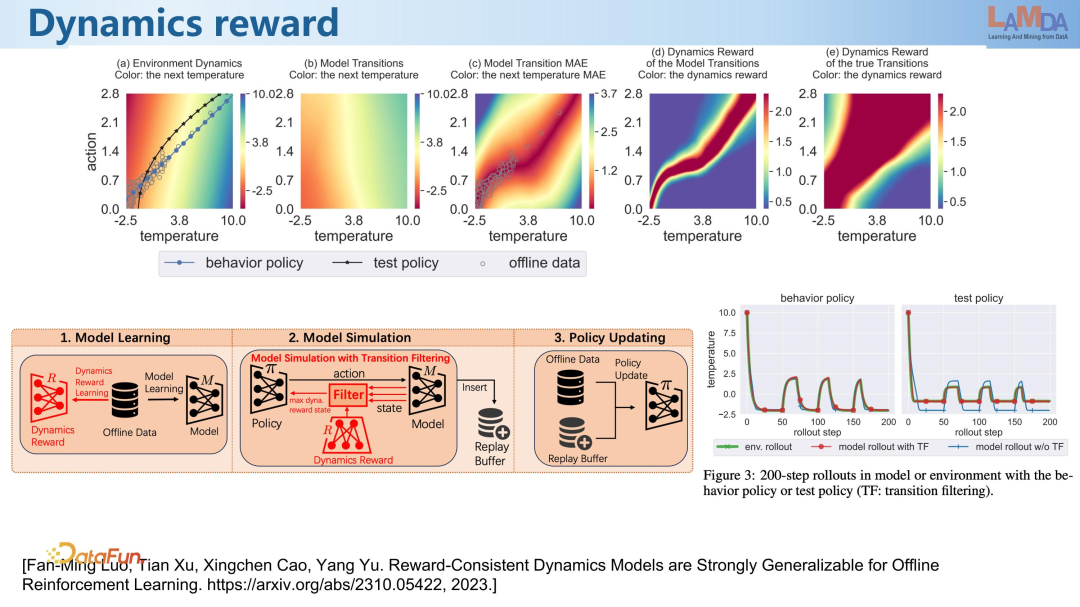

這是一個(gè)簡單的場景,通過控制冰箱溫度來調(diào)整壓縮機(jī)的控制。如果壓縮機(jī)增加壓力,溫度就會(huì)上升。圖中橫軸表示溫度,縱軸表示壓縮機(jī)的控制,顏色表示下一個(gè)時(shí)刻的溫度。從圖中可以看出,溫度正在下降。圖中的斜對角線代表我們的策略,該策略在采集到的數(shù)據(jù)點(diǎn)上運(yùn)行,這些數(shù)據(jù)點(diǎn)用小圓圈表示。由于數(shù)據(jù)量有限,當(dāng)我們嘗試使用監(jiān)督學(xué)習(xí)從這些數(shù)據(jù)中學(xué)習(xí)時(shí),它的泛化能力非常有限,只能泛化到深色區(qū)域的一小部分,只有這一小部分是正確的,其他部分則不正確。因此,直接使用數(shù)據(jù)進(jìn)行學(xué)習(xí)的泛化能力較差。

當(dāng)我們從這些數(shù)據(jù)中學(xué)習(xí)一個(gè) reward model 后,該 reward model 可以為模型評分,即確定哪些地方的 reward 較高,也就是模型在真實(shí)環(huán)境中表現(xiàn)良好的地方。通過對比可以看出,監(jiān)督學(xué)習(xí)的泛化能力只覆蓋了一小部分,而 reward model 學(xué)到的 Dynamics reward model 的泛化能力則涵蓋了更大的區(qū)域。因此,泛化能力得到了顯著增強(qiáng)。

對于一個(gè)未見過的測試策略,在監(jiān)督學(xué)習(xí)模型中可能會(huì)偏離真實(shí)環(huán)境。但是如果使用了 reward model,模型就能夠更緊密地貼合真實(shí)環(huán)境。值得一提的是,reward model 與我們在 ChatGPT 的最后一步中看到的用 reward model 修正價(jià)值對齊的方法基本相同。因此,在強(qiáng)化學(xué)習(xí)中,除了學(xué)習(xí)轉(zhuǎn)移和計(jì)算轉(zhuǎn)移外,我們還通過逆強(qiáng)化學(xué)習(xí)學(xué)習(xí)了一個(gè) Dynamics reward model,并使用該 Dynamic reward model 進(jìn)行轉(zhuǎn)移修正,這極大地提高了離線強(qiáng)化學(xué)習(xí)的性能。

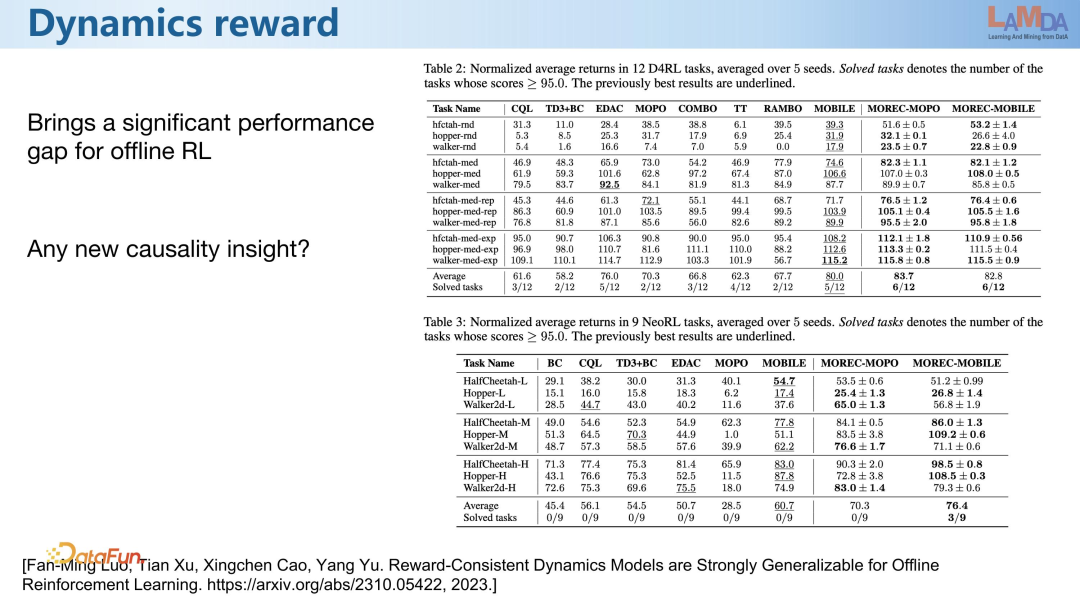

在默認(rèn)的 RL 基準(zhǔn)測試上,可以看到性能得到了顯著提升。之前的情況下,分?jǐn)?shù)大致在 60 到 70 之間,而在線強(qiáng)化學(xué)習(xí)則能夠達(dá)到 100 分。我們之前的研究在六個(gè)任務(wù)中取得了 80 分的成績,而引入 Dynamics reward model 后,性能提升至 83 分,已經(jīng)達(dá)到了性能的天花板,無法繼續(xù)提高。我們已經(jīng)成功解決了六個(gè)任務(wù),這意味著我們的離線強(qiáng)化學(xué)習(xí)已經(jīng)達(dá)到了與在線強(qiáng)化學(xué)習(xí)相媲美的水平,已經(jīng)完成了一半的任務(wù)。

在更為困難的新 RL 基準(zhǔn)測試中,采樣策略的平均得分為 50 分,之前基本上都無法及格,我們的上一項(xiàng)工作僅達(dá)到 60 分,而加入 Dynamics reward model 的修正后,分?jǐn)?shù)提高到 76 分,并且有三個(gè)任務(wù)的得分能夠與在線強(qiáng)化學(xué)習(xí)相匹敵。因此,更好地建模 world model,能夠使整個(gè)強(qiáng)化學(xué)習(xí)的性能顯著提升。

我們注意到在 CVPR 2023 上已經(jīng)有一些研討會(huì)強(qiáng)調(diào)了對 world model 的研究,尤其是特斯拉公司,他們認(rèn)為構(gòu)建出的 world model 對于自動(dòng)駕駛至關(guān)重要。當(dāng)然,這些僅僅是一個(gè)起點(diǎn),我們期望更多的研究人員和學(xué)者,特別是從事因果建模的人士,能夠?qū)⒀芯抗ぷ髋c world model 相結(jié)合。感謝大家的關(guān)注。

四、問答環(huán)節(jié)

Q1:請問世界模型是否類似于真實(shí)世界的數(shù)字孿生?或者在某種程度上兩者之間是不是有一些技術(shù)可以共享?

A1:目前數(shù)字孿生僅是一個(gè)概念或者期望,我們希望在數(shù)字環(huán)境中創(chuàng)建與真實(shí)世界相似的實(shí)體。因此,數(shù)字孿生的定義在愿景上是相似的。然而,數(shù)字孿生并未形成獨(dú)特的技術(shù)體系。特別是,當(dāng)我們看今天市場上的數(shù)字孿生時(shí),它們幾乎全部轉(zhuǎn)變?yōu)榭梢暬ぞ撸@與數(shù)字孿生最初的愿景背離甚遠(yuǎn)。雖然數(shù)字孿生方向有其潛力,但目前實(shí)際上并未產(chǎn)生出全新的技術(shù)。因此,我們?nèi)匀徽J(rèn)為從數(shù)據(jù)學(xué)習(xí),特別是學(xué)習(xí) world model,并運(yùn)用因果關(guān)系進(jìn)行這些工作,才是真正值得追求的方向。這僅代表個(gè)人觀點(diǎn)。

Q2:分享中提到因果推斷與 world model 之間的相互賦能,可否分享一些這方面的啟示。

A2:在建模時(shí),World Model 表現(xiàn)為高度非線性,幾乎沒有線性情況。我們特別期望非線性因果建模和因果推斷的技術(shù)能夠得到良好的發(fā)展,并成功應(yīng)用于 World Model。此外,在強(qiáng)化學(xué)習(xí)領(lǐng)域,我們渴望將因果推斷技術(shù)應(yīng)用于探索建模以及整個(gè)學(xué)習(xí)過程。目前,強(qiáng)化學(xué)習(xí)中的探索大多是隨機(jī)的,效率較低。但如果引入因果推斷,系統(tǒng)將能夠理解應(yīng)該在哪些方面進(jìn)行探索,從而提高效率。因此,我們希望在強(qiáng)化學(xué)習(xí)中充分結(jié)合因果推斷,盡管目前結(jié)合兩者的研究相對較少。強(qiáng)化學(xué)習(xí)研究涉及領(lǐng)域廣泛,而因果推斷的應(yīng)用相對有限,這可能是由于這一結(jié)合難度較大。因此,在這個(gè)方向上的堅(jiān)持可能需要大家的共同努力。