拖拽P圖技術(shù)又升級了:StableDrag更穩(wěn)、更準(zhǔn),南大、騰訊聯(lián)合打造

去年 5 月,動動鼠標(biāo)就能讓圖片變「活」得研究 DragGAN 吸引了 AI 圈的關(guān)注。通過拖拽,我們可以改變并合成自己想要的圖像,比如下圖中讓一頭獅子轉(zhuǎn)頭并張嘴。

實現(xiàn)這一效果的研究出自華人一作領(lǐng)銜的「Drag Your GAN」論文,于上個月放出并已被 SIGGRAPH 2023 會議接收。相關(guān)的項目在 GitHub 上已經(jīng)積累了 34.5k 的 Star 量。

項目地址:https://github.com/XingangPan/DragGAN

之后,新加坡國立大學(xué)和字節(jié)跳動推出了類似的研究 ——DragDiffusion。他們利用大規(guī)模預(yù)訓(xùn)練擴散模型,極大提升了基于點的交互式編輯在現(xiàn)實世界場景中的適用性。效果如下動圖所示:

盡管取得了很大的成功,但類似的拖拽方案存在兩個主要缺陷,即點跟蹤不準(zhǔn)確和動作監(jiān)督不完整,從而可能導(dǎo)致無法達(dá)到滿意的拖拽效果。

為了克服這些缺陷,南京大學(xué)、騰訊的幾位研究者提出了一種判別式點跟蹤方法并針對動作監(jiān)督采用了基于置信的潛在增強策略,構(gòu)建了一個更加穩(wěn)定和精確的拖拽編輯框架 ——StableDrag。

其中判別式點跟蹤方法能夠精確地定位更新的操縱點,提高長程操縱穩(wěn)定性;基于置信的潛在增強策略能夠在所有操縱步驟中,保證優(yōu)化的潛在變量盡可能地高質(zhì)量。

- 論文標(biāo)題:StableDrag: Stable Dragging for Point-based Image Editing

- 論文地址:https://arxiv.org/pdf/2403.04437.pdf

- 項目地址:https://stabledrag.github.io/

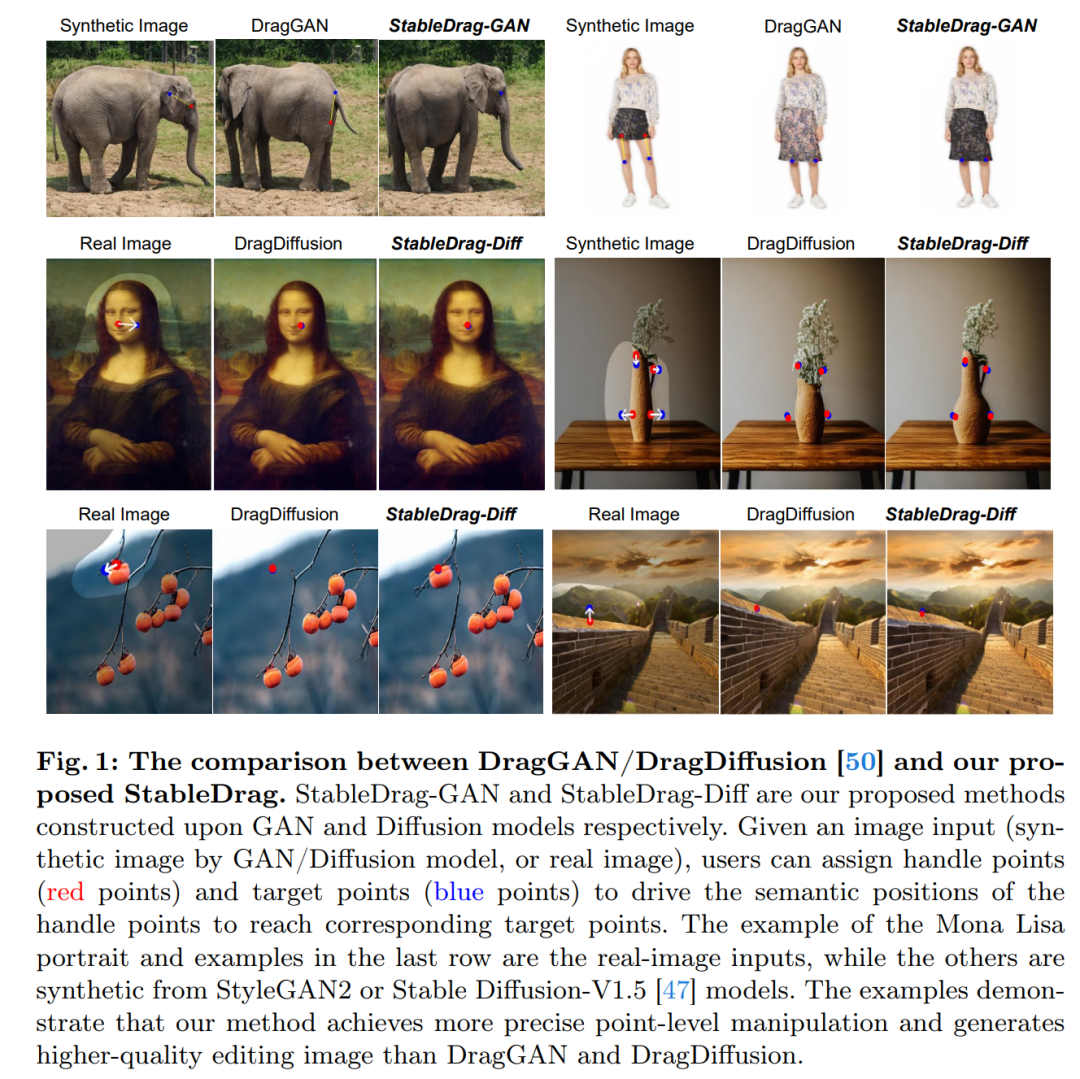

得益于這些獨特的設(shè)計,研究者實例化了兩種類型的圖像編輯模型:StableDrag-GAN 和 StableDrag-Diff。這兩個模型在 DragBench 上進行了廣泛的定性和定量評估,結(jié)果都顯示出更加穩(wěn)定的拖拽效果。

從下面視頻中,我們可以看到 StableDrag-GAN 的拖拽全過程。

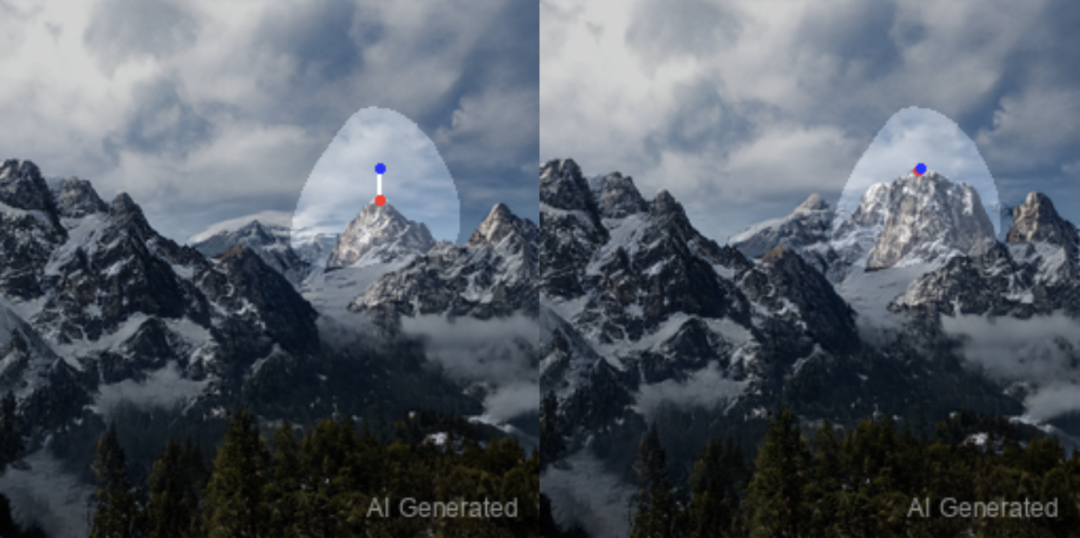

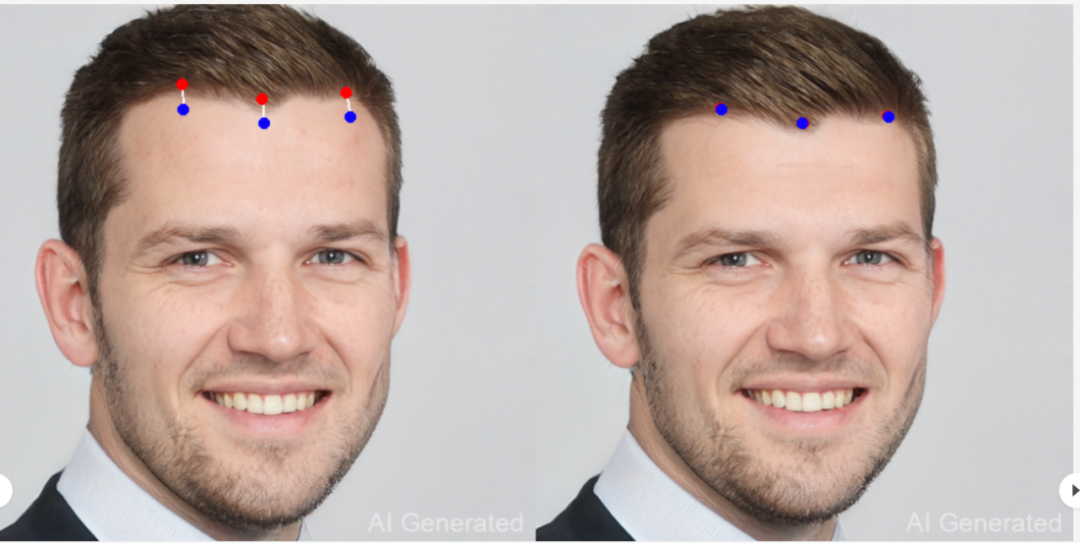

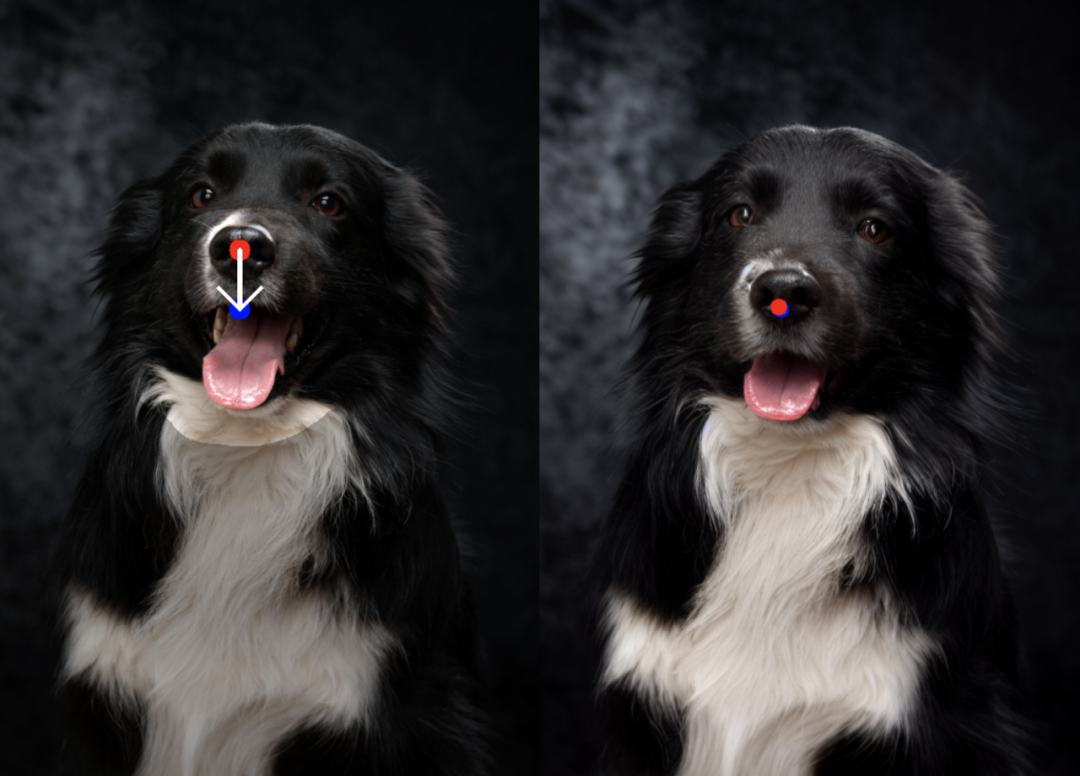

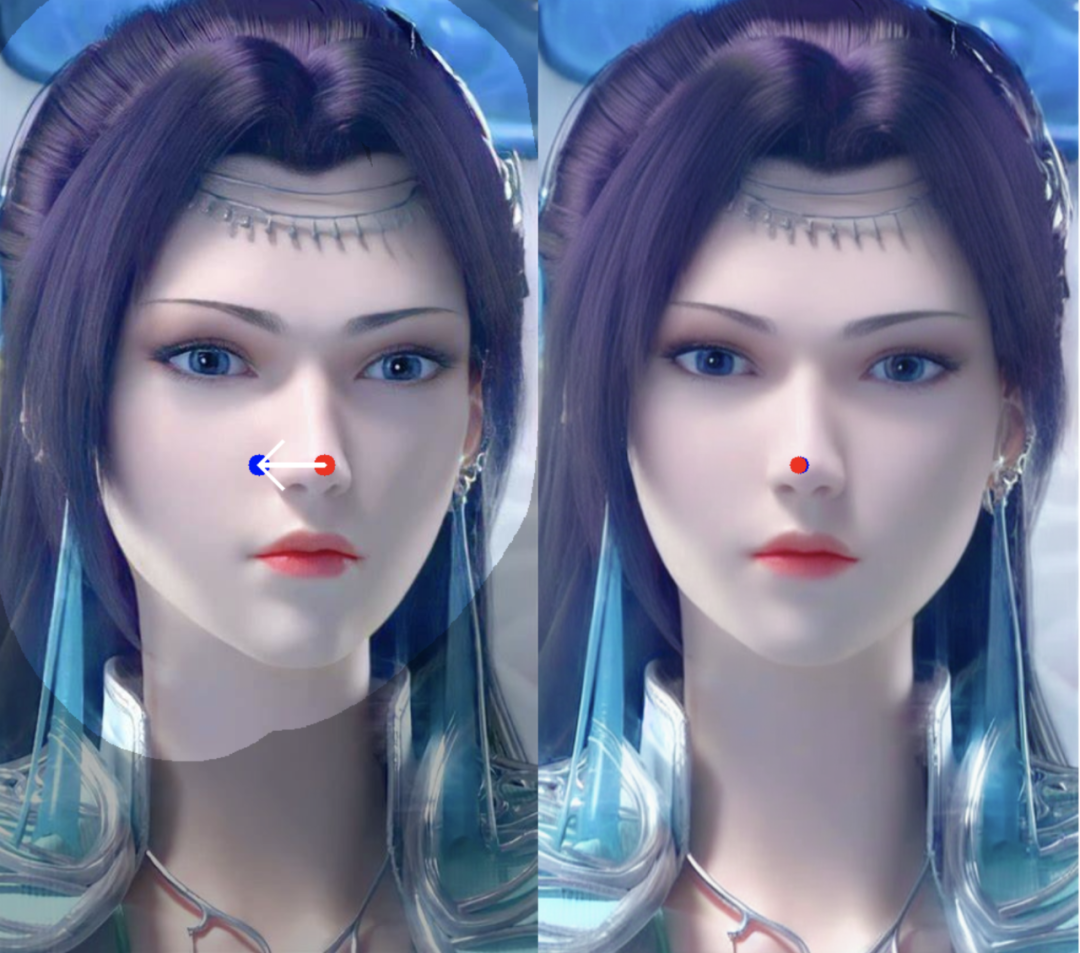

如下為 StableDrag-GAN 的更多拖拽示例。

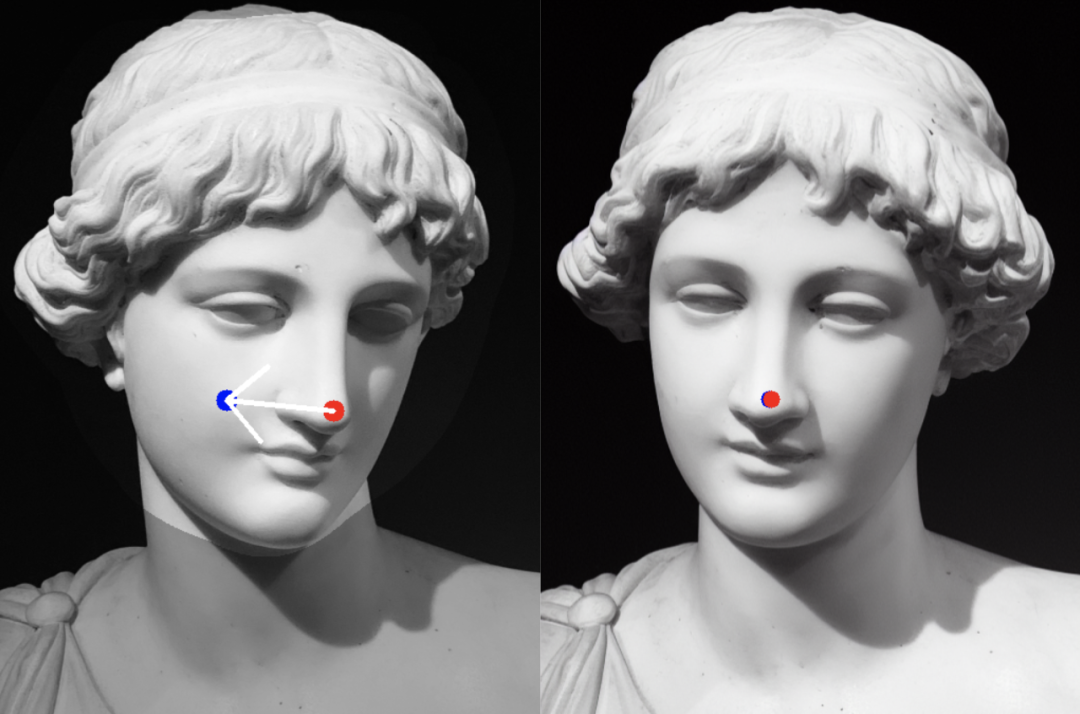

StableDrag-Diff 的拖拽示例如下所示。

方法介紹

如圖 1 所示,由于不精確的點跟蹤和不完整的動作監(jiān)督,DragGAN 和 DragDiffusion 對圖像的編輯質(zhì)量不高。因此,在這項工作中,本文將注意力集中在當(dāng)前的拖拽技術(shù)上,以實現(xiàn)更穩(wěn)定和更精確的圖像操作。

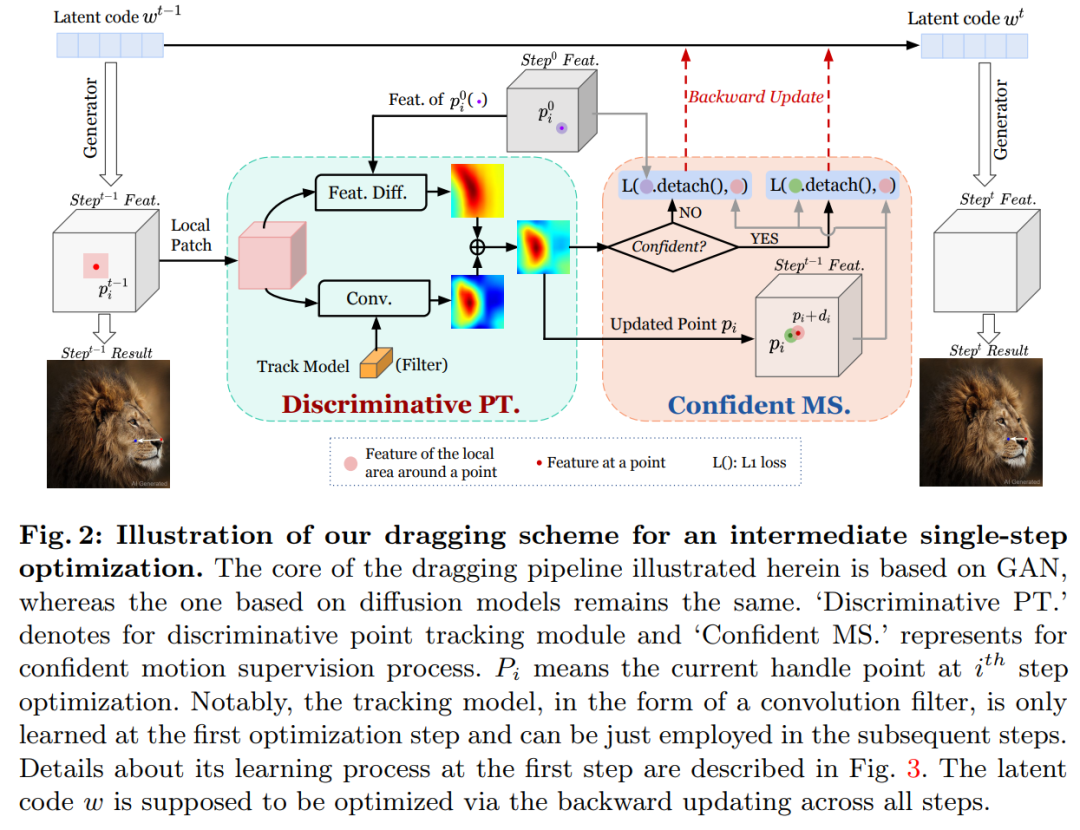

拖拽 pipeline 如圖 2 所示,包括判別點跟蹤模塊( Discriminative PT )和置信動作監(jiān)督模塊( Confident MS )。

判別點跟蹤

本文提出了一種更具辨別力但簡單的點跟蹤算法。在本文的設(shè)計中,點跟蹤模型構(gòu)成卷積層的權(quán)重,并提供點分類得分作為輸出。具體來說,本文建議學(xué)習(xí)一個函數(shù) ,其中 g 為卷積函數(shù),

,其中 g 為卷積函數(shù), 為當(dāng)前操縱點( handle point ) p_i 周圍的局部 patch,z_i 為學(xué)習(xí)到的跟蹤模型。詳細(xì)流程如上圖 2 所示。

為當(dāng)前操縱點( handle point ) p_i 周圍的局部 patch,z_i 為學(xué)習(xí)到的跟蹤模型。詳細(xì)流程如上圖 2 所示。

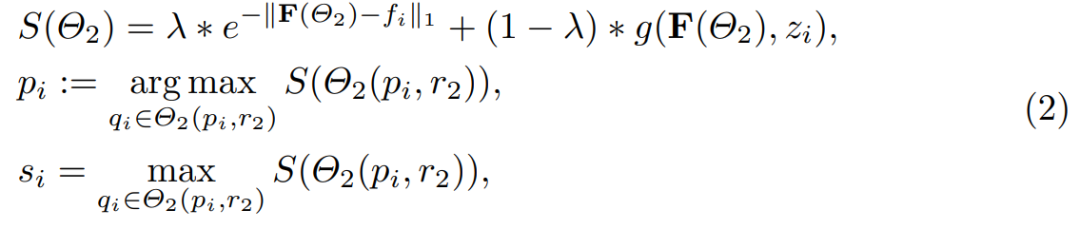

在此過程中,跟蹤點 p_i 的更新方式為:

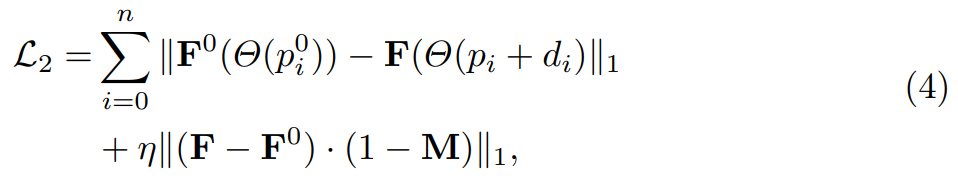

跟蹤模型 z_i 是一個大小為 1 × C × 1 × 1 的卷積濾波器,其學(xué)習(xí)過程概述如圖 3 所示。本文使用 f_i 初始化 z_i 并在以下?lián)p失的監(jiān)督下更新權(quán)重:

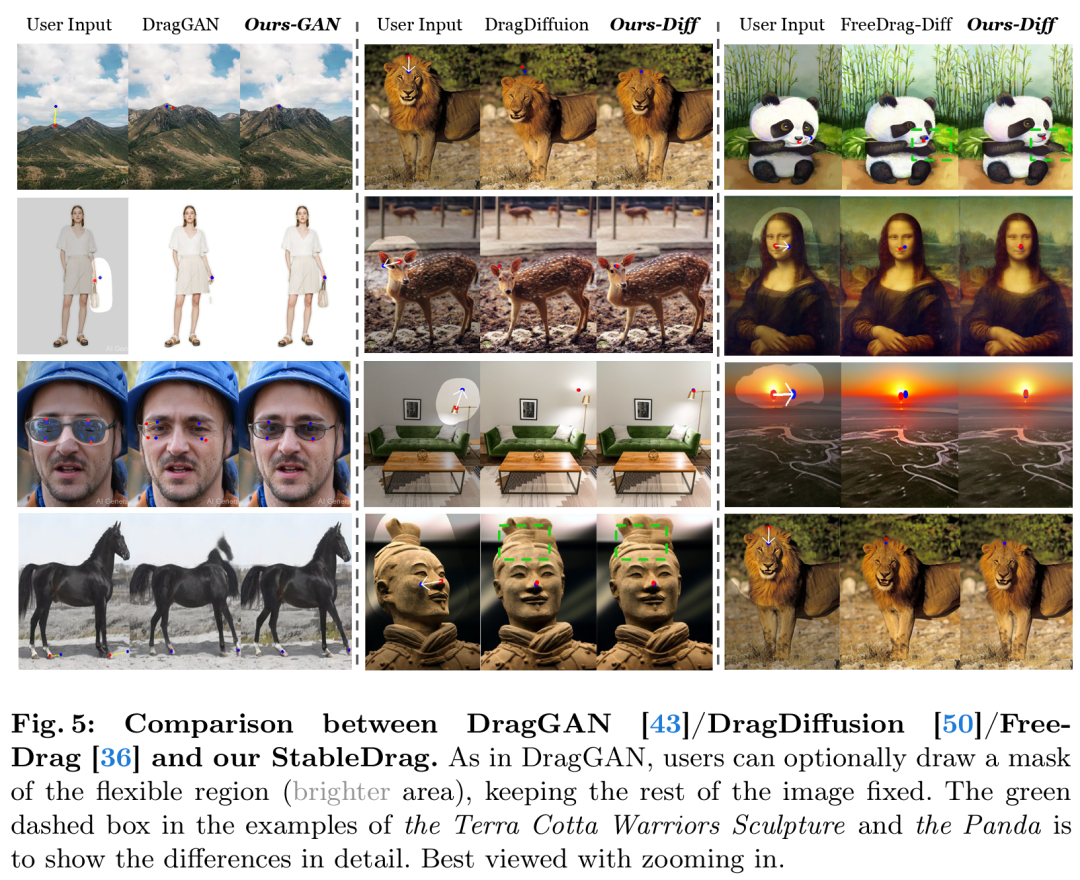

置信動作監(jiān)督

本文提出了一種基于置信度的潛在增強策略,如圖 2 所示。首先,本文引入跟蹤得分最大值即 s_i,來表示當(dāng)前的監(jiān)督置信度,以及置信度分?jǐn)?shù)在 step-1 產(chǎn)生增強策略的閾值。通常,當(dāng)模型足夠自信地識別當(dāng)前狀態(tài)時,本文會采用論文中等式(1)的原始動作監(jiān)督。如果當(dāng)前的置信度得分低于預(yù)定義的閾值,則采用初始模板進行監(jiān)督。具體強化監(jiān)督定義為:

實驗結(jié)果

研究者基于 PyTorch 實現(xiàn)了 StableDrag-GAN 和 StableDrag-Diff,實驗中使用了一塊英偉達(dá) V100 GPU。

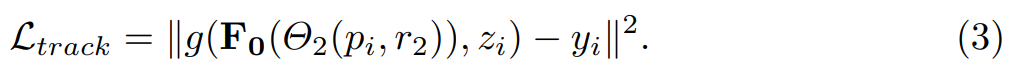

下圖 5 展示了 DragGAN 與 StableDrag-GAN、DragDiffusion 與 StableDrag-Diff、以及 FreeDrag-Diff 與 StableDrag-Diff 三組模型之間的定性比較。

可以看到,本文的 StableDrag 方法可以更精準(zhǔn)地將操縱點移動到目標(biāo)點,例如山峰、獅子下巴、小鹿額頭和燈泡。同時,StableDrag 可以生成更高質(zhì)量和更高保真度的編輯結(jié)果,比如保持手提包、眼鏡、馬和兵馬俑的外觀。

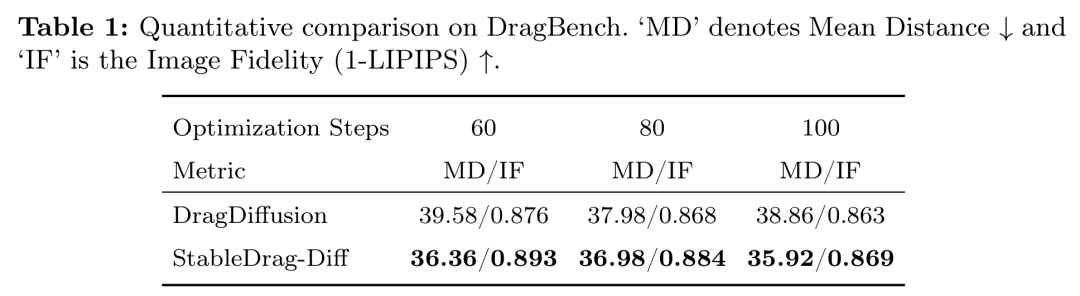

研究者在 DragBench 基準(zhǔn)上對 StableDrag 方法進行了定量評估,該基準(zhǔn)包含 205 個具有預(yù)定義拖拽點和掩碼(mask)的樣本。

如下表 1 所示,在 3 種不同的優(yōu)化步驟設(shè)置下,StableDrag-Diff 始終能夠優(yōu)化 DragDiffusion。

這進一步表明:通過置信動作監(jiān)督和判別式點跟蹤,StableDrag 可以在編輯準(zhǔn)確性和內(nèi)容一致性方面實現(xiàn)有潛力的結(jié)果。

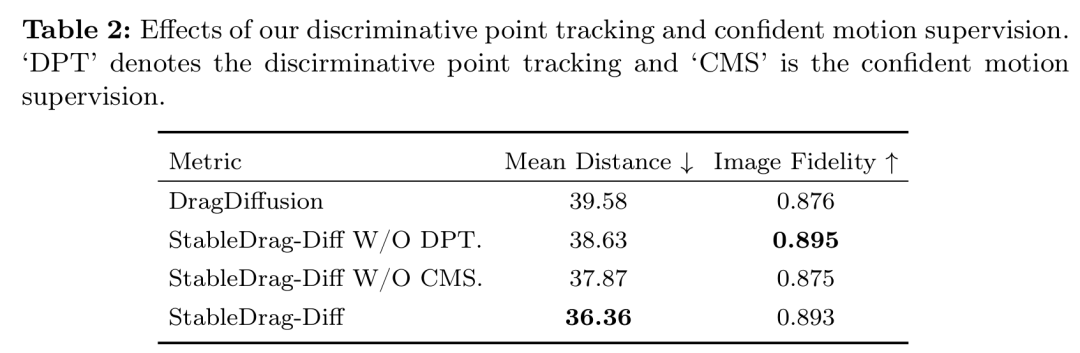

除了定性和定量評估之外,為了驗證本文方法的有效性并展開深入分析,研究者通過「基于 GAN 和擴散模型的定性可視化」以及「基于擴散模型的 DragBench 定量評估」,進行了詳細(xì)的消融實驗。

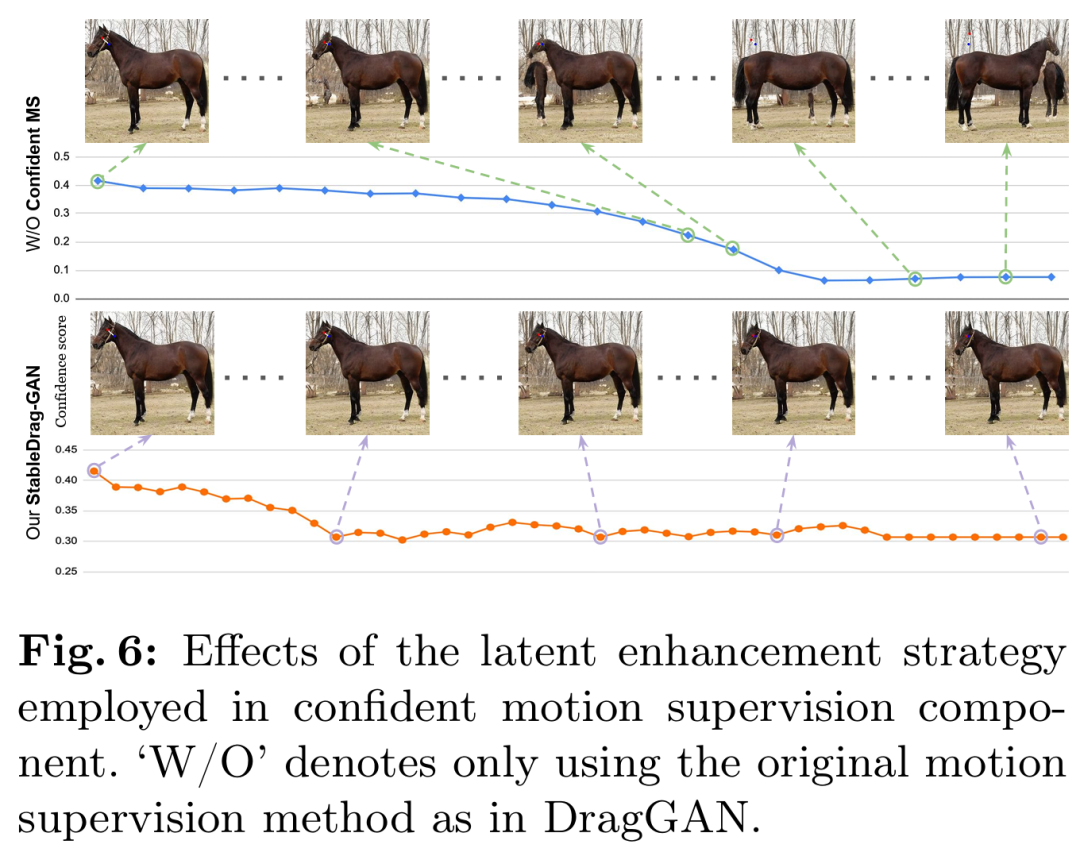

首先是置信動作監(jiān)督。研究者首先進行了基于 StableDrag-GAN 的馬編輯實驗,如下圖 6 所示,隨著置信度得分逐漸降低,沒有置信度動作監(jiān)督模塊的 StableDrag 編輯的圖像質(zhì)量較低。

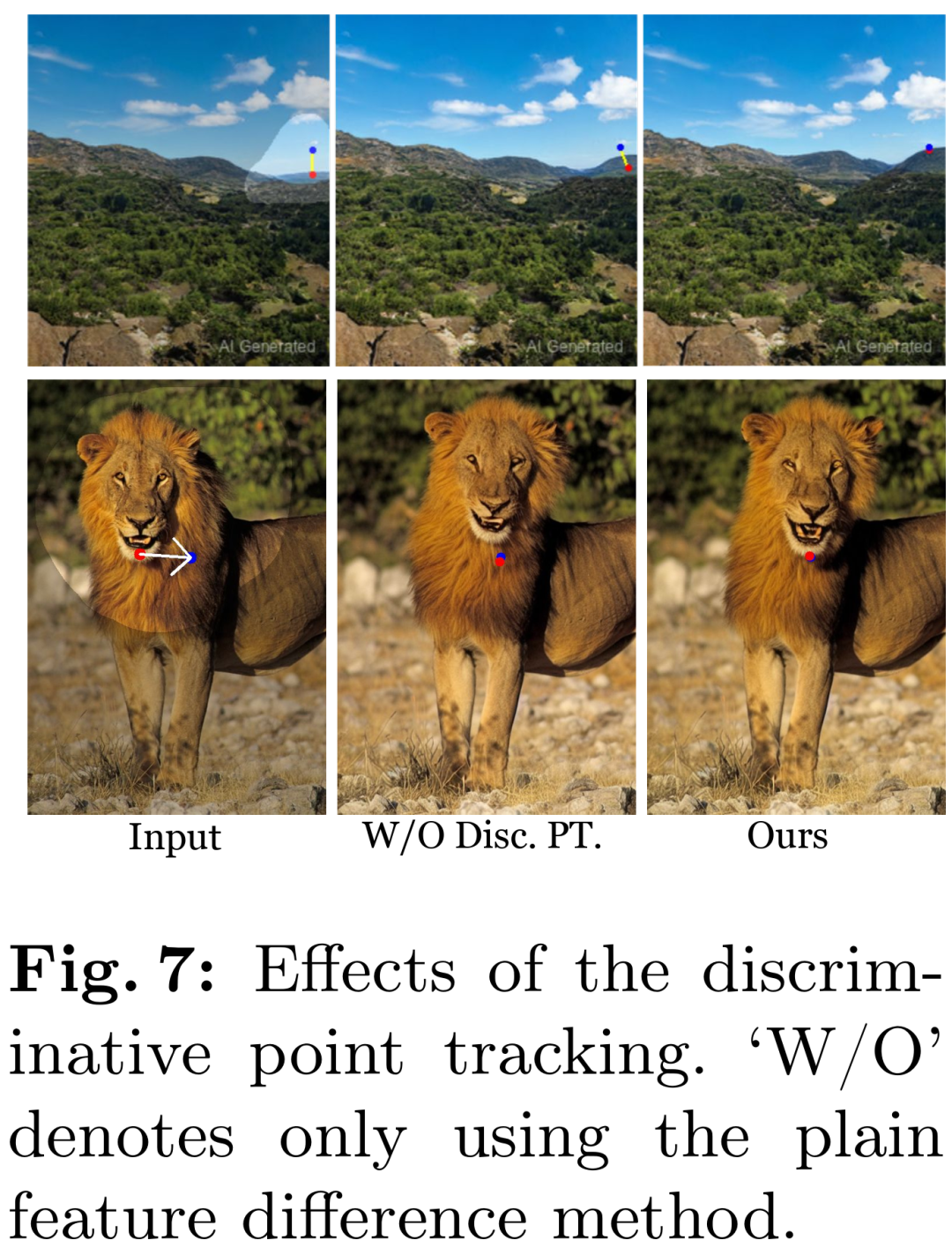

其次是判別點跟蹤。圖 7 和表 2 評估了 StableDrag 和沒有判別跟蹤模型的 StableDrag。我們可以看到,沒有判別跟蹤模型的 StableDrag 可能會受到背景干擾點的誤導(dǎo),導(dǎo)致結(jié)果不準(zhǔn)確。

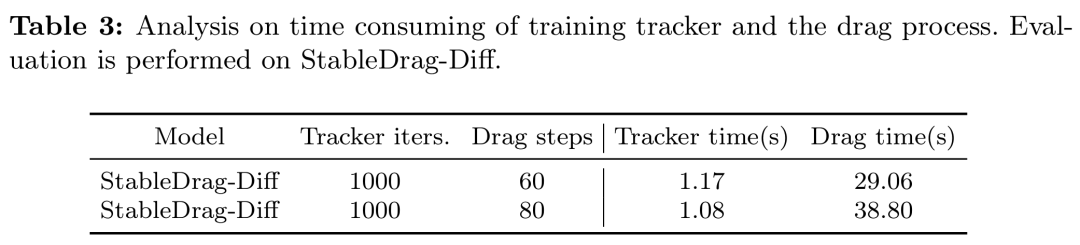

最后是跟蹤模塊的實用性。該研究提出的點跟蹤器在公式和實現(xiàn)上都很簡潔。如表 3 所示訓(xùn)練跟蹤器(大約僅 1 秒)花費的時間遠(yuǎn)少于拖拽過程。

更多技術(shù)細(xì)節(jié)和實驗結(jié)果請參閱原論文。