全網最詳細的AI大事記!

1942年,美國科幻小說家艾薩克·阿西莫夫(Isaac Asimov)在自己的短篇小說《Runaround(環舞)》中提出了影響深遠的“機器人三定律”:機器人不得傷害人類,或坐視人類受到傷害;除非違背第一定律,否則機器人必須服從人類命令;除非違背第一或第二定律,否則機器人必須保護自己。后來,這篇小說被合入1950年出版的短篇科幻小說集《I,Robot(我,機器人)》中。

1943年,美國神經生理學家沃倫·麥卡洛克(Warren McCulloch)和數學家沃爾特·皮茨(Walter Pitts),基于人類大腦的神經網絡,發表了《A logical calculus of ideas immanent in nervous activity(神經活動中內在思想的邏輯演算)》論文,提出了一個形式神經元的計算機模型,并將其取名為M-P(McCulloch&Pitts)模型。

1949年,唐納德·赫布(Donald O. Hebb)在自己的著作《The Organization of Behavior; a Neuropsychological Theory(行為的組織:一種神經心理學理論)》中,描述了突觸可塑性的基本原理,對學習和記憶提供了生理學層面的新理解。赫布也憑此被譽為“神經心理學與神經網絡之父”。

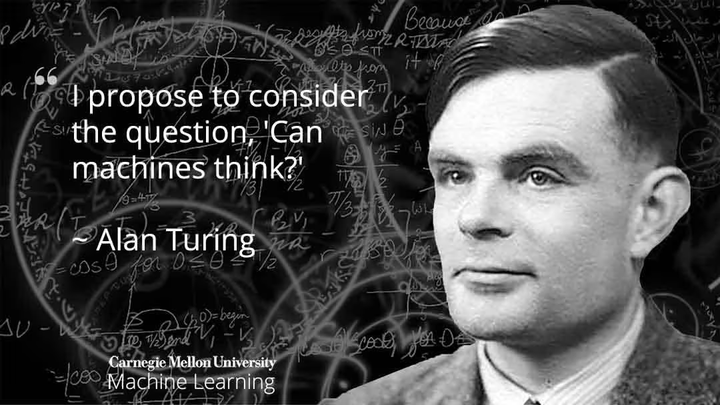

1950年,阿蘭·圖靈在《Mind(心靈)》雜志上發表了重要論文《Computing Machinery and Intelligence(計算機器與智能)》,并提出了著名的圖靈測試。

阿蘭·圖靈

1950年,馬文·明斯基(Marvin Minsky)和鄧恩·埃德蒙(Dunn Edmund)構建了第一臺神經網絡計算機SNARC。

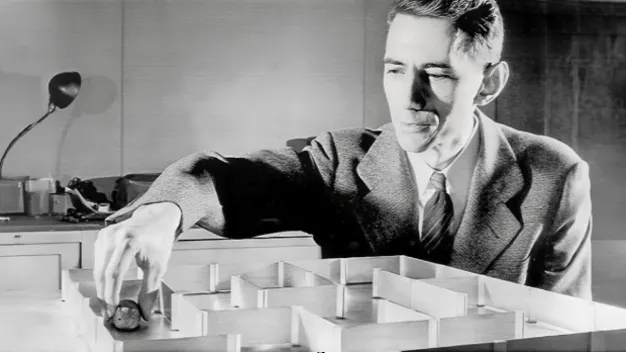

1950年,克勞德·香農(Claude Shannon)發表論文《Programming a computer for playing chess(為下棋編程計算機)》”。香農認為,總有一天,計算機會擊敗世界冠軍。這一年,他還發明了一種由機電繼電器電路控制的可以走迷宮的機械老鼠——忒修斯(Theseus)。

克勞德·香農

1954年,Georgetown(喬治敦)大學和IBM合作,進行了一次名為“Georgetown Experiment”的實驗,成功地使用機器將60多個俄語句子翻譯成英文。這是機器翻譯和NLP(自然語言處理)的一次重要嘗試。

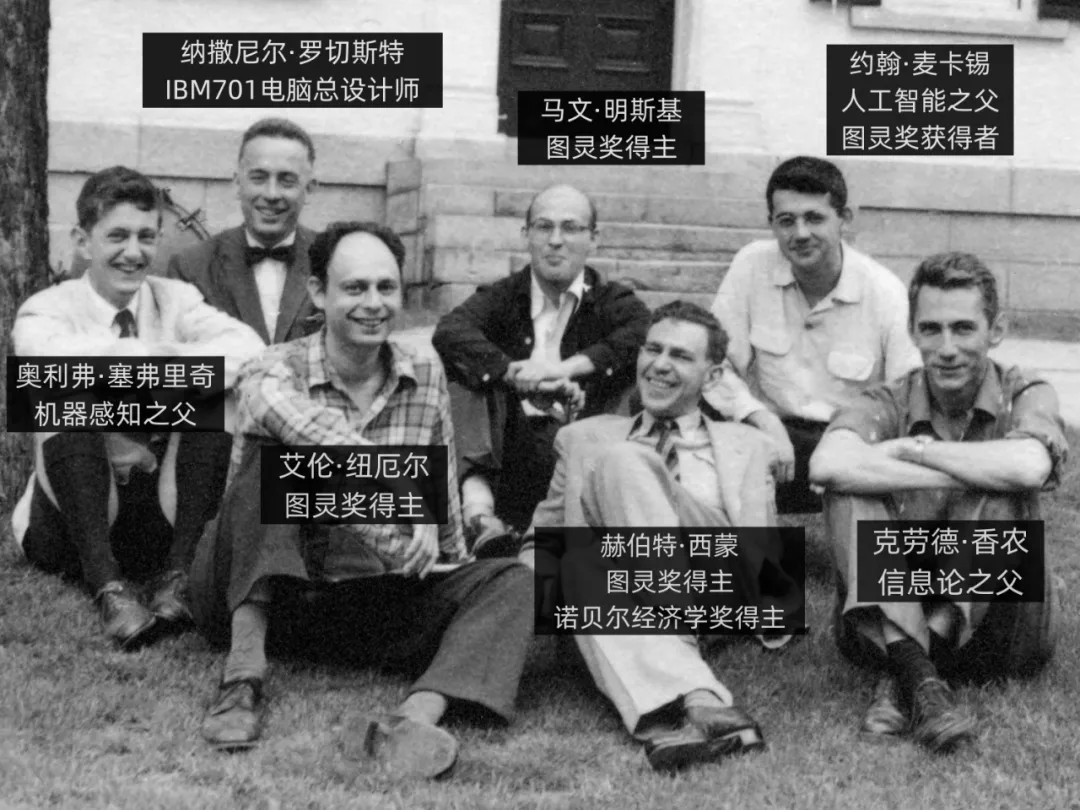

1955年9月,約翰·麥卡錫(John McCarthy)、馬文·明斯基、克勞德·香農、納撒尼爾·羅切斯特(N. Rochester)四人,共同提出了一個關于機器智能的研究項目。在項目中,首次引入了“Artificial Intelligence”這個詞,也就是人工智能。

1955年,赫伯特·西蒙(Herbert A. Simon,也譯為司馬賀)和艾倫·紐維爾(Allen Newell)開發的一個名為“邏輯理論家(Logic Theorist)”的程序。“邏輯理論家”被認為是人類歷史上第一個人工智能程序。

1956年6月,在約翰·麥卡錫等人的召集下,著名的達特茅斯會議(Dartmouth workshop)在美國新罕布什爾州漢諾威鎮的達特茅斯學院召開。這場會議標志著人工智能作為一個研究領域正式誕生。

圖片

圖片

1957年,美國康奈爾大學的心理學家和計算機科學家弗蘭克·羅森布拉特(Frank Rosenblatt),在一臺IBM-704計算機上,模擬實現了一種他發明的叫“感知機 (Perceptron) ”的神經網絡模型。

弗蘭克·羅森布拉特

1957年,赫伯特·西蒙等人在“邏輯理論家”的基礎上,又推出了通用問題解決器(General Problem Solver,GPS)。這是一個旨在模仿人類解決問題的程序。

1957年,卡內基梅隆大學建立了世界上第一個人工智能研究實驗室。

1958年,約翰·麥卡錫正式發布了自己開發的人工智能編程語言——LISP(LIST PROCESSING,意思是"表處理")。后來的很多知名AI程序,都是基于LISP開發的。

約翰·麥卡錫(1927-2011)

1959年,美國發明家喬治·德沃爾(George Devol)與約瑟夫·英格伯格(Joseph Engelberger)發明了人類首臺工業機器人——Unimate。Unimate重達兩噸,安裝運行于通用汽車生產線,可以控制一個機械臂,搬運和堆疊熱壓鑄金屬件。

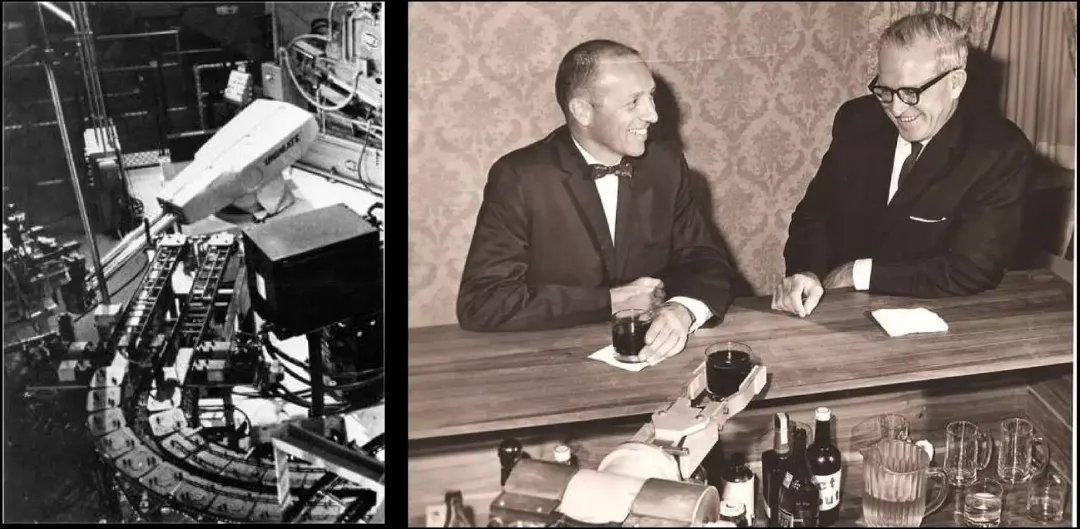

左圖為Unimate

右圖是約瑟夫·英格伯格(左)、喬治·德沃爾(右)

1959年,赫伯特·格蘭特(Herbert Gelernter)開發了幾何定理證明程序。

1959年,IBM科學家亞瑟·塞繆爾(Arthur Samuel)在自家首臺商用計算機IBM701上,成功編寫了一套西洋跳棋程序。這個程序具有“學習能力”,可以通過對大量棋局的分析,逐漸辨識出“好棋”和“壞棋”,從而提高自己的下棋水平。因為首次提出了“機器學習(Machine Learning)”的概念,亞瑟·塞繆爾被后人譽為“機器學習之父”。

亞瑟·塞繆爾(1901-1990)

1959年,約翰·麥卡錫和馬文·明斯基創立了麻省理工學院人工智能項目。

1961年,萊昂納德·莫里克(Leonard Merrick Uhr)和查爾斯·沃斯勒(Charles M Vossler)發表了題目為《A Pattern Recognition Program That Generates, Evaluates and Adjusts its Own Operators(生成、評估和調整其自身算子的模式識別程序)》的模式識別論文,描述了一種利用機器學習或自組織過程設計的模式識別程序的嘗試。

1963年,約翰·麥卡錫在斯坦福大學創立了人工智能實驗室。

1965年,英國數學家厄文·古德(Irving John Good)發表了一篇對人工智能未來可能對人類構成威脅的文章,可以算“AI威脅論”的先驅。

1966年,美國麻省理工學院的約瑟夫·魏澤鮑姆(Joseph Weizenbaum),發明了世界上第一個聊天機器人——ELIZA。ELIZA 通過關鍵詞匹配規則對輸入進行分解,而后根據分解規則所對應的重組規則來生成回復,是現在Siri、小愛同學等問答交互工具的鼻祖。

魏澤鮑姆(坐者)正在與ELIZA對話

1966年,查理·羅森(Charlie Rosen)領導的美國斯坦福研究所(SRI),研發成功了首臺人工智能機器人——Shakey。它具備一定程度的人工智能,能夠自主進行感知、環境建模、行為規劃并執行任務。

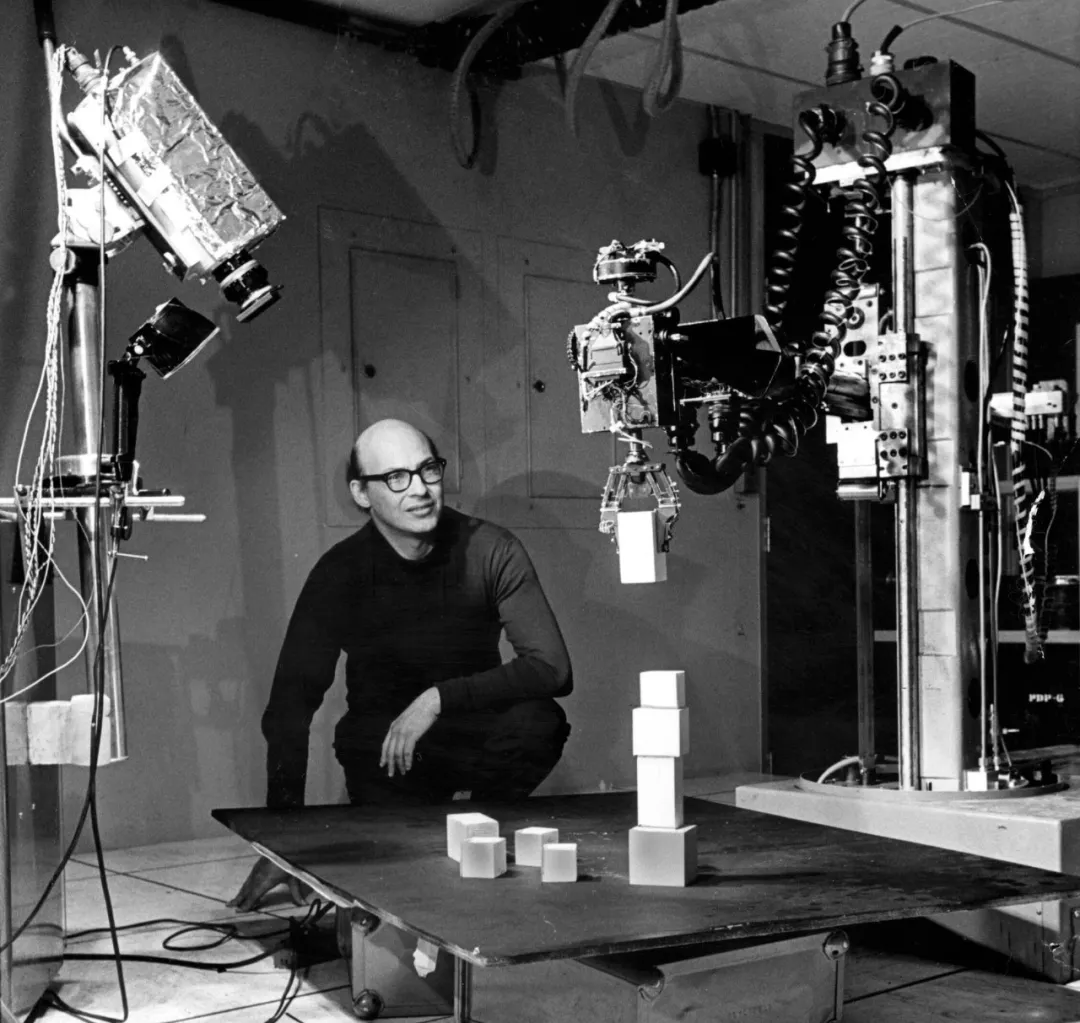

研究人員正在調測Shakey

1966年,美國計算機協會(ACM)設立圖靈獎(Turing Award),被稱為“計算機界的諾貝爾獎”。

1967年,托馬斯·卡沃(Thomas Cover)基于艾沃林·菲克斯(Evelyn Fix)和約瑟夫·霍德吉斯(Joseph Hodges)的研究,擴展提出了K最近鄰算法(k-nearest neighbors algorithm)。

1968年,美國科學家愛德華·費根鮑姆(Edward Feigenbaum)提出了第一個專家系統——DENDRAL,并對知識庫給出了初步的定義。這標志著專家系統的誕生。DENDRAL面向的是化學行業,可以幫助化學家判斷物質的分子結構。

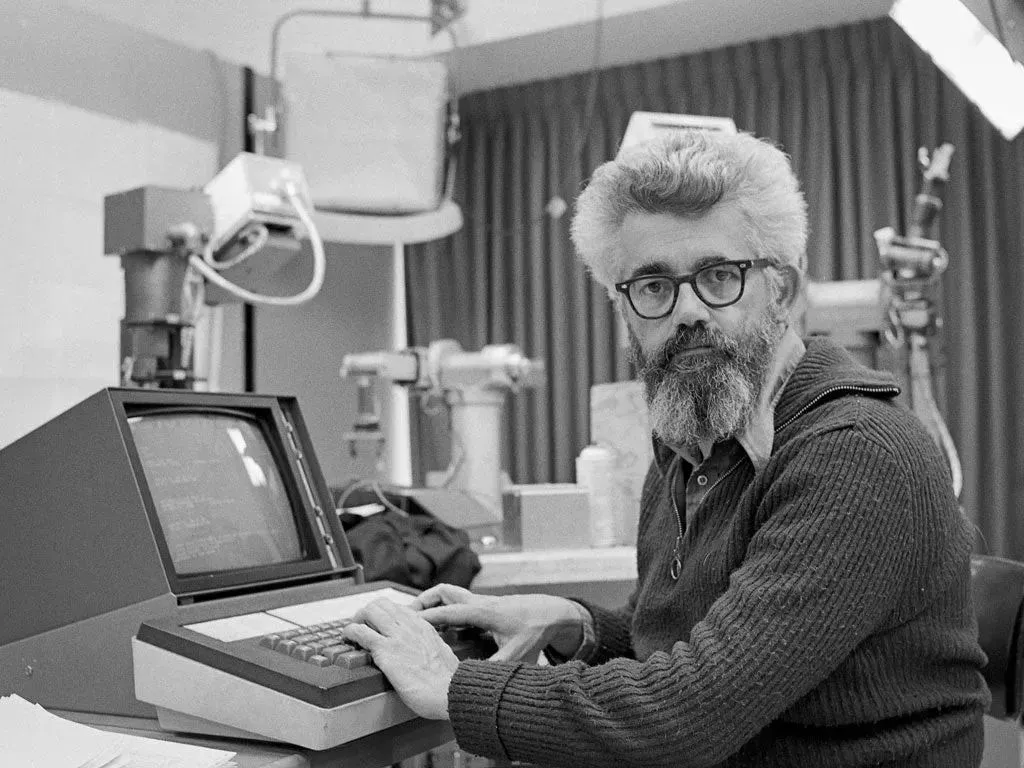

愛德華·費根鮑姆(坐著的那位)

1969年,馬文·明斯基和西蒙·派珀特(Seymour Papert)發表著作《感知機: 計算幾何學導論》的書,對羅森布萊特的感知器提出了質疑。這導致了神經網絡研究十余年的中斷。

馬文·明斯基

1969年,馬文·明斯基為導演斯坦利·庫布里克(Stanley Kubrick)的電影《2001漫游太空》擔任顧問,塑造了片中超級智能計算機HAL9000的銀幕形象。

電影海報

1970年,麻省理工學院博士研究生特里·維諾格拉德(Terry Winograd)開發了早期自然語言理解程序SHRDLU。該程序可以部分理解語言,是"微型世界"項目的一部分。

1972年,柯爾麥倫納(Colmeraner)及其研究小組在法國馬賽大學提出邏輯編程語言PROLOG。

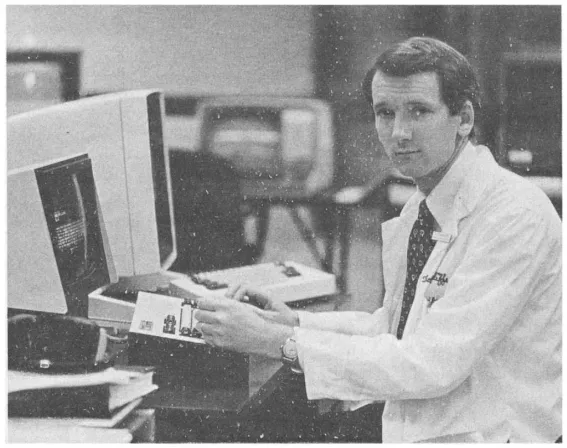

1972年,美國醫生兼科學家愛德華·H·肖特利夫(Edward H. Shortliffe)創建了可以幫助進行醫學診斷的專家系統——MYCIN。

愛德華·H·肖特利夫

1973年,政府部門對AI的資助開始大幅滑坡,AI研究進入了“AI寒冬(AI Winter)”。

1973年,數學家萊特希爾(Lighthill)向英國政府提交了一份關于人工智能的研究報告(著名的《萊特希爾報告》),對當時的AI研究進行了嚴厲且猛烈的批評,認為其宏偉的目標根本無法實現,研究已經徹底失敗。

1975年,馬文·明斯基在論文《A Framework for Representing Knowledge(知識表示的框架)》中,提出用于人工智能中的知識表示學習框架理論。

1977年,愛德華·費根鮑姆在第五屆國際人工智能聯合會議上,提出了“知識工程(Knowledge Engineering)”的概念,進一步推動了專家系統的普及。

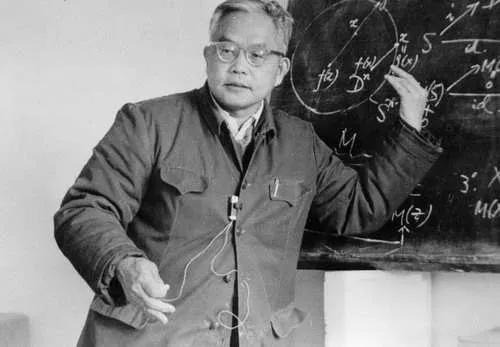

1977年,中國著名數學家吳文俊院士在《中國科學》期刊發表了具有劃時代意義的科學論文——《初等幾何判定問題與機械化證明》,在國際上引起了巨大轟動。吳文俊院士所獨創的新方法在國際上被譽為“吳方法”。它能夠使人工智能自動并有效地證明幾何定理,也被應用到其他數學領域。

吳文俊院士

1979年,美國國家標準技術研究所開始制定基于知識的推理系統規范語言(知識表示語言KRL)。

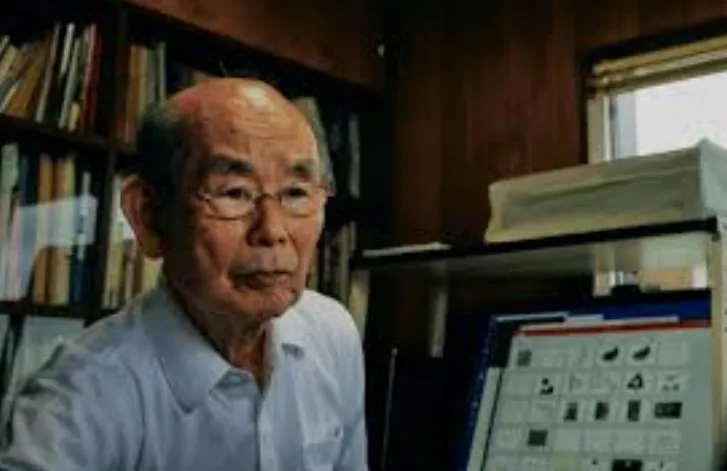

1979年,日本學者福島邦彥博士模仿生物的視覺皮層(visual cortex),開發了一種用于模式識別的神經網絡模型Neocognitron(神經認知機)。Neocognitron是第一個使用卷積和下采樣的神經網絡,也是現代卷積神經網絡的雛形。

福島邦彥

1979年,斯坦福大學的漢斯·莫拉韋克(Hans Moravec)設計了斯坦福卡車(Stanford Cart)。這是一臺可以自主導航和避障的機器人。這是機器人領域的一個重要里程碑。

1980年,在美國的卡內基梅隆大學(CMU)召開了第一屆機器學習國際研討會,標志著機器學習研究的興起。

1980年,卡耐基梅隆大學研發的專家系統XCON(eXpertCONfigurer)正式商用,為當時的計算機巨頭公司DEC每年省下數千萬美金。

1981年,理查德·保羅(Richard.P.Paul)出版了第一本機器人學課本《Robot Manipulator:Mathematics,Programmings and Control(機器人機械手:數學、編程與控制)》。

1981年,日本通商產業省(MITI)撥款8.5億美元,用以研發第五代計算機項目(FGCS)。FGCS的目標是造出一臺人工智能計算機,能夠與人對話、翻譯語言、解釋圖像、完成推理。不久后,英國、美國紛紛響應,開始向信息技術領域的研究提供大量資金。

1981年,“窄AI(Narrow AI)”的概念誕生。相關研究不再尋求通用智能,而轉向了面向更小范圍的專業任務領域。

1982年,約翰·霍普菲爾德(John Hopfield)在自己的論文中重點介紹了Hopfield網絡模型(模型原型早期由其他科學家提出)。這是一種具有記憶和優化功能的循環(遞歸)神經網絡。

約翰·霍普菲爾德

1982年,戴維·馬爾(David Marr)發表代表作《視覺計算理論》,提出計算機視覺(Computer Vision)的概念,并構建系統的視覺理論,對認知科學(CognitiveScience)產生了很深遠的影響。

1983年,通用電氣公司搞出了柴油電力機車維修專家系統(DELTA)。這個系統封裝了眾多GE資深現場服務工程師的知識和經驗,能夠指導員工進行故障檢修和維護。

1983年,特倫斯·謝諾夫斯基(Terrence Sejnowski)和杰弗里·辛頓(Geoffrey Hinton)提出了“隱單元”的概念。1986年,他們提出了一種生成式隨機神經網絡(generative stochastic neural network)——Boltzmann Machine(玻爾茲曼機)。

1983年,美國國防部高級研究計劃局(DARPA)通過“戰略計算促進會(Strategic Computing Initiative)”,重啟對高級計算和人工智能研究的資助。

1984年,美國數十家大公司聯合成立了微電子與計算機技術公司(MCC)。該公司發起了人工智能歷史上最大也是最具爭議性的項目Cyc(大百科全書)。

1986年,戴維·魯梅爾哈特(David Rumelhart)、杰弗里·辛頓(Geoffrey Hinton)和羅納德·威廉姆斯(Ronald Williams)等人共同發表了一篇名為《Learning representations by back-propagation errors(通過反向傳播算法的學習表征)》的論文。在論文中,他們提出了一種適用于多層感知器(MLP)的算法,叫做反向傳播算法(Backpropagation,簡稱BP算法)。BP算法不僅為多層神經網絡的發展奠定了基礎,也打破了馬文·明斯基當年提出的“神經網絡具有局限性”魔咒,意義非常重大。

1986年,澳大利亞計算機科學家羅斯·昆蘭(Ross Quinlan)提出ID3決策樹算法。

1987年,LISP機器市場在崩潰,AI領域進入了“第二個AI冬天”。

LISP系列主機

1988年:計算機科學家和哲學家猶大·伯爾(Judea Pearl)出版了著作《Probabilistic Reasoning in Intelligent Systems(智能系統中的概率推理)》。伯爾還發明了貝葉斯網絡。

1988年,貝爾實驗室的法國科學家楊立昆(Yann LeCun)等人,提出了卷積神經網絡。這是一種專門用于處理圖像數據的神經網絡模型。

Yann LeCun

1990年,澳大利亞科學家羅德尼·布魯克斯(Rodney Brooks)提出了“由下自上”的研究思路,開發能夠模擬人腦細胞運作方式的神經網絡,并學習新的行為。

1990年,美國認知科學家、心理語言學家杰弗里·艾爾曼(Jeffrey Elman)提出了首個遞歸神經網絡——艾爾曼網絡模型。遞歸神經網絡能夠在訓練時維持數據本身的先后順序性質,非常適合于自然語言處理領域的應用。

1992年,因為未能實現十年前提出的目標,日本終止了FGCS項目。

1993年,在花費近10億美元且遠未達到預期的情況下,DARPA結束了戰略計算計劃。

1995年,克里娜·柯爾特斯(Corinna Cortes)和弗拉基米爾·萬普尼克(Vladimir Vapnik)開發了支持向量機(Support Vector Machine,SVM)。支持向量機是一種映射和識別類似數據的系統,可以視為在感知機基礎上的改進。

1995年,約阿夫·佛羅因德(Yoav Freund)和羅伯特·沙皮爾(Robert Schapire)提出了AdaBoost (Adaptive Boosting)算法。

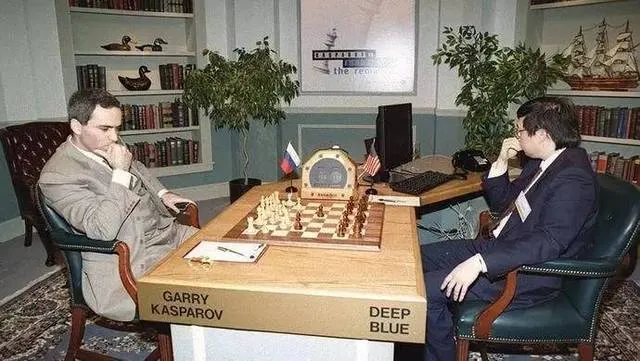

1997年5月,IBM的計算機“深藍(DEEP BLUE)”以2勝1負3平的成績擊敗國際象棋世界冠軍加里·卡斯帕羅夫,震驚了全世界。

1997年,德國計算機科學家瑟普·霍克賴特(Sepp Hochreiter)及其導師于爾根·施密德胡伯(Jürgen Schmidhuber)開發了用于遞歸神經網絡的LSTM(長短期記憶網絡)。

1998年,Yann LeCun等人提出了一個用于手寫數字識別的卷積神經網絡——LeNet,初步展示了神經網絡在圖像識別領域的潛力。

2000年:本田發布了ASIMO,一種人工智能的人形機器人。

2001年,布雷曼(Leo Breiman)和阿黛爾·卡特勒(Adele Cutler)提出隨機森林(Random Forest)。

2003年,約書亞·班吉歐(Yoshua Bengio)發表一篇基于人工神經網絡打造自然語言模型的論文《A Neural Probabilistic Language Model(一種神經概率語言模型)》,提出了具有奠基意義的NNLM“神經網絡語言模型”。他還提出了"詞向量"的概念。

2006年,多倫多大學的杰弗里·辛頓在Science期刊上,發表了重要的論文《Reducing the dimensionality of data with neural networks(用神經網絡降低數據維數)》,提出深度信念網絡(Deep Belief Networks,DBNs)。

杰弗里·辛頓

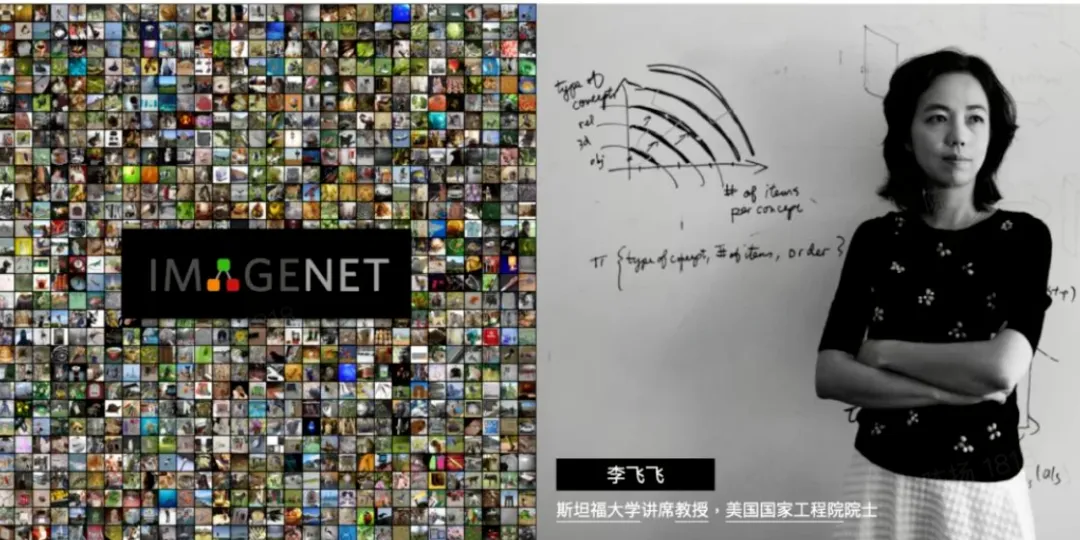

2006年,在斯坦福任教的華裔科學家李飛飛發起創建了ImageNet項目,號召民眾上傳圖像并標注圖像內容。2009年,ImageNet正式發布,包括了1400萬張圖片數據,超過2萬個類別,為全球AI研究(神經網絡訓練)提供了強大支持。

李飛飛和ImageNet

2006年,谷歌公司推出了一種基于統計學習的語音識別技術,該技術被廣泛應用于語音助手、智能家居等領域。

2008年,谷歌在iPhone上發布了一款語音識別應用,開啟了數字化語音助手(Siri、Alexa、Cortana)的浪潮。

2011年10月,蘋果推出語音助手Siri。

2011年,IBM的計算機沃森(Watson)在美國電視智力競賽節目“危險邊緣”中,擊敗兩位人類冠軍選手,展示出其在自然語言處理和知識推理方面的強大能力。

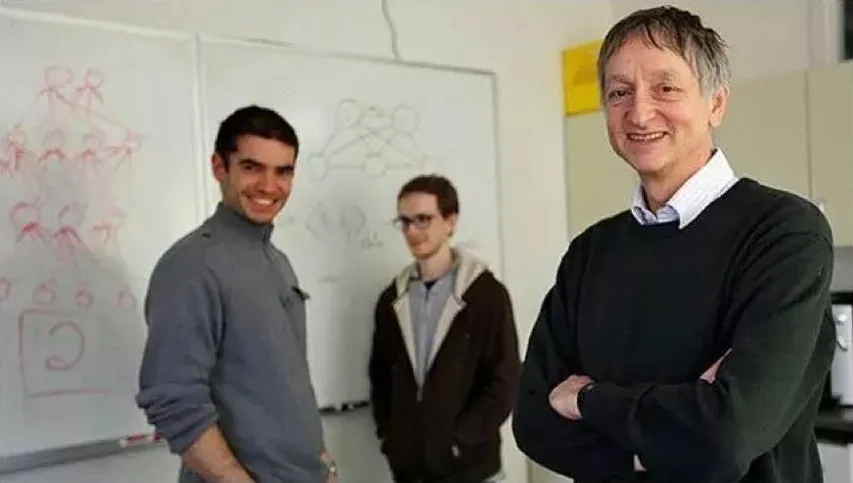

2012年,杰弗里·辛頓和他的學生伊利亞·蘇茨克沃(Ilya Sutskever)和亞歷克斯·克里切夫斯基(Alex Krizhevsky)參加了ImageNet大規模視覺識別挑戰賽。他們設計的深度神經網絡模型AlexNet在這次競賽中以壓倒性優勢獲得第一名,引起了業界轟動。

杰弗里·辛頓師徒三人

2012年,加拿大神經學家團隊創造了一個具備簡單認知能力、有250萬個模擬“神經元”的虛擬大腦Spaun,通過了最基本的智商測試。

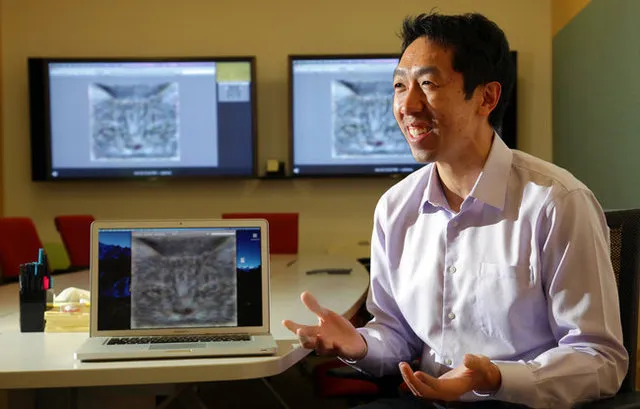

2012年,谷歌“Google Brain”項目的研究人員吳恩達(Andrew Ng)、杰夫·迪恩(Jeff Dean)等人,搭建了一個神經網絡(10億參數),用來訓練對貓的識別。他們的訓練數據是來自youtube的1000萬個貓臉圖片,用了1.6萬個CPU,整整訓練了3天。

吳恩達

2012年7月,谷歌公司推出虛擬助手GoogleNow,即谷歌助手的前身。

2012年,谷歌公司正式發布谷歌知識圖譜Google Knowledge Graph。

2013年,辛頓師徒三人共同成立了一家名為DNNresearch的公司。后來,這家公司被谷歌以幾千萬美元的價格競購。

2013年,谷歌公司的托馬斯·米科洛夫(Tomas Mikolov)帶領研究團隊發表了論文《Efficient Estimation of Word Representations inVector Space(詞表示向量空間的有效估計)》,提出了Word2Vec。Word2Vec基于給定的語料庫,通過優化后的訓練模型,可以快速有效地將一個詞語表達成高維空間里的詞向量形式,為自然語言處理領域的應用研究提供了新的工具。

2014年,谷歌公司收購了專注于深度學習和強化學習技術的人工智能公司——DeepMind公司。

2014年6月,一臺名為Eugene Goostman(尤金·古斯特曼)的聊天機器人通過了圖靈測試。

2014年,蒙特利爾大學博士生伊恩· 古德費洛(Ian Goodfellow),從博弈論中的“二人零和博弈”得到啟發,提出了生成對抗網絡(GANs,Generative Adversarial Networks)。

伊恩· 古德費洛

2015年,Microsoft Research的何愷明(Kaiming He)等人提出的殘差網絡(ResNet),在ImageNet大規模視覺識別競賽中,獲得了圖像分類和物體識別的優勝。

2015年1月,埃隆·馬斯克、斯蒂芬·霍金和史蒂夫·沃茲尼亞克等人在一封公開信上簽名,要求禁止開發人工智能武器。

2015年11月,谷歌公司開源了重要的深度學習框架Tensor Flow。

2015年12月,埃隆·馬斯克(Elon Musk)、薩姆·奧爾特曼(Sam Altman)、彼得·泰爾(Peter Thiel)、里德·霍夫曼(Reid Hoffman)等人在舊金山聯合成立了OpenAI公司。

2016年,谷歌提出聯邦學習方法,它在多個持有本地數據樣本的分散式邊緣設備或服務器上訓練算法,而不交換其數據樣本。

2016年3月,DeepMind開發的人工智能圍棋程序AlphaGo(阿爾法狗),以4:1的總比分戰勝了世界圍棋冠軍李世石,震驚了全世界。

2016年2月,中國香港的漢森機器人公司(Hanson Robotics)推出了一款名為索菲亞(Sophia)的仿人機器人。它能通過圖像識別“看”東西,做出面部表情,并能使用人工智能進行交流。

2016年,微軟公司推出了小冰(Xiaoice)。這是一款利用自然語言處理和情感計算技術提供社交聊天服務的人工智能系統。

2017年1月,Facebook人工智能研究院開源了PyTorch。這是一個用于機器學習和深度學習的開源深度學習框架。

2017年5月,升級版的AlphaGo以3:0戰勝世界排名第一的中國圍棋棋手柯潔。

2017年10月18日,DeepMind團隊公布AlphaGo Zero。從空白狀態學起,只需3天就以100:0的戰績擊敗曾戰勝柯潔的AlphaGo系統。

2017年12月,Google機器翻譯團隊在行業頂級會議NIPS上,發表了重磅論文《Attention is all you need(你所需要的,就是注意力)》,提出只使用“自我注意力(Self Attention)”機制來訓練自然語言模型——Transformer(轉換器、變壓器)。Transformer徹底改變了深度學習的發展方向。它不僅對序列到序列任務、機器翻譯和其它自然語言處理任務產生了深遠的影響,也為后來AIGC的崛起打下了堅實的基礎。

2018年5月,谷歌推出Google Duplex服務,允許人工智能助手通過電話預約。

2018年6月,OpenAI發布了第一版的GPT系列模型——GPT-1。同時,他們還發表了論文《Improving Language Understanding by Generative Pre-training(通過生成式預訓練改進語言理解)》。2019年和2020年,OpenAI接連發布了GPT-2和GPT-3。

2018年10月,谷歌發布了有3億參數的BERT(Bidirectional Encoder Representation from Transformers)模型,意思是“來自Transformers的雙向編碼表示”模型。

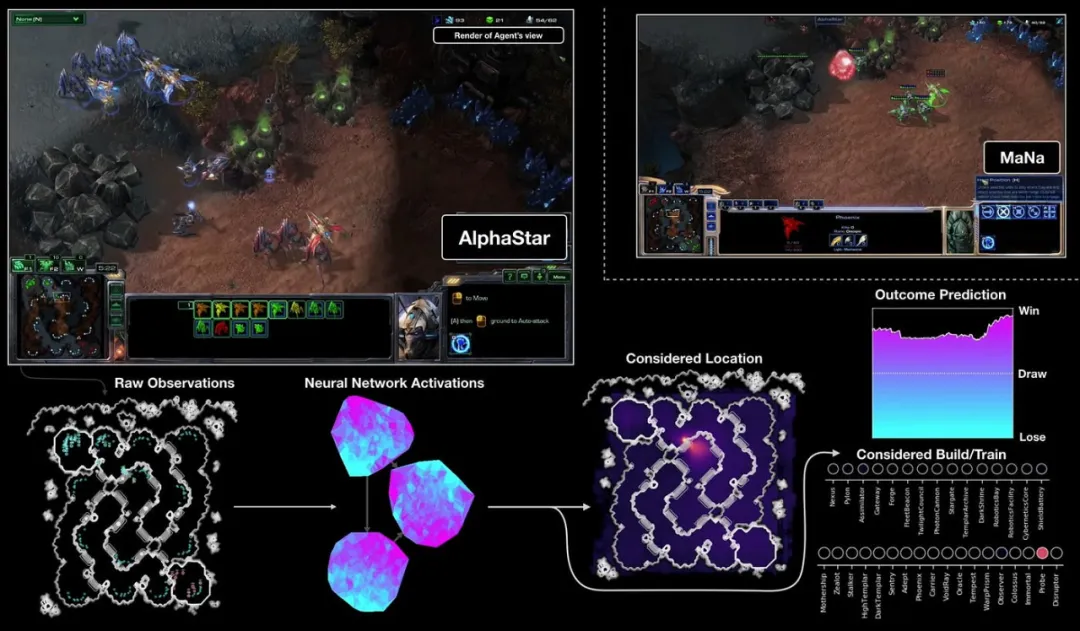

2019年,DeepMind公司開發了阿爾法星際爭霸(AlphaStar),這是一臺專門用于玩星際爭霸2游戲的人工智能系統。

2019年3月份,OpenAI正式宣布重組,成為一家"利潤上限(caped-profit)"的公司。7月,重組后的OpenAI拿到了微軟包括Azure云計算資源在內的10億美金投資。微軟將作為"首選合作伙伴”,今后可獲得OpenAI技術成果的獨家授權。

2020年2月,微軟推出Turind Natural Language Generatio(T-NLG),這是一種生成式語言模型,是當時最大的語言模型。

2020年6月,OpenAl發布了GPT-3語言模型。該模型通過預先訓練的算法生成文本,并完成人類幾乎無法完成的語言任務。隨后,OpenAI發表了論文《Language Models are Few-Shot Learner》,闡述了大模型的各種新能力,而最重要的就是小樣本(few-shot)學習能力。

2020年6月,論文《Denoising Diffusion Probabilistic Models(去噪擴散概率模型,DDPM)》發表。這篇論文第一次把2015年誕生的Diffusion"擴散模型"用在了圖像生成上。不久之后,DDPM以及后續的Diffusion擴散模型就全面取代了GAN(生成式對抗網絡),成為了AI繪畫大模型的主流技術。

2020年11月30日,DeepMind公司宣布其研制的人工智能系統AlphaFold2可以精準預測蛋白質的3D結構,即解決了“蛋白質折疊”問題,被認為是解決了生物領域50年來的重要難題,是人工智能的又一次巨大成功。

2021年1月,OpenAl發布了可從文本生成圖像的人工智能模型DALL-E。

2021年1月11日,谷歌公司發表論文《Switch Transformers:Scaling to Trillion Parameter Models with Simple and Efficient Sparsity》,提出了最新語言模型—Switch Transformer。這個模型以高達1.6萬億的參數量,成為歷史上首個萬億級語言模型。

2021年2月,Open AI開源了新的深度學習模型CLIP(Contrastive Language-Image Pre-Training)。同時,OpenAI還發布了自己基于CLIP的AI繪畫DALL-E 模型。

2021年6月30日,OpenAI和GitHub聯合發布了AI代碼補全工具GitHub Copilot。Copilot的AI技術核心正是OpenAI的新模型CodeX(隨后的8月份也對外發布了)。

2021年5月,谷歌公司引入了Language Model for Dialoque Applications(LaMDA)。這是一個大型語言模型,用于在對話中生成類似人類的反應。

2021年10月,第一個開源的AI繪畫大模型Disco-Diffusion誕生。

2022年3月,OpenAI發布InstructGPT,同時發表論文《Training language models to follow instructions with human feedback(訓練語言模型以遵循帶有人類反饋的指令)》。

2022年3月,AI繪畫工具Midjourney問世,創始人是David Holz(戴維·霍爾茲)。

2022年4月,OpenAI發布了AI繪畫大模型DALL-E 2。

2022年7月,DeepMind破解了幾乎所有已知的蛋白質結構,其AlphaFold算法數據庫里包含了2億種已知蛋白質結構。

2022年8月,Stability AI開源了Stable Diffusion繪畫大模型的源代碼。這是一款基于文本描述生成圖像的文本到圖像工具。

2022年11月,OpenAI發布了基于GPT模型的人工智能對話應用服務——ChatGPT(也可以理解為GPT-3.5),徹底引爆了全世界。

2023年1月,微軟宣布對OpenAl進行多年期巨額投資,數十億美元。

2023年2月7日,谷歌公司發布了由LaMDA提供支持的聊天機器人Bard。

2023年2月25日,Meta公司發布LLaMA模型并開源。7月19日,Meta公司發布了人工智能模型LLaMA 2的開源商用版本。

2023年3月15日,OpenAI發布了GPT-4。

2023年3月16日,百度發布文心一言。

2023年5月11日,谷歌正式開放超級AI大模型PaLM2。

2023年6月,英偉達市值突破1萬億美元。美股“七巨頭”(Magnificent 7,分別是:谷歌母公司Alphabet、亞馬遜、蘋果、Meta、微軟、英偉達和特斯拉)的股價開始不斷攀升。

2023年11月,首份人工智能監管聲明《布萊切利宣言》發布。

2023年11月18日,OpenAI CEO山姆·奧特曼(Sam Altman)被開除,引發全網關注。22日,OpenAI官方推特宣布,Sam Altman回歸并重新擔任OpenAI CEO。

2023年12月6日,谷歌公司發布多模態大模型Gemini 1.0(雙子星)。

2024年2月15日,OpenAI發布人工智能文生視頻大模型Sora。

2024年5月14日,OpenAI舉行春季發布會,推出新旗艦模型GPT-4o。

2024年7月23日,Meta發布LLAMA 3.1 405B開源人工智能模型。

(截止日期:2024年7月29日)

參考文獻:

1、《人工智能簡史》,尼克;

2、《人工智能發展簡史》孫凌云、孟辰燁、李澤健;

3、《人工智能 60 年技術簡史》,李理;

4、《深度學習簡史》,Keith D. Foote;

5、《人工智能發展史(從起步到磅礴)以及浪潮階段》,CSDN;

6、《從零啟程——人工智能簡史》,知乎;

7、《四張圖片道清AI大模型的發展史》,阿里云;

8、《GPT的背后,從命運多舛到顛覆世界,人工神經網絡的跌宕80年》,孫睿晨;

9、百度百科、維基百科等。