87.8%準確率趕超GPT-4o登頂!谷歌DeepMind發布自動評估模型FLAMe

大語言模型都卷起來了,模型越做越大,token越來越多,輸出越來越長。

那么問題來了,如何有效地評估大語言模型的長篇大論呢?要是輸出長度長了但胡言亂語輸出質量差,又臭又長,豈不是白搭?

首先能想到的方法就是人工評估。人工評估雖然對于評價模型性能至關重要,但受到主觀性、評估者之間的差異性以及廣泛評估的高成本的限制。

考慮到這些因素,谷歌DeepMind研究團隊提出了自動評估解決方案FLAMe。

圖片

圖片

論文地址:https://arxiv.org/abs/2407.10817

模型本身在經歷多輪大規模指令任務調整后,可以遵循一套新的指令,使它們適合用作模型輸出的自動評估器。

一方面,為了使LLM自動評分更加合理、準確并與人類偏好保持一致,對人類判斷的數據收集極其重要。

然而,獲得這些判斷數據既昂貴又耗時。從以前的研究中收集現有的人類評估貌似可行,但面臨著缺乏標準、文檔數據不充分、數據隱私和專有權等問題。

另一方面,直接使用模型輸出進行自動評分器訓練可提供一致性,但也存在風險,包括強化偏見和幻覺。

此外,它可能違反專有LLM服務的使用條款,條款禁止使用其模型的輸出來開發競爭模型。

為了解決這些限制和顯著降低成本,谷歌引入了一個用于自動評分的大型基礎模型系列----FLAMe。

FLAMe模型的主要優勢和貢獻是:

- 數據收集:僅使用獲得許可的數據集,并對人類評估結果進行標準化。共包含102個評估任務、530萬條人類評估意見。為了促進未來的研究,論文公開了所有數據集來源。

- LLM自動評分器:既包括使用多任務組合來訓練通用 LLM自動評分器 (FLAMe) ,也包括針對下游應用程序優化過的LLM 自動評分器 ( FLAMe-RM 和 FLAMe-Opt-RM)。

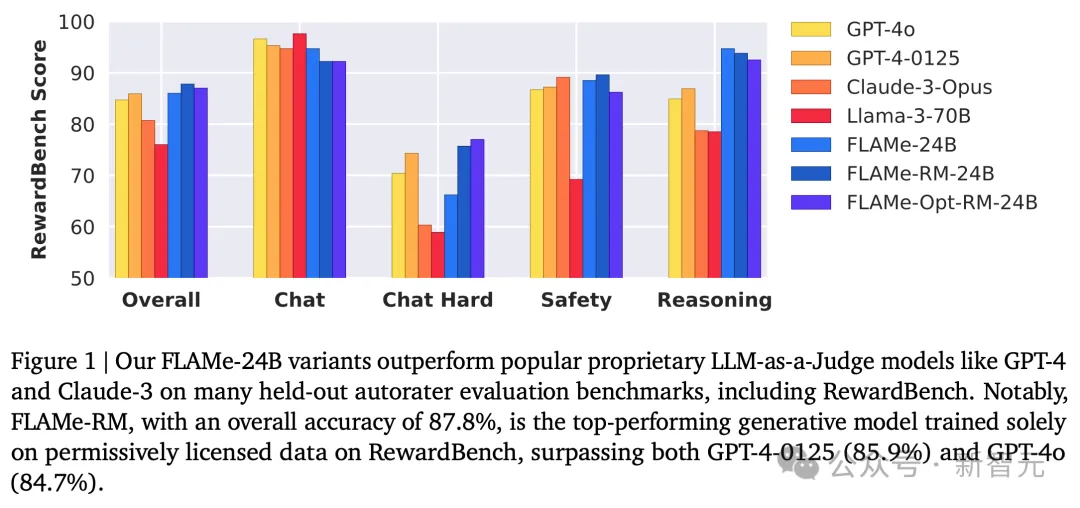

在12個自動評分器評估基準中的8個基準上,FLAMe及其變體的自動評分性能優于用專有數據訓練的GPT-4o、Gemini-1.5-Pro等模型。

- 計算高效的多任務訓練:引入了一種計算更為高效的方法,使用創新的微調策略來優化目標分布的多個任務,顯著減少計算量來實現更佳的性能。

自動評估方法

為了將人工評估的流程自動化,作者對LLM任務和評估標準進行了細致的定義。

數據收集

和領域內很多科技巨頭的做法形成鮮明對比的是,DeepMind這篇論文不僅披露了使用的數據集列表,而且從數據收集步驟開始,就堅持了幾個公認正確但很難做到的原則。

首先,為了論文的透明度和可復現,作者僅使用HuggingFace、TensorFlow這些平臺上的公共開源數據集,以及得到原作者許可的GitHub庫。

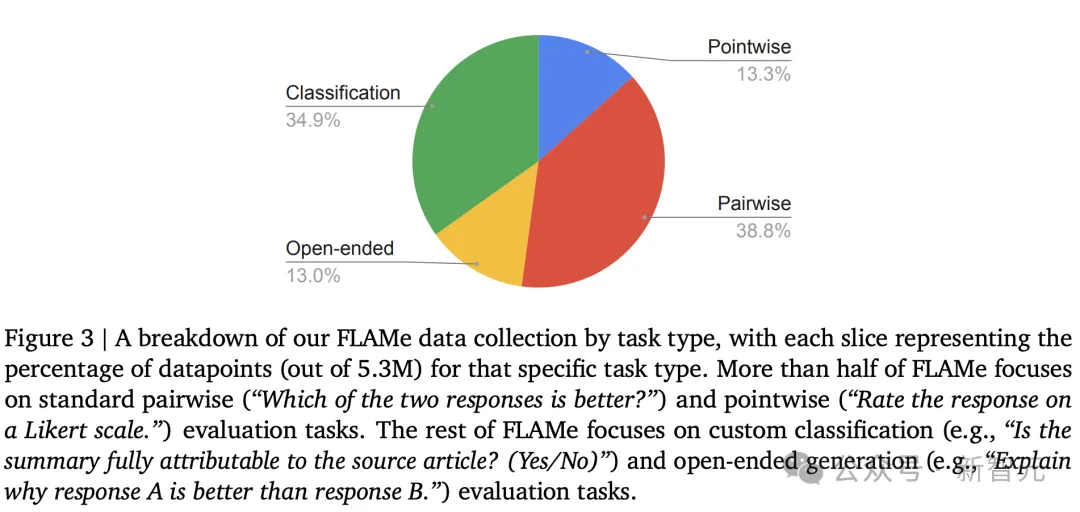

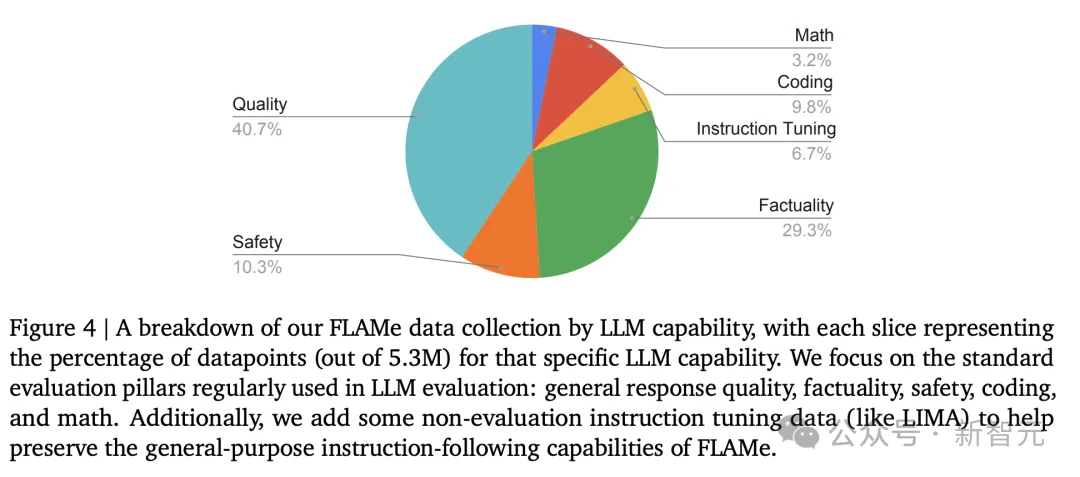

為了避免GPT-4等模型生成數據帶來的不準確性和潛在法律問題,作者只使用了帶有人工標注的數據集,并涵蓋了各種任務類型(圖3)和LLM能力(圖4)。

最終用于訓練的數據集含有102項評估任務、共530萬條經過標準化處理的人類評估意見。

圖片

圖片

任務類型主要包含以下四種:

- 成對評估(pairwise evaluation):比較兩個響應結果并確定偏好

- 逐點評估(pointwise evaluation):對單個響應結果的指定屬性進行打分

- 分類:將單個響應劃分為某個預定義類別,例如:模型輸出是否遵循說明?(是/否)

-開放式評估:自由形式、不受限制的評估結果

圖片

圖片

按照評估的LLM能力劃分數據集,則大致有6類能力:

- 一般響應質量:包括有用性、連貫性、流暢性、創造力、復雜性和冗長性等多個屬性,以及指令跟隨能力

- 事實性/內容出處:針對LLM應用中日益重要的幻覺問題,幾個數據集都用于評估響應輸出的事實準確性及其基礎,看模型提出的聲明是否有源文檔作為依據

- 數學推理:區分LLM生成數學解題方案的正確或錯誤

- 編碼:涵蓋Python、JavaScript、Java、C++、Go和Rus等流行編程語言,訓練FLAMe從備選答案中選出正確程序或修復程序

- 安全性:為了使FLAMe能夠識別出更有幫助且無害的模型響應

- 指令微調:結合數據集中的指令微調數據和人類編寫的響應,幫助保留模型的指令微調能力

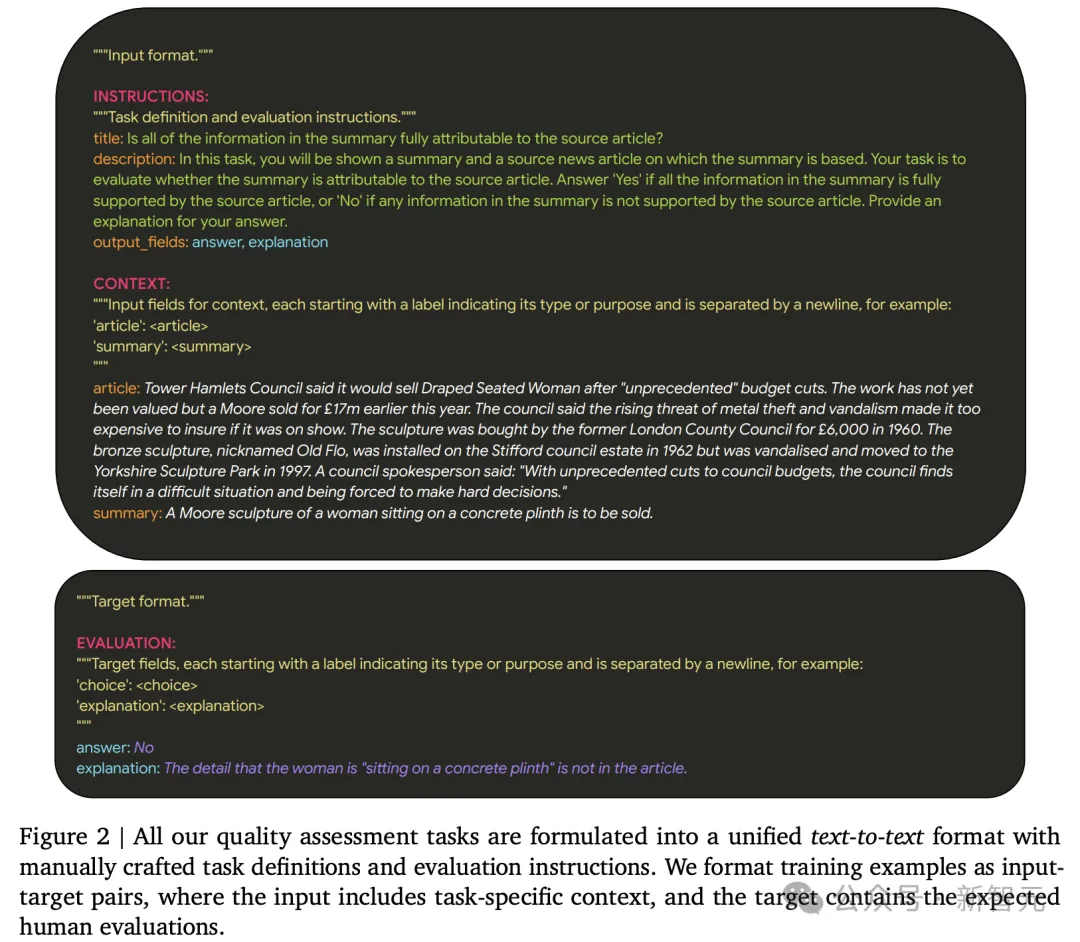

統一任務格式

精心選擇好合適的數據集后,作者受到T5統一任務格式的啟發,將所有數據都標準化為統一的「文本到文本」格式。這種靈活的格式可以輕松適應上述各種評估任務。

任務定義、評估指令和所需的輸出字段被列在輸入的INSTRUCTION部分,具體的輸入內容和目標輸出分別放在CONTEXT和EVALUATION部分(圖2)。

其中任務定義和評估指令都經過精心設計,確保一致性和標準化,并忠實于原始數據集。

模型訓練

為了訓練出通用LLM自動評估器,能夠在推理過程中提示它們執行各種任務。實驗訓練了三種模型變體:

FLAMe,通用評分器;

FLAMe-RM,用FLAMe初始化,并均勻混合了四個成對評估數據集進行微調,性能評估標準包括聊天對話、推理和安全性;

FLAMe-Opt-RM,使用獎勵模型優化的混合權重進行訓練,并使用尾部補丁微調策略(tail-patch fine-tuning)。

FLAMe

從基準訓練方法開始,使用監督多任務訓練的方式,對PaLM-2-24B模型進行指令微調,進行固定數量的30K訓練步驟。

采用示例比例混合權重(examples-proportiaonal mixture weights),每個任務采樣上限為為2^16,以避免對大型數據集進行過采樣。

FLAMe模型顯著提高了對各種held-out任務的泛化能力,在許多任務上優于GPT-4、Claude-3和Llama-3等模型。

圖片

圖片

以上數據能夠證明FLAMe具有的的基礎功能,即進行大規模多任務指令微調,可以讓模型發展出通用的質量評估能力。

然而,FLAMe對于獎勵模型評估等專門的下游應用來說并不是最佳的,因此論文進一步提出針對特定下游分布的模型變體。

FLAMe-RM

受FLAMe研究結果的啟發,作者更加深入地研究了FLAMe的拓展,將其作為進一步微調特定下游應用的起點。

作者采用了大量獎勵模型評估作為案例研究。通過在四個成對評估數據集的混合上微調FLAMe來創建FLAMe-RM。

數據集包括:HelpSteer、PRM800K、CommitPack和HH-RLHF Harmless。

由于FLAMe已經在這些數據集上進行了訓練,因此僅對其進行50個步驟的微調。

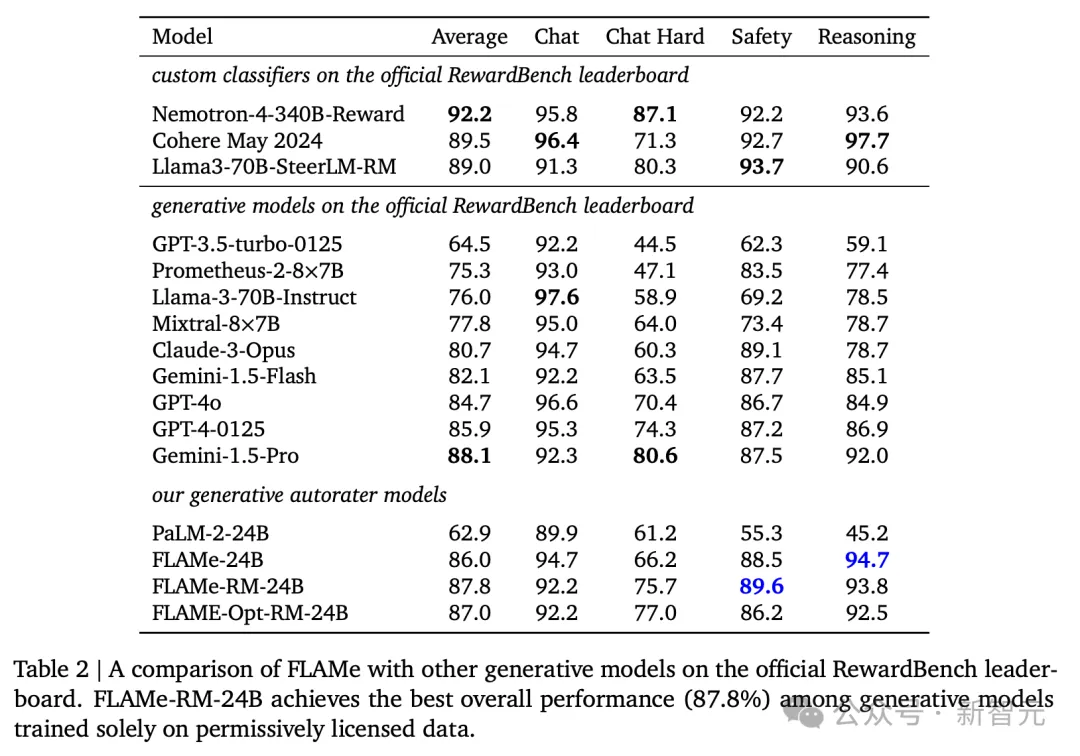

由此產生的FLAMe-RM模型將原始FLAMe的RewardBench總體得分從86.0%準確率提高到87.8%。

值得注意的是,FLAMe-RM-24B是專門在許可數據上訓練的性能最佳的生成模型,超過了GPT-4(85.9%) 和GPT-4o (84.7%)。

圖片

圖片

FLAMe-Opt-RM

雖然FLAM在許多任務中表現良好,但它需要大量的訓練才能在某些專門的下游應用程序(例如RewardBench)上獲得強大的性能。

圖片

圖片

為了解決這個問題,研究引入了一種尾部補丁消融策略(tail-patch ablation),該策略分析每個數據集對目標分布的影響。

這能夠幫助找到多任務混合中各個數據集的最佳比例,從而有效地優化混合權重超參數。

通過這種優化過的混合數據微調PaLM-2-24B僅需要5000步,相比RewardBench上的基線模型(86.0%)實現了有競爭力的性能 (87.0%),而且所用的訓練數據也減少了約25倍。

研究直接根據RewardBench性能變化(由于缺乏開發集)優化了多任務混合。

值得注意的是,研究的目標不是實現最佳的RewardBench結果,而是展示如何針對目標分布進行多任務混合的優化方法。

通過測試發現,和FLAMe-RM 一樣,微調進一步提高了RewardBench性能。

此外,FLAMe-Opt-RM在其他held-out任務中的優秀表現表明,moxing 并沒有過度擬合RewardBench,這證實了FLAMe-Opt-RM在不同任務中的廣泛適用性。

訓練細節

研究使用了PaLM-2-24B模型對FLAMe和 FLAMe-Opt-RM進行初始化,并在Flan集合上進行指令調整,分別訓練30000步和5000步,然后將FLAMe進一步微調50步以創建 FLAMe-RM。

模型使用T5X和Adam優化器進行訓練,學習率為 0.0001,dropout為 0.05。

FLAMe在256個PU芯片上進行訓練,批大小為32,而FLAMe-RM和FLAMe-Opt-RM使用128個TPU芯片,批大小為8。

評估實驗

討論過FLAMe系列模型的構建方法后,作者使用了包含12個自動評分器基準的評估套件,將FLAMe與幾個流行的LLM-as-a-Judge自動評分器進行對比。

12個基準中,只有HelpSteer作為held-in驗證,其余的RewardBench、LLM-AggreFact等11個作為held-out測試。

評估數據同樣涵蓋了53個任務,但為了降低模型API成本,每個測試集(除RewardBench)僅隨機抽取256個樣本。

對比的基線包括Llama-3-70B-Instruct、Mixtral8×7B、Claude-3-Opus等流行的LLM-as-a-Judge模型,以及RewardBench官方排行榜上列出的Gemini-1.5-Pro、Nemotron-4-340B-Reward等。

FLAMe的3種模型變體都參與了評估,而且還包括了進行指令微調前的PaLM-2-24B,以更好說明FLAMe訓練的效果。

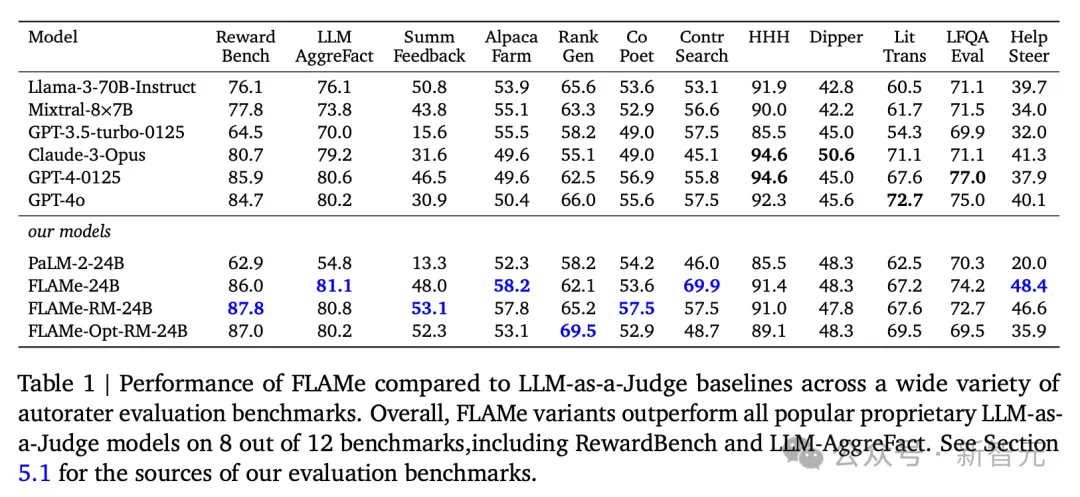

表1列舉了FLAMe系列在12個基準上與流行基線模型的對比。

其中8個都取得了最優性能,尤其是Contr Search和HelpSteer上相比次優模型有大幅度提升,讓我們看到了「許可數據」超越「專有數據」的希望。

圖片

圖片

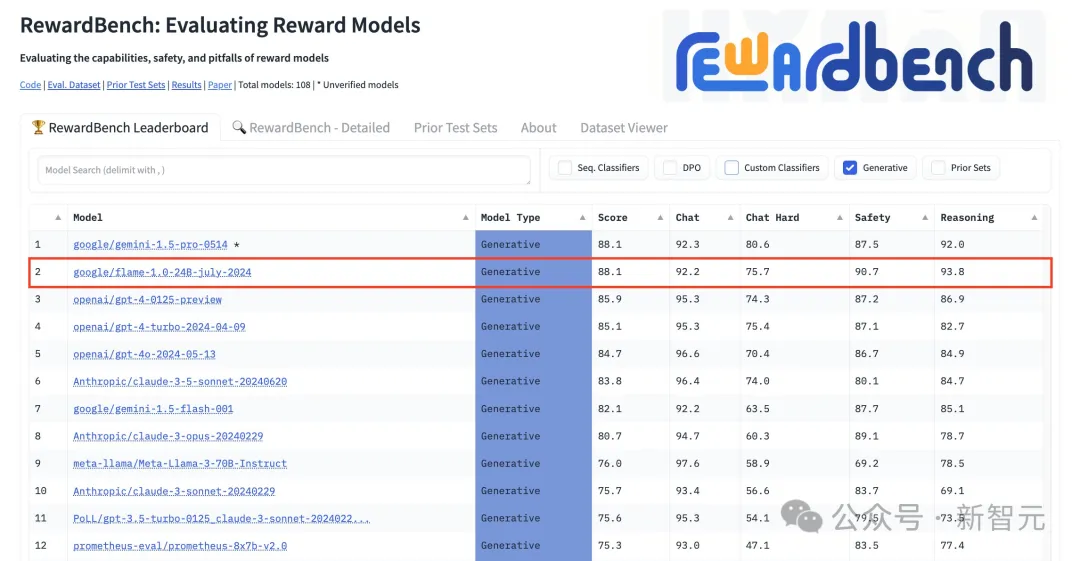

在RewardBench排行榜上,截止7月15日,FLAMe-RM-24B在所有生成模型中排名第2(僅次于Gemini-1.5-Pro),在所有模型中排名第6,在4個類別中都取得了強勁表現。

圖片

圖片

圖片

圖片

雖然RewardBench是評估獎勵模型時被廣泛使用的基準,但作者也在實驗時發現了其中的評估偏差問題,比如有對輸出答案的長度偏好,以及偏愛「sorry」、「I'm sorry」等短語。

RewardBench4個類別任務對響應長度的不同偏好

RewardBench4個類別任務對響應長度的不同偏好

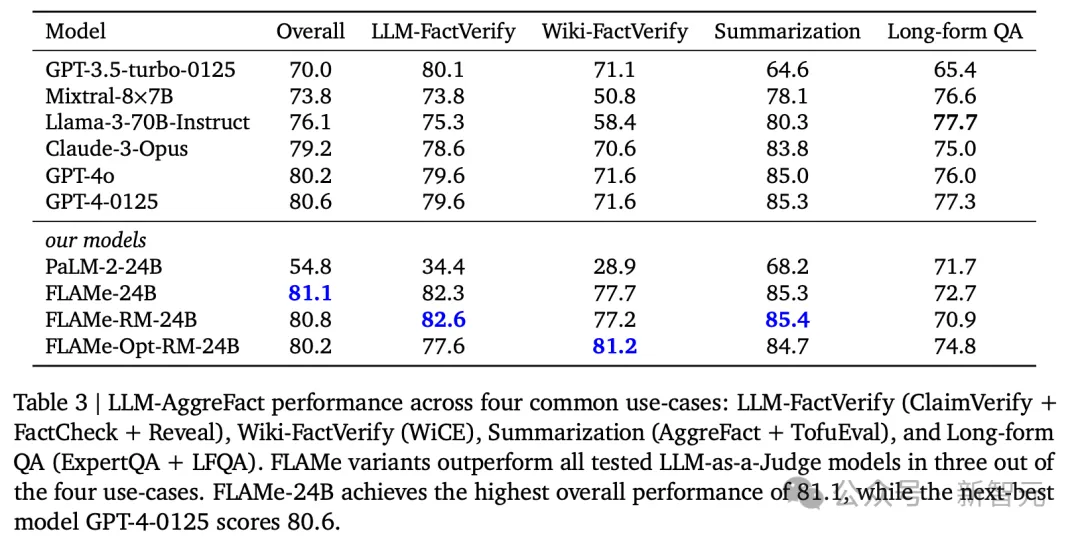

在AggreFact基準的結果中(表3),FLAMe-24B獲得了整體最佳性能,比GPT-4o高出將近1分。

在總共4個類別的用例中,FLAMe系列變體在其中3個取得了最優性能,僅在Long-formQA上表現不佳,與表1中LFQA Eval的結果相一致。

圖片

圖片

此外,上述3個表格中都能發現,相比原有的PALM-2-24B,經過訓練后的FLAMe-24B性能有大幅度的提升,證明了FLAMe訓練方法的有效性。

分析

模型大小、數據集大小和數據質量等因素在最近的多任務學習和指令調優工作中已經得到了廣泛的研究。

論文更加著重探索LLM自動評分器固有的潛在偏見,這也是影響評估準確性的一個重要方面。

另外,FLAMe對于AI開發還有許多潛在用途,例如對高質量響應數據進行采樣。

自動評分器偏差分析

對LLM自動評估器(LLM-as-a-Judge autorater)的常見批評主要涉及他們對某些判斷的偏見。

通過在自動評估器偏見基準CoBBLEr上評估 FLAMe及其變體,論文發現FLAMe模型比其他流行的LLM自動評估器的偏見要小得多。

CoBBLEr主要測量LLM自動評估器中的6種偏見:

- 順序:自動評估器對回復順序是否有偏好?

- 同情心:當使用生成響應的LLM的實際名稱(例如「GPT-4」)而不是「Model A」等別名時,自動評估者的判斷會改變嗎?

- 長度:自動評估器是否會偏好較長或較短的輸出?

- 以自我為中心:自動評估器是否偏愛自己生成的輸出?

- 見風使舵:自動評估器是否會被「90% 的人更喜歡回答 A」這樣的句子所左右?

- 注意力:自動評估器是否被不相關的上下文信息干擾

評估結果如表4所示,可以看到,相比其他基線模型,FLAMe系列在大部分維度都表現出明顯較低的偏見,而且總體偏見值最低。

圖片

圖片

使用FLAMe對解碼輸出重新排序

最后,研究還探索了LLM自動評估器在從多個響應中選擇最佳輸出方面的應用,這種方法稱為「Best-of-N」采樣。

實驗中使用了OpenAI的3個代碼生成模型,并通過循環機制(round-robin)讓FLAMe分別對它們生成的10個代碼樣本進行重新排名,然后使用排名靠前的代碼示例,在HumanEval Python基準中測試其性能。

結果表明,FLAMe在所有三個模型中都顯著提高了pass@1準確率。

圖片

圖片

值得注意的是,FLAMe將CodeGen16B的pass@1準確率從21.2提高到31.1,與Oracle排名器 (46.9) 的差距縮小了近40%。

結論與討論

FLAMe是一系列基礎自動評估器模型,可以執行各種質量評估任務。訓練所用的數據不僅大規模而且多樣化, 僅來自許可數據集,包含標準化的人類評估意見且經過精心設計。

研究展示了FLAMe強大的零樣本泛化能力,在許多懸而未決的任務中,其性能優于使用GPT-4和Claude-3等專有數據訓練的模型。

FLAMe還可以有效地作為進一步下游微調的強大起點。FLAMe-RM變體針對獎勵模型評估進行了微調,盡管僅在許可數據上進行訓練,但仍是RewardBench上表現最好的生成模型之一,其性能優于GPT-4-0125和GPT-4o。

此外,論文提出了一種計算效率更高的方法,使用新穎的尾部補丁微調策略來優化目標分布的多任務混合FLAMe模型,以顯著減少的計算量提供有競爭力的性能。

FLAMe變體在12個自動評估基準中的8個優于流行的專有LLM-as-aJudge模型,涵蓋53項質量評估任務,包括RewardBench和LLM-AggreFact。

最后,分析表明,與CoBBLEr自動評分器偏差基準上流行的LLM-as-a-Judge模型相比,FLAMe表現出明顯較低的偏見,同時能夠有效地識別代碼生成的高質量響應。

局限性和未來工作

由于評估標準不斷變化以及評估新的LLM功能的需要,評估LLM具有挑戰性,通過開源貢獻擴大我們的數據收集范圍可以解決這個問題。

此外,模型主要在上下文長度為2048個token的英語數據上進行訓練,可能在多語言或長上下文上表現不佳。

在未來的版本中,作者計劃包括對更多具有更長上下文的多語言數據集的訓練。

最后,這項工作一直以有監督的多任務方式訓練FLAMe模型。探索RLHF和DPO等其他訓練方法是未來工作的一個有希望的方向。

道德考慮和道德風險

針對預訓練和指令微調的LLMs工作概述的所有注意事項和風險也都適用于LLM自動評估器,研究也都遵循標準實踐來負責任地開發FLAMe模型。

此外,由于評估能力和評估質量的增強,LLM自動評估器也帶來了新的風險。

首先,模型可能會繼承并放大人類評估的偏見,導致不公平或歧視性的結果。

例如,該模型可能會復制訓練數據中與種族、性別或其他敏感屬性相關的偏見,這可能會損害某些群體利益。

其次,過度依賴LLM自動評估器可能會導致需要人類理解和同理心的決策不經思考而只根據LLM判定。

為了減輕這些風險,模型開發和使用的透明度,以及偏見處理、數據匿名化和納入不同觀點等強有力的措施,對于促進公平、問責和可信度至關重要。