設(shè)計(jì)一個(gè)通用的框架!3D場(chǎng)景理解最新研究進(jìn)展

3D場(chǎng)景理解是指利用計(jì)算機(jī)視覺(jué)和機(jī)器學(xué)習(xí)技術(shù)來(lái)解釋和理解三維空間中的環(huán)境和對(duì)象,通常涉及到從3D數(shù)據(jù)中識(shí)別和分類對(duì)象、理解對(duì)象之間的關(guān)系以及場(chǎng)景的語(yǔ)義信息。傳統(tǒng)的3D場(chǎng)景理解包括但不限于:(1)語(yǔ)義分割:識(shí)別并分割出圖像中每個(gè)像素所屬的類別(但不同實(shí)例的同一類別對(duì)象(如多輛汽車(chē))通常無(wú)法區(qū)分)(2)實(shí)例分割:不僅識(shí)別圖像中每個(gè)像素的對(duì)象類別,還區(qū)分同一類別中不同的實(shí)例(3)對(duì)象檢測(cè)(4)視覺(jué)定位。3D場(chǎng)景理解廣泛應(yīng)用于自動(dòng)駕駛、具身智能等領(lǐng)域,比如輔助車(chē)輛理解周?chē)?D環(huán)境,進(jìn)行導(dǎo)航和避障、幫助機(jī)器人在復(fù)雜環(huán)境中自主導(dǎo)航、與環(huán)境交互等。

目前對(duì)于3D場(chǎng)景理解的最新研究進(jìn)展如下:(1)部分學(xué)者致力于提高3D場(chǎng)景理解模型的計(jì)算效率,比如改進(jìn)自注意力機(jī)制的計(jì)算復(fù)雜度。(2)也有大部分學(xué)者關(guān)注開(kāi)放詞匯的3D場(chǎng)景理解,即在沒(méi)有明確標(biāo)記數(shù)據(jù)的情況下,對(duì)3D場(chǎng)景進(jìn)行理解和分類的方法。這與傳統(tǒng)的3D場(chǎng)景理解方法不同,傳統(tǒng)方法通常依賴于有限的、預(yù)先定義好的類別標(biāo)簽,而開(kāi)放詞匯3D場(chǎng)景理解允許模型理解和分類更廣泛的對(duì)象、屬性和場(chǎng)景特征,而無(wú)需針對(duì)每個(gè)新類別進(jìn)行重新訓(xùn)練。為了實(shí)現(xiàn)開(kāi)放詞匯的3D場(chǎng)景理解,學(xué)者們致力于將視覺(jué)語(yǔ)言模型(如CLIP)的先驗(yàn)知識(shí)引入3D場(chǎng)景理解,具體來(lái)說(shuō)需要將3D點(diǎn)云特征與文本特征、圖像特征對(duì)齊。(3)另外,鑒于目前對(duì)于各個(gè)單一任務(wù)的3D場(chǎng)景理解研究已卓有成就,并且大多數(shù)3D場(chǎng)景理解框架僅適用于特定任務(wù),還有學(xué)者希望設(shè)計(jì)一個(gè)通用的任務(wù)框架來(lái)應(yīng)用在各種3D場(chǎng)景理解的任務(wù)上,包括語(yǔ)義分割、實(shí)例分割、全景分割、交互分割、開(kāi)放詞匯分割等,具體方法比如通過(guò)知識(shí)蒸餾將通用框架在某一任務(wù)上的知識(shí)向其他任務(wù)轉(zhuǎn)移,從而實(shí)現(xiàn)了任務(wù)間的知識(shí)共享。

來(lái)看下近年來(lái)的一些研究。

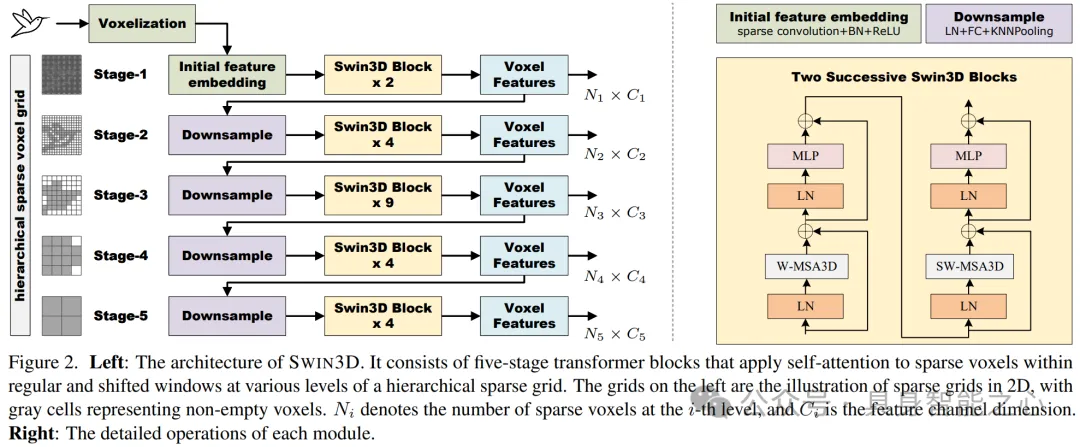

Swin3D:用于 3D 室內(nèi)場(chǎng)景理解的預(yù)訓(xùn)練 Transformer 主干

3D Transformer網(wǎng)絡(luò)在處理3D點(diǎn)云數(shù)據(jù)時(shí)面臨的高計(jì)算復(fù)雜度問(wèn)題。在傳統(tǒng)的3D Transformer網(wǎng)絡(luò)中,自注意力(self-attention)模塊的空間復(fù)雜度通常是二次方的,因?yàn)閷?duì)于每個(gè)輸入點(diǎn),都需要計(jì)算它與所有其他點(diǎn)之間的關(guān)系,這意味著隨著點(diǎn)云數(shù)據(jù)量的增加,計(jì)算和內(nèi)存需求會(huì)急劇上升。這不僅限制了模型的規(guī)模,也限制了其在大規(guī)模數(shù)據(jù)集上的應(yīng)用。為了解決這一問(wèn)題,文章提出了一種改進(jìn)的自注意力機(jī)制,能夠在稀疏體素(voxels)網(wǎng)格上以線性空間復(fù)雜度運(yùn)行,顯著降低了內(nèi)存和計(jì)算成本,使得模型能夠處理更大規(guī)模的數(shù)據(jù)集。

- 高效的自注意力算法:文章設(shè)計(jì)了一種新型的3D自注意力操作符,用于在局部窗口內(nèi)計(jì)算稀疏體素的自注意力。這種算法將自注意力的內(nèi)存成本從二次降低到線性,相對(duì)于窗口內(nèi)稀疏體素的數(shù)量,從而使得模型能夠高效地運(yùn)行而不會(huì)犧牲自注意力的準(zhǔn)確性。

- 首先,文章使用稀疏體素(voxels)來(lái)表示3D點(diǎn)云數(shù)據(jù)。體素化是一種將連續(xù)的3D空間離散化成網(wǎng)格單元(體素)的方法,其中只有非空的體素才會(huì)存儲(chǔ)點(diǎn)云數(shù)據(jù)。這種方法可以有效地減少內(nèi)存占用,因?yàn)橹惶幚矸强阵w素,而不是整個(gè)空間。

- 此外,文章將3D空間劃分為局部窗口,并在這些窗口內(nèi)計(jì)算自注意力。這種方法限制了自注意力計(jì)算的范圍,從而減少了計(jì)算量和內(nèi)存需求。

- 文章提出的新型自注意力操作符通過(guò)優(yōu)化計(jì)算過(guò)程,使得內(nèi)存需求與窗口內(nèi)非空體素的數(shù)量呈線性增長(zhǎng)。這是通過(guò)避免存儲(chǔ)所有點(diǎn)對(duì)之間的注意力權(quán)重來(lái)實(shí)現(xiàn)的,而是直接在計(jì)算過(guò)程中累加這些權(quán)重。

- 層次化結(jié)構(gòu):SWIN3D采用了類似Swin Transformer的層次化結(jié)構(gòu),由多個(gè)階段的SWIN3D塊組成,每個(gè)階段處理不同分辨率的體素特征,實(shí)現(xiàn)了多尺度特征編碼。

- 上下文相對(duì)位置編碼(cRPE):為了捕捉點(diǎn)云信號(hào)的不規(guī)則性,文章提出了一種泛化的上下文相對(duì)位置編碼方案。這種編碼方案不僅考慮了點(diǎn)的位置信息,還考慮了顏色、法線等其他信號(hào)的不規(guī)則性,通過(guò)將這些信號(hào)的相對(duì)變化納入自注意力計(jì)算中,進(jìn)一步提升了網(wǎng)絡(luò)的性能。

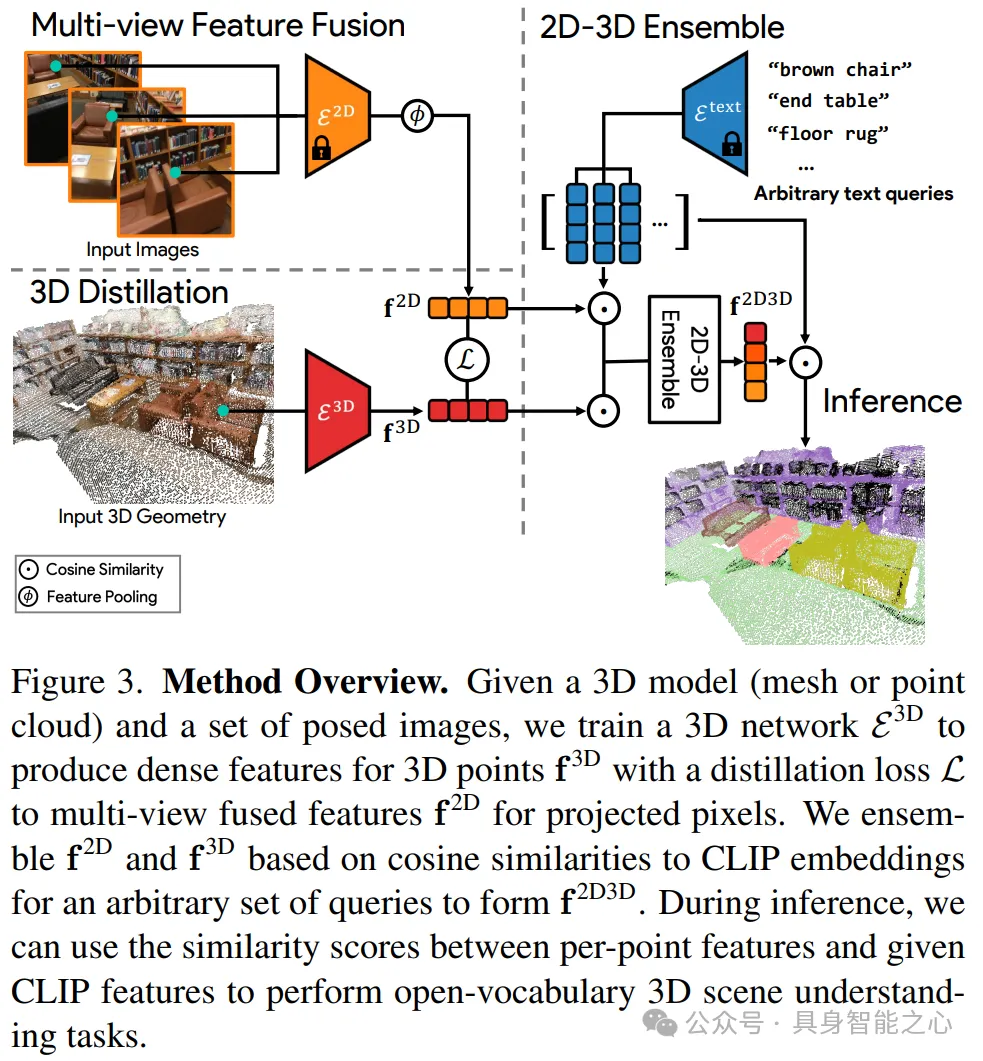

OpenScene:用開(kāi)放詞匯理解3D場(chǎng)景

開(kāi)放詞匯3D場(chǎng)景理解是指能夠在沒(méi)有明確標(biāo)記數(shù)據(jù)的情況下,對(duì)3D場(chǎng)景進(jìn)行理解和分類的方法。這與傳統(tǒng)的3D場(chǎng)景理解方法不同,傳統(tǒng)方法通常依賴于有限的、預(yù)先定義好的類別標(biāo)簽,并且需要大量的標(biāo)記3D數(shù)據(jù)來(lái)訓(xùn)練模型,以便模型能夠在特定任務(wù)上表現(xiàn)出色。這種方法的難點(diǎn)在于:(1)數(shù)據(jù)標(biāo)記成本高(2)泛化能力有限(3)任務(wù)特定性強(qiáng)。開(kāi)放詞匯3D場(chǎng)景理解旨在解決這些限制,它允許模型理解和分類更廣泛的對(duì)象、屬性和場(chǎng)景特征,而無(wú)需針對(duì)每個(gè)新類別進(jìn)行重新訓(xùn)練。

文章提出的模型架構(gòu)OpenScene,是一種零樣本學(xué)習(xí)方法,它利用了大規(guī)模預(yù)訓(xùn)練的文本-圖像嵌入模型(如CLIP)來(lái)增強(qiáng)3D場(chǎng)景理解的能力。模型將3D點(diǎn)的特征與文本和圖像像素在CLIP特征空間中共同嵌入。這意味著3D點(diǎn)的特征不僅與視覺(jué)信息相關(guān)聯(lián),還與語(yǔ)言概念對(duì)齊,從而允許使用文本查詢來(lái)探索3D場(chǎng)景。模型具體通過(guò)以下步驟將3D點(diǎn)的特征與視覺(jué)特征和語(yǔ)言特征的對(duì)齊:

- 圖像特征提取及2D-3D配對(duì):首先,對(duì)于每個(gè)RGB圖像,使用一個(gè)預(yù)訓(xùn)練的2D視覺(jué)-語(yǔ)言分割模型(如OpenSeg或LSeg)來(lái)計(jì)算每個(gè)像素的嵌入特征。這些特征被用來(lái)表示圖像中的視覺(jué)信息。接著,對(duì)于3D點(diǎn)云中的每個(gè)3D表面點(diǎn),通過(guò)相機(jī)的內(nèi)參和外參矩陣將其投影回對(duì)應(yīng)的2D圖像平面上。這個(gè)步驟確保了每個(gè)3D點(diǎn)都能找到它在2D圖像中的對(duì)應(yīng)像素。這樣,每個(gè)3D點(diǎn)都獲得了一個(gè)融合了多個(gè)視角下視覺(jué)信息的特征向量。

- 3D網(wǎng)絡(luò)蒸餾:盡管可以直接使用融合的2D特征進(jìn)行語(yǔ)言驅(qū)動(dòng)的3D場(chǎng)景理解,但為了提高魯棒性并處理只有3D點(diǎn)云數(shù)據(jù)的情況,文章提出了一個(gè)3D網(wǎng)絡(luò)(如MinkowskiNet),它只使用3D點(diǎn)的位置信息作為輸入,并訓(xùn)練這個(gè)網(wǎng)絡(luò)來(lái)復(fù)現(xiàn)融合的2D特征。通過(guò)最小化3D網(wǎng)絡(luò)輸出和融合的2D特征之間的差異,3D網(wǎng)絡(luò)學(xué)習(xí)到了與2D特征對(duì)齊的特征表示。

- 2D-3D特征集成:為了結(jié)合2D圖像特征和3D幾何特征的優(yōu)勢(shì),文章提出了一個(gè)集成方法。通過(guò)計(jì)算每個(gè)3D點(diǎn)的2D融合特征和3D蒸餾特征與一組文本提示的相似度,選擇與文本提示最相似的特征作為最終的集成特征。

由于CLIP模型是在大規(guī)模的圖像和文本數(shù)據(jù)上預(yù)訓(xùn)練的,它能夠捕捉到比傳統(tǒng)對(duì)象類別標(biāo)簽更豐富的概念,包括物理屬性、材料、功能等。OpenScene利用這一點(diǎn),允許用戶輸入任意文本查詢,并在3D場(chǎng)景中找到與這些查詢匹配的部分。

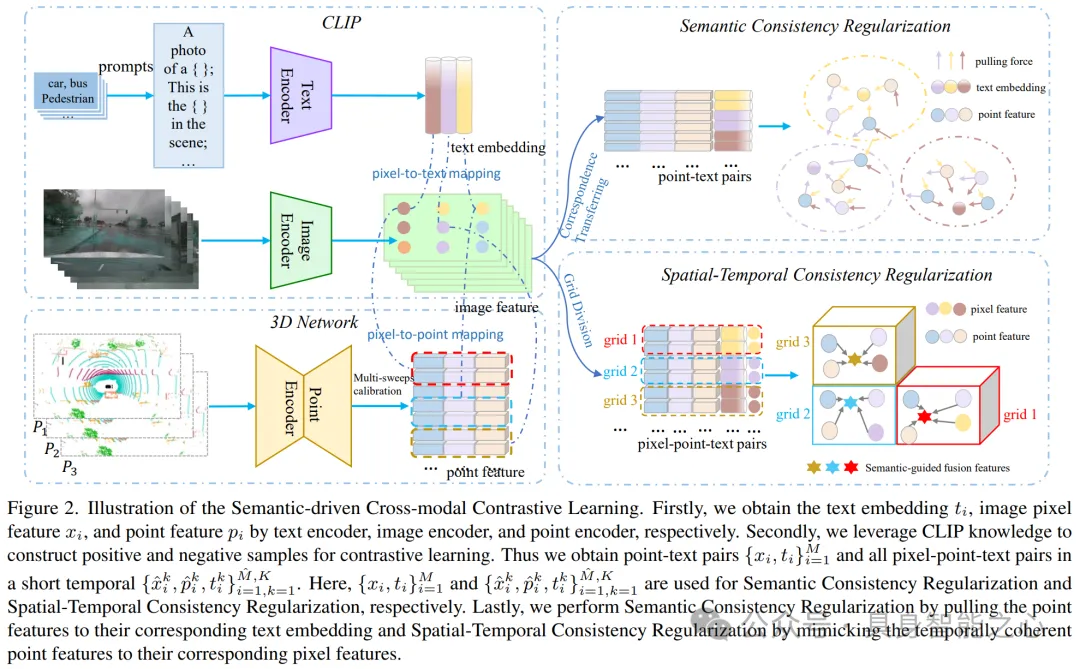

CLIP2Scene:通過(guò)CLIP實(shí)現(xiàn)標(biāo)簽高效的3D場(chǎng)景理解

類似于上文,CLIP2Scene也是應(yīng)用 CLIP 來(lái)幫助學(xué)習(xí) 3D 場(chǎng)景理解,將CLIP知識(shí)從2D圖像-文本預(yù)訓(xùn)練模型轉(zhuǎn)移到3D點(diǎn)云網(wǎng)絡(luò)。CLIP2Scene的框架通過(guò)語(yǔ)義和時(shí)空一致性正則化來(lái)預(yù)訓(xùn)練3D點(diǎn)云網(wǎng)絡(luò),使得3D點(diǎn)云特征能夠與CLIP的視覺(jué)和文本特征對(duì)齊。下面是具體的對(duì)齊方法:

- 語(yǔ)義一致性正則化(Semantic Consistency Regularization):利用CLIP的文本語(yǔ)義來(lái)選擇正樣本和負(fù)樣本。具體來(lái)說(shuō),通過(guò)將類別名稱放入預(yù)先定義的模板中,使用CLIP的文本編碼器生成文本嵌入(text embeddings),這些嵌入包含了對(duì)應(yīng)類別的語(yǔ)義信息。然后,將這些文本嵌入與3D點(diǎn)云特征進(jìn)行對(duì)比學(xué)習(xí)。通過(guò)對(duì)比損失函數(shù),拉近具有相同語(yǔ)義的點(diǎn)云特征和文本嵌入之間的距離,同時(shí)推遠(yuǎn)不同語(yǔ)義的點(diǎn)云特征和文本嵌入,從而使得3D網(wǎng)絡(luò)學(xué)習(xí)到的特征能夠與CLIP的文本語(yǔ)義對(duì)齊。

- 時(shí)空一致性正則化(Spatial-Temporal Consistency Regularization):此外,還將點(diǎn)云數(shù)據(jù)與對(duì)應(yīng)的圖像數(shù)據(jù)進(jìn)行校準(zhǔn),建立圖像像素特征與點(diǎn)云特征之間的對(duì)應(yīng)關(guān)系。為了使多掃描點(diǎn)云具有時(shí)間一致性,即在連續(xù)時(shí)間幀內(nèi)捕獲的點(diǎn)云數(shù)據(jù)具有空間和時(shí)間上的連貫性,在正則化過(guò)程中,強(qiáng)制使得同一空間位置和時(shí)間戳內(nèi)的點(diǎn)云特征與圖像像素特征保持一致。這通過(guò)計(jì)算點(diǎn)云特征和對(duì)應(yīng)圖像像素特征之間的相似度,并使用損失函數(shù)來(lái)最小化它們之間的差異來(lái)實(shí)現(xiàn)。

通過(guò)上述兩個(gè)正則化策略,CLIP2Scene框架能夠?qū)?D點(diǎn)云特征與CLIP的豐富視覺(jué)和文本信息有效地結(jié)合起來(lái),從而提高3D場(chǎng)景理解的性能。這種跨模態(tài)的對(duì)比學(xué)習(xí)方法不僅使得3D網(wǎng)絡(luò)能夠進(jìn)行零樣本(annotation-free)的語(yǔ)義分割,而且在有少量標(biāo)注數(shù)據(jù)進(jìn)行微調(diào)(fine-tuning)時(shí)也能顯著提高性能。

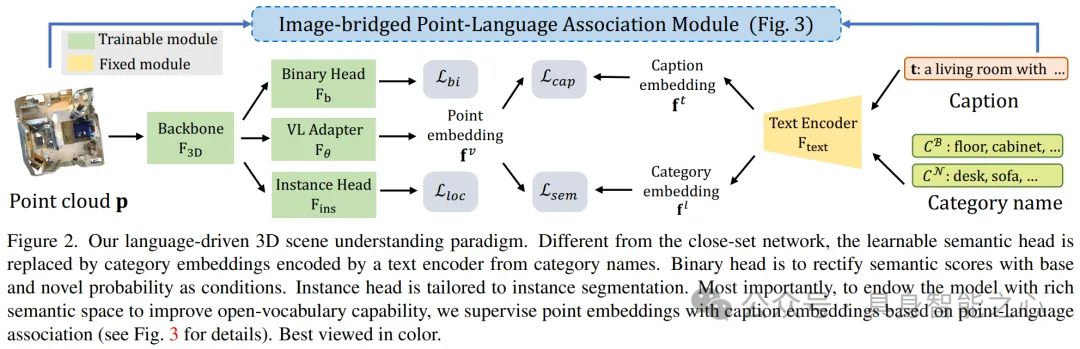

PLA:語(yǔ)言驅(qū)動(dòng)的開(kāi)放詞匯3D場(chǎng)景理解

提出了一種名為PLA(Point-Language Association)的方法,也是希望利用視覺(jué)語(yǔ)言模型輔助3D特征與文本特征對(duì)齊,實(shí)現(xiàn)開(kāi)放詞匯3D場(chǎng)景理解。具體如下:

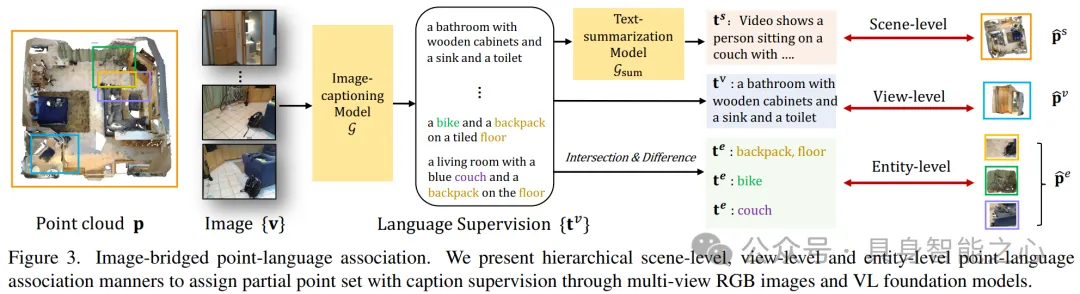

- 首先,從3D場(chǎng)景中獲取多個(gè)視角的圖像。這些圖像通常由圍繞3D場(chǎng)景的不同位置的相機(jī)拍攝得到,能夠提供場(chǎng)景的全面視圖。利用3D場(chǎng)景和這些多視圖圖像之間的幾何關(guān)系,例如相機(jī)的內(nèi)參和外參,以及3D點(diǎn)與2D圖像之間的投影關(guān)系。這些幾何約束確保了從不同視角觀察到的同一物體在3D空間中的位置是一致的。

- 構(gòu)建分層的3D-字幕對(duì):然后文章使用一個(gè)預(yù)訓(xùn)練的視覺(jué)語(yǔ)言基礎(chǔ)模型(具體為GPT-ViT2)來(lái)為3D場(chǎng)景的多視圖圖像添加字幕,提供與3D場(chǎng)景相關(guān)的語(yǔ)義豐富的描述。文章設(shè)計(jì)了分層的3D字幕對(duì),包括場(chǎng)景級(jí)(將整個(gè)3D場(chǎng)景與一個(gè)匯總的字幕相關(guān)聯(lián))、視圖級(jí)(將每個(gè)視角下的3D點(diǎn)云與對(duì)應(yīng)圖像的字幕相關(guān)聯(lián))和實(shí)體級(jí)(通過(guò)分析相鄰視圖級(jí)點(diǎn)集的差異和交集,構(gòu)建與特定實(shí)體(如單個(gè)物體實(shí)例)相關(guān)的字幕)。這些層次化的字幕對(duì)利用3D場(chǎng)景和多視圖圖像之間的幾何約束,從而在不同的空間尺度上建立3D點(diǎn)云與文本之間的關(guān)聯(lián)。

- 3D點(diǎn)云特征與文本特征對(duì)齊:最后,通過(guò)對(duì)比學(xué)習(xí)的方法,使得3D點(diǎn)云的特征與相應(yīng)文本描述的特征在特征空間中相互靠近,從而學(xué)習(xí)到能夠反映文本描述內(nèi)容的3D特征表示。

這種方法的優(yōu)勢(shì)在于,它不僅能夠利用豐富的文本信息來(lái)增強(qiáng)3D數(shù)據(jù)的理解,還能夠處理不同尺度和粒度的3D場(chǎng)景內(nèi)容,從而提高模型在開(kāi)放詞匯3D場(chǎng)景理解任務(wù)中的性能和泛化能力。

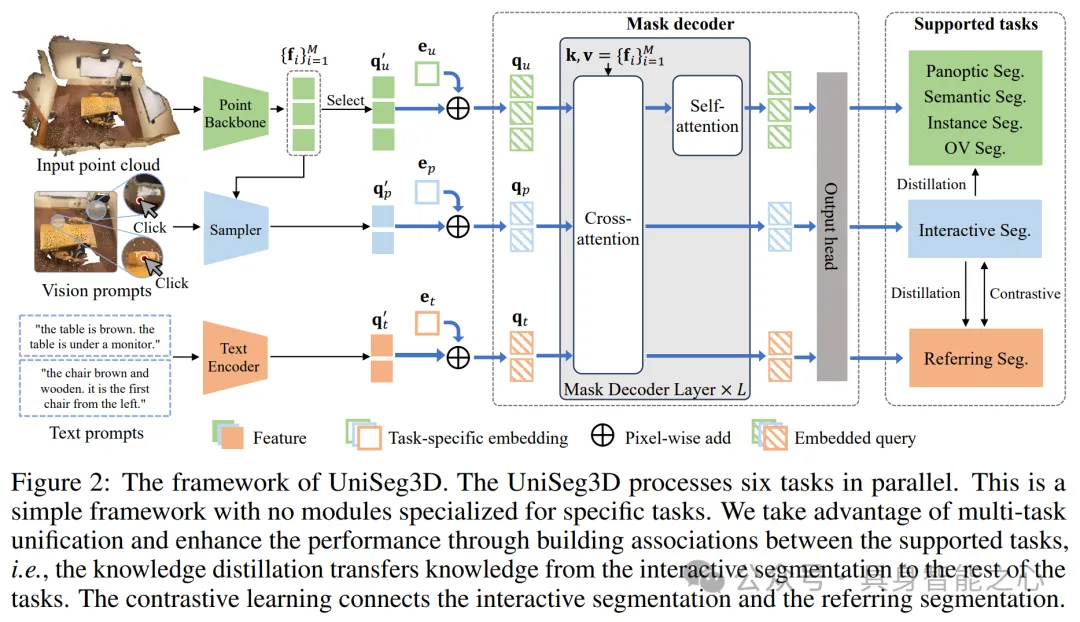

UniSeg3D:三維場(chǎng)景理解的統(tǒng)一框架

以往的大多數(shù) 3D 場(chǎng)景分割方法都專門(mén)用于特定任務(wù),因此將他們對(duì) 3D 場(chǎng)景的理解限制在特定于任務(wù)的視角上。這篇文章提出了 UniSeg3D,它使用一個(gè)統(tǒng)一的Transformer作為核心處理單元,這個(gè)Transformer接收統(tǒng)一的輸入表示,并為所有任務(wù)生成特征。這種設(shè)計(jì)允許模型在不同任務(wù)之間共享知識(shí),提高了模型的泛化能力和效率。

- 首先,為了處理不同的任務(wù),UniSeg3D引入了多種類型的輸入查詢(queries):

- 通用分割任務(wù)(如語(yǔ)義分割、實(shí)例分割、全景分割)使用點(diǎn)云作為輸入,通過(guò)3D U-Net提取特征。

- 交互分割任務(wù)通過(guò)視覺(jué)提示(如點(diǎn)擊或畫(huà)框)來(lái)指定感興趣的區(qū)域。

- 引用分割任務(wù)使用文本描述來(lái)指定分割目標(biāo)。

- 開(kāi)放詞匯分割任務(wù)處理未在訓(xùn)練集中出現(xiàn)的類別。

- 然后,UniSeg3D利用知識(shí)蒸餾從交互分割任務(wù)(由于其視覺(jué)提示的可靠性,通常具有較高的分割性能)向其他任務(wù)轉(zhuǎn)移知識(shí)。具體來(lái)說(shuō),使用匈牙利算法(Hungarian algorithm)將交互分割任務(wù)的預(yù)測(cè)結(jié)果與真實(shí)標(biāo)簽進(jìn)行匹配,從而得到正樣本。然后,在交互分割任務(wù)的預(yù)測(cè)掩碼中,選擇具有最高置信度(例如,前k%)的區(qū)域作為學(xué)習(xí)區(qū)域。在這些學(xué)習(xí)區(qū)域內(nèi),計(jì)算交互分割任務(wù)的預(yù)測(cè)掩碼與“學(xué)生”任務(wù)的預(yù)測(cè)掩碼之間的損失。這個(gè)損失通過(guò)比較匹配區(qū)域內(nèi)的預(yù)測(cè)掩碼來(lái)衡量,使用二元交叉熵?fù)p失(Binary Cross-Entropy, BCE)來(lái)實(shí)現(xiàn)。通過(guò)最小化這個(gè)損失,將交互分割任務(wù)的知識(shí)轉(zhuǎn)移到其他任務(wù)中,從而提高這些任務(wù)的性能。

- 此外,為了將文本描述與3D場(chǎng)景中的相應(yīng)對(duì)象或區(qū)域關(guān)聯(lián)起來(lái),設(shè)計(jì)了一種基于排名的對(duì)比學(xué)習(xí)方法。具體來(lái)說(shuō),首先使用Transformer架構(gòu)來(lái)獲取點(diǎn)云特征、使用預(yù)訓(xùn)練的CLIP模型來(lái)獲取文本特征。然后通過(guò)一個(gè)對(duì)比學(xué)習(xí)框架匹配點(diǎn)云特征和文本特征。為了進(jìn)一步優(yōu)化對(duì)比學(xué)習(xí)的效果,UniSeg3D引入了排名規(guī)則。這個(gè)規(guī)則確保在對(duì)比學(xué)習(xí)過(guò)程中,與特定文本描述最相關(guān)的點(diǎn)云特征在相似度排序中位于最前面。通過(guò)這種方式,模型能夠更好地理解和處理引用分割任務(wù)中的文本描述。