史上最嚴“中文真實性評估”:OpenAI o1第1豆包第2,其它全部不及格

新的大語言模型(LLM)評估基準對于跟上大語言模型的快速發展至關重要。

近日,淘寶天貓集團的研究者們提出了中文簡短問答(Chinese SimpleQA),這是首個全面的中文基準,具有“中文、多樣性、高質量、靜態、易于評估”五個特性,用于評估語言模型回答簡短問題的真實性能力。

研究人員表示,中文簡短問答能夠指導開發者更好地理解其模型的中文真實性能力,并促進基礎模型的發展。

論文地址:https://arxiv.org/abs/2411.07140

引言

人工智能發展中的一個重大挑戰是確保語言模型生成的回答在事實上準確無誤。當前前沿模型有時會產生錯誤輸出或缺乏證據支持的答案,這就是所謂的“幻覺”問題,極大地阻礙了通用人工智能技術(如大語言模型)的廣泛應用。此外,評估現有大語言模型的真實性能力也頗具難度。例如,大語言模型通常會生成冗長的回復,包含大量事實性陳述。最近,為解決上述評估問題,OpenAI發布了簡短問答基準(SimpleQA),其中包含4326個簡潔且尋求事實的問題,使得衡量真實性變得簡單可靠。

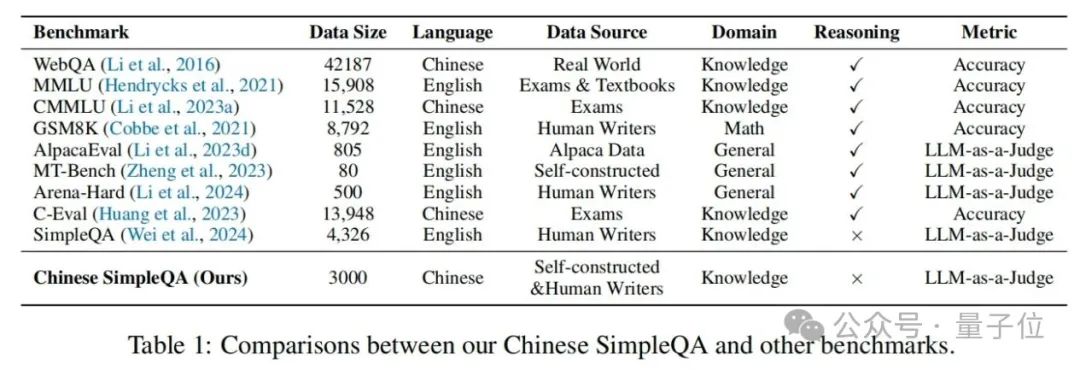

然而,簡短問答基準主要針對英語,導致對大語言模型在其他語言中的能力了解有限。此外,受近期幾個中文大語言模型基準(如C-Eval、CMMLU)的啟發,為了評估大語言模型在中文語境下的真實性能力,淘天集團的研究人員提出了中文簡短問答基準。該基準由3000個高質量問題組成,涵蓋從人文到科學工程等6個主要主題。具體而言,中文簡短問答的顯著主要特征如下:

- 中文特性:專注于中文語言,能夠全面評估現有大語言模型在中文語境下的真實性能力。

- 多樣性:涵蓋6個主題,即“中國文化”“人文”“工程、技術與應用科學”“生活、藝術與文化”“社會”和“自然科學”。這些主題總共包括99個細粒度的子主題,體現了中文簡短問答的多樣性。

- 高質量:實施了全面且嚴格的質量控制流程,以確保中文簡短問答的質量和準確性。

- 靜態性:與SimpleQA類似,為保持中文簡短問答的常青特性,所有參考答案不會隨時間改變。

- 易于評估:與SimpleQA類似,由于問題和答案都非常簡短,通過現有大語言模型(如OpenAI API)進行評分的過程快速便捷。

研究人員在中文簡短問答上對現有大語言模型進行了全面評估和分析,得出了以下一些有洞察力的發現:

- 中文簡短問答具有挑戰性:只有o1-preview和Doubao-pro-32k達到及格分數(在正確指標上分別為63.8%和61.9%),許多閉源和開源大語言模型仍有很大的改進空間。

- 模型越大效果越好:基于Qwen2.5系列、InternLM系列、Yi-1.5系列等的結果,作者觀察到模型越大性能越好。

- 更大的模型更校準:作者觀察到o1-preview比o1-mini更校準,GPT-4o比GPT-4o-mini更校準。

- 檢索增強生成(RAG)很重要:當將RAG策略引入現有大語言模型時,不同大語言模型之間的性能差距顯著縮小。例如,對于GPT-4o和Qwen2.5-3B,使用RAG后性能差距從42.4%縮小到9.3%。

- 存在對齊代價:現有的對齊或后訓練策略通常會降低語言模型的真實性。

- SimpleQA和中文簡短問答的排名不同:幾個專注于中文的大語言模型(Doubao-pro-32k和GLM-4-Plus)的性能接近高性能的o1-preview。特別是在“中國文化”主題上,這些中文社區大語言模型明顯優于GPT或o1系列模型。

中文簡短問答

概述

圖片

圖片

中文簡短問答的類別分布,包含六個主要主題,每個主要主題包含多個二級子主題。在表1中,作者將中文簡短問答與幾個主流的大語言模型評估基準進行了比較,這表明中文簡短問答是第一個專注于評估大語言模型中中文知識邊界的基準。

數據收集

圖片

圖片

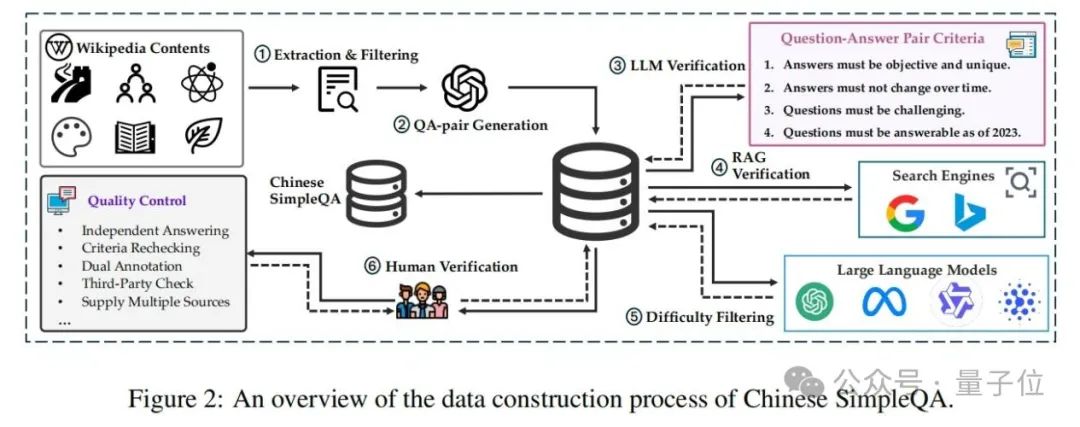

如圖2所示,中文簡短問答的數據收集過程涉及自動構建和人工驗證。自動階段包括:(1)提取和過濾相關知識內容,(2)自動生成問題-答案對,(3)根據預定義標準使用大語言模型驗證這些對,(4)執行檢索增強生成(RAG)驗證,以及(5)進行難度篩選。

具體而言,首先,作者從各種知識領域(如維基百科)收集大量知識豐富的文本內容,并使用質量評估模型過濾掉低質量數據。然后,作者提示大語言模型使用這些高質量知識內容生成問題-答案對。之后,為確保中文簡短問答的質量,作者使用大語言模型去除不符合預定義標準要求的樣本。通過這種方式,可以獲得大量初步篩選后的知識問題-答案對。同時,為了提高答案的質量,部署外部檢索工具(即搜索引擎)來收集更多樣化的信息,這引導大語言模型基于RAG系統評估答案的事實正確性。具體來說,應用LlamaIndex作為檢索方法,以谷歌和必應的搜索結果作為數據源。關于生成和驗證的詳細信息可以在附錄A中找到。此外,作者過濾一些簡單樣本以發現大語言模型的知識邊界并提高中文簡短問答的難度。具體來說,如果一個問題可以被四個大模型正確回答,則認為它是一個簡單問題并將其丟棄。

值得注意的是,問題-答案對的構建基于以下標準:

- 答案必須客觀且唯一:問題應與客觀世界的事實知識相關,不受個人主觀觀點影響。例如,以“你認為……怎么樣?”或“你如何評價……?”開頭的問題是不合適的。此外,每個問題的答案必須是唯一的,排除多個正確答案的可能性。例如,“朱祁鎮在哪一年登上皇位?”這個問題是不充分的,因為它有兩個可能的答案:1435年和1457年。

- 答案必須不隨時間變化:答案應始終反映永恒的事實,不受提問時間的影響。例如,“碳的原子序數是多少?”,答案“6”始終不變。相比之下,關于時事的問題,如“某個國家的現任總統是誰?”是不合適的,因為其答案會隨時間變化。

- 問題必須具有挑戰性:問題不應過于簡單,設計的查詢需要全面評估模型的知識深度。

- 問題必須截至2023年可回答:每個問題必須在2023年12月31日前可回答,以確保對在此日期后訓練的數據的模型進行公平評估。

2.3質量控制

在自動數據收集之后,采用人工驗證來提高數據集質量。具體來說,每個問題由兩個人工注釋者獨立評估。首先,注釋者確定問題是否符合上述預定義標準。如果任何一個注釋者認為問題不符合要求,則丟棄該樣本。隨后,兩個注釋者都使用搜索引擎檢索相關信息并制定答案。在此階段,注釋者應使用權威來源(如維基百科、百度百科)的內容,并且每個注釋者必須提供至少兩個支持性URL。如果注釋者的答案不一致,則由第三個注釋者審查該樣本。最終注釋由第三個注釋者根據前兩個評估確定。最后,將人工注釋結果與大語言模型生成的回復進行比較,僅保留完全一致的問題-答案對。這個嚴格的人工驗證過程確保了數據集保持高準確性并符合既定標準。

在構建和注釋中文簡短問答的整個過程中,許多低質量的問題-答案對被丟棄。具體來說,最初生成了10000對。經過使用不同模型進行難度評估后,大約保留了6310對,其中約37%的較簡單數據被丟棄。在此之后,經過基于規則的驗證和基于模型的RAG驗證,又刪除了2840個樣本,這意味著僅剩下約35%的原始生成數據。最后,經過徹底和嚴格的人工審查,僅保留了約3000個樣本,約占原始數據集的30%。

2.4數據集統計

圖片

圖片

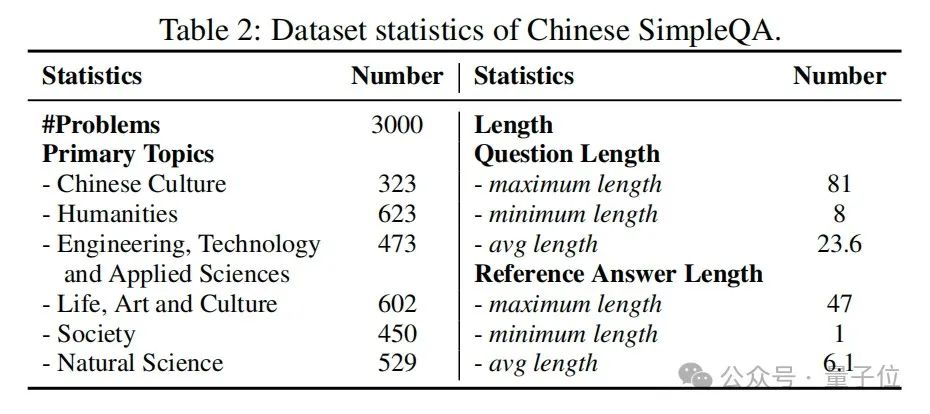

表2展示了中文簡短問答的統計數據。共有3000個樣本,中文簡短問答在六個主要主題上的數據分布相對均衡,這可以有效地評估大語言模型在各個領域的知識邊界。此外,該數據集中問題和參考答案的長度分布都非常短,這是基于知識查詢的特點。值得注意的是,使用中文簡短問答評估模型需要最少的輸入和輸出標記,從而導致非常低的評估計算和時間成本。

2.5評估指標

與SimpleQA類似,中文簡短問答也采用以下五個評估指標:

- 正確(CO):預測答案完全包含參考答案,且不引入任何矛盾元素。

- 未嘗試(NA):預測答案未完全給出參考答案,但與參考答案不存在矛盾元素。

- 不正確(IN):預測答案與參考答案矛盾,即使矛盾可以解決。

- 嘗試后正確(CGA):該指標是在嘗試回答的問題中準確回答問題的比例。

- F分數:該指標表示正確和嘗試后正確之間的調和平均值。

3.實驗

3.1基線模型

作者評估了17個閉源大語言模型(即o1-preview、Doubao-pro-32k、GLM-4-Plus、GPT-4o、Qwen-Max、Gemini-1.5-pro、DeepSeek-V2.5、Claude-3.5-Sonnet、Yi-Large、moonshot-v1-8k、GPT-4-turbo、GPT-4、Baichuan3-turbo、o1-mini、Doubao-lite-4k、GPT-4o-mini、GPT-3.5)和24個開源大語言模型(即Qwen2.5系列、InternLM2.5系列、Yi-1.5系列、LLaMA3系列、DeepSeek系列、Baichuan2系列、Mistral系列、ChatGLM3和GLM-4)。

3.2主要結果

圖片

圖片

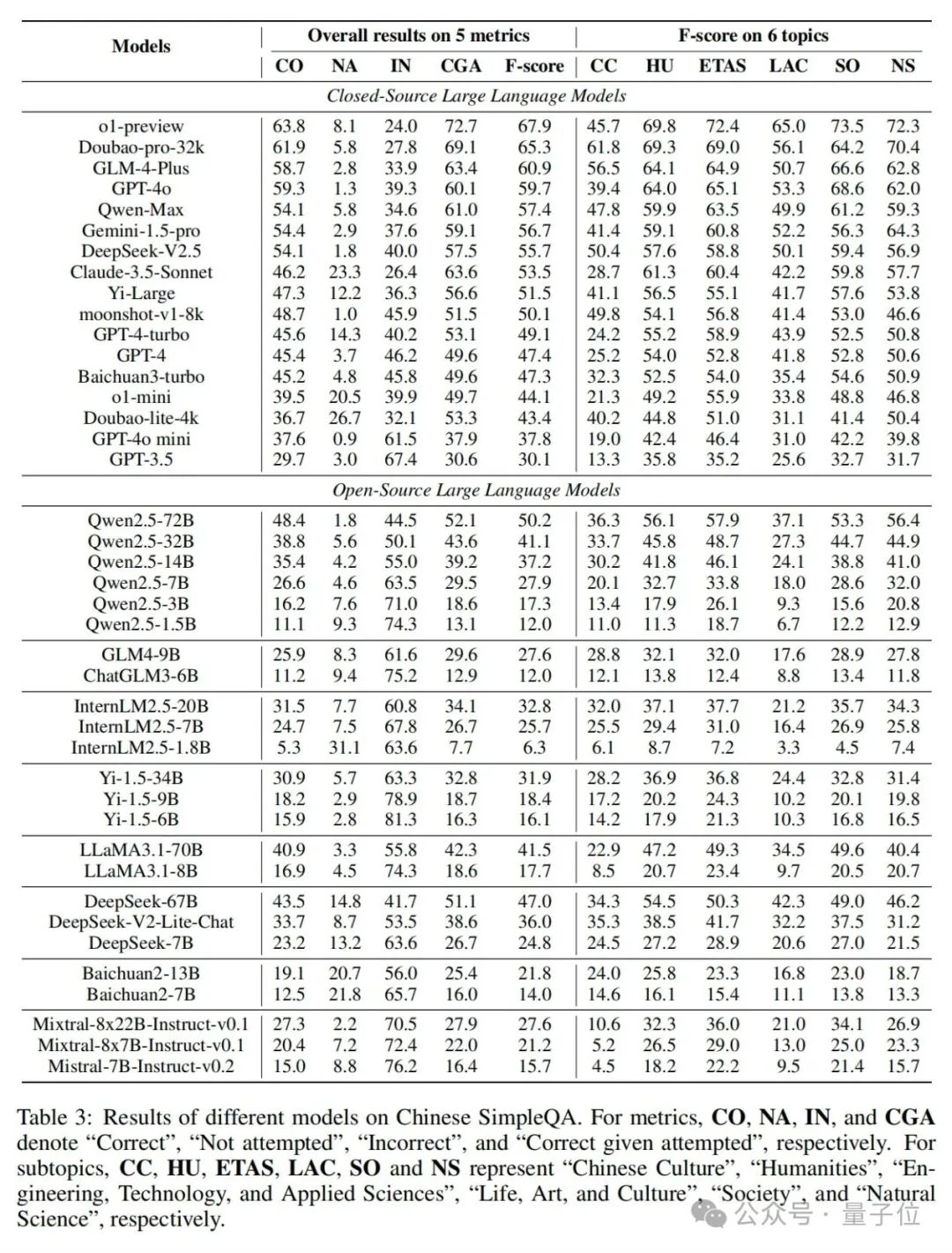

如表3所示,論文提供了不同大語言模型在中文簡短問答上的性能結果。具體來說,與SimpleQA類似,作者提供了五個評估指標的總體結果。

此外,論文還報告了六個主題的F分數,以分析這些大語言模型的細粒度真實性能力。在表3中,有以下有洞察力和有趣的觀察結果:

- o1-preview表現最佳:o1-preview在中文簡短問答上取得了最佳性能,并且幾個近期專注于中文的閉源大語言模型(Doubao-pro-32k和GLM-4-Plus)的性能結果與o1-preview非常接近。

- “mini”系列模型表現較差:很明顯,“mini”系列模型(o1-mini、GPT-4o-mini)的結果比相應的更大模型(o1-preview、GPT-4o)低,這也表明這些“mini”系列模型不注重記憶事實性知識。

圖片

圖片

圖片

圖片

- 模型越大性能越好:基于許多模型系列(如GPT、Qwen2.5、InternLM2.5、Yi-1.5),我們可以得出更大的大語言模型會導致更好的性能這一結論。

- 小模型在“未嘗試”上得分較高:小型大語言模型通常在“未嘗試(NA)”上得分較高。o1-mini、InternLM2.5-1.8B的NA分數分別為20.5和9.3,遠高于相應更大模型的分數(o1-preview為8.1,Qwen2.5-72B為1.8)。

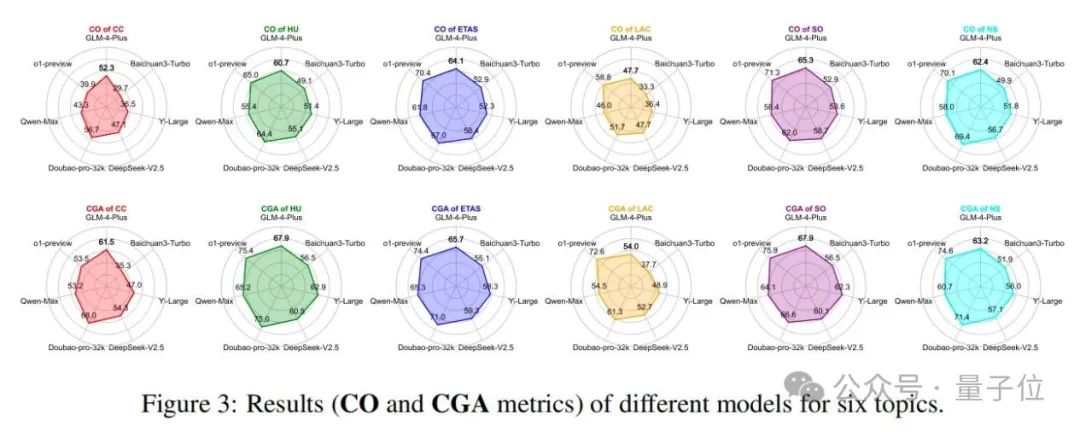

- 不同子主題性能差異顯著:不同大語言模型在不同子主題上存在顯著的性能差異。值得注意的是,中文社區大語言模型(如Doubao-pro-32k、GLM-4-Plus、Qwen-Max、Deepseek)在“中國文化(CC)”子主題上明顯優于GPT或o1模型。相比之下,o1在與科學相關的子主題(如“工程、技術與應用科學(ETAS)”和“自然科學(NS)”)上具有顯著優勢。

此外,論文還在圖3中提供了六個主題的詳細結果(CO和CGA指標)。

3.3進一步分析

3.3.1校準分析

圖片

圖片

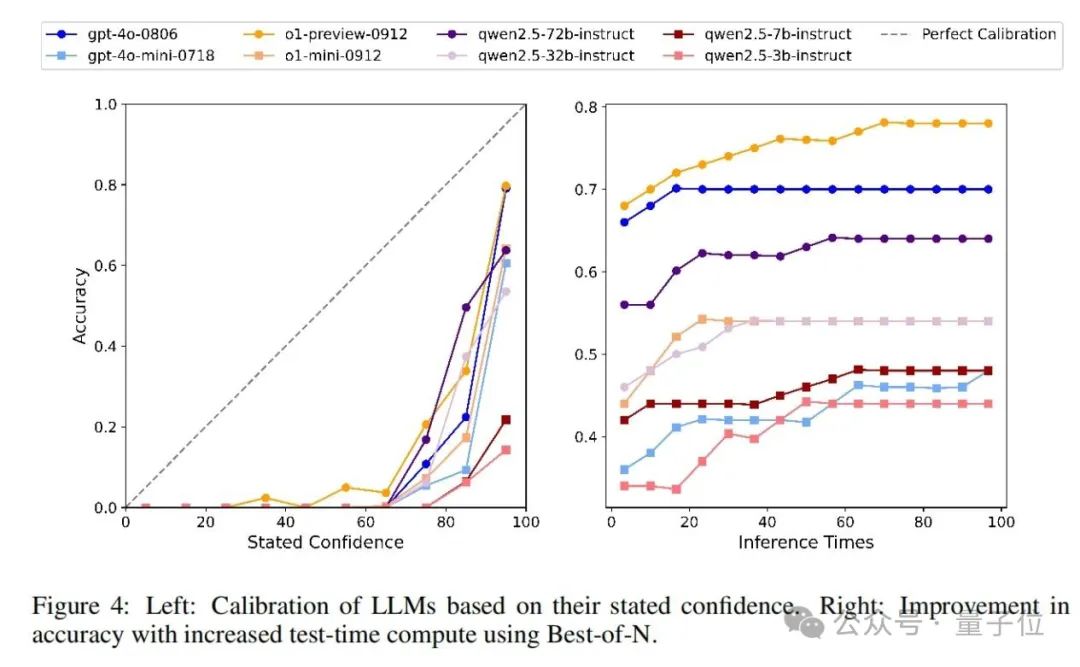

對于不同大語言模型的校準,與SimpleQA類似,作者指示模型在回答問題時提供相應的置信水平(從0到100),以衡量模型對其答案的信心(見附錄B中的提示)。我們知道,一個完美校準的模型的置信度(%)應該與其答案的實際準確性相匹配。圖4中的左圖說明了校準性能,這表明GPT-4o比GPT-4o-mini校準得更好,o1-preview比o1-mini校準得更好。對于Qwen2.5系列,校準順序為Qwen2.5-72B>Qwen2.5-32B>Qwen2.5-7B>Qwen2.5-3B,這表明更大的模型尺寸會導致更好的校準。此外,對于所有評估模型,它們在置信度>50的范圍內的置信度低于完美校準線,這意味著它們都高估了其回復的準確性,存在過度自信的情況。

3.3.2測試時間計算分析

論文還評估了不同模型在增加測試時間計算時與回復準確性的關系。具體來說,從中文簡短問答中隨機抽取50個樣本,對于每個樣本,模型被要求獨立回答100次。然后,使用最佳N法隨著推理次數的增加獲得模型的回復準確性。結果如圖4中的右圖所示。作者觀察到,隨著推理次數的增加,所有模型的回復準確性都有所提高,并最終達到一個上限。這對于中文簡短問答來說是合理的,因為它專門用于探測模型知識的邊界。

3.3.3檢索增強生成(RAG)效果分析

圖片

圖片

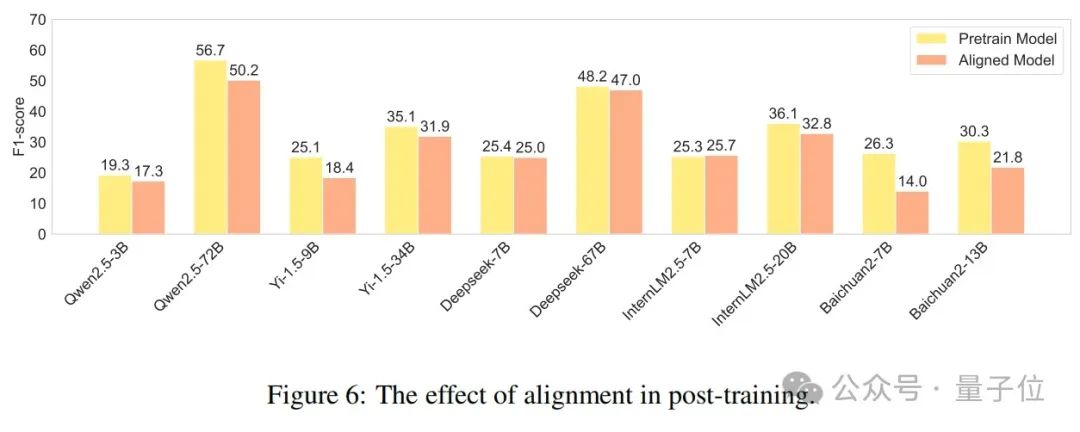

在這項研究中,論文探索了檢索增強生成(RAG)策略在提高大語言模型在中文簡短問答數據集上的事實準確性方面的有效性。具體來說,作者基于LlamaIndex重現了一個RAG系統,并整合了谷歌搜索API。如圖5所示,所有模型在使用RAG后準確性都有顯著提高。例如,Qwen2.5-3B的性能提高了三倍多。值得注意的是,幾乎所有使用RAG的模型都優于原生的GPT-4o模型。同時,RAG的應用也顯著降低了模型之間的性能差距。例如,使用RAG的Qwen2.5-3B與使用RAG的Qwen2.5-72B之間的F分數差異僅為6.9%。這表明RAG大大縮小了模型之間的性能差距,使較小的模型在使用RAG增強時也能實現高性能。總體而言,這表明RAG是提高大語言模型真實性的有效捷徑。

圖片

圖片

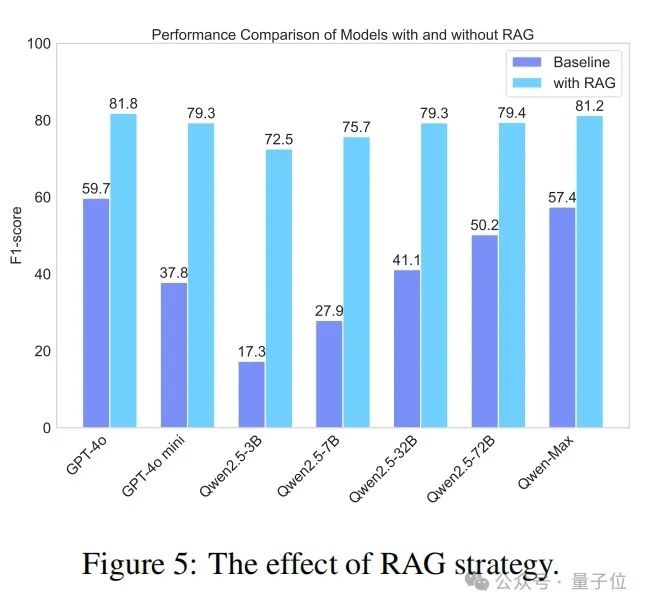

3.3.4對齊代價分析

最近,先前的研究(OpenAI,2023;Song等人,2023)發現,對齊可能會導致語言模型能力的下降,即所謂的“對齊代價”。為了說明對齊對真實性的影響,作者對預訓練模型和經過監督微調(SFT)或強化學習從人類反饋(RLHF)訓練的對齊模型進行了比較性能分析。如圖6所示,不同模型在訓練后表現出不同的趨勢,但大多數模型都有顯著下降。其中,Baichuan2系列模型下降最為顯著,Baichuan2-7B和Baichuan2-13B的F分數分別降低了47%和28%。這反映出當前大多數大語言模型的對齊訓練在產生知識幻覺方面仍然存在明顯缺陷,這進一步反映了此次數據集的必要性。

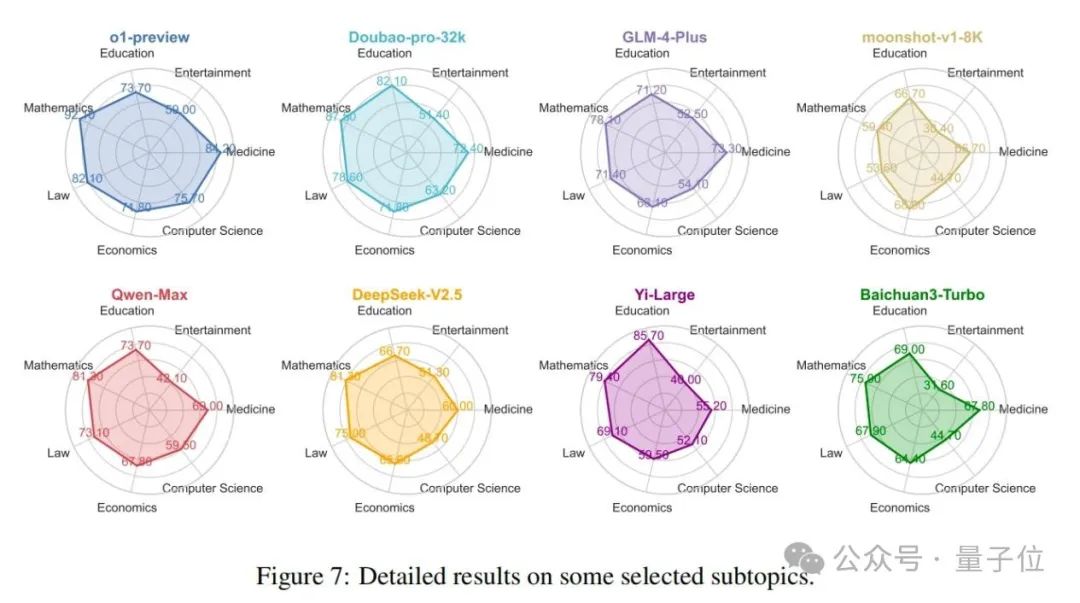

3.3.5子主題結果分析

如2.2節所述,該基準涵蓋了總共99個子主題,可以全面檢測模型在各個領域的知識水平。圖7展示了o1模型和七個著名的中文社區模型在幾個常見領域內的性能比較。首先,從整體上看,o1-preview模型在這些領域中表現出最全面的性能,Doubao模型緊隨其后。相比之下,Moonshot模型總體性能最弱。其次,在具體領域方面,中文社區模型和o1模型在計算機科學和醫學等領域存在顯著差距。然而,在教育和經濟等領域,這種差距最小。值得注意的是,在教育領域,一些中文社區模型優于o1-preview,突出了它們在特定垂直領域取得成功的潛力。最后,在具體模型方面,Moonshot模型在數學、法律和娛樂等領域明顯較弱,而Baichuan模型在娛樂領域也表現不佳。Yi-Large模型在教育領域表現出色,o1模型在其他領域保持最強性能。評估模型在基準數據集內不同領域的性能使用戶能夠確定最適合其特定需求的模型。

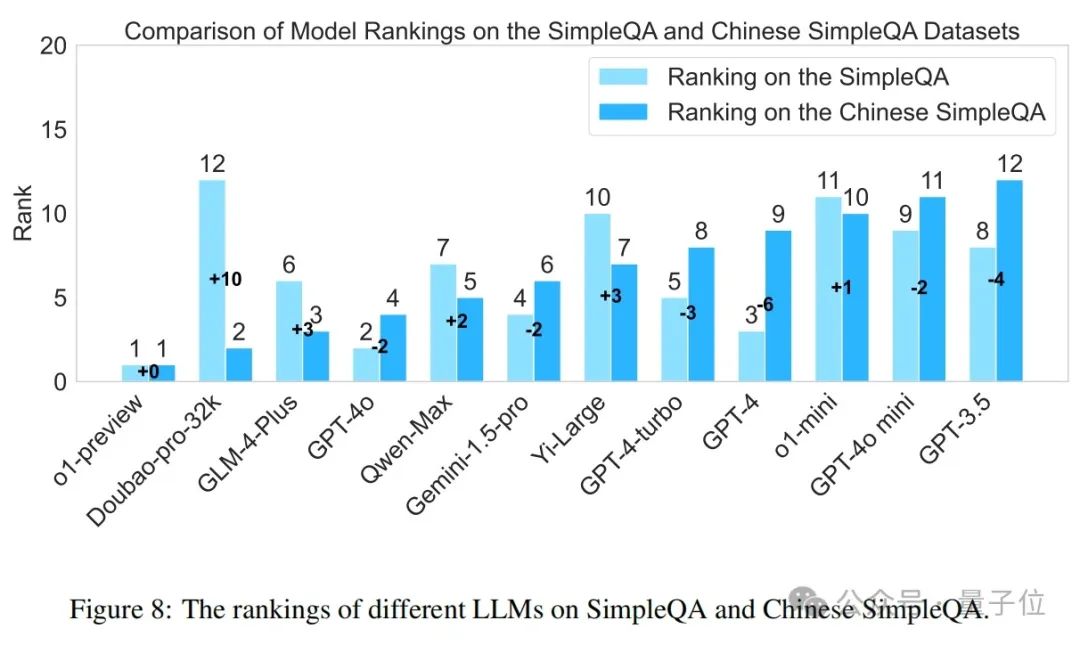

3.3.6中文簡短問答與SimpleQA的比較

圖片

圖片

論文還比較了各種模型在SimpleQA和中文簡短問答上的排名差異。如圖8所示,這些兩個基準上的模型性能存在顯著差異。例如,Doubao-pro-32k在中文簡短問答上的排名顯著提高,從第12位上升到第2位(+10)。相反,GPT-4在中文簡短問答上的性能下降,從第3位下降到第9位(-6)。這些差異強調了在不同語言的數據集上評估模型的重要性,以及研究優化模型在不同語言環境中性能的必要性。值得注意的是,o1-preview在兩個數據集上始終保持領先地位,表明其對不同語言上下文的穩健性和適應性。此外,大多數中文社區開發的模型(如Qwen-Max、GLM-4-Plus、Yi-Large、Doubao-pro-32k)在SimpleQA上的表現優于在簡短問答上的表現,展示了它們在中文任務上的競爭力。

4.相關工作

-大語言模型真實性:大語言模型真實性是指大語言模型產生遵循事實內容的能力,包括常識、世界知識和領域事實,并且這些事實內容可以通過權威來源(如維基百科、教科書)得到證實。最近的作品探索了大語言模型作為事實知識庫的潛力(Yu等人,2023;Pan等人,2023)。具體而言,現有研究主要集中在對大語言模型真實性的定性評估(Lin等人,2022;Chern等人,2023)、對知識存儲機制的研究(Meng等人,2022;Chen等人,2023)以及對知識相關問題的分析(Gou等人,2023)。

-真實性基準:已經提出了許多真實性基準(Hendrycks等人,2021;Zhong等人,2023;Huang等人,2023;Li…等人,2023b;Srivastava等人,2023;Yang等人,2018)。例如,MMLU(Hendrycks等人,2021)用于測量在各種不同任務上的多任務準確性。TruthfulQA(Lin等人,2022)專注于評估語言模型生成答案的真實性。此外,HaluEval(Li等人,2023c)用于檢查大語言模型產生幻覺的傾向。最近,SimpleQA(Wei等人,2024)被提出用于測量大語言模型中的簡短事實性。然而,SimpleQA僅關注英語領域。相比之下,中文簡短問答旨在全面評估中文語境下的真實性。

結論

為了評估現有大語言模型的真實性能力,淘天集團的研究者們提出了第一個中文簡短事實性基準(即中文簡短問答),它包括6個主要主題和99個子主題。此外,中文簡短問答主要具有五個重要特征(即中文、多樣性、高質量、靜態和易于評估)。基于中文簡短問答,研究人員全面評估了現有40多個大語言模型在真實性方面的性能,并提供了詳細分析,以證明中文簡短問答的優勢和必要性。在未來,研究人員將研究提高大語言模型的真實性,并探索將中文簡短問答擴展到多語言和多模態設置。