從本地部署到企業級服務:十種主流LLM推理框架的技術介紹與對比

大語言模型(Large Language Models, LLMs)的部署是一項具有技術挑戰性的工作。隨著模型架構日益復雜,以及硬件需求不斷提升,部署過程變得愈發復雜。業界已經發展出多種解決方案,使LLM的部署和擴展變得更加便捷。從適用于個人開發的輕量級本地部署工具,到面向企業級高性能生產環境的推理引擎,各類解決方案能夠滿足不同場景的需求。

本文將深入探討十種主流LLM服務引擎和工具,系統分析它們在不同應用場景下的技術特點和優勢。無論是在消費級硬件上進行模型實驗的研究人員,還是在生產環境中部署大規模模型的工程團隊,都能從中找到適合的技術方案。

1、WebLLM

WebLLM是一個基于瀏覽器的高性能LLM推理引擎,其核心特性是利用WebGPU進行硬件加速。這使得Llama 3等大規模模型能夠直接在瀏覽器環境中運行,無需服務器端支持。該架構在保證AI交互實時性的同時,通過模塊化設計確保了數據隱私和計算效率。

技術特性

- WebGPU加速計算:利用瀏覽器原生的WebGPU能力實現模型加速

- API兼容性:完整實現OpenAI API規范,支持無縫集成

- 實時數據流:支持流式響應和結構化JSON生成

- 模型適配:廣泛支持Llama、Phi、Gemma等主流模型架構

- 自定義模型集成:通過MLC格式支持模型定制

- 并行計算優化:集成Web Worker和Service Worker提升性能

- 瀏覽器擴展性:支持Chrome擴展開發

技術優勢分析

- 無服務器架構:消除了服務器部署和維護成本

- 端側計算:通過客戶端計算保障數據隱私

- 跨平臺兼容:基于Web標準實現多平臺支持

技術局限性

- 模型支持受限:僅支持適配瀏覽器環境的模型

- 計算能力約束:受限于客戶端硬件性能

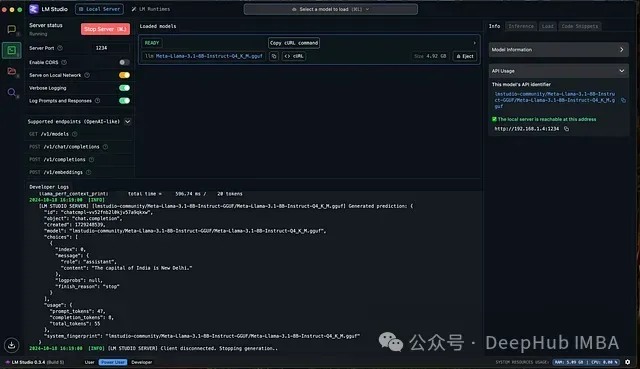

2、LM Studio

LM Studio是一個功能完備的本地化LLM運行環境,支持在本地設備上完全離線執行大語言模型。該框架適配多種硬件配置,并提供模型實驗和配置功能。通過集成用戶友好的對話界面和OpenAI兼容的本地服務器,LM Studio為開發者提供了靈活的模型集成和實驗環境。

技術實現細節

LM Studio通過llama.cpp實現了在Mac、Windows和Linux平臺上的模型執行。在搭載Apple Silicon的Mac設備上,還可以通過Apple的ML Compute框架(_MLX_)進行模型運行,充分利用了Apple芯片的AI加速能力。

核心功能架構

- 離線計算引擎:實現本地化模型執行,無需網絡連接

- 結構化輸出系統:支持規范化的JSON格式數據生成

- 多模型并行:支持多個模型的同時運行和任務并行處理

- 文檔交互功能:通過內置UI實現本地文檔的智能交互(v0.3新增)

- API兼容層:提供OpenAI兼容的本地服務接口

- 模型管理系統:集成Hugging Face生態,簡化模型獲取和管理流程

LM Studio技術優勢

- 本地化推理:提供高速的設備端推理能力,完全離線的GUI操作界面

- 模型資源管理:與Hugging Face平臺深度集成,實現高效的模型管理

- 雙模交互接口:同時提供對話界面和本地API服務

- 計算資源調度:支持多模型的并行計算和資源調度

技術限制

- 部署范圍受限:僅支持桌面環境,不適用于生產級部署

- 模型兼容性:部分模型架構需要額外適配

- 資源需求:大型模型運行需要較高的系統資源配置

- 性能依賴:計算性能受本地硬件條件限制

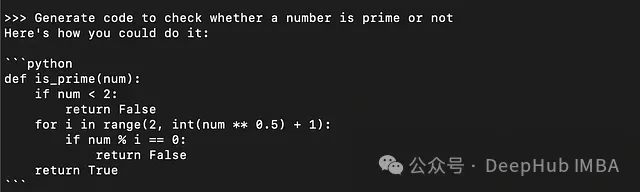

3、 Ollama

Ollama是一個開源的輕量級LLM服務框架,專注于本地推理能力的實現。其核心設計理念是通過本地化部署提升數據隱私保護和降低推理延遲。該框架為開發者和組織提供了完整的模型管理和推理服務能力,特別適合對數據安全性要求較高的應用場景。

核心技術特性

- 本地推理引擎:實現高效的本地模型推理,優化延遲表現

- 模型生命周期管理:提供完整的模型加載、卸載和切換功能

- 服務接口設計:實現簡潔的API架構,便于應用集成

- 多平臺兼容性:支持主流操作系統,提供統一的運行環境

- 參數配置系統:支持靈活的模型參數調整和行為定制

技術優勢

- 部署便捷性:簡化的安裝和配置流程

- 應用適配性:適合中小規模項目快速落地

- 模型生態支持:預置多種常用模型支持

- 接口集成性:提供命令行和API雙重接入方式

- 配置靈活性:支持模型參數的實驗和優化

技術局限

- 模型支持范圍:受限于Ollama官方支持的模型

- 硬件依賴性:性能受限于本地計算資源

- 擴展性限制:相比專業推理引擎,在大規模應用場景下的擴展能力有限

部署示例

以下是Ollama的基本部署和使用流程:

# 啟動Ollama推理服務

ollama serve

# 拉取指定模型

ollama pull granite-code:8b

# 查看已安裝模型列表

ollama list

# 運行模型服務

ollama run granite-code:8b

4、vLLM

vLLM(Virtual Large Language Model)是一個專注于高性能推理和服務的開源框架。其核心創新在于PagedAttention技術的應用,實現了高效的內存管理機制。通過連續批處理技術優化GPU利用率,并支持多種量化方法提升推理性能。該框架與OpenAI API兼容,并與Hugging Face生態系統實現了深度集成。

核心技術組件

- PagedAttention內存管理:優化注意力機制的內存使用效率

- 連續批處理系統:實現請求的動態批處理

- 量化加速引擎:支持多種精度的模型量化

- API適配層:提供OpenAI兼容的接口規范

- 分布式計算框架:支持張量并行和流水線并行的分布式推理

- CUDA優化:集成FlashAttention和FlashInfer等高性能CUDA核心

- 模型生態支持:全面支持主流開源模型,包括:

- Transformer架構LLMs(如Llama)

- 混合專家模型(如Mixtral)

- 嵌入模型(如E5-Mistral)

- 多模態LLMs(如Pixtral)

vLLM技術優勢分析

vLLM框架在設計上充分考慮了生產環境的需求,具有顯著的技術優勢:

- 生產級性能表現:通過深度優化的推理引擎,實現了業界領先的吞吐量和響應速度

- 架構適應性:靈活支持多種模型架構,便于在不同應用場景中部署

- 開源生態優勢:基于開源架構,支持社區貢獻和持續優化

- 并發處理能力:優秀的多請求并發處理機制,保證服務穩定性

- 內存效率:通過優化的內存管理,支持在有限硬件資源上運行大規模模型

技術實現細節

以下是vLLM框架在實際應用中的典型實現示例,展示了其在多模態場景下的部署方法:

from vllm import LLM

from vllm.sampling_params import SamplingParams

# 初始化模型配置

model_name = "mistralai/Pixtral-12B-2409"

max_img_per_msg = 2

# 設置采樣參數

sampling_params = SamplingParams(max_tokens = 2048)

# 初始化LLM實例,配置關鍵參數

llm = LLM(

model = model_name,

tokenizer_mode = "mistral", # 指定分詞器模式

load_format = "mistral", # 設置加載格式

config_format = "mistral", # 配置文件格式

dtype = "bfloat16", # 設置計算精度

max_model_len = 8192, # 最大模型長度

gpu_memory_utilization = 0.95, # GPU內存利用率

limit_mm_per_prompt = {"image": max_img_per_msg}, # 多模態限制

)

# 設置圖像處理參數

image_url = "deephub.jpg"

# 構建多模態消息結構

messages = [

{

"role": "user",

"content": [

{"type": "text", "text": "Extract the company name conducting hackathon and then generate a catchy social media caption for the image. Output in JSON format."},

{"type": "image_url", "image_url": {"url": image_url}}

]

}

]

# 執行模型推理

res = llm.chat(messages=messages, sampling_params=sampling_params)

print(res[0].outputs[0].text)HTTP服務部署

vLLM提供了完整的HTTP服務器實現,支持OpenAI的Completions和Chat API規范。對于Pixtral等視覺-語言模型,服務器完全兼容OpenAI Vision API標準。以下是部署流程:

# 啟動服務器實例

vllm serve mistralai/Pixtral-12B-2409 --tokenizer_mode mistral --limit_mm_per_prompt 'image=2'

# API調用示例

curl --location 'http://localhost:8000/v1/chat/completions' \

--header 'Content-Type: application/json' \

--data '{

"model": "mistralai/Pixtral-12B-2409",

"messages": [

{

"role": "user",

"content": [

{"type" : "text", "text": "Describe the content of this image in detail please."},

{"type": "image_url", "image_url": {"url": "https://s3.amazonaws.com/cms.ipressroom.com/338/files/201808/5b894ee1a138352221103195_A680%7Ejogging-edit/A680%7Ejogging-edit_hero.jpg"}}

]

}

]

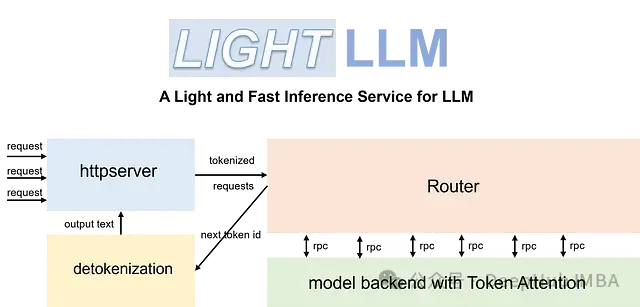

}'5、LightLLM

LightLLM是一個基于Python的高效推理框架,其設計融合了FasterTransformer、TGI、vLLM和FlashAttention等成熟開源實現的優勢。該框架通過創新的系統架構優化了GPU利用率和內存管理,適用于開發和生產環境。

核心技術架構

LightLLM的架構設計基于以下關鍵技術組件:

1.異步協作處理系統:

- 實現分詞、模型推理和解碼的異步執行

- 顯著提升GPU利用效率

- 優化計算資源分配

2.注意力機制優化:

- 實現Nopad(無填充)注意力操作

- 高效處理長度差異顯著的請求

- 支持跨模型的注意力計算優化

3.動態批處理引擎:

- 實現請求的動態調度系統

- 優化計算資源使用效率

- 支持靈活的批處理策略

4.內存管理系統:

- 實現基于Token的KV緩存管理

- 確保推理過程中的零內存浪費

- 提供精細化的GPU內存管理

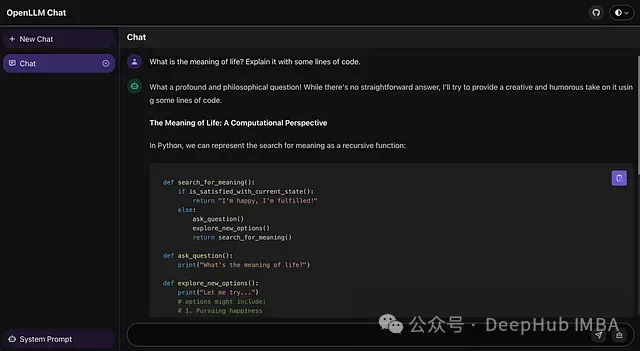

6、OpenLLM

OpenLLM是一個為大語言模型自托管設計的綜合性平臺,其核心優勢在于簡化了大規模語言模型的部署流程。系統實現了對Llama、Qwen、Mistral等主流開源模型的標準化支持,并提供了與OpenAI兼容的API接口。通過與Docker、Kubernetes和BentoCloud的深度集成,OpenLLM建立了一個完整的模型部署和管理生態系統。

系統架構設計

OpenLLM的系統架構基于以下幾個核心層次:

1.模型服務層

- 實現單命令模型部署功能

- 提供標準化的模型加載和初始化流程

- 支持模型運行時的動態配置

2.API兼容層

- 實現OpenAI API規范

- 提供統一的接口調用標準

- 支持多種開發框架的集成需求

3.部署管理層

- 集成容器化部署支持

- 實現Kubernetes編排能力

- 提供云平臺部署接口

4.交互界面層

- 實現Web化的交互界面

- 提供模型調試和測試功能

- 支持實時對話能力

技術實現示例

以下代碼展示了OpenLLM的基本部署和使用流程:

from langchain_community.llms import OpenLLM

# 初始化LLM服務實例

llm = OpenLLM(server_url='http://localhost:3000')

# 執行模型推理

result = llm.invoke("Which is the largest mammal in the world?")部署流程

# 通過包管理器安裝

pip install openllm

# 啟動本地服務

openllm serve llama3.1:8b-4bit系統將自動在http://localhost:3000/chat地址提供Web交互界面。

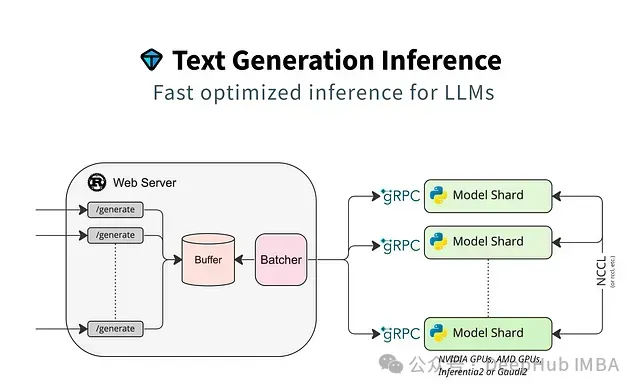

7. HuggingFace TGI

HuggingFace Text Generation Inference (TGI)是一個專為大規模文本生成任務優化的推理框架。該框架在設計時特別關注了推理性能和資源效率,通過深度優化實現了低延遲的文本生成能力。TGI與Hugging Face的模型生態系統緊密集成,為開發者提供了完整的模型部署解決方案。

核心技術組件

1.推理引擎優化

- 專門針對大規模文本生成任務進行優化

- 實現低延遲的推理處理

- 支持高并發請求處理

2.模型支持系統

- 支持Hugging Face模型庫中的主流模型

- 包括GPT、BERT等架構

- 提供自定義模型支持能力

3.資源調度系統

- 實現GPU資源的高效調度

- 支持多模型并行服務

- 提供自動擴縮容能力

4.可觀測性支持

- 集成Open Telemetry分布式追蹤

- 提供Prometheus指標支持

- 實現完整的監控體系

模型部署示例

以下代碼展示了使用transformers部署TGI服務的過程:

import transformers

import torch

# 配置模型參數

model_id = "meta-llama/Meta-Llama-3.1-70B-Instruct"

# 初始化推理管道

pipeline = transformers.pipeline(

"text-generation",

model=model_id,

model_kwargs={"torch_dtype": torch.bfloat16},

device_map="auto", # 自動設備映射

)

# 構建對話消息

messages = [

{"role": "system", "content": "You are a wise sage who answers all questions with ancient wisdom."},

{"role": "user", "content": "What is the meaning of life?"},

]

# 執行推理

outputs = pipeline(

messages,

max_new_tokens=256,

)

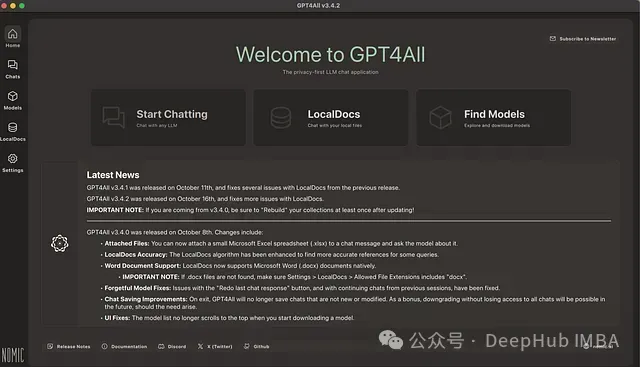

print(outputs[0]["generated_text"][-1])8、GPT4ALL

GPT4ALL是Nomic開發的一個綜合性框架,它既包含了模型系列,也提供了完整的本地訓練和部署生態系統。該框架的核心設計理念是實現高效的本地設備推理,同時確保數據隱私安全。系統通過集成Nomic的嵌入模型技術,實現了本地文檔的智能交互能力。

技術架構特點

1.本地計算引擎

- 支持CPU和GPU的本地推理能力

- 實現完全離線的模型執行

- 優化的資源調度機制

2.數據安全機制

- 全本地化的數據處理流程

- 端到端的隱私保護設計

- 安全的文檔交互系統

3.文檔處理系統

- 支持PDF、TXT等多種格式

- 實現文檔信息的智能提取

- 本地化的文檔索引機制

開發接口實現

以下代碼展示了GPT4ALL的Python SDK使用方法:

from gpt4all import GPT4All

# 初始化模型(自動下載并加載4.66GB的LLM)

model = GPT4All("Meta-Llama-3-8B-Instruct.Q4_0.gguf")

# 創建對話會話

with model.chat_session():

# 執行模型推理,設置最大token數

response = model.generate(

"How does transfer learning work in image classification?",

max_tokens=512

)9、llama.cpp

llama.cpp是一個高度優化的C/C++實現,專注于本地LLM推理性能的優化。該框架與GGML庫深度集成,為多個LLM工具和應用提供了基礎運行時支持。系統通過多種優化技術,實現了在不同硬件平臺上的高效運行。

核心技術特性

1.計算優化系統

- 無外部依賴的獨立實現

- 針對ARM和x86架構的特定優化

- 支持Apple Silicon原生加速

2.量化處理引擎

- 支持1.5位到8位的整數量化

- 靈活的精度配置選項

- 內存使用優化機制

3.多語言綁定支持

- 提供Python、Go、Node.js等語言接口

- 統一的API設計

- 跨平臺兼容性支持

部署實現示例

from llama_cpp import Llama

# 初始化模型實例

llm = Llama(model_path="./path/model.gguf")

# 執行模型推理

output = llm(

"What is artificial intelligence?",

max_tokens=100, # 控制生成長度

stop=["\n"], # 設置停止條件

echo=True # 在輸出中包含輸入提示

)

# 獲取生成結果

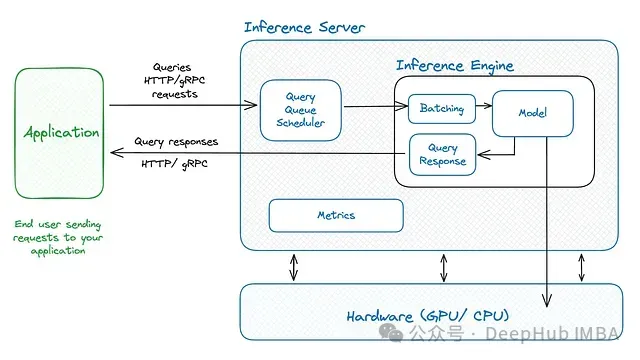

response = output["choices"][0]["text"].strip()10、Triton Inference Server與TensorRT-LLM

NVIDIA的Triton Inference Server配合TensorRT-LLM,構建了一個完整的企業級模型部署方案。該系統通過深度優化,實現了LLM在生產環境中的高性能服務能力。

系統核心組件

1.模型優化引擎

- TensorRT-LLM模型編譯優化

- 針對推理性能的專項優化

- 高效的計算圖優化

2.內存管理系統

- 分頁注意力機制

- 高效的KV緩存實現

- 優化的內存分配策略

3.請求調度系統

- 動態批處理機制

- 智能的負載均衡

- 資源動態分配

4.監控與度量系統

- 詳細的GPU使用監控

- 服務性能指標采集

- 系統資源使用追蹤

技術優勢

1.性能優化

- 顯著提升推理速度

- 優化的響應延遲

- 高效的資源利用

2.擴展能力

- 多GPU橫向擴展

- 節點間負載均衡

- 集群化部署支持

技術總結

大語言模型服務部署方案的選擇需要綜合考慮以下關鍵因素:

- 部署場景:從個人開發環境到企業級生產系統,選擇合適的部署方案。

- 性能需求:根據延遲、吞吐量等指標選擇最適合的技術框架。

- 資源約束:考慮硬件資源限制,選擇合適的優化策略。

- 開發難度:評估團隊技術能力,選擇適合的實現方案。

- 維護成本:考慮長期運維和升級的技術投入。

通過深入理解各個框架的技術特點和適用場景,開發團隊可以根據具體需求選擇最適合的部署方案,實現大語言模型的高效服務。