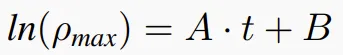

LLM最大能力密度100天翻一倍!清華劉知遠團隊提出Densing Law

支持大模型一路狂飆的 Scaling Law 到頭了?

近期,AI 圈針對 Scaling Law 是否到頭產生了分歧。一派觀點認為 Scaling Law 已經「撞墻」了,另一派觀點(如 OpenAI CEO Sam Altman)仍然堅定 Scaling Law 的潛力尚未窮盡。

其實以上爭論的核心點在于,大模型的性能提升是否還能繼續(xù)靠無限堆疊數據和參數規(guī)模從而大力出奇跡。

然而 Scaling Law 并非唯一的視角,近期,來自清華大學劉知遠教授團隊發(fā)現并提出大模型的密度定律(Densing Law)—— 模型能力密度隨時間呈指數級增長,2023 年以來能力密度約每 3.3 個月(約 100 天) 翻一倍。這意味著每 100 天,我們可以用一半參數量實現當前最優(yōu)模型相當的性能。

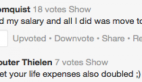

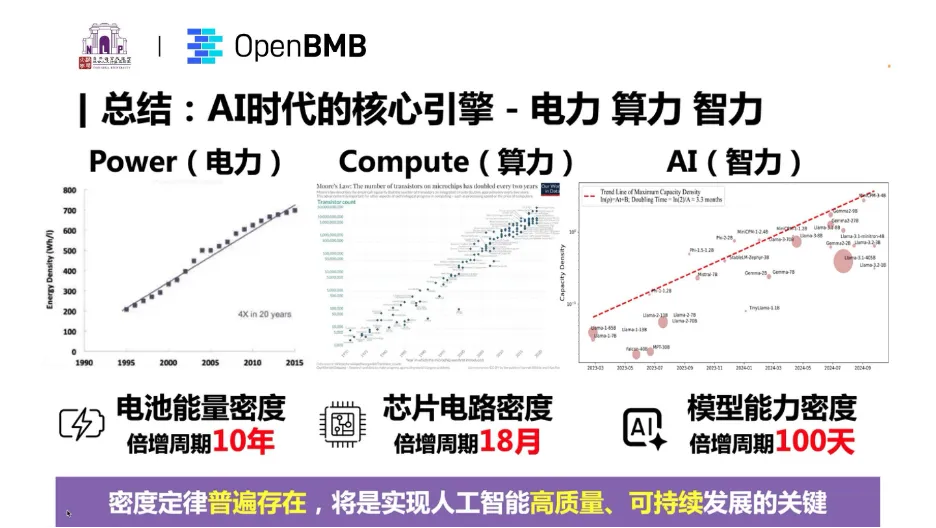

根據密度定律,研究團隊還得出以下重要推論,并且發(fā)現 AI 時代的三大核心引擎——電力、算力與智力,都同樣遵循密度快速增長趨勢。

- 推論 1 :模型推理開銷隨時間指數級下降。

- 推論 2 :大模型能力密度正在加速增強 。

- 推論 3:模型小型化揭示端側智能巨大潛力 。

- 推論 4:無法依靠模型壓縮算法增強模型能力密度 。

- 推論 5:模型高性價比有效期不斷縮短。

該定律還揭示了端側智能的巨大潛力,并指出未來應持續(xù)探索大模型科學化建設路徑,不斷改進模型制造工藝,實現大模型的高質量、可持續(xù)發(fā)展。

相關研究成果可參考論文《Densing Law of LLMs》。

- 論文標題:Densing Law of LLMs

- 論文鏈接:https://arxiv.org/pdf/2412.04315v2

Scaling Law 和 Densing Law

大模型尺度定律(Scaling Law)和密度定律(Densing Law),都是大模型指導性的規(guī)律發(fā)現。它們分別在不同的維度,對大模型進行科學化的推演。

大模型尺度定律是一種描述大模型隨著規(guī)模的變化而發(fā)生的規(guī)律性變化的數學表達,表現為大模型的 Loss 與模型參數規(guī)模、訓練數據規(guī)模之間的冪律關系。

尺度定律之外,清華研究團隊發(fā)現,大模型還有另一種度量與優(yōu)化的空間,能力密度(Capability Density),它為評估不同規(guī)模 LLM 的訓練質量提供了新的統(tǒng)一度量框架。

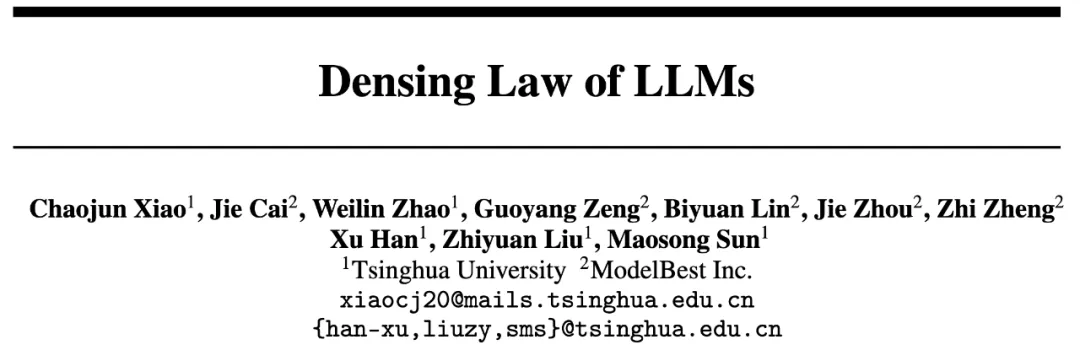

清華研究團隊提出的「能力密度」(Capability Density),定義為給定 LLM 的有效參數大小與實際參數大小的比率。有效參數大小指的是達到與目標模型同等性能所需的參考模型的參數數量。清華研究團隊特別引入了參考模型(Reference Model)的概念,通過擬合參考模型在不同參數規(guī)模下的性能表現,建立起參數量與性能之間的映射關系。

具體來說,若一個目標模型 M 的參數量為 N_M ,其在下游任務上的性能分數為 S_M,研究人員會計算出參考模型要達到相同性能所需的參數量 N (S_M),即「有效參數量」。目標模型 M 的密度就定義為這個「有效參數量」與其實際參數量的比值: 比如一個 3B 的模型能達到 6B 參考模型的性能,那么這個 3B 模型的能力密度就是 2(6B/3B)。

比如一個 3B 的模型能達到 6B 參考模型的性能,那么這個 3B 模型的能力密度就是 2(6B/3B)。

為了準確估計模型性能,研究團隊采用了兩步估計法。第一步是損失(Loss)估計,通過一系列不同規(guī)模的參考模型來擬合參數量與語言模型 Loss 之間的關系;第二步是性能估計,考慮到涌現能力的存在,研究人員結合開源模型來計算它們的損失和性能,最終建立起完整的映射關系。

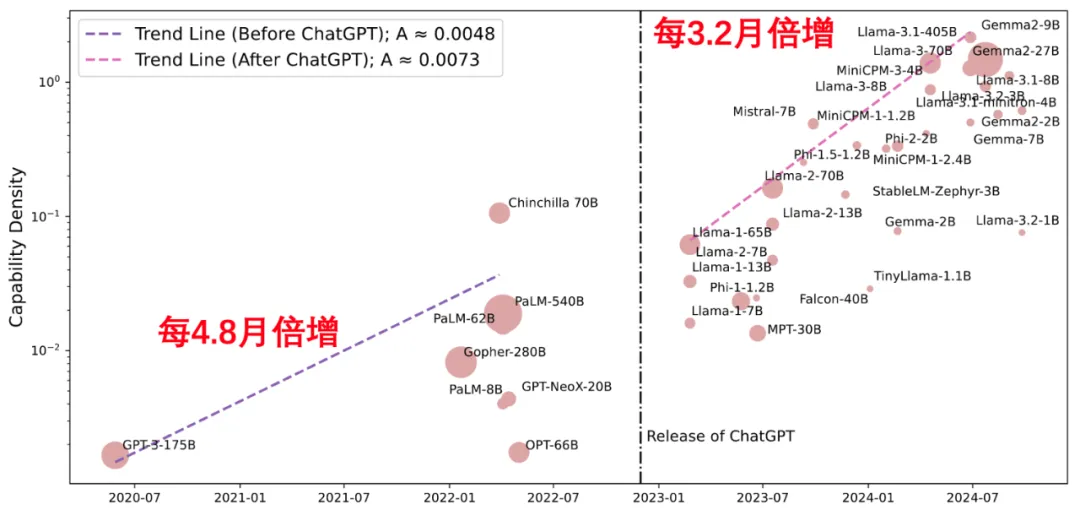

通過研究分析近年來 29 個被廣泛使用的開源大模型,清華研究團隊發(fā)現,LLM 的最大能力密度隨時間呈指數增長趨勢,可以以下公式來描述,其中 ρ_max 是時間 t 時 LLM 的最大能力密度。

密度定律表明,大約每過 3.3 個月 (100 天),我們就能用參數量減半的模型達到當前最先進模型的性能水平。

基于密度定律,清華研究團隊提出了多個重要推論。

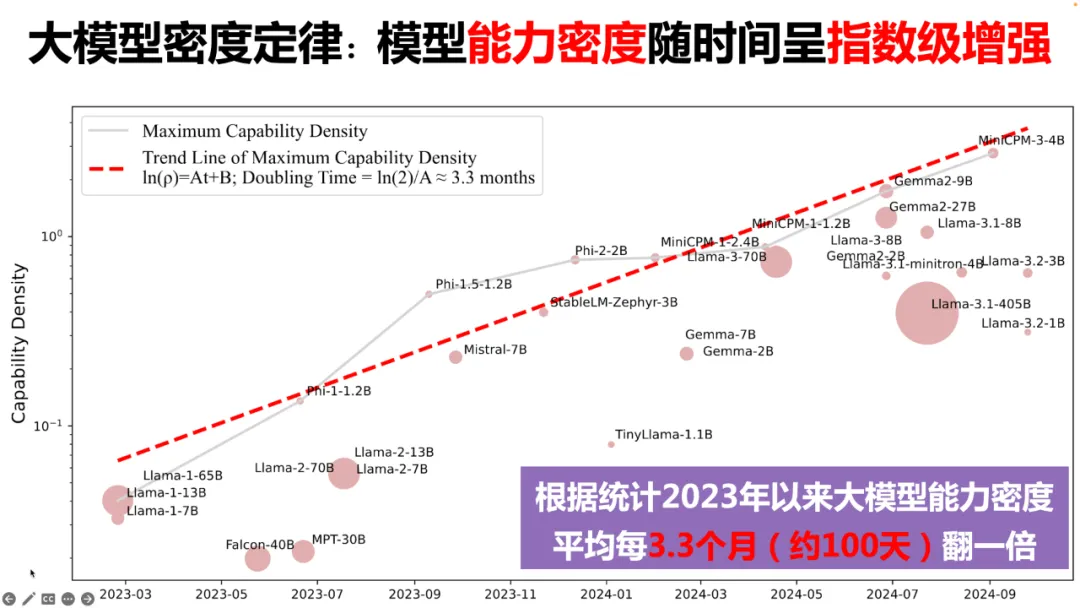

首先,模型推理開銷隨時間指數級下降。2022 年 12 月的 GPT-3.5 模型每百萬 Token 的推理成本為 20 美元,而 2024 年 8 月的 Gemini-1.5-Flash 模型僅為 0.075 美元,成本降低了 266 倍,約 2.5 個月下降一倍。與此同時,大模型推理算法不斷取得新的技術突破:模型量化、投機采樣、顯存優(yōu)化 。

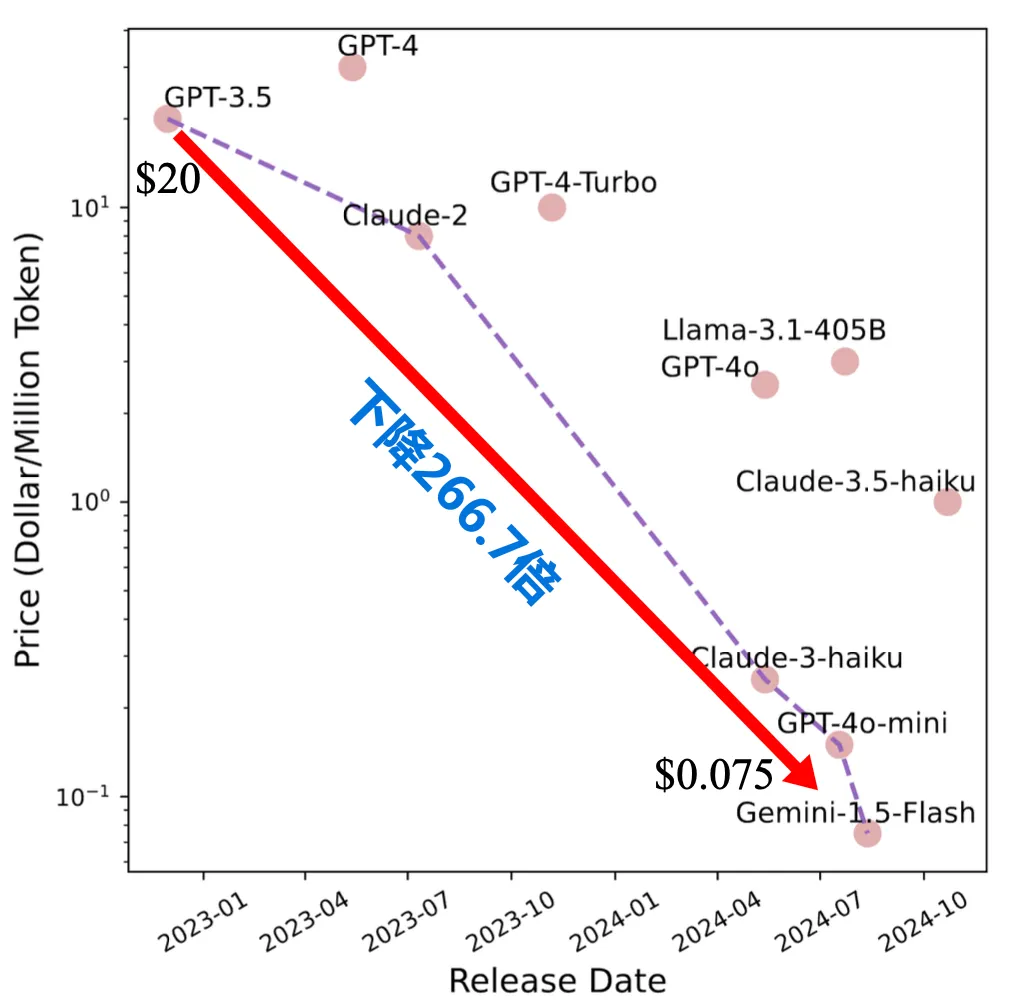

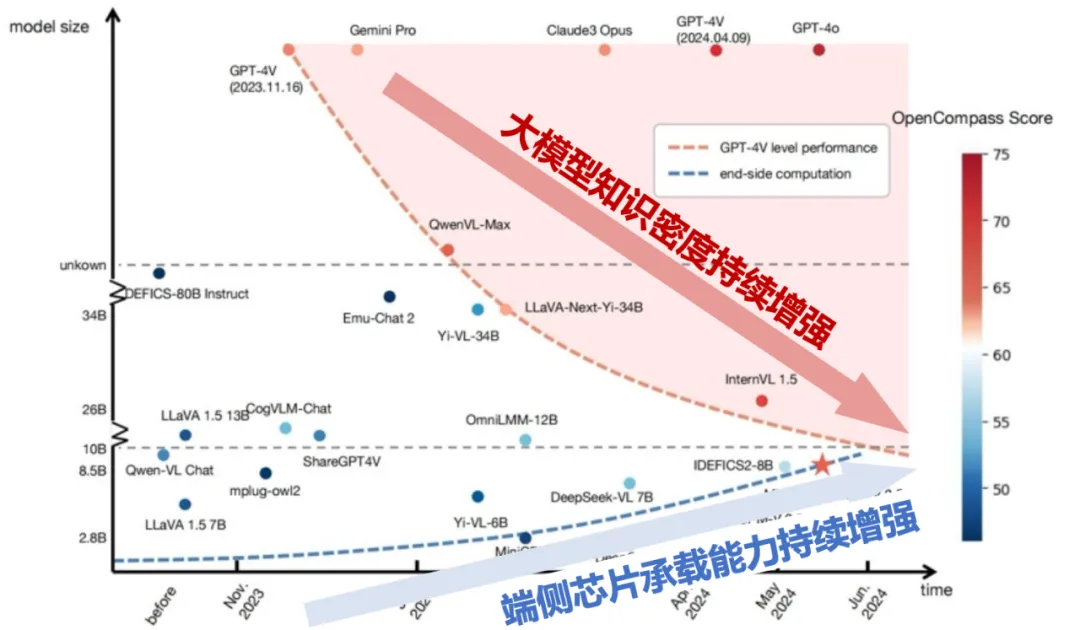

其次,研究還發(fā)現,自 ChatGPT 發(fā)布以來,大模型能力密度正在加速增強 。

以 MMLU 為評測基準測量的能力密度變化情況,ChatGPT 發(fā)布前按照每 4.8 月倍增,發(fā)布后按照每 3.2 月倍增,密度增強速度增加 50% 。這一現象背后,更高效模型引起了學術界和產業(yè)的廣泛關注,誕生了更多高質量開源模型。

再次,芯片電路密度 (摩爾定律) 和模型能力密度 (密度定律) 持續(xù)增強,兩條曲線交匯揭示端側智能巨大潛力。研究顯示,在摩爾定律的作用下,相同價格芯片的計算能力每 2.1 年翻倍,而密度法則表明模型的有效參數規(guī)模每 3.3 個月翻倍。兩條曲線的交匯,意味著主流終端如 PC、手機將能運行更高能力密度的模型,推動端側智能在消費市場普及。

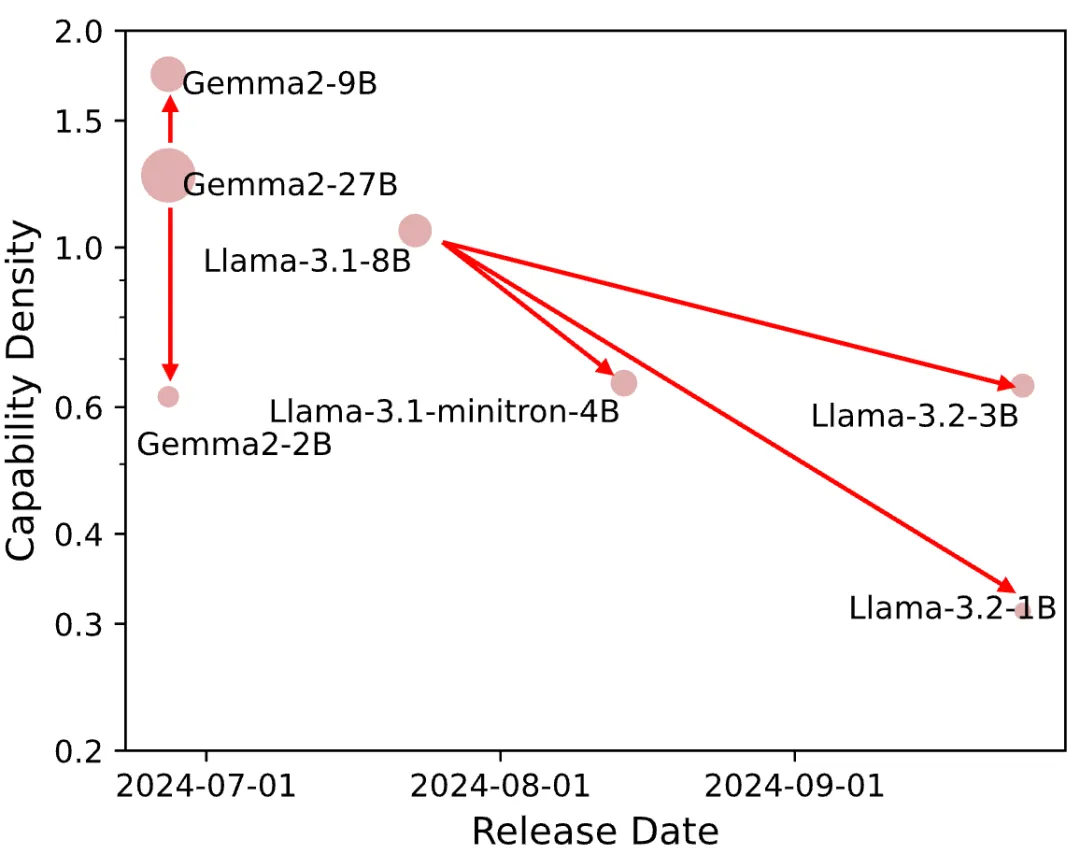

此外,團隊指出,無法僅依靠模型壓縮算法增強模型能力密度 。現有的模型壓縮技術(如剪枝和蒸餾)未必能提高模型密度。實驗表明,大多數壓縮模型的密度低于原始模型,模型壓縮算法雖可以節(jié)省小參數模型構建開銷,但是如果后訓練不充分,小參數模型能力密度將會有顯著下降。

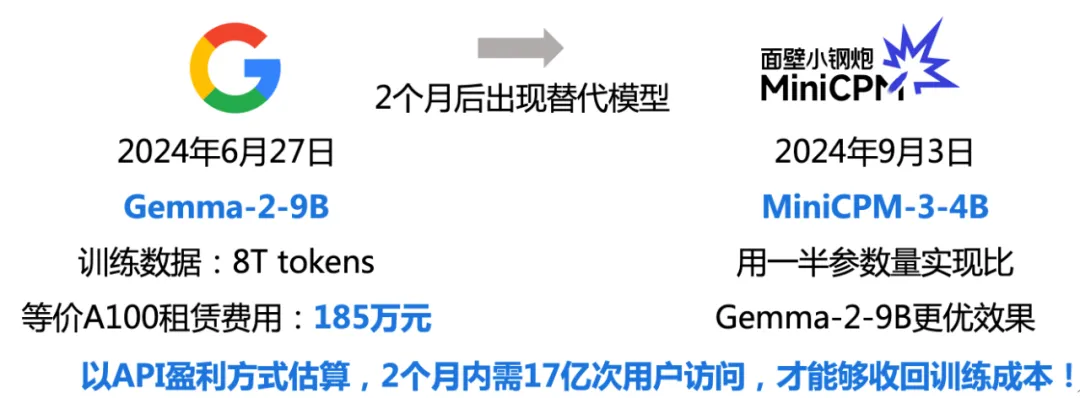

最后,研究團隊指出,模型高性價比有效期不斷縮短。根據尺度定律,更多數據 + 更多參數實現能力增強,訓練成本會急劇上升;而能力密度定律,隨著能力密度加速增強,每隔數月會出現更加高效的模型。這意味著模型高性價比的有效使用期縮短,盈利窗口短暫。例如,2024 年 6 月發(fā)布的 Google Gemma-2-9B 模型,其訓練成本約 185 萬人民幣,但僅兩個月后,它的性能就被參數量減半的 MiniCPM-3-4B 超越。以 API 盈利方式估算,2 個月內需要 17 億次用戶訪問,才能夠收回訓練成本!

Densing Law(密度定律)揭示 LLM 進入「密度至上」新發(fā)展階段

尺度定律下,LLM 規(guī)模至上。而在密度定律下,LLM 正進入一個全新的發(fā)展階段。在清華劉知遠老師最新報告中,AI 時代的三大核心引擎 —— 電力、算力與智力,密度都在快速增長:電池能量密度在過去 20 年中增長了 4 倍,其倍增周期約為 10 年;摩爾定律則揭示,芯片的晶體管密度每 18 個月翻倍;而 AI 模型能力密度每 100 天翻倍的速度更是驚人。

尤其是模型能力密度的提升也意味著用更少的資源實現更強的能力,這不僅降低了 AI 發(fā)展對能源和算力的需求,也為 AI 技術的可持續(xù)發(fā)展提供了無限可能。同時也揭示了端側智能的巨大潛力 。

在這一趨勢下,AI 計算從中心端到邊緣端的分布式特性協(xié)同高效發(fā)展,將實現「AI 無處不在」的愿景。隨著全球 AI 計算云端數據中心、邊緣計算節(jié)點的擴張,加上模型能力密度增長帶來的效率提升,我們將看到更多本地化的 AI 模型涌現,云端和邊緣端各司其職,可運行 LLM 的終端數量和種類大幅增長,「AI 無處不在」的未來正在到來。