ICLR 2025 Spotlight |「免費(fèi)」多模態(tài)信息助力3D小樣本分割

該文章的第一作者安照崇,目前在哥本哈根大學(xué)攻讀博士學(xué)位,導(dǎo)師為 Serge Belongie。他碩士畢業(yè)于蘇黎世聯(lián)邦理工學(xué)院(ETH Zurich),在碩士期間,他跟隨導(dǎo)師 Luc Van Gool 進(jìn)行了多個(gè)研究項(xiàng)目。他的主要研究方向包括場(chǎng)景理解、小樣本學(xué)習(xí)以及多模態(tài)學(xué)習(xí)。

當(dāng)人形機(jī)器人能夠辨識(shí)身邊的一切,VR/AR 設(shè)備呈現(xiàn)出定制化的虛擬世界,自動(dòng)駕駛汽車實(shí)時(shí)捕捉路面狀況,這一切都依賴于對(duì) 3D 場(chǎng)景的精確理解。然而,這種精準(zhǔn)的 3D 理解往往需要大量詳細(xì)標(biāo)注的 3D 數(shù)據(jù),極大推高了時(shí)間成本和資源消耗,而每當(dāng)出現(xiàn)新場(chǎng)景或特定目標(biāo)時(shí),又不得不重復(fù)這一繁重過程。

Few-shot 學(xué)習(xí)是一種有效的解決思路——通過極少量標(biāo)注樣本,讓模型迅速掌握新類別,從而大幅改善了這一局限性。但當(dāng)前研究都局限于單模態(tài)點(diǎn)云數(shù)據(jù),忽略了多模態(tài)信息的潛在價(jià)值。對(duì)此,University of Copenhagen、ETH Zurich 等團(tuán)隊(duì)填補(bǔ)了這一空白,提出了一個(gè)全新的多模態(tài) Few-shot 3D 分割設(shè)定和創(chuàng)新方法:在無(wú)需額外標(biāo)注成本的前提下,融合了文本,2D,3D 信息,助力模型更好地適應(yīng)到新類別。

這篇文章已被 ICLR 2025 接收為 Spotlight 論文,歡迎關(guān)注論文和代碼,了解更多細(xì)節(jié)!

- 論文:Multimodality Helps Few-shot 3D Point Cloud Semantic Segmentation

- 論文鏈接:https://arxiv.org/abs/2410.22489

- GitHub鏈接:https://github.com/ZhaochongAn/Multimodality-3D-Few-Shot

3D Few-shot 分割結(jié)果示例

引言

3D 場(chǎng)景理解在具身智能、VR/AR 等領(lǐng)域至關(guān)重要,幫助設(shè)備準(zhǔn)確感知和解讀三維世界。然而,傳統(tǒng)全監(jiān)督模型雖在特定類別上表現(xiàn)出色,但其能力局限于預(yù)定義類別。每當(dāng)需要識(shí)別新類別時(shí),必須重新收集并標(biāo)注大量 3D 數(shù)據(jù)以及重新訓(xùn)練模型,這一過程既耗時(shí)又昂貴,極大地制約了模型的應(yīng)用廣度。

3D Few-shot 學(xué)習(xí)旨在利用極少量的示例樣本以適應(yīng)模型來有效的識(shí)別任意的全新類別,大大降低了新類適應(yīng)的開銷,使得傳統(tǒng)的 3D 場(chǎng)景理解模型不再局限于訓(xùn)練集中有限的類別標(biāo)簽,對(duì)廣泛的應(yīng)用場(chǎng)景有重要的價(jià)值。

具體而言,對(duì)于 Few-shot 3D 點(diǎn)云語(yǔ)義分割(FS-PCS)任務(wù),模型的輸入包括少量支持樣本(包含點(diǎn)云及對(duì)應(yīng)新類標(biāo)簽)和查詢點(diǎn)云。模型需要通過利用支持樣本獲得關(guān)于新類別的知識(shí)并應(yīng)用于分割查詢點(diǎn)云,預(yù)測(cè)出查詢點(diǎn)云中關(guān)于新類別的標(biāo)簽。在模型訓(xùn)練和測(cè)試時(shí)使用的目標(biāo)類別無(wú)重合,以保證測(cè)試時(shí)使用的類均為新類,未被模型在訓(xùn)練時(shí)見過。

目前,該領(lǐng)域涌現(xiàn)出的工作 [1,2] 都只利用點(diǎn)云單模態(tài)的輸入,忽略了利用多模態(tài)信息的潛在的益處。對(duì)此,這篇文章提出一個(gè)全新的多模態(tài) Few-shot 3D 分割設(shè)定,利用了文本和 2D 模態(tài)且沒有引入額外的標(biāo)注開銷。在這一設(shè)定下,他們推出了創(chuàng)新模型——MultiModal Few-Shot SegNet (MM-FSS)。該模型通過充分整合多模態(tài)信息,有效提升小樣本上新類別的學(xué)習(xí)與泛化能力,證明了利用普遍被忽略的多模態(tài)信息對(duì)于實(shí)現(xiàn)更好的小樣本新類泛化的重要性,為未來研究開辟了全新方向。

Multimodal FS-PCS Setup

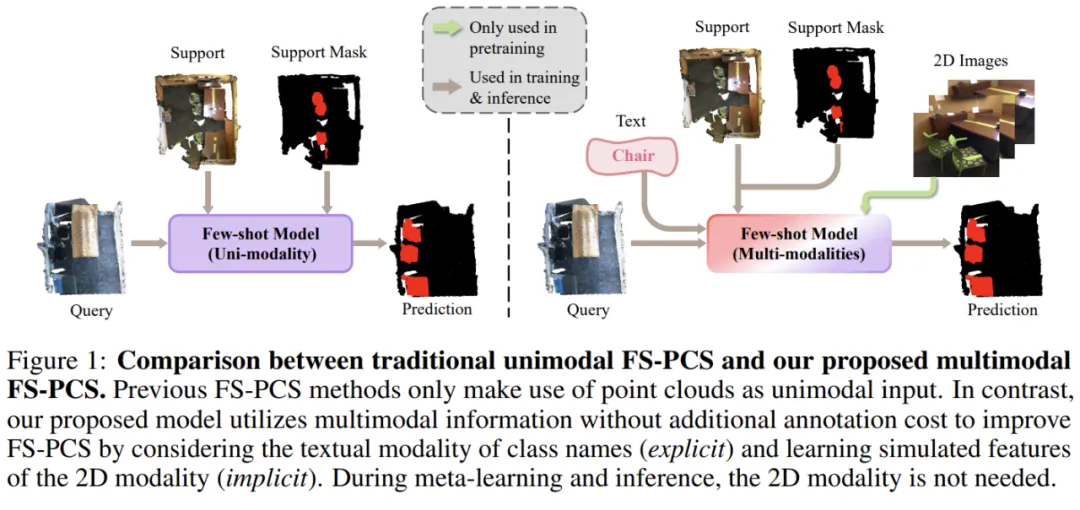

圖 1. 多模態(tài) FS-PCS 設(shè)定

為便于討論,以下都將 Few-shot 3D 點(diǎn)云語(yǔ)義分割簡(jiǎn)稱為 FS-PCS。

傳統(tǒng)的 FS-PCS 任務(wù):模型的輸入包含少量的支持點(diǎn)云以及對(duì)應(yīng)的新類別的標(biāo)注(support point cloud & support mask)。此外,輸入還包括查詢點(diǎn)云(query point cloud)。模型需借助 support 樣本中關(guān)于新類別的知識(shí),在 query 點(diǎn)云中完成新類別分割。

多模態(tài) FS-PCS 任務(wù):作者引入的多模態(tài) FS-PCS 包括了除 3D 點(diǎn)云之外的兩個(gè)額外模態(tài):文本和 2D。文本模態(tài)相應(yīng)于支持樣本中的目標(biāo)類別 / 新類的名稱。2D 模態(tài)相應(yīng)于 2D 圖片,往往伴隨 3D 場(chǎng)景采集同步獲得。值得注意的是,2D 模態(tài)僅用于模型預(yù)訓(xùn)練,不要求在 meta-learning 和測(cè)試時(shí)作為輸入,保證了其 Few-shot 輸入形式與傳統(tǒng) FS-PCS 對(duì)齊,僅需要相同的數(shù)據(jù)且無(wú)需額外標(biāo)注。

新的 Multimodal FS-PCS 模型 MM-FSS

模型概覽

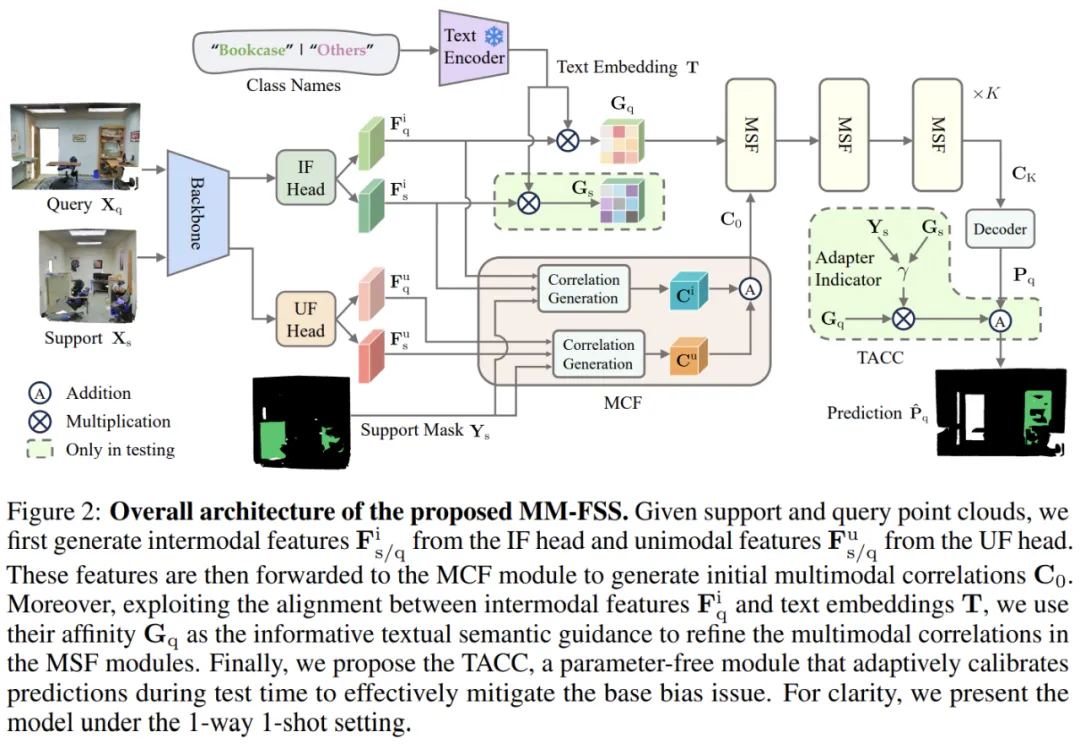

圖 2. MM-FSS 架構(gòu)

關(guān)鍵模塊解析

MM-FSS 在 Backbone 后引入兩個(gè)特征提取分支:

- Intermodal Feature (IF) Head(跨模態(tài)特征頭):學(xué)習(xí)與 2D 視覺特征對(duì)齊的 3D 點(diǎn)云特征。

- Unimodal Feature (UF) Head(單模態(tài)特征頭):提取 3D 點(diǎn)云本身的特征。

① 預(yù)訓(xùn)練階段

MM-FSS 先進(jìn)行跨模態(tài)對(duì)齊預(yù)訓(xùn)練,通過利用 3D 點(diǎn)云和 2D 圖片數(shù)據(jù)對(duì),使用 2D 視覺 - 語(yǔ)言模型(VLM)輸出的 2D 特征監(jiān)督 IF head 輸出的 3D 特征,使得 IF Head 學(xué)習(xí)到與 2D 視覺 - 語(yǔ)言模型對(duì)齊的 3D 特征。這一階段完成后:

- Backbone 和 IF Head 保持凍結(jié),確保模型在 Few-shot 學(xué)習(xí)時(shí)能利用其預(yù)訓(xùn)練學(xué)到的 Intermodal 特征。這樣,在 Few-shot 任務(wù)中無(wú)需額外的 2D 輸入,僅依賴 Intermodal 特征即可獲益于多模態(tài)信息。

- 此外,該特征也隱式對(duì)齊了 VLM 的文本特征,為后續(xù)階段利用重要的文本引導(dǎo)奠定基礎(chǔ)。

② Meta-learning 階段

在 Few-shot 訓(xùn)練(稱為 meta-learning)時(shí),給定輸入的 support 和 query 點(diǎn)云,MM-FSS 分別將 IF Head 和 UF Head 輸出的兩套特征計(jì)算出對(duì)應(yīng)的兩套 correlations(correlations 表示每個(gè) query 點(diǎn)和目標(biāo)類別 prototypes 之間的特征相似度)。

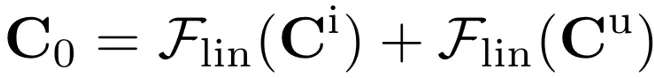

- 兩套 correlations 會(huì)通過 Multimodal Correlation Fusion (MCF) 進(jìn)行融合,生成初始多模態(tài) correlations,包含了 2D 和 3D 的視覺信息。這個(gè)過程可以表示為:

其中 和

和  分別表示用 IF Head 和 UF Head 特征算得的 correlations。

分別表示用 IF Head 和 UF Head 特征算得的 correlations。 為 MCF 輸出的初始多模態(tài) correlations。

為 MCF 輸出的初始多模態(tài) correlations。

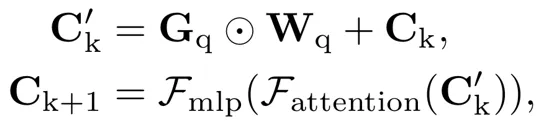

- 當(dāng)前獲得的多模態(tài) correlations 融合了不同的視覺信息源,但文本模態(tài)中的語(yǔ)義信息尚未被利用,因此設(shè)計(jì)了 Multimodal Semantic Fusion (MSF) 模塊,進(jìn)一步利用文本模態(tài)特征作為語(yǔ)義引導(dǎo),提升多模態(tài) correlations:

其中  為文本模態(tài)的語(yǔ)義引導(dǎo),

為文本模態(tài)的語(yǔ)義引導(dǎo), 為文本和視覺模態(tài)間的權(quán)重(會(huì)動(dòng)態(tài)變化以考慮不同模態(tài)間變化的相對(duì)重要性),

為文本和視覺模態(tài)間的權(quán)重(會(huì)動(dòng)態(tài)變化以考慮不同模態(tài)間變化的相對(duì)重要性), 為多模態(tài) correlations。

為多模態(tài) correlations。

③ 測(cè)試階段

為緩解 Few-shot 模型對(duì)于訓(xùn)練類別的 training bias(易被測(cè)試場(chǎng)景中存在的訓(xùn)練類別干擾,影響新類分割),MM-FSS 在測(cè)試時(shí)引入 Test-time Adaptive Cross-modal Calibration (TACC) :利用跨模態(tài)的語(yǔ)義引導(dǎo)(由 IF Head 生成)適應(yīng)性地修正預(yù)測(cè)結(jié)果,實(shí)現(xiàn)更好的泛化。

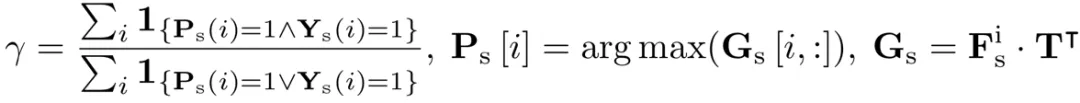

跨模態(tài)的語(yǔ)義引導(dǎo)未經(jīng) meta-learning 訓(xùn)練,有更少的 training bias。為了有效的執(zhí)行測(cè)試時(shí)修正,作者提出基于支持樣本及其標(biāo)簽估算可靠性指標(biāo),用于自動(dòng)調(diào)整修正程度(當(dāng)該語(yǔ)義引導(dǎo)可靠性更高時(shí),分配更大的修正權(quán)重,否則分配更小的權(quán)重):

為模型的預(yù)測(cè),

為模型的預(yù)測(cè), 為跨模態(tài)語(yǔ)義引導(dǎo),γ 為適應(yīng)性指標(biāo)。通過借助 support point cloud 以及可用的 support mask 可以如下計(jì)算 γ 作為修正可靠程度的估計(jì):

為跨模態(tài)語(yǔ)義引導(dǎo),γ 為適應(yīng)性指標(biāo)。通過借助 support point cloud 以及可用的 support mask 可以如下計(jì)算 γ 作為修正可靠程度的估計(jì):

實(shí)驗(yàn)結(jié)果

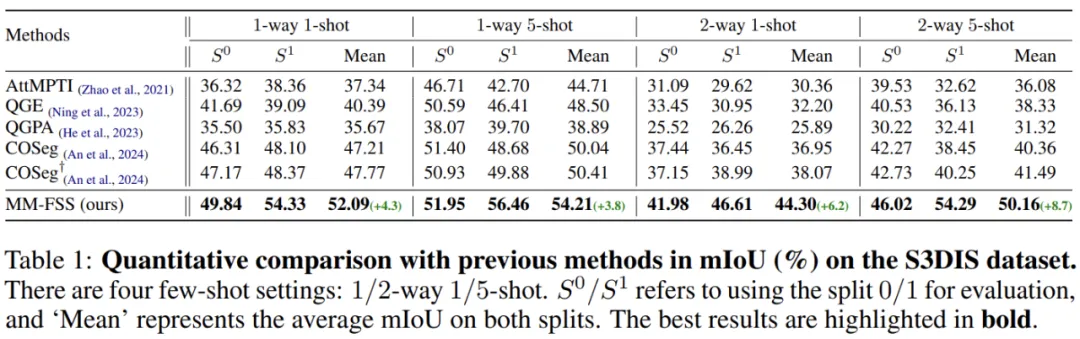

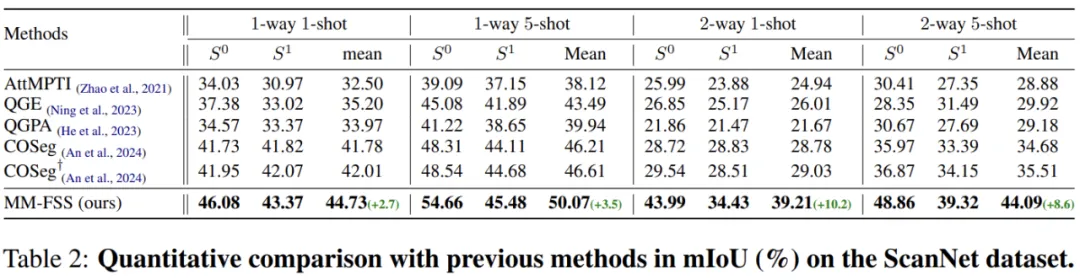

表 1. 實(shí)驗(yàn)結(jié)果

表 2.實(shí)驗(yàn)結(jié)果

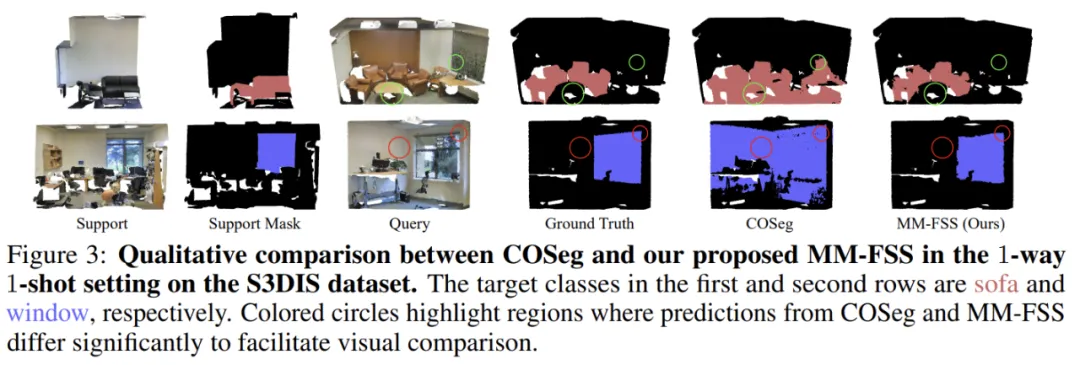

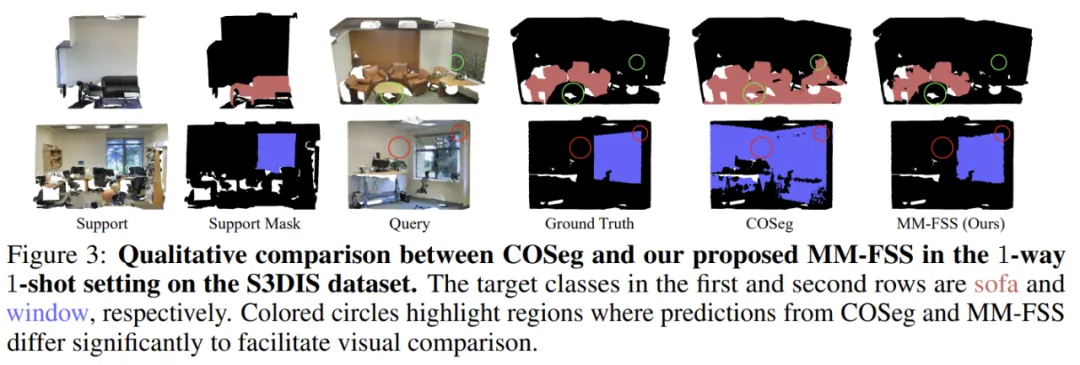

圖 3. MM-FSS 的可視化對(duì)比結(jié)果

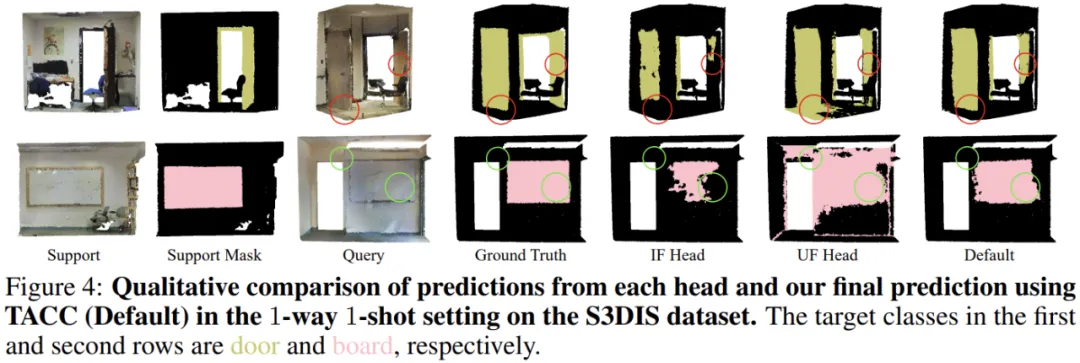

圖 4. MM-FSS 的可視化消融實(shí)驗(yàn)結(jié)果

實(shí)驗(yàn)在兩個(gè)標(biāo)準(zhǔn)的 FS-PCS 數(shù)據(jù)集上進(jìn)行,證明了 MM-FSS 在各類 few-shot 任務(wù)中都實(shí)現(xiàn)了最佳性能。可視化也清楚表明了模型能夠?qū)崿F(xiàn)更優(yōu)的新類分割,展示了更強(qiáng)的新類泛化能力。更多詳細(xì)實(shí)驗(yàn)和分析內(nèi)容請(qǐng)參見論文。

總結(jié)

這項(xiàng)工作首次探索了融合多模態(tài)以提升 FS-PCS 任務(wù)的可能性。文中首先提出了全新的多模態(tài) FS-PCS 設(shè)定,無(wú)額外開銷地融合文本和 2D 模態(tài)。在該設(shè)定下,作者提出首個(gè)多模態(tài) FS-PCS 模型 MM-FSS,顯式的利用文本模態(tài),隱式的利用 2D 模態(tài),最大化其靈活性和各場(chǎng)景下的應(yīng)用性。

MM-FSS 包含了 MCF 和 MSF 來有效的從視覺線索和語(yǔ)義信息雙重角度高效聚合多模態(tài)知識(shí),增強(qiáng)對(duì)新類概念的全面理解。此外,為了協(xié)調(diào) few-shot 模型的 training bias,作者設(shè)計(jì)了 TACC 技術(shù),在測(cè)試時(shí)動(dòng)態(tài)的修正預(yù)測(cè)。

綜合來看,該工作展示了過往被普遍忽略的「免費(fèi)」多模態(tài)信息對(duì)于小樣本適應(yīng)的重要性,為未來的研究提供了寶貴的新視野且開放了更多有趣的潛在方向。可參考的方向包括性能的提升 [2,3],訓(xùn)練和推理效率的優(yōu)化 [4],更深入的模態(tài)信息利用等。