強化學習也遇到了“天花板”?Andrej Karpathy構(gòu)建了一個新算法

RL還行不行?表面上很風光,但真實情況怎樣呢?

大神Karpathy提出了一種超越當前RL范式、更接近人類學習機制的新思路。

強化學習的強大與局限

Karpathy首先肯定了強化學習的巨大價值。他指出,與監(jiān)督微調(diào)(SFT)相比,RL的“杠桿效應(yīng)”要強大得多。SFT依賴于大量高質(zhì)量、人工標注的數(shù)據(jù),成本高昂且難以擴展。而RL則可以通過一個相對簡單的獎勵信號(比如任務(wù)成功或失敗)來引導(dǎo)模型學習,這種方式更具擴展性,也更符合Rich Sutton提出的“苦澀的教訓(The Bitter Lesson)”——即那些能充分利用計算資源進行大規(guī)模學習的通用方法,最終將勝過依賴人類知識的特定方法。

然而,Karpathy指出了RL的兩大核心局限:

漸進式學習的低效性(Asymptotic Suspicion):當前的RL機制可以被概括為:“這件事做得好/差,我就為未來稍微增加/減少采取過的每個行動的概率”。當任務(wù)變得極其復(fù)雜,需要長達數(shù)分鐘甚至數(shù)小時的互動才能完成時,這種學習方式就顯得非常可疑。難道智能體付出了如此巨大的努力,僅僅是為了在最后獲得一個單一的標量獎勵(比如1或0),然后用這個微弱的信號去調(diào)整成百上千步?jīng)Q策的梯度嗎?這在信息效率上是極低的。

與人類學習機制的背離:這并非人類學習和提升智能的主要方式。當我們完成一項任務(wù)后,我們不會只得到一個簡單的“好”或“壞”的反饋。相反,我們會進行一個“復(fù)盤和反思(review/reflect)”的階段,從中提取出豐富得多的監(jiān)督信息,比如:“哪一步做得好?哪里出了問題?下次我應(yīng)該嘗試什么新方法?”

“第二天性”新范式

Karpathy認為,我們?nèi)笔Я艘环N更接近人類智慧的學習范式。他將其描述為一個從“顯式策略”到人類學習“第二天性”的過程。

他構(gòu)想了這樣一個算法:

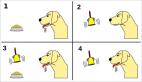

1. 執(zhí)行與收集:針對一個任務(wù),讓智能體進行幾次嘗試。

2. 反思與總結(jié):將所有嘗試的過程和最終結(jié)果(獎勵)打包放入一個上下文窗口中。然后,使用一個“元提示詞(meta-prompt)”引導(dǎo)模型對這些經(jīng)歷進行復(fù)盤和反思。

3. 生成“教訓”:模型通過反思,生成一段明確的、可操作的“教訓(lesson)”字符串。

4. 應(yīng)用與迭代:將這條新“教訓”添加到系統(tǒng)的提示詞(System Prompt)中,或一個專門的“教訓數(shù)據(jù)庫”里,用于指導(dǎo)未來的任務(wù)。

一個絕佳的例子是Claude模型曾經(jīng)用于解決“數(shù)字母”難題的“補丁”。眾所周知,由于分詞(tokenization)機制,LLM很難直接“看到”并計算單詞中的字母。Claude的系統(tǒng)提示詞中曾加入過這樣一條指令:“如果用戶要求你數(shù)一個單詞里的字母,請先用逗號將字母隔開,然后每數(shù)一個就增加一個顯式計數(shù)器。”

這段話就是一個典型的“教訓”。Karpathy的核心問題是:我們?nèi)绾巫屩悄荏w通過自主實踐,自動地從失敗中總結(jié)出這樣的“教訓”,而不是依賴工程師硬編碼?

從“刻意練習”到“直覺”

Karpathy進一步將這個過程與人類學習的“第二天性(second nature)”聯(lián)系起來。新生成的“教訓”字符串,就像我們學習新技能時,在腦中明確記住的步驟和策略。這是一種刻意的、消耗認知資源的思考。

然而,隨著時間的推移和經(jīng)驗的積累,這些明確的指令可以通過一個類似“睡眠”的過程,被“蒸餾”并融入模型的權(quán)重中,最終成為一種無需思考的直覺。這正是我們所說的“熟能生巧”或“內(nèi)化于心”。

當然,這個構(gòu)想也面臨諸多挑戰(zhàn):如何泛化這個學習過程?如何管理一個不斷增長的“教訓”數(shù)據(jù)庫以避免上下文窗口無限膨脹?如何高效地進行“蒸餾”?這些都是需要填補的空白。