AI在實時視頻里秒“剪”出你想要的部分!輸入文字/圖/視頻片段,它都能秒懂|ICCV2025

還在實時視頻里找特定事件找半天?最新技術直接開掛了。

試想一下,安防監控中,幾個人影短暫掠過,利用新技術可以秒級調出這段“可疑聚眾”的精準片段。

△圖片為AI生成

在VR訓練場,你戴上VR眼鏡練習投籃,提前在手機App輸入“定位和這個視頻示范(庫里完美三分片段)相似的動作”。訓練開始,每一次出手,眼鏡在后臺默默分析第一視角視頻流。當你做出動作、發力、弧線都神似庫里的三分時,眼鏡立刻就能在虛擬界面高亮標記這個片段。

△圖片為AI生成

不賣關子,這就是來自深圳北理莫斯科大學、阿德萊德大學的研究團隊提出的新任務。

名叫混合模態在線視頻定位(Online Video Grounding with Hybrid-modal Queries, OVG-HQ)。

用大白話說,這項技術能讓系統一邊直播/錄像,一邊根據你提供的多種“線索”,包括文字、參考圖、示范視頻片段或組合等,瞬間在實時視頻流中找出并精準裁剪出你關心的完整事件。

論文已收錄于ICCV2025。

此前方法的缺陷有兩個:

“離線”是硬傷:主流技術必須等視頻錄完才能干活,事后分析如同馬后炮,無法滿足安防“秒級響應”、直播“即時重現”、VR“訓練中實時反饋”的剛需。

“詞窮”是軟肋:僅靠文字描述(如“聚眾”“劈殺”“完美三分”)難精準定義視覺世界的微妙差異。動作發力點、光影細節、空間模式……很多時候“只可意會”。

OVG-HQ是怎么破局的呢?

怎么做到的?

團隊表示,要讓系統做到“精準定位+理解多模態”,需跨過兩道坎:

挑戰一:流式場景下的歷史知識持續保留

模型在實時處理視頻流時,必須確保歷史關鍵信息不丟失——否則早期出現的動作線索或場景特征被遺忘,將導致事件起止點誤判。

挑戰二:查詢模態分布不均

同一用戶意圖可能對應一段5秒視頻(信息豐富),也可能僅是一張低分辨率圖或簡短文字(信息稀疏)。強弱模態的顯著差異會導致模型過度依賴強模態,無法充分利用弱模態信息,影響多源信息整合精度。構建能均衡處理所有模態組合的統一模型異常困難。

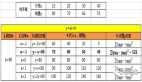

為系統性研究上述問題,團隊整理QVHighlights數據,構建首個支持混合模態在線定位的基準集QVHighlights-Unify,擴充四種查詢元素:

- 檢索圖:模擬用戶從搜索引擎獲取參考圖

- 生成圖:模擬用戶用文生圖模型生成參考圖

- 生成片段:模擬用戶用文生視頻模型生成參考視頻

- 互補圖文對:模擬用戶用圖+文共同說明意圖(缺一不可)

總計71.6K組查詢,覆蓋8種模態組合,構成首個混合模態在線定位的統一評估基準。

針對兩項挑戰,團隊提出兩個核心組件:

1、參數化記憶模塊(PMB)

step 1:記憶當前輸入,通過參數即記憶層,將當前輸入信息壓縮到記憶參數中,并采用重構損失進行自監督學習。通過梯度下降更新記憶參數,使其同時保留當前和歷史信息。

step 2:記憶增強處理,利用更新后的記憶參數對當前輸入進行增強:先經投影層映射,輸入參數即記憶層,再通過層歸一化和投影操作,輸出記憶增強后的表征供后續模塊使用。

2、混合模態蒸餾(Hybrid-modal Distillation)

step 1: 為信息量豐富的模態組合(文本+生成片段)訓練專家模型。

step 2: 以專家輸出為軟標簽,引導其他模態的學生模型,最終得到能統一處理8種模態組合的通用模型。

實驗效果如何?

離線指標只關心“對不對”,不關心“快不快”。為衡量實時能力,團隊引入時間衰減因子β:當預測在標注片段結束時刻命中時,β=1,若預測時間晚于標注結束時間,β線性衰減,超過閾值后降為0,基于此設計兩項在線指標:

- oR@n(Online Recall@n):在置信度排序的top n預測片段中,若存在至少一個命中標注片段,則根據命中預測片段的延遲計算β。

- omAP(Online mAP):為每個預測片段分配時間折扣分,延遲越久得分越低。

兩項指標共同要求“又快又準”,貼合安防、直播等場景需求。

實驗結果顯示,使用混合模態蒸餾后 ,模型在弱模態處理上顯著提升:Image-R提升8.98%,Image-G提升9.35%。

參數化記憶模塊效果優于ATT和LSTM,,以生成視頻查詢(Segment-G)為例,PMB(20.13%)>LSTM(17.41%)>ATT(11.85%)。

總結來說,OVG-HQ任務、QVHighlights-Unify數據集、PMB模塊及混合模態蒸餾策略,共同勾勒出實時視頻理解的新范式:“用戶給任何線索,系統實時在當前視頻流中定位完整事件。”這不僅加速安防告警、體育直播回放、VR訓練反饋,更為智能家居、工業質檢、自動駕駛等場景打開新想象空間。

作者及單位

曾潤浩(深圳北理莫斯科大學)、毛嘉其(深圳大學)、賴銘浩(深圳大學)、Minh Hieu Phan(阿德萊德大學)、董延杰(深圳北理莫斯科大學)、王偉(深圳北理莫斯科大學)、陳奇(阿德萊德大學)、胡希平(深圳北理莫斯科大學)

論文鏈接: https://arxiv.org/abs/2508.11903