卡帕西:強化學習很糟糕,但其他所有方法都更糟

卡帕西大神的最新專訪來了!

作為特斯拉前AI總監、OpenAI創始成員,卡帕西在近兩個半小時的訪談中,深入回答了一系列引人深思的問題:

- 為何強化學習表現糟糕(但其他方法更糟糕)?

- 為何通用人工智能會延續2%的GDP增長率?

- 為何自動駕駛技術歷經漫長攻堅期?

解答問題之余,由于卡帕西早已宣布全職搞教育,那不得不提的還有他對未來教育發展的見解。

網友表示:知識點實在太密集了,卡帕西訪談的兩個小時等于別人的四個小時。

干貨要來了,請系好安全帶,別被轟暈了!

AGI起碼還要十年

訪談一開始,主持人就先對卡帕西提出了一個人令許多人都很好奇的問題:

為什么說未來將是“智能體的十年”,而不是“智能體的一年”?

卡帕西解答道,現在確實有一些非常早期的智能體,比如他每天都在使用的Claude、Codex等,它們已經展現出令人驚嘆的能力。

但不可否認的是,這些系統還需要不斷進化,最終達到理想狀態,而十年正是實現這一蛻變所需要的時間跨度。

那這個時間節點為什么是十年呢?

卡帕西接著舉了個例子,他認為,當智能體能夠像員工或實習生一樣與人協作時,才是它真正發揮作用的時候。

顯然,目前智能體還做不到這樣。那么,為了讓它們做到,需要什么條件呢?為什么人們今天還沒用它們來做呢?

原因很簡單,就是現有系統尚未成熟。智能水平尚未達標、多模態能力存在局限、也缺乏操作計算機完成復雜任務的能力。

此外,它們也沒有持續學習能力——你無法通過單次告知就讓系統永久掌握知識。在認知架構層面仍存在顯著缺陷,導致現有方案完全不可行。

憑借卡帕西15年做AI的經驗,要系統性解決這些難題,大約還需要十年。

LLM認知缺陷

之后,卡帕西還講了自己構建代碼倉庫的一些事情。

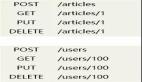

他認為目前人們與代碼交互的方式主要有三類:

- 完全拒絕所有大語言模型(LLM),堅持手動編寫所有代碼。

- 中間派系(也是卡帕西所屬的陣營)仍然會親自編寫大量代碼,但會利用現有的自動補全功能。

- 氛圍編程,直接輸入“請實現某某功能”,然后讓模型完成。

卡帕西承認,現有的智能體在做模塊化代碼方面確實很有效,但他做的NanoChat是一個很獨特的倉庫,幾乎每行都需要深度思考,所有細節都必須精確安排。

然而,現有的模型存在太多認知缺陷。由于它們在訓練中吸收了網絡上常見的編程范式,所以它們總是無法突破思維定勢,執意要將代碼改造成生產級標準。

但卡帕西的代碼本身已包含若干假設,根本不需要那些冗余內容。它們不僅膨脹了代碼庫規模,增加了復雜度,還頻繁使用已棄用的API,最終搞得一團糟。

總的來說,卡帕西認為現在的模型還沒有達到理想狀態,業界對它們的能力有些過度夸大,其實它們仍需要大量改進。

強化學習很糟糕

接著,主持人聊到了現在大火的強化學習。

卡帕西表示:

強化學習遠比普通人想象的還要糟糕,它確實很差,但其他方法更差。

以解數學題為例,在強化學習中,你會首先生成大量嘗試方案:針對同一問題產出數百種解法,可能涉及不同思路的探索與調整,最終某個答案恰好正確。

這時強化學習的做法是:對最終正確的解題路徑上的每個步驟都進行權重強化,仿佛在說“請多做這類操作”。

但問題在于這種做法充滿噪聲。它默認正確解法的每個環節都完美無缺,但現實中人們常會繞彎路,只是最終誤打誤撞找到答案。只要結果正確,所有錯誤步驟反而都被強化了——這顯然不合理。

人們投入大量計算資源,最終僅獲得“正確/錯誤”的二元判斷,并據此對整個軌跡進行加權,卡帕西認為,“這實在荒謬”。

真正的人類絕不會這么干。第一,人類不會做數百次嘗試;第二,當人類找到答案時,會進行復雜的復盤:“哪些做得好,哪些沒做好”。他們會思考,而當前LLM完全沒有這種機制。

以閱讀為例,當LLM“閱讀”時,只是在做下一個詞預測并從中獲取知識。但人類閱讀時,書本更像是激發思考的提示集——人們會通過信息重組來內化知識。

對此,卡帕西期待在預訓練階段加入“思考消化”環節,讓模型能真正整合新信息與既有認知。

AGI將延續2%的GDP增長趨勢

接著,主持人還提到了衡量AGI的標尺,以教育水平為例,AGI是從高中生水平通過強化學習達到大學生水平,最終取得博士學位。

卡帕西可不認同上述標準,他認同的是OpenAI初創時對AGI的定義:能完成任何具有經濟價值任務且達到或超越人類水平的系統。

這就涉及到現有工作被替代的程度,卡帕西認為,即使是如客服中心員工這種更易自動化的職業,AGI也不能瞬間完全替代,而是實現“自主性滑塊”——AI處理80%常規工作,剩下20%留給人類監督。

那如果有AGI替代人類工作,它的并行復制會顯著加速AI進步嗎?會出現智力爆炸嗎?

卡帕西回答道:智力爆炸已經在發生了,通過歷史GDP的指數增長就能體現出來。這是漸進的自動化趨勢:工業革命是物理自動化,早期軟件是數字自動化。

他認為:

這種增長模式大體保持不變。就像互聯網讓我們維持2%的增長一樣,AGI也只是延續這種模式,不會突然產生巨大的跳躍。

自動駕駛為何耗時如此之長

主持人還提到了卡帕西在特斯拉的經歷,問道:“你曾在2017年到2022年領導特斯拉自動駕駛項目,為什么這個項目耗時如此之長?”

首先,卡帕西澄清了一點:自動駕駛還遠未完成。

對于某些任務或工作來說,演示到產品的差距非常大。演示可能很容易,但做成真正的產品非常難。自動駕駛尤其如此,因為失敗代價太高。

軟件工程也有類似特性。比如普通編程可能沒那么嚴格,但如果你寫的是生產級代碼,任何小錯誤都可能導致安全漏洞,泄露數百萬人的個人信息。

自動駕駛如果出錯可能有人受傷,但軟件出錯可能帶來的后果幾乎是無限的。

其中的關鍵在于所謂的“9的進度”。每增加一位9(比如從90%到99%的可靠性),都需要大量工作。卡帕西在特斯拉的五年里,他們可能達到了三位或兩位9,但還有更多9等著去完成。

畢竟真正的產品要面對現實中的各種挑戰,需要不斷修補各種邊緣情況。

教育的未來

最后,卡帕西作為一名全職教育家,不得不提的還有教育。

卡帕西表示:

我們在嘗試建立一所技術知識方面的頂尖學府,一所非常現代化、領先的學校。我想做的是一種真正的“導師體驗”。

以他學韓語為例,一開始是自學,然后加入韓國的一個小班,和十來個學生一起上課。后來他換成了一對一導師。他發現這位導師的教學非常棒,可以迅速判斷他的知識水平,提出合適的問題來理解他的認知模型。

目前,即使是優秀的LLM也做不到這一點,但好的導師可以做到。一旦導師了解自己,就能提供給學生最需要的知識——適度的挑戰,既不太難也不太簡單。

此外,卡帕西還想做一門非常優秀的課程,讓學生學習AI時能有頂尖的體驗。這個課程就是LLM101N,Nanochat是其中的經典項目。之后他還需要構建中間內容,招募助教團隊,完善整門課程。

最后的最后,有的網友也是狠狠附議了卡帕西訪談中的一些觀點。

比如LLM的“健忘癥”。

但有的人也表示:

完全不同意,現在的編碼智能體已經很可靠了。