HF日趨榜一!真端到端模型AutoDeco終結(jié)手動調(diào)參解碼

大語言模型(LLM)的「煉丹師」們,或許都曾面臨一個共同的困擾:為不同任務(wù)、不同模型手動調(diào)整解碼超參數(shù)(如 temperature 和 top-p)。這個過程不僅耗時耗力,而且一旦模型或任務(wù)發(fā)生變化,歷史經(jīng)驗(yàn)便瞬間失效,一切又得從頭再來。

這種繁瑣的試錯過程,在許多研發(fā)團(tuán)隊(duì)的日常溝通中屢見不鮮,正如下圖所展示的那樣:

圖 1:研發(fā)人員手動調(diào)整解碼參數(shù)的日常。

一個靈魂拷問隨之而來:為何不能讓模型自己學(xué)會如何解碼,從而實(shí)現(xiàn)真正的「端到端」?

事實(shí)上,各大模型廠商的 API 文檔也印證了這一難題。以 DeepSeek 為例,其官方文檔明確建議針對不同場景設(shè)置截然不同的 temperature 值,這使得單一的靜態(tài)參數(shù)設(shè)置顯得捉襟見肘。

圖 2:不同任務(wù)需要不同的解碼參數(shù),這使得靜態(tài)設(shè)置難以應(yīng)對復(fù)雜多變的現(xiàn)實(shí)需求。

近日,由騰訊 AI Lab 的王琰研究員及其團(tuán)隊(duì)領(lǐng)銜,聯(lián)合香港中文大學(xué)(深圳)唐曉瑩教授及其博士生王志超給出了一個優(yōu)雅的答案。他們推出了名為 AutoDeco 的全新架構(gòu),旨在徹底終結(jié)手動解碼的「手工作坊」時代。這項(xiàng)研究《The End of Manual Decoding: Towards Truly End-to-End Language Models》,通過讓模型動態(tài)預(yù)測并控制自身的解碼參數(shù),向著真正端到端的語言生成邁出了關(guān)鍵一步。

- 論文鏈接: https://huggingface.co/papers/2510.26697

- 代碼鏈接: https://github.com/Zacks917/AutoDeco

- 模型鏈接: https://huggingface.co/collections/Jadeislaw/autodeco

圖 3:AutoDeco 位居 Hugging Face Daily Papers 榜首

當(dāng)前,盡管 LLM 本身已高度集成,但其生成過程的「最后一公里」—— 解碼,仍然是一個獨(dú)立于模型之外的、不可微的僵硬環(huán)節(jié)。研究團(tuán)隊(duì)形象地將其比作「手動擋變速箱」:無論引擎(LLM)多么強(qiáng)大,換擋(調(diào)參)依然依賴人工操作。

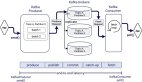

AutoDeco 的核心思想,就是為 LLM 裝上「自動擋」。它通過在標(biāo)準(zhǔn) Transformer 架構(gòu)中引入兩個超輕量的預(yù)測頭,讓模型在生成每一個 token 時,都能根據(jù)當(dāng)前的上下文信息,動態(tài)地預(yù)測出最適合下一步生成的 temperature 和 top-p 值。其架構(gòu)如下圖所示:

圖 4:AutoDeco(上)與傳統(tǒng)手動解碼(下)的對比。AutoDeco 將解碼參數(shù)的預(yù)測無縫集成到模型的前向傳播中,實(shí)現(xiàn)了動態(tài)自調(diào)節(jié)。

核心挑戰(zhàn)與技術(shù)突破:如何訓(xùn)練一個沒有「標(biāo)準(zhǔn)答案」的任務(wù)?

設(shè)想很美好,然而,一個關(guān)鍵的挑戰(zhàn)擺在研究團(tuán)隊(duì)面前:如何訓(xùn)練這些預(yù)測頭?在訓(xùn)練數(shù)據(jù)中,并不存在每一時刻「正確」的溫度和 top-p 標(biāo)簽,這使得監(jiān)督學(xué)習(xí)無從談起。

為此,團(tuán)隊(duì)提出了一種創(chuàng)新的、完全端到端的訓(xùn)練策略。他們設(shè)計(jì)了一種新穎的可微分「軟性 top-p」(soft top-p)機(jī)制,巧妙地替代了傳統(tǒng) top-p 采樣中不可微的「硬截?cái)唷共僮鳌T摲椒ǚ譃槿剑?/span>

(一)溫度縮放:首先,使用模型預(yù)測的溫度 對原始 logits l 進(jìn)行縮放,得到初始概率分布 p。

對原始 logits l 進(jìn)行縮放,得到初始概率分布 p。

(二)掩碼生成:接著,計(jì)算概率的累積分布 c,并使用模型預(yù)測的 top-p 值

生成一個平滑的、可微分的掩碼 m。其核心思想是,對于累積概率小于

生成一個平滑的、可微分的掩碼 m。其核心思想是,對于累積概率小于 的 token,掩碼值為 1;對于超出部分的 token,掩碼值通過一個指數(shù)衰減函數(shù)平滑地趨近于 0。

的 token,掩碼值為 1;對于超出部分的 token,掩碼值通過一個指數(shù)衰減函數(shù)平滑地趨近于 0。

其中 α 是控制衰減陡峭程度的超參數(shù)。

(三) 最終概率分布:最后,將掩碼應(yīng)用到初始概率上并重新歸一化,得到最終的可微分概率分布 p。

圖 5:可微分的 soft top-p(橙色線)與傳統(tǒng)的 hard top-p (綠色線)對比。Soft top-p 的平滑特性打通了從最終損失到解碼參數(shù)預(yù)測頭的梯度路徑。

這一設(shè)計(jì)的巧妙之處在于,它使得從最終的「下一個詞預(yù)測」損失到解碼參數(shù)預(yù)測頭的梯度能夠順暢回傳。如此一來,模型便可以在標(biāo)準(zhǔn)的 Next Token Prediction 任務(wù)中,通過優(yōu)化最終生成結(jié)果來「倒逼」自己學(xué)會如何動態(tài)調(diào)整解碼策略,整個過程無需任何額外的標(biāo)注數(shù)據(jù)。

AutoDeco 的驚人表現(xiàn):三大亮點(diǎn)

通過在 Llama、Qwen、Deepseek 等多個主流模型家族上的廣泛實(shí)驗(yàn),AutoDeco 展現(xiàn)了其強(qiáng)大的能力:

- 卓越的性能與泛化能力

實(shí)驗(yàn)結(jié)果表明,AutoDeco 不僅穩(wěn)定超越了傳統(tǒng)的 Greedy Search 和 Default Sampling 等基線方法,其性能甚至能媲美、乃至超越了利用測試集進(jìn)行精細(xì)調(diào)優(yōu)的「神諭」基線(oracle-tuned baseline)。

圖 6:AutoDeco 在多個數(shù)學(xué)和通用任務(wù) benchmark 上均取得了 SOTA 性能,展現(xiàn)了其強(qiáng)大的泛化能力。

- 極致的效率與易用性

AutoDeco 的預(yù)測頭設(shè)計(jì)極為輕量,其帶來的額外推理延遲通常僅為 1.7%,內(nèi)存開銷也幾乎可以忽略不計(jì)。對于開發(fā)者而言,接入 AutoDeco 模型僅需修改幾行代碼,即可享受「免費(fèi)」的性能提升。

- 「言出法隨」:開創(chuàng)性的自然語言控制能力

研究中最令人興奮的發(fā)現(xiàn)之一,是 AutoDeco 涌現(xiàn)出的一種「通過自然語言控制解碼」的能力。用戶可以直接在 prompt 中通過自然語言下達(dá)指令,如「我希望答案更有創(chuàng)意」,模型便能「聽懂」并自主地調(diào)高其預(yù)測的 temperature 和 top-p 值,整個過程清晰可見。

圖 7:在不同指令下,AutoDeco 預(yù)測的 T/P 值變化。從左至右分別為:基線、高創(chuàng)造力指令(T/P 值自發(fā)升高)、高確定性指令(T/P 值自發(fā)降低)。

當(dāng)然,作者坦言這種能力還不夠完善,還做不到非常精準(zhǔn)的控制。他們猜測實(shí)現(xiàn)細(xì)粒度、高精度的自然語言控制解碼無法僅僅能通過微調(diào) AutoDeco 模塊做到,而是需要全參微調(diào)模型,這也被他們列為了 Future work 的重點(diǎn)。因此,作者沒有放出帶有自然語言控制能力的 AutoDeco heads 權(quán)重。

AutoDeco 在發(fā)布后迅速吸引全球 AI 社區(qū)的關(guān)注,在 Twitter 等社交平臺上引發(fā)了頂尖學(xué)者、開發(fā)者和企業(yè)家的廣泛熱議和高度評價(jià)。

圖 8:大模型社區(qū)對 AutoDeco 的廣泛熱議和高度評價(jià)。

目前,該團(tuán)隊(duì)已將論文、代碼以及在多個主流模型上訓(xùn)練好的 AutoDeco heads 全面開源,包含適配于 Deepseek V3.1、Qwen3-235B、GPT-OSS-120B 等生產(chǎn)級大模型的版本。正如研究人員在分享中所說,這項(xiàng)工作旨在將研究者和開發(fā)者從繁瑣的調(diào)參工作中解放出來,共同邁向一個更智能、更自動化的 AGI 新時代。