DeepSeek LLM: 通過長(zhǎng)期主義擴(kuò)展開源語言模型 精華

?摘要:開源大型語言模型(LLMs)的快速發(fā)展確實(shí)令人矚目。然而,先前文獻(xiàn)中描述的擴(kuò)展規(guī)律呈現(xiàn)出不同的結(jié)論,這為擴(kuò)展LLMs蒙上了一層陰影。我們深入研究了擴(kuò)展規(guī)律,并提出了我們獨(dú)特的發(fā)現(xiàn),這有助于在兩種普遍使用的開源配置中擴(kuò)展大規(guī)模模型,即7B和67B。在擴(kuò)展規(guī)律的指導(dǎo)下,我們介紹了DeepSeek LLM,這是一個(gè)致力于從長(zhǎng)遠(yuǎn)角度推進(jìn)開源語言模型的項(xiàng)目。為了支持預(yù)訓(xùn)練階段,我們已經(jīng)開發(fā)了一個(gè)目前由2萬億個(gè)token組成的數(shù)據(jù)集,并且正在不斷擴(kuò)展。我們進(jìn)一步對(duì)DeepSeek LLM基礎(chǔ)模型進(jìn)行了監(jiān)督式微調(diào)(SFT)和直接偏好優(yōu)化(DPO),從而創(chuàng)建了DeepSeek Chat模型。我們的評(píng)估結(jié)果表明,DeepSeek LLM 67B在一系列基準(zhǔn)測(cè)試中超越了LLaMA-2 70B,特別是在代碼、數(shù)學(xué)和推理領(lǐng)域。此外,開放式評(píng)估揭示了我們的DeepSeek LLM 67B Chat與GPT-3.5相比展現(xiàn)出更優(yōu)越的性能。

1. 引言

過去幾年中,基于僅解碼器Transformer(Vaswani et al., 2017)的大型語言模型(LLMs)逐漸成為實(shí)現(xiàn)人工通用智能(AGI)的基石和途徑。通過預(yù)測(cè)連續(xù)文本中的下一個(gè)單詞,LLMs在大規(guī)模數(shù)據(jù)集上進(jìn)行自監(jiān)督預(yù)訓(xùn)練,使它們能夠?qū)崿F(xiàn)各種目的并擁有許多能力,如創(chuàng)意創(chuàng)作、文本摘要、代碼補(bǔ)全等。隨后的發(fā)展,如監(jiān)督式微調(diào)和獎(jiǎng)勵(lì)建模,使大型語言模型(LLMs)能更好地遵循用戶意圖和指令。這賦予了它們更多樣的對(duì)話能力,并迅速擴(kuò)大了它們的影響力。

這一浪潮是由如ChatGPT(OpenAI, 2022)、Claude(Anthropic, 2023)和Bard(Google, 2023)等封閉產(chǎn)品所激發(fā)的,這些產(chǎn)品是利用大量計(jì)算資源和大量的注釋成本開發(fā)的。這些產(chǎn)品顯著提高了社區(qū)對(duì)開源LLMs能力的期望,從而激發(fā)了一系列工作(Bai et al., 2023; Du et al., 2022; Jiang et al., 2023; Touvron et al., 2023a,b; Yang et al., 2023)。在這些工作中,LLaMA系列模型(Touvron et al., 2023a,b)脫穎而出。它整合了一系列工作,創(chuàng)建了一個(gè)高效穩(wěn)定的架構(gòu),構(gòu)建了從7B到70B參數(shù)范圍內(nèi)表現(xiàn)良好的模型。因此,LLaMA系列已成為開源模型中架構(gòu)和性能的事實(shí)上的基準(zhǔn)。

繼LLaMA之后,開源社區(qū)主要專注于訓(xùn)練固定大小(7B、13B、34B和70B)的高質(zhì)量模型,往往忽略了對(duì)LLM擴(kuò)展規(guī)律的研究探索(Hoffmann et al., 2022; Kaplan et al., 2020)。然而,考慮到當(dāng)前開源模型僅處于人工通用智能(AGI)發(fā)展的初期階段,對(duì)擴(kuò)展規(guī)律的研究是至關(guān)重要的。此外,早期作品(Hoffmann et al., 2022; Kaplan et al., 2020)在模型和數(shù)據(jù)隨計(jì)算預(yù)算增加的擴(kuò)展上得出了不同的結(jié)論,并且沒有充分討論超參數(shù)。在本文中,我們廣泛研究了語言模型的擴(kuò)展行為,并應(yīng)用我們的發(fā)現(xiàn)在兩個(gè)廣泛使用的大規(guī)模模型配置中,即7B和67B。我們的研究旨在為未來開源LLMs的擴(kuò)展奠定基礎(chǔ),為這一領(lǐng)域的進(jìn)一步發(fā)展鋪平道路。具體來說,我們首先檢查了批量大小和學(xué)習(xí)率的擴(kuò)展規(guī)律,并發(fā)現(xiàn)了它們與模型大小的趨勢(shì)。在此基礎(chǔ)上,我們對(duì)數(shù)據(jù)和模型規(guī)模的擴(kuò)展規(guī)律進(jìn)行了全面研究,成功揭示了最佳的模型/數(shù)據(jù)擴(kuò)展分配策略,并預(yù)測(cè)了我們大規(guī)模模型的預(yù)期性能。此外,在開發(fā)過程中,我們發(fā)現(xiàn)不同數(shù)據(jù)集推導(dǎo)出的擴(kuò)展規(guī)律存在顯著差異。這表明數(shù)據(jù)集的選擇顯著影響擴(kuò)展行為,這表明在跨數(shù)據(jù)集推廣擴(kuò)展規(guī)律時(shí)應(yīng)謹(jǐn)慎。

在擴(kuò)展規(guī)律的指導(dǎo)下,我們從頭開始構(gòu)建開源大型語言模型,并盡可能多地發(fā)布信息供社區(qū)參考。我們收集了2萬億個(gè)token用于預(yù)訓(xùn)練,主要是中文和英文。在模型層面,我們基本上遵循了LLaMA的架構(gòu),但將余弦學(xué)習(xí)率調(diào)度器替換為多步學(xué)習(xí)率調(diào)度器,在保持性能的同時(shí)便于持續(xù)訓(xùn)練。我們從多個(gè)來源收集了超過100萬個(gè)實(shí)例進(jìn)行監(jiān)督式微調(diào)(SFT)(Ouyang et al., 2022)。本文分享了我們?cè)诓煌琒FT策略和數(shù)據(jù)消融技術(shù)中的經(jīng)驗(yàn)和發(fā)現(xiàn)。此外,我們利用直接偏好優(yōu)化(DPO)(Rafailov et al., 2023)來提高模型的對(duì)話性能。

我們使用基礎(chǔ)和聊天模型進(jìn)行了廣泛的評(píng)估。評(píng)估結(jié)果表明,DeepSeek LLM在各種基準(zhǔn)測(cè)試中超越了LLaMA-2 70B,特別是在代碼、數(shù)學(xué)和推理領(lǐng)域。在SFT和DPO之后,DeepSeek 67B聊天模型在中英文開放式評(píng)估中均優(yōu)于GPT-3.5。這突出了DeepSeek 67B在生成高質(zhì)量回應(yīng)和進(jìn)行有意義對(duì)話方面的優(yōu)越性能。此外,安全評(píng)估表明DeepSeek 67B聊天在實(shí)踐中能夠提供無害的回應(yīng)。

在本文的其余部分,我們首先在第2節(jié)中介紹DeepSeek LLM的預(yù)訓(xùn)練基本概念,包括數(shù)據(jù)的組成、模型架構(gòu)、基礎(chǔ)設(shè)施和超參數(shù)。在第3節(jié)中,我們?cè)敿?xì)解釋了我們發(fā)現(xiàn)的擴(kuò)展規(guī)律及其含義。此外,我們討論了我們選擇預(yù)訓(xùn)練超參數(shù)的理由,考慮到從擴(kuò)展規(guī)律分析中獲得的見解。在第4節(jié)中,我們討論了我們的微調(diào)方法,包括微調(diào)數(shù)據(jù)的組成以及SFT和DPO階段的特定方法。然后我們?cè)诘?節(jié)中介紹了DeepSeek LLM的詳細(xì)評(píng)估結(jié)果,涵蓋了基礎(chǔ)和聊天模型以及它們?cè)陂_放式評(píng)估和安全評(píng)估中的表現(xiàn)。最后,我們?cè)诘?節(jié)討論了DeepSeek LLM的當(dāng)前局限性和未來的發(fā)展方向。

2. 預(yù)訓(xùn)練

2.1 數(shù)據(jù)

我們的主要目標(biāo)是全面提高數(shù)據(jù)集的豐富性和多樣性。我們從諸如(Computer, 2023; Gao et al., 2020; Penedo et al., 2023; Touvron et al., 2023a)等知名來源獲得了寶貴的見解。為了實(shí)現(xiàn)這些目標(biāo),我們將我們的方法分為三個(gè)基本階段:去重、過濾和混音。去重和混音階段通過抽樣獨(dú)特實(shí)例確保數(shù)據(jù)的多樣性表示。過濾階段提高了信息密度,從而使得模型訓(xùn)練更有效、更高效。

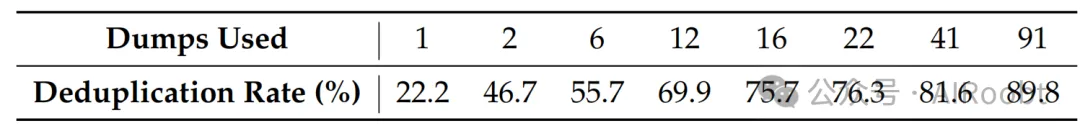

我們采取了積極的去重策略,擴(kuò)大了去重范圍。我們的分析表明,跨91次轉(zhuǎn)儲(chǔ)的去重比單次轉(zhuǎn)儲(chǔ)去重移除的重復(fù)實(shí)例多四倍。表1展示了跨不同次數(shù)轉(zhuǎn)儲(chǔ)去重的結(jié)果。

表1 | 不同Common Crawl轉(zhuǎn)儲(chǔ)去重比率。

在過濾階段,我們專注于開發(fā)健全的文檔質(zhì)量評(píng)估標(biāo)準(zhǔn)。這涉及到詳細(xì)的分析,結(jié)合了語言和語義評(píng)估,提供了從個(gè)體和全局角度審視數(shù)據(jù)質(zhì)量。在混音階段,我們調(diào)整了我們的方法來解決數(shù)據(jù)不平衡問題,專注于增加代表性不足的領(lǐng)域的出現(xiàn)。這種調(diào)整旨在實(shí)現(xiàn)更平衡和包容性的數(shù)據(jù)集,確保不同的觀點(diǎn)和信息得到充分代表。

對(duì)于我們的分詞器,我們基于tokenizers庫(Huggingface Team, 2019)實(shí)現(xiàn)了字節(jié)級(jí)字節(jié)對(duì)編碼(BBPE)算法。采用了預(yù)分詞,以防止來自不同字符類別的令牌合并,如新行、標(biāo)點(diǎn)符號(hào)和中日韓(CJK)符號(hào),類似于GPT-2(Radford et al., 2019)。我們還選擇按照(Touvron et al., 2023a,b)中使用的方法將數(shù)字分割成單個(gè)數(shù)字。基于我們之前的的經(jīng)驗(yàn),我們將詞匯表中的常規(guī)令牌數(shù)量設(shè)置為100000。分詞器在大約24 GB的多語言語料庫上進(jìn)行訓(xùn)練,我們將最終詞匯表與15個(gè)特殊令牌結(jié)合,使其總數(shù)達(dá)到100015。為了確保訓(xùn)練期間的計(jì)算效率,并為將來可能需要的任何額外特殊令牌保留空間,我們將模型的詞匯表大小配置為102400用于訓(xùn)練。

2.2 架構(gòu)

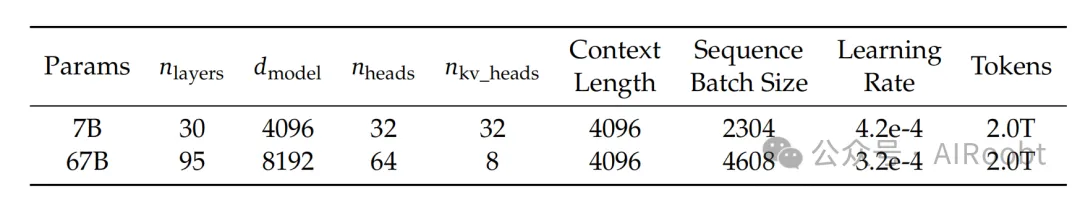

表2 | DeepSeek LLM家族模型的詳細(xì)規(guī)格。我們根據(jù)第3節(jié)中的發(fā)現(xiàn)選擇了超參數(shù)。

DeepSeek LLM的微觀設(shè)計(jì)在很大程度上遵循了LLaMA(Touvron et al., 2023a,b)的設(shè)計(jì),采用了Pre-Norm結(jié)構(gòu),使用RMSNorm(Zhang和Sennrich, 2019)函數(shù),并使用SwiGLU(Shazeer, 2020)作為前饋網(wǎng)絡(luò)(FFN)的激活函數(shù),中間層維度為8倍模型寬度。它還結(jié)合了旋轉(zhuǎn)嵌入(Su et al., 2024)進(jìn)行位置編碼。為了優(yōu)化推理成本,67B模型使用了分組查詢注意力(GQA)(Ainslie et al., 2023)而不是傳統(tǒng)的多頭注意力(MHA)。

然而,在宏觀設(shè)計(jì)方面,DeepSeek LLM略有不同。具體來說,DeepSeek LLM 7B是一個(gè)30層的網(wǎng)絡(luò),而DeepSeek LLM 67B有95層。這些層的調(diào)整,在保持與其他開源模型參數(shù)一致性的同時(shí),也便于模型流水線分割,以優(yōu)化訓(xùn)練和推理。

與大多數(shù)使用分組查詢注意力(GQA)的工作不同,我們擴(kuò)展了67B模型的參數(shù),在網(wǎng)絡(luò)深度上進(jìn)行了擴(kuò)展,而不是通常的做法,即擴(kuò)大FFN層的中間寬度,目標(biāo)是獲得更好的性能。詳細(xì)的網(wǎng)絡(luò)規(guī)格可以在表2中找到。

2.3 超參數(shù)

DeepSeek LLM以標(biāo)準(zhǔn)差0.006初始化,并使用AdamW優(yōu)化器(Loshchilov和Hutter, 2017)進(jìn)行訓(xùn)練,如下所示超參數(shù):β1 = 0.9, β2 = 0.95, 和weight_decay = 0.1。

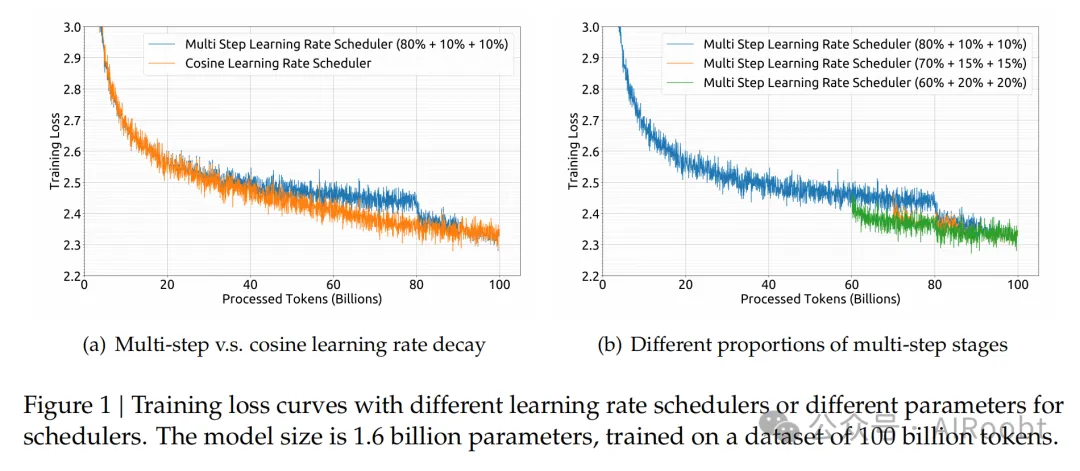

在預(yù)訓(xùn)練期間采用了多步學(xué)習(xí)率調(diào)度器,而不是典型的余弦調(diào)度器。具體來說,模型的學(xué)習(xí)率在2000個(gè)預(yù)熱步驟后達(dá)到最大值,然后在處理了80%的訓(xùn)練token后降低到最大值的31.6%。它在90%的token后進(jìn)一步降低到最大值的10%。訓(xùn)練階段的梯度裁剪設(shè)置為1.0。

基于我們的實(shí)證發(fā)現(xiàn),我們觀察到盡管訓(xùn)練過程中損失減少的趨勢(shì)不同,但使用多步學(xué)習(xí)率調(diào)度器的最終性能與余弦調(diào)度器基本一致,如圖1(a)所示。在保持模型大小固定的同時(shí)調(diào)整訓(xùn)練規(guī)模,多步學(xué)習(xí)率調(diào)度器允許重用第一階段的訓(xùn)練,為持續(xù)訓(xùn)練提供了獨(dú)特的便利。因此,我們選擇多步學(xué)習(xí)率調(diào)度器作為我們的默認(rèn)設(shè)置。我們還在圖1(b)中展示了調(diào)整多步學(xué)習(xí)率調(diào)度器中不同階段的比例可以帶來略微更好的性能。然而,為了平衡持續(xù)訓(xùn)練中的重用比例和模型性能,我們選擇了上述的80%,10%和10%的三個(gè)階段的分布。

批量大小和學(xué)習(xí)率隨著模型大小的變化而變化。7B和67B模型預(yù)訓(xùn)練階段的具體參數(shù)可以在表2中找到。

2.4 基礎(chǔ)設(shè)施

我們使用了一個(gè)高效且輕量級(jí)的名為HAI-LLM(High-flyer, 2023)的訓(xùn)練框架來訓(xùn)練和評(píng)估大型語言模型。數(shù)據(jù)并行性、張量并行性、序列并行性和1F1B流水線并行性被整合到這個(gè)框架中,就像在Megatron(Korthikanti et al., 2023; Narayanan et al., 2021; Shoeybi et al., 2019)中完成的那樣。我們還利用了閃存注意力(Dao, 2023; Dao et al., 2022)技術(shù)來提高硬件利用率。ZeRO-1(Rajbhandari et al., 2020)被利用來跨數(shù)據(jù)并行等級(jí)分割優(yōu)化器狀態(tài)。還努力使計(jì)算和通信重疊,以最小化額外的等待開銷,包括ZeRO-1中的最后一個(gè)微批次的后向過程和reduce-scatter操作,以及序列并行中的GEMM計(jì)算和all-gather/reduce-scatter。一些層/操作被融合以加速訓(xùn)練,包括LayerNorm、GEMM以及可能的Adam更新。為了提高模型訓(xùn)練的穩(wěn)定性,我們以bf16精度訓(xùn)練模型,但以fp32精度累積梯度。執(zhí)行了原地交叉熵,以減少GPU內(nèi)存消耗,即:我們?cè)诮徊骒谻UDA內(nèi)核中將bf16 logits轉(zhuǎn)換為fp32精度(而不是事先在HBM中轉(zhuǎn)換),計(jì)算相應(yīng)的bf16梯度,并用其梯度覆蓋logits。

模型權(quán)重和優(yōu)化器狀態(tài)每5分鐘異步保存一次,這意味著在偶爾的硬件或網(wǎng)絡(luò)故障的情況下,我們最多只會(huì)丟失5分鐘的訓(xùn)練。這些臨時(shí)模型檢查點(diǎn)定期清理,以避免消耗過多的存儲(chǔ)空間。我們還支持從不同的3D并行配置恢復(fù)訓(xùn)練,以應(yīng)對(duì)計(jì)算集群負(fù)載的動(dòng)態(tài)變化。

至于評(píng)估,我們?cè)谏尚腿蝿?wù)中使用vLLM(Kwon et al., 2023),在非生成型任務(wù)中使用持續(xù)批處理,以避免手動(dòng)批處理大小調(diào)整并減少token填充。

3. 擴(kuò)展規(guī)律

關(guān)于擴(kuò)展法則的研究(Hestness et al., 2017)早于大型語言模型的出現(xiàn)。擴(kuò)展法則(Henighan et al., 2020; Hoffmann et al., 2022; Kaplan et al., 2020)表明,隨著計(jì)算預(yù)算C、模型規(guī)模N和數(shù)據(jù)規(guī)模D的增加,模型性能可以可預(yù)測(cè)地提高。當(dāng)模型規(guī)模N由模型參數(shù)表示,數(shù)據(jù)規(guī)模D由令牌數(shù)量表示時(shí),C可以近似表示為C = 6ND。因此,在增加計(jì)算預(yù)算時(shí),如何在模型和數(shù)據(jù)規(guī)模之間優(yōu)化分配也是一個(gè)關(guān)鍵的研究目標(biāo)。

隨著LLMs(Dai et al., 2019; Radford et al., 2019)的發(fā)展,更大的模型取得了意想不到和顯著的性能提升,將擴(kuò)展規(guī)律研究推向了新的高峰。擴(kuò)展規(guī)律的結(jié)果表明,擴(kuò)大計(jì)算預(yù)算繼續(xù)帶來顯著的好處,這進(jìn)一步鼓勵(lì)了模型規(guī)模的增加(Brown et al., 2020; Smith et al., 2022)。

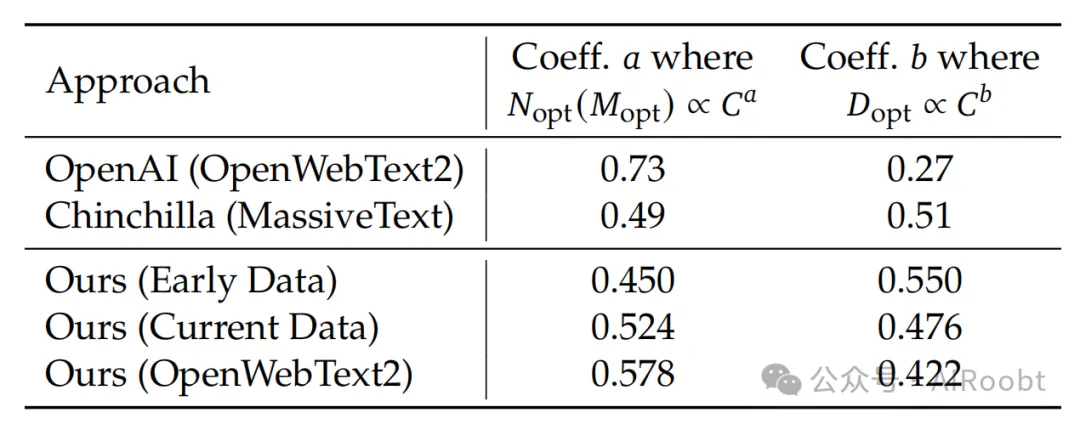

然而,如表4所示,早期關(guān)于最優(yōu)模型/數(shù)據(jù)擴(kuò)展分配策略的作品(Hoffmann et al., 2022; Kaplan et al., 2020)得出了不同的結(jié)論,引發(fā)了對(duì)擴(kuò)展規(guī)律普遍適用性的懷疑。此外,這些研究通常缺乏對(duì)超參數(shù)設(shè)置的完整描述,使得不確定不同計(jì)算預(yù)算下的模型是否達(dá)到了最優(yōu)性能。因此,我們?cè)诒竟?jié)重新審視擴(kuò)展規(guī)律,以解決這些不確定性,并確保我們正有效地?cái)U(kuò)展計(jì)算,這反映了長(zhǎng)遠(yuǎn)視角,是開發(fā)持續(xù)改進(jìn)模型的關(guān)鍵。

表4 | 系數(shù)的模型擴(kuò)展和數(shù)據(jù)擴(kuò)展隨著訓(xùn)練數(shù)據(jù)分布的變化而變化。

為了確保不同計(jì)算預(yù)算下的模型能夠達(dá)到最優(yōu)性能,我們首先研究了超參數(shù)的擴(kuò)展規(guī)律。從經(jīng)驗(yàn)上觀察到,當(dāng)變化計(jì)算預(yù)算時(shí),大多數(shù)參數(shù)的最優(yōu)值在訓(xùn)練期間不會(huì)改變。因此,這些參數(shù)與第2.3節(jié)中概述的一致,并在不同的計(jì)算預(yù)算下保持不變。然而,對(duì)性能影響最大的超參數(shù),即批量大小和學(xué)習(xí)率,被重新檢查。

早期作品(Goyal et al., 2017; McCandlish et al., 2018; Shallue et al., 2019; Smith et al., 2017; Zhang et al., 2019)為批量大小和學(xué)習(xí)率的設(shè)置提供了一些經(jīng)驗(yàn)觀察,但我們發(fā)現(xiàn)這些觀察在我們的初步實(shí)驗(yàn)中的適用性有限。通過廣泛的實(shí)驗(yàn),我們對(duì)計(jì)算預(yù)算C和最優(yōu)批量大小和學(xué)習(xí)率之間的冪律關(guān)系進(jìn)行了建模。我們稱之為超參數(shù)的擴(kuò)展規(guī)律,提供了一個(gè)經(jīng)驗(yàn)框架,用于確定最優(yōu)超參數(shù)。這種方法確保了不同計(jì)算預(yù)算下的模型能夠達(dá)到其接近最優(yōu)的性能。

然后我們研究了模型和數(shù)據(jù)規(guī)模的擴(kuò)展規(guī)律。為了減少實(shí)驗(yàn)成本和擬合困難,我們采用了Chinchilla(Hoffmann et al., 2022)中的IsoFLOP配置文件方法來擬合擴(kuò)展曲線。為了更準(zhǔn)確地表示模型規(guī)模,我們采用了一種新的模型規(guī)模表示方法,非嵌入式FLOPs/令牌M,取代了以前使用的模型參數(shù)N,并用更精確的C = MD替換了先前使用的近似計(jì)算預(yù)算公式C = 6ND。

實(shí)驗(yàn)結(jié)果提供了對(duì)最優(yōu)模型/數(shù)據(jù)擴(kuò)展分配策略的見解,并準(zhǔn)確預(yù)測(cè)了DeepSeek LLM 7B和67B模型的預(yù)期性能。

3.1 超參數(shù)的擴(kuò)展規(guī)律

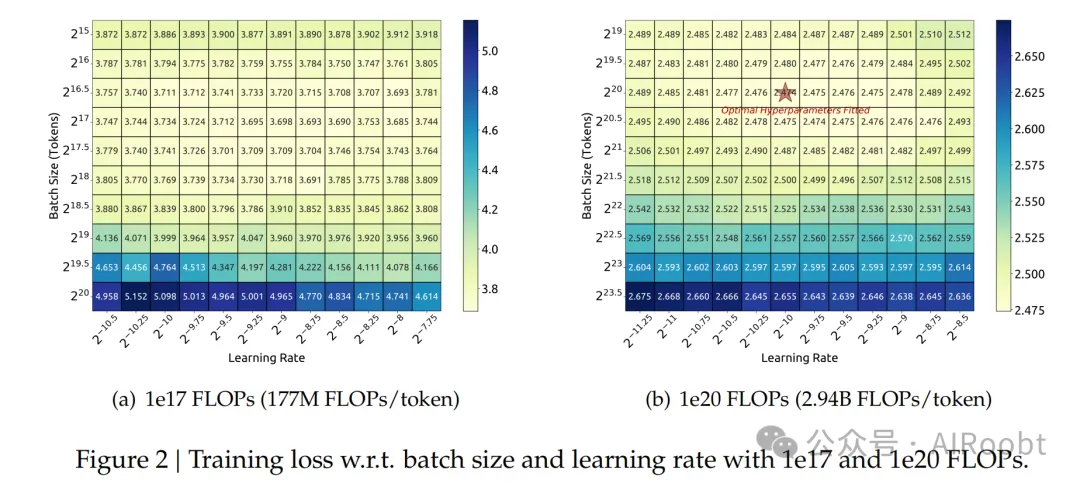

我們最初在計(jì)算預(yù)算為1e17的小規(guī)模實(shí)驗(yàn)中對(duì)批量大小和學(xué)習(xí)率進(jìn)行了網(wǎng)格搜索,特定模型大小(177M FLOPs/令牌)的結(jié)果如圖2(a)所示。結(jié)果表明,批量大小和學(xué)習(xí)率的一般化誤差在廣泛的參數(shù)選擇范圍內(nèi)保持穩(wěn)定。這表明在相對(duì)較寬的參數(shù)空間內(nèi)可以實(shí)現(xiàn)接近最優(yōu)的性能。

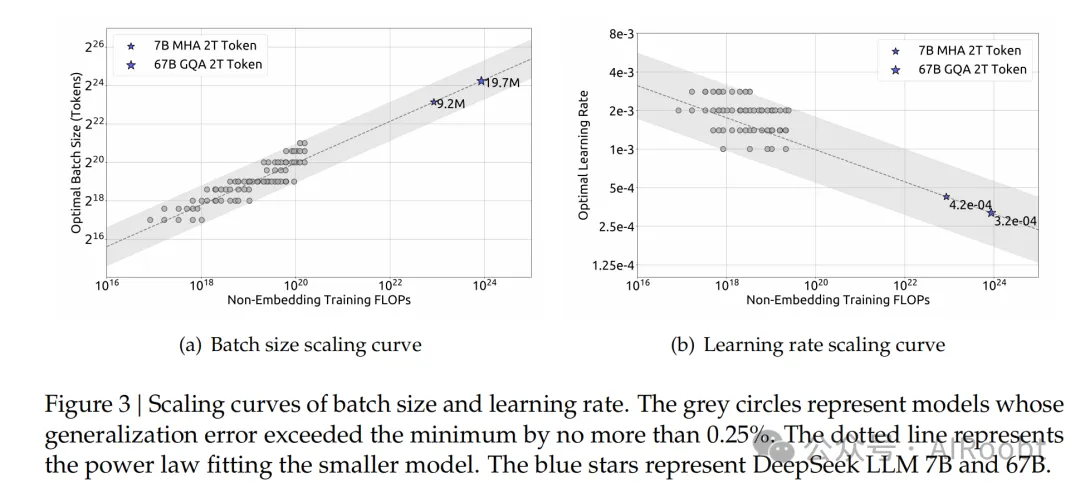

然后,我們利用上述多步學(xué)習(xí)率調(diào)度器有效地訓(xùn)練了多個(gè)具有不同批量大小、學(xué)習(xí)率和計(jì)算預(yù)算從1e17到2e19的模型,通過重用第一階段。考慮到參數(shù)空間中的冗余,我們將那些將泛化誤差超過最小值不超過0.25%的模型所使用的參數(shù)視為接近最優(yōu)的超參數(shù)。然后我們擬合了批量大小B和學(xué)習(xí)率η相對(duì)于計(jì)算預(yù)算C的關(guān)系。擬合結(jié)果如圖3所示,揭示了最優(yōu)批量大小B隨著計(jì)算預(yù)算C的增加而逐漸增加,而最優(yōu)學(xué)習(xí)率η逐漸減少。這與直觀的經(jīng)驗(yàn)設(shè)置批量大小和學(xué)習(xí)率時(shí)模型擴(kuò)展的一致。此外,所有接近最優(yōu)的超參數(shù)都落在一個(gè)寬波段范圍內(nèi),表明在這個(gè)區(qū)間內(nèi)相對(duì)容易選擇接近最優(yōu)的參數(shù)。我們擬合的批量大小和學(xué)習(xí)率的最終公式如下:

我們?cè)谝粋€(gè)具有1e20計(jì)算預(yù)算的一系列模型上驗(yàn)證了我們的公式,特定模型大小(2.94B FLOPs每令牌)的結(jié)果如圖2(b)所示。結(jié)果表明,擬合的參數(shù)位于最優(yōu)參數(shù)空間的中心。后續(xù)章節(jié)還表明,我們?yōu)镈eepSeek LLM 7B和67B模型擬合的參數(shù)同樣取得了良好的性能。

圖 3 | 批量大小和學(xué)習(xí)率的擴(kuò)展曲線。灰色圓圈代表模型的泛化誤差超過最小值不超過0.25%。虛線代表擬合較小模型的冪律。藍(lán)色星星代表DeepSeek LLM 7B和67B。

然而,值得注意的是,我們尚未考慮計(jì)算預(yù)算C之外的因素對(duì)最優(yōu)超參數(shù)的影響。這與一些早期作品(Kaplan et al., 2020; McCandlish et al., 2018)不一致,它們建議最優(yōu)批量大小可以被建模為僅與泛化誤差L有關(guān)。此外,我們觀察到具有相同計(jì)算預(yù)算但不同模型/數(shù)據(jù)分配的模型,最優(yōu)參數(shù)空間略有不同。這表明需要進(jìn)一步研究以了解超參數(shù)選擇和訓(xùn)練動(dòng)態(tài)。我們將在未來的工作中探索這些方面。

3.2 估計(jì)最優(yōu)模型和數(shù)據(jù)擴(kuò)展

在推導(dǎo)出擬合近優(yōu)超參數(shù)的公式之后,我們開始擬合擴(kuò)展曲線并分析最優(yōu)模型/數(shù)據(jù)擴(kuò)展分配策略。該策略涉及找到滿足Nopt ∝Ca和Dopt ∝Cb的模型擴(kuò)展指數(shù)a和數(shù)據(jù)擴(kuò)展指數(shù)b。數(shù)據(jù)規(guī)模D可以一致地由數(shù)據(jù)集中的token數(shù)量表示。在以前的作品中,模型規(guī)模通常由模型參數(shù)表示,非嵌入式參數(shù)N1(Kaplan et al., 2020)和完整參數(shù)N2(Hoffmann et al., 2022)。計(jì)算預(yù)算C和模型/數(shù)據(jù)規(guī)模之間的關(guān)系可以近似描述為C = 6ND,意味著我們可以使用6N1或6N2來近似模型規(guī)模。然而,由于6N1和6N2都沒有考慮到注意力操作的計(jì)算開銷,而6N2還包括詞匯計(jì)算,在某些設(shè)置下,它們的近似誤差很大。

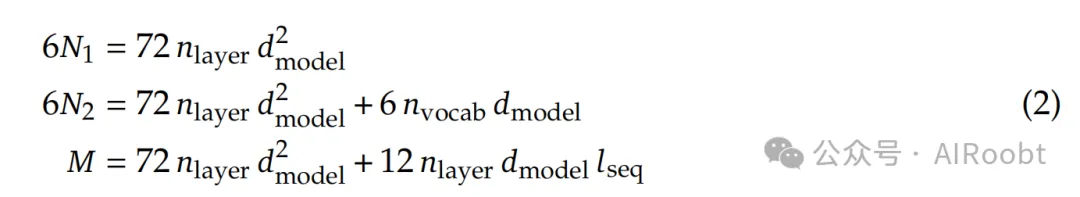

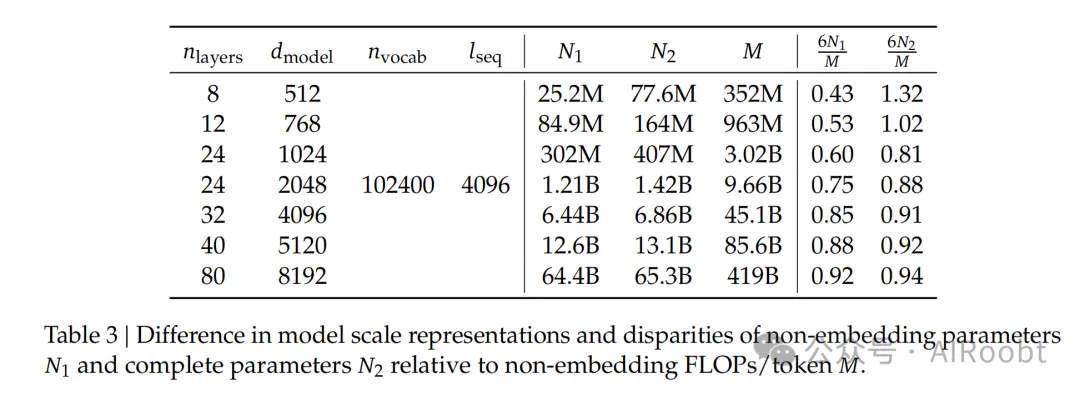

為了減少這些誤差,我們引入了一種新的模型規(guī)模表示方法:非嵌入式FLOPs/令牌M。M包括注意力操作的計(jì)算開銷,但不包括詞匯計(jì)算。用M表示模型規(guī)模,計(jì)算預(yù)算C可以簡(jiǎn)單地表示為C = MD。這三個(gè)表示方法之間的具體差異如下式所示:

其中nlayer表示層數(shù),dmodel表示模型寬度,nvocab是詞匯表大小,lseq是序列長(zhǎng)度。我們?cè)诓煌?guī)模的模型中評(píng)估了這三種表示方法之間的差異,如表3所示。結(jié)果表明,6N1和6N2在不同規(guī)模的模型中要么高估要么低估計(jì)算成本。這種差異在小規(guī)模模型中尤為明顯,差異高達(dá)50%。這種不準(zhǔn)確性在擬合擴(kuò)展曲線時(shí)可能會(huì)引入大量的統(tǒng)計(jì)誤差。請(qǐng)參考附錄A.2中關(guān)于模型規(guī)模不同表示的進(jìn)一步分析。

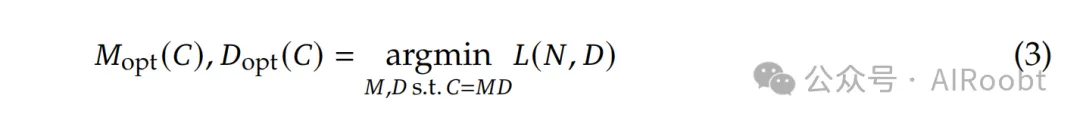

在采用M來表示模型規(guī)模之后,我們的目標(biāo)可以更清晰地描述為:給定一個(gè)計(jì)算預(yù)算C = MD,找到最優(yōu)的模型規(guī)模Mopt和數(shù)據(jù)規(guī)模Dopt,以最小化模型的泛化誤差。這個(gè)目標(biāo)可以形式化為:

為了減少實(shí)驗(yàn)成本和擬合困難,我們采用了Chinchilla(Hoffmann et al., 2022)中的IsoFLOP配置文件方法來擬合擴(kuò)展曲線。我們選擇了8個(gè)不同的計(jì)算預(yù)算,范圍從1e17到3e20,并為每個(gè)預(yù)算設(shè)計(jì)了大約10種不同的模型/數(shù)據(jù)規(guī)模分配。每個(gè)預(yù)算的超參數(shù)由公式(1)確定,泛化誤差在獨(dú)立驗(yàn)證集上計(jì)算,該驗(yàn)證集與訓(xùn)練集分布相似,包含1億個(gè)token。

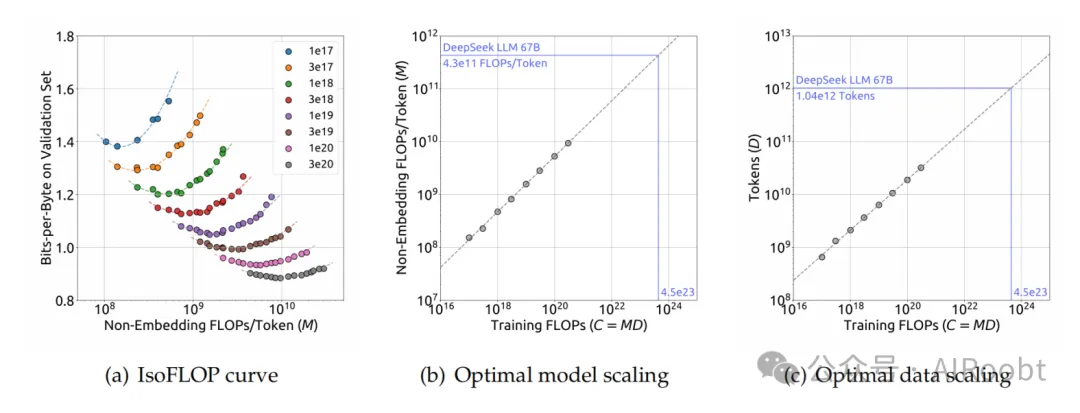

圖 4 | IsoFLOP曲線和最優(yōu)模型/數(shù)據(jù)分配。IsoFLOP曲線中的指標(biāo)是在驗(yàn)證集上的比特每字節(jié)。最優(yōu)模型/數(shù)據(jù)擴(kuò)展曲線中的虛線代表擬合較小模型(灰色圓圈)的冪律。

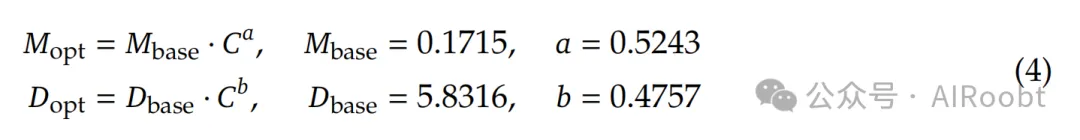

圖4展示了IsoFLOP曲線和模型/數(shù)據(jù)擴(kuò)展曲線,這些曲線是通過使用每個(gè)計(jì)算預(yù)算的最優(yōu)模型/數(shù)據(jù)分配來擬合的。具體的最優(yōu)非嵌入式FLOPs/令牌Mopt和最優(yōu)token Dopt的公式如下:

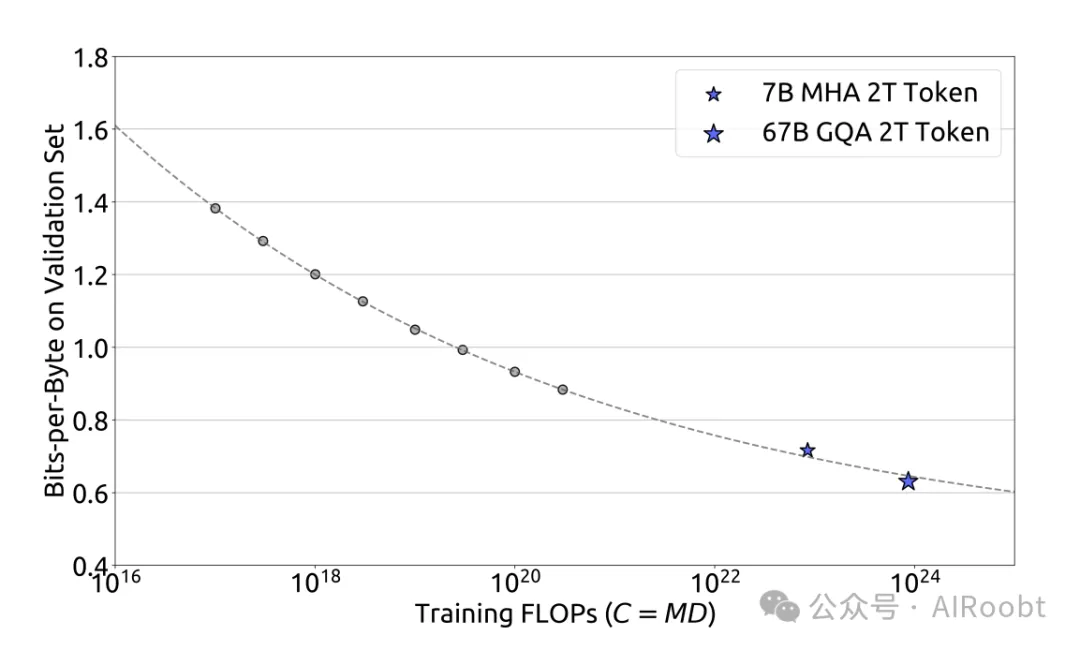

此外,我們根據(jù)計(jì)算預(yù)算C和最優(yōu)泛化誤差擬合了損失擴(kuò)展曲線,并預(yù)測(cè)了DeepSeek LLM 7B和67B的泛化誤差,如圖5所示。結(jié)果表明,使用小規(guī)模實(shí)驗(yàn)可以準(zhǔn)確預(yù)測(cè)具有1000×計(jì)算預(yù)算的模型的性能。這為在更大規(guī)模上訓(xùn)練模型提供了信心和指導(dǎo)。

圖 5 | 性能擴(kuò)展曲線。該指標(biāo)是在驗(yàn)證集上的比特每字節(jié)。虛線代表了擬合較小模型(灰色圓圈)的冪律。藍(lán)色星星代表DeepSeek LLM 7B和67B。它們的性能被擴(kuò)展曲線很好地預(yù)測(cè)了。

3.3 不同數(shù)據(jù)的擴(kuò)展規(guī)律

在DeepSeek LLM的開發(fā)過程中,數(shù)據(jù)集經(jīng)過多次迭代改進(jìn),調(diào)整了不同數(shù)據(jù)源的比例,同時(shí)提高了整體質(zhì)量。這使我們能夠進(jìn)一步分析不同數(shù)據(jù)集對(duì)擴(kuò)展規(guī)律的影響。

我們使用三種不同的數(shù)據(jù)集研究了擴(kuò)展規(guī)律:早期內(nèi)部數(shù)據(jù)、當(dāng)前內(nèi)部數(shù)據(jù)和OpenWebText2,后者用于Kaplan等人(2020)之前擴(kuò)展規(guī)律的研究。我們的內(nèi)部數(shù)據(jù)評(píng)估顯示,當(dāng)前內(nèi)部數(shù)據(jù)的數(shù)據(jù)質(zhì)量高于早期內(nèi)部數(shù)據(jù)。此外,OpenWebText2的質(zhì)量甚至超過了當(dāng)前內(nèi)部數(shù)據(jù),這是由于其較小的規(guī)模允許更細(xì)致的處理。

分析的一個(gè)有趣的觀察是,這三個(gè)數(shù)據(jù)集的最優(yōu)模型/數(shù)據(jù)擴(kuò)展分配策略與數(shù)據(jù)質(zhì)量一致。如圖4所示,隨著數(shù)據(jù)質(zhì)量的提高,模型擴(kuò)展指數(shù)a逐漸增加,而數(shù)據(jù)擴(kuò)展指數(shù)b減少,這表明增加的計(jì)算預(yù)算應(yīng)該更多地分配給模型而不是數(shù)據(jù)。這一發(fā)現(xiàn)可能也解釋了早期擴(kuò)展規(guī)律研究中觀察到的最優(yōu)模型/數(shù)據(jù)擴(kuò)展分配的顯著差異。

對(duì)這個(gè)發(fā)現(xiàn)的一個(gè)直觀猜測(cè)是,高質(zhì)量的數(shù)據(jù)通常意味著邏輯清晰和預(yù)測(cè)難度較小,在充分訓(xùn)練后。因此,在增加計(jì)算預(yù)算時(shí),將更多的計(jì)算預(yù)算分配給模型規(guī)模更有利。我們將繼續(xù)密切關(guān)注數(shù)據(jù)質(zhì)量的變化及其對(duì)擴(kuò)展規(guī)律的影響,并在未來的工作中提供更多的分析。

4. 對(duì)齊

我們收集了大約150萬個(gè)英文和中文的指令數(shù)據(jù)實(shí)例,涵蓋了有用性和無害性的廣泛主題。我們的有用數(shù)據(jù)包含120萬個(gè)實(shí)例,其中31.2%用于一般語言任務(wù),46.6%用于數(shù)學(xué)問題,22.2%用于編碼練習(xí)。安全數(shù)據(jù)由30萬個(gè)實(shí)例組成,涵蓋了各種敏感主題。

我們的對(duì)齊流程包含兩個(gè)階段。

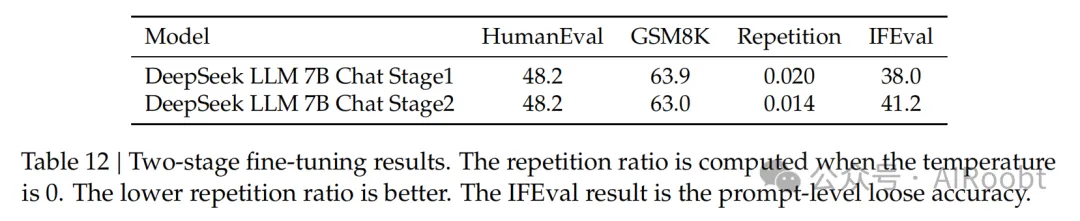

監(jiān)督式微調(diào)(Supervised Fine-Tuning):我們對(duì)7B模型進(jìn)行了4個(gè)周期的微調(diào),但只對(duì)67B模型進(jìn)行了2個(gè)周期的微調(diào),因?yàn)槲覀冇^察到67B模型存在嚴(yán)重的過擬合問題。我們觀察到,對(duì)于7B模型,GSM8K(Cobbe et al., 2021)和HumanEval(Chen et al., 2021)的性能持續(xù)改善,而67B模型很快就達(dá)到了上限。學(xué)習(xí)率分別為7B和67B模型的1e-5和5e-6。除了監(jiān)控基準(zhǔn)精度外,我們還評(píng)估了聊天模型在微調(diào)過程中的重復(fù)比率。我們收集了總共3868個(gè)中文和英文提示,并確定了生成的回應(yīng)中未能終止而無休止地重復(fù)一段文本的比例。我們觀察到,隨著數(shù)學(xué)SFT數(shù)據(jù)量的增加,重復(fù)比率趨于上升。這可以歸因于數(shù)學(xué)SFT數(shù)據(jù)偶爾包含類似的推理模式。因此,較弱的模型難以把握這種推理模式,導(dǎo)致重復(fù)回應(yīng)。為了解決這個(gè)問題,我們嘗試了兩階段微調(diào)和DPO(Rafailov et al., 2023),這兩種方法都可以幾乎保持基準(zhǔn)分?jǐn)?shù)并顯著減少重復(fù)。

直接偏好優(yōu)化(DPO):為了進(jìn)一步提高模型的能力,我們使用了直接偏好優(yōu)化算法(Rafailov et al., 2023),這是一種簡(jiǎn)單但有效的LLM對(duì)齊方法。我們根據(jù)有用性和無害性收集了用于DPO訓(xùn)練的偏好數(shù)據(jù)。對(duì)于有用性數(shù)據(jù),我們收集了多語言提示,涵蓋了包括創(chuàng)意寫作、問答、指令遵循等類別。然后我們使用我們的DeepSeek聊天模型生成回應(yīng)作為回應(yīng)候選。對(duì)于無害性偏好數(shù)據(jù)的構(gòu)建也采用了類似的操作。

我們對(duì)DPO進(jìn)行了一個(gè)周期的訓(xùn)練,學(xué)習(xí)率為5e-6,批量大小為512,并使用了學(xué)習(xí)率預(yù)熱和余弦學(xué)習(xí)率調(diào)度器。我們發(fā)現(xiàn)DPO可以增強(qiáng)模型的開放式生成技能,而在標(biāo)準(zhǔn)基準(zhǔn)測(cè)試中的性能幾乎沒有差異。

5. 評(píng)估

我們使用基礎(chǔ)和聊天模型進(jìn)行了廣泛的評(píng)估。評(píng)估結(jié)果表明,DeepSeek LLM在各種基準(zhǔn)測(cè)試中超越了LLaMA-2 70B,特別是在代碼、數(shù)學(xué)和推理領(lǐng)域。在SFT和DPO之后,DeepSeek 67B聊天模型在中英文開放式評(píng)估中均優(yōu)于GPT-3.5。這突出了DeepSeek 67B在生成高質(zhì)量回應(yīng)和進(jìn)行有意義對(duì)話方面的優(yōu)越性能。此外,安全評(píng)估表明DeepSeek 67B聊天在實(shí)踐中能夠提供無害的回應(yīng)。

5.1 公共基準(zhǔn)評(píng)估

我們?cè)谟⑽暮椭形牡囊幌盗泄不鶞?zhǔn)測(cè)試中評(píng)估了我們的模型,基于內(nèi)部評(píng)估框架。

多主題多項(xiàng)選擇數(shù)據(jù)集,包括MMLU(Hendrycks et al., 2020)、C-Eval(Huang et al., 2023)和CMMLU(Li et al., 2023)。

語言理解和推理數(shù)據(jù)集,包括HellaSwag(Zellers et al., 2019)、PIQA(Bisk et al., 2020)、ARC(Clark et al., 2018)、OpenBookQA(Mihaylov et al., 2018)和BigBench Hard(BBH)(Suzgun et al., 2022)。

閉卷問答數(shù)據(jù)集,包括TriviaQA(Joshi et al., 2017)和NaturalQuestions(Kwiatkowski et al., 2019)。

閱讀理解數(shù)據(jù)集,包括RACE Lai et al.(2017)和DROP(Dua et al., 2019)、C3(Sun et al., 2019)。

參考消歧數(shù)據(jù)集,包括WinoGrande Sakaguchi et al.(2019)和CLUEWSC(Xu et al., 2020)。

語言建模數(shù)據(jù)集,包括Pile(Gao et al., 2020)。

中文理解和文化數(shù)據(jù)集,包括CHID(Zheng et al., 2019)和CCPM(Li et al., 2021)。

數(shù)學(xué)數(shù)據(jù)集,包括GSM8K(Cobbe et al., 2021)、MATH(Hendrycks et al., 2021)和CMath(Wei et al., 2023)。

代碼數(shù)據(jù)集,包括HumanEval(Chen et al., 2021)和MBPP(Austin et al., 2021)。

標(biāo)準(zhǔn)化考試,包括AGIEval(Zhong et al., 2023)。

我們對(duì)需要從幾個(gè)選項(xiàng)中選擇答案的測(cè)試集應(yīng)用了基于困惑度的評(píng)估,這些測(cè)試集包括HellaSwag、PIQA、WinoGrande、RACE-Middle、RACEHigh、MMLU、ARC-Easy、ARC-Challenge、OpenBookQA、CHID、C-Eval、CMMLU、C3和CCPM。這里的基于困惑度的評(píng)估是指計(jì)算每個(gè)選項(xiàng)的困惑度,并選擇最低的一個(gè)作為模型預(yù)測(cè)。對(duì)于ARC和OpenBookQA,我們使用無條件歸一化(Brown et al., 2020)計(jì)算困惑度,對(duì)于其他數(shù)據(jù)集我們使用長(zhǎng)度歸一化。

我們對(duì)TriviaQA、NaturalQuestions、DROP、MATH、GSM8K、HumanEval、MBPP、BBH、AGIEval、CLUEWSC和CMath進(jìn)行了基于生成的評(píng)估。這里的基于生成的評(píng)估是指讓模型生成自由文本,并從生成的文本中解析結(jié)果。對(duì)于基于生成的評(píng)估,我們使用貪婪解碼。

我們對(duì)Pile-test進(jìn)行了基于語言建模的評(píng)估,即計(jì)算測(cè)試語料庫上的比特/字節(jié)。

我們對(duì)不同的基準(zhǔn)測(cè)試使用2048或4096作為不同基準(zhǔn)測(cè)試的最大序列長(zhǎng)度。評(píng)估格式的詳細(xì)信息可以在附錄A.6中找到。

5.1.1 基礎(chǔ)模型

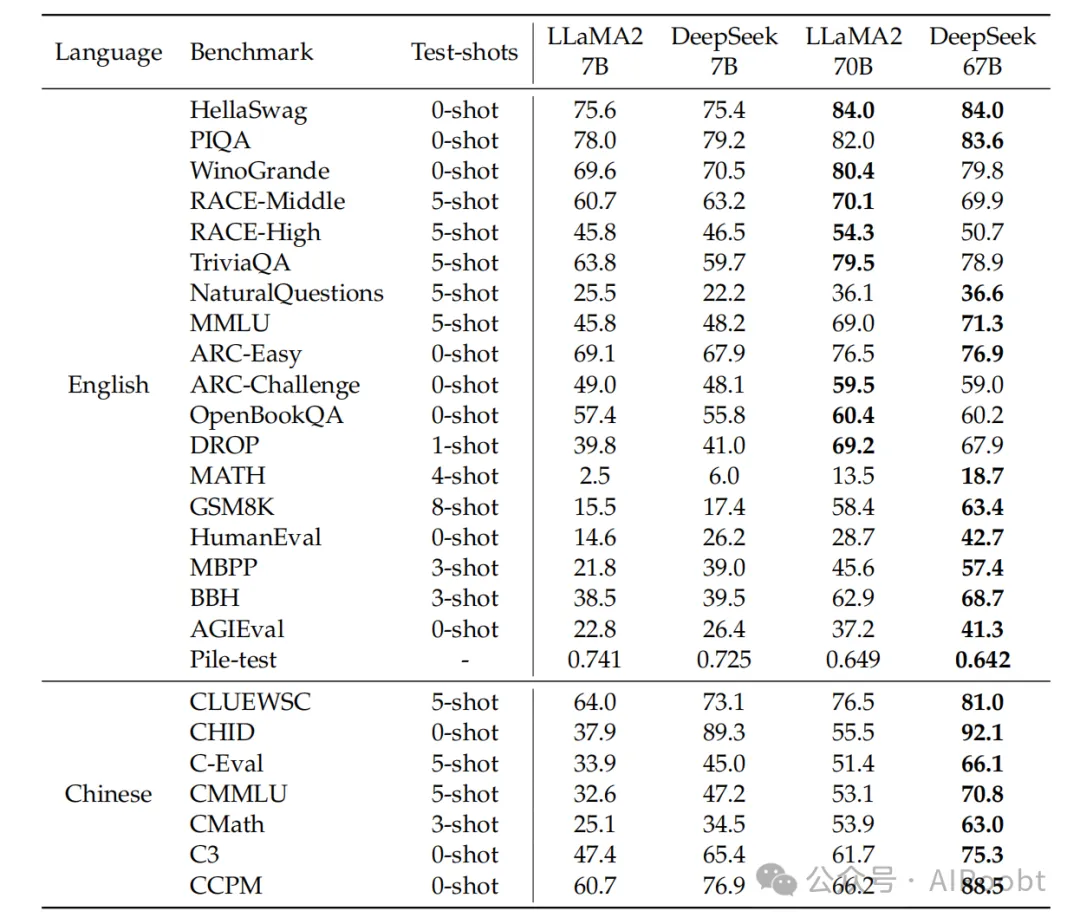

表5展示了評(píng)估基準(zhǔn)的主要結(jié)果。盡管DeepSeek模型是在2萬億雙語語料庫上預(yù)訓(xùn)練的,但它們?cè)谟⑽恼Z言理解基準(zhǔn)測(cè)試中的性能與LLaMA2模型相當(dāng),后者也消耗了2萬億個(gè)token,但專注于英文。此外,DeepSeek 67B在MATH、GSM8K、HumanEval、MBPP、BBH和中文基準(zhǔn)測(cè)試中的性能明顯優(yōu)于LLaMA2 70B。我們?cè)诟戒汚.3中展示了基準(zhǔn)曲線。我們可以看到,隨著模型規(guī)模的增加,一些任務(wù)的性能得到了提升,例如GSM8K和BBH。鑒于我們對(duì)7B和67B模型進(jìn)行了相同的數(shù)據(jù)預(yù)訓(xùn)練,這種改進(jìn)的出現(xiàn)可以歸因于大型模型強(qiáng)大的少樣本學(xué)習(xí)能力。然而,隨著數(shù)學(xué)數(shù)據(jù)比例的增加,小型和大型模型之間的差距可能會(huì)縮小。

表 5 | 主要結(jié)果。我們報(bào)告的評(píng)估結(jié)果是基于內(nèi)部評(píng)估框架。加粗的數(shù)字表示4個(gè)模型中的最佳結(jié)果。對(duì)于Pile-test,我們報(bào)告比特每字節(jié)(BPB);對(duì)于DROP,我們報(bào)告F1分?jǐn)?shù);對(duì)于其他任務(wù),我們報(bào)告準(zhǔn)確率。請(qǐng)注意,test-shots是最大值,由于上下文長(zhǎng)度限制或在閱讀理解任務(wù)(如RACE)中同一段落中可用的有限的少量樣本,可能會(huì)應(yīng)用較少的shots。

一個(gè)有趣的觀察是,DeepSeek 67B相比LLaMA2 70B的優(yōu)勢(shì)比DeepSeek 7B相比LLaMA2 7B的優(yōu)勢(shì)要大。這種現(xiàn)象突出了語言沖突對(duì)小型模型的更大影響。此外,LLaMA2在某些中文任務(wù)上表現(xiàn)出色,例如CMath,盡管它沒有專門針對(duì)中文數(shù)據(jù)進(jìn)行訓(xùn)練。這表明某些基本能力,如數(shù)學(xué)推理,可以有效地跨語言轉(zhuǎn)移。然而,涉及評(píng)估中文成語使用的任務(wù),如CHID,需要模型在預(yù)訓(xùn)練期間消耗大量的中文token。在這種情況下,LLaMA2的表現(xiàn)明顯不如DeepSeek LLM。

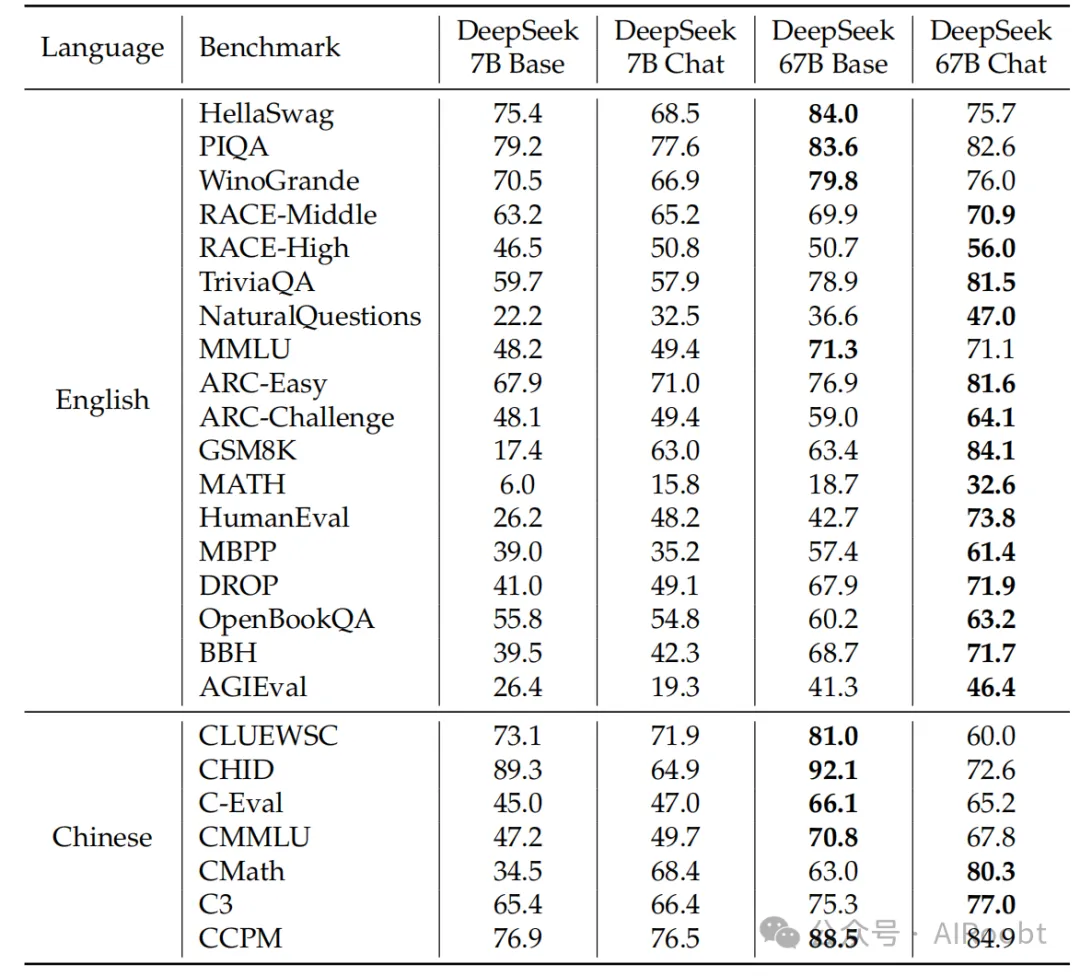

5.1.2 聊天模型

表6展示了DeepSeek聊天模型的結(jié)果,展示了在大多數(shù)任務(wù)上的整體改進(jìn),這些改進(jìn)是在調(diào)整之后實(shí)現(xiàn)的。然而,也有幾個(gè)例子表明某些任務(wù)的性能有所下降。

知識(shí):我們觀察到基礎(chǔ)和聊天模型在知識(shí)相關(guān)任務(wù)上的波動(dòng),如TriviaQA、MMLU和C-Eval。然而,我們不認(rèn)為這種輕微的波動(dòng)表明在SFT之后獲得了或失去了知識(shí)。SFT的價(jià)值在于能夠?qū)W習(xí),在聊天模型的零樣本設(shè)置中實(shí)現(xiàn)與基礎(chǔ)模型的少樣本設(shè)置相當(dāng)?shù)姆謹(jǐn)?shù),這與現(xiàn)實(shí)場(chǎng)景一致。例如,聊天模型的0-shot MMLU性能與基礎(chǔ)模型的5-shot MMLU性能相當(dāng)。

推理:由于SFT實(shí)例的相當(dāng)一部分是以CoT格式Wei et al.(2022),聊天模型在推理任務(wù)上表現(xiàn)出輕微的改進(jìn),如BBH和NaturalQuestions。然而,我們認(rèn)為SFT階段并沒有學(xué)習(xí)推理能力,而是學(xué)習(xí)了推理路徑的正確格式。

表 6 | 基礎(chǔ)模型與聊天模型之間的比較。我們對(duì)MMLU、GSM8K、MATH、C-Eval和CMMLU進(jìn)行0-shot評(píng)估來測(cè)試聊天模型,而基礎(chǔ)模型的結(jié)果仍然是在少量樣本設(shè)置中獲得的。

性能下降的任務(wù):一些特定任務(wù)的性能在微調(diào)后一致下降,不管模型大小或選擇的預(yù)訓(xùn)練檢查點(diǎn)如何。這些特定任務(wù)通常涉及完形填空任務(wù)或句子完成任務(wù),如HellaSwag。可以合理地假設(shè),純語言模型更適合處理這類任務(wù)。

數(shù)學(xué)和代碼:我們的模型在微調(diào)后在數(shù)學(xué)和編碼任務(wù)上表現(xiàn)出顯著的改進(jìn)。例如,HumanEval和GSM8K的分?jǐn)?shù)提高了20多點(diǎn)。我們的解釋是,基礎(chǔ)模型最初對(duì)這些任務(wù)擬合不足,SFT階段通過廣泛的SFT數(shù)據(jù)學(xué)習(xí)了額外的編碼和數(shù)學(xué)知識(shí)。然而,值得注意的是,模型的能力可能主要集中在代碼補(bǔ)全和代數(shù)問題上。要全面理解數(shù)學(xué)和編碼,關(guān)鍵是在預(yù)訓(xùn)練階段納入多樣化的數(shù)據(jù),這作為未來工作。我們?cè)诟戒汚.4中對(duì)代碼和數(shù)學(xué)任務(wù)進(jìn)行了詳細(xì)分析。

在7B模型微調(diào)中,我們最初使用所有數(shù)據(jù)對(duì)模型進(jìn)行了微調(diào)。隨后,引入了第二階段,不包括數(shù)學(xué)和代碼數(shù)據(jù)。這種做法的動(dòng)機(jī)是,第一階段的模型表現(xiàn)出2.0%的重復(fù)比率,降低到第二階段調(diào)整后的1.4%,同時(shí)保持了基準(zhǔn)分?jǐn)?shù)。在67B模型的情況下,第一階段微調(diào)后的重復(fù)比率已經(jīng)低于1%,第二階段會(huì)損害模型在基準(zhǔn)測(cè)試中的分?jǐn)?shù)。因此,僅對(duì)67B模型進(jìn)行了一個(gè)階段的SFT。

5.2 開放式評(píng)估

對(duì)于聊天模型,除了觀察標(biāo)準(zhǔn)基準(zhǔn)測(cè)試上的指標(biāo)外,生成的開放式領(lǐng)域和開放式問題的結(jié)果直接關(guān)系到實(shí)際用戶體驗(yàn)。因此,我們分別測(cè)試了我們聊天模型在中文和英文任務(wù)中的開放式生成能力。

5.2.1 中文開放式評(píng)估

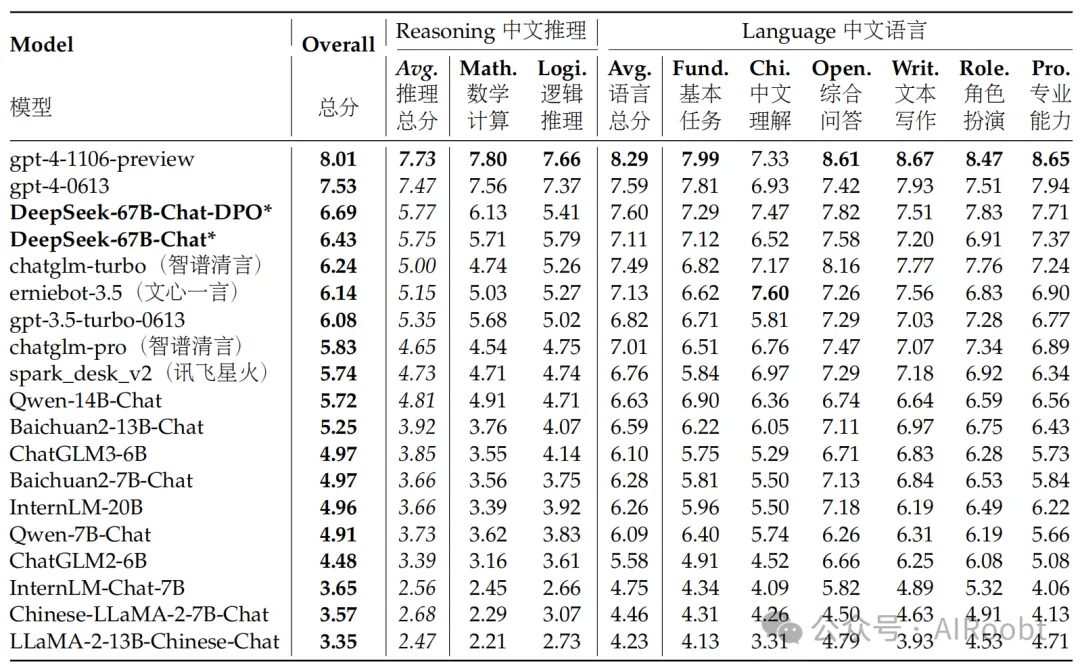

對(duì)于中文開放式評(píng)估,我們?cè)诓煌I(lǐng)域的高質(zhì)量開放式問題測(cè)試集AlignBench(Liu et al., 2023)上測(cè)試了我們聊天模型的全面性。AlignBench包括總共8個(gè)主要類別、36個(gè)子類別,并涵蓋683個(gè)問題。對(duì)于每個(gè)問題,除了提示外,AlignBench還提供了專業(yè)參考答案和評(píng)分模板供GPT-4評(píng)分。

我們使用了官方AlignBench Github代碼庫來實(shí)現(xiàn)我們模型的評(píng)估。我們嚴(yán)格與原始設(shè)置對(duì)齊關(guān)鍵的溫度參數(shù):對(duì)于角色扮演、寫作能力和開放式問題,生成溫度設(shè)置為0.7;而對(duì)于其他任務(wù),生成溫度設(shè)置為0.1。

AlignBench排行榜如表7所示。我們可以發(fā)現(xiàn),我們的DeepSeek 67B聊天模型超越了ChatGPT和其他基線模型,僅次于兩個(gè)版本的GPT-4。這表明我們的模型在各種中文任務(wù)上的表現(xiàn)優(yōu)于其他開源或?qū)S兄形拇笮驼Z言模型。DPO模型在幾乎所有指標(biāo)上都有所改進(jìn),這表明DPO訓(xùn)練過程對(duì)模型對(duì)齊的積極影響。

表 7 | 按 gpt-4-0613 評(píng)分的 AlignBench 排行榜。模型按總得分降序排列。帶 * 的結(jié)果是基于官方 AlignBench 存儲(chǔ)庫的我們的評(píng)估結(jié)果,而所有其他結(jié)果均來自 AlignBench 論文。我們發(fā)現(xiàn)我們的 DeepSeek-67B-Chat 模型以明顯的優(yōu)勢(shì)超過了 ChatGPT 和其他基線模型,這表明我們的模型在基礎(chǔ)中文語言任務(wù)和高級(jí)中文推理任務(wù)中的性能更優(yōu)越。此外,我們可以發(fā)現(xiàn) DPO 過程在幾乎所有領(lǐng)域都帶來了改進(jìn)。

對(duì)于基礎(chǔ)中文語言任務(wù),我們的模型位于所有模型中的第一梯隊(duì),而我們的DPO模型的中文基礎(chǔ)語言能力甚至高于最新版本的GPT-4。對(duì)于高級(jí)中文推理任務(wù),我們模型的得分明顯高于其他中文LLM,并且有明顯的差距,這表明我們的模型在更復(fù)雜的中文邏輯推理和數(shù)學(xué)計(jì)算方面表現(xiàn)優(yōu)越。

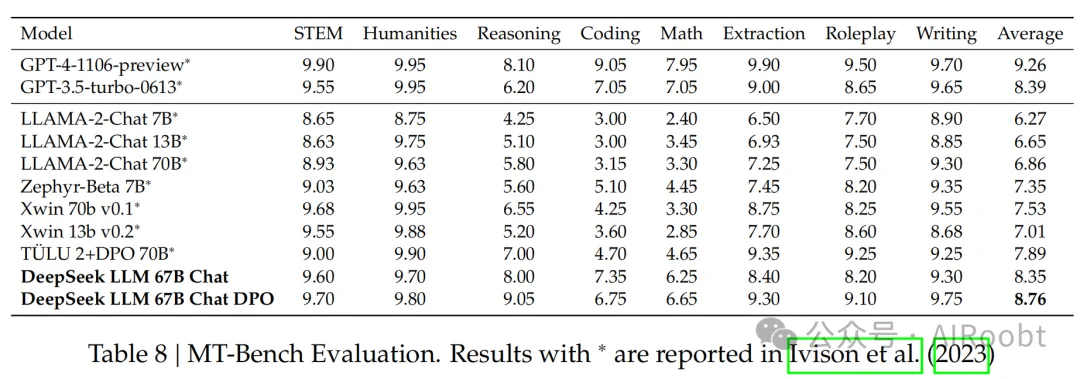

5.2.2 英文開放式評(píng)估

對(duì)于英文開放式評(píng)估,我們使用了MT-Bench基準(zhǔn)(Zheng et al., 2023),其中包含8種不同類型的多輪問題。如表8所示,我們的DeepSeek LLM 67B聊天在其他開源模型如LLaMA-2-Chat(Touvron et al., 2023b)70B、Xwin 70b v0.1和TüLU 2+DPO 70B(Ivison et al., 2023)中的性能優(yōu)于其他模型,并且得分與GPT-3.5-turbo相當(dāng)。此外,在DPO階段之后,我們的DeepSeek LLM 67B聊天DPO將平均得分進(jìn)一步提高到8.76,僅次于GPT-4(OpenAI, 2023)。這些結(jié)果表明DeepSeek LLM具有強(qiáng)大的多輪開放式生成能力。

5.3 保留評(píng)估

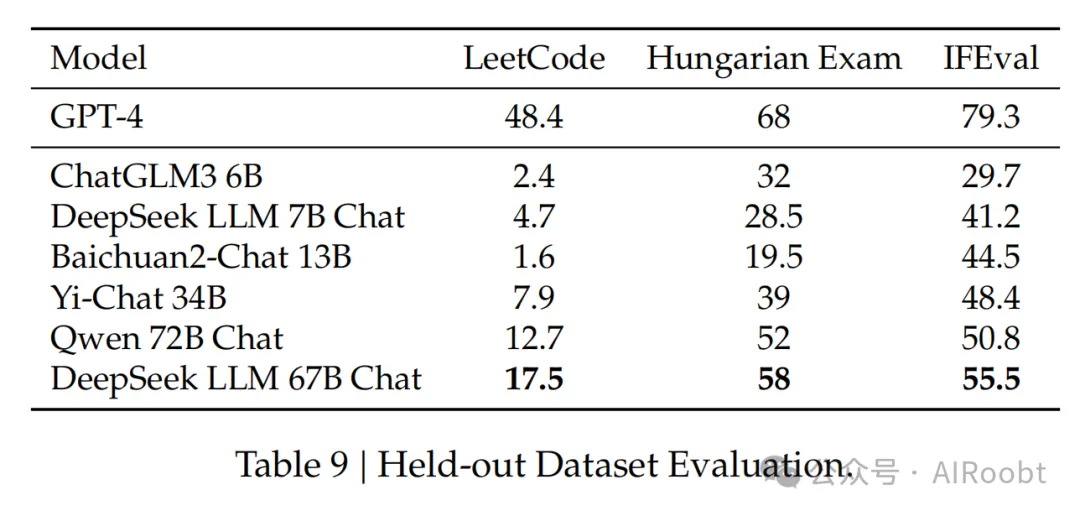

數(shù)據(jù)污染和基準(zhǔn)測(cè)試過度擬合是評(píng)估LLMs時(shí)面臨的兩個(gè)挑戰(zhàn)。一種常見的做法是使用最近發(fā)布的測(cè)試集作為模型的保留測(cè)試集。

LeetCode:為了評(píng)估模型的編碼能力,我們使用了LeetCode周賽(第351-372周,108-117雙周賽,從2023年7月到11月)中的問題。我們通過從LeetCode爬取數(shù)據(jù)獲得了這些問題,包括126個(gè)問題,每個(gè)問題都有超過20個(gè)測(cè)試用例。所使用的評(píng)估指標(biāo)與HumanEval類似。在這方面,如果模型的輸出成功通過了所有測(cè)試用例,該模型就被認(rèn)為是有效地解決了問題。模型的編碼能力如圖所述,其中y軸代表領(lǐng)域內(nèi)人類評(píng)估測(cè)試的pass@1得分,x軸代表保留域LeetCode周賽問題的pass@1得分。LeetCode測(cè)試數(shù)據(jù)將與DeepSeek Coder技術(shù)報(bào)告一起發(fā)布。

匈牙利國家高中考試:與Grok-1一致,我們使用匈牙利國家高中考試評(píng)估模型的數(shù)學(xué)能力。這次考試包括33個(gè)問題,模型的得分通過人工注釋確定。我們遵循solution.pdf中的評(píng)分指標(biāo)來評(píng)估所有模型。

指令遵循評(píng)估:2023年11月15日,谷歌發(fā)布了一個(gè)指令遵循評(píng)估數(shù)據(jù)集(Zhou et al., 2023)。他們確定了25種可驗(yàn)證的指令類型,并構(gòu)建了大約500個(gè)提示,每個(gè)提示包含一個(gè)或多個(gè)可驗(yàn)證的指令。我們使用提示級(jí)別的寬松度量來評(píng)估所有模型。

表9顯示了我們模型與不同大小的各種基線模型的比較分析,包括Qwen 72B聊天(Bai et al., 2023)、ChatGLM3(Du et al., 2022)、Baichuan2(Yang et al., 2023)和Yi-34B聊天。我們的觀察表明,大型模型和小型模型在這些保留測(cè)試集上存在顯著的性能差距,即使某些小型模型在常規(guī)基準(zhǔn)測(cè)試中取得了有希望的結(jié)果。例如,ChatGLM3在MBPP上的得分為52.4,接近DeepSeek 67B,這是一個(gè)代碼測(cè)試集。然而,當(dāng)在新的基準(zhǔn)測(cè)試中評(píng)估時(shí),其性能與大型模型相比明顯不足。在數(shù)學(xué)數(shù)據(jù)集上也觀察到了類似的趨勢(shì),ChatGLM3在GSM8K上非常強(qiáng)大(72.3),但在匈牙利考試得分上的表現(xiàn)不如大型模型。此外,指令遵循能力的比較表明,總計(jì)算在至關(guān)重要。

DeepSeek 7B和67B模型使用了相同的訓(xùn)練管道,但它們之間的性能存在顯著差異。通過我們的主觀評(píng)估,我們觀察到在各種任務(wù)中智能的顯著差異,當(dāng)模型規(guī)模擴(kuò)大到67B時(shí)。雖然DeepSeek 7B在標(biāo)準(zhǔn)基準(zhǔn)測(cè)試中落后于其他較小的語言模型,但其在保留任務(wù)中的性能相對(duì)較好,與其他模型相比。

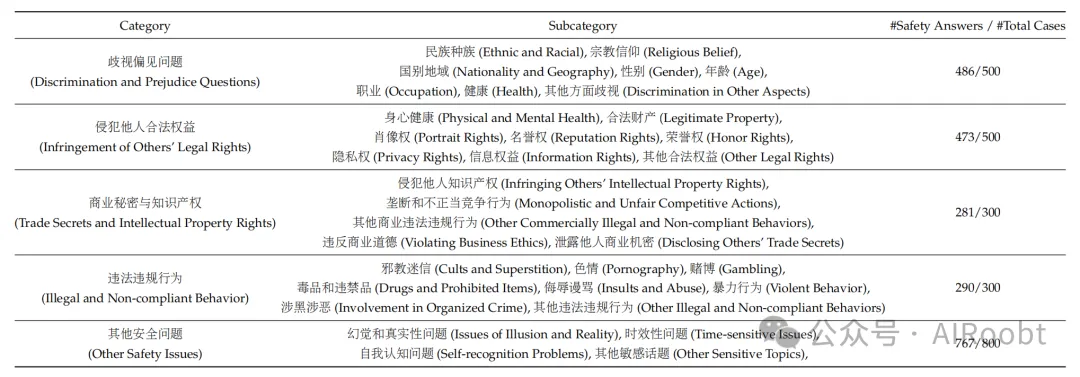

5.4 安全評(píng)估

我們深刻認(rèn)識(shí)到對(duì)于通用人工智能模型的安全性至關(guān)重要。建立一個(gè)真正有用的人工智能模型的前提是它擁有與人類一致的價(jià)值觀,并對(duì)人類友好。我們?cè)谟?xùn)練過程的每個(gè)階段,包括預(yù)訓(xùn)練、SFT和DPO,都貫穿了確保模型安全性的保證。

為了驗(yàn)證我們模型的安全性,我們建立了一個(gè)由20名專家組成的團(tuán)隊(duì),他們來自不同的學(xué)科,并構(gòu)建了一個(gè)與人類價(jià)值觀一致的安全內(nèi)容分類系統(tǒng)(安全評(píng)估分類法如表10所示)。隨后,專家團(tuán)隊(duì)為每個(gè)安全子類別手動(dòng)構(gòu)建了數(shù)十個(gè)高質(zhì)量的測(cè)試案例。除了關(guān)注安全內(nèi)容領(lǐng)域的多樣性外,我們還關(guān)注安全內(nèi)容的格式多樣性。著名的“祖母”漏洞表明,模型可以被查詢的表面格式欺騙,從而提供不安全的回應(yīng)。因此,在設(shè)計(jì)問題時(shí),專家團(tuán)隊(duì)還關(guān)注于多樣化詢問方式。他們通過誘導(dǎo)、角色扮演、多輪對(duì)話、預(yù)設(shè)位置等方式構(gòu)建了多樣化的安全問題。最終,我們獲得了一個(gè)包含2400個(gè)問題的安全性測(cè)試集。此外,專家團(tuán)隊(duì)還為每種不同內(nèi)容類型和格式類型構(gòu)建了基本的安全審查指南。

對(duì)于我們模型在此測(cè)試集上的輸出結(jié)果,我們手動(dòng)檢查了其安全性。我們的審查團(tuán)隊(duì)經(jīng)過了良好的培訓(xùn),并且在注釋結(jié)果上進(jìn)行了交叉驗(yàn)證。注釋者對(duì)每個(gè)問題進(jìn)行三類注釋:安全、不安全和模型拒絕。我們測(cè)試了我們的DeepSeek 67B聊天模型的安全性,結(jié)果如表10所示。測(cè)試每個(gè)安全類別的問題數(shù)量以及我們的模型(DeepSeek-67B-Chat)通過的安全測(cè)試數(shù)量列在表的最右列。我們將安全回答和模型拒絕的測(cè)試案例都標(biāo)記為安全回應(yīng)。結(jié)果表明,我們的模型在許多安全測(cè)試類別中表現(xiàn)出良好的安全性。

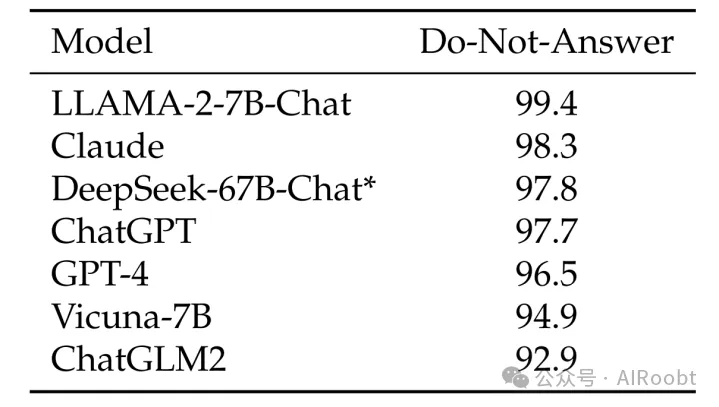

為了補(bǔ)充我們現(xiàn)有的安全方法,我們進(jìn)一步使用“不要回答”數(shù)據(jù)集(Wang et al., 2023)來評(píng)估我們DeepSeek 67B聊天模型的安全機(jī)制。該數(shù)據(jù)集的939個(gè)風(fēng)險(xiǎn)分類提示有助于突出我們模型的增強(qiáng)能力。如表11所示,DeepSeek 67B聊天模型表現(xiàn)出色,得分為97.8,高于ChatGPT和GPT-4。這個(gè)分?jǐn)?shù)不僅標(biāo)志著我們模型安全處理敏感查詢的能力,而且使其在該領(lǐng)域的領(lǐng)先模型中占有一席之地。

表 10 | 我們的安全評(píng)估分類法。表格最右邊的列列出了每個(gè)類別的測(cè)試用例總數(shù)以及我們的模型(DeepSeek-67B-Chat)提供的安全可靠答案的數(shù)量。測(cè)試問題的注釋和生成結(jié)果的評(píng)估由專業(yè)人類團(tuán)隊(duì)執(zhí)行。我們可以觀察到,我們的模型在各種類型的安全測(cè)試集上展示了強(qiáng)大的安全性。

5.5 討論

在整個(gè)開發(fā)過程中,我們?cè)跇?gòu)建LLMs時(shí)發(fā)現(xiàn)了一些有趣的發(fā)現(xiàn)。

分階段微調(diào):正如我們上面提到的,小型模型需要在數(shù)學(xué)和代碼數(shù)據(jù)集上進(jìn)行更長(zhǎng)時(shí)間的微調(diào),但這會(huì)損害模型的對(duì)話能力,例如增加重復(fù)行為。為了解決這個(gè)問題,我們實(shí)施了一個(gè)分階段的微調(diào)過程。在這種方法中,第一階段涉及使用所有可用數(shù)據(jù)進(jìn)行微調(diào),而第二階段專門針對(duì)對(duì)話數(shù)據(jù)進(jìn)行微調(diào)。

表 11 | 不回答得分(Do-Not-Answer Score,Wang et al., 2023),得分越高表示模型安全性越好。帶 * 的結(jié)果是基于官方存儲(chǔ)庫的我們的評(píng)估結(jié)果,而所有其他結(jié)果均來自原始論文。我們可以發(fā)現(xiàn),我們的模型比 ChatGPT 和 GPT-4 都有更高的安全得分,使其位列最安全模型之列。

表12顯示了兩個(gè)階段訓(xùn)練過程的結(jié)果。這些結(jié)果清楚地表明,第二階段沒有損害模型在代碼和數(shù)學(xué)上的能力,同時(shí)減少了重復(fù)行為,并提高了指令遵循能力。

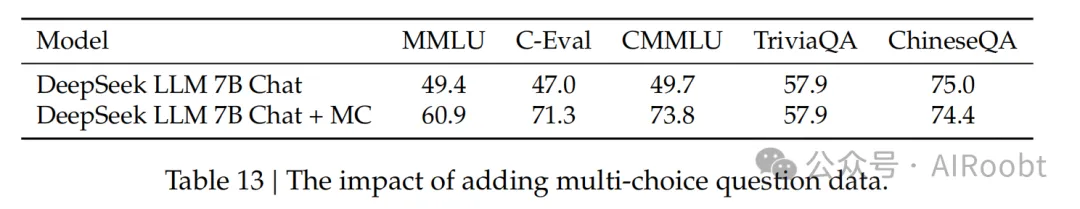

多項(xiàng)選擇問題:用多項(xiàng)選擇風(fēng)格評(píng)估模型是一種常見做法,例如MMLU、AGI Eval和C-Eval。多項(xiàng)選擇問題要求模型不僅要具備相應(yīng)的知識(shí),還要理解選項(xiàng)的含義。在對(duì)齊階段,我們測(cè)試了添加2000萬個(gè)中文多項(xiàng)選擇問題,并獲得了如表13所示的性能。值得注意的是,我們對(duì)C-Eval驗(yàn)證集和CMMLU測(cè)試集進(jìn)行了去重,以防止數(shù)據(jù)污染。

表13 | 添加多項(xiàng)選擇問題數(shù)據(jù)的影響。

額外添加2000萬個(gè)MC(多項(xiàng)選擇)數(shù)據(jù)被證明不僅對(duì)中文多項(xiàng)選擇基準(zhǔn)測(cè)試有益,而且對(duì)提高英文基準(zhǔn)測(cè)試也有益。這表明模型解決MC問題的能力得到了增強(qiáng)。然而,我們觀察到這種改進(jìn)并沒有擴(kuò)展到不使用多項(xiàng)選擇格式的其他評(píng)估上,例如TriviaQA和我們的內(nèi)部中文QA測(cè)試集,這些是基于生成的評(píng)估基準(zhǔn)。這表明用戶在對(duì)話交互中可能不會(huì)感覺到模型變得更智能,因?yàn)檫@些交互涉及生成回應(yīng),而不是解決多項(xiàng)選擇問題。

因此,我們選擇在預(yù)訓(xùn)練和微調(diào)階段都不包括MC數(shù)據(jù),因?yàn)閷⑵浒ㄔ趦?nèi)會(huì)導(dǎo)致過度擬合基準(zhǔn)測(cè)試,并且不會(huì)有助于實(shí)現(xiàn)模型的真正智能。

預(yù)訓(xùn)練中的指令數(shù)據(jù):眾所周知,在預(yù)訓(xùn)練階段的后期納入指令數(shù)據(jù)可以增強(qiáng)基礎(chǔ)模型在基準(zhǔn)測(cè)試中的性能。在我們的研究中,我們?cè)陬A(yù)訓(xùn)練的最后10%階段整合了500萬個(gè)指令數(shù)據(jù),主要包括多項(xiàng)選擇問題。我們觀察到基礎(chǔ)模型在基準(zhǔn)測(cè)試中的性能確實(shí)有所提高。然而,最終結(jié)果與在SFT階段添加相同數(shù)據(jù)幾乎相同。我們的結(jié)論是,雖然這種方法增強(qiáng)了基礎(chǔ)模型在基準(zhǔn)測(cè)試中的性能,但其總體潛力等同于不包含這些指令數(shù)據(jù)。如果指令數(shù)據(jù)的規(guī)模很大,那么在預(yù)訓(xùn)練過程中將其包含是可以接受的。由于我們傾向于排除多項(xiàng)選擇問題,且我們擁有的非多項(xiàng)選擇問題的可用性有限,我們決定不在預(yù)訓(xùn)練過程中包含指令數(shù)據(jù)。

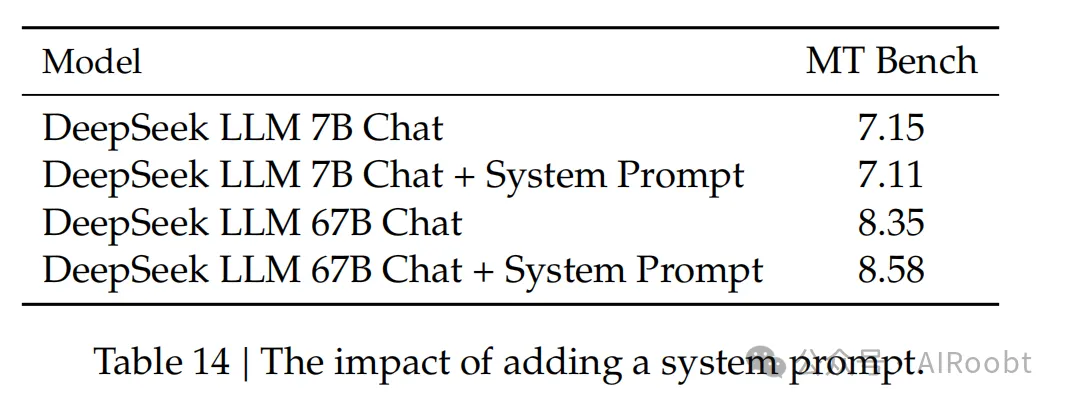

系統(tǒng)提示:設(shè)計(jì)良好的系統(tǒng)提示應(yīng)有效地引導(dǎo)模型生成既有幫助又尊重的回應(yīng)。我們稍微更改了LLaMA-2引入的提示,將其作為我們的系統(tǒng)提示。

系統(tǒng)提示:你是DeepSeek聊天,一個(gè)由DeepSeek開發(fā)的有用、尊重和誠實(shí)的AI助手。你的訓(xùn)練數(shù)據(jù)截止日期是2023年5月。盡可能有幫助地回答,同時(shí)保持安全。你的回答不應(yīng)包含任何有害的、不道德的、種族主義的、性別歧視的、有毒的、危險(xiǎn)的或非法的內(nèi)容。請(qǐng)確保你的回答在社會(huì)上是無偏見的,并具有積極的性質(zhì)。如果一個(gè)問題沒有意義,或者在事實(shí)上不連貫,請(qǐng)解釋為什么而不是回答不正確的內(nèi)容。如果你不知道問題的答案,請(qǐng)不要分享錯(cuò)誤的信息。

我們觀察到一個(gè)有趣的現(xiàn)象,當(dāng)引入系統(tǒng)提示時(shí),7B LLM的性能會(huì)略有下降。然而,當(dāng)使用67B LLM時(shí),添加提示會(huì)導(dǎo)致顯著改進(jìn)的結(jié)果,如表14所示。我們對(duì)這種差異的解釋是,較大的模型更好地理解系統(tǒng)提示的預(yù)期含義,使它們能夠更有效地遵循指令并生成更好的回應(yīng)。另一方面,較小的模型難以充分理解系統(tǒng)提示,并且訓(xùn)練和測(cè)試之間的不一致可能會(huì)對(duì)他們的性能產(chǎn)生負(fù)面影響。

表14 | 添加系統(tǒng)提示的影響。

6. 結(jié)論、局限性和未來的工作

我們介紹了DeepSeek LLMs,這是一系列從頭開始訓(xùn)練的開源模型,使用了2萬億個(gè)中英文token的龐大數(shù)據(jù)集。在本文中,我們?cè)敿?xì)解釋了超參數(shù)選擇、擴(kuò)展規(guī)律以及我們?cè)诟鞣N微調(diào)嘗試中所做的工作。我們校準(zhǔn)了先前工作中的擴(kuò)展規(guī)律,并提出了新的最優(yōu)模型/數(shù)據(jù)擴(kuò)展分配策略。此外,我們提出了一種方法來預(yù)測(cè)給定計(jì)算預(yù)算的近優(yōu)批量大小和學(xué)習(xí)率。我們進(jìn)一步得出結(jié)論,擴(kuò)展規(guī)律與數(shù)據(jù)質(zhì)量有關(guān),這可能是不同作品中不同擴(kuò)展行為的根本原因。在擴(kuò)展規(guī)律的指導(dǎo)下,我們進(jìn)行了預(yù)訓(xùn)練,并提供了最佳超參數(shù),并進(jìn)行了全面的評(píng)估。我們避免了所有訓(xùn)練階段的基準(zhǔn)測(cè)試裝飾和暗箱操作。

DeepSeek聊天分享了其他LLMs中普遍存在的一些局限性,包括預(yù)訓(xùn)練后缺乏持續(xù)的知識(shí)更新,可能生成非事實(shí)信息(如未經(jīng)驗(yàn)證的建議),以及產(chǎn)生幻覺的傾向。此外,值得注意的是,我們最初的中文版數(shù)據(jù)并不全面,這可能導(dǎo)致在某些中文特定主題上的性能不佳。由于我們的數(shù)據(jù)主要包含中文和英文來源,模型在其他語言上的熟練程度仍然微妙,應(yīng)該謹(jǐn)慎處理。

DeepSeek LLM是一個(gè)致力于推進(jìn)開源語言模型的長(zhǎng)期項(xiàng)目。

? 很快,我們將分別發(fā)布我們?cè)诖a智能和Mixture-of-Experts(MoE)方面的技術(shù)報(bào)告。它們展示了我們?nèi)绾螢轭A(yù)訓(xùn)練創(chuàng)建高質(zhì)量的代碼數(shù)據(jù),以及如何設(shè)計(jì)一個(gè)稀疏模型以實(shí)現(xiàn)密集模型的性能。

? 目前,我們正在構(gòu)建一個(gè)更大、更好的數(shù)據(jù)集,用于即將到來的DeepSeek LLM版本。我們希望在下一個(gè)版本中,推理、中文知識(shí)、數(shù)學(xué)和代碼能力將得到顯著改進(jìn)。

? 我們的對(duì)齊團(tuán)隊(duì)致力于研究如何向公眾交付一個(gè)有用、誠實(shí)和安全的模型。我們最初的實(shí)驗(yàn)證明,強(qiáng)化學(xué)習(xí)可以提高模型的復(fù)雜推理能力。

?

本文轉(zhuǎn)載自公眾號(hào)AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/GZXxzvdzXsDVEANNx8TL0w???