CVPR'24| 中大哈佛等提出creative Leap-of-thought探究大模型幽默創新力

導讀:

多模態大模型具備創造的潛力嗎?能力如何?本文從大模型創造力測評與增強等方面進行了探索,從幽默創新響應的角度,揭示了大模型在創新任務上的潛力和不足。目前該成果被計算機視覺頂級會議CVPR 2024錄用。

論文:https://arxiv.org/abs/2312.02439

Project: https://zhongshsh.github.io/CLoT/

Code: https://github.com/sail-sg/CLoT

為了探索多模態大模型的創造力,中山大學HCP實驗室林倞教授團隊聯同Sea AI Lab、哈佛大學的研究人員從日本傳統的創新幽默游戲“大喜利”(Oogiri)切入,探索目前多模態大模型在創新響應上的現狀。并提出了讓多模態大模型打破常規思維思考(Think Outside the Box)的訓練方法 Creative Leap-of-Thought (CLoT)。

什么是“大喜利”創新響應游戲?

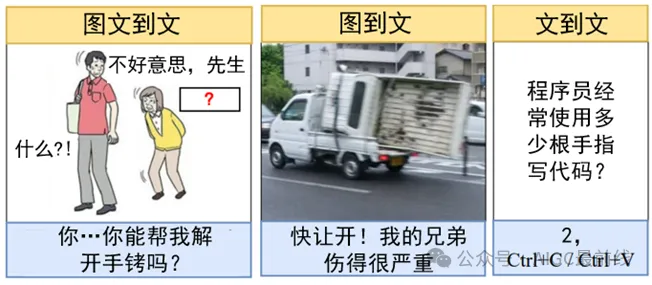

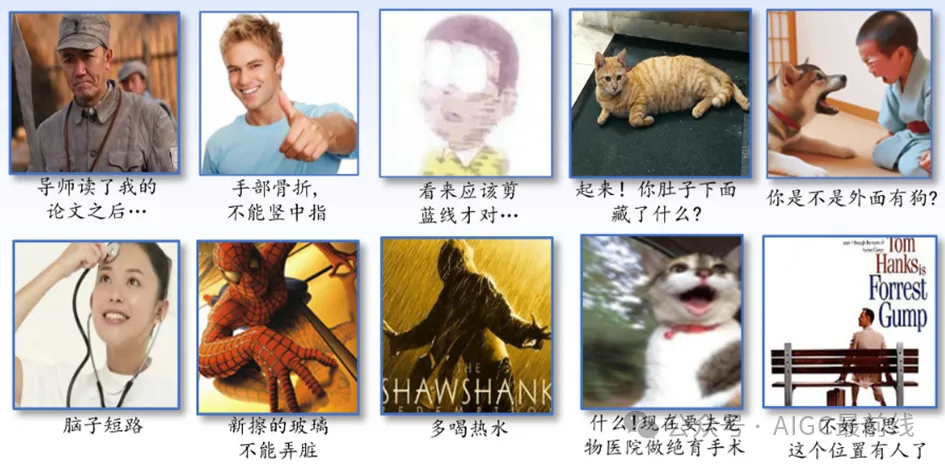

“大喜利”本來是指一系列日本傳統戲劇游戲,隨著時代的快速發展。現代的“大喜利”,目前一般是指一種叫Tonchi (頓智)的游戲,通常以游戲節目或智力問答節目的形式呈現,可以參考B站的日本著名節目IPPON大獎賽 (視頻鏈接)。玩家被提供各種多模態內容,可以是簡單的問題、隨機圖像等,然后提示玩家想出幽默的、有創意的反應,以達到令人驚訝的喜劇效果,如下圖所示的例子。

(例子1) 在第一個“圖文到文”的例子中,玩家要求閱讀圖像,和上面對應的文字,嘗試想出一段文字填入對應的“問號?"位置,使得整個圖文可以展示出幽默且有創意的效果。在第一個例子中,老人向年輕人尋求幫助,從正常的思維來看,可能的填寫方式可以是“請問xxx路怎么走?”或者是"可以帶我回家嗎,我迷路了"之類的┓( ′?` )┏。然而,所給出的“你...你能幫我解開手銬嗎?”的寫法具有沖擊感、幽默感,且看起來確實是這么一回事,使人忍俊不禁。

(例子2) 在第二個“圖到文”的例子中,玩家要求看圖配文,并使得圖文搭配起來具有幽默效果。這張圖看起來是一個很普通的拖車的圖片(需要注意的是,在“大喜利”游戲中,一般圖片都是很普通的日常圖片)。配文“快讓開!我的兄弟傷得很嚴重”讓傾斜著身體45°向上的車看起來像是一個奄奄一息的車子。在道路上快速的馳騁也確實體現了位于下方的車很著急,急著送兄弟去醫院。整體來說配文相當有趣且幽默!

(例子3) 在第三個“圖到文”的例子中,玩家被要求根據所給的文字進行回復,使得回復和問題合在一起具備幽默感。本例子中的回復似乎在調侃程序員的日常工作主要就是代碼的“復制+黏貼”┓( ′?` )┏ (注:CV工程師除了可以表示computer vision工程師也可以表示ctrl+c/ctrl+v工程師 )

本工作主要關注這三種類型的“大喜利”游戲,相關數據Oogiri-GO (如下表所示,含中英日三種語言)可以進入Project頁面下載。

為什么考慮“大喜利”游戲?

“大喜利”游戲是用于探索多模態大模型創新能力的理想平臺,因為:

- “大喜利”游戲是天然的創新響應任務。如上所提到的,現代“大喜利”也被稱為Tonchi (頓智)。“頓”在日文和中文中都表示“突然”,而“智”的意思是“智力、洞察力或直覺”,該游戲天然地要求玩家給出令人眼前一亮、靈光一閃的創新響應;

- “大喜利”的數據格式是高度合適的。不管是“圖文到文”、“圖到文”還是“文到文”,這些類型都天然地和目前多模特大模型的輸入輸出格式吻合,即輸入為“圖文”,輸出僅為“文”。

- “大喜利”數據質量高。創新是一件很難的事情,即使是人類,因此能作為“創新”相關的數據集并不多。鑒于該游戲長期在互聯網上非常活躍(在中文社區中,一般也叫日式神吐槽/冷吐槽),而且帶有大量點評數據,比如點贊數等等。正好積累了大量高質量人類創新幽默響應可以被用于研究。

性能結果展示

注意事項:

- 幽默是主觀的。任何一個幽默的響應都很難取悅每一個人 (人類的悲歡并不相通.jpg)。另外文化的差異、知識范圍等原因也會造成不同人對不同響應的幽默理解。

- 創新是困難的。如日本著名“大喜利”節目IPPON大獎賽 (視頻鏈接) 中頂尖人類選手也很難確保每一次響應都能讓評委滿意。如果模型響應不滿意,可以讓它多試幾次~

- 幽默是多元的。一些常見的“調侃“、“諷刺“等手段是幽默的重要組成部分。不同的文化,甚至不同的人,對這些內容的容忍度不同,模型輸出的內容可能對某些人會產生冒犯,敬請多多包容。本文、模型以及數據均只用于學術研究。

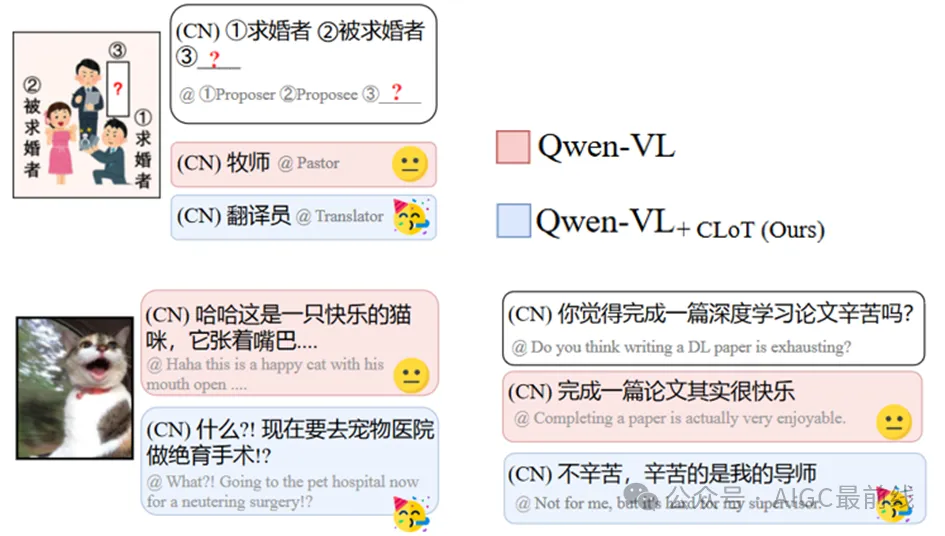

首先展示的是在本文方法CLoT前后的創新響應對比:

接下來是一些精彩的模型響應合集:

激發創造力的思維方式Leap-of-Thought (LoT)

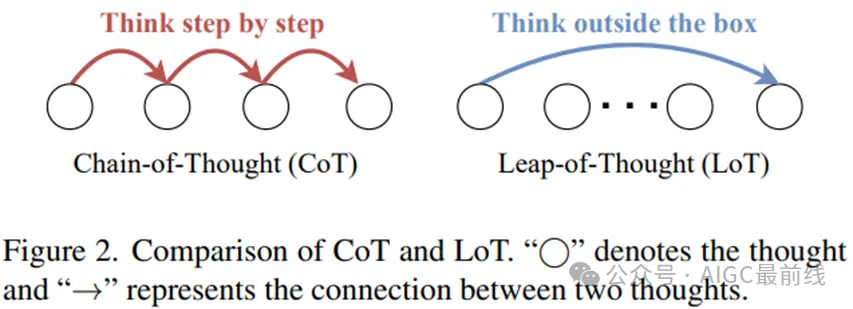

如下圖(左)所示,傳統的鏈式思考(Chain-of-Thought,CoT)方法是一種順序思考過程,通過逐步推理指導大模型進行邏輯推理,每個后續的思考都建立在前一個思考的基礎上。這一思考過程一定程度上確保了精確性和嚴謹性,但對于創造性問題表現不佳。如下圖(右)所示,本文探索了一種新的非順序、創造性思維范式——跳躍思維Leap-of-Thought(LoT)。這種范式涉及到思考關聯性和知識跳躍。遠距離的思考也被認為是聯想。與CoT強調邏輯緊密的思維鏈不同,LoT強調打破常規思維思考問題,激發模型的創造力。

通向LoT! 激發創造力的訓練方法CLoT

基于所提出的Oogiri-GO數據集,本文探索出一套激發多模態大模型創造力的訓練方法CLoT。如下圖所示,CLoT包括兩個階段:

- (1)關聯性指令微調。在這一階段,本文設計生成式和判別式模板,將Oogiri-GO數據集轉換為指令微調的訓練數據,用于訓練多模態大模型,使得模型具備初步的創新響應能力。

- (2)探索性自我調整。在這一階段中,本文首先通過設計遠關聯的條件詞,促使(1)中的模型生成多樣化且與輸入遠關聯的回答,并設計篩選流程,獲得可靠的新LoT數據。隨后,新數據被轉換成指令微調的訓練數據,用于進一步微調模型,具體地:

- (2.1) 探索性遠程關聯:這一步驟鼓勵LLM在給定的弱關聯條件下產生創新的回應。通過這種方式,LLM學習在看似不相關的概念之間建立聯系,從而生成多樣化的創意內容。

- (2.2)自我精煉:在探索性遠程關聯的基礎上,通過設計一系列篩選流程,收集到的創意回應被用來進一步訓練LLM。這樣做可以提高LLM在處理創造性任務時的表現,使其能夠生成更高質量和多樣性的內容。

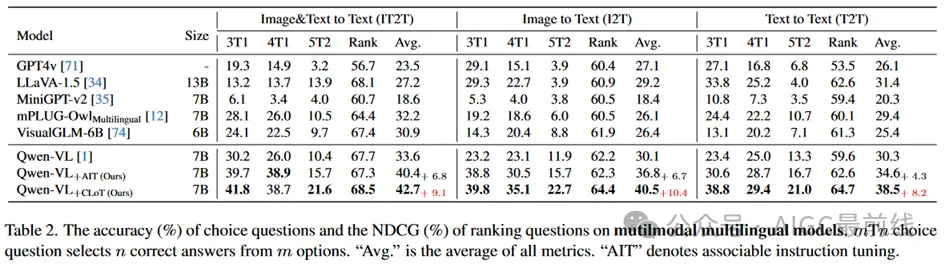

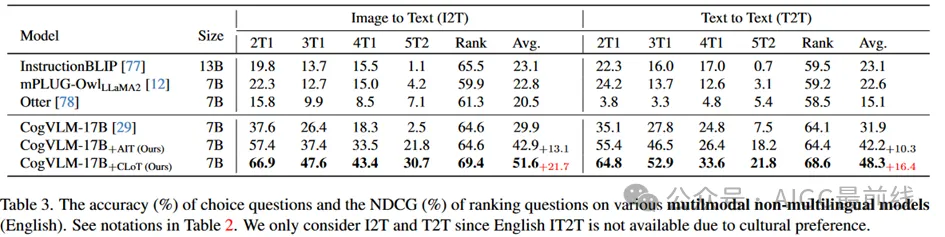

性能評估

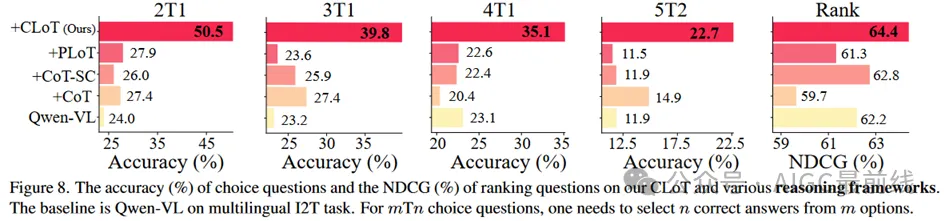

為了盡可能全面評估CLoT,本文基于Oogiri-GO數據集,設計了選擇題和排序題作為量化評估方式。實驗結果表明,CLoT能夠顯著提高多模態大模型(如Qwen和CogVLM)的性能,顯著超越包括GPT4v在內的先進模型。另外,與其他先進推理框架CoT等相比,在各項量化指標下也是有顯著優勢的。

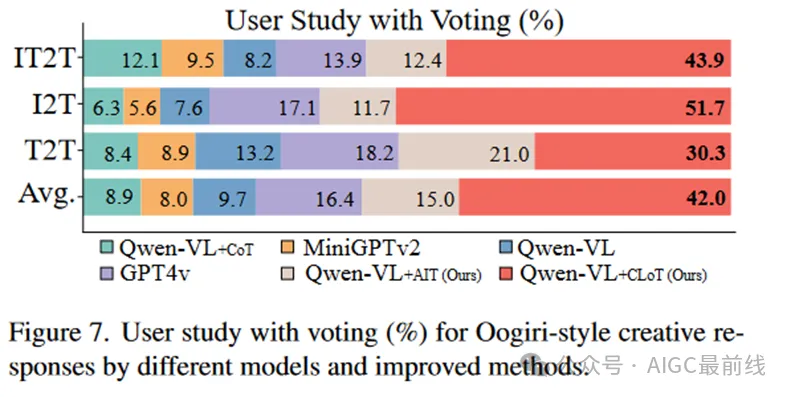

此外,研究團隊還通過用戶調查,證實了CLoT幫助模型生成了更好的幽默內容。

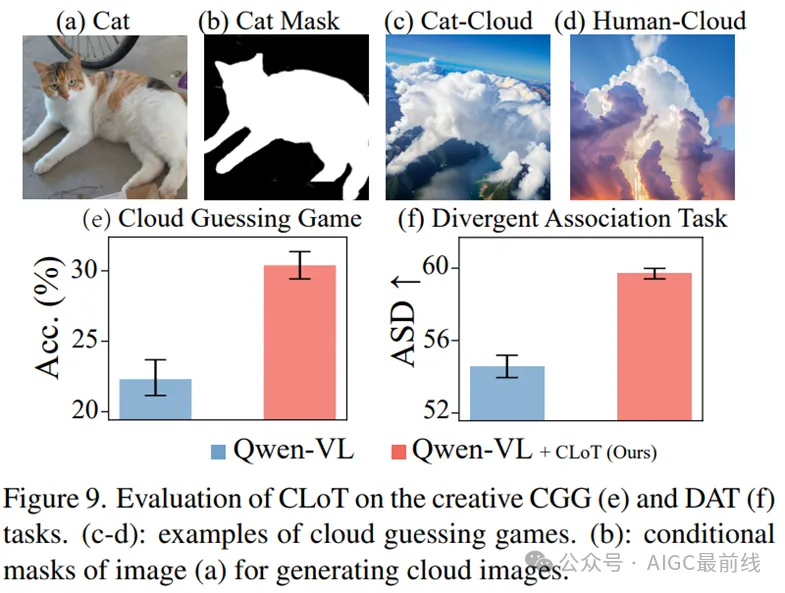

研究團隊還考慮到了CLoT的泛化性,用“看云猜物CGG”和“發散思維測試DAT”兩個其他任務評估CLoT的性能,實驗結果顯示CLoT相對于基準模型具有更好的準確度,說明CLoT具備不錯的泛化能力。DAT是一種用于評估人類聯想創造能力的測試。

總結

本文基于研究創造力的理想平臺”大喜利”幽默創新響應游戲,來首次探討了多模態大模型的創新響應能力。揭示了現有大模型在創造力、幽默能力在內的能力不足的現狀,并提出緩解目前現狀的提升方法。本工作已開源???https://github.com/sail-sg/CLoT???,歡迎使用和引用。

本文轉載自公眾號AIGC最前線 作者投稿